触手可及,函数计算玩转 AI 大模型

AI的时代下,大模型类型丰富、功能强大,正推动着各行各业的智能化转型和创新突破。企业纷纷寻求部署自己的大模型,以满足特定业务需求,从而在激烈的市场竞争中获得优势。本方案介绍通过阿里云函数计算的按量付费、卓越弹性、快速交付能力,助力企业快速部署 AI 大模型。

当冷启动一次问答调用时长为80s时,一次调用费用大约为0.388元,当活跃一次问答调用时长为30s时,一次调用的费用大约为0.145元,供参考)函数计算 文件存储NAS 专有网络VPC 立即体验 图像生成-ComfyUI 图像生成-ComfyUI 通过函数计算快速部署 ComfyUI,提供可自定义工作流的图像生成的服务。您可以通过 ComfyUI 的 Web 界面...

来自:

技术解决方案

大模型服务平台百炼

阿里云百炼是企业级大模型开发平台,助力企业轻松打造最优落地效果的AI应用,深度聚焦于人工智能与机器学习的前沿技术,它不仅提供了丰富的多模态模型调用服务,还简化了在线模型训练与部署流程,让开发者能够轻松驾驭大模型,加速创新应用的开发,推动AI技术在各行业的广泛应用。

查看更多应用构建开放高效,业务落地更轻松兼容LlamaIndex等开源框架和Open AI的Assistant API调用,支持5-10分钟低代码快速构建智能体。应用和模型双引擎驱动发展生态化共建,助力千行百业落地大模型应用。查看更多应用效果灵活可配,业务落地效果更佳提供全链路的模型训练及评估工具,以及可以帮助企业和开发者快速灵活...

来自:

云产品

ChatGLM和LangChain搭建对话模型

通过ChatGLM和LangChain构建高效的对话模型。基于自然语言处理技术,并使用语言交换协议提升语义理解和交互体验。可广泛应用于聊天机器人、智能客服、社交媒体等场景中,有效解决对话模型中的语义理解和交互问题,提高用户交互的自然性和流畅度。

在线部署 适用客户 需部署语言模型进行业务增强 追求高效对话系统构建的开发者 需根据用户行为偏好提供定制化服务 方案优势 为什么选择ChatGLM和LangChain搭建对话模型 低代码部署ChatGLM-WebUI 5分钟快速部署稳定的在线对话式模型推理验证,降低了开发者接入难度,体验ChatGLM大模型对话搜索。训练专属模型 通过预置的...

来自:

技术解决方案

10 分钟构建 AI 客服并应用到网站、钉钉或微信中

为了提升用户体验和增强业务竞争力,越来越多的企业会构建 AI 助手,以便全天候(7x24)回应客户咨询。在阿里云上,只需 10 分钟即可构建一个 AI 助手,并发布到网站、钉钉或微信公众号中。

如果免费试用额度已耗尽,体验本方案预计成本不超过 1 元)大模型服务平台百炼 函数计算 钉钉机器人 AI 助手 在钉钉中添加一个 AI 问答机器人 借助百炼您可以 0 代码创建一个大模型 RAG 应用,来实现 AI 助手的智能问答能力。然后可以在不写一行代码的情况下,完成钉钉机器人和大模型应用的对接,实现一个能回答私有领域...

来自:

技术解决方案

通义千问和LangChain搭建对话服务

本方案结合通义千问和LangChain技术构建高效的对话模型,该模型基于自然语言处理技术提升语义理解和用户交互体验。它可以有效解决传统对话模型在理解能力和交互效果上的局限,使得用户沟通更加自然流畅,被广泛应用于聊天机器人、智能客服和社交媒体等多种场景。

在线部署 适用客户 寻求迅速实施智能客服解决方案的企业 需求定制化企业级大型模型部署的企业 方案优势 为什么选择通义千问和LangChain搭建对话服务 低代码部署可视化的对话模型 5分钟快速部署稳定的在线对话式模型推理验证,降低了开发者接入难度,体验通义千问大模型对话功能。部署专属模型 通过预置的LangChain插件,...

来自:

技术解决方案

开源大数据平台 E-MapReduce 相关资源

阿里云大数据平台 E-MapReduce 提供详细的产品文档,面向开发者提供全方位的服务,有免费的实验课程和解决方案体验馆,帮助您快速上手。在阿里云 E-MapReduce 开发者社区,您可以和更多开发者交流。

镜像站170+开源软件镜像查看更多资源编排 ROSIaC 自动部署云资源查看更多WebIDE云命令行TerraformCLI 工具系统运维管理代码示例常见问题方案规划资源计费集群开通Q:EMR支持哪些地域?A:当前EMR支持的地域有:华东1(杭州)、华东2(上海)、华北1(青岛)、华北2(北京)、华北3(张家口)、华北5(呼和浩特)、华北6...

来自:

云产品

10分钟在网站上增加一个 AI 助手

为了提升用户体验和增强业务竞争力,越来越多的网站会引入 AI 助手,以便全天候(7x24)回应客户咨询。在阿里云上,只需 10 分钟即可为您的网站添加一个 AI 助手。

方案介绍 方案介绍 借助百炼您可以 0 代码创建一个大模型 RAG 应用,来实现 AI 助手的智能问答能力。然后可以借助函数计算将其暴露为网页前端可访问的 API。最后在前端代码中通过几行代码引入 AI 助手,用户就可以在您的网站上看到一个 AI 助手,并与之对话。立即部署 10 分钟 0 元(百炼和函数计算提供了免费试用额度;...

来自:

技术解决方案

云效代码管理 Codeup

云效代码管理 Codeup,10万企业都在用的代码管理平台,提供代码托管、代码评审、代码扫描、质量检测、持续集成等功能,全方位保护企业代码资产,帮助企业实现安全、稳定、高效的研发管理。

提供行级/函数级实时续写、自然语言生成代码、单元测试生成、代码注释生成、代码解释、研发智能问答、异常报错排查等能力.不限成员数、不限容量.不限成员数、不限容量.通用icon文字列表.云效助力新金融DevOps转型——南京银行实践之路.发版周期缩短1半,自动化率提升60%,上汽通用DevOps转型实践.「商米」从”蒸汽时代”到...

来自:

云产品

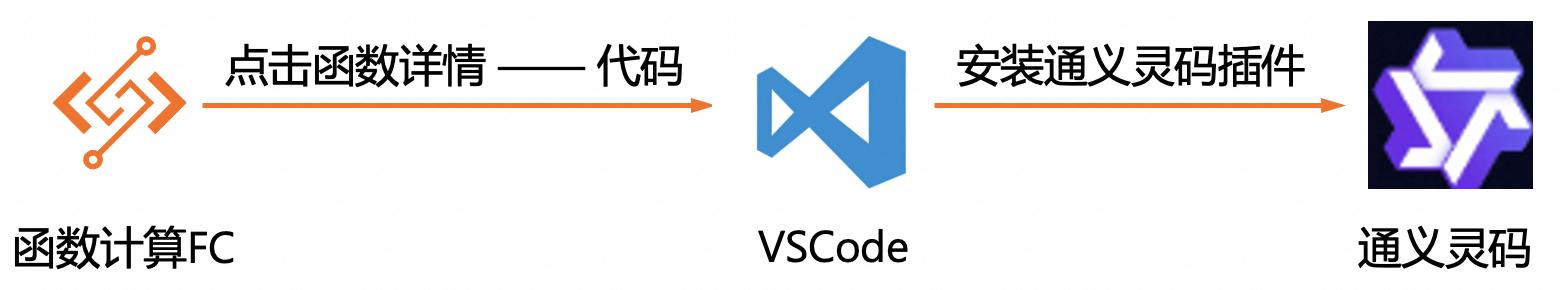

通义灵码助力函数计算FC实现函数编写

现在社会软件开发的复杂性不断增加,服务器配置和运维管理更复杂、开发效率变低。函数计算FC采用无服务器计算模式,用户只需要关注业务逻辑的实现,无需关心底层的服务器配置和运维管理,从而大大降低了运维成本和复杂性,而且具有弹性伸缩、快速部署、按需使用按量付费的特点。通义灵码是阿里云出品的一款基于通义大模型的智能编码辅助工具,可以帮助开发者快速编写高质量的代码,为开发者提供了强大的编程辅助功能。两者的结合让开发者可以更高效地编写函数代码,简化部署流程,提高开发效率。

应用场景 通义灵码可以助力函数计算FC的代码编写,函数计算WebIDE使用的是vscode,在vscode中安装通义灵 码插件就可以使用通义灵码的智能编写能力:生成单元测试、生成代码注释、代码解释、优化建议,还支 持自由问答,大大提高开发效率。解决问题•简化模型部署流程•全链路自适应弹性,无需为流量峰谷做频繁的手工处理 ...

Serverless 开发平台

阿里云Serverless 开发平台是无服务器开发平台,可通过Serverless 应用部署和开发快速提高Serverless 项目研发、应用集成部署与运维效能,无需考虑服务器即可快速构建并运行应用程序。

基于 Serverless 应用中心体验 AIGC 文生图应用技术交流内容分类:问答电子书文章描述2020-02-02文章描述2020-02-02文章描述2020-02-02函数计算怎么用 Serverless devs 创建一个应用?使用Serverless Devs创建GPU函数跟弹性实例基本一致,s.yaml的配置中需要指明instanceType/gpuMemorySize字段的配置,请参考Yaml规范和FC ...

来自:

云产品

基于函数计算FC实现大语言模型部署

在现代AI应用中, Qwen /chatglm2-6b 和Stable Diffusion等模型因其强大的功能而受到关注。然而,这些模型对计算资源的高需求和复杂的运维管理成为部署时的挑战。基于函数计算FC的无服务器计算模式为这类模型的部署提供了全新的解决方案。用户只需关注模型的部署和调用逻辑,而无需关心底层的服务器配置、资源分配和扩展性等问题。函数计算FC能够自动处理函数的执行环境,包括冷启动、弹性伸缩等,确保模型能够在大规模的请求下稳定运行。

使用FC应用模版部署社区模型 步骤5 在资源创建配置中,输入步骤 2获得的通义千问 API-KEY,之后选择适合的通义千问 模型版本,记住客户端的访问密码(默认为fc-qwen),创建应用。文档版本:20240429 15 基于函数计算 FC实现大语言模型部署最佳实践 使用FC应用模版部署社区模型 步骤6 进入函数部署页面,可以看到部署状态。...

- 产品推荐

- 这些文档可能帮助您