自建Hive数据仓库跨版本迁移到阿里云Databricks数据洞察

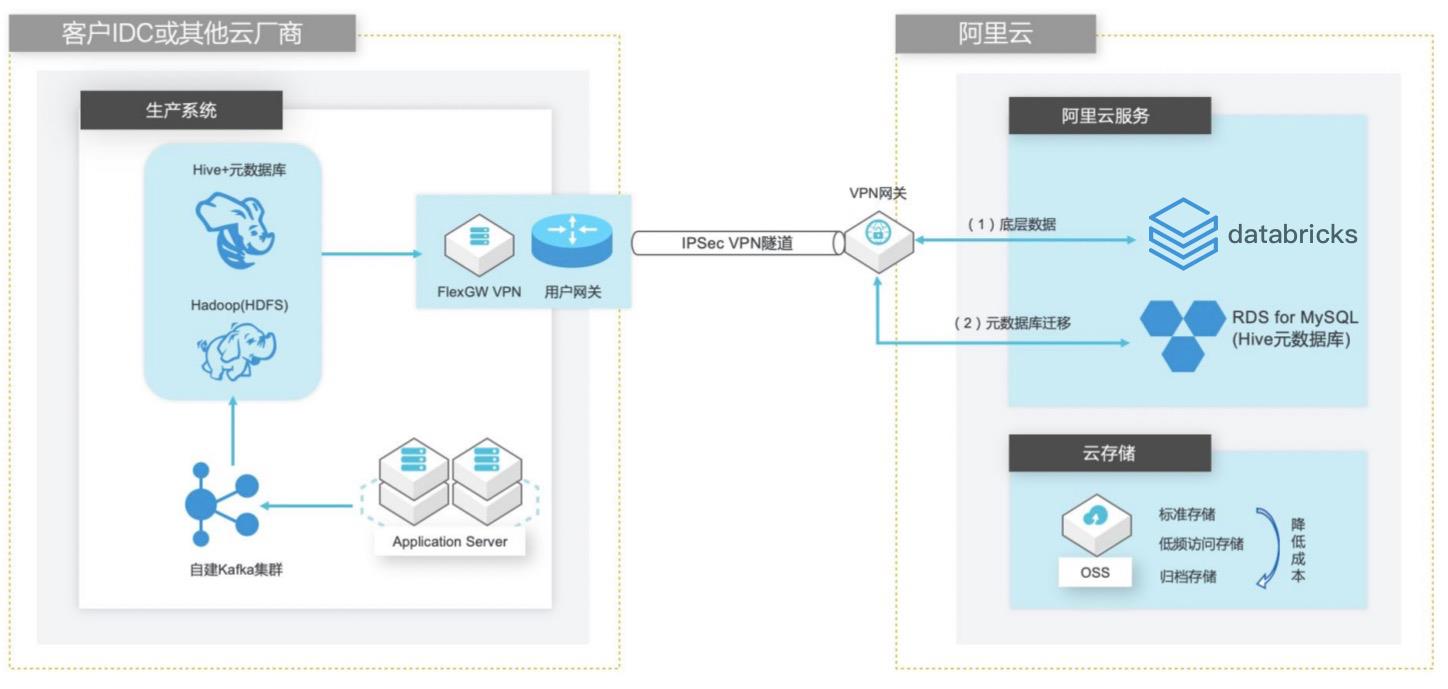

场景描述 客户在IDC或者公有云环境自建Hadoop集群构建数据仓库和分析系统,购买阿里云Databricks数据洞察集群之后,涉及到数仓数据和元数据的迁移以及Hive版本的订正更新。 方案优势 1. 全托管Spark集群免运维,节省人力成本。 2. Databricks数据洞察与阿里云其他产品(OSS、RDS、MaxCompute、EMR)进行深度整合,支持以这些产品为数据源的输入和输出。 3. 使用Databricks Runtime商业版引擎相比开源Spark性能有3-5倍的提升。 解决问题 1. Hive数仓数据迁移OSS方案。 2. Hive元数据库迁移阿里云RDS方案。 3. Hive跨版本迁移到Databricks数据洞察使用Delta表查询以提高查询效率。

自建 Hive数据仓库跨版本迁移到阿里云 Databricks数据洞察 业务架构 场景描述 客户在 IDC或者公有云环境自建 Hadoop集群 构建数据仓库和分析系统,购买阿里云 Databricks数据洞察集群之后,涉及到数仓数 据和元数据的迁移以及 Hive版本的订正更新。方案优势 1.全托管 Spark集群免运维,节省人力成 本。2.Databricks数据洞察...

数据传输解决方案

数据传输解决方案支持关系型数据库、NoSQL、大数据(OLAP)等数据源间的数据传输。 它是一种集数据迁移、数据订阅及数据实时同步于一体的数据传输服务。数据传输致力于在公共云、混合云场景下,解决远距离、毫秒级异步数据传输难题。

DTS基于数据库日志监听解析的技术实现非侵入式的增量数据实时采集。可将MySQL,PostgreSQL、Oracle、DB2及SQLServer等数据库的增量日志实时采集,实现多种数据库的零停机上云迁移.支持多种数据库的零停机上云迁移.DTS可实现MySQL、Oracle、DRDS、PostgreSQL等多种数据源的实时同步,实现数据...通过数据订阅实现缓存更新策略.

来自:

解决方案

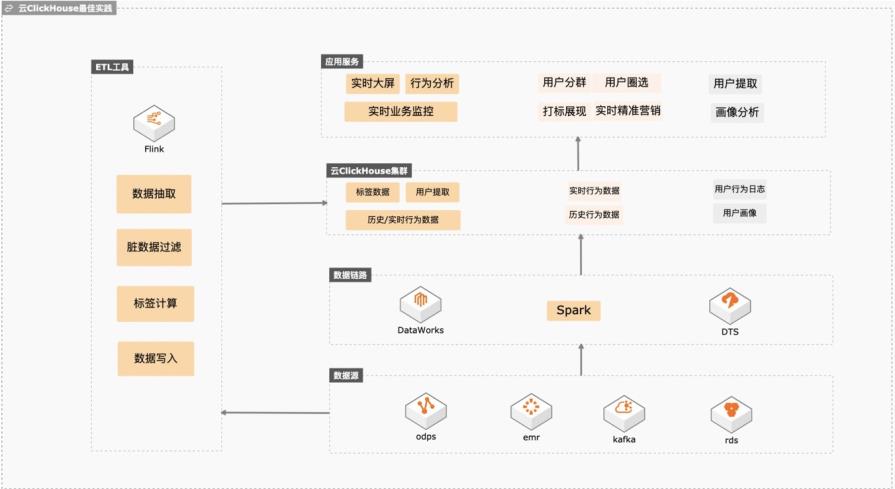

云Clickhouse冷热数据分层存储

基于云ClickHouse可以给电商、游戏、互联网以及其他行业提供高性能、高稳定性、低维护成本、高性价比的实时数据分析、精准营销、业务运营、业务分析、业务预警、业务营销、数仓加速等场景化方案,本实践会向客户提供数据库低维护成本、数据库链路构建、冷热分层存储、快熟分析等操作实践。 解决问题 1. 维护成本低不用建设维护体系,稳定性高,数据倾斜自动均衡。 2. 完善的数据同步链路,可以平滑将业务库、大数据、日志服务的数据同步到Clickhouse,降低研发成本。 3. 平滑升级版本,业务中断小。 冷热分层后透明读取,帮客户节约整体数据存储成本。

由于该功能是通 过存储阈值设置冷热分层,对于哪些数据进入冷存可控性不好,建议生产环境结合 TTL 策略进行分层存储。当云 ClickHouse 集群存储数据的物理存储大小超过了“热存可存储数据物理大小”后,部分数据会自动归档到冷存。热存可存储数据物理大小=云 ClickHouse集群磁盘 空间*(1-数 据 移 动 因 子),关 于 数 据 ...

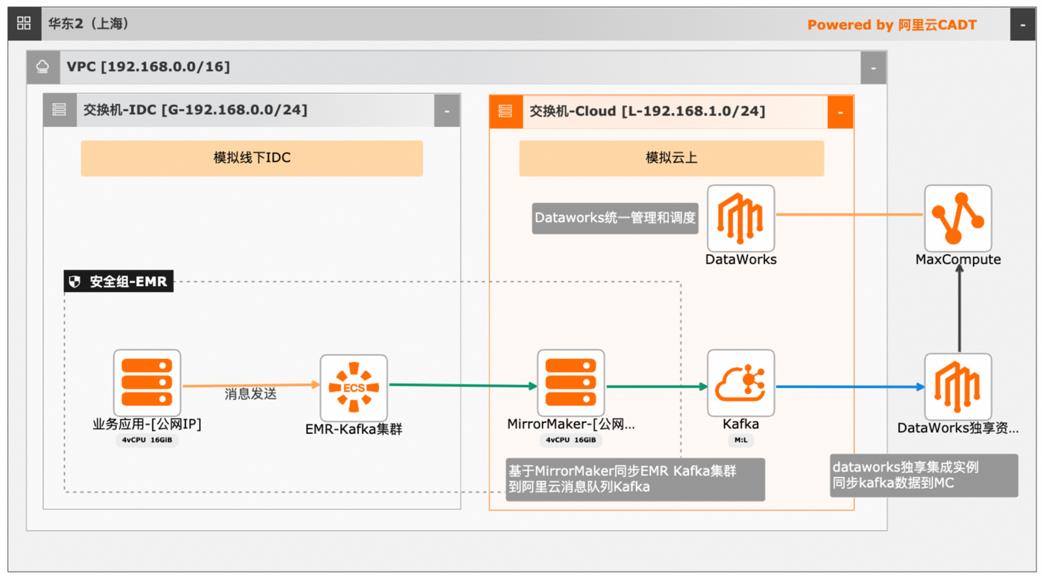

大数据近实时数据投递MaxCompute

本文介绍离线大数据场景使MaxCompute构建云 上近实时数仓,打通云下数据上云链路,解决数据复杂类型支持和动态分区问题,满足高级数据处理需求的最佳实践。 l混合云环境下,现有业务系统零改造,打通数据上云链路。 l使用UDF实现复杂数据类型转换和数据动态分区。 l使用DataWorks配置周期调度业务流程,数据自动入仓。 l借助MaxCompute优化计算引擎,实现降本增效。 产品列表 云服务器ECS 专有网络VPC 访问控制RAM 数据总线DataHub E-MapReduceEMR DataWorks 大数据计算服务MaxCompute

consumer.sh-bootstrap-server core-1-1:9092-topic message-from-beginning-max-messages 10 文档版本:20240419 15 大数据近实时数据投递 MaxCompute 4.EMR Kafka数据拉取至消息队列 Kafka 在本实践中,云上环境使用独立 ECS部署 MirrorMaker服务同步 EMR Kafka集群 数据至云上阿里云消息队列 Kafka,再通过数据同步至 ...

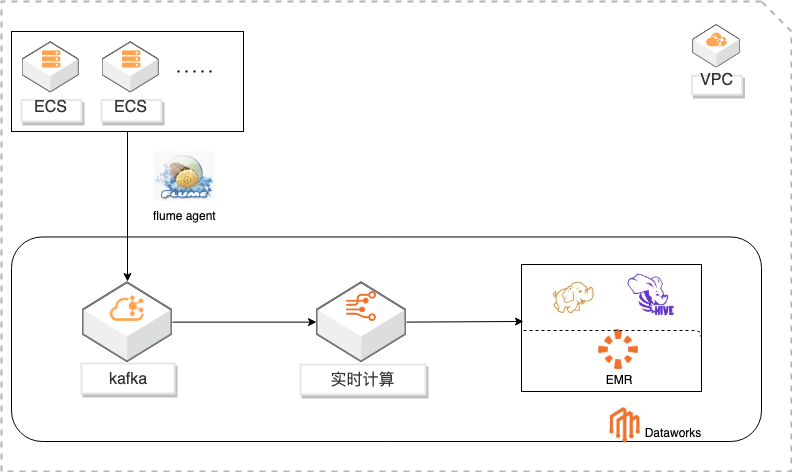

基于DataWorks的大数据一站式开发及数据治理

概述 基于Dataworks做大数据一站式开发,包含数据实时采集到kafka通过实时计算对数据进行ETL写入HDFS,使用Hive进行数据分析。通过Dataworks进行数据治理,数据地图查看数据信息和血缘关系,数据质量监控异常和报警。 适用场景 日志采集、处理及分析 日志使用Flink实时写入HDFS 日志数据实时ETL 日志HIVE分析 基于dataworks一站式开发 数据治理 方案优势 大数据一站式开发,完善的数据治理能力。 性能优越:高吞吐,高扩展性。 安全稳定:Exactly-Once,故障自动恢复,资源隔离。 简单易用:SQL语言,在线开发,全面支持UDX。 功能强大:支持SQL进行实时及离线数据清洗、数据分析、数据同步、异构数据源计算等Data Lake相关功能 ,以及各种流式及静态数据源关联查询。

基于 DataWorks的大数据一站式开发及数据治理 最佳实践 业务架构 场景描述 解决问题 本实践基于 Dataworks做大数据一站式开发,包含 日志采集、处理及分析 数据实时采集到 kafka 通过实时计算对数据进行 日志使用 Flink实时写入 HDFS ETL写入 HDFS,使用 Hive进行数据分析。通过 日志数据实时 ETL Dataworks进行数据治理,...

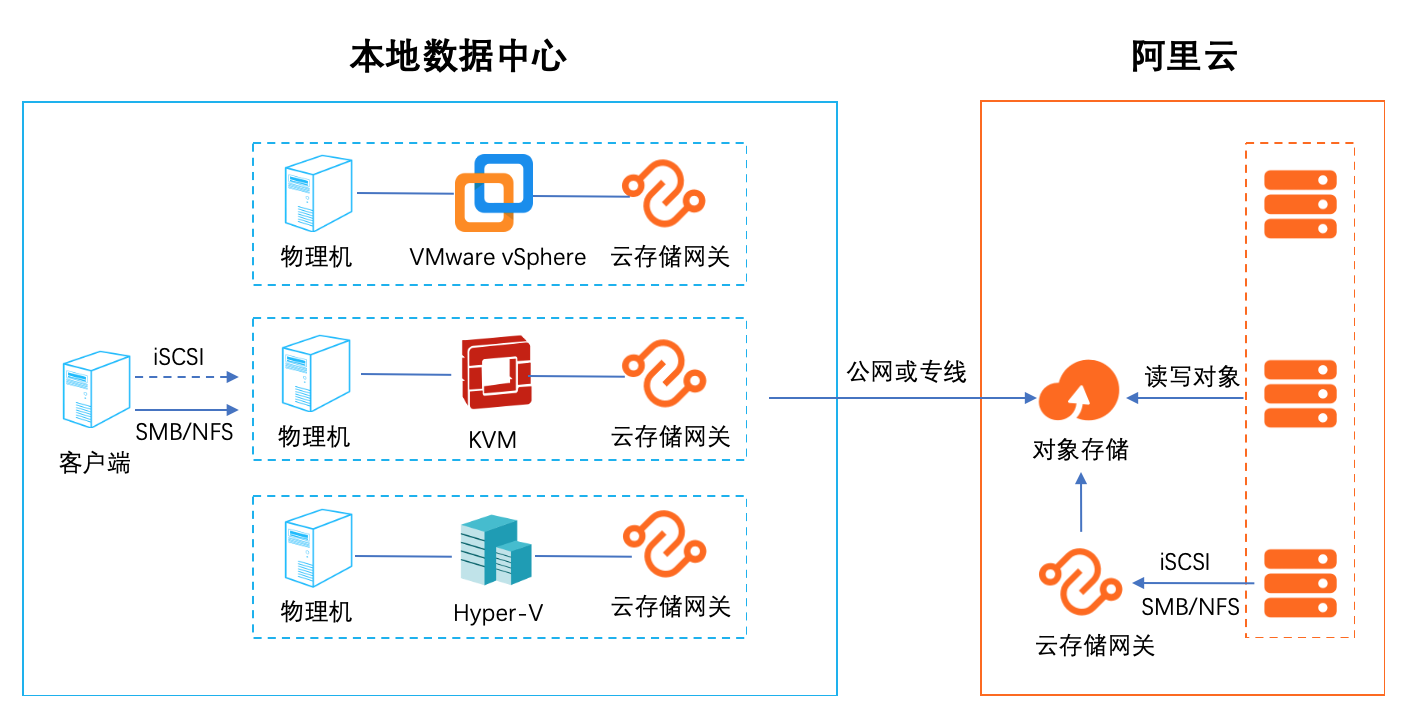

本地数据中心基于SMB/NFS协议访问对象存储最佳实践

1. 云存储扩容和迁移 集成智能缓存算法,自动识别冷热数据,将热数据保留在本地缓存,保证数据访问体验,无感知的将海量云存储数据接入本地数据中心,拓展存储空间。同时在云端 保留全量数据(冷+热)保证数据的一致性 2.云容灾 随着云计算的普及,越来越多的用户把自己的业务放到了云上。但是随着业务的发展,如何提高业务的可靠性和连续性,跨云容灾是一个比较热门的话题。借助云存 储网关对虚拟化的全面支持,可以轻松应对各种第三方云厂商对接阿里云的数据容灾。 3. 多地数据共享和分发 通过多个异地部署的文件网关实例,对接同一个阿里云OSS Bucket,可以实现快速的异地文件共享和分发,非常适合多个分支机构之间互相同步和共享数据。 4. 适配传统应用 有很多用户在云上的业务是新老业务的结合,老业务是从数据中心迁移过来的使用的是标准的存储协议,例如: NFS/SMB/iSCSI。新的应用往往采用比较新的技 术,支持对象访问的协议。如何沟通两种业务之间的数据是一个比较麻烦的事情,云存储网关正好起到一个桥梁的作用,可以便捷的沟通新旧业务,进行数据交换。 5. 替代 ossfs 和 ossftp ossfs 和 ossftp 都是基于文件协议的开源工具,用户可以通过它们直接上传文件到OSS。但是这两个开源文件都不建议在生产环境使用(POSIX 兼容度低),同时挂 载在用户的客户端需要额外的配置和缓存资源,对于多个客户端的情况安装配置繁琐。通过文件网关的服务可以完美替代 ossfs 和 ossftp。通过创建文件网关,用 户只需要执行简单的挂载(NFS)和映射(Windows SMB)就可以像使用本地文件系统一样使用 OSS。

共享目录下的数据通过缓存盘传至阿里云 OSS,也可以通过缓存盘将 阿里云 OSS数据同步到本地。步骤1 打开缓存设置页面,单击创建。步骤2 单击选择。文档版本:20210525 45 本地数据中心基于 SMB/NFS协议访问对象存储 配置本地云存储网关 步骤3 选中磁盘,单击确认。步骤4 单击确认。磁盘总容量是 80GB,缓存占用 80%,所以...

数据同步服务

数据同步 MSS,源于阿里云移动开发平台。移动数据同步 MSS,通过一个安全的数据通道 TCP+SSL,及时、准确、有序地将服务器端的业务数据,主动的同步(SYNC)到客户端 App。提供增量、可靠的消息触达能力,将聊天消息按发送方的发送顺序,有序推送至指定用户。可以动态地将配置信息进行全设备推送,保证在线 APP 可实时接收推送数据。

组件接入问题咨询>>.开通 mPaaS,创建 mPaaS App,并下载配置.查看接入帮助.接入客户端和服务端.完成基础配置、添加 MSS SDK,更新业务代码后,接入...移动数据同步 MSS,通过一个安全的数据通道 TCP+SSL,及时、准确、有序地将服务器端的业务数据,主动的同步(SYNC)到客户端 App.查看产品文档,快速上手.数据同步 MSS.

来自:

云产品

数据安全解决方案

数据是企业的核心资产,如何保护企业的云上数据,是每个企业管理者都应当重视的课题。在云平台提供更为安全便捷的数据保护能力的同时,阿里云根据自身多年的经验积累,结合大量云上客户的最佳实践,提供了一套完整的数据安全解决方案,帮助企业提升云上数据风险防御能力,实现企业核心及敏感数据安全可控。

数据安全成熟度模型.DSMM模型中将数据安全过程维度分为数据全生命周期安全和数据通用安全两个过程,并将数据全生命周期划分为:数据采集安全、数据传输安全、数据存储安全、数据处理安全、数据交换安全、数据销毁安全六个阶段。数据生命周期安全共包含30个过程域,为企业保护数据提供了可落地的参考.数据安全生命周期过程域...

来自:

解决方案

跨链数据可信连接服务

跨链数据连接服务 ODATS 是利用蚂蚁区块链领先技术实现的跨链数据连接服务。通过制定标准化的区块链UDAG全栈跨链协议,保证跨链交易的安全性、可扩展性及可靠性,打破区块链数据孤岛,实现同构及异构链之间的可信互通,助力企业之间可信协作,促进产业生态可信融合。

生产商、加工商、供应商及采购商可以组件各自区块链溯源平台,通过ODATS服务,能够安全可信地进行区块链之间的数据流通,全生命周期追踪商品信息,保证商品质量,同时更加精准定位目标客群.超过30个专利的自研跨链技术,通过区块链跨链协议栈,提供同构或异构区块链之间丰富的跨链互操作.领先跨链专利.基于硬件安全跨链验证...

来自:

云产品

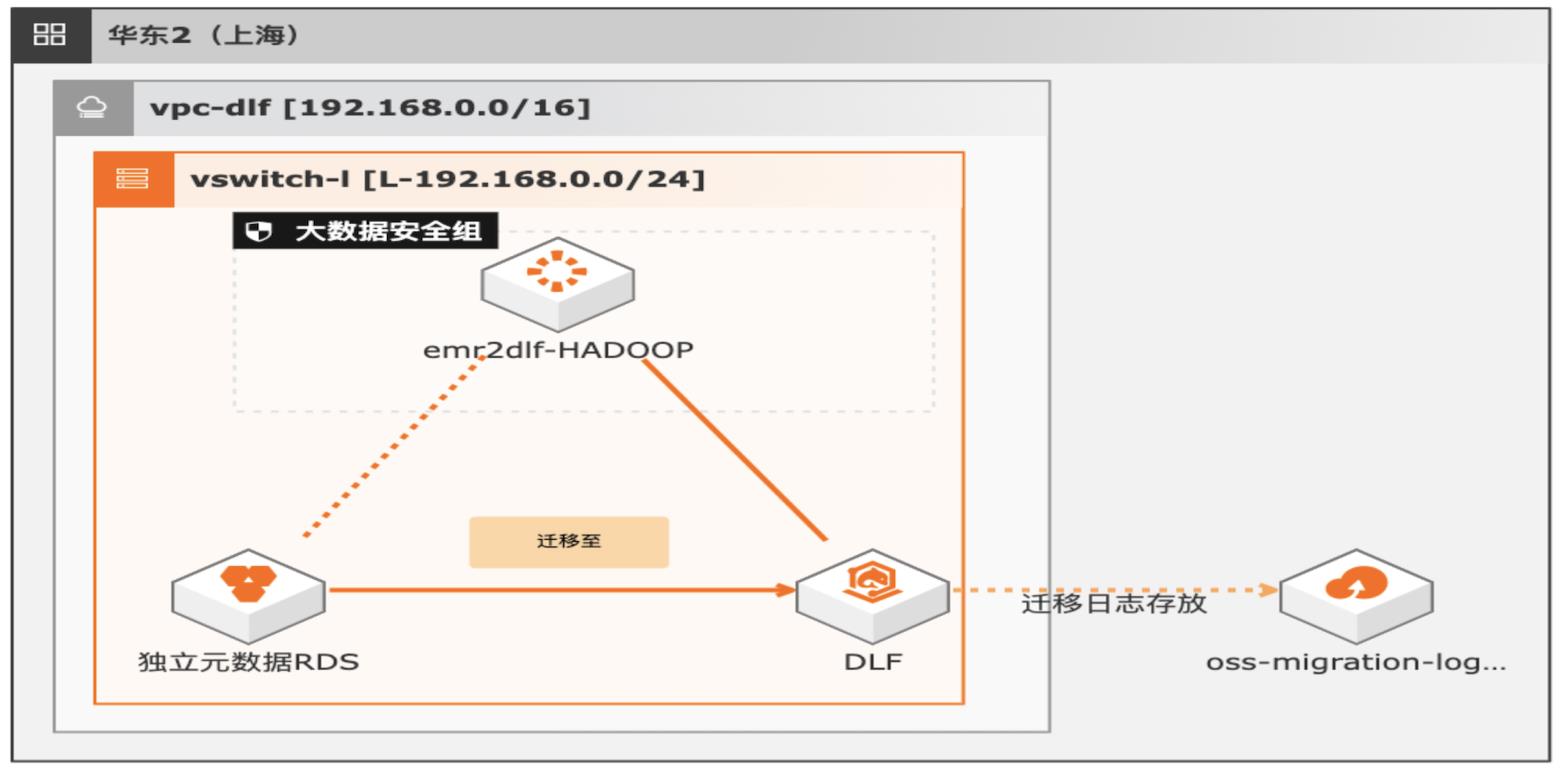

湖仓一体架构EMR元数据迁移DLF

通过EMR+DLF数据湖方案,可以为企业提供数据湖内的统一的元数据管理,统一的权限管理,支持多源数据入湖以及一站式数据探索的能力。本方案支持已有EMR集群元数据库使用RDS或内置MySQL数据库迁移DLF,通过统一的元数据管理,多种数据源入湖,搭建高效的数据湖解决方案。

湖仓一体架构 EMR元数据迁移 DLF最佳实践 业务架构 场景描述 解决的问题 通过 EMR+DLF数据湖方案,可以为企业提供数据 EMR元数据迁移至 DLF 湖内的统一的元数据管理,统一的权限管理,支持多 元数据迁移验证 源数据入湖以及一站式数据探索的能力。本方案支 数据一致性校验 持已有 EMR集群元数据库使用 RDS或内置 MySQL ...

跨链数据连接服务解决方案

利用蚂蚁区块链领先技术实现的跨链数据连接服务 Open Data Access Trusted Service(ODATS)。通过制定标准化的区块链UDAG全栈跨链协议,保证跨链交易的安全性、可扩展性及可靠性,打破区块链数据孤岛,实现同构及异构链之间的可信互通,助力企业之间可信协作,促进产业生态可信融合。

客户价值:合同存证链、版权存证链等数据存证场景中,如果发生任何纠纷,司法区块链可以通过跨链服务,可信获取其他链上的证据信息,确保证据真实性,提升收集的效率及有效性,降低司法判案成本.跨链可信取证.行业及客户痛点:在供应链场景中,供应商的票据上链存证,积累信用,如何将供应商的链上票据信息可信传递到金融...

来自:

解决方案

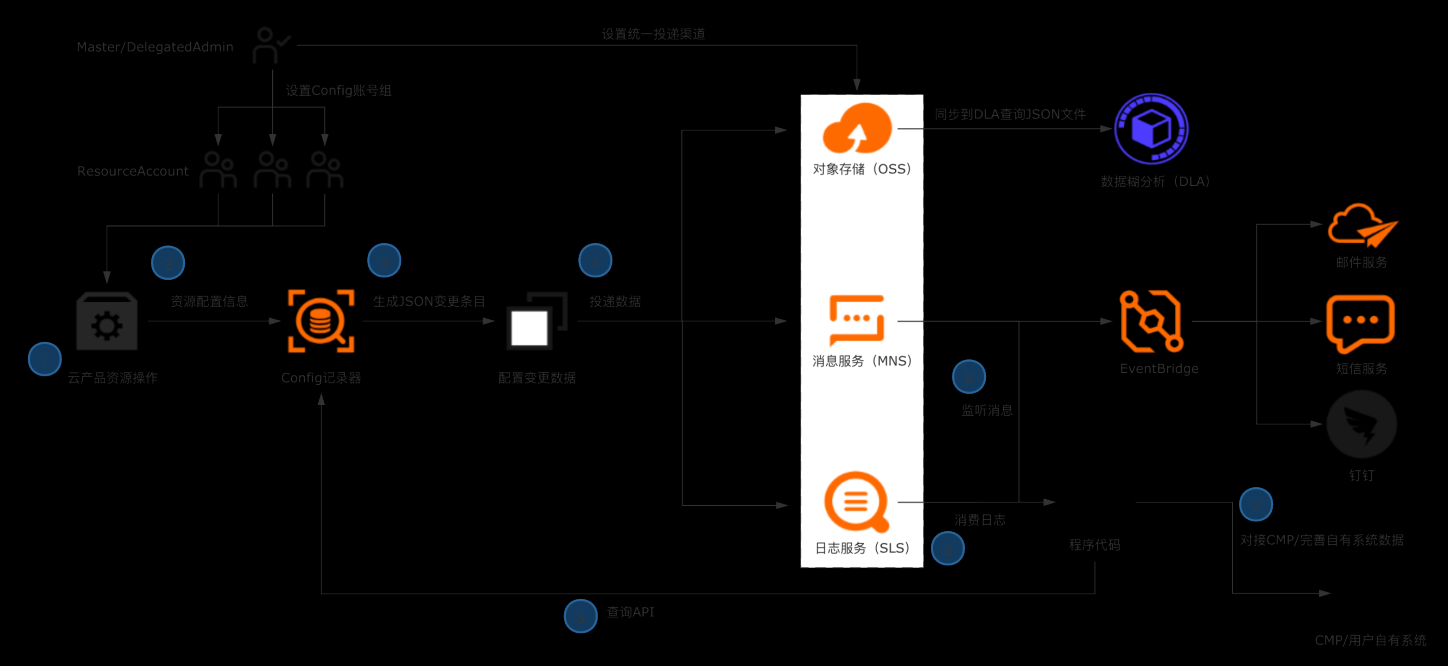

企业构建统一CMDB数据源

典型场景 l 企业/ISV构建多云CMDB平台,对接数十款产品的API,拉取、清洗、格式化、存储配置数据是复杂且高成本的工作。 l 企业日常的资源管理,需依赖资源配置历史、资源关系数据进行故障溯源和影响评估。 解决方案 l 企业管理账号设置Config配置数据投递,将所有账号的资源配置快照和历史归集到统一地址留存。 l 使用OSS做长期归档,使用SLS做实时分析和监听。获取全量资源数据并及时感知云上资源的变更。 l 将数据集成到自有CMDB平台 客户价值 l 基于配置审计简单便捷的持续收集云上资源配置数据,在自建CMDB过程中节省大量人力和时间成本。 l 跨账号统一收集数据,实现中心化的资源配置管理。 l 实现资源配置数据的持续收集和监听,及时感知云上资源的增删改,洞察异常变更。

获取ECS网络信息 本章节,我们以ECS资源的网络配置数据为例,使用 python脚本模拟将资源配置数 据导入企业自有系统。用到了配置审计的 API,在使用前需要导入阿里云 SDK 核心库:aliyun-python-sdk-core:在多账号情况下,列出主账号下指定账号 组的所有资源数据:在多账号情况下,查询指定资源的详细数据 注意:上述两个...

EMR本地盘实例大规模数据集测试

场景描述 阿里云为了满足大数据场景下的存储需求,在云 上推出了本地盘D1机型,这个系列提供了本地 盘而非云盘作为存储,提高了磁盘的吞吐能力, 发挥Hadoop的就近计算优势。阿里云EMR 产品针对本地盘机型,推出了一整套的自动化运 维方案,帮助用户方便可靠地使用本地盘机型, 不需要关注整个运维过程同时数据的高可靠和 服务的高可用。 解决问题 1.云盘多份冗余数据导致成本高 2.磁盘吞吐量不高 3.节点的高可靠分布问题 4.本地盘与节点的故障监控问题 5.数据迁移时自动决策问题 6.自动故障节点迁移与数据平衡问题 产品列表 EMR(E-MapReduce) 本地盘 VPC

Master节点 通常可以生成 1TB的数据进行基准性能测试,首先进入 hive-testbench目录下执行如 下脚本并加载测试数据 参数说明:数据集规模参数单位为 GB,1000表示生成的数据量为 1TB/tpcdata/tpcds 为表数据生成的目录,目录不存在就自动生成,如果不指定目录,数 据目录就默认生成到/tmp/tpcds目录下 cd hive-testbench#如果...

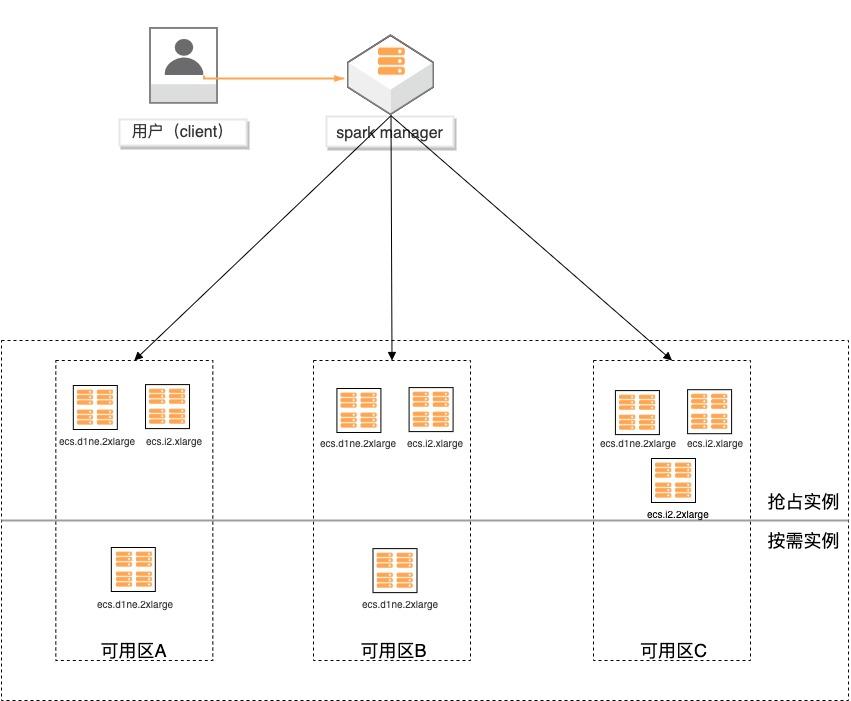

基于弹性供应组构建大数据分析集群

场景描述 基于弹性供应组(APG)搭建spark计算集 群,提供一键开启跨售卖方式、跨可用区、 跨实例规格的计算集群交付模式的实践。 方案优势 1.超低成本:跨售卖方式提供计算实 例,按秒计费,可全部使用spot实例 交付,最高可省90%成本。 2.稳定可靠:跨可用域、跨实例规格, 降低spot被集体释放的风险;自动托 管,分钟级巡检,动态保证集群的算 力。 3.快速交付:单次可在5分钟内交付 2000个实例。 4.多策略组合:可分别指定spot和按量 实例的交付策略,以及差额补足的策 略,包括成本最低、打散和折中。 解决问题 1.大规模计算集群成本高。 2.创建ECS实例方式单一,无法跨计费 方式、可用区及规格等核心参数。 3.当可用区资源紧张,无法自动保证基于 spot类型的稳定算力。 产品列表 专有网络VPC 云服务器ECS

集群计算能力规划 基于降成本的需要,您可以使用弹性供应组同时开出抢占式实例和按量付费实例,通 过搭配使用两种计费方式,保证满足最低计算力,同时降低获得更高计算力时的成本。供应组内实例可全部使用 spot实例交付,最高可省 90%成本。在搭建 spark集群前,预估计算容量,例如:类别 CPU core 总算力 48 core 按量计费...

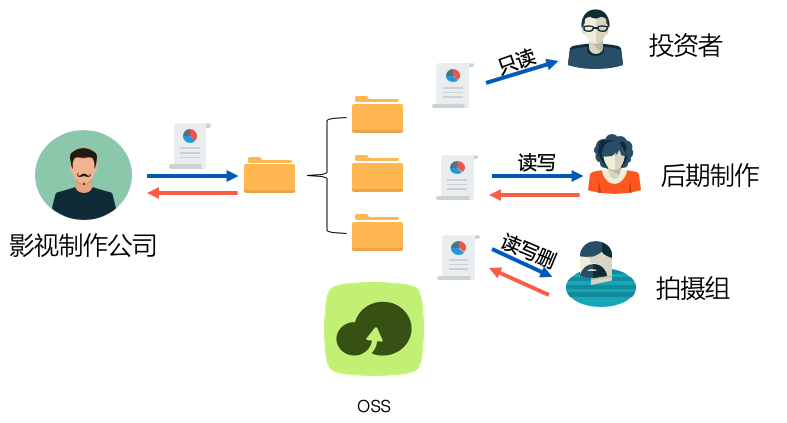

影视数据分发汇集与传输加速

场景描述 使用阿里云对象存储服务OSS及OSSBrowser 工具,实现影视数据多用户多地域分发、汇集, 以及传输加速的最佳实践。 解决问题 1.跨地域、多角色、分权限文件上传、下载。 2.基于OSS及其客户端实现Serverless文件 分发服务(可替换传统FTP服务)。 3.OSS文件传输全球加速。 产品列表 lOSS lRAM

影视数据分发汇集与传输加速 场景描述 业务架构 使用阿里云对象存储服务 OSS及 OSSBrowser 工具,实现影视数据多用户多地域分发、汇集,以及传输加速的最佳实践。解决问题 1.跨地域、多角色、分权限文件上传、下载。2.基于 OSS及其客户端实现 Serverless文件 分发服务(可替换传统 FTP服务)。3.OSS文件传输全球加速。产品...

- 产品推荐

- 这些文档可能帮助您