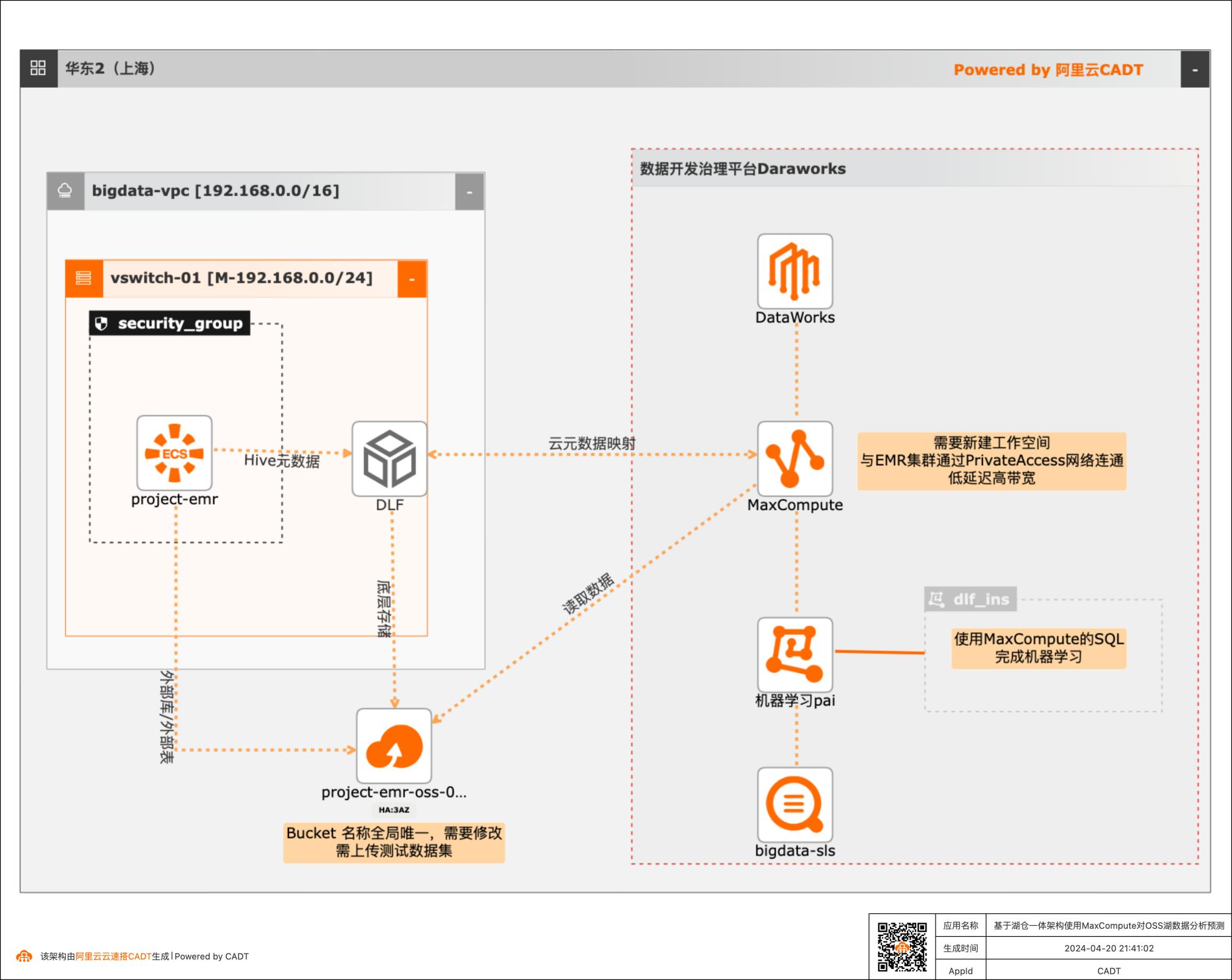

基于湖仓一体架构使用MaxCompute对OSS湖数据分析预测

本篇最佳实践先创建EMR集群作为数据湖对象,Hive元数据存储在DLF,外表数据存储在OSS。然后使用阿里云数据仓库MaxCompute以创建外部项目的方式与存储在DLF的元数据库映射打通,实现元数据统一。最后通过一个毒蘑菇的训练和预测demo,演示云数仓MaxCompute如何对于存储在EMR数据湖的数据进行加工处理以达到业务预期。

相关命令可 以下载后浏览:gitclonehttps:/best-practice:Abcd123456@codeup.aliyun.com/best-practice/bp/199.git 使用场景 针对分析师如何利用MaxComputeIn-databaseML 能力,通过湖仓一体架构对海量OSS 非结构化、半结构化数据做数据分析和机器学习模型构建、训练和应用。业务架构基于湖仓一体架构使用MaxCompute对OSS湖...

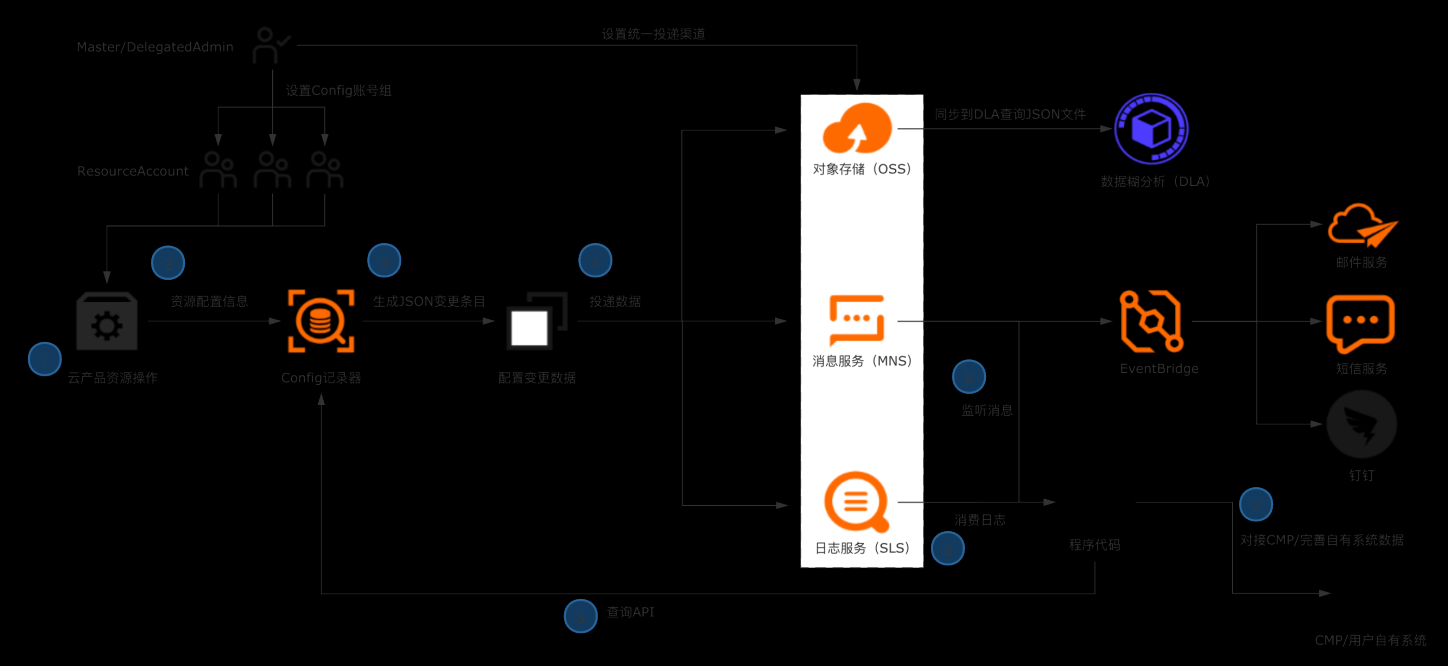

企业构建统一CMDB数据源

典型场景 l 企业/ISV构建多云CMDB平台,对接数十款产品的API,拉取、清洗、格式化、存储配置数据是复杂且高成本的工作。 l 企业日常的资源管理,需依赖资源配置历史、资源关系数据进行故障溯源和影响评估。 解决方案 l 企业管理账号设置Config配置数据投递,将所有账号的资源配置快照和历史归集到统一地址留存。 l 使用OSS做长期归档,使用SLS做实时分析和监听。获取全量资源数据并及时感知云上资源的变更。 l 将数据集成到自有CMDB平台 客户价值 l 基于配置审计简单便捷的持续收集云上资源配置数据,在自建CMDB过程中节省大量人力和时间成本。 l 跨账号统一收集数据,实现中心化的资源配置管理。 l 实现资源配置数据的持续收集和监听,及时感知云上资源的增删改,洞察异常变更。

获取ECS网络信息 本章节,我们以ECS资源的网络配置数据为例,使用 python脚本模拟将资源配置数 据导入企业自有系统。用到了配置审计的 API,在使用前需要导入阿里云 SDK 核心库:aliyun-python-sdk-core:在多账号情况下,列出主账号下指定账号 组的所有资源数据:在多账号情况下,查询指定资源的详细数据 注意:上述两个...

数据安全中心

敏感数据保护(Sensitive Data Discovery and Protection),在满足等保v2.0“安全审计”、等保v3.0及“个人信息保护”的合规要求的基础上,为客户提供敏感数据识别、分级分类、数据安全审计、数据脱敏、智能异常检测等数据安全能力,形成一体化的数据安全解决方案。

从海量数据中发现和锁定保护对象,通过内置算法规则和自定义敏感数据识别规则,对其存储的数据库类型数据以及非数据库类型文件进行整体扫描、分类、分级,并根据结果做进一步的安全防护,如细粒度访问控制、加密保存等.敏感数据识别.细粒度行为审计追溯的能力,可审计用户终端信息、使用工具、数据信息、返回结果等详细信息...

来自:

云产品

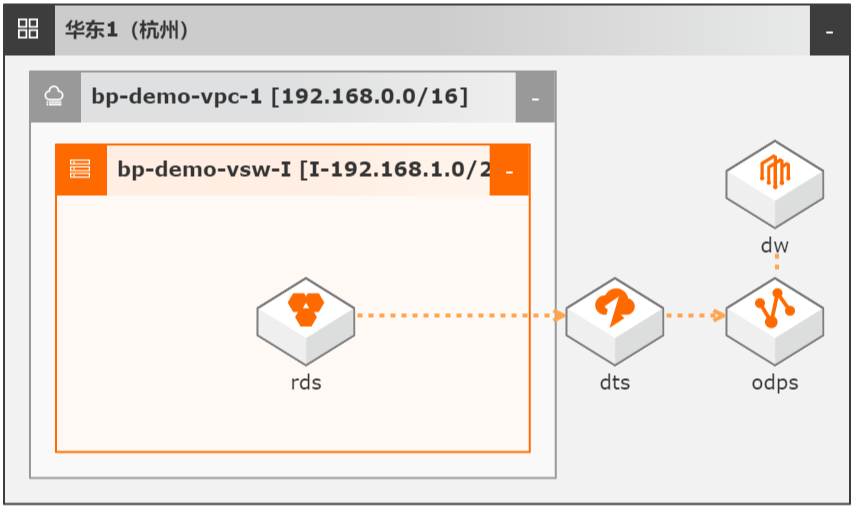

DTS数据同步集成MaxCompute数仓

场景描述 本文Step by Step介绍了通过数据传输服务 DTS实现从云数据库RDS到MaxCompute的 数据同步集成,并介绍如何使用DTS和 MaxCompute数仓联合实现数据ETL幂等和数 据生命周期快速回溯。 解决问题 1.实现大数据实时同步集成。 2.实现数据ETL幂等。 3.实现数据生命周期快速回溯。 产品列表 MaxCompute 数据传输服务DTS DataWorks 云数据库RDS MySQL 版

数据抽取不幂等或容错率低,如凌晨 0:00启动的 ETL任务因为各种原因(数据库 HA切换、网络抖动或 MAXC写入失败等)失败后,再次抽取无法获取 0:00时的数 据状态。2.针对不规范设计表,如没有 create_time/update_time的历史遗留表,传统 ETL需 全量抽取。3.实时性差,抽取数据+重试任务往往需要 1-3小时。另外数据库的数据...

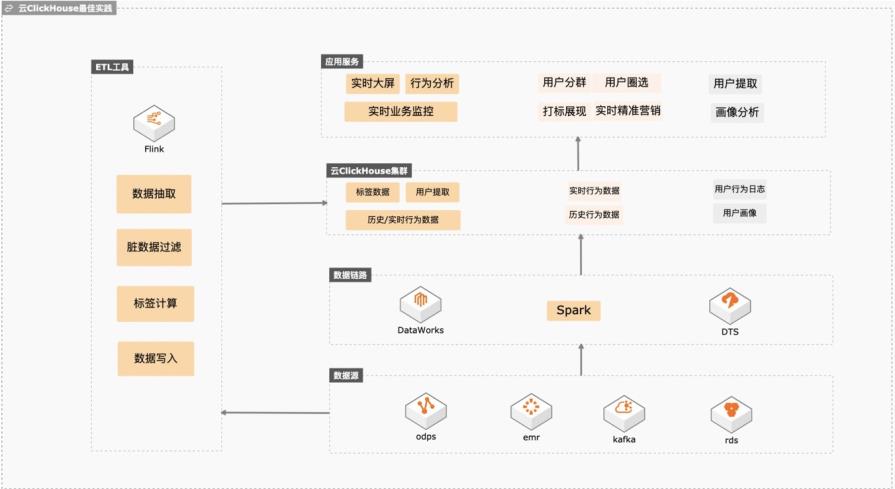

云Clickhouse冷热数据分层存储

基于云ClickHouse可以给电商、游戏、互联网以及其他行业提供高性能、高稳定性、低维护成本、高性价比的实时数据分析、精准营销、业务运营、业务分析、业务预警、业务营销、数仓加速等场景化方案,本实践会向客户提供数据库低维护成本、数据库链路构建、冷热分层存储、快熟分析等操作实践。 解决问题 1. 维护成本低不用建设维护体系,稳定性高,数据倾斜自动均衡。 2. 完善的数据同步链路,可以平滑将业务库、大数据、日志服务的数据同步到Clickhouse,降低研发成本。 3. 平滑升级版本,业务中断小。 冷热分层后透明读取,帮客户节约整体数据存储成本。

热存可存储数据物理大小=云 ClickHouse集群磁盘 空间*(1-数 据 移 动 因 子),关 于 数 据 移 动 因 子描述 参 考:https://help.aliyun.com/document_detail/202879.html 通过该步骤创建一个宽表并写入大量数据,突破“热存可存储数据物理大小”,触发部 文档版本:20210416 42 云 ClickHouse冷热数据分层存储最佳实践 ...

智能数据建设与治理Dataphin

Dataphin遵循阿里巴巴集团多年实战沉淀的大数据建设OneData体系(OneModel、OneID、OneService),集产品、技术、方法论于一体,一站式地为您提供集数据引入、规范定义、智能建模研发、数据萃取、数据资产管理、数据服务等的全链路智能数据构建及管理服务。助您打造属于自己的标准统一、资产化、服务化和闭环自优化的智能数据体系,驱动创新。

集成超过50个数据源涉及的数据,地产、物业、营销、市场、IoT 等数据域上云.多源异构的数据上云.5人的数据团队,服务集团区域及总部职能人员超百人的数据需求.人力运营成本的管控.丰富的数据模型构建,洞察业务的过程数据,实现精细化运营.业务的精细化运营.Dataphin助力地产行业客户实现高效数据服务.版本和功能特性.行业...

来自:

云产品

Spark on ECI大数据分析

场景描述 方案优势 1.计算引擎弹性扩缩容,兼顾资源弹性与计 算资源成本优化。 2.计算与存储分离架构,结合阿里云原生云 存储产品,海量数据湖优势。 3.Kubernetes原生的调度性能优势,提升在 大规模分析作业时的分析性能优势分。 4.集群资源隔离和按需分配。 解决问题 1.计算资源弹性能力不足,计算资源成本管 控能力欠缺. 2.集群资源调度能力和隔离能力不足。 3.计算与存储无法分离,大数据量分析时出 现数据存储资源瓶颈。 4.Spark submit方式提交分析作业参数支持 有限等缺点。 产品列表 容器服务Kubernetes版(ACK) 弹性容器实例(ECI) 文件存储HDFS 对象存储OSS 专有网络VPC 容器镜像服务ACR

对 Spark大数据分析平台计算资源成本控制考虑的用户 需要有灵活可扩展计算平台资源弹性及管控的用户 名词解释 文件存储 HDFS:阿里云文件存储 HDFS是面向阿里云 ECS实例及容器服务等计 算资源的文件存储服务,允许用户像在 Hadoop分布式文件系统中管理和访问数 据,无需对数据分析应用做任何修改,即可使用具备无限容量及...

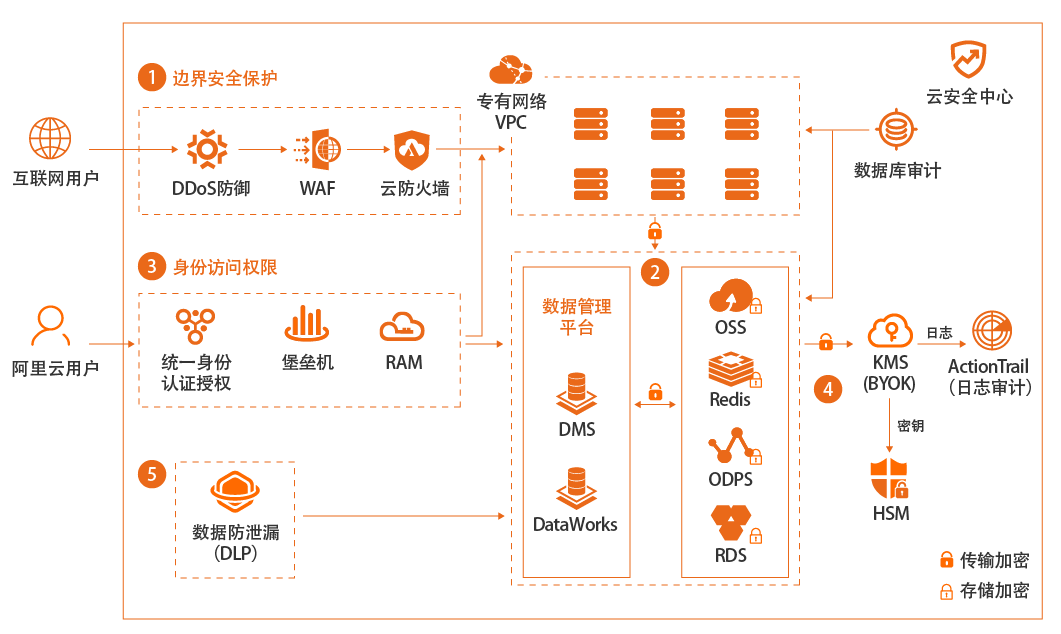

企业上云数据安全

场景描述 企业是否选择上公共云,或者哪些系统或数据上 公共云,对数据安全的关心是重要因素之一。本 最佳实践重点在于介绍狭义的数据加密存储安 全范畴,即首先使用SDDP产品进行敏感数据发 现和分级分类,然后对高级别敏感数据进行按 需、不同类型的全链路加密存储。 解决问题 1.帮助客户发现敏感数据 2.对敏感数据进行分类、分级 3.对不同级别的数据如何选择加密方式 4.具体如何进行加密 产品列表 敏感数据识别SDDP 密钥管理服务KMS 云数据库RDS 对象存储OSS

流程如下图:对于客户端加密方式,分为用户自己管理密钥加密(CSE-C)和 KMS 托管密钥(CSE-KMS)加密两种,如下图所示:文档版本:20210809 28 企业上云数据安全 OSS数据加密 使用客户端加密,可以使用客户端加密 SDK,在本地进行数据加密,并将加密后的数 据上传到 OSS。在这种场景下,用户需要管理加密过程以及加密密钥...

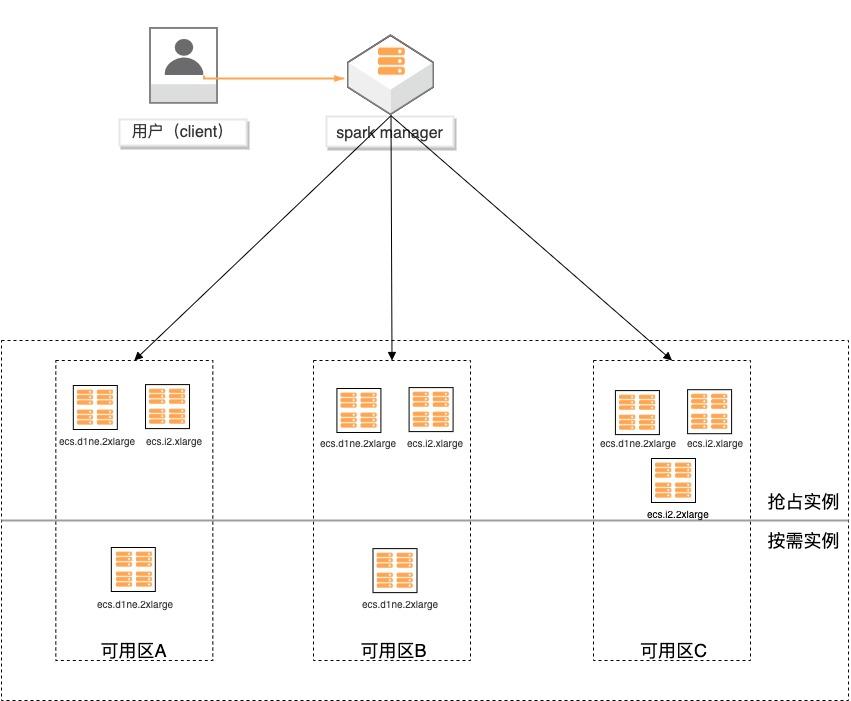

基于弹性供应组构建大数据分析集群

场景描述 基于弹性供应组(APG)搭建spark计算集 群,提供一键开启跨售卖方式、跨可用区、 跨实例规格的计算集群交付模式的实践。 方案优势 1.超低成本:跨售卖方式提供计算实 例,按秒计费,可全部使用spot实例 交付,最高可省90%成本。 2.稳定可靠:跨可用域、跨实例规格, 降低spot被集体释放的风险;自动托 管,分钟级巡检,动态保证集群的算 力。 3.快速交付:单次可在5分钟内交付 2000个实例。 4.多策略组合:可分别指定spot和按量 实例的交付策略,以及差额补足的策 略,包括成本最低、打散和折中。 解决问题 1.大规模计算集群成本高。 2.创建ECS实例方式单一,无法跨计费 方式、可用区及规格等核心参数。 3.当可用区资源紧张,无法自动保证基于 spot类型的稳定算力。 产品列表 专有网络VPC 云服务器ECS

可以认为是一种算量的衡量方式,单位可以是 vCPU个数,也可以是实 例个数。容量权重指每个实例规格对目标容量的贡献度,权重越大,单台实例满足计算力需求 的能力越大,所需的实例数量越小。权重根据指定实例规格的计算力与集群单节点最 低计算力得出,假设单节点最低算力为 8 vCPU/60GB,则 8 vCPU/60GB的实例权重 为 1,...

数据安全解决方案

数据是企业的核心资产,如何保护企业的云上数据,是每个企业管理者都应当重视的课题。在云平台提供更为安全便捷的数据保护能力的同时,阿里云根据自身多年的经验积累,结合大量云上客户的最佳实践,提供了一套完整的数据安全解决方案,帮助企业提升云上数据风险防御能力,实现企业核心及敏感数据安全可控。

数据安全成熟度模型.DSMM模型中将数据安全过程维度分为数据全生命周期安全和数据通用安全两个过程,并将数据全生命周期划分为:数据采集安全、数据传输安全、数据存储安全、数据处理安全、数据交换安全、数据销毁安全六个阶段。数据生命周期安全共包含30个过程域,为企业保护数据提供了可落地的参考.数据安全生命周期过程域...

来自:

解决方案

智能数据标注PAI-iTAG

智能数据标注PAI-iTAG是一款智能化数据标注平台,支持图像、文本、视频、音频等多种数据类型的标注以及多模态的混合标注。智能标注PAI-iTAG提供了丰富的标注内容组件和题目组件,可以直接使用平台预置的标注模板,也可以根据场景自定义模板进行数据标注。

将结果创建为一个数据集,便于应用于模型训练.远低于自建外包团队的人力成本.标注员专业的技能培训和生产管理.专业标注团队.0事故数据安全运营记录.数据安全保密.标准化SAAS数据标注服务交付流程.全托管式项目管理.PAI-iTAG 提供专业、全托管的定制化标注服务,培训专业标注人才上岗,并配备专职的驻场人员严格把关质量,极...

来自:

云产品

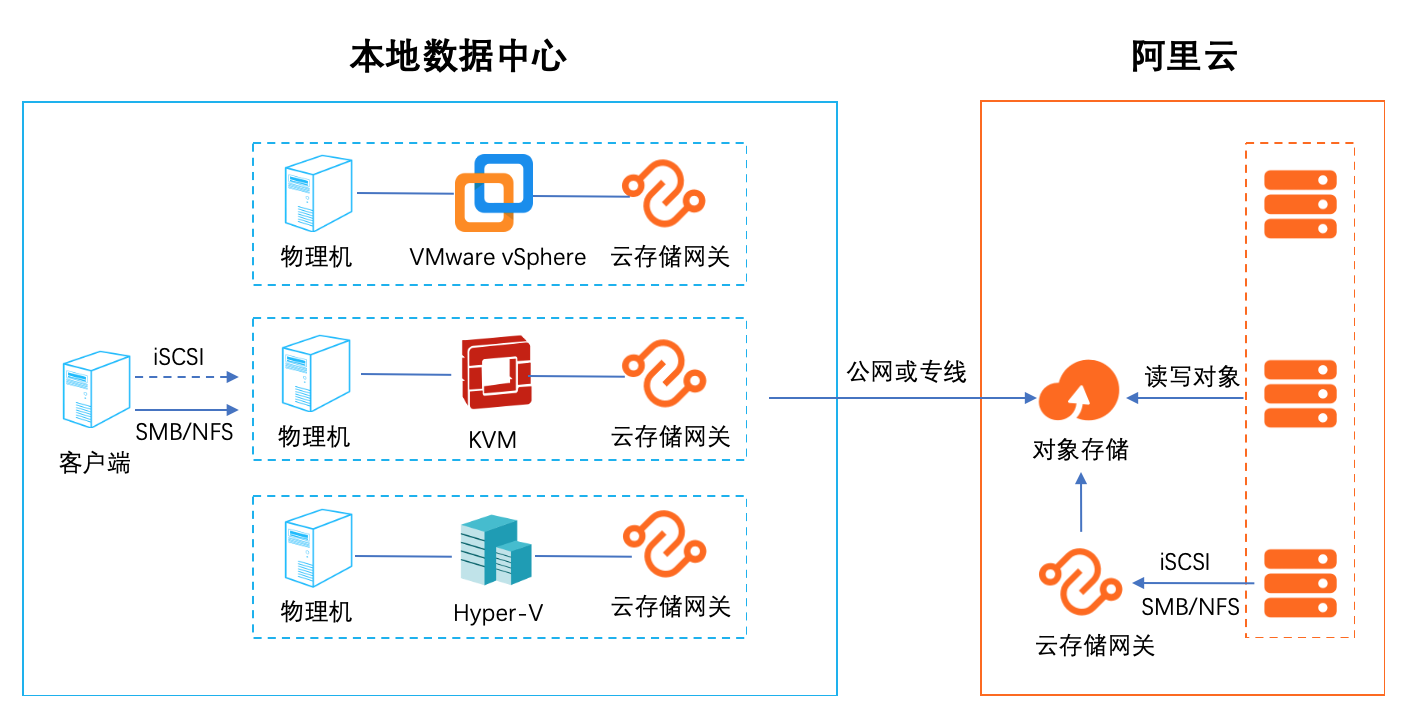

本地数据中心基于SMB/NFS协议访问对象存储最佳实践

1. 云存储扩容和迁移 集成智能缓存算法,自动识别冷热数据,将热数据保留在本地缓存,保证数据访问体验,无感知的将海量云存储数据接入本地数据中心,拓展存储空间。同时在云端 保留全量数据(冷+热)保证数据的一致性 2.云容灾 随着云计算的普及,越来越多的用户把自己的业务放到了云上。但是随着业务的发展,如何提高业务的可靠性和连续性,跨云容灾是一个比较热门的话题。借助云存 储网关对虚拟化的全面支持,可以轻松应对各种第三方云厂商对接阿里云的数据容灾。 3. 多地数据共享和分发 通过多个异地部署的文件网关实例,对接同一个阿里云OSS Bucket,可以实现快速的异地文件共享和分发,非常适合多个分支机构之间互相同步和共享数据。 4. 适配传统应用 有很多用户在云上的业务是新老业务的结合,老业务是从数据中心迁移过来的使用的是标准的存储协议,例如: NFS/SMB/iSCSI。新的应用往往采用比较新的技 术,支持对象访问的协议。如何沟通两种业务之间的数据是一个比较麻烦的事情,云存储网关正好起到一个桥梁的作用,可以便捷的沟通新旧业务,进行数据交换。 5. 替代 ossfs 和 ossftp ossfs 和 ossftp 都是基于文件协议的开源工具,用户可以通过它们直接上传文件到OSS。但是这两个开源文件都不建议在生产环境使用(POSIX 兼容度低),同时挂 载在用户的客户端需要额外的配置和缓存资源,对于多个客户端的情况安装配置繁琐。通过文件网关的服务可以完美替代 ossfs 和 ossftp。通过创建文件网关,用 户只需要执行简单的挂载(NFS)和映射(Windows SMB)就可以像使用本地文件系统一样使用 OSS。

本地数据中心基于 SMB/NFS协议访问对象存储 最佳实践 业务架构 场景描述 本地数据中心在本地存储有限的情况下可以基 于云存储网关搭建一个海量文件系统的文件存 储服务,实现多个数据中心互相之间高效的同步 和共享数据。云存储网关以对象存储 OSS为后 端存储,为云上和云下应用提供业界标准的文件 服务(NFS和 SMB)和块...

Databricks数据洞察

阿里云Databricks数据洞察是基于Apache Spark的全托管数据分析平台, 内核采用更高效、稳定的商业版Databricks Runtime和Delta Lake。可满足数据分析师、数据工程师和数据科学家在大数据场景下对数据湖分析、实时数仓、离线数仓、BI数据分析、AI机器学习等需求

满足高性能、高稳定性、可弹性的计算需求.Databricks Delta Lake为数据湖分析提供了ACID事务能力,轻松处理包含数十亿文件的PB级表的元数据信息,实现了批流一体的数据处理方式.同时满足数据科学家、数据工程师以及业务分析师的计算需求,提供交互式的协同分析工作平台.计算存储分离,减少数据冗余,实现多引擎间的数据共享...

来自:

云产品

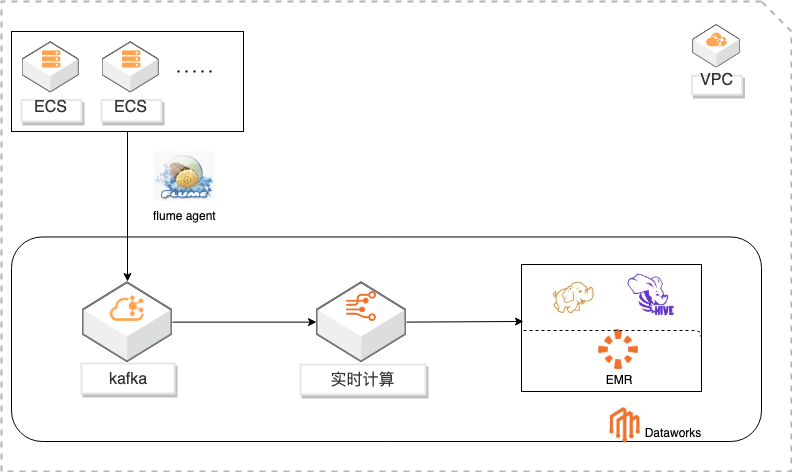

基于DataWorks的大数据一站式开发及数据治理

概述 基于Dataworks做大数据一站式开发,包含数据实时采集到kafka通过实时计算对数据进行ETL写入HDFS,使用Hive进行数据分析。通过Dataworks进行数据治理,数据地图查看数据信息和血缘关系,数据质量监控异常和报警。 适用场景 日志采集、处理及分析 日志使用Flink实时写入HDFS 日志数据实时ETL 日志HIVE分析 基于dataworks一站式开发 数据治理 方案优势 大数据一站式开发,完善的数据治理能力。 性能优越:高吞吐,高扩展性。 安全稳定:Exactly-Once,故障自动恢复,资源隔离。 简单易用:SQL语言,在线开发,全面支持UDX。 功能强大:支持SQL进行实时及离线数据清洗、数据分析、数据同步、异构数据源计算等Data Lake相关功能 ,以及各种流式及静态数据源关联查询。

基于 hive的离线分析 Hive是一个数据仓库基础工具在 Hadoop中用来处理结构化数据。它架构在 Hadoop 之上,提供简单的 sql查询功能,可以将 sql语句转换为 MapReduce任务进行运行。Hive 的最佳使用场合是大数据集的批处理作业,例如,网络日志分析。本章主要通过 hive对存储在 hdfs上的日志进行分析,获取错误日志记录。整体...

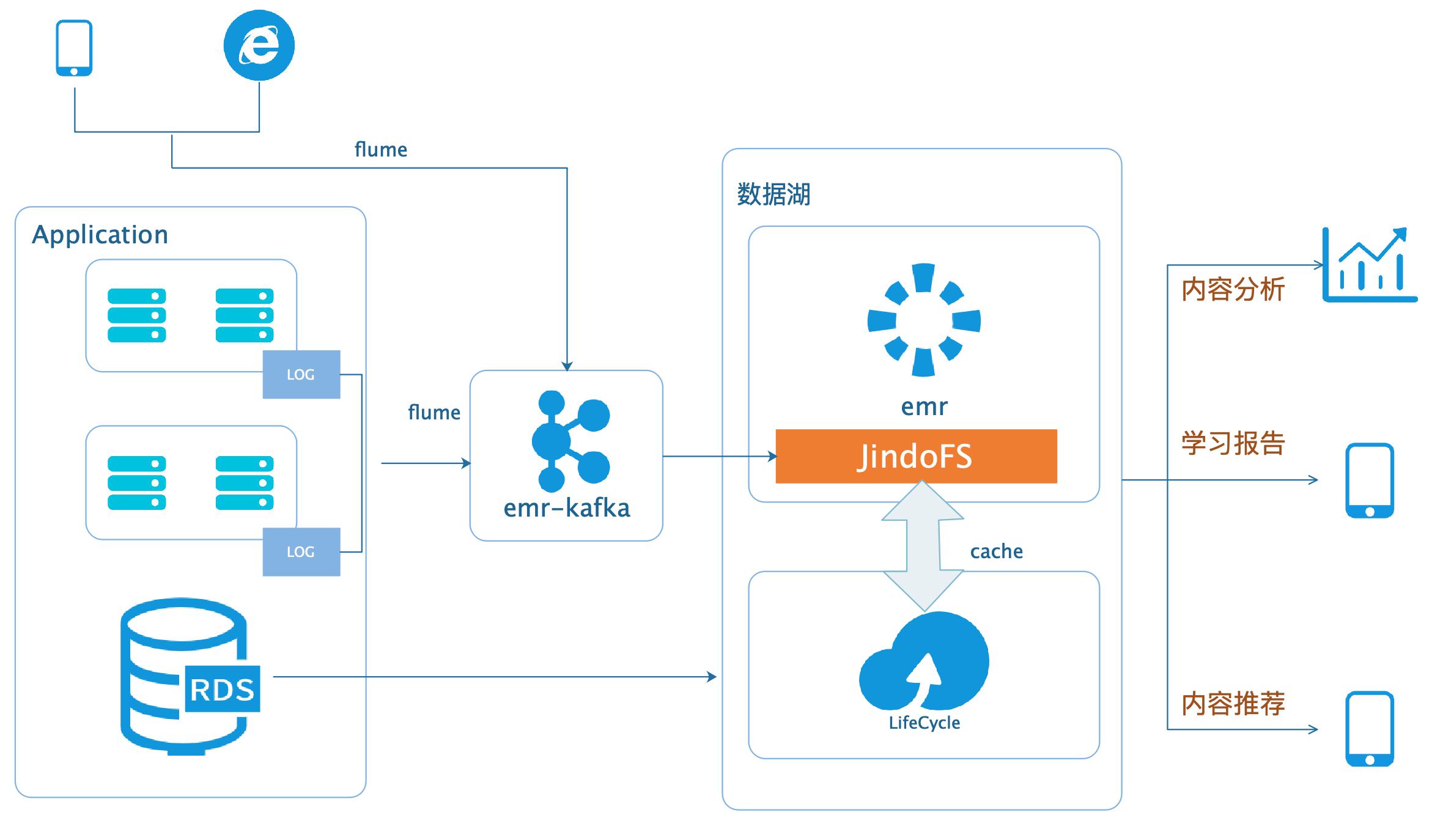

数据湖-在线学习场景数据分析

场景描述 本场景以在线教育中一个答题闯关类的应用为 例,使用WebServer来模拟演示这类日志数据 的分析处理。通过Nginx和Pythonflask搭建 WebServer,模拟应用中的关键页面,比如登 录、课程内容等,之后构造若干用户使用的模拟 日志数据,投递到数据湖进行分析后获取应用 PV、UV、课程内容访问排行、平均得分等等。 解决问题 基于数据湖(EMR+OSS)搭建大数据平台。 EMR和OSS使用和配置。 数据统一存储到OSS。 产品列表 E-MapReduce 对象存储OSS 云服务器ECS 访问控制RAM 专有网络VPC

数据湖-在线学习场景数据分析 最佳实践 场景描述 业务架构 本场景以在线教育中一个答题闯关类的应用为例,使用WebServer来模拟演示这类日志数据的分析 处理。通过Nginx和Python flask搭建Web Server,模拟应用中的关键页面,比如登录、课程 内容等,之后构造若干用户使用的模拟日志数据,投递到数据湖进行分析后获取应用PV...

- 产品推荐

- 这些文档可能帮助您