跨地域跨账号网络互通方案

跨地域跨账号网络互通方案支持跨地域、跨账号的网络互通,可实现企业云上一张网。当客户业务遍及多地,并且在阿里云多个账号多个地域均部署了服务时,采用该方案可以实现云上资源的灵活使用,提高了企业组网的灵活性和效率,并保障了企业数据的安全性和可控性。

实际情况中可能部分实例无法购买需要根据实际情况调整资源规格,同时因您操作过程中实际使用的流量差异,会导致费用有所变化,请以控制台显示的实际报价以及最终账单为准)云企业网 专有网络VPC 云服务器 ECS 应用场景 技术方案的广泛应用场景 大规模互联网应用多地域部署 互联网应用可根据用户群体分布范围及系统需求,...

来自:

技术解决方案

多媒体数据存储与分发

多媒体数据存储与分发解决方案融合对象存储 OSS、内容分发 CDN 、智能媒体管理 IMM 等产品能力,解决客户多媒体数据存储、处理、加速、分发等业务问题,进而实现低成本、高稳定性的业务目标。本技术解决方案以搭建一个多媒体数据存储与分发服务为例,搭建一个多媒体数据存储与分发服务。

架构与部署 多媒体数据存储与分发 架构采用对象存储 OSS 标准类型提供海量存储空间和高吞吐带宽,结合云弹性计算 ECS、内容分发网络 CDN、智能媒体管理 IMM 等产品,为客户提供源站数据存储和分发完整解决方案,同时结合日志服务 SLS 能力提供可观测数据分析能力。立即部署 40分钟 1元(预估费用不包含域名和加密证书费用,...

来自:

技术解决方案

两地三中心异地多活网络

基于阿里云洛神网络全球基础设施及云原生SDN技术,帮助企业客户在云上快速构建两地三中心跨域多活网络,保障企业核心业务在全球多地域的高品质互联。

实际情况中可能部分实例无法购买需要根据实际情况调整资源规格,同时因您操作过程中实际使用的流量差异,会导致费用有所变化,请以控制台显示的实际报价以及最终账单为准)弹性公网IP 云企业网 转发路由器 数据传输服务 云原生数据库 PolarDB MySQL 版 云解析DNS 负载均衡 应用场景 技术方案的广泛应用场景 异地多活 企业...

来自:

技术解决方案

ECS 数据备份与保护

随着企业核心业务规模不断扩大,需要根据业务需求对生产环境中的关键数据进行定期备份,在发生误操作、病毒感染、或攻击等情况时,能够快速从已有的快照恢复到某个历史状态,从而最大程度减少数据丢失带来的损失。

随着企业核心业务规模不断扩大,需要根据业务需求对生产环境中的关键数据进行定期备份,在发生误操作、病毒感染、或攻击等情况时,能够快速从已有的快照恢复到某个历史状态,从而最大程度减少数据丢失带来的损失。ECS 数据备份与保护 随着企业核心业务规模不断扩大,需要根据业务需求对生产环境中的关键数据进行定期备份,...

来自:

技术解决方案

企业云上网络架构规划

企业云上网络架构规划方案能够为企业提供面向业务的网络架构,确保业务的可靠性,并保持架构的可扩展性和可持续性,以满足未来企业业务增长所需的资源扩容和架构升级。

实际情况中可能部分实例无法购买需要根据实际情况调整资源规格,同时因您操作过程中实际使用的流量差异,会导致费用有所变化,请以控制台显示的实际报价以及最终账单为准)专有网络VPC 云企业网 转发路由器 云服务器 ECS 应用场景 应用场景 企业IDC迁云 企业从IDC搬迁到云上,构建基于业务逻辑的云上网络整体架构,满足企业...

来自:

技术解决方案

企业级云灾备与数据管理

云备份 Cloud Backup 为企业数据安全提供了全方位的云灾备、冷热数据统一管理能力,全面覆盖公共云、混合云以及本地 IDC 生产环境,帮助用户减少因自然灾害、系统故障、运维事故、勒索病毒等造成的数据丢失而带来的业务影响。

云备份 Cloud Backup 为企业数据安全提供了全方位的云灾备、冷热数据统一管理能力,全面覆盖公共云、混合云以及本地 IDC 生产环境,帮助用户减少因自然灾害、系统故障、运维事故、勒索病毒等造成的数据丢失而带来的业务影响。企业级云灾备与数据管理 云备份 Cloud Backup 为企业数据安全提供了全方位的云灾备、冷热数据统一...

来自:

技术解决方案

从海量到价值,泛时序数据一站式分析与洞察

泛时序数据广泛存在于车联网、工业物联网、金融交易、股票分析等业务场景。随着业务增长带来的数据量激增,如何高效地获取和分析这些数据成为业务洞察和决策的关键挑战,Lindorm作为阿里云自研的云原生多模数据库,具备低成本存储、弹性高可用的能力,提供一站式的分析与洞察。

泛时序数据广泛存在于车联网、工业物联网、金融交易、股票分析等业务场景。随着业务增长带来的数据量激增,如何高效地获取和分析这些数据成为业务洞察和决策的关键挑战,Lindorm作为阿里云自研的云原生多模数据库,具备低成本存储、弹性高可用的能力,提供一站式的分析与洞察。从海量到价值,泛时序数据一站式分析与洞察 泛...

来自:

技术解决方案

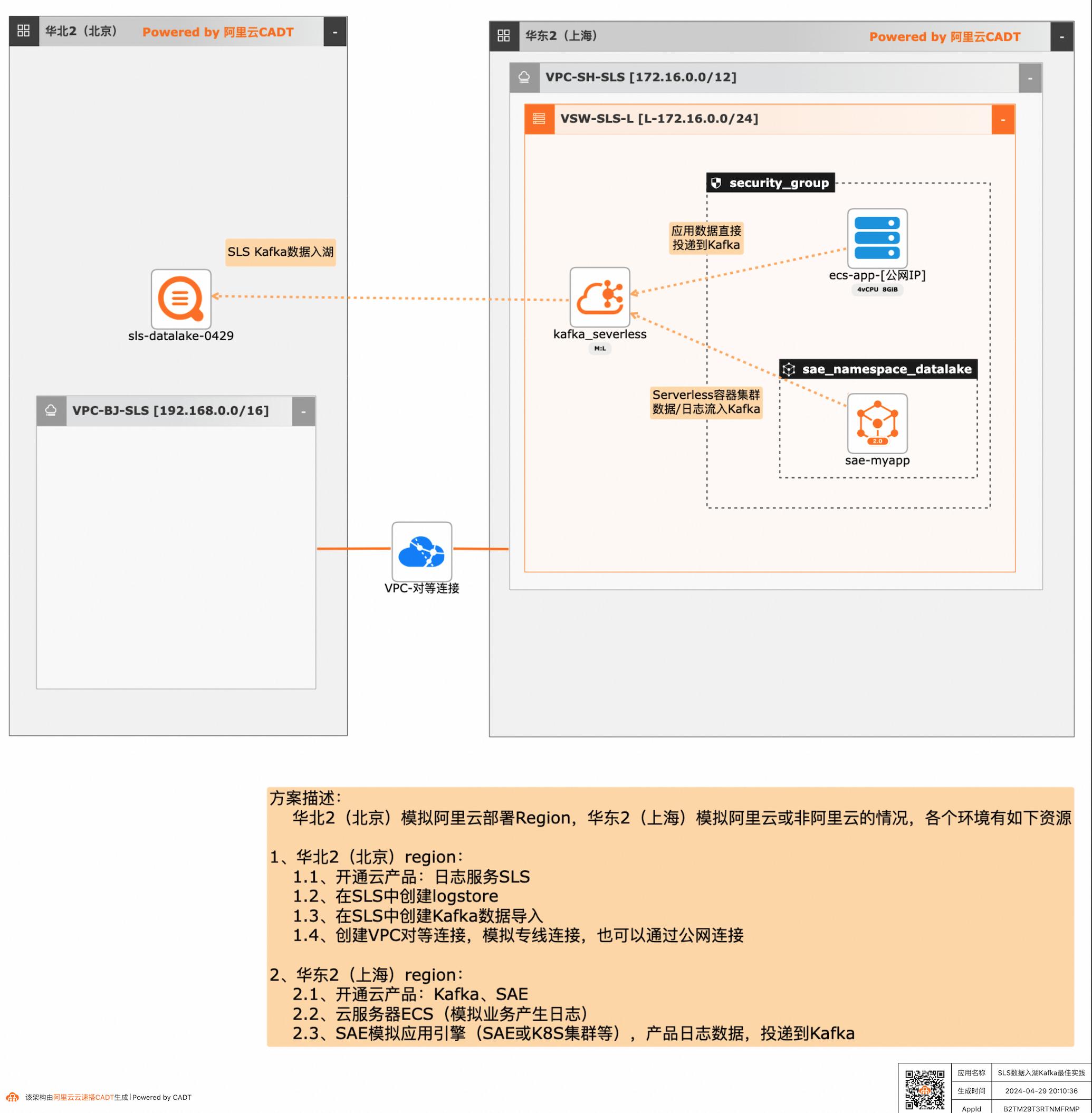

SLS数据入湖Kafka最佳实践

应用和数据分散在多云或混合云,在面对多云/混合云这样大的趋势下,数据无法进行统一的聚合、分析处理和导出等,本方案给出了在多云/混合云场景下,构建通过标准的Kafka协议和托管服务,SLS可以连接Kafka数据入湖导入,然后进行统一的海量数据的集中存储、智能转储、聚合分析查询等。

ECS-Kafka-SLS的数据入湖 步骤1通过CADT画布登录SLS(北京region)控制台,或者通过日志控制台Link访问(https://sls.console.aliyun.com/)步骤2查看在 ecs-app中投递到 kafka的数据(每次 10000条),已经通过 kafka-sls数 据入湖的通道,在sls已经可以查询到:文档版本:20240428 34SLS数据入湖Kafka最佳实践 场景验证 ...

数据安全中心

敏感数据保护(Sensitive Data Discovery and Protection),在满足等保v2.0“安全审计”、等保v3.0及“个人信息保护”的合规要求的基础上,为客户提供敏感数据识别、分级分类、数据安全审计、数据脱敏、智能异常检测等数据安全能力,形成一体化的数据安全解决方案。

增强数据安全保障能力,建立数据分类分级保护基础制度,健全网络数据监测预警和应急处置工作体系.4项国家标准征求意见稿专家审查.2023年5月11日,秘书处组织《IPv6地址分配和编码规则 接口标识符》《信息安全技术 存储介质数据恢复服务安全规范》《信息安全技术 数据交易服务安全要求》《信息安全技术 敏感个人信息处理安全...

来自:

云产品

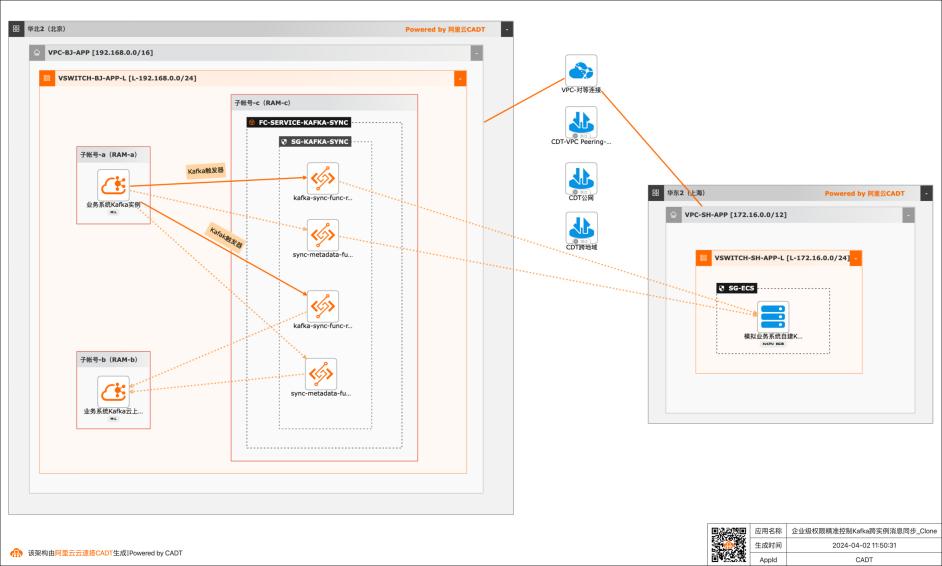

基于函数计算FC实现企业级权限精准控制Kafka跨实例消息同步

应用场景 在大数据场景,企业的Kafka实例可能存在多种情况,比如使用阿里云Kafka服务,可能是自建开源Kafka,或者是其他云上的云Kafka。不同的业务使用不同类型的Kafka实例,在这个前提下Kafka实例之间可能会需要消息同步的情况: 同帐号容灾场景:比如Kafka实例都是阿里云Kafka,但是Kafka实例会有主备之分,需要将主Kafka实例的消息实时同步到备Kafka。 跨帐号或异地容灾:这类场景比如主Kafka是阿里云Kafka,备Kafka是IDC开源自建Kafka,或者是其他云上的Kafka。 不同业务之间消息同步:因为现在的业务通常不会是信息孤岛,都需要消息互通,所以可能是A业务的Kafka实例消息需要同步到B业务的Kafka实例,并且这两个Kafka实例归属不同的RAM角色,有自己独自的权限控制。 解决问题 解决使用开源组件做消息同步的高成本问题。 解决使用开源组件做消息同步的并发性能、稳定性问题。 解决使用开源组件做消息同步的可靠性问题(重试机制,容错机制,死信队列等)。 大幅提升构建消息同步架构的效率,降低构建复杂度问题。

kafka-message-sync.py:同步消息的示例代码 metadata_cloud_kafka_to_idc_kafka.py:阿里云Kafka向自建IDCKafka同步元数 据的示例代码。 metadata_cloud_kafka_to_cloud_kafka.py:阿里云Kafka向阿里云Kafka同步元数 据的示例代码。以上三份Python代码在文档后续内容中会替换到函数计算的函数中。文档版本:...

数据传输服务DTS

阿里云数据传输服务集数据迁移、订阅及实时同步功能于一体,能够解决公共云、混合云场景下,远距离、毫秒级异步数据传输难题,支持关系型数据库、NoSQL、大数据(OLAP)等数据源,其底层基础设施采用阿里双11异地多活架构,为数千下游应用提供实时数据流,已在线上稳定运行7年之久。

根据数据量和网络的情况,迁移所耗费的时间可能会持续数小时甚至数天,对业务影响较大。通过数据传输服务可轻松实现数据一键上云,将停机时间降低到分钟级。在线咨询 能够提供 简单易用 只需配置迁移的源、目标实例及迁移对象,即可实现业务平滑迁移,支持结构迁移、全量数据迁移及增量数据迁移。多种ETL特性 支持库表列三...

来自:

云产品

数据集成 Data Integration

阿里云数据集成 Data Integration是跨异构数据、低成本、弹性扩展的数据采集同步平台,为DataX的商业版,支持ETL,支持50+数据源跨网络离线(全量/增量)同步。

数据集成主要解决异构数据源之间的跨网络数据同步问题.阿里云大数据专业认证是面向使用阿里云大数据产品的架构、开发、运维类人员的专业技术认证.了解数据集成支持的20+异构数据源.如何进行增量数据同步.数据同步任务的脚步模式.创建数据集团的同步任务.查看如何配置数据集成的数据源.数据集成整库迁移介绍.批量化将库中...

来自:

云产品

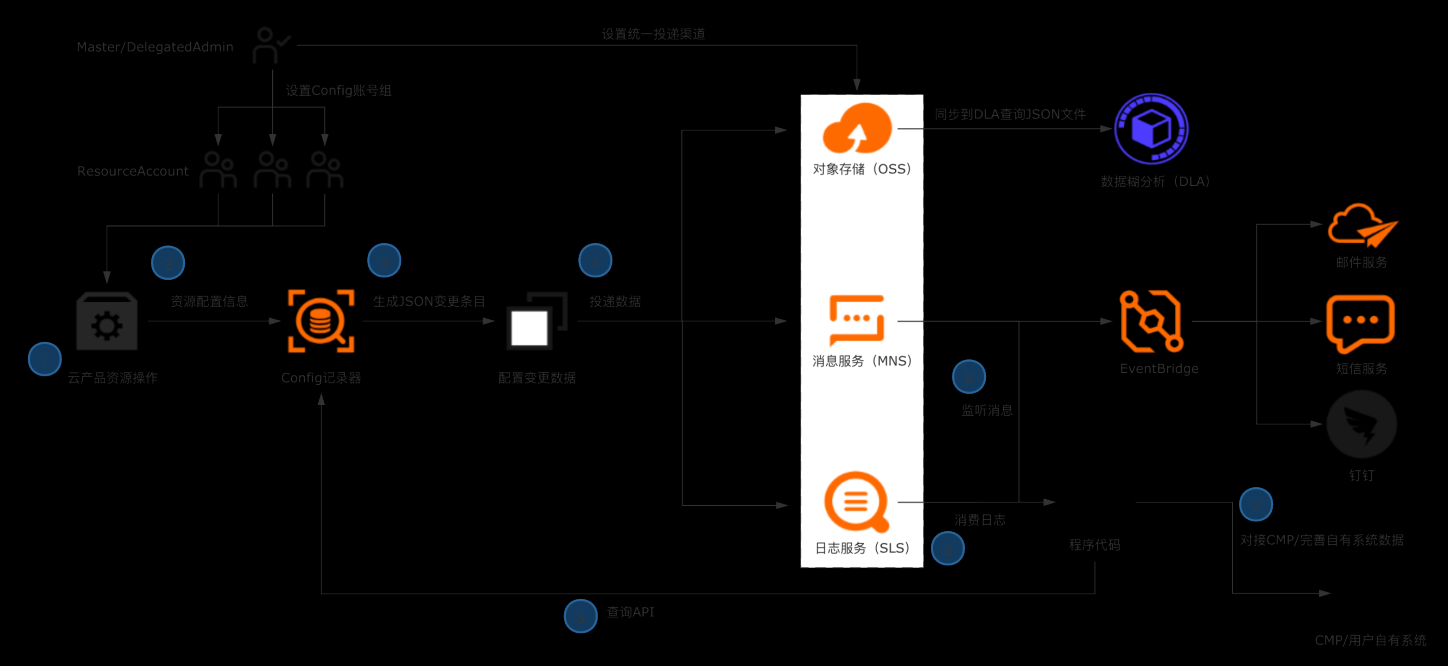

企业构建统一CMDB数据源

典型场景 l 企业/ISV构建多云CMDB平台,对接数十款产品的API,拉取、清洗、格式化、存储配置数据是复杂且高成本的工作。 l 企业日常的资源管理,需依赖资源配置历史、资源关系数据进行故障溯源和影响评估。 解决方案 l 企业管理账号设置Config配置数据投递,将所有账号的资源配置快照和历史归集到统一地址留存。 l 使用OSS做长期归档,使用SLS做实时分析和监听。获取全量资源数据并及时感知云上资源的变更。 l 将数据集成到自有CMDB平台 客户价值 l 基于配置审计简单便捷的持续收集云上资源配置数据,在自建CMDB过程中节省大量人力和时间成本。 l 跨账号统一收集数据,实现中心化的资源配置管理。 l 实现资源配置数据的持续收集和监听,及时感知云上资源的增删改,洞察异常变更。

获取ECS网络信息 本章节,我们以ECS资源的网络配置数据为例,使用 python脚本模拟将资源配置数 据导入企业自有系统。用到了配置审计的 API,在使用前需要导入阿里云 SDK 核心库:aliyun-python-sdk-core:在多账号情况下,列出主账号下指定账号 组的所有资源数据:在多账号情况下,查询指定资源的详细数据 注意:上述两个...

- 产品推荐

- 这些文档可能帮助您