通过PAI-灵骏分布式训练和部署Llama 2模型

以 Meta 最新开源的大语言模型 Llama2 为例,通过PAI-灵骏完成了大语言模型的高效分布式训练、三阶段指令微调、模型离线推理验证以及在线服务部署等完整的开发链路。

步骤包含:资源准备、模型及数据等准备、模型训练、模型离线推理及上传和模型部署这五个阶段。用户在规划好网络和资源、完成资源部署后,可通过Huggingface 或 ModelScope等社区渠道下载Llama2模型,并可在灵骏智算平台的DSW实例中,完成准备预训练数据准备;训练阶段提供多种方案,保障模型效果的同时,提升大模型分布式...

来自:

解决方案

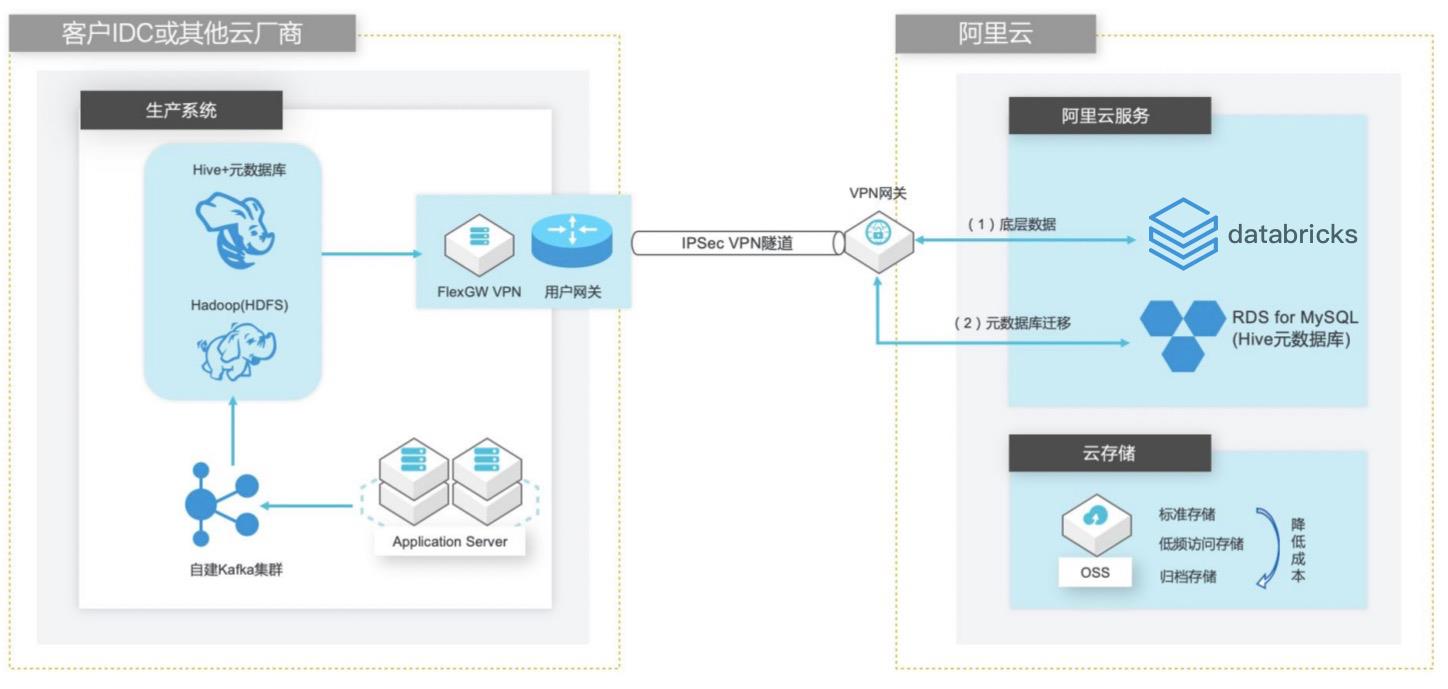

自建Hive数据仓库跨版本迁移到阿里云Databricks数据洞察

场景描述 客户在IDC或者公有云环境自建Hadoop集群构建数据仓库和分析系统,购买阿里云Databricks数据洞察集群之后,涉及到数仓数据和元数据的迁移以及Hive版本的订正更新。 方案优势 1. 全托管Spark集群免运维,节省人力成本。 2. Databricks数据洞察与阿里云其他产品(OSS、RDS、MaxCompute、EMR)进行深度整合,支持以这些产品为数据源的输入和输出。 3. 使用Databricks Runtime商业版引擎相比开源Spark性能有3-5倍的提升。 解决问题 1. Hive数仓数据迁移OSS方案。 2. Hive元数据库迁移阿里云RDS方案。 3. Hive跨版本迁移到Databricks数据洞察使用Delta表查询以提高查询效率。

自建 Hive数据仓库跨版本迁移到阿里云 Databricks数据洞察 业务架构 场景描述 客户在 IDC或者公有云环境自建 Hadoop集群 构建数据仓库和分析系统,购买阿里云 Databricks数据洞察集群之后,涉及到数仓数 据和元数据的迁移以及 Hive版本的订正更新。方案优势 1.全托管 Spark集群免运维,节省人力成 本。2.Databricks数据洞察...

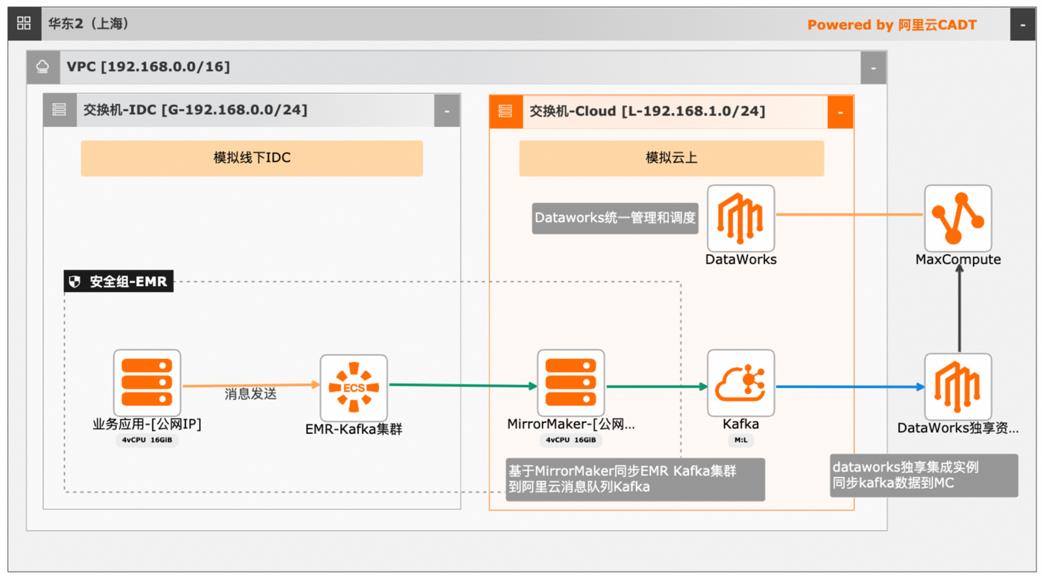

大数据近实时数据投递MaxCompute

本文介绍离线大数据场景使MaxCompute构建云 上近实时数仓,打通云下数据上云链路,解决数据复杂类型支持和动态分区问题,满足高级数据处理需求的最佳实践。 l混合云环境下,现有业务系统零改造,打通数据上云链路。 l使用UDF实现复杂数据类型转换和数据动态分区。 l使用DataWorks配置周期调度业务流程,数据自动入仓。 l借助MaxCompute优化计算引擎,实现降本增效。 产品列表 云服务器ECS 专有网络VPC 访问控制RAM 数据总线DataHub E-MapReduceEMR DataWorks 大数据计算服务MaxCompute

MaxCompute已与数据集成、DataWorks、QuickBI、机器学习 PAI、ADB、推荐引擎、移动数据分析等大数据产 品打通,可快速集成使用,轻松应对各种大数据应用场景。本文以线下现有业务大数据离线数仓建设为背景,介绍如何在现有业务应用系统零 改造的前提下,从 Kafka集群切入,打通数据上云链路,解决数据复杂类型支持和 动态...

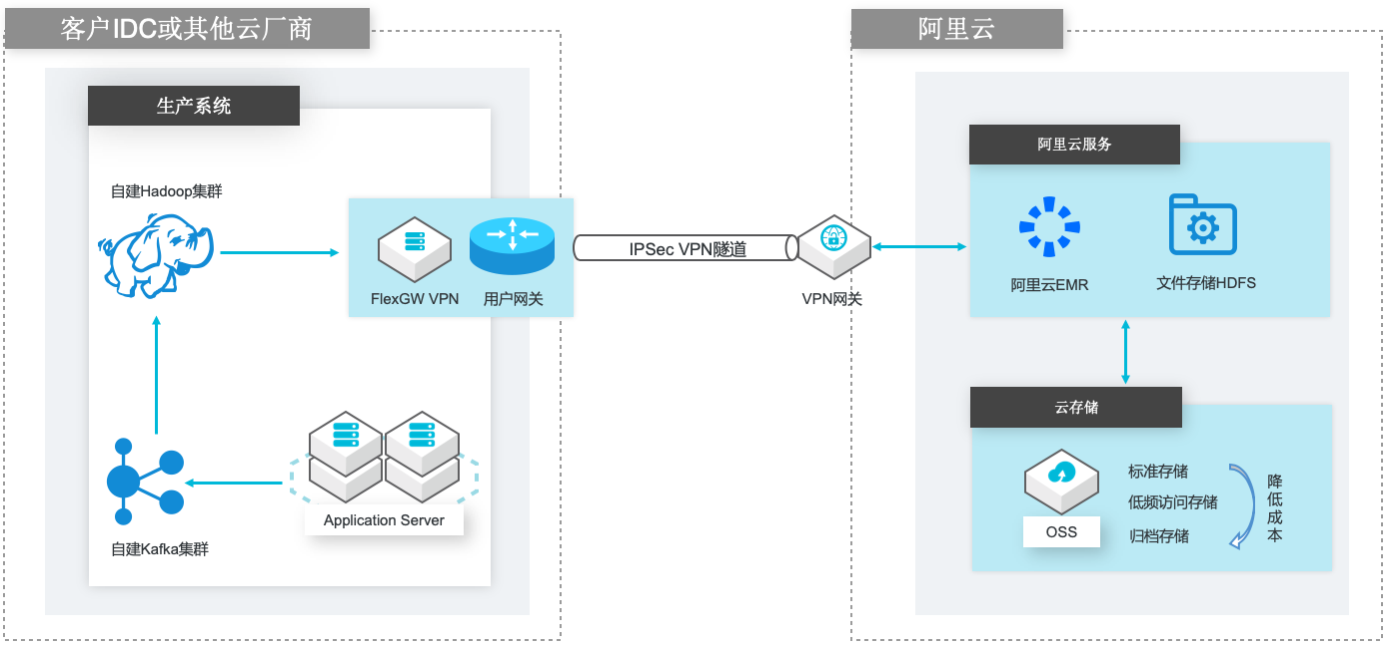

自建Hadoop迁移到阿里云EMR

场景描述 场景1:自建Hadoop集群数据(HDFS)迁移到 阿里云EMR集群的HDFS文件系统; 场景2:自建Hadoop集群数据(HDFS)迁移到 计算存储分离架构的阿里云EMR集群,以OSS 和JindoFS作为EMR集群的后端存储。 解决的问题 客户自建Hadoop迁移到阿里云EMR集群的 技术方案; 基于IPSecVPN隧道构建安全和低成本数据 传输链路 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

VPN网关 VPN网关是一款基于 Internet的网络连接服务,通过加密通道的方式实现企业数 据中心、企业办公网络或 Internet终端与阿里云专有网络(VPC)安全可靠的连 接。VPN 网关提供 IPSec-VPN 连接和 SSL-VPN 连接。详情请查看 https://www.aliyun.com/product/vpn IPSec VPN 基于路由的 IPSec-VPN,不仅可以更方便的配置和...

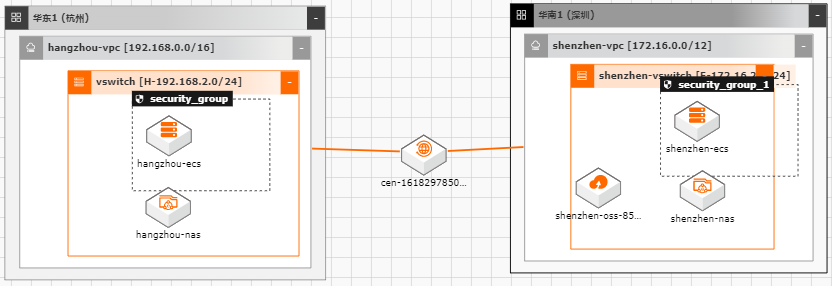

数据迁移上云

随着越来越多的企业选择将业务系统上云,各种类型的数据如何便捷、平滑的迁移上 云,成了用户上云较为关注的点;业务上云后,因为业务或者其他方面调整等因素, 也存在如跨区域,跨账号等数据迁移的场景。针对以上需求,阿里云上提供了较为丰 富的工具(如ossimport)、服务(在线迁移服务),旨在能够帮助客户便捷进行数据迁 移。 本文通过云架构设计工具CADT来快速创建云上基础资源,并以杭州区域来模拟线 下IDC(或友商),深圳区域模拟阿里云云上资源。通过云上的工具命令、服务来提 供常见数据迁移场景的最佳实践。

广泛应用于容器存储、大数据分析、Web 服务和内容管 理、应用程序开发和测试、媒体和娱乐工作流程、数据库备份。支持冷热数据分级 存储。详见:https://www.aliyun.com/product/nas 云服务器 ECS:云服务器 ECS(Elastic Compute Service)是一种弹性可伸缩的 计算服务,助您降低 IT 成本,提升运维效率,使您更专注于核心...

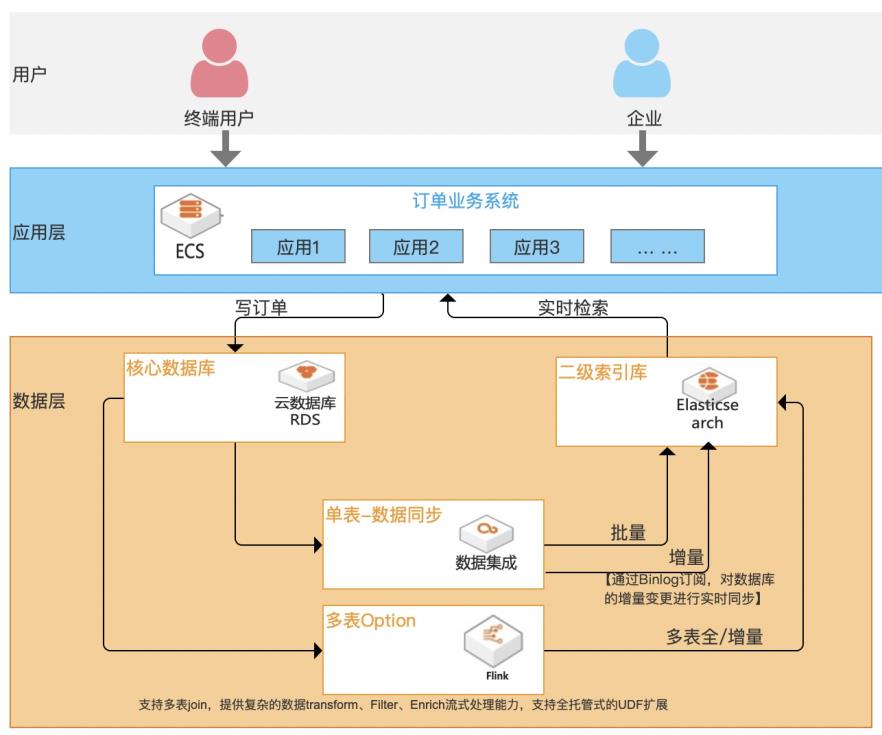

基于Elasticsearch的订单检索加速最佳实践

随着企业信息化程度越来越高,核心业务数据存储在传统关系型数据库中不可避免地会遇到一个问题:单表记录不断增多,数据检索速度会变慢,尤其是对中文的模糊查询(建立普通索引完全不起作用)。虽然数据库自身在不断完善,但效果有限且没办法灵活扩展,复杂场景无法应对。 本方案基于阿里云Elasticsearch作为二级索引库,数据集成产品提供Binlog实时订阅,实时解析、增量数据实时更新及二级索引库之间进行数据实时同步,为数据库提供“能力增益”, 不仅能从根本解决主库抗压问题,提升稳定性;同时支持高效率、高性能、高弹性、低成本、多复杂场景的检索加速服务。

步骤11 回到 rds的 dms界面中,对表 trading_order插入数据,再到 Elasticsearch中查看数 据。(dms登录方式本可查看文档章节 2.4创建 rds订单表”。在上图 dms中使用 insert into语句插入一条数据到 trading_order表中:insert into trading_order(order_amount,source_type,consignee_ada,order_type,company,consignee_...

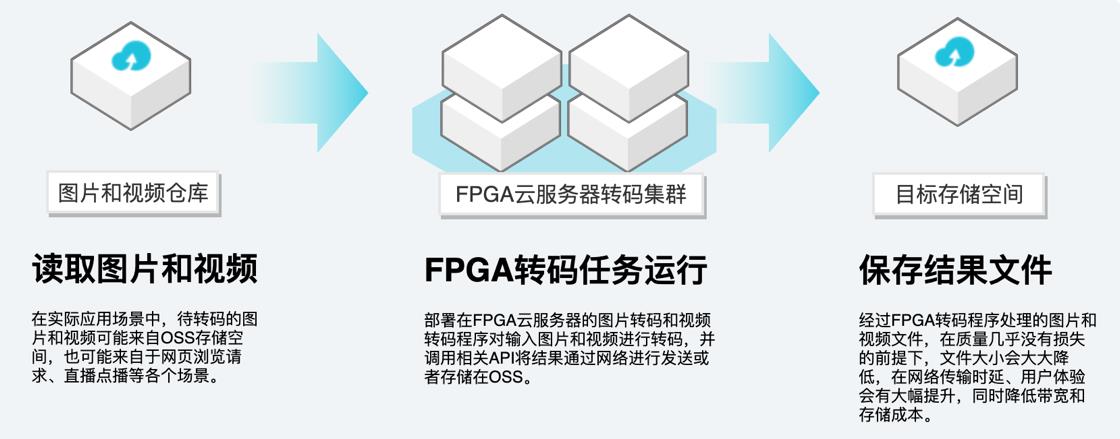

FPGA加速图片和视频转码

场景描述 场景1:图片转码 移动互联网早已进入读图时代,目前的图片都是 JPEG格式,尺寸太大,导致传输占用更多的网络 带宽,花费更多的传输时间并占用更多的存储空 间。JPEG图片转码为WebP/HEIF需要消耗大量的 计算能力。使用阿里云FaaS加速图片转码解决 方案将使客户TCO降低约40%。 场景2:视频转码 到2022年,82%的IP流量都将来自于视频的录 制、上传和播放。HEVC/H.265无论从画质还是码 率,都比H.264有明显的优势,但是将视频将 H.264编码为H.265将消耗巨大的算力。使用阿 里云FaaS加速视频转码将显著降低视频大小, 节省网络流量,降低成本。 解决的问题 通过FPGA云服务器进行高效图片转 码 通过FPGA云服务器进行高效视频转 码 产品列表 VPC,ECS,FPGA,OSS

– 基因组学研究 文档版本:20210906 III 使用 FPGA云服务器加速图片和视频转码 前言 – 数据库加速 – 图片转码,例如 JPEG转 WebP – 实时视频处理,例如 H.265视频压缩 – 加解密 – 大数据过滤、大数据分析 FPGA计算型实例规格族 f1◆f1的特点如下:– I/O优化实例 – 支持 IPv6 – 仅支持 SSD云盘和高效云盘 – 采用 ...

实时同步RDS与Redis构建缓存一致性

通过DTS数据订阅能力,用户可以实时订阅RDS日志数据变更,并将其写入Redis以实现缓存数据的更新,可以实现MySQL与Redis之间的缓存同步一致性。

产品解决方案文档与社区权益中心定价云市场合作伙伴支持与服务了解阿里云备案控制台实时同步RDS与Redis构建缓存...无论是生成报表分析数据,还是进行实时的业务决策,用户都能够在一个集成的环境中完成,提高工作效率和数据准确性。查看详情技术解决方案咨询我们将根据您提交的需求,安排技术解决方案专家为您服务!立即咨询

来自:

解决方案

RDS+ClickHouse构建一站式HTAP

通过融合MySQL和ClickHouse的数据同步能力,用户可以在一个可视化窗口中简单灵活地配置和管理实时数据同步,这为业务报表统计、交互式运营分析和实时数仓构建提供了便利。

无论是生成报表分析数据,还是进行实时的业务决策,用户都能够在一个集成的环境中完成,提高工作效率和数据准确性。方案预估:体验本方案每小时预计产生费用不超过10元(假设您选择下表中的相关规格资源,如果调整了资源规格,请以控制台显示的实际报价以及最终账单为准)方案部署一步步跟随方案教程,带你快速上手,进行...

来自:

解决方案

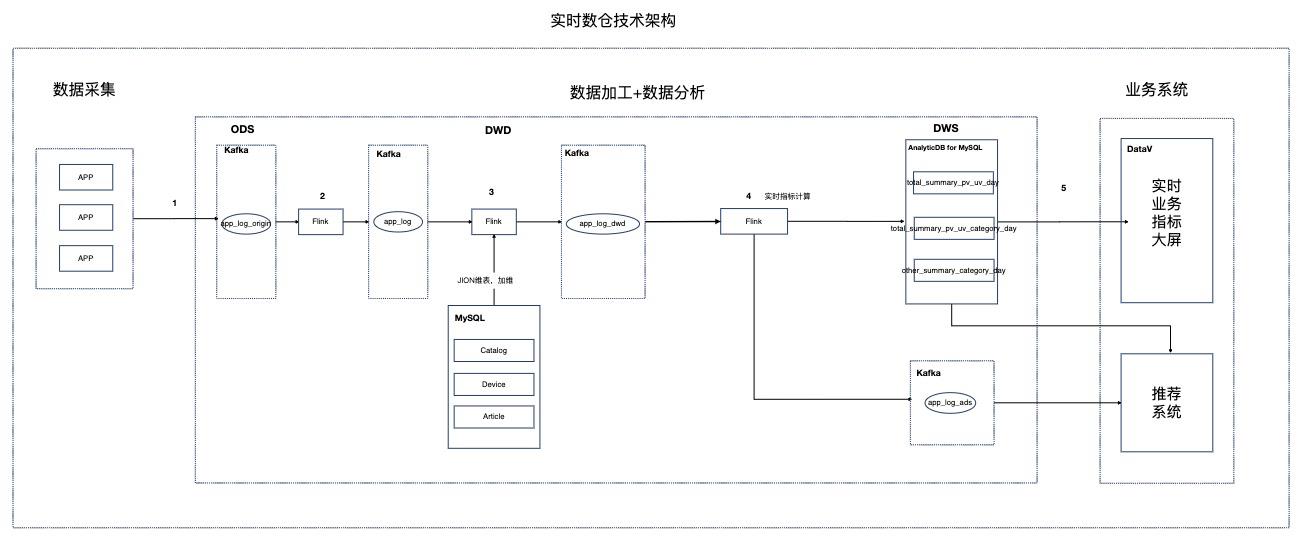

基于Flink的资讯场景实时数仓

场景描述 本实践针对资讯聚合类业务场景,Step by Step介绍 如何搭建实时数仓。 解决问题 1.如何搭建实时数仓。 2.通过实时计算Flink实现实时ETL和数据流。 3.通过实时计算Flink实现实时数据分析。 4.通过实时计算Flink实现事件触发。 产品列表 实时计算 专有网络VPC 云数据库RDSMySQL版 分析型数据库MySQL版 消息队列Kafka 对象存储OSS NAT网关 DataV数据可视化

数据分析包括以下两步:a)通过实时计算 Flink抽取 DWD中对应信息并进行轻度汇总(如部分业务指标 计算),生成 DWS(Data Warehouse Summary,汇总数据层),并将数据存 储到 AnalyticDB for MySQL。b)通过 AnalyticDB for MySQL进行多维数据分析和大屏实时查询。4.业务系统:业务系统通过 DataV数据可视化实现业务指标实时...

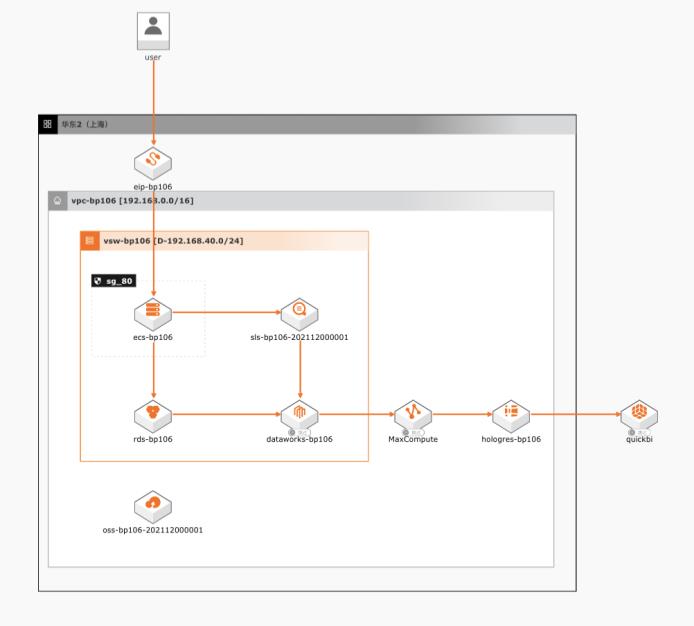

基于MaxCompute的大数据BI分析

场景描述 本文以电商行业为例,将业务数据和日志数据使用 MaxCompute做ETL之后,同步到ADB进行实时 分析,之后通过QuickBI进行快速可视化展示。 解决问题 1.互联网行业、电商、游戏行业等网站、App、 小程序应用内BI分析场景。 2.可扩展到各类网站BI分析场景使用。 产品列表 1.MaxCompute 2.分析型数据MySQL版 3.日志服务SLS 4.QuickBI 5.云服务器ECS 6.RDSMySQL版

步骤3 找到数据表 mc_weblog,拖拽到图中,见下图:文档版本:20211213 95 基于 MaxCompute的大数据 BI分析 数据分析及QuickBI展示 再选择 customer表,拖拽到图中:再新增关联关系:文档版本:20211213 96 基于 MaxCompute的大数据 BI分析 数据分析及QuickBI展示 步骤4 配置 weblog与 product的关联关系 再新增关联关系:...

E-MapReduce

阿里云E-MapReduce(简称EMR)是阿里云云原生数据湖的核心计算引擎,全面支持Hadoop、Spark、HBase、Hive、Flink等大数据组件,为客户提供企业级开源大数据平台服务。通过有效弹性伸缩和数据分层存储机制,相较于传统HDFS固定集群方式,可节省50%以上的费用,同时支持创建抢占式实例,相比按量付费的购买方式,可节省50%~80%的费用。

凌晨DB数据接入的时间成本大大降低,确保所有非特殊要求的DB数据接入都能在1个小时内跑完,大大提升了效率.HDFS,Hive,Kafka迁移到EMR最佳实践.EMR开源大数据迁移专区.EMR弹性低成本离线大数据分析最佳实践.EMR弹性计算实践.通过Serverless StarRocks实现增量数据实时统计.增量数据实时统计实践.通过Serverless StarRocks...

来自:

云产品

云原生大数据计算服务MaxCompute

阿里云云原生大数据计算服务MaxCompute是面向分析的企业级云数仓,作为一体化大数据智能计算平台ODPS的大规模批量计算引擎,MaxCompute以 Serverless 架构提供快速、全托管的在线数据仓库服务,使您经济高效的分析处理海量数据,进行敏捷的业务洞察。

对业务数据分析能力提升并有效监控,更好的业务赋能.阿里云大数据生态满足新业务数据分析需求的“随机应变”能力.快速响应业务需求.推荐搭配使用.目前阿里巴巴淘系已能通过平台自助打标后,在报表中做自助即席多维分析,涵盖1000+自定义维度信息,无需开发同学额外支持,解放人力,减少沟通成本.无需更改blink作业,整体...

来自:

云产品

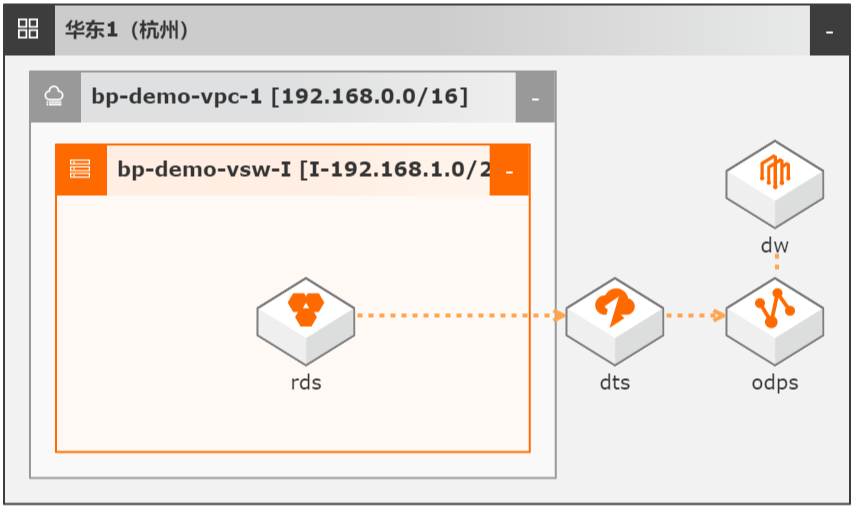

DTS数据同步集成MaxCompute数仓

场景描述 本文Step by Step介绍了通过数据传输服务 DTS实现从云数据库RDS到MaxCompute的 数据同步集成,并介绍如何使用DTS和 MaxCompute数仓联合实现数据ETL幂等和数 据生命周期快速回溯。 解决问题 1.实现大数据实时同步集成。 2.实现数据ETL幂等。 3.实现数据生命周期快速回溯。 产品列表 MaxCompute 数据传输服务DTS DataWorks 云数据库RDS MySQL 版

数据抽取不幂等或容错率低,如凌晨 0:00启动的 ETL任务因为各种原因(数据库 HA切换、网络抖动或 MAXC写入失败等)失败后,再次抽取无法获取 0:00时的数 据状态。2.针对不规范设计表,如没有 create_time/update_time的历史遗留表,传统 ETL需 全量抽取。3.实时性差,抽取数据+重试任务往往需要 1-3小时。另外数据库的数据...

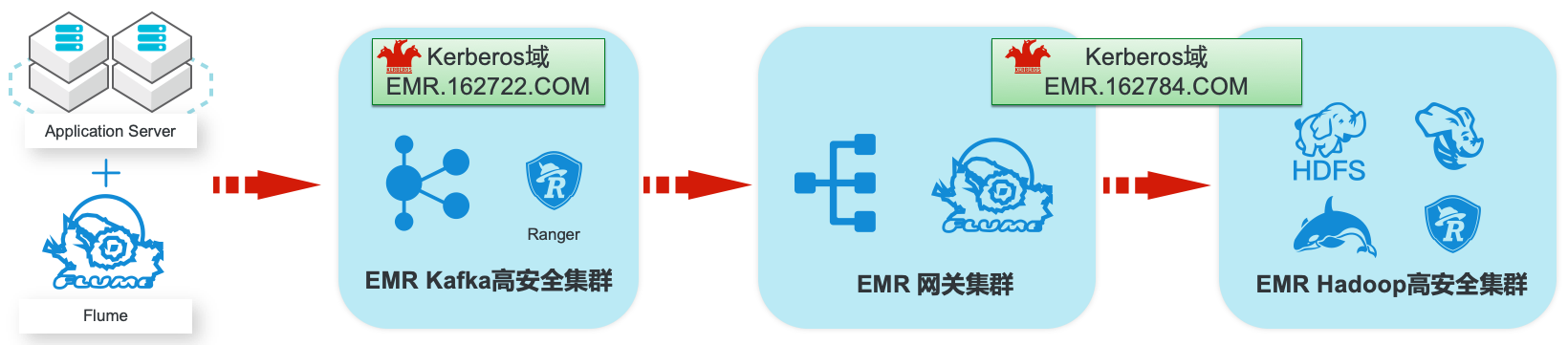

EMR集群安全认证和授权管理

场景描述 阿里云EMR服务Kafka和Hadoop安全集群使 用Kerberos进行用户安全认证,通过Apache Ranger服务进行访问授权管理。本最佳实践中以 Apache Web服务器日志为例,演示基于Kafka 和Hadoop的生态组件构建日志大数据仓库,并 介绍在整个数据流程中,如何通过Kerberos和 Ranger进行认证和授权的相关配置。 解决问题 1.创建基于Kerberos的EMR Kafka和 Hadoop集群。 2.EMR服务的Kafka和Hadoop集群中 Kerberos相关配置和使用方法。 3.Ranger中添加Kafka、HDFS、Hive和 Hbase服务和访问策略。 4.Flume中和Kafka、HDFS相关的安全配 置。 产品列表:E-MapReduce、专有网络VPC、云服务器ECS、云数据库RDS版

提供 用户在云上使用开源技术建设数据仓库、离线批处理、在线流式处理、即时查询、机 器 学 习 等 场 景 下 的 大 数 据 解 决 方 案。详 情 请 查 看 www.aliyun.com/product/emapreduce Kerberos:Kerberos是一种网络身份验证协议,它旨在通过使用密钥加密为客户 端/服务器应用程序提供强身份验证。它提供了网络上的身份...

阿里云数据库快速搭建疫情分析系统最佳实践

疫情态势分析和防控任务迫在眉睫,如果快速搭建高效的疫情态势分析系统是众多部门和单位的难题,阿里云polardb for PG+Ganos解决方案可在极短时间内完成分析系统搭建,有效助力疫情防。 方案优势: 1、性能优越:Ganos作为自研的时空数据库引擎,相比postgis性能更优秀。 2、安全稳定:故障自动切换自愈,资源隔离,多副本存储。 3、简单易用:开箱即用,兼容postgresql,打通quickbi快速搭建数据分析展示。 4、功能强大:相比postgis在时空模型上做了较多扩充,支持几何模型,栅格模型,网络模型,时空轨迹模型,点云模型,拓扑网络模型。

简单易用:开箱即用,兼容 postgresql,打通 quickbi快速搭建数据分析展示。功能强大:相比 postgis在时空模型上做了较多扩充,支持几何模型,栅格模型,网络模型,时空轨迹模型,点云模型,拓扑网络模型。文档版本:20210725 1 阿里云数据库快速搭建疫情分析系统最佳实践 前置条件 前置条件 为了顺利完成本实践,您需要...

数据总线Datahub

数据总线(DataHub)服务是阿里云提供的流式数据(Streaming Data)服务,它提供流式数据的发布(Publish)和订阅(Subscribe)的功能,拥有高吞吐量、高稳定性、低成本等特点,与阿里云大数据生态系统完美打通,让您可以轻松构建基于流式数据的分析和应用。

通过数据总线,业务数据能够实时汇入大数据系统,缩短数据分析周期.实时计算Flink.实时数据通道.接入多种异构数据并投递到下游多种大数据系统.对互联网公司而言,广告依然是目前主流的变现方式。广告的本质是在卖流量,所以这是一个实时决策、在线转化的过程,离线数据T+1的计算已经不满足业务需求,整个行业需要实时转型....

来自:

云产品

- 产品推荐

- 这些文档可能帮助您