大数据workshop

大数据workshop

在 HoloWeb控制台,选择 SQL编辑器,然后点击新增 SQL窗口,选择对应的数 据库,编辑填写相应的 DDL建表语句(默认数据表的属性是列存模式,列存模式更 适合 OLAP数据分析,数据表的行存模式更适合高 QPS点查询场景)。1.首先创建 ads_province_info表。文档版本:20210628(发布日期)42 阿里云最佳实践大数据 WorkShop ...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

金融专属大数据workshop

实践目标 学习搭建一个实时数据仓库,掌握数据采集、存储、计算、输出、展示等整个业务流程。 整个实时数据仓库系统全部基于阿里云产品进行架构搭建,用户可以掌握并学会运用各个服务组件及各个组件之间如何联动。 理解阿里云原生实时离线一体数仓解决方案架构以及掌握交付落地的实践使用方法。 前置知识要求 熟练掌握SQL语法 对大数据体系系统知识有一定的了解

在HoloWeb控制台,选择SQL编辑器,然后点击新增SQL窗口,选择对应的数 据库,编辑填写相应的DDL建表语句(默认数据表的属性是列存模式,列存模式更 适合OLAP数据分析,数据表的行存模式更适合高QPS点查询场景)。1.首先创建ads_province_info表。文档版本:20210803(发布日期)39阿里云最佳实践金融大数据WorkShop 最佳...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

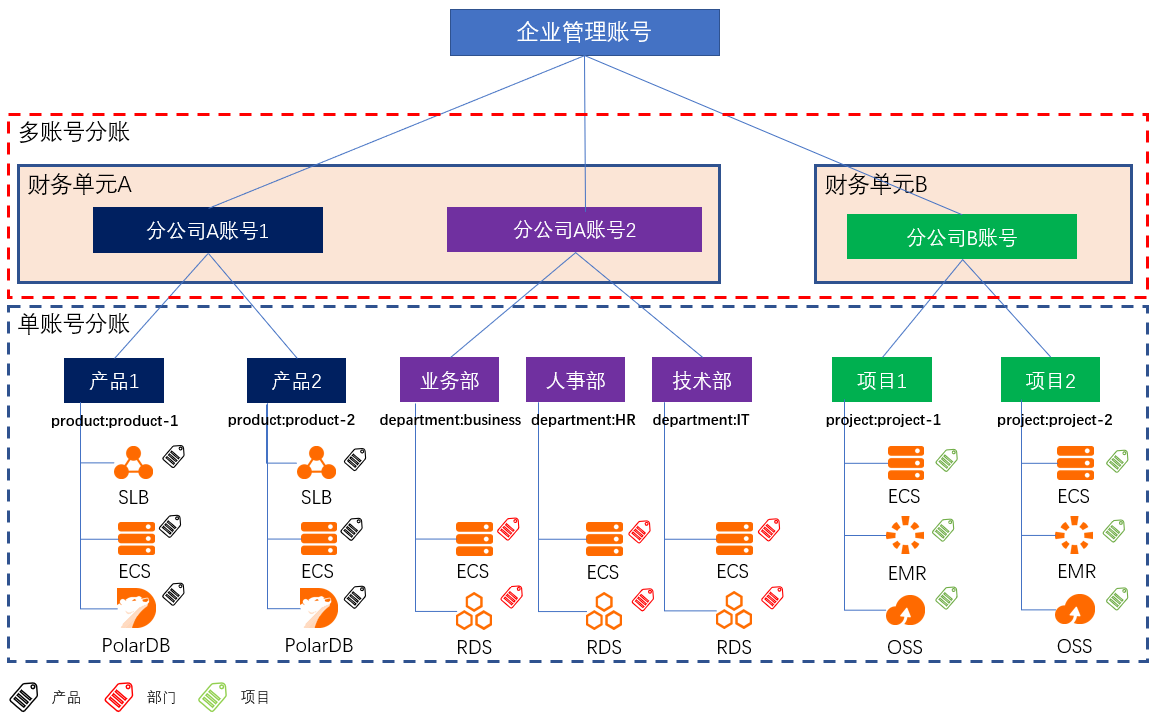

多账号下企业分账

场景描述 财务分账,是根据企业的成本中心,将云上资源的成本划分到给各个项目组/业务部门;助力企业快速梳理云上成本结构,搭建复杂组织架构下的成本关系,便捷地进行财务和云上成本的管理。 大型企业或集团公司,由于组织架构复杂,业务复杂等原因,通常拥有多个阿里云账号来管理规模庞大的云上资源。针对云上资源,如何建立有效的分账方案,是财务关注的重要问题。 解决问题 解决CIO/CTO最关心的云上IT治理,IT成本核算等问题。 弄清楚企业内各部门成本及云上IT成本结构。 让CIO/CTO准确地掌握云上资源成本情况,清楚业务与成本的关系。 让采购/运维轻松搞定每月的IT成本汇报。

将字段账期、财务单元、标签、标签值 拖入数据透视表的行中,对字段应付金额求和。文档版本:20210128 30 多账号下企业分账最佳实践 账单处理与解读 在以上数据透视表中,可以看到在 2021年 1月总共花费 55.76,其中分公司 A应付 9.13,分公司 B应付 46.63。通过标签,我们可以进一步把费用分摊到对应的部门,产品和项目。5...

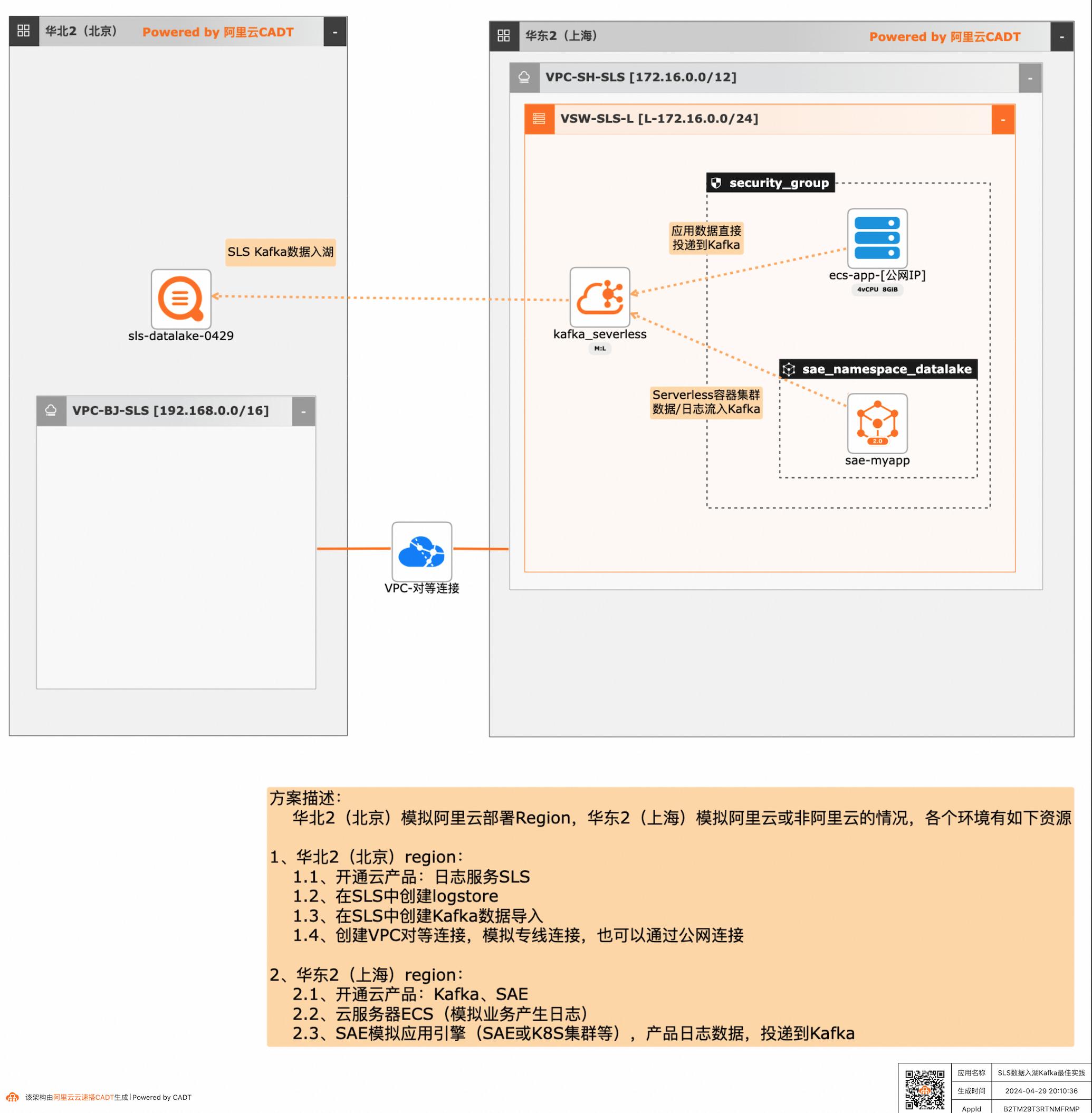

SLS数据入湖Kafka最佳实践

应用和数据分散在多云或混合云,在面对多云/混合云这样大的趋势下,数据无法进行统一的聚合、分析处理和导出等,本方案给出了在多云/混合云场景下,构建通过标准的Kafka协议和托管服务,SLS可以连接Kafka数据入湖导入,然后进行统一的海量数据的集中存储、智能转储、聚合分析查询等。

SLS 数据入湖 Kafka 最佳实践 业务架构 场景描述 应用和数据分散在多云或混合云,在面对多云/混合云这样大的趋势下,数据无法进行统一的 聚合、分析处理和导出等,本方案给出了在多 云/混合云场景下,构建通过标准的Kafka协议 和托管服务,SLS可以连接Kafka数据入湖导 入,然后进行统一的海量数据的集中存储、智 能转储、...

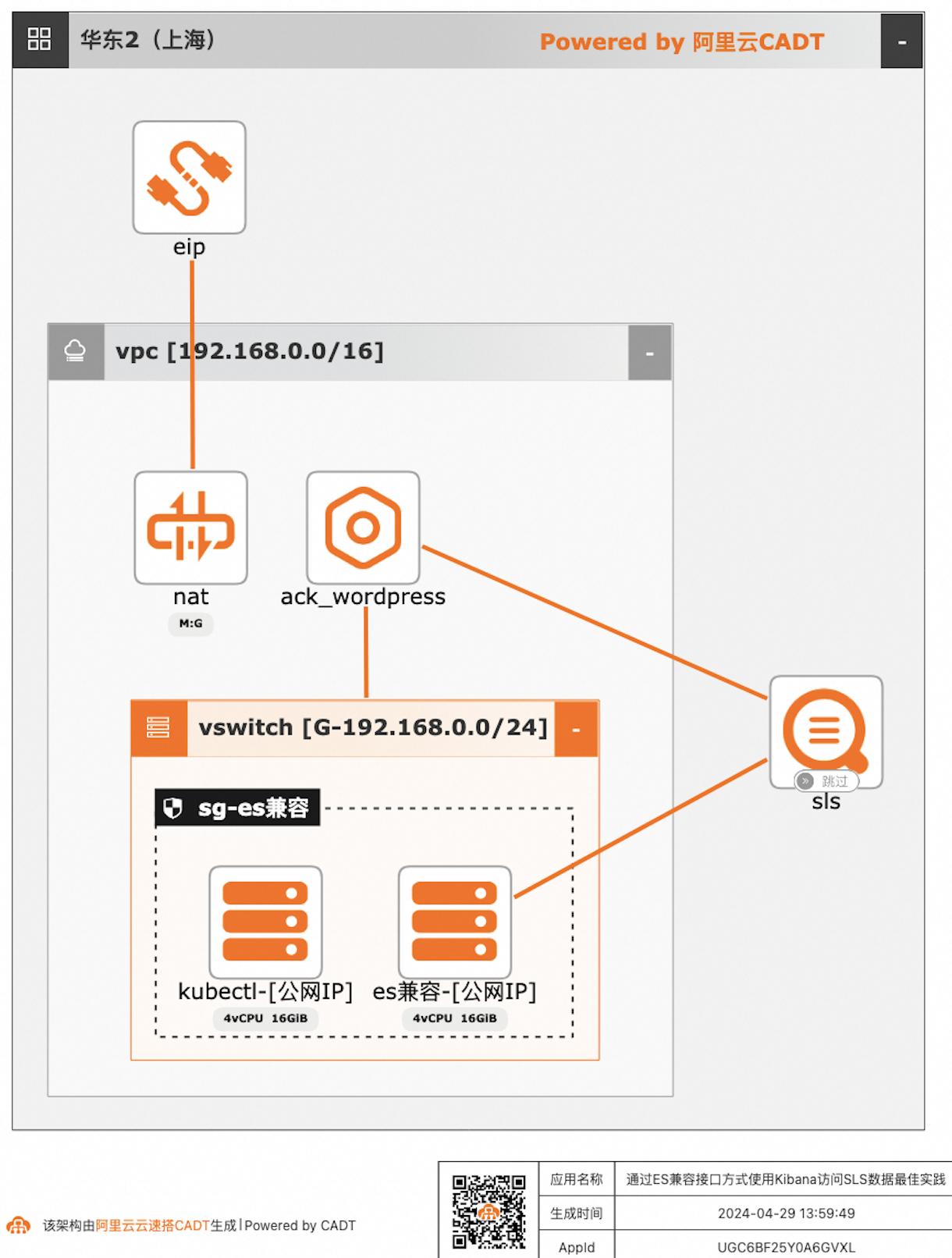

通过ES兼容接口方式使用Kibana访问SLS数据

自建ELK日志系统的客户迁移到阿里云日志服务SLS后,对SLS查询分析语法不太熟悉的客户,可以继续沿用原有的查询分析习惯,在不改变使用方式习惯的情况下,通过Elasticsearch兼容接口的方式使用Kibana访问SLS。

通过ES兼容接口方式使用Kibana访问SLS数据最佳实践 业务架构 场景描述 日志服务SLS提供Elasticsearch兼容接口,支 持客户将日志采集到日志服务后,仍可以继续沿 用Elasticsearch的查询方案,即通过使用 Kibana访问日志服务的Elasticsearch兼容接 口,实现查询SLS数据。应用场景 自建ELK日志系统的客户迁移到阿里云日志服 务...

ECS 数据备份与保护

随着企业核心业务规模不断扩大,需要根据业务需求对生产环境中的关键数据进行定期备份。

产品解决方案文档与社区权益中心定价云市场合作伙伴支持与服务了解阿里云备案控制台ECS 数据备份与保护方案介绍方案优势应用场景方案部署ECS 数据备份与保护随着企业核心业务规模不断扩大,需要根据业务需求对生产环境中的关键数据进行定期备份,在发生误操作、病毒感染、或攻击等情况时,能够快速从已有的快照恢复到某个...

来自:

解决方案

无代理ECS数据备份与高效环境搭建

本方案是基于快照提供数据保护和环境搭建的解决方案。可以帮助您实现无代理且有效可靠的数据备份,同时还可以帮助您快速克隆部署开发测试环境。使用基于快照的备份不仅简单有效,在数据备份以及恢复中也能保证稳定可靠,同时基于快照的环境搭建,不仅可以免于从0到1搭建环境,还可以将环境、数据等全部打包克隆到新机器上。

产品解决方案文档与社区权益中心定价云市场合作伙伴支持与服务了解阿里云备案控制台无代理ECS备份与高效环境搭建方案介绍方案优势应用场景方案部署方案权益无代理ECS备份与高效环境搭建本方案是基于快照提供数据保护和环境搭建的解决方案,可以帮助您实现无代理且有效可靠的数据备份,同时还可以帮助您快速克隆部署开发测试...

来自:

解决方案

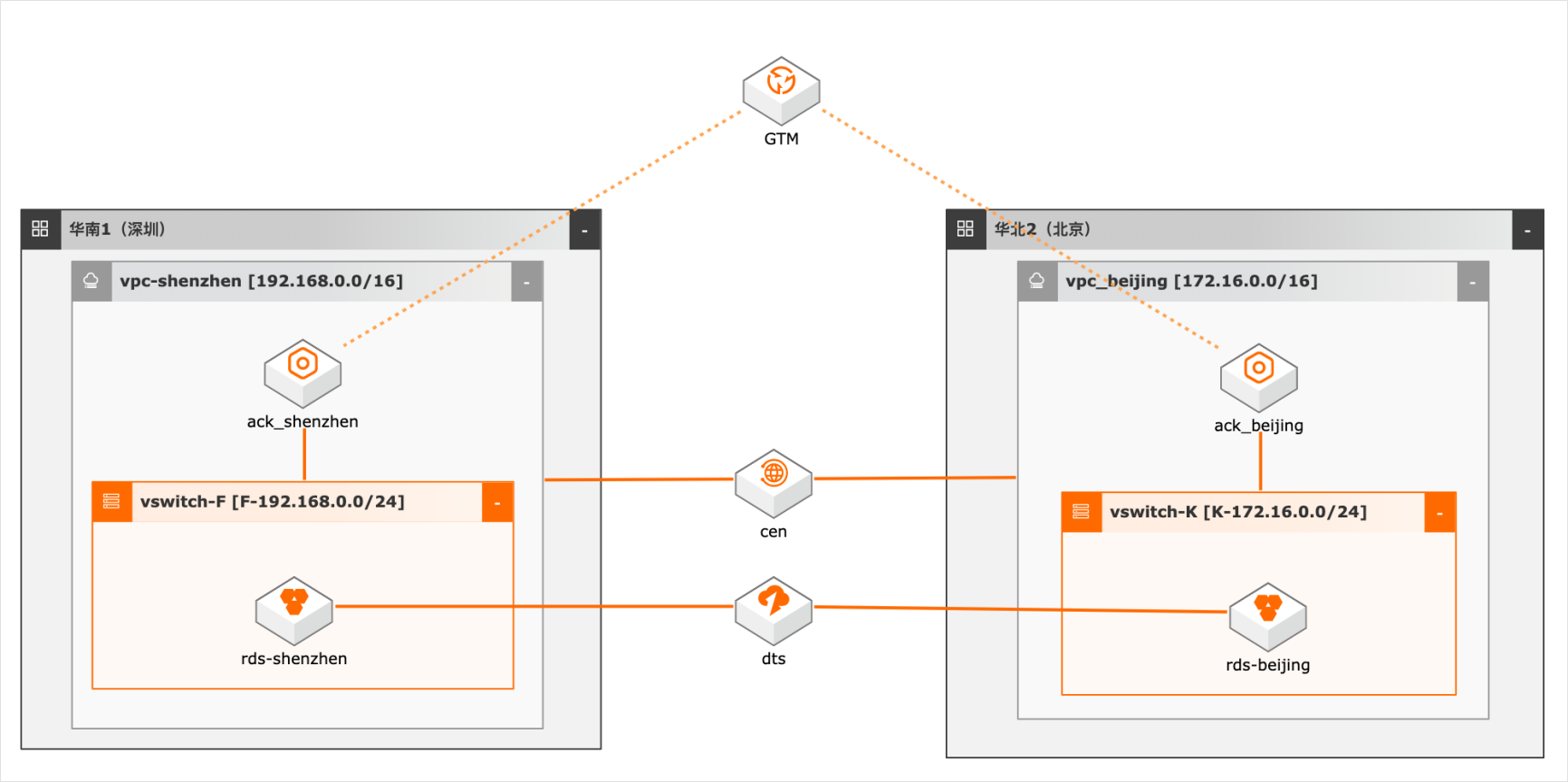

异地双活场景下的数据双向同步

概述 随着客户业务规模的扩大,对系统高可用性要求越来越高,越来越多用户采用异地双活/多活架构,多活架构往往涉及业务侧做单元化改造,本方案仅模拟用户已做单元化改造后的数据双向同步,数据库采用双主架构,本地写本地读,同时又保证双库的数据一致性,为业务增加可用性和灵活性。 适用场景 数据库双向同步 数据库全局ID不冲突 双活架构的数据库建设问题 技术架构 本实践方案基于如下图所示的技术架构和主要流程编写操作步骤: 方案优势 DTS双向同步,采用独立模块避免数据同步占用系统资源。 奇偶ID涉及,避免数据冲突。 DTS多种处理冲突的方式供业务选择。 安全:原生的多租户系统,以项目进行隔离,所有计算任务在安全沙箱中运行。

随着客户业务规模的扩大,对系统高可用性要求越 数据库双向同步 来越高,越来越多用户采用异地双活/多活架构,多 数据库全局 ID不冲突 活架构往往涉及业务侧做单元化改造,本方案仅模 双活架构的数据库建设问题 拟用户已做单元化改造后的数据双向同步,数据库 采用双主架构,本地写本地读,同时又保证双库的数 据一致性,为...

基于DataWorks的大数据一站式开发及数据治理

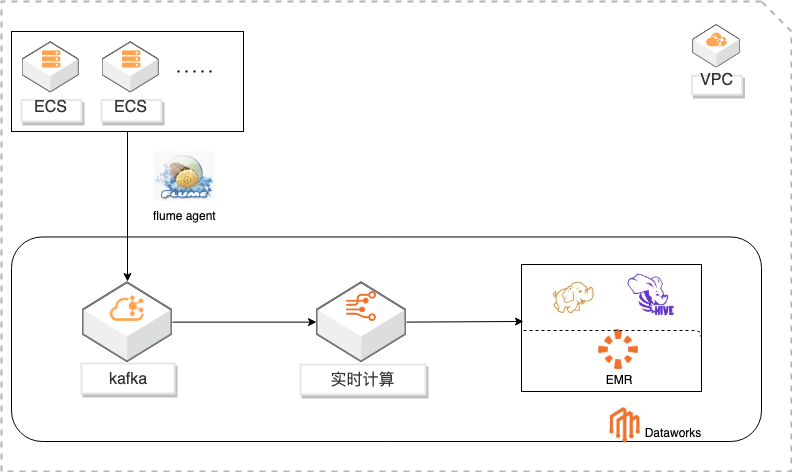

概述 基于Dataworks做大数据一站式开发,包含数据实时采集到kafka通过实时计算对数据进行ETL写入HDFS,使用Hive进行数据分析。通过Dataworks进行数据治理,数据地图查看数据信息和血缘关系,数据质量监控异常和报警。 适用场景 日志采集、处理及分析 日志使用Flink实时写入HDFS 日志数据实时ETL 日志HIVE分析 基于dataworks一站式开发 数据治理 方案优势 大数据一站式开发,完善的数据治理能力。 性能优越:高吞吐,高扩展性。 安全稳定:Exactly-Once,故障自动恢复,资源隔离。 简单易用:SQL语言,在线开发,全面支持UDX。 功能强大:支持SQL进行实时及离线数据清洗、数据分析、数据同步、异构数据源计算等Data Lake相关功能 ,以及各种流式及静态数据源关联查询。

文档版本:20201020 43 基于 Dataworks的大数据一站式开发及数据治理 数据治理 步骤4 添加规格,比如本例监控错误数的波动情况,如果波动上升进行报警,即错误率飙升 的时候给我们报警,进一步查询错误原因。步骤5 可以先试跑测试数据规则。步骤6 关联调度,每次调度后都会检测数据规则。步骤7 添加 hive_log节点进行关联,...

企业级云灾备与数据管理

本方案以备份 ECS 文件为例,介绍如何部署一个简单的云灾备环境,以满足常见的数据保护需求。

产品解决方案文档与社区权益中心定价云市场合作伙伴支持与服务了解阿里云备案控制台企业级云灾备与数据管理方案介绍方案优势应用场景方案部署方案权益企业级云灾备与数据管理云备份 Cloud Backup 为企业数据安全提供了全方位的云灾备、冷热数据统一管理能力,全面覆盖公共云、混合云以及本地 IDC 生产环境,帮助用户减少因...

来自:

解决方案

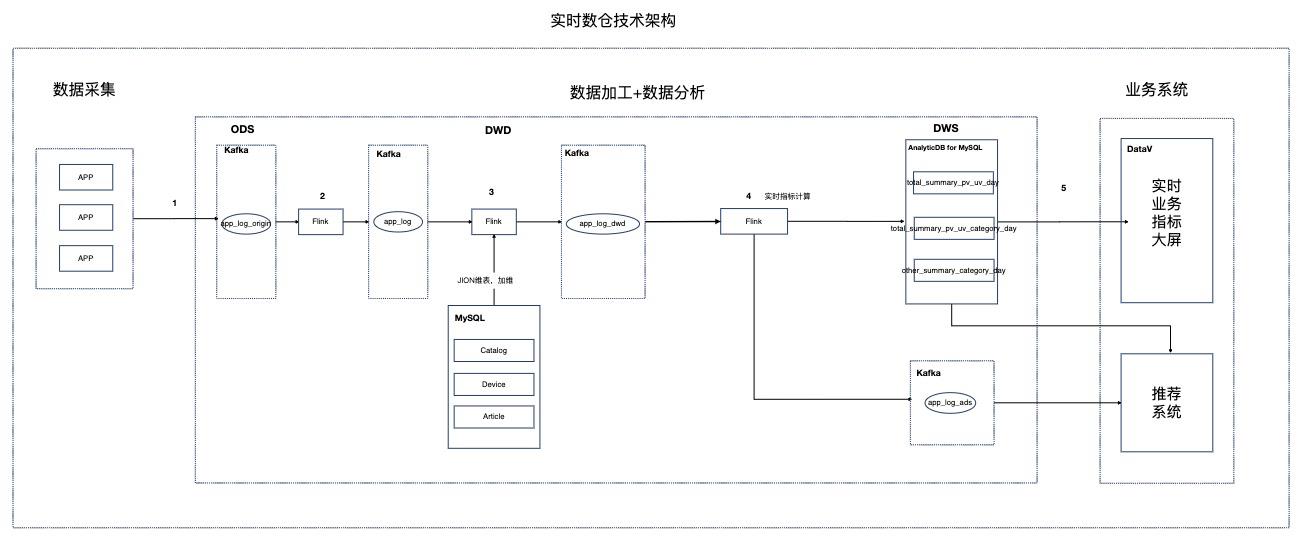

基于Flink的资讯场景实时数仓

场景描述 本实践针对资讯聚合类业务场景,Step by Step介绍 如何搭建实时数仓。 解决问题 1.如何搭建实时数仓。 2.通过实时计算Flink实现实时ETL和数据流。 3.通过实时计算Flink实现实时数据分析。 4.通过实时计算Flink实现事件触发。 产品列表 实时计算 专有网络VPC 云数据库RDSMySQL版 分析型数据库MySQL版 消息队列Kafka 对象存储OSS NAT网关 DataV数据可视化

3.数据加工:消息队列收到的原始数据,往往存在格式不齐或内容不全,需要经过数 据清洗(ETL)之后,才能更好的被下游业务使用。而整个 ETL过程,是实时数 仓架构设计上非常重要的一环,该环节要做到延时小,成本低,可扩展性好,业务 指标计算准确。在系统选型上,推荐使用实时计算 Flink对数据进行处理,因为 Flink具有...

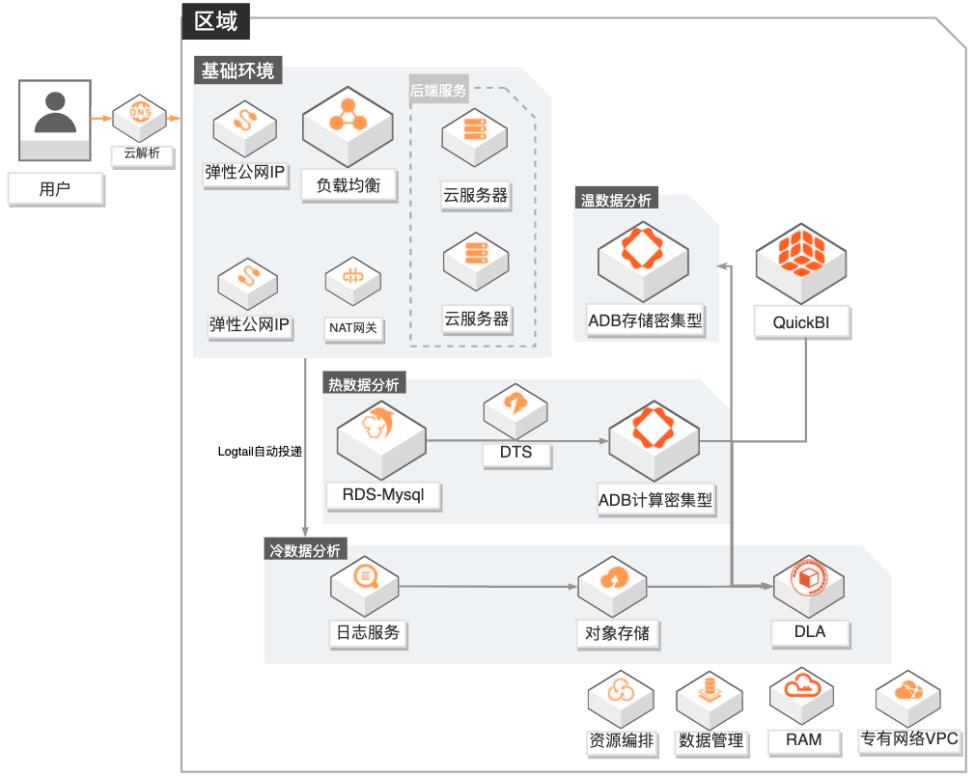

游戏数据运营融合分析

场景描述 1.游戏行业有结构化和非结构化数据融合分 析需求的客户。 2.游戏行业有数据实时分析需求的客户,无法 接受T+1延迟。 3.对数据成本有一定诉求的客户,希望物尽其 用尽量优化成本。 4.其他行业有类似需求的客户。 方案优势/解决问题 1.秒级实时分析:依托ADB计算密集型实例, 秒级监控DAU等数据,为广告投放效果提 供有力的在线决策支撑。 2.高效数据融合分析:打通结构化和非结构化 数据,支撑产品体验分析;广告买量投放效 果实时(分钟级)分析,渠道的评估更准确。 3.低成本:DLA融合冷数据分析+ADB存储密 集型温数据分析+ADB计算密集型热数据分 析,在满足各种分析场景需求的同时,有效 地降低的客户的总体使用成本。 4.学习成本低:DLA和ADB兼容标准SQL语 法,无需额外学习其他技术。 产品列表 专有网络VPC、负载均衡SLB、NAT网关、弹性公网IP 云服务器ECS、日志服务SLS、对象存储OSS 数据库RDSMySQL、数据传输服务DTS、数据管理DMS 分析型数据库MySQL版ADS 数据湖分析DLA、QuickBI

数据融合分析:文档版本:20210224 3 游戏数据运营融合分析 最佳实践概述 ᅳ DLA融合分析(冷数据,全周期,低频查询、大范围跨度查询、关联 ADB 维度数据分析)+ADB存储密集型分析(温数据,1-3个月批量数据分析)+ADB计算密集型(热数据,实时分析)。ᅳ 真正实现云原生数据处理、分析链路闭环,极大提高客户收益。方案...

多媒体数据存储与分发

以搭建一个多媒体数据存储与分发服务为例,搭建一个多媒体数据存储与分发服务。

产品解决方案文档与社区权益中心定价云市场合作伙伴支持与服务了解阿里云备案控制台多媒体数据存储与分发方案介绍方案优势应用场景方案部署方案权益多媒体数据存储与分发视频、图文类多媒体数据量快速增长,内容不断丰富,多媒体数据存储与分发解决方案融合对象存储 OSS、内容分发 CDN、智能媒体管理 IMM 等产品能力,解决...

来自:

解决方案

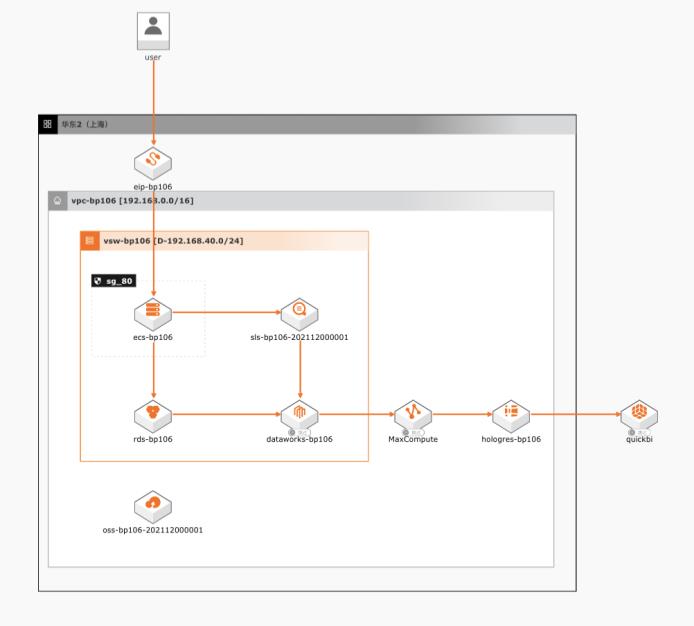

基于MaxCompute的大数据BI分析

场景描述 本文以电商行业为例,将业务数据和日志数据使用 MaxCompute做ETL之后,同步到ADB进行实时 分析,之后通过QuickBI进行快速可视化展示。 解决问题 1.互联网行业、电商、游戏行业等网站、App、 小程序应用内BI分析场景。 2.可扩展到各类网站BI分析场景使用。 产品列表 1.MaxCompute 2.分析型数据MySQL版 3.日志服务SLS 4.QuickBI 5.云服务器ECS 6.RDSMySQL版

文档版本:20211213 1 基于 MaxCompute的大数据 BI分析 最佳实践概述 方案优势 以 Hologres+QuickBI快速实时数据分析的核心能力为切入点,将客户的业务数 据、日志数据引导至阿里云的日志服务和分析性数据库。融合阿里云的日志服务 SLS 的生态,增强用户体验(如无缝对接 Flink、Elasticsearch、RDS、Hologres、EMR、dataV ...

本地数据中心基于SMB/NFS协议访问对象存储最佳实践

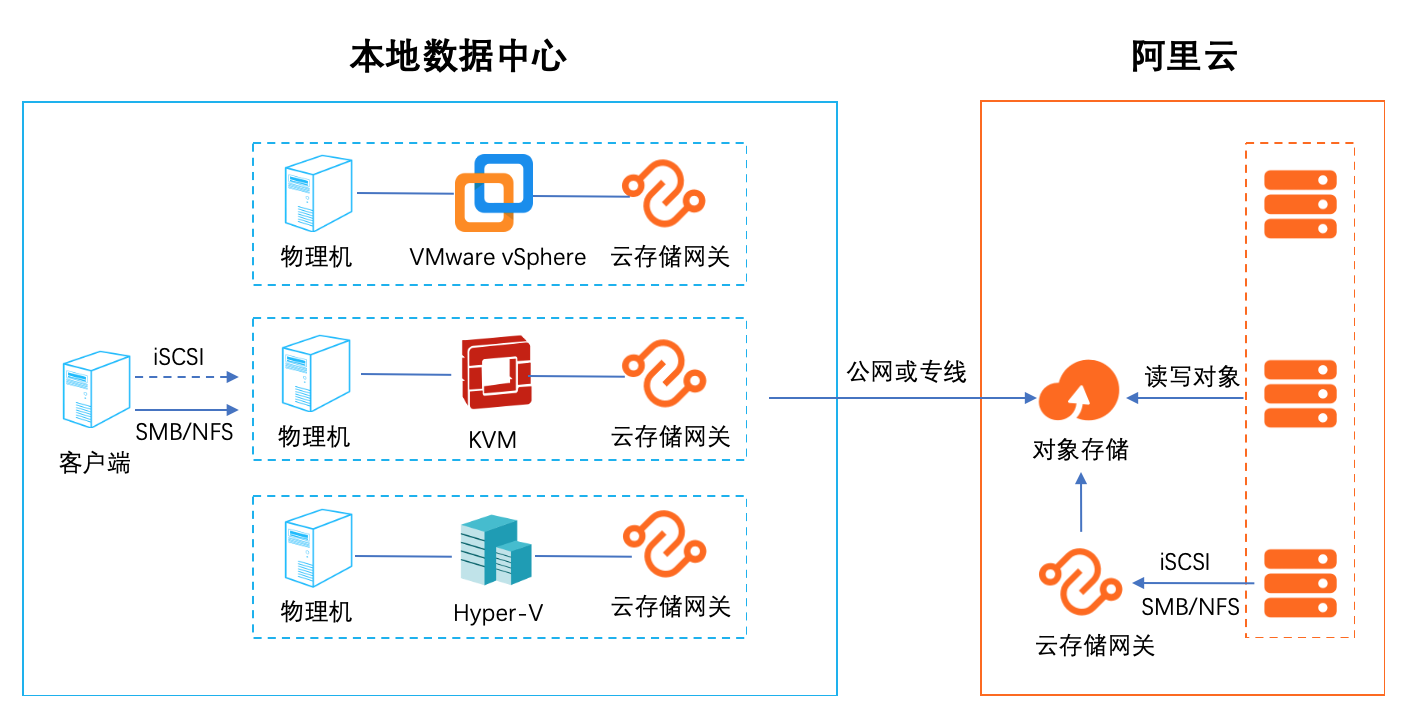

1. 云存储扩容和迁移 集成智能缓存算法,自动识别冷热数据,将热数据保留在本地缓存,保证数据访问体验,无感知的将海量云存储数据接入本地数据中心,拓展存储空间。同时在云端 保留全量数据(冷+热)保证数据的一致性 2.云容灾 随着云计算的普及,越来越多的用户把自己的业务放到了云上。但是随着业务的发展,如何提高业务的可靠性和连续性,跨云容灾是一个比较热门的话题。借助云存 储网关对虚拟化的全面支持,可以轻松应对各种第三方云厂商对接阿里云的数据容灾。 3. 多地数据共享和分发 通过多个异地部署的文件网关实例,对接同一个阿里云OSS Bucket,可以实现快速的异地文件共享和分发,非常适合多个分支机构之间互相同步和共享数据。 4. 适配传统应用 有很多用户在云上的业务是新老业务的结合,老业务是从数据中心迁移过来的使用的是标准的存储协议,例如: NFS/SMB/iSCSI。新的应用往往采用比较新的技 术,支持对象访问的协议。如何沟通两种业务之间的数据是一个比较麻烦的事情,云存储网关正好起到一个桥梁的作用,可以便捷的沟通新旧业务,进行数据交换。 5. 替代 ossfs 和 ossftp ossfs 和 ossftp 都是基于文件协议的开源工具,用户可以通过它们直接上传文件到OSS。但是这两个开源文件都不建议在生产环境使用(POSIX 兼容度低),同时挂 载在用户的客户端需要额外的配置和缓存资源,对于多个客户端的情况安装配置繁琐。通过文件网关的服务可以完美替代 ossfs 和 ossftp。通过创建文件网关,用 户只需要执行简单的挂载(NFS)和映射(Windows SMB)就可以像使用本地文件系统一样使用 OSS。

本地数据中心基于 SMB/NFS协议访问对象存储 最佳实践 业务架构 场景描述 本地数据中心在本地存储有限的情况下可以基 于云存储网关搭建一个海量文件系统的文件存 储服务,实现多个数据中心互相之间高效的同步 和共享数据。云存储网关以对象存储 OSS为后 端存储,为云上和云下应用提供业界标准的文件 服务(NFS和 SMB)和块...

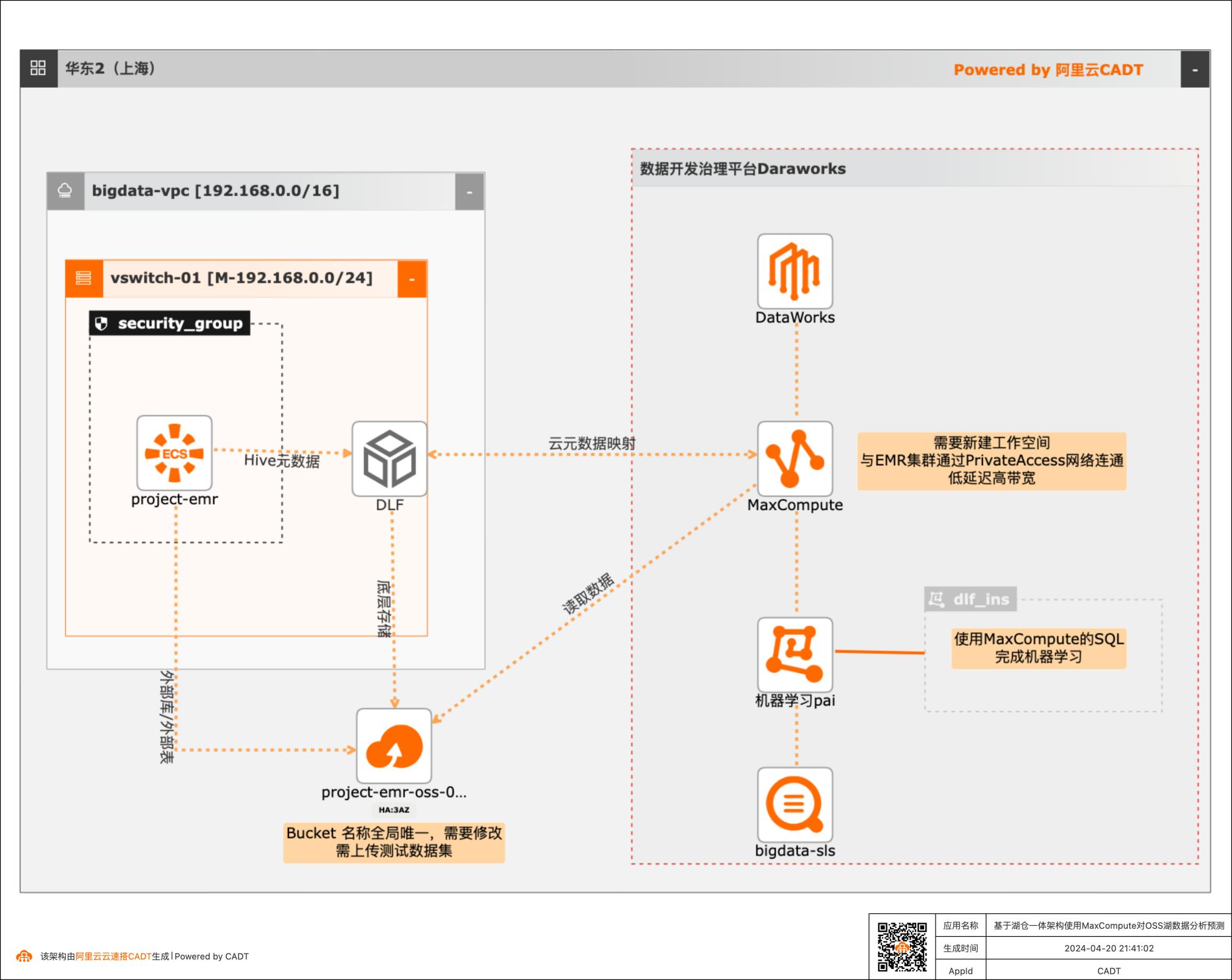

基于湖仓一体架构使用MaxCompute对OSS湖数据分析预测

本篇最佳实践先创建EMR集群作为数据湖对象,Hive元数据存储在DLF,外表数据存储在OSS。然后使用阿里云数据仓库MaxCompute以创建外部项目的方式与存储在DLF的元数据库映射打通,实现元数据统一。最后通过一个毒蘑菇的训练和预测demo,演示云数仓MaxCompute如何对于存储在EMR数据湖的数据进行加工处理以达到业务预期。

基于湖仓一体架构使用MaxCompute对OSS湖数据分析预测实践 业务架构 场景描述 数据湖和数据仓库是当前大数据技术条件下构建分布式系 统的两种数据架构设计取向,数据湖偏向灵活性,数据仓 库侧重成本、性能、安全、治理等企业级特性。但是数据 湖和数据仓库的边界正在慢慢模糊,数据湖自身的治理能 力、数据仓库延伸到外部...

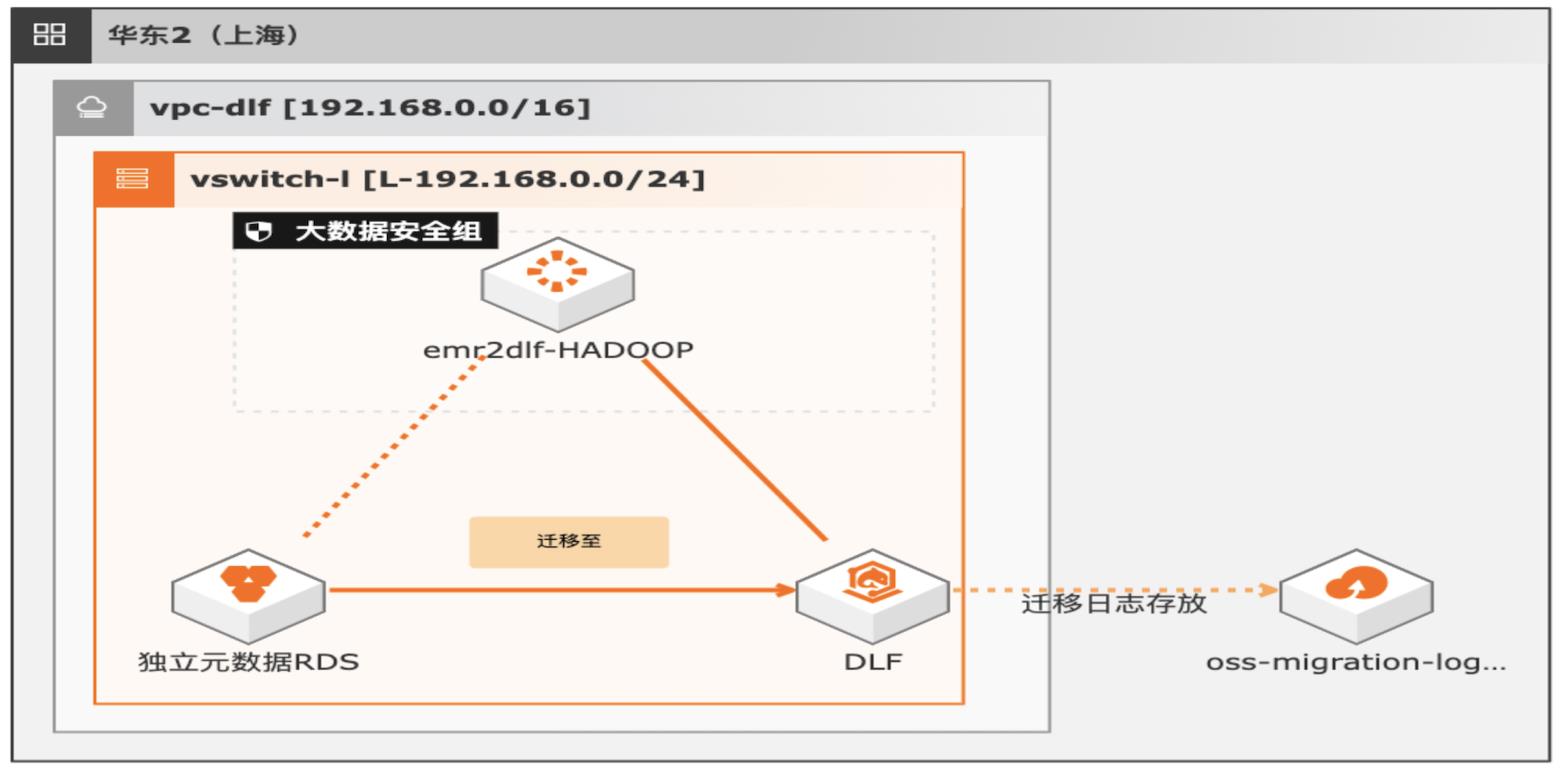

湖仓一体架构EMR元数据迁移DLF

通过EMR+DLF数据湖方案,可以为企业提供数据湖内的统一的元数据管理,统一的权限管理,支持多源数据入湖以及一站式数据探索的能力。本方案支持已有EMR集群元数据库使用RDS或内置MySQL数据库迁移DLF,通过统一的元数据管理,多种数据源入湖,搭建高效的数据湖解决方案。

湖仓一体架构 EMR元数据迁移 DLF最佳实践 业务架构 场景描述 解决的问题 通过 EMR+DLF数据湖方案,可以为企业提供数据 EMR元数据迁移至 DLF 湖内的统一的元数据管理,统一的权限管理,支持多 元数据迁移验证 源数据入湖以及一站式数据探索的能力。本方案支 数据一致性校验 持已有 EMR集群元数据库使用 RDS或内置 MySQL ...

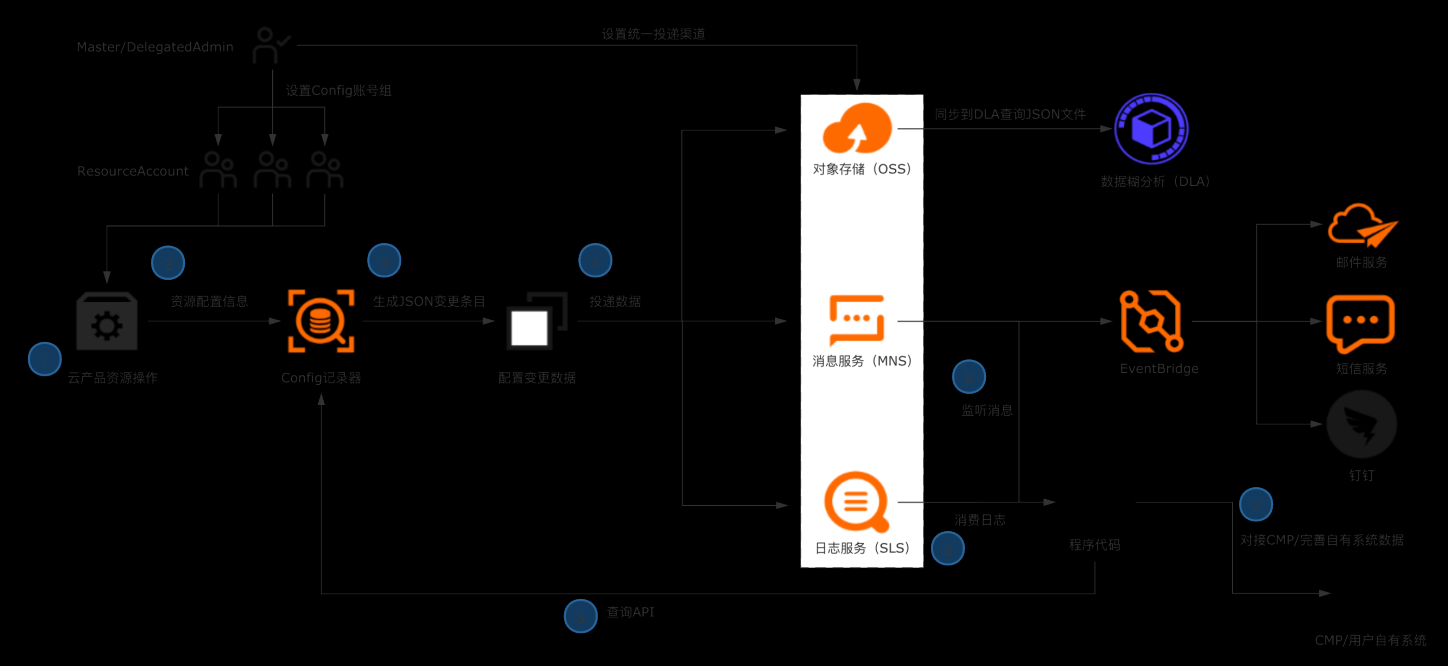

企业构建统一CMDB数据源

典型场景 l 企业/ISV构建多云CMDB平台,对接数十款产品的API,拉取、清洗、格式化、存储配置数据是复杂且高成本的工作。 l 企业日常的资源管理,需依赖资源配置历史、资源关系数据进行故障溯源和影响评估。 解决方案 l 企业管理账号设置Config配置数据投递,将所有账号的资源配置快照和历史归集到统一地址留存。 l 使用OSS做长期归档,使用SLS做实时分析和监听。获取全量资源数据并及时感知云上资源的变更。 l 将数据集成到自有CMDB平台 客户价值 l 基于配置审计简单便捷的持续收集云上资源配置数据,在自建CMDB过程中节省大量人力和时间成本。 l 跨账号统一收集数据,实现中心化的资源配置管理。 l 实现资源配置数据的持续收集和监听,及时感知云上资源的增删改,洞察异常变更。

获取ECS网络信息 本章节,我们以ECS资源的网络配置数据为例,使用 python脚本模拟将资源配置数 据导入企业自有系统。用到了配置审计的 API,在使用前需要导入阿里云 SDK 核心库:aliyun-python-sdk-core:在多账号情况下,列出主账号下指定账号 组的所有资源数据:在多账号情况下,查询指定资源的详细数据 注意:上述两个...

- 产品推荐

- 这些文档可能帮助您