ECS 数据备份与保护

随着企业核心业务规模不断扩大,需要根据业务需求对生产环境中的关键数据进行定期备份,在发生误操作、病毒感染、或攻击等情况时,能够快速从已有的快照恢复到某个历史状态,从而最大程度减少数据丢失带来的损失。

操作过程中可能会根据实际使用的资源流量差异导致费用变化,请以控制台显示的实际报价以及最终账单为准)云服务器 ECS 块存储 应用场景 技术方案的广泛应用场景 日常数据保护 使用自动快照可以定期备份云盘上的数据,并保留一定时长,在需要时能够进行整盘数据恢复。高危操作护航 ECS 实例和云盘进行变配、升级、迁移等运维...

来自:

技术解决方案

企业级云灾备与数据管理

云备份 Cloud Backup 为企业数据安全提供了全方位的云灾备、冷热数据统一管理能力,全面覆盖公共云、混合云以及本地 IDC 生产环境,帮助用户减少因自然灾害、系统故障、运维事故、勒索病毒等造成的数据丢失而带来的业务影响。

云备份 Cloud Backup 为企业数据安全提供了全方位的云灾备、冷热数据统一管理能力,全面覆盖公共云、混合云以及本地 IDC 生产环境,帮助用户减少因自然灾害、系统故障、运维事故、勒索病毒等造成的数据丢失而带来的业务影响。企业级云灾备与数据管理 云备份 Cloud Backup 为企业数据安全提供了全方位的云灾备、冷热数据统一...

来自:

技术解决方案

从海量到价值,泛时序数据一站式分析与洞察

泛时序数据广泛存在于车联网、工业物联网、金融交易、股票分析等业务场景。随着业务增长带来的数据量激增,如何高效地获取和分析这些数据成为业务洞察和决策的关键挑战,Lindorm作为阿里云自研的云原生多模数据库,具备低成本存储、弹性高可用的能力,提供一站式的分析与洞察。

在线部署 适用客户 有车联网、金融、日志等海量数据处理场景 寻求“宽表+搜索+分析”大数据组合方案的一站式替代 方案优势 为什么选择 Lindorm 使用Lindorm对泛时序数据进行一站式的处理分析,不仅在开发效率和成本效益上超越传统自建方式,更在性能优化和运维便捷性上提供卓越表现。预处理效率高 支持接收实时数据,进行流...

来自:

技术解决方案

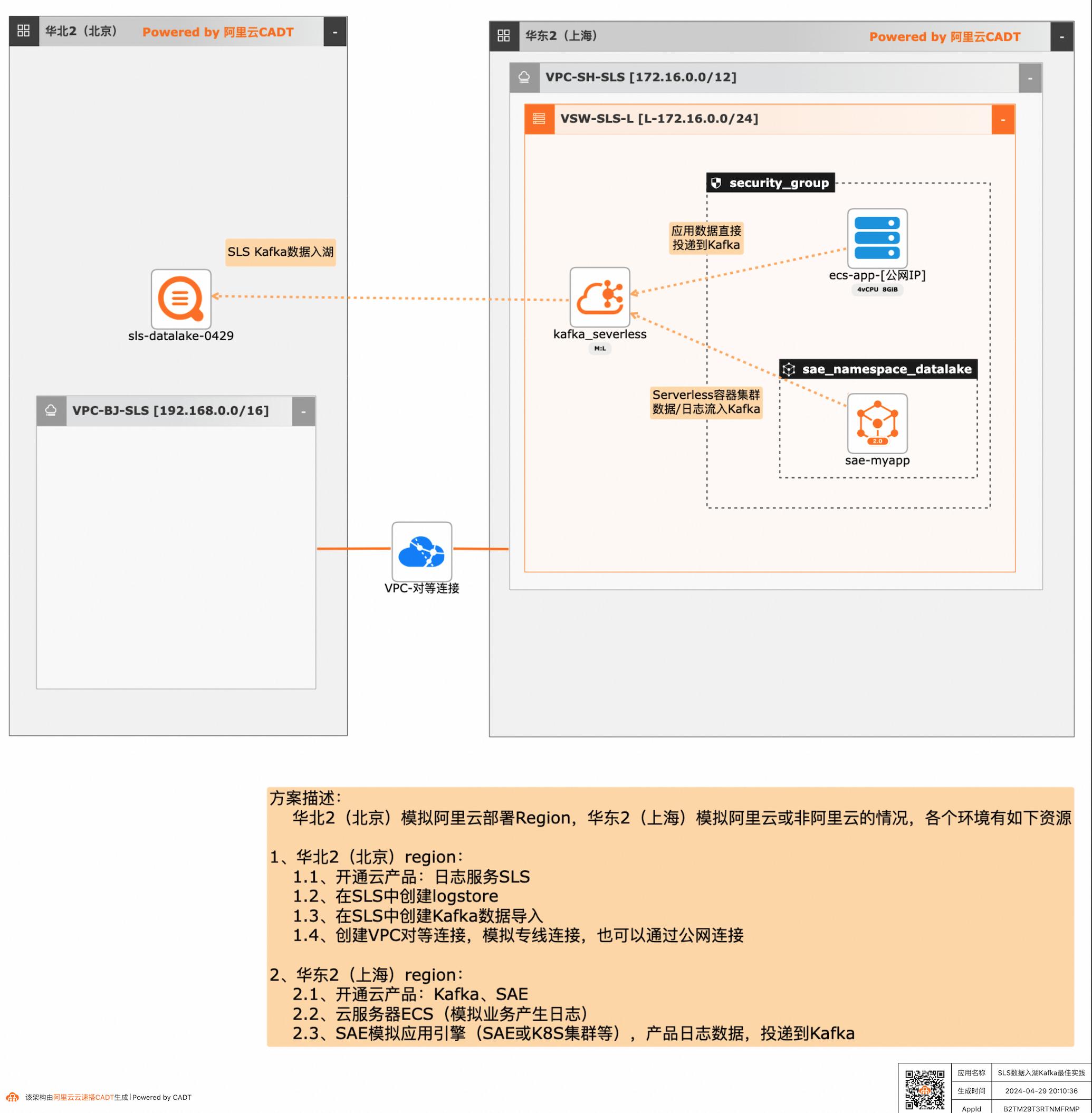

SLS数据入湖Kafka最佳实践

应用和数据分散在多云或混合云,在面对多云/混合云这样大的趋势下,数据无法进行统一的聚合、分析处理和导出等,本方案给出了在多云/混合云场景下,构建通过标准的Kafka协议和托管服务,SLS可以连接Kafka数据入湖导入,然后进行统一的海量数据的集中存储、智能转储、聚合分析查询等。

SLS 数据入湖 Kafka 最佳实践 业务架构 场景描述 应用和数据分散在多云或混合云,在面对多云/混合云这样大的趋势下,数据无法进行统一的 聚合、分析处理和导出等,本方案给出了在多 云/混合云场景下,构建通过标准的Kafka协议 和托管服务,SLS可以连接Kafka数据入湖导 入,然后进行统一的海量数据的集中存储、智 能转储、...

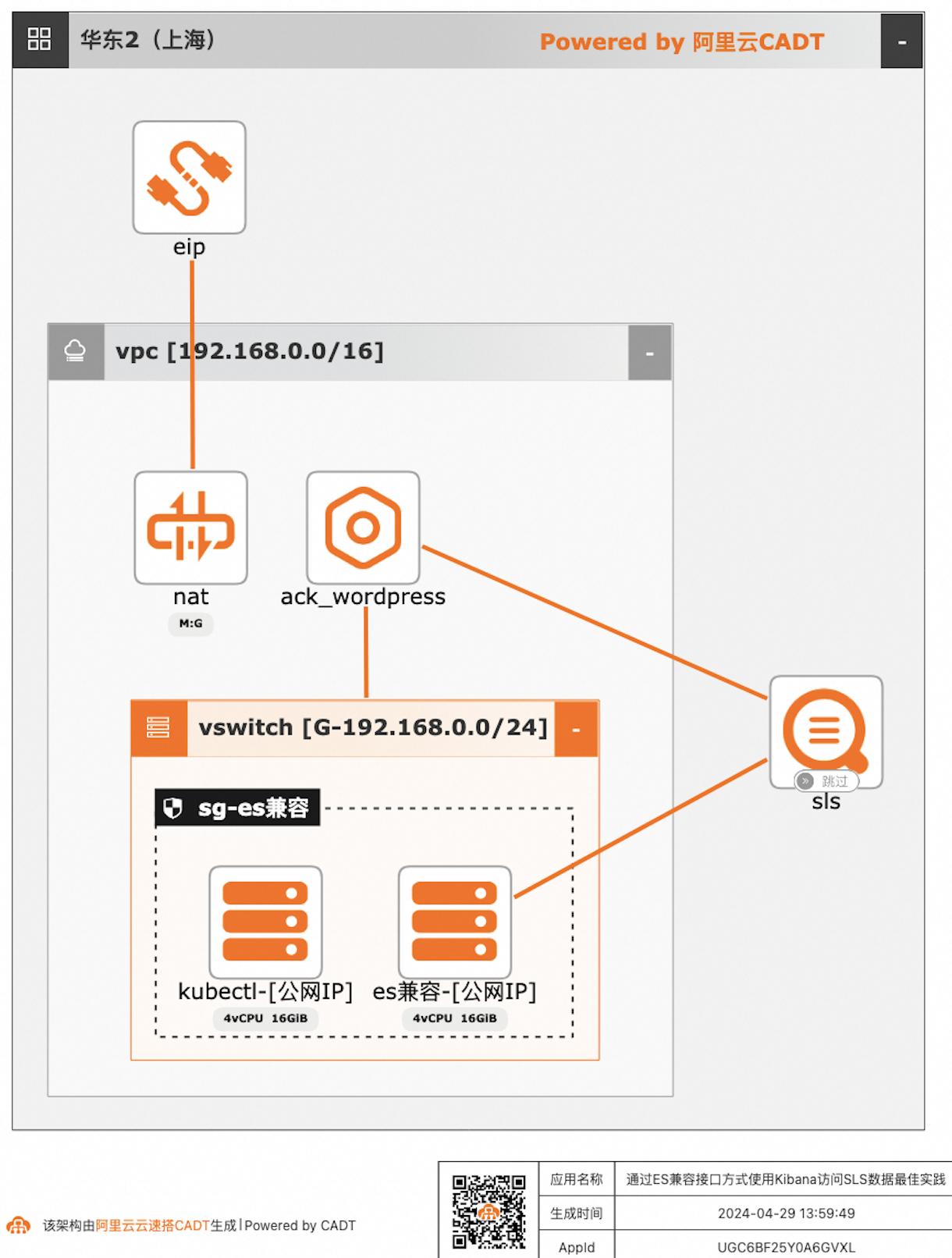

通过ES兼容接口方式使用Kibana访问SLS数据

自建ELK日志系统的客户迁移到阿里云日志服务SLS后,对SLS查询分析语法不太熟悉的客户,可以继续沿用原有的查询分析习惯,在不改变使用方式习惯的情况下,通过Elasticsearch兼容接口的方式使用Kibana访问SLS。

v3.14.3-linux-amd64.tar.gz 到本地,在scp上传到kubectl服务器上,其中公网ip根据实际地址替换 scp~/helm-v3.14.3-linux-amd64.tar.gzroot@47.103.135.74:~/步骤4 解压helm-v3.14.3-linux-amd64.tar.gz文件 tar-zxvfhelm-v3.14.3-linux-amd64.tar.gz 步骤5 将可执行文件移到系统PATH路径下以便在任何地方运行Helm并检查...

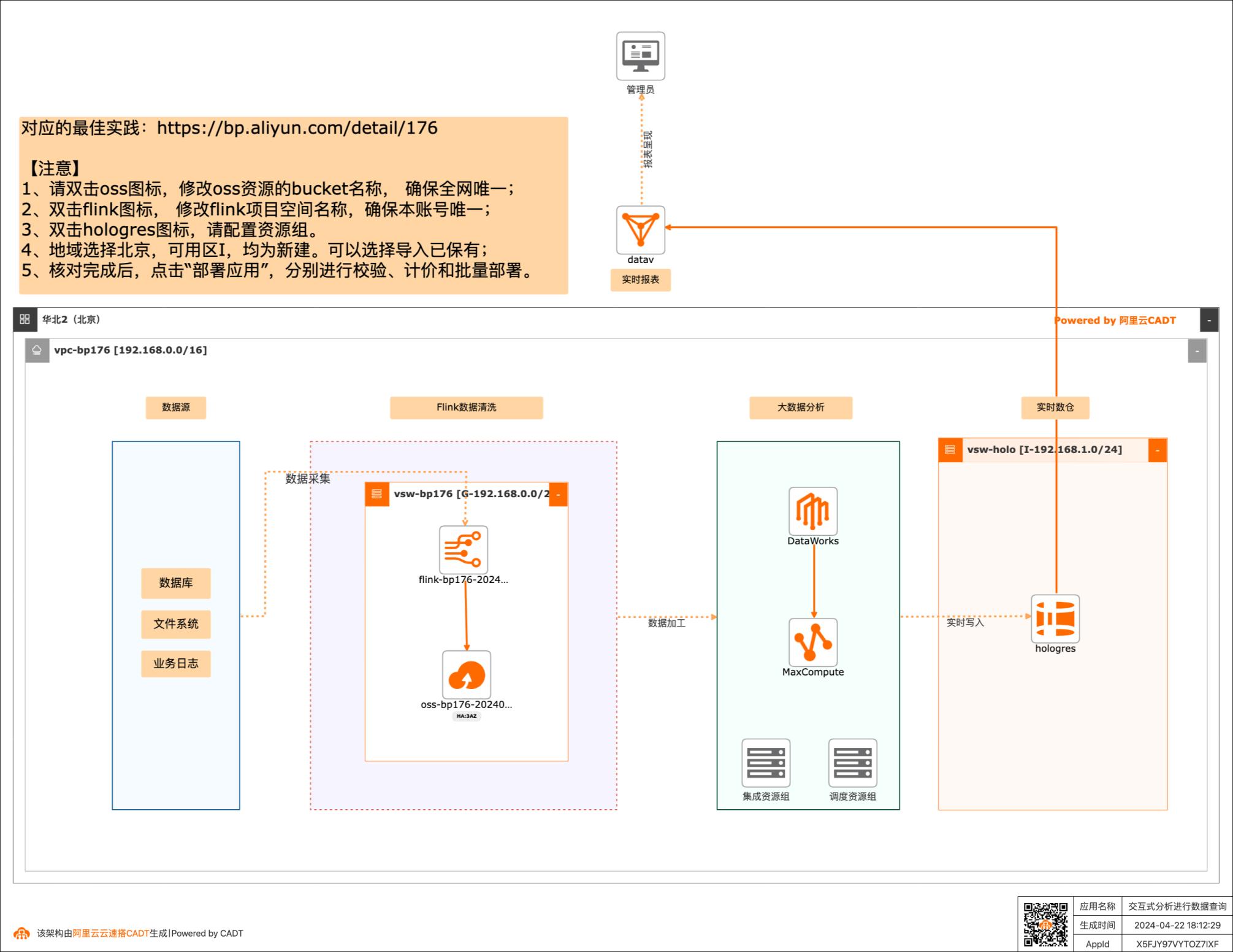

利用交互式分析(Hologres)进行数据查询

场景描述:随着收集数据的方式不断丰富,企业信息化 程度越来越高,企业掌握的数据量呈TB、 PB或EB级别增长。同时,数据中台的快 速推进,使数据应用主要为数据支撑、用户 画像、实时圈人及广告精准投放等核心业务 服务。高可靠和低延时地数据服务成为企业 数字化转型的关键。 Hologres致力于低成本和高性能地大规模 计算型存储和强大的查询能力,为您提供海 量数据的实时数据仓库解决方案和实时交 互式查询服务。 解决问题 1.加速查询MaxCompute数据 2.快速搭建实时数据仓库 3.无缝对接主流BI工具 产品列表 MaxCompute Hologres 实时计算Flink 专有网络VPC DataWorks DataV

执行过程并不会将数据上传到hologres)步骤7 查看执行结果如下图所示:步骤8 部署作业,同步数据到hologres中,单击部署。状态显示“已部署”:步骤9 单击作业运维,并启动作业步骤10通过“运行事件”,查看作业的具体运行状态 步骤11查看作业运行结果。在HoloWeb中查看log_pv表的内容,可以看到数据处理的结果。SELECT*...

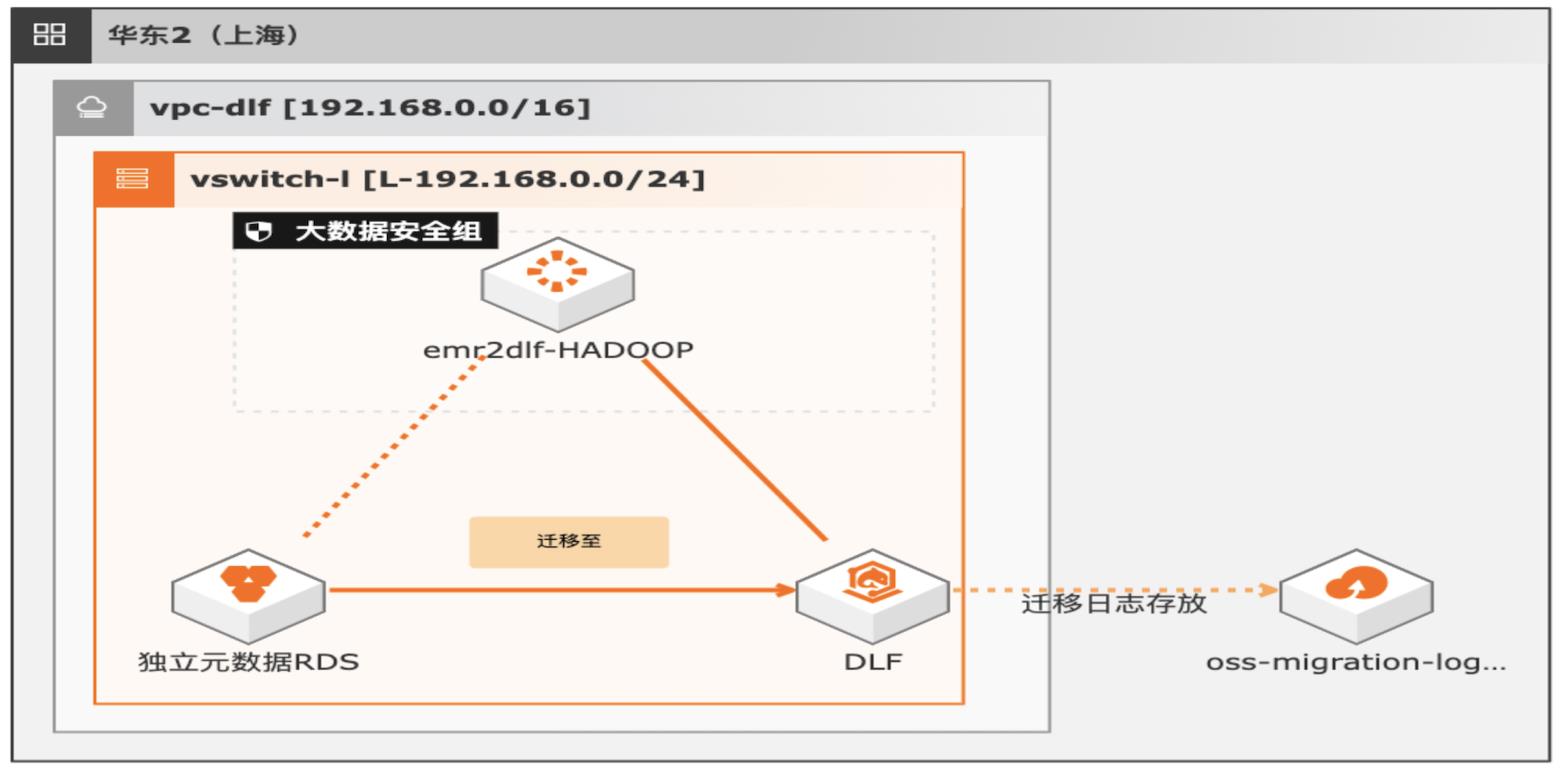

湖仓一体架构EMR元数据迁移DLF

通过EMR+DLF数据湖方案,可以为企业提供数据湖内的统一的元数据管理,统一的权限管理,支持多源数据入湖以及一站式数据探索的能力。本方案支持已有EMR集群元数据库使用RDS或内置MySQL数据库迁移DLF,通过统一的元数据管理,多种数据源入湖,搭建高效的数据湖解决方案。

湖仓一体架构 EMR元数据迁移 DLF最佳实践 业务架构 场景描述 解决的问题 通过 EMR+DLF数据湖方案,可以为企业提供数据 EMR元数据迁移至 DLF 湖内的统一的元数据管理,统一的权限管理,支持多 元数据迁移验证 源数据入湖以及一站式数据探索的能力。本方案支 数据一致性校验 持已有 EMR集群元数据库使用 RDS或内置 MySQL ...

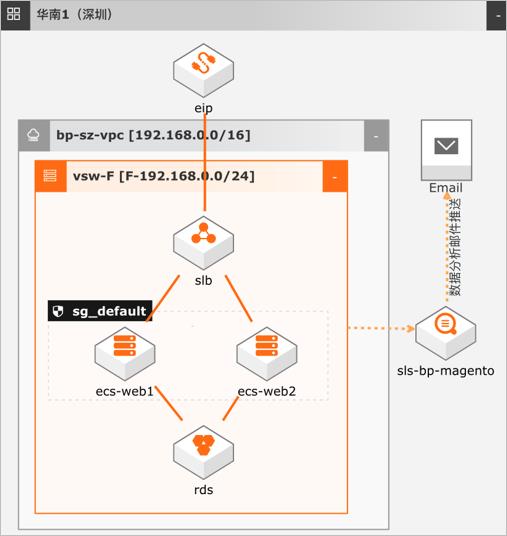

电商网站数据埋点及分析

场景描述 数据埋点是数据产品经理、数据运营以及数据分 析师,基于业务需求(例如:CPC点击付费广 告中统计每一个广告位的点击次数),产品需求 (例如:推荐系统中推荐商品的曝光次数以及点 击的人数)对用户行为的每一个事件对应的位置 进行开发埋点,并通过SDK上报埋点的数据结 果,记录数据汇总后进行分析,推动产品优化或 指导运营。 解决问题 1.电商网站广告位效果统计分析 2.电网网站推荐商品曝光、点击、购买等行为统 计分析 3.电商网站用户分布分析 4.电商网站页面热点图分析等 产品列表 日志服务SLS Dataworks 云服务器ECS 云数据库RDS版 负载均衡SLB 专有网络VPC

文档版本:20220127 XV 电商网站数据埋点及分析 电商网站数据埋点 步骤7 进入 logstore查看日志已经成功上传。小结:本节介绍使用日志服务在 web前端页面进行埋点,这里的数据仅做模拟,真实 业 务 根 据 业 务 需 求 和 智 能 推 荐 的 埋 点 建 议(https://help.aliyun.com/document_detail/116675.html)进行埋点。4.3....

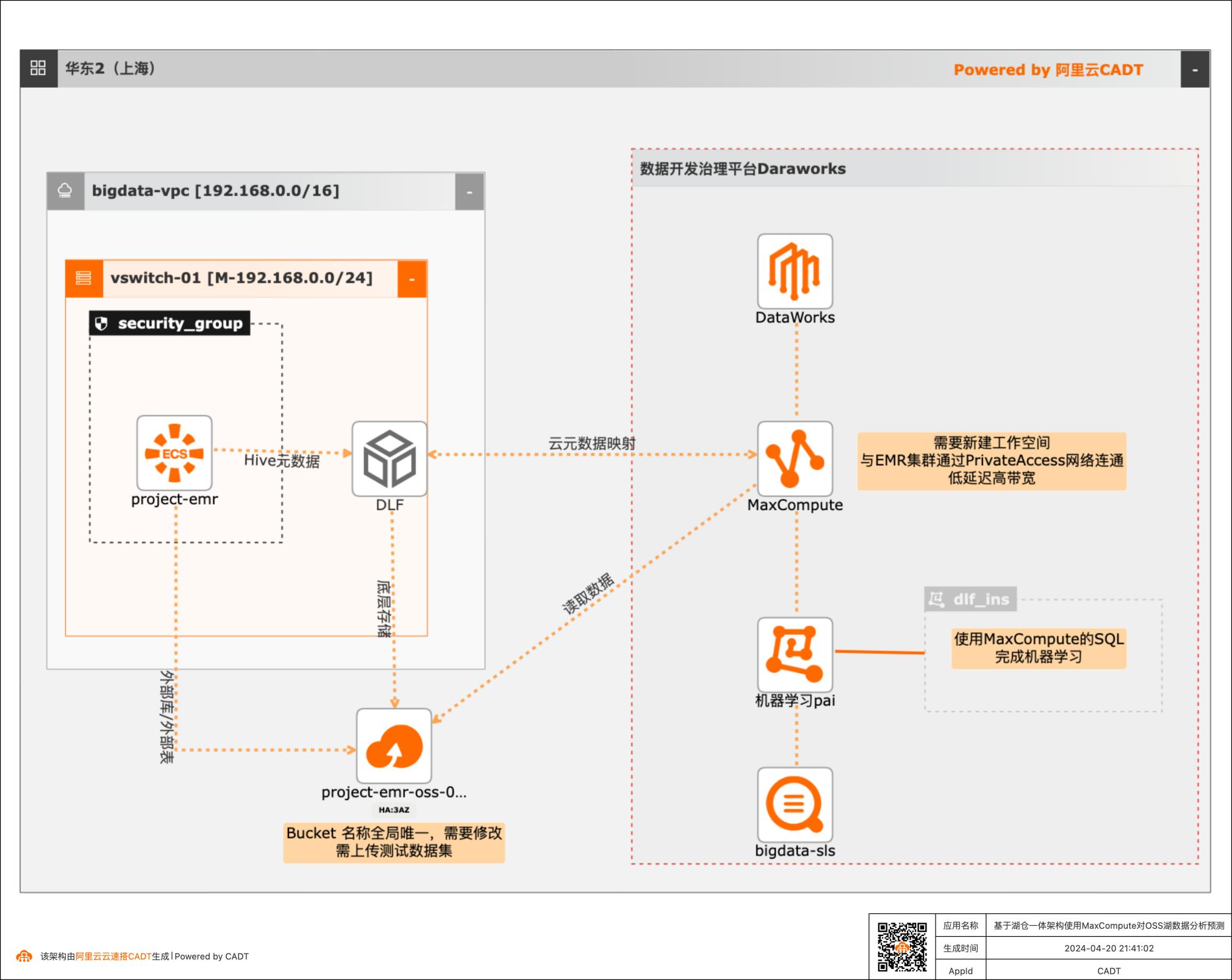

基于湖仓一体架构使用MaxCompute对OSS湖数据分析预测

本篇最佳实践先创建EMR集群作为数据湖对象,Hive元数据存储在DLF,外表数据存储在OSS。然后使用阿里云数据仓库MaxCompute以创建外部项目的方式与存储在DLF的元数据库映射打通,实现元数据统一。最后通过一个毒蘑菇的训练和预测demo,演示云数仓MaxCompute如何对于存储在EMR数据湖的数据进行加工处理以达到业务预期。

基于湖仓一体架构使用MaxCompute对OSS湖数据分析预测实践 业务架构 场景描述 数据湖和数据仓库是当前大数据技术条件下构建分布式系 统的两种数据架构设计取向,数据湖偏向灵活性,数据仓 库侧重成本、性能、安全、治理等企业级特性。但是数据 湖和数据仓库的边界正在慢慢模糊,数据湖自身的治理能 力、数据仓库延伸到外部...

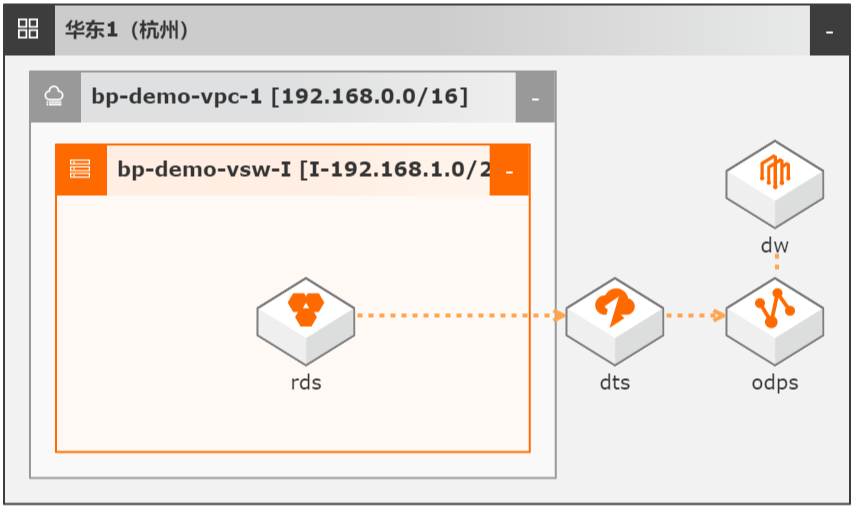

DTS数据同步集成MaxCompute数仓

场景描述 本文Step by Step介绍了通过数据传输服务 DTS实现从云数据库RDS到MaxCompute的 数据同步集成,并介绍如何使用DTS和 MaxCompute数仓联合实现数据ETL幂等和数 据生命周期快速回溯。 解决问题 1.实现大数据实时同步集成。 2.实现数据ETL幂等。 3.实现数据生命周期快速回溯。 产品列表 MaxCompute 数据传输服务DTS DataWorks 云数据库RDS MySQL 版

数据抽取不幂等或容错率低,如凌晨 0:00启动的 ETL任务因为各种原因(数据库 HA切换、网络抖动或 MAXC写入失败等)失败后,再次抽取无法获取 0:00时的数 据状态。2.针对不规范设计表,如没有 create_time/update_time的历史遗留表,传统 ETL需 全量抽取。3.实时性差,抽取数据+重试任务往往需要 1-3小时。另外数据库的数据...

数据集成 Data Integration

阿里云数据集成 Data Integration是跨异构数据、低成本、弹性扩展的数据采集同步平台,为DataX的商业版,支持ETL,支持50+数据源跨网络离线(全量/增量)同步。

数据集成 Data Integration是阿里集团对外提供的可跨异构数据存储系统的、可靠、安全、低成本、可弹性扩展的数据同步平台,为400对数据源提供不同网络环境下的全量/增量数据进出通道.20+种异构数据源.20+种异构数据源.支持关系型数据库、大数据存储、非结构化存储、NoSql数据库之间的数据同步.支持经典/专有等网络环境.支持...

来自:

云产品

- 产品推荐

- 这些文档可能帮助您