自建Hadoop迁移MaxCompute

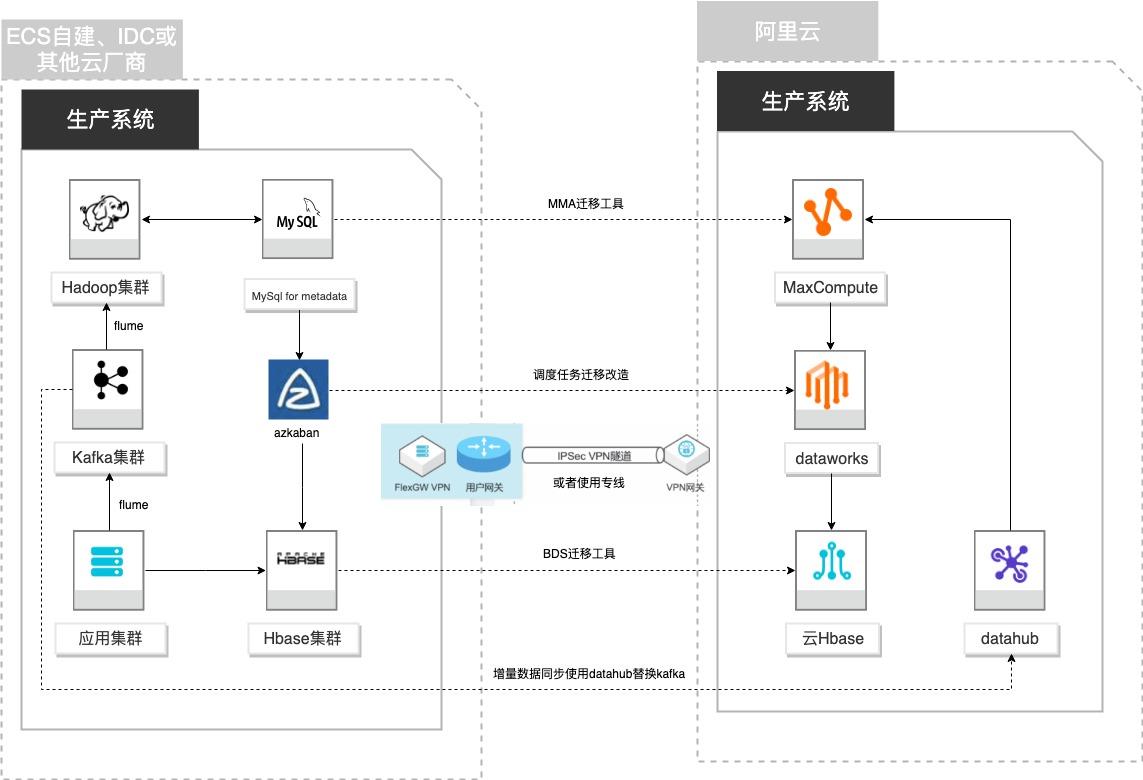

场景描述 客户基于ECS、IDC自建或在友商云平台自建了大数 据集群,为了降低企业大数据计算平台的成本,提高 大数据应用开发效率,更有效保障数据安全,把大数 据集群的数据、作业、调度任务以及业务数据库整体 迁移到MaxCompute和其他云产品。 解决的问题 自建Hadoop集群搬迁到MaxCompute 自建Hbase集群搬迁到云Hbase 自建Kafka或应用数据准实时同步到 MaxCompute 自建Azkaban任务迁移到Dataworks任务 产品列表 MaxCompute,Dataworks、云数据库Hbase版、Datahub、VPC,ECS。

但同时,它和其他的分布式 文件系统的区别也是很明显的。HDFS是一个高度容错性的系统,适合部署在廉 价的机器上。HDFS能提供高吞吐量的数据访问,非常适合大规模数据集上的应 用。VPN网关 VPN网关是一款基于 Internet的网络连接服务,通过加密通道的方式实现企业数 据中心、企业办公网络或 Internet终端与阿里云专有网络...

自建Hadoop迁移到阿里云EMR

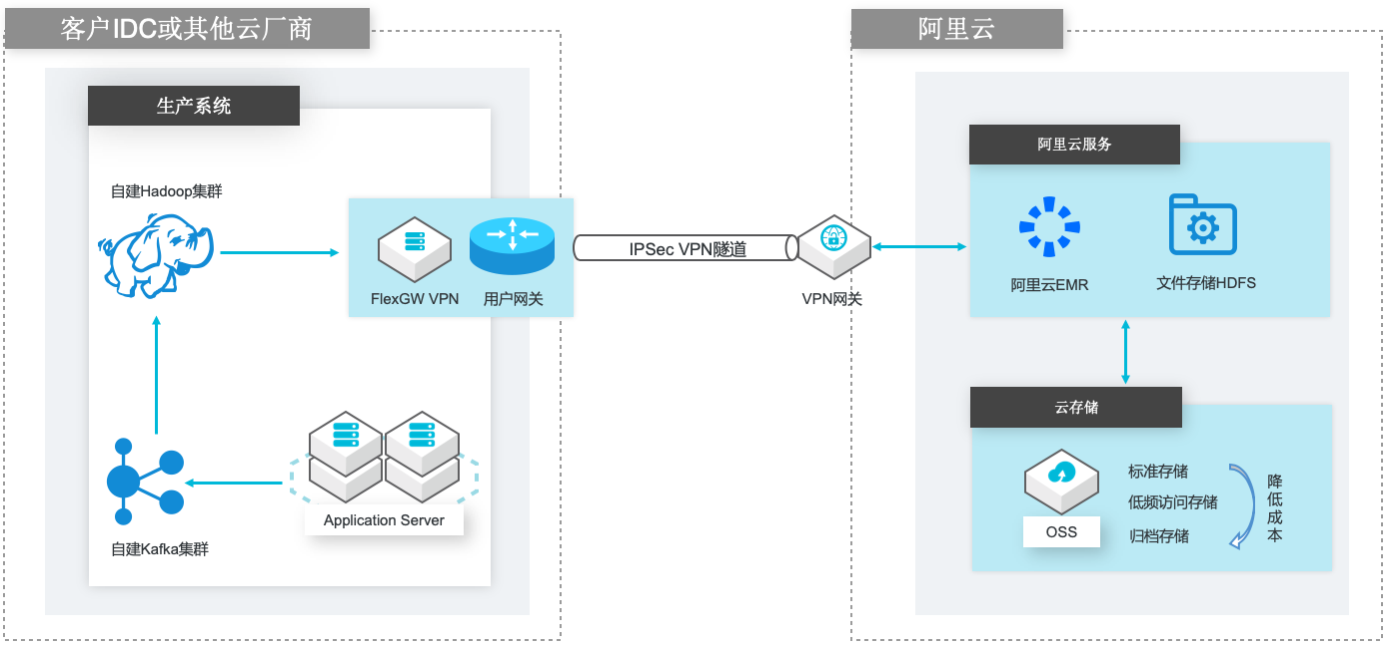

场景描述 场景1:自建Hadoop集群数据(HDFS)迁移到 阿里云EMR集群的HDFS文件系统; 场景2:自建Hadoop集群数据(HDFS)迁移到 计算存储分离架构的阿里云EMR集群,以OSS 和JindoFS作为EMR集群的后端存储。 解决的问题 客户自建Hadoop迁移到阿里云EMR集群的 技术方案; 基于IPSecVPN隧道构建安全和低成本数据 传输链路 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

名词解释 E-MapReduce 阿里云 E-MapReduce(EMR)是构建在阿里云云服务器 ECS 上的开源 Hadoop、Spark、HBase、Hive、Flink生态大数据 PaaS 产品。提供用户在云 上使用开源技术建设数据仓库、离线批处理、在线流式处理、即时查询、机器学 习等场景下的大数据解决方案。详情请查看 ...

EMR集群安全认证和授权管理

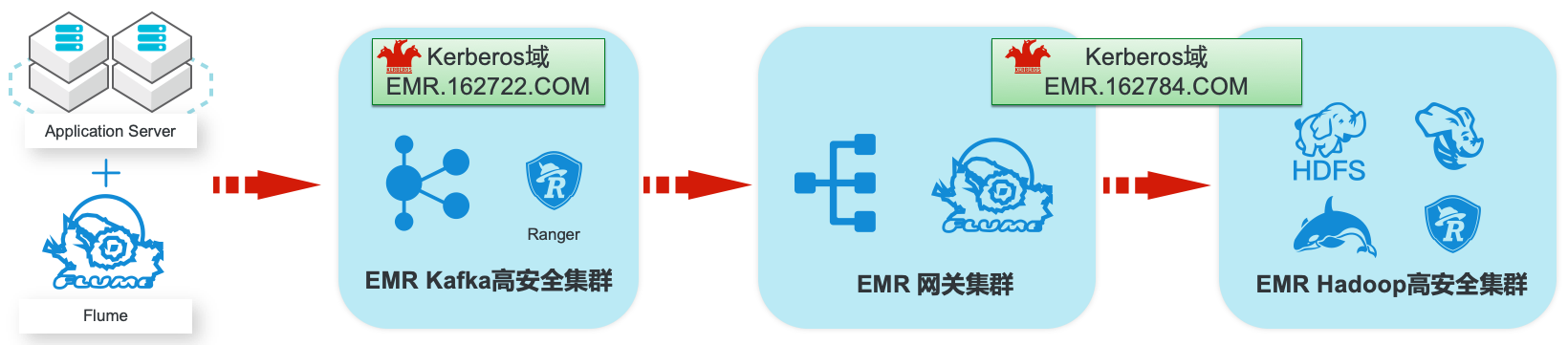

场景描述 阿里云EMR服务Kafka和Hadoop安全集群使 用Kerberos进行用户安全认证,通过Apache Ranger服务进行访问授权管理。本最佳实践中以 Apache Web服务器日志为例,演示基于Kafka 和Hadoop的生态组件构建日志大数据仓库,并 介绍在整个数据流程中,如何通过Kerberos和 Ranger进行认证和授权的相关配置。 解决问题 1.创建基于Kerberos的EMR Kafka和 Hadoop集群。 2.EMR服务的Kafka和Hadoop集群中 Kerberos相关配置和使用方法。 3.Ranger中添加Kafka、HDFS、Hive和 Hbase服务和访问策略。 4.Flume中和Kafka、HDFS相关的安全配 置。 产品列表:E-MapReduce、专有网络VPC、云服务器ECS、云数据库RDS版

EMR集群安全认证和授权管理 最佳实践 业务架构 场景描述 解决问题 阿里云 EMR服务 Kafka和 Hadoop安全集群使用 1.创建基于 Kerberos的 EMR Kafka和 Kerberos进行用户安全认证,通过 Apache Ranger Hadoop集群。服务进行访问授权管理。本最佳实践中以 Apache 2.EMR服务的 Kafka和 Hadoop集群中 Web服务器日志为例,演示基于 ...

基于DataWorks的大数据一站式开发及数据治理

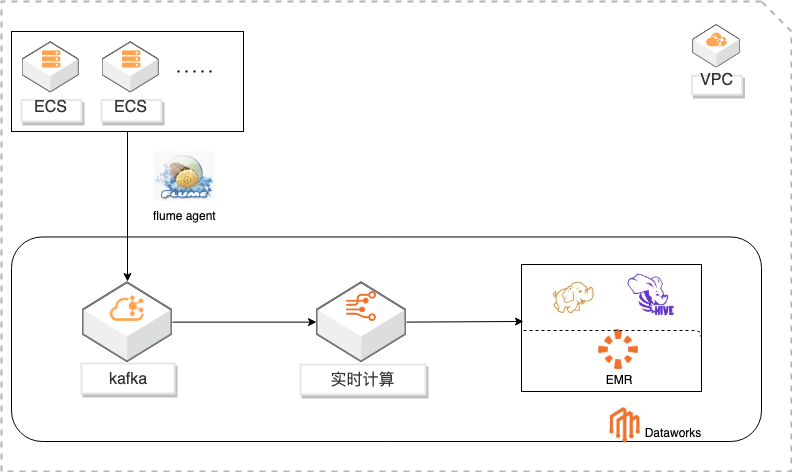

概述 基于Dataworks做大数据一站式开发,包含数据实时采集到kafka通过实时计算对数据进行ETL写入HDFS,使用Hive进行数据分析。通过Dataworks进行数据治理,数据地图查看数据信息和血缘关系,数据质量监控异常和报警。 适用场景 日志采集、处理及分析 日志使用Flink实时写入HDFS 日志数据实时ETL 日志HIVE分析 基于dataworks一站式开发 数据治理 方案优势 大数据一站式开发,完善的数据治理能力。 性能优越:高吞吐,高扩展性。 安全稳定:Exactly-Once,故障自动恢复,资源隔离。 简单易用:SQL语言,在线开发,全面支持UDX。 功能强大:支持SQL进行实时及离线数据清洗、数据分析、数据同步、异构数据源计算等Data Lake相关功能 ,以及各种流式及静态数据源关联查询。

但同时,它和其他的分 布式文件系统的区别也是很明显的。HDFS 是一个高度容错性的系统,适合部署 在廉价的机器上。HDFS 能提供高吞吐量的数据访问,非常适合大规模数据集上 的应用。实时计算:实时计算(Alibaba Cloud Realtime Compute,Powered by Ververica)是阿里云提供的基于 Apache Flink 构建的企业级大数据计算...

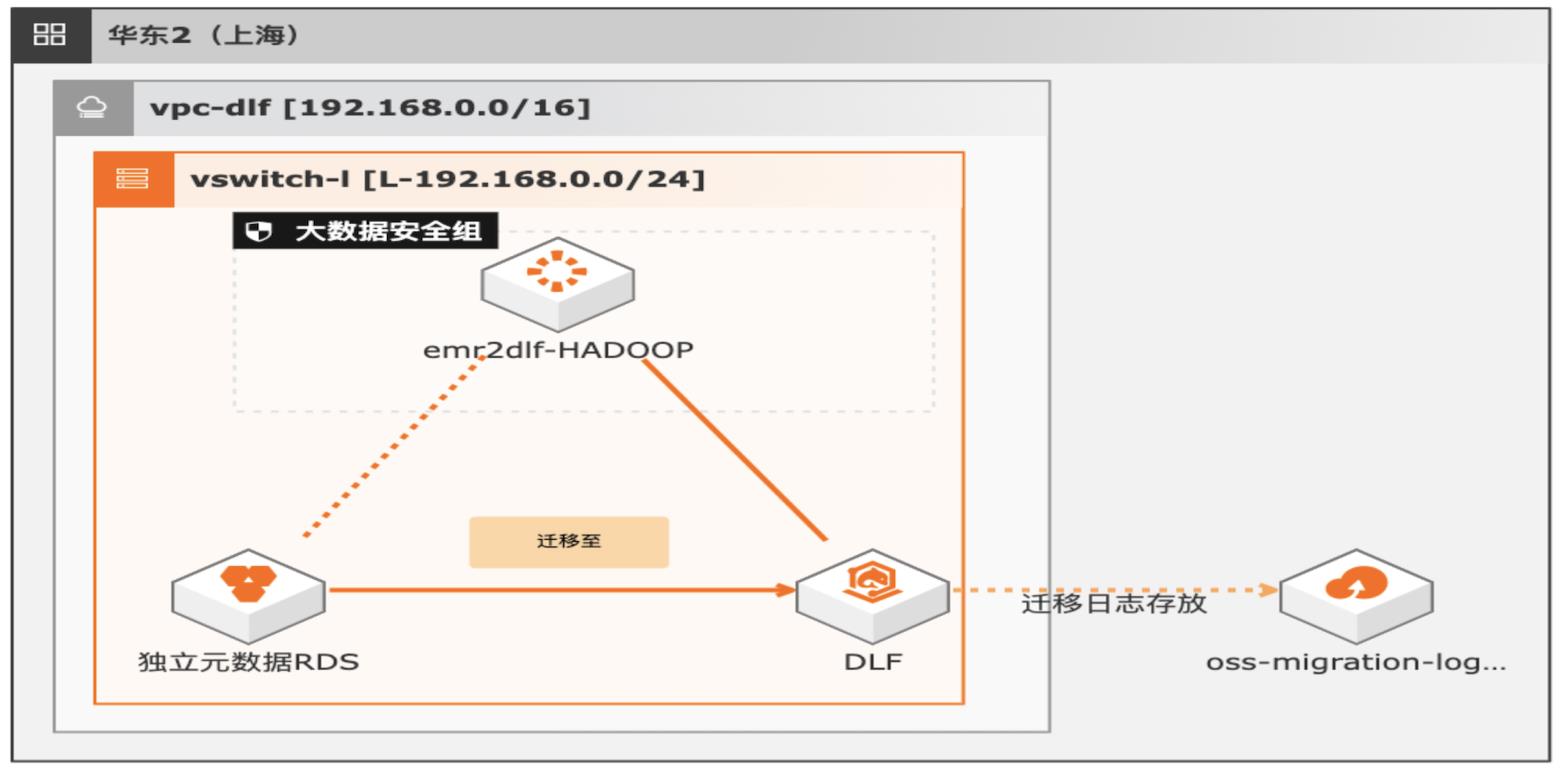

湖仓一体架构EMR元数据迁移DLF

通过EMR+DLF数据湖方案,可以为企业提供数据湖内的统一的元数据管理,统一的权限管理,支持多源数据入湖以及一站式数据探索的能力。本方案支持已有EMR集群元数据库使用RDS或内置MySQL数据库迁移DLF,通过统一的元数据管理,多种数据源入湖,搭建高效的数据湖解决方案。

EMR是云原生开源大数据平台,向客户提 供简单易集成的 Hadoop、Hive、Spark、Flink、Presto、ClickHouse、Delta、Hudi 等开源大数据计算和存储引擎。EMR计算资源可以根据业务的需要调整。EMR可 以 部 署 在 阿 里 云 公 有 云 的 ECS 和 ACK、专 有 云 平 台。(https://www.aliyun.com/product/emapreduce)。数据湖构建 ...

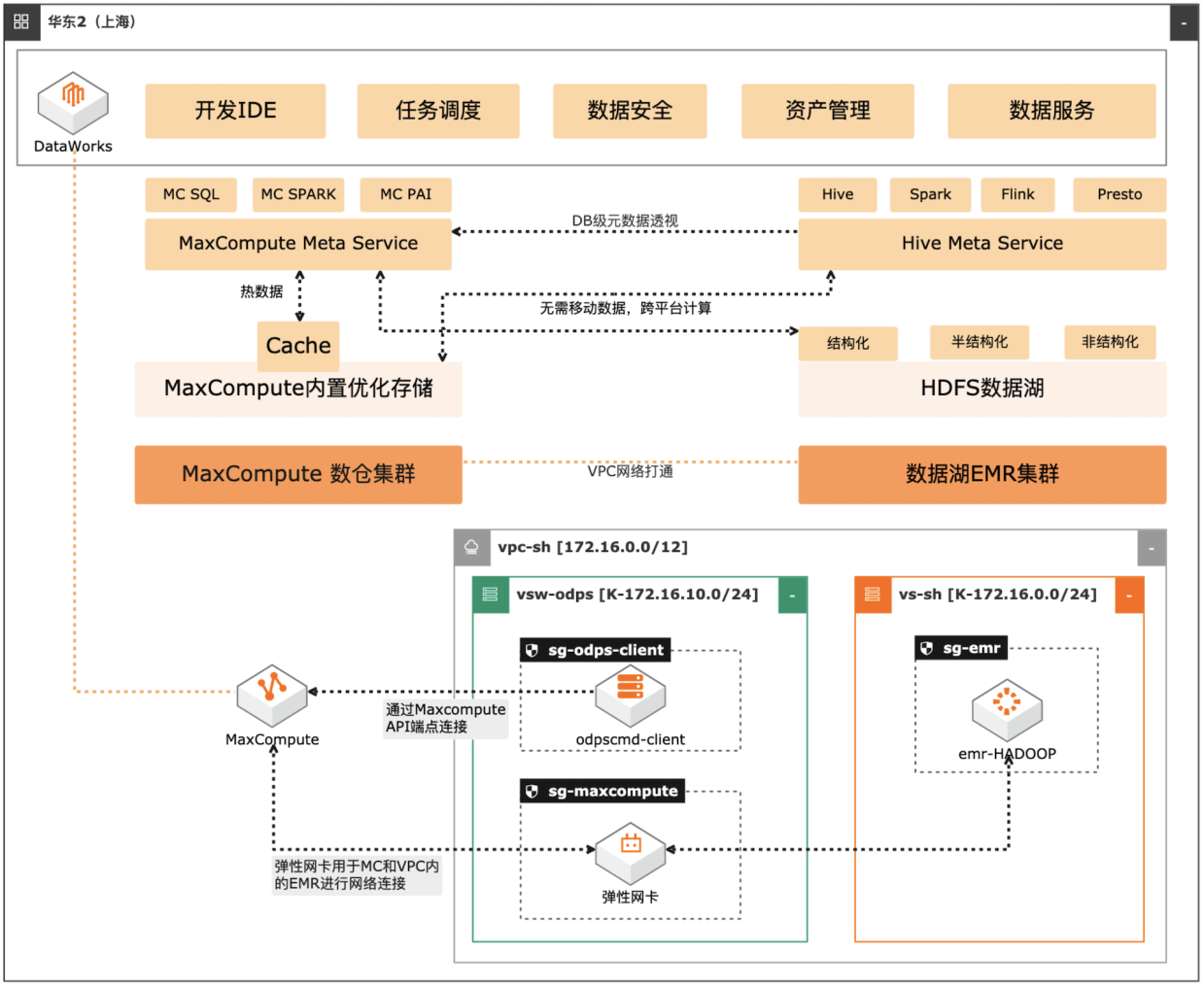

MaxCompute湖仓一体方案

场景描述 自建数据湖与云数仓的融合解决方案,将 MaxCompute与自建的Hive集群做数据打 通,通过存储共享,元数据镜像等方式,解 决传统模式下的存储冗余,计算资源弹性能 力弱的痛点。可大幅度增强系统的资源弹 性,解决业务高峰期计算资源不足的问题。 方案优势 1.业务无侵入性:现有业务无需改造。 2.性能优化:MaxCompute在SQL上做 了大量优化与能力沉淀,可提高SQL 运行性能,降低计算成本。 3.灵活管理:元数据实时同步,无需额外 管理数据同步任务。 4.资源弹性:利用MaxCompute计算池 弹性进行海量数据计算。 解决问题 1.增强业务高峰期的资源弹性。 2.优化自建数据湖的数据治理能力。 3.减少跨平台数据处理的存储冗余。 产品列表 专有网络VPC 云服务器ECS 访问控制RAM 运维编排OOS MaxCompute(原ODPS) 云企业网CEN

但同时,它和其他的分 布式文件系统的区别也是很明显的。HDFS 是一个高度容错性的系统,适合部署 在廉价的机器上。HDFS 能提供高吞吐量的数据访问,非常适合大规模数据集上 的应用。Apache Hive:Apache Hive是基于 Hadoop的一个数据仓库工具,可以将结构化 的数据文件映射为一张数据库表,并提供简单的 SQL查询功能,可以...

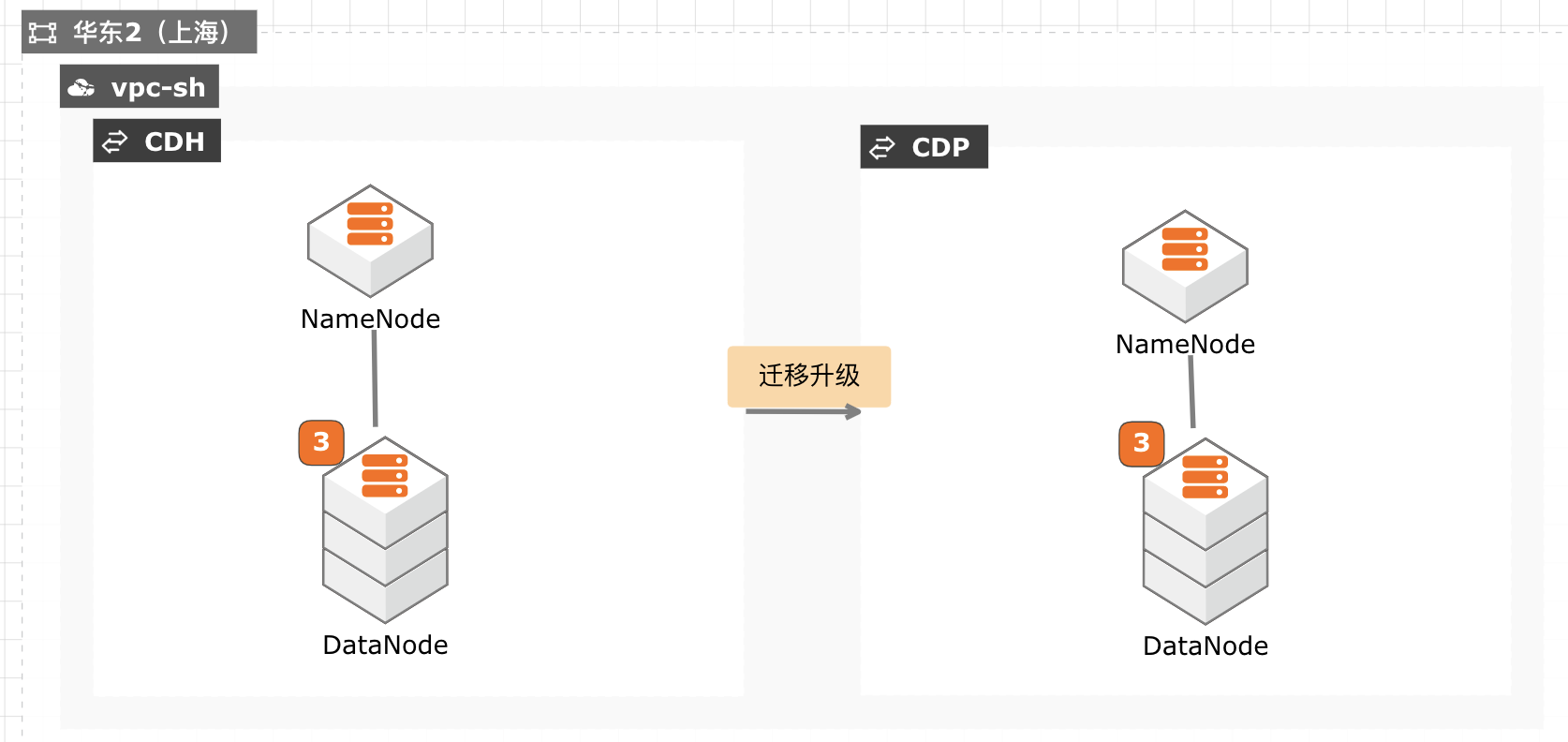

CDH迁移升级CDP最佳实践

当前 CDH 免费版停止下载,终止服务,针对需要企业版服务能力并且CDH 升级过程对业务影响较小的客户,通过安装新的 CDP 集群,将现有数据拷贝至新集群,然后将新集群切换为生产集群,升级过程没有数据丢失风险,停机时间较短,适合大部分互联网客户升级使用。

安装 Spark2 说明:由于 Kudu迁移工具需 Spark2支持,CDH5可以支持 Spark和 Spark2两个环 境同时运行,如果集群上没有 Spark2请先进行安装。已经安装的略过此步骤。另外,kudu迁移也可以使用 kudu table copy来实现,也不需要安装 Spark2。把 Sparks2的安装包移动到/opt/cloudera/csd/目录下。mv cdh/spark2/*/opt/cloudera...

金融专属大数据workshop

实践目标 学习搭建一个实时数据仓库,掌握数据采集、存储、计算、输出、展示等整个业务流程。 整个实时数据仓库系统全部基于阿里云产品进行架构搭建,用户可以掌握并学会运用各个服务组件及各个组件之间如何联动。 理解阿里云原生实时离线一体数仓解决方案架构以及掌握交付落地的实践使用方法。 前置知识要求 熟练掌握SQL语法 对大数据体系系统知识有一定的了解

技术选型 阿里云框架 开源框架 数据采集传输 DataHub、DTS Flume、Kafka、Canal、MaxWell 数据存储 RDS、MaxCompute MySQL、Hadoop、HBase 数据计算 实时计算Flink版 Spark、Flink 数据可视化 DataV、QuickBI Tableau、Echarts、Kibana 2.2.4.系统架构设计 下图为所设计的系统架构设计,主要包括数据源(两类...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

E-MapReduce Serverless Spark 版

E-MapReduce Serverless Spark 是阿里云 E-MapReduce 基于 Spark 提供的一款全托管、一站式的数据计算平台。它为用户提供任务开发、调试、发布、调度和运维等全方位的产品化服务,显著简化了大数据计算的工作流程,使用户能更专注于数据分析和价值提炼。

EMR Serverless Spark 还内嵌了先进的版本管理系统,并提供了开发与生产环境的完全隔离,确保符合企业级用户在研发和发布流程方面的严格要求。这些特性共同保障了数据处理的可靠性和效率,同时满足企业级应用的高标准要求.全托管免运维.弹性扩展能力.开放数据湖架构.一站式的数据开发平台.开源大数据平台 EMR.数据湖构建 ...

来自:

云产品

中小企业自建Hadoop集群上云解决方案

中小企业自建 Hadoop 集群上云解决方案,助力自建 Hadoop 用户快速构建云上半托管开源大数据平台,在保持原组件使用习惯延续的同时,充分利用云上服务特点,更加便捷地迭代企业大数据平台架构,聚焦业务价值开发。

提供高性能、稳定版本 Hadoop、Spark、Hive、Flink、Kafka、Hbase、Presto、Impala、Hudi、ClickHouse 等开源大数据组件,可根据场景灵活搭配使用。采用 JindoFS+OSS,在保证数据可靠性的基础上,性能大幅提升.开源生态,性能优化.分钟级创建集群,支持对集群、节点和服务进行监控和运维操作,大幅提升运维工作效率,让数据...

来自:

解决方案

Spark on ECI大数据分析

场景描述 方案优势 1.计算引擎弹性扩缩容,兼顾资源弹性与计 算资源成本优化。 2.计算与存储分离架构,结合阿里云原生云 存储产品,海量数据湖优势。 3.Kubernetes原生的调度性能优势,提升在 大规模分析作业时的分析性能优势分。 4.集群资源隔离和按需分配。 解决问题 1.计算资源弹性能力不足,计算资源成本管 控能力欠缺. 2.集群资源调度能力和隔离能力不足。 3.计算与存储无法分离,大数据量分析时出 现数据存储资源瓶颈。 4.Spark submit方式提交分析作业参数支持 有限等缺点。 产品列表 容器服务Kubernetes版(ACK) 弹性容器实例(ECI) 文件存储HDFS 对象存储OSS 专有网络VPC 容器镜像服务ACR

2.关于 Hadoop的核心配置文件的说明介绍如下图所示:文档版本:20200409 5 Spark on ECI大数据分析 环境准备 3.修改 core-site.xml文件,路径位于 Hadoop目录下的/etc/hadoop/目录下。步骤5 配置环境变量。1.修改/etc/profile文件并保存。2.在配置最后加入相应路径信息。3.执行 source/etc/profile命令以便环境变量配置生效...

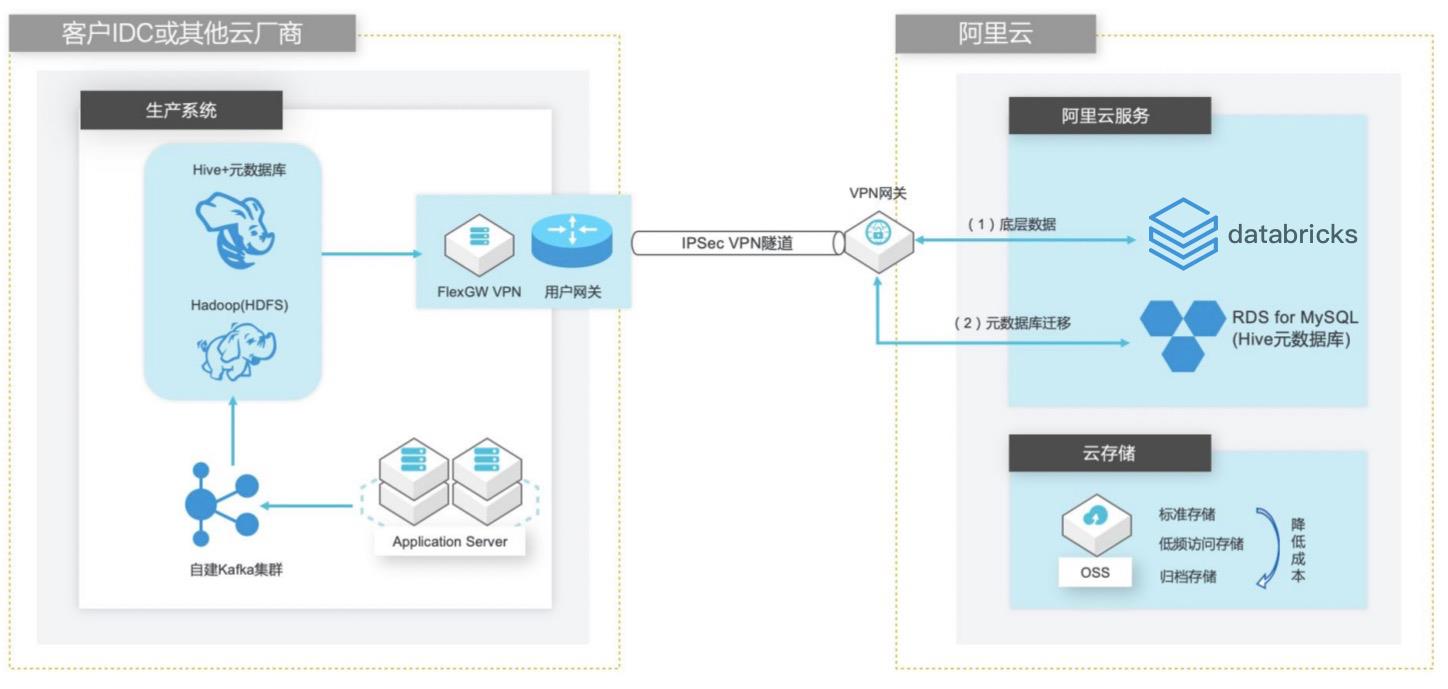

自建Hive数据仓库跨版本迁移到阿里云Databricks数据洞察

场景描述 客户在IDC或者公有云环境自建Hadoop集群构建数据仓库和分析系统,购买阿里云Databricks数据洞察集群之后,涉及到数仓数据和元数据的迁移以及Hive版本的订正更新。 方案优势 1. 全托管Spark集群免运维,节省人力成本。 2. Databricks数据洞察与阿里云其他产品(OSS、RDS、MaxCompute、EMR)进行深度整合,支持以这些产品为数据源的输入和输出。 3. 使用Databricks Runtime商业版引擎相比开源Spark性能有3-5倍的提升。 解决问题 1. Hive数仓数据迁移OSS方案。 2. Hive元数据库迁移阿里云RDS方案。 3. Hive跨版本迁移到Databricks数据洞察使用Delta表查询以提高查询效率。

与社区版 Spark和 Delta Lake相比,在功能和性能 上都有明显的优势。经济 文档版本:20210425 V 自建 Hive数据仓库跨版本迁移到阿里云 Databricks数据洞察 最佳实践概述 您可以按需创建 Databricks数据洞察集群,即离线作业运行结束就可以释放集群,同时支持按负载和时间的弹性伸缩。协同分析 Databricks数据洞察 Notebook...

- 产品推荐

- 这些文档可能帮助您