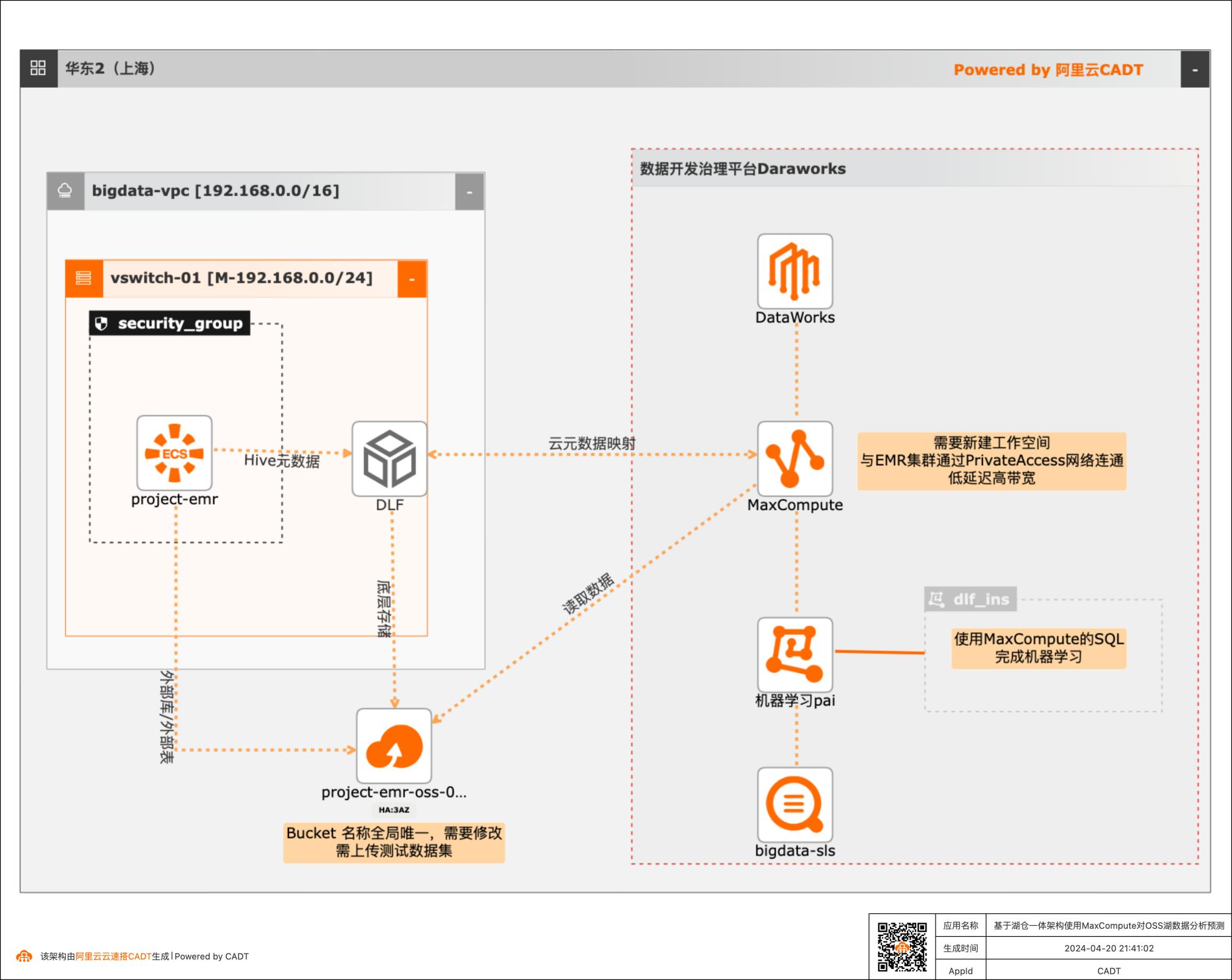

基于湖仓一体架构使用MaxCompute对OSS湖数据分析预测

本篇最佳实践先创建EMR集群作为数据湖对象,Hive元数据存储在DLF,外表数据存储在OSS。然后使用阿里云数据仓库MaxCompute以创建外部项目的方式与存储在DLF的元数据库映射打通,实现元数据统一。最后通过一个毒蘑菇的训练和预测demo,演示云数仓MaxCompute如何对于存储在EMR数据湖的数据进行加工处理以达到业务预期。

通过MC查询EMR的Hive数据表.29 3.4.数据预处理.30 3.5.创建预测模型.35 3.6.使用模型做预测.36 4.一键释放云资源.39 5.附录A.42 5.1.MaxCompute和DLF属于同一个账号,需要自定义授权.42 5.2.MaxCompute和DLF属于不同账号.47 6.附录B.49基于湖仓一体架构使用MaxCompute对OSS湖数据分析预测 最佳实践概述 最佳实践概述 方案...

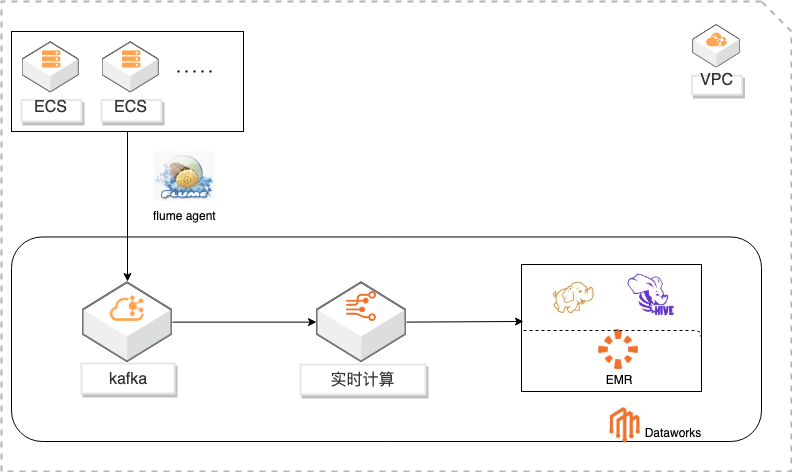

基于DataWorks的大数据一站式开发及数据治理

概述 基于Dataworks做大数据一站式开发,包含数据实时采集到kafka通过实时计算对数据进行ETL写入HDFS,使用Hive进行数据分析。通过Dataworks进行数据治理,数据地图查看数据信息和血缘关系,数据质量监控异常和报警。 适用场景 日志采集、处理及分析 日志使用Flink实时写入HDFS 日志数据实时ETL 日志HIVE分析 基于dataworks一站式开发 数据治理 方案优势 大数据一站式开发,完善的数据治理能力。 性能优越:高吞吐,高扩展性。 安全稳定:Exactly-Once,故障自动恢复,资源隔离。 简单易用:SQL语言,在线开发,全面支持UDX。 功能强大:支持SQL进行实时及离线数据清洗、数据分析、数据同步、异构数据源计算等Data Lake相关功能 ,以及各种流式及静态数据源关联查询。

kafka通过实时计算对数 据进行 ETL写入 HDFS,使用 Hive进行数据分析。通过 DataWorks进行数据治理,数据地图查看数据信息和血缘关系,数据质量监控异常和报警。名词解释 HDFS:Hadoop分布式文件系统(HDFS)被设计成适合运行在通用硬件上的分 布式文件系统,它和现有的分布式文件系统有很多共同点。但同时,它和其他的分 ...

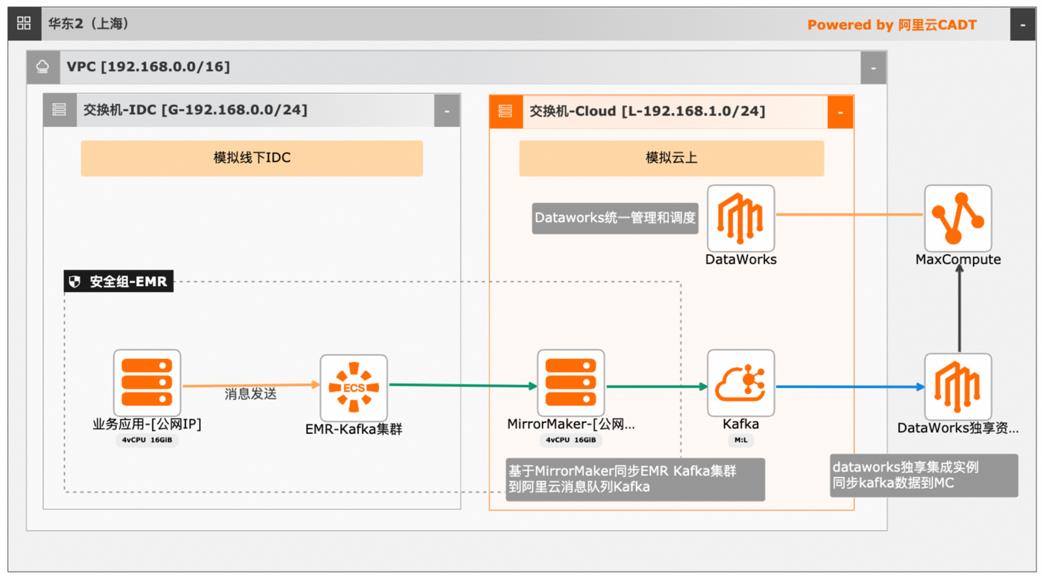

大数据近实时数据投递MaxCompute

本文介绍离线大数据场景使MaxCompute构建云 上近实时数仓,打通云下数据上云链路,解决数据复杂类型支持和动态分区问题,满足高级数据处理需求的最佳实践。 l混合云环境下,现有业务系统零改造,打通数据上云链路。 l使用UDF实现复杂数据类型转换和数据动态分区。 l使用DataWorks配置周期调度业务流程,数据自动入仓。 l借助MaxCompute优化计算引擎,实现降本增效。 产品列表 云服务器ECS 专有网络VPC 访问控制RAM 数据总线DataHub E-MapReduceEMR DataWorks 大数据计算服务MaxCompute

双击解析 tmp表数据至 final表节点,打开节点编辑界面,输入从临时表读取数据,解析后写入最终表的 SQL语句。INSERT INTO TABLE kafka_final_table PARTITION(date_for_p)SELECT parse_json_str(message)AS(id,time,tags,scores,school,data_for_p)FROM kafka_tmp_table WHERE ds='${thisdate}' AND hh='${thishour}' AND ...

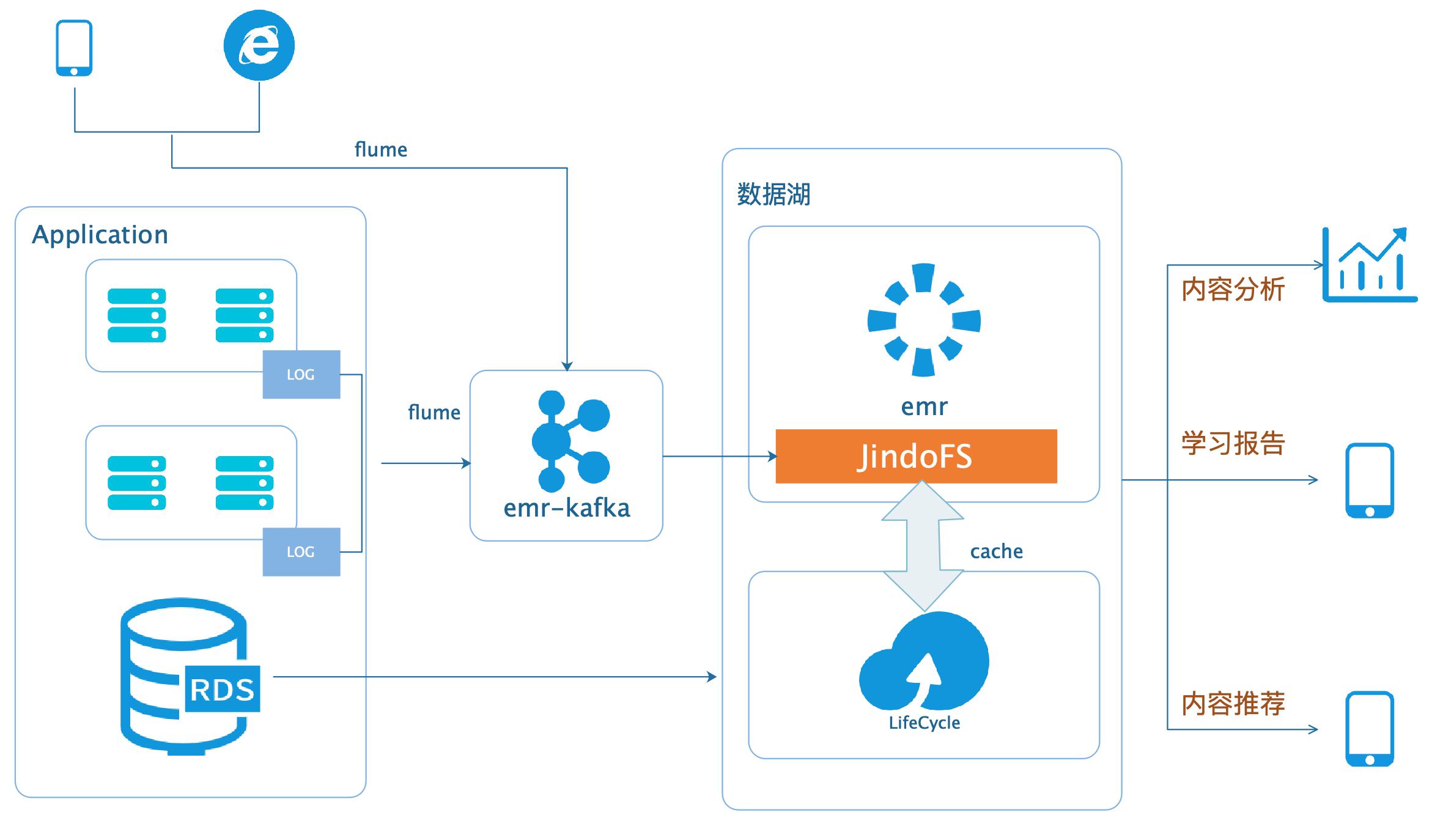

数据湖-在线学习场景数据分析

场景描述 本场景以在线教育中一个答题闯关类的应用为 例,使用WebServer来模拟演示这类日志数据 的分析处理。通过Nginx和Pythonflask搭建 WebServer,模拟应用中的关键页面,比如登 录、课程内容等,之后构造若干用户使用的模拟 日志数据,投递到数据湖进行分析后获取应用 PV、UV、课程内容访问排行、平均得分等等。 解决问题 基于数据湖(EMR+OSS)搭建大数据平台。 EMR和OSS使用和配置。 数据统一存储到OSS。 产品列表 E-MapReduce 对象存储OSS 云服务器ECS 访问控制RAM 专有网络VPC

借助EMR 可以简单快速的构建一个基于 Hadoop,Spark,Hive等大数据产品的计算集群,而且可以按需使用,其所有 Job完 文档版本:20200331 5数据湖-在线学习场景数据分析 数据湖 成之后,销毁集群,因为所有的数据都保存在OSS。此外,对于Hadoop集群上的任务,不同类型的任务对于机器配置的要求不同,比如 推荐和算法业务可能...

云数据库 SelectDB 版

阿里云数据库 SelectDB 是现代化实时数据仓库 SelectDB 在阿里云上的全托管服务,内核基于业界领先的开源分析型数据库 Apache Doris 研发,由阿里云和飞轮科技联合打造。阿里云数据库 SelectDB 聚焦于满足企业级大数据分析需求,广泛应用于实时报表分析、即席多维分析、日志检索分析、数据联邦与查询加速等场景,致力于为客户提供极致性能、简单易用的数据分析服务。

万级高并发支持分区分桶级裁剪、跳数索引(Zonemap、Bloomfilter)、点查索引(主键、倒排),减少读取的数据量,提升并发查询能力。结合行列混存、定制查询优化器,单机可支撑上万 QPS 的高并发点查。相关产品云数据库 SelectDB 版本产品云数据库 RDS MySQL 版云消息队列 Kafka 版数据传输服务DTS实时计算Flink版在线咨询即席...

来自:

云产品

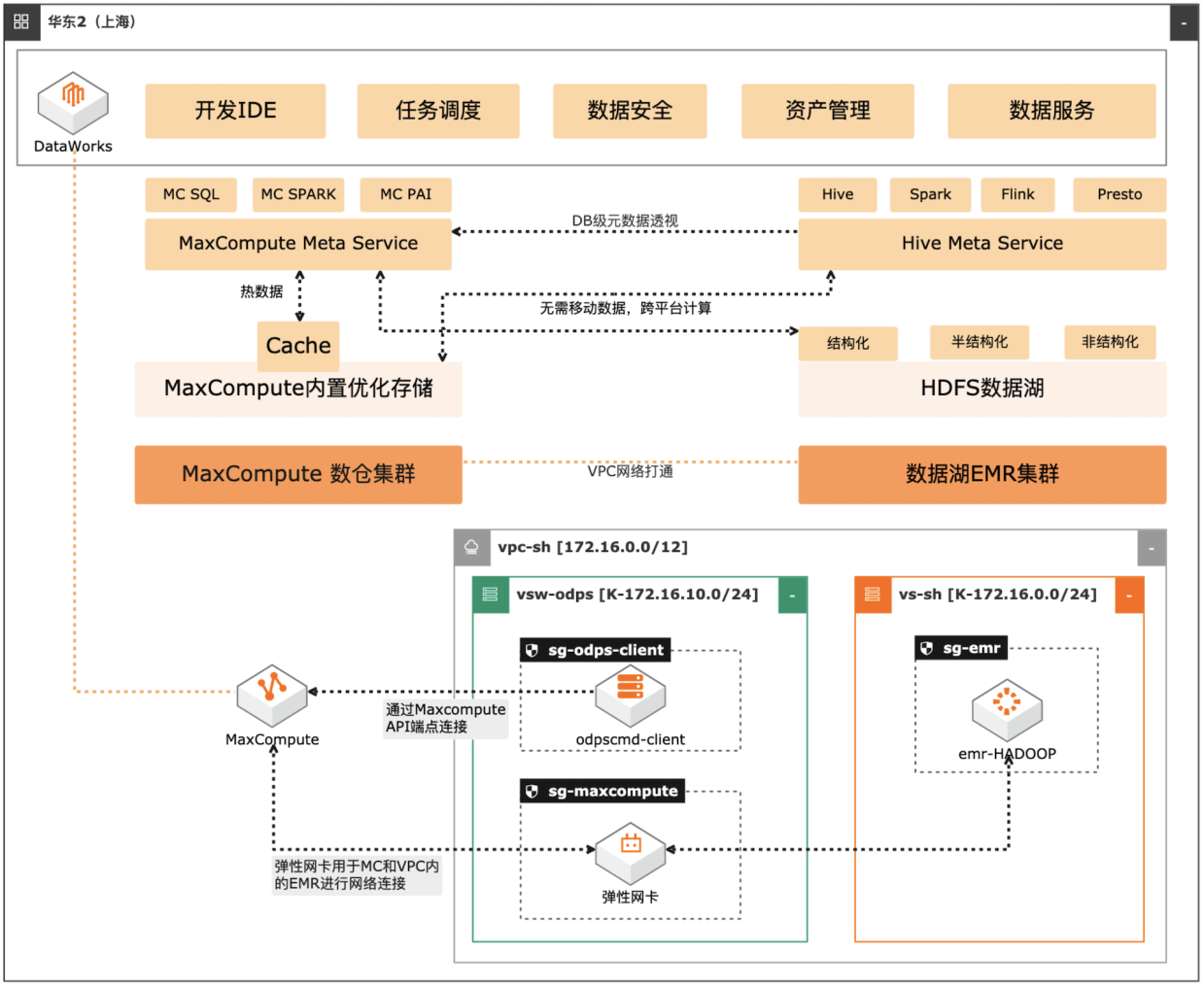

MaxCompute湖仓一体方案

场景描述 自建数据湖与云数仓的融合解决方案,将 MaxCompute与自建的Hive集群做数据打 通,通过存储共享,元数据镜像等方式,解 决传统模式下的存储冗余,计算资源弹性能 力弱的痛点。可大幅度增强系统的资源弹 性,解决业务高峰期计算资源不足的问题。 方案优势 1.业务无侵入性:现有业务无需改造。 2.性能优化:MaxCompute在SQL上做 了大量优化与能力沉淀,可提高SQL 运行性能,降低计算成本。 3.灵活管理:元数据实时同步,无需额外 管理数据同步任务。 4.资源弹性:利用MaxCompute计算池 弹性进行海量数据计算。 解决问题 1.增强业务高峰期的资源弹性。 2.优化自建数据湖的数据治理能力。 3.减少跨平台数据处理的存储冗余。 产品列表 专有网络VPC 云服务器ECS 访问控制RAM 运维编排OOS MaxCompute(原ODPS) 云企业网CEN

查看数据库表 元数据和数据库信息映射完成后,我们可以直接在 MaxCompute中查看到 hive数据 库的表信息。步骤1 进入 odpscmd,选择使用刚刚创建的数据库。键入命令 show tables;查看所有表。发现可以通过 odpscmd客户端查看到在 Hive中创建的表信息。3.4.执行 SQL任务 在 MaxCompute中,我们可以通过 Hive混合模式来运行...

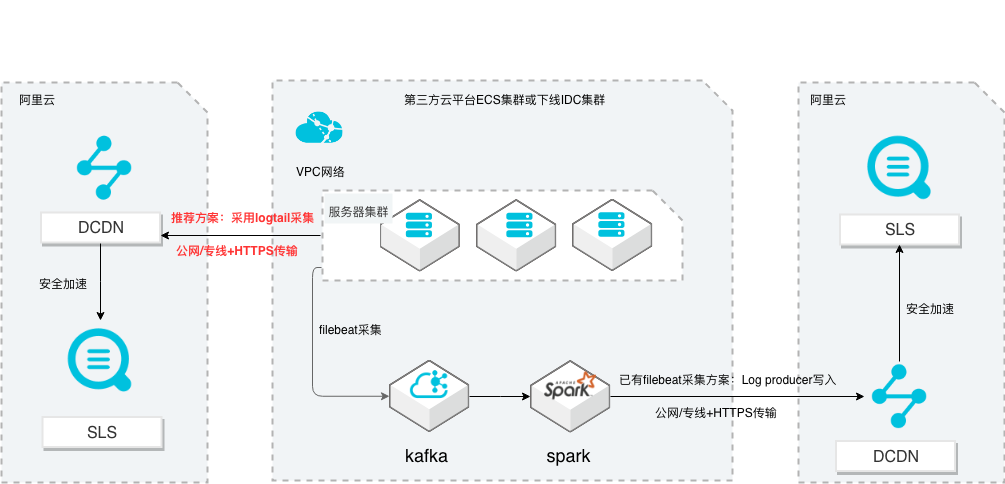

SLS多云日志采集、处理及分析

场景描述 从第三方云平台或线下IDC服务器上采集 日志写入到阿里云日志服务,通过日志服务 进行数据分析,帮助提升运维、运营效率, 建立DT 时代海量日志处理能力。 针对未使用其他日志采集服务的用户,推荐 在他云或线下服务器安装logtail采集并使用 Https安全传输;针对已使用其他日志采集 工具并且已有日志服务需要继续服务的情 况,可以通过Log producer SDK写入日志 服务。 解决问题 1.第三方云平台或线下IDC客户需要使用 阿里云日志服务生态的用户。 2.第三方云平台或线下IDC服务器已有完 整日志采集、处理及分析的用户。 产品列表 E-MapReduce 专有网络VPC 云服务器ECS 日志服务LOG DCDN

E-MapReduce:阿里云 E-MapReduce(EMR)是构建在阿里云云服务器 ECS 上 的开源 Hadoop、Spark、Hive、Flink 生态大数据 PaaS 产品。提供用户在云上 使用开源技术建设数据仓库、离线批处理、在线流式处理、即时查询、机器学习 等场景下的大数据解决方案。更多信息,请参见专有 E-MapReduce简介...

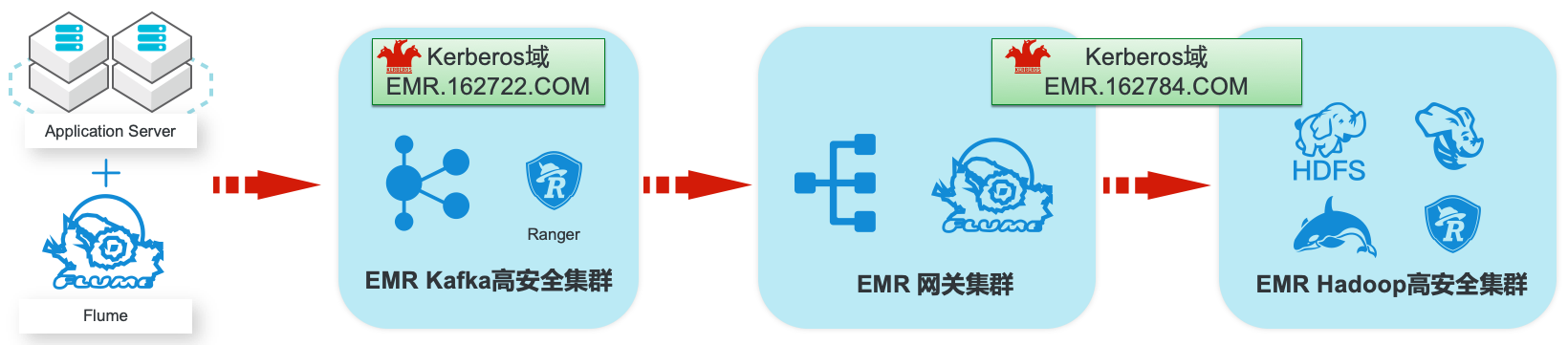

EMR集群安全认证和授权管理

场景描述 阿里云EMR服务Kafka和Hadoop安全集群使 用Kerberos进行用户安全认证,通过Apache Ranger服务进行访问授权管理。本最佳实践中以 Apache Web服务器日志为例,演示基于Kafka 和Hadoop的生态组件构建日志大数据仓库,并 介绍在整个数据流程中,如何通过Kerberos和 Ranger进行认证和授权的相关配置。 解决问题 1.创建基于Kerberos的EMR Kafka和 Hadoop集群。 2.EMR服务的Kafka和Hadoop集群中 Kerberos相关配置和使用方法。 3.Ranger中添加Kafka、HDFS、Hive和 Hbase服务和访问策略。 4.Flume中和Kafka、HDFS相关的安全配 置。 产品列表:E-MapReduce、专有网络VPC、云服务器ECS、云数据库RDS版

总结 Hadoop集群:Hive数据仓库的 HDFS权限 我们使用 admin用户登录到 Hue管理界面,并在 4.1节将 HDFS的原始文件加载 到 Hive分区表。此时,可以看到实际上文件是在 HDFS文件系统中,从/usr/dfs/data/flume/kafka/20200311 移动到:/user/hive/warehouse/log_data_warehouse.db/apache_logs/ds=20200311 需要特别说明一下...

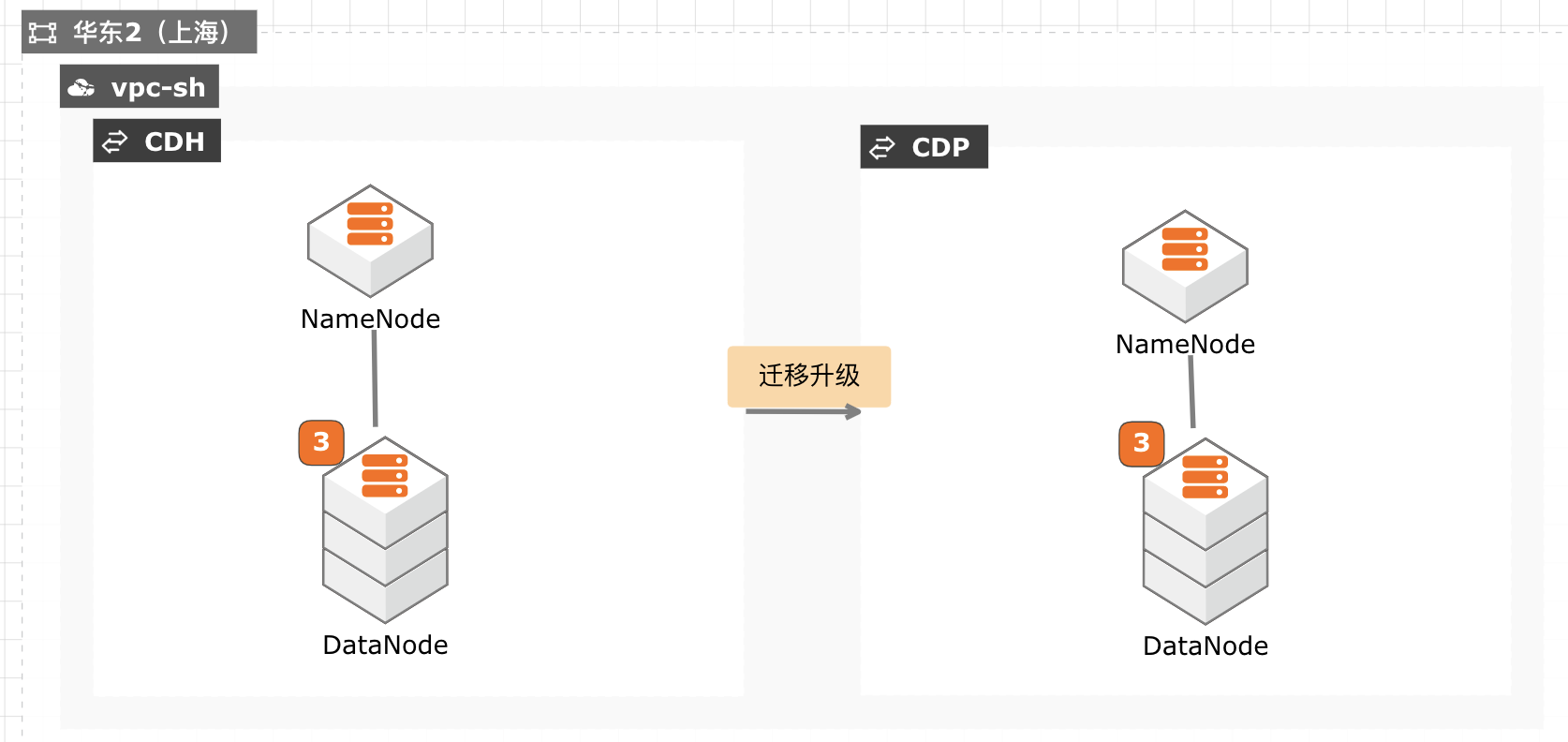

CDH迁移升级CDP最佳实践

当前 CDH 免费版停止下载,终止服务,针对需要企业版服务能力并且CDH 升级过程对业务影响较小的客户,通过安装新的 CDP 集群,将现有数据拷贝至新集群,然后将新集群切换为生产集群,升级过程没有数据丢失风险,停机时间较短,适合大部分互联网客户升级使用。

构造 Hbase测试数据 接下来把 hive 数据导入 Hbase,这里测试只取 item 表。首先进入 hive,使用 tpcds_text_2数据库,创建 Hbase的 hive关联表。hive use tpcds_text_2;CREATE TABLE hbase_hive_tabale_item(key string,i_item_sk bigint,i_item_id string,i_rec_start_date string,i_rec_end_date string,i_item_desc ...

实时数仓Hologres

Hologres(原交互式分析)是一站式实时数据仓库引擎,支持海量数据实时写入、实时更新、实时分析,支持标准SQL(兼容PostgreSQL协议),支持PB级数据多维分析(OLAP)与自助分析(Ad Hoc),支持高并发低延迟的在线数据服务(Serving),与MaxCompute、Flink、DataWorks深度融合,提供离在线一体化全栈数仓解决方案。

与Flink、Spark等计算框架原生集成,通过内置Connector,支持高通量数据实时写入与更新,支持源表、结果表、维度表多种场景,支持多流合并等复杂操作.所见即所得的开发.数据实时写入即可查询,支持DB、Schema、Table三级体系,支持视图View,原生支持Update/Delete,支持关联、嵌套、窗口等丰富表达能力,支持半结构JSON...

来自:

云产品

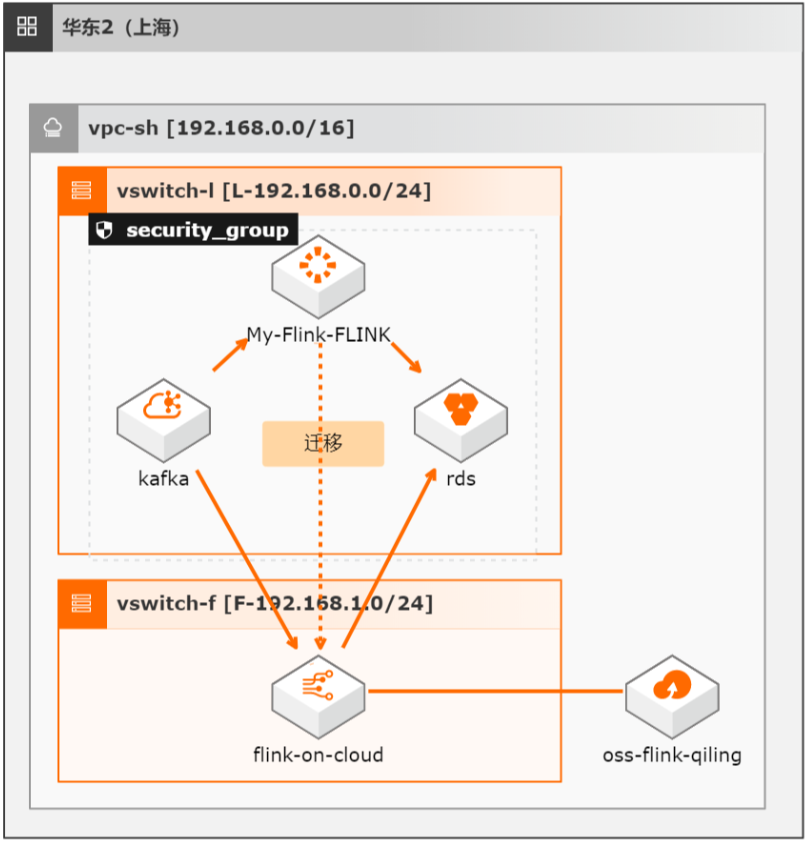

开源Flink迁移实时计算Flink全托管版最佳实践

本方案介绍如何将自建开源Flink集群的流式任务(包含Datastream、Table/SQL、PyFlink任务)迁移至阿里云实时计算全托管版。

比如聚合任务按小时、天维度计算的聚合值,清洗任务加工的按天分区表等,在数据对比时就可以根据对应的时间周期来进对比,比如小时周期的任务实际已完整处理多个小时数据 后,就可以对比处理过的小时数 据,而天维度的聚合值,一般就需要等待新任务处理完完整的一天数 据后才能对比。2、数据规模 中小数据规模:建议进行全量...

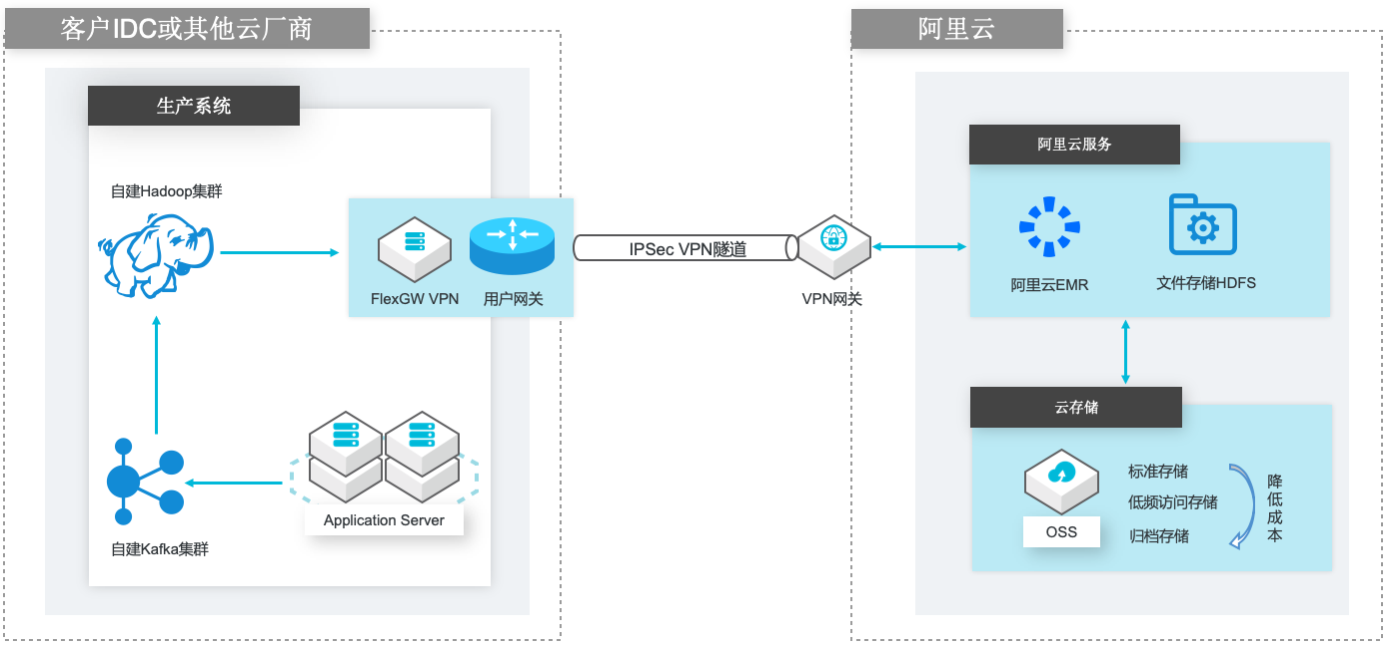

自建Hadoop迁移到阿里云EMR

场景描述 场景1:自建Hadoop集群数据(HDFS)迁移到 阿里云EMR集群的HDFS文件系统; 场景2:自建Hadoop集群数据(HDFS)迁移到 计算存储分离架构的阿里云EMR集群,以OSS 和JindoFS作为EMR集群的后端存储。 解决的问题 客户自建Hadoop迁移到阿里云EMR集群的 技术方案; 基于IPSecVPN隧道构建安全和低成本数据 传输链路 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

VPN网关 VPN网关是一款基于 Internet的网络连接服务,通过加密通道的方式实现企业数 据中心、企业办公网络或 Internet终端与阿里云专有网络(VPC)安全可靠的连 接。VPN 网关提供 IPSec-VPN 连接和 SSL-VPN 连接。详情请查看 https://www.aliyun.com/product/vpn IPSec VPN 基于路由的 IPSec-VPN,不仅可以更方便的配置和...

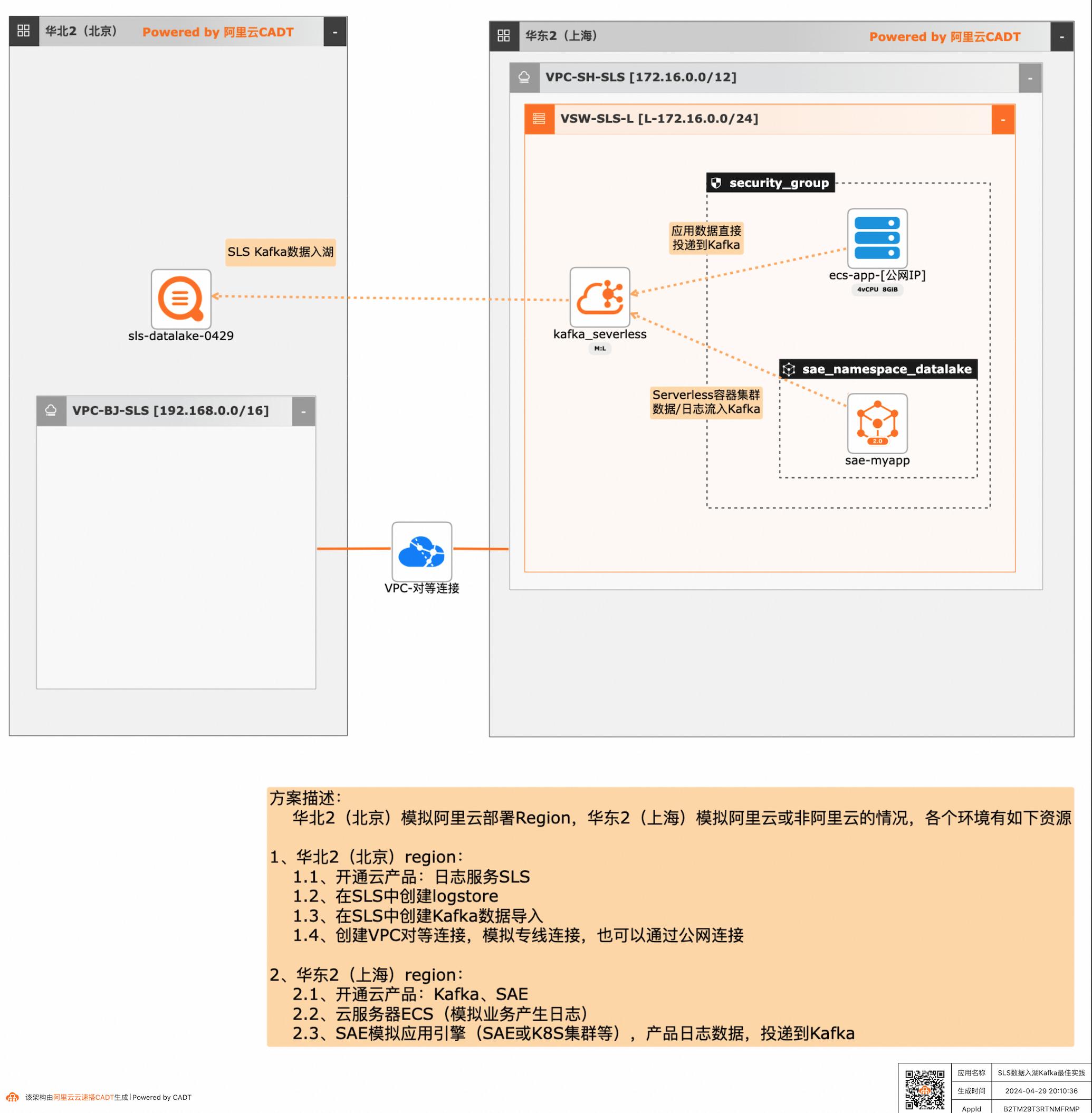

SLS数据入湖Kafka最佳实践

应用和数据分散在多云或混合云,在面对多云/混合云这样大的趋势下,数据无法进行统一的聚合、分析处理和导出等,本方案给出了在多云/混合云场景下,构建通过标准的Kafka协议和托管服务,SLS可以连接Kafka数据入湖导入,然后进行统一的海量数据的集中存储、智能转储、聚合分析查询等。

SLS 数据入湖 Kafka 最佳实践 业务架构 场景描述 应用和数据分散在多云或混合云,在面对多云/混合云这样大的趋势下,数据无法进行统一的 聚合、分析处理和导出等,本方案给出了在多 云/混合云场景下,构建通过标准的Kafka协议 和托管服务,SLS可以连接Kafka数据入湖导 入,然后进行统一的海量数据的集中存储、智 能转储、...

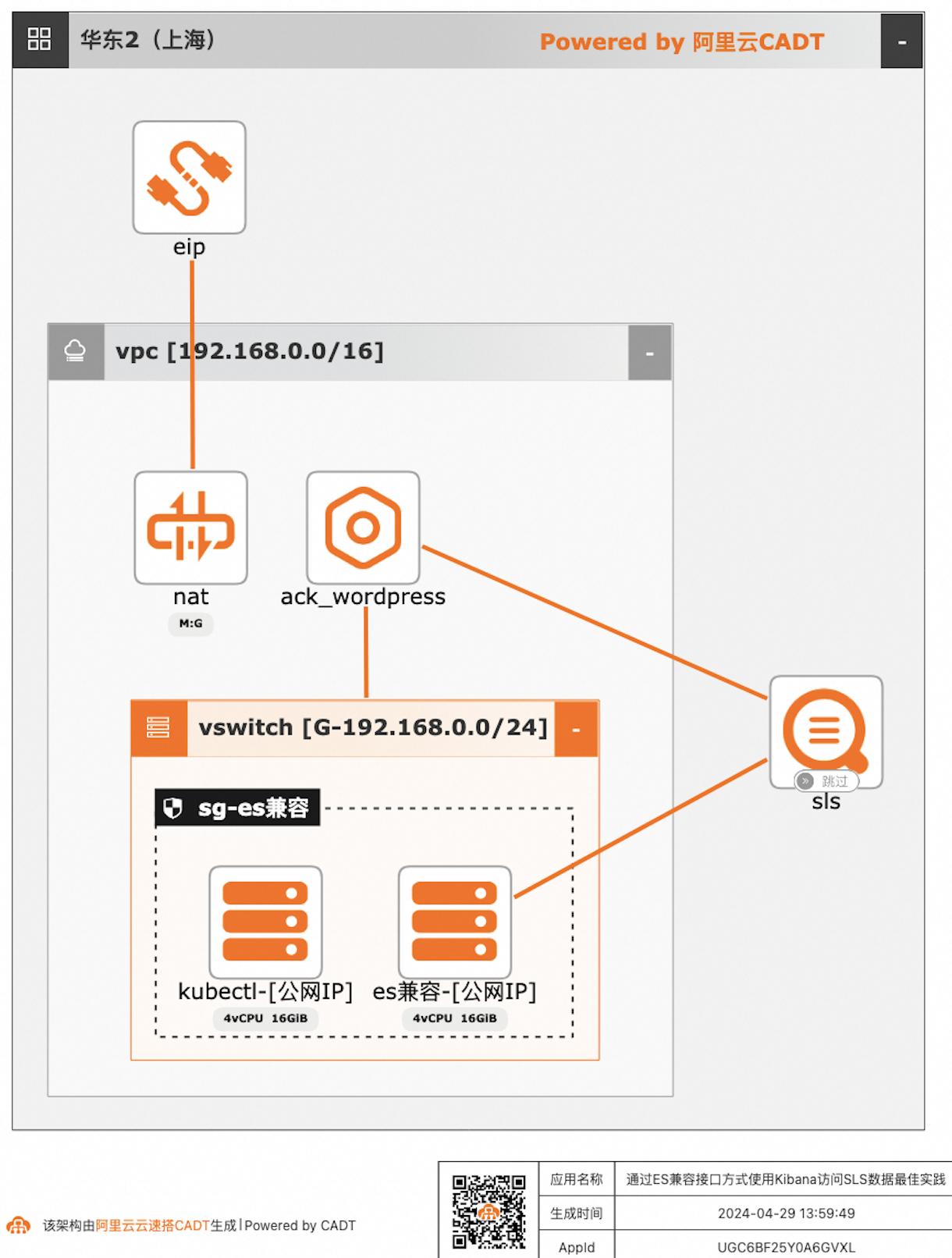

通过ES兼容接口方式使用Kibana访问SLS数据

自建ELK日志系统的客户迁移到阿里云日志服务SLS后,对SLS查询分析语法不太熟悉的客户,可以继续沿用原有的查询分析习惯,在不改变使用方式习惯的情况下,通过Elasticsearch兼容接口的方式使用Kibana访问SLS。

通过ES兼容接口方式使用Kibana访问SLS数据最佳实践 业务架构 场景描述 日志服务SLS提供Elasticsearch兼容接口,支 持客户将日志采集到日志服务后,仍可以继续沿 用Elasticsearch的查询方案,即通过使用 Kibana访问日志服务的Elasticsearch兼容接 口,实现查询SLS数据。应用场景 自建ELK日志系统的客户迁移到阿里云日志服 务...

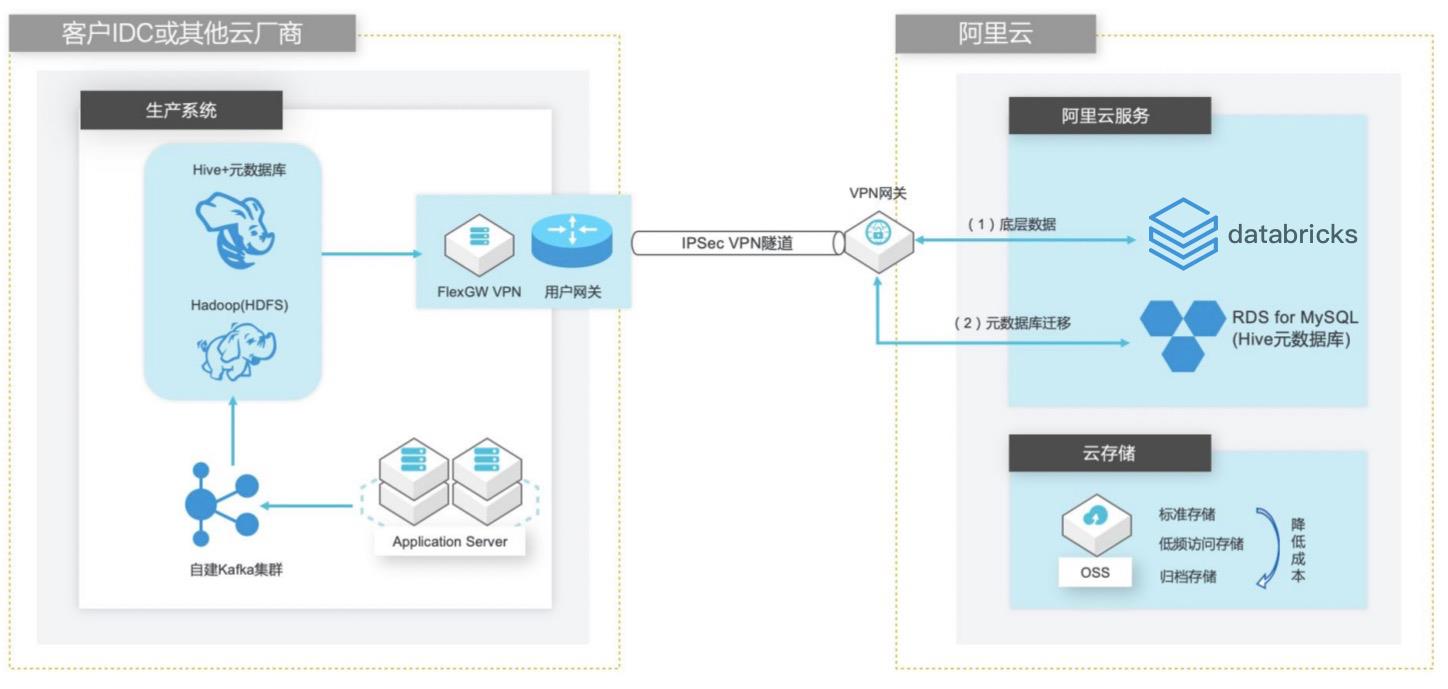

自建Hive数据仓库跨版本迁移到阿里云Databricks数据洞察

场景描述 客户在IDC或者公有云环境自建Hadoop集群构建数据仓库和分析系统,购买阿里云Databricks数据洞察集群之后,涉及到数仓数据和元数据的迁移以及Hive版本的订正更新。 方案优势 1. 全托管Spark集群免运维,节省人力成本。 2. Databricks数据洞察与阿里云其他产品(OSS、RDS、MaxCompute、EMR)进行深度整合,支持以这些产品为数据源的输入和输出。 3. 使用Databricks Runtime商业版引擎相比开源Spark性能有3-5倍的提升。 解决问题 1. Hive数仓数据迁移OSS方案。 2. Hive元数据库迁移阿里云RDS方案。 3. Hive跨版本迁移到Databricks数据洞察使用Delta表查询以提高查询效率。

自建 Hive数据仓库跨版本迁移到阿里云 Databricks数据洞察 业务架构 场景描述 客户在 IDC或者公有云环境自建 Hadoop集群 构建数据仓库和分析系统,购买阿里云 Databricks数据洞察集群之后,涉及到数仓数 据和元数据的迁移以及 Hive版本的订正更新。方案优势 1.全托管 Spark集群免运维,节省人力成 本。2.Databricks数据洞察...

ECS 数据备份与保护

随着企业核心业务规模不断扩大,需要根据业务需求对生产环境中的关键数据进行定期备份。

产品解决方案文档与社区权益中心定价云市场合作伙伴支持与服务了解阿里云备案控制台ECS 数据备份与保护方案介绍方案优势应用场景方案部署ECS 数据备份与保护随着企业核心业务规模不断扩大,需要根据业务需求对生产环境中的关键数据进行定期备份,在发生误操作、病毒感染、或攻击等情况时,能够快速从已有的快照恢复到某个...

来自:

解决方案

Spark on ECI大数据分析

场景描述 方案优势 1.计算引擎弹性扩缩容,兼顾资源弹性与计 算资源成本优化。 2.计算与存储分离架构,结合阿里云原生云 存储产品,海量数据湖优势。 3.Kubernetes原生的调度性能优势,提升在 大规模分析作业时的分析性能优势分。 4.集群资源隔离和按需分配。 解决问题 1.计算资源弹性能力不足,计算资源成本管 控能力欠缺. 2.集群资源调度能力和隔离能力不足。 3.计算与存储无法分离,大数据量分析时出 现数据存储资源瓶颈。 4.Spark submit方式提交分析作业参数支持 有限等缺点。 产品列表 容器服务Kubernetes版(ACK) 弹性容器实例(ECI) 文件存储HDFS 对象存储OSS 专有网络VPC 容器镜像服务ACR

应用范围 需要使用 Spark on Kubernetes解决方案的用户 对 Spark大数据分析平台计算资源成本控制考虑的用户 需要有灵活可扩展计算平台资源弹性及管控的用户 名词解释 文件存储 HDFS:阿里云文件存储 HDFS是面向阿里云 ECS实例及容器服务等计 算资源的文件存储服务,允许用户像在 Hadoop分布式文件系统中管理和访问数 据,...

无代理ECS数据备份与高效环境搭建

本方案是基于快照提供数据保护和环境搭建的解决方案。可以帮助您实现无代理且有效可靠的数据备份,同时还可以帮助您快速克隆部署开发测试环境。使用基于快照的备份不仅简单有效,在数据备份以及恢复中也能保证稳定可靠,同时基于快照的环境搭建,不仅可以免于从0到1搭建环境,还可以将环境、数据等全部打包克隆到新机器上。

产品解决方案文档与社区权益中心定价云市场合作伙伴支持与服务了解阿里云备案控制台无代理ECS备份与高效环境搭建方案介绍方案优势应用场景方案部署方案权益无代理ECS备份与高效环境搭建本方案是基于快照提供数据保护和环境搭建的解决方案,可以帮助您实现无代理且有效可靠的数据备份,同时还可以帮助您快速克隆部署开发测试...

来自:

解决方案

- 产品推荐

- 这些文档可能帮助您