金融专属大数据workshop

实践目标 学习搭建一个实时数据仓库,掌握数据采集、存储、计算、输出、展示等整个业务流程。 整个实时数据仓库系统全部基于阿里云产品进行架构搭建,用户可以掌握并学会运用各个服务组件及各个组件之间如何联动。 理解阿里云原生实时离线一体数仓解决方案架构以及掌握交付落地的实践使用方法。 前置知识要求 熟练掌握SQL语法 对大数据体系系统知识有一定的了解

选择模板创建 步骤1 在我的可视化中,单击新建PC端可视化。文档版本:20210803(发布日期)52阿里云最佳实践金融大数据WorkShop 最佳实践项目实践 步骤2 选择集团数据看板模板,并单击创建。步骤3 在创建数据大屏对话框中,设置数据大屏名称,并单击创建。文档版本:20210803(发布日期)53阿里云最佳实践金融大数据...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

大数据workshop

大数据workshop

Flink SQL作业读取了 Datahub的历史脏数据,可以在 修改 Flink SQL作业以后并将 Flink SQL作业的恢复策略设置为 NONE再重新上 线启动 Flink SQL作业,因为 Flink SQL作业改代码/增加一些参数,是要停止重 启,且恢复策略要为 NONE,原因是因为 DAG 会变化导致 state 不兼容。文档版本:20210628(发布日期)55 阿里云最佳...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

云服务总线CSB

云服务总线CSB是一个基于高可用分布式技术构建的服务API开放平台,帮助企业打通内外新旧系统,实现跨技术平台、跨应用系统、跨企业组织的服务互通,以服务API的形式,加以一致的组织和管控,构建企业内部以及与上下游、第三方企业之间融合、重塑、创新的合作平台。

位于企业内部数据中心的业务系统,与企业在云上的业务系统之间,通过各自环境内云服务总线CSB实例之间“桥接”实现的服务通道,把各自的服务在对方云CSB实例上发布成API,进行管理和授权,让对方可以订阅和访问.企业能力可对外开放,也可引入外部能力内部使用.内外能力双向开放.可对接基于不同技术架构构建的系统和端,统一...

来自:

云产品

数据总线Datahub

数据总线(DataHub)服务是阿里云提供的流式数据(Streaming Data)服务,它提供流式数据的发布(Publish)和订阅(Subscribe)的功能,拥有高吞吐量、高稳定性、低成本等特点,与阿里云大数据生态系统完美打通,让您可以轻松构建基于流式数据的分析和应用。

通过数据总线,您可以实时接入APP、WEB、IoT和数据库等产生的异构数据,统一管理,并投递到下游的分析、归档等系统,构建清晰的数据流,让您更好的释放数据的价值.对外,大数据系统与业务系统解耦,对内,大数据系统各组件之间解耦.通过数据总线,业务数据能够实时汇入大数据系统,缩短数据分析周期.实时计算Flink.实时数据...

来自:

云产品

事件总线 EventBridge

事件总线 EventBridge是阿里云提供的一款无服务器事件总线服务,支持阿里云服务、自定义应用、SaaS应用以标准化、中心化的方式接入,并能够以标准化的 CloudEvents 1.0 协议在这些应用之间路由事件,帮助您轻松构建松耦合、分布式的事件驱动架构。

产品功能子项.产品功能子项描述....事件总线 EventBridge 是阿里云提供的一款无服务器事件总线服务,支持阿里云服务、自定义应用、SaaS应用以标准化、中心化的方式接入,并能够以标准化的 CloudEvents 1.0 协议在这些应用之间路由事件,帮助您轻松构建松耦合、分布式的事件驱动架构.事件总线 EventBridge.

来自:

云产品

地址标准化

地址标准化(Address Purification)是依托阿里云海量的地址语料库,及超强的NLP算法实力所沉淀出的高性能、高准确率、功能覆盖最全的标准地址算法服务。可为企业、政府机关及开发者提供地址数据清洗。地址标准化通过地址解析、补全、匹配等赋能业务的上层应用。

地址标准化(Address Purification)是一站式闭环地址数据处理和服务平台产品,依托阿里云海量的地址语料库,针对各行业业务系统所登记的地址数据,进行纠错、补全、归一、结构化、标签化等NLP处理清洗,实现地址库的标准化,并向上提供地址智能填写、地址搜索/联想、地址正/逆编码、地址围栏等地址服务.提供一系列将详细的...

来自:

云产品

阿里云最佳实践离线大数据workshop

本最佳实践,首先搭建一个简化的电商 demo 系统,然后为此 demo 系统构建一套离 线大数据分析系统。 实践目标 1. 学习搭建一个离线大数据分析系统,学习从数据采集到数据存储和业务分析的业 务流程。 2. 整个离线大数据分析系统全部基于阿里云产品进行搭建,学习掌运用各个服务组 件及各个组件之间如何联动。 背景知识要求 熟练掌握 SQL 语法 对大数据体系系统知识有一定的了解

游士 创建 V1.1 2021-08-02 敬海 更新细节 文档版本:20210802(发布日期)I离线大数据分析WorkShop 产品介绍 产品介绍 云速搭CADT:是一款为上云应用提供自助式云架构管理的产品,显著地降低应 用云上管理的难度和时间成本。本产品提供丰富的预制应用架构模板,同时也支 持自助拖拽方式定义应用云上架构;支持较多阿里...

来自:

最佳实践

相关产品:云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,日志服务(SLS),大数据计算服务 MaxCompute,DataV数据可视化,数据总线,Quick BI,云速搭

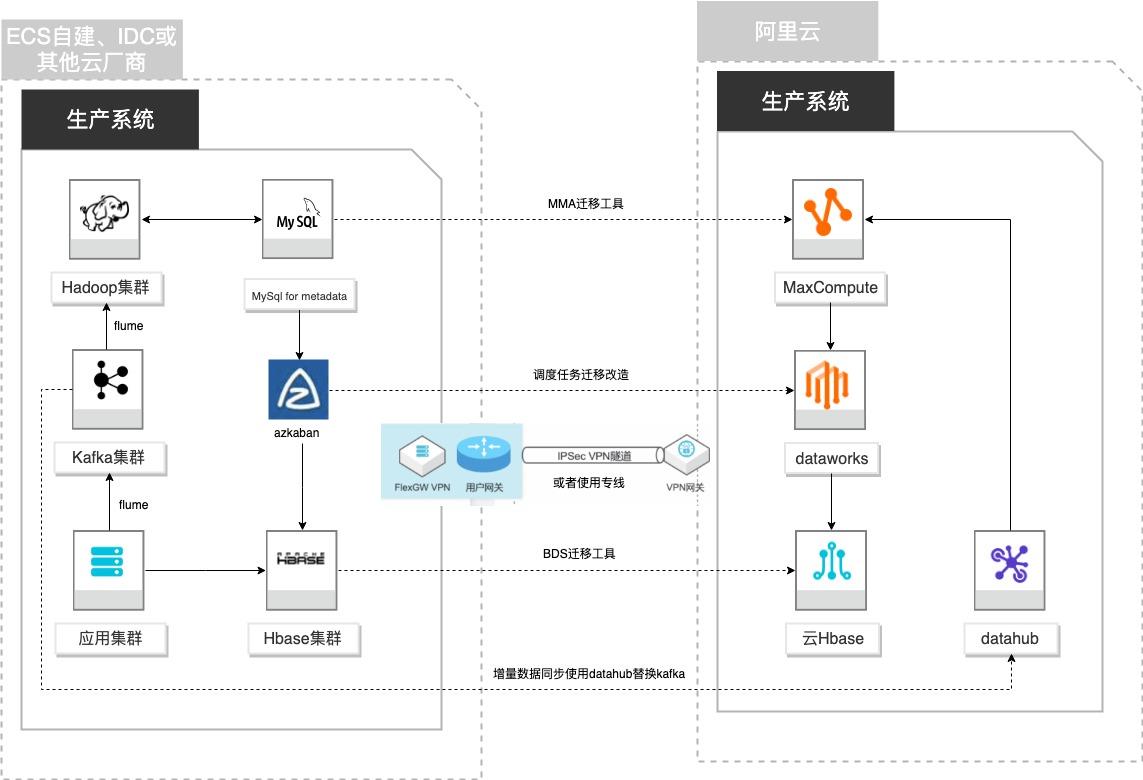

自建Hadoop迁移MaxCompute

场景描述 客户基于ECS、IDC自建或在友商云平台自建了大数 据集群,为了降低企业大数据计算平台的成本,提高 大数据应用开发效率,更有效保障数据安全,把大数 据集群的数据、作业、调度任务以及业务数据库整体 迁移到MaxCompute和其他云产品。 解决的问题 自建Hadoop集群搬迁到MaxCompute 自建Hbase集群搬迁到云Hbase 自建Kafka或应用数据准实时同步到 MaxCompute 自建Azkaban任务迁移到Dataworks任务 产品列表 MaxCompute,Dataworks、云数据库Hbase版、Datahub、VPC,ECS。

Flume Flume是一种分布式,可靠且可用的服务,用于有效地收集,聚合和移动大量日 志数据。它具有基于流数据流的简单灵活的体系结构。它具有可调整的可靠性机 制以及许多故障转移和恢复机制,具有强大的功能和容错能力。它使用一个简单 的可扩展数据模型,允许在线分析应用程序。文档版本:20210723 IV 自建Hadoop迁移...

云速搭部署Flink应用

本水煎通过云速搭实现一个DataHub+Flink的实时流计算引擎架构,利用DataHub收集原始数据,推送到Flink进行基于流式数据的分析和应用。

已开通以下服务:ᅳ 专有网络 VPC ᅳ 云速搭 CADT ᅳ 实时计算 Flink ᅳ 数据总线 DataHub ᅳ 对象存储 OSS 文档版本:20211103 2 云速搭部署 Flink应用 产品介绍 产品介绍 云速搭 CADT:是一款为上云应用提供自助式云架构管理的产品,显著地降低应 用云上管理的难度和时间成本。本产品提供丰富的预制应用架构模板,同时也...

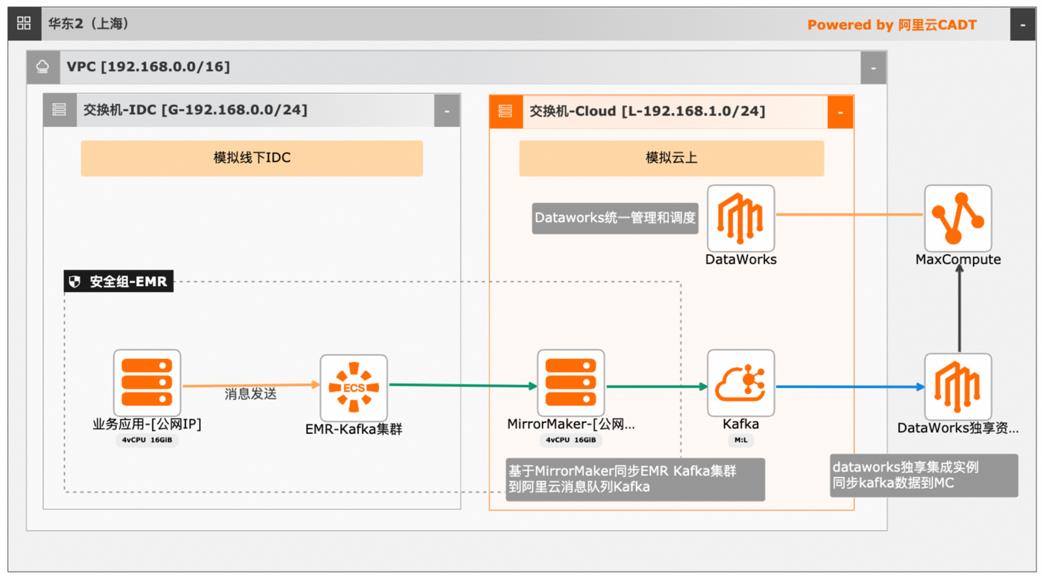

大数据近实时数据投递MaxCompute

本文介绍离线大数据场景使MaxCompute构建云 上近实时数仓,打通云下数据上云链路,解决数据复杂类型支持和动态分区问题,满足高级数据处理需求的最佳实践。 l混合云环境下,现有业务系统零改造,打通数据上云链路。 l使用UDF实现复杂数据类型转换和数据动态分区。 l使用DataWorks配置周期调度业务流程,数据自动入仓。 l借助MaxCompute优化计算引擎,实现降本增效。 产品列表 云服务器ECS 专有网络VPC 访问控制RAM 数据总线DataHub E-MapReduceEMR DataWorks 大数据计算服务MaxCompute

获取 Kafka 接入点 在 EMR Kafka集群页面中,展开 emr_core_1后有三个节点,记录这三个 IP地 址。记录上述地址,后续章节需要用到。192.168.0.231,192.168.0.232,192.168.0.233 3.2.配置 App Server 应用环境 CADT架构图中,双击 ecs“业务应用”,点击 远程登录。文档版本:20240419 12 大数据近实时数据投递 MaxCompute...

- 产品推荐

- 这些文档可能帮助您