基于DataWorks的大数据一站式开发及数据治理

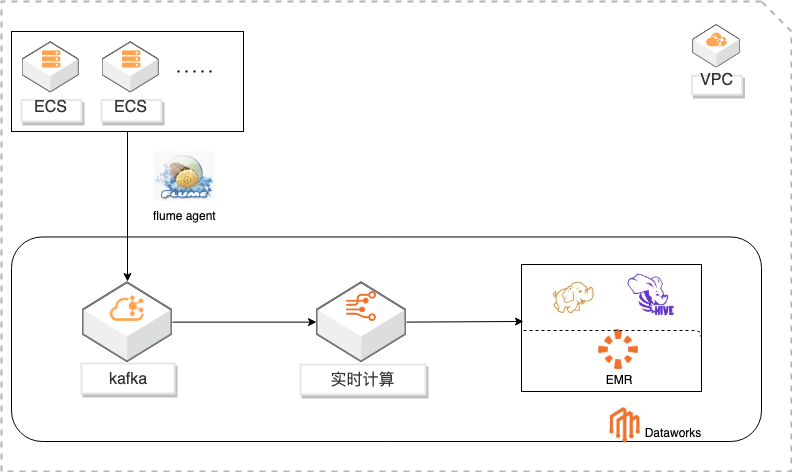

概述 基于Dataworks做大数据一站式开发,包含数据实时采集到kafka通过实时计算对数据进行ETL写入HDFS,使用Hive进行数据分析。通过Dataworks进行数据治理,数据地图查看数据信息和血缘关系,数据质量监控异常和报警。 适用场景 日志采集、处理及分析 日志使用Flink实时写入HDFS 日志数据实时ETL 日志HIVE分析 基于dataworks一站式开发 数据治理 方案优势 大数据一站式开发,完善的数据治理能力。 性能优越:高吞吐,高扩展性。 安全稳定:Exactly-Once,故障自动恢复,资源隔离。 简单易用:SQL语言,在线开发,全面支持UDX。 功能强大:支持SQL进行实时及离线数据清洗、数据分析、数据同步、异构数据源计算等Data Lake相关功能 ,以及各种流式及静态数据源关联查询。

模拟日志采集 步骤1 在 ECS控制台找到前面创建日志服务器,登录 ECS(确保开启了 22端口,没有开启 请在安全组中添加)。步骤2 在合适的目录下,编辑脚本,输入下述代码。本示例中,使用路径/root/log/src来做示 范:每秒生成一条日志,并写入文件,python代码如下(请注意从 democode.txt中拷贝 避免字符问题,此例用来...

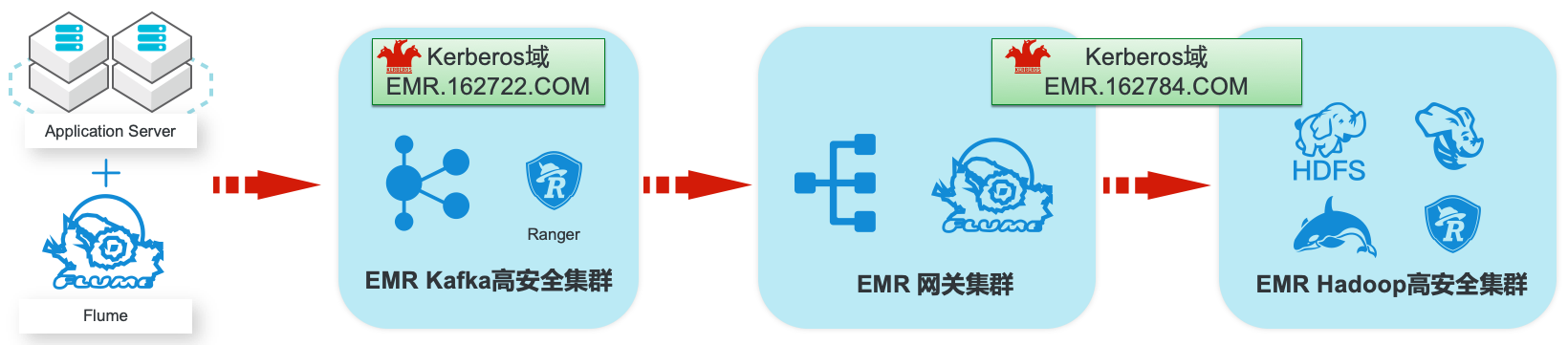

EMR集群安全认证和授权管理

场景描述 阿里云EMR服务Kafka和Hadoop安全集群使 用Kerberos进行用户安全认证,通过Apache Ranger服务进行访问授权管理。本最佳实践中以 Apache Web服务器日志为例,演示基于Kafka 和Hadoop的生态组件构建日志大数据仓库,并 介绍在整个数据流程中,如何通过Kerberos和 Ranger进行认证和授权的相关配置。 解决问题 1.创建基于Kerberos的EMR Kafka和 Hadoop集群。 2.EMR服务的Kafka和Hadoop集群中 Kerberos相关配置和使用方法。 3.Ranger中添加Kafka、HDFS、Hive和 Hbase服务和访问策略。 4.Flume中和Kafka、HDFS相关的安全配 置。 产品列表:E-MapReduce、专有网络VPC、云服务器ECS、云数据库RDS版

Knox作为阿里云 EMR集群的默认服务进行安装,安装后,使用者可以指定阿里 云 RAM子用户作为认证用户,在公网直接访问 Yarn、HDFS、SparkHistory等服 务的 Web UI。1.2.授权(Authorization)授权是任何计算环境的基本安全要求之一。其目标是确保只有适当的人员或流程才能 访问、查看、使用、控制或更改特定的资源、服务或...

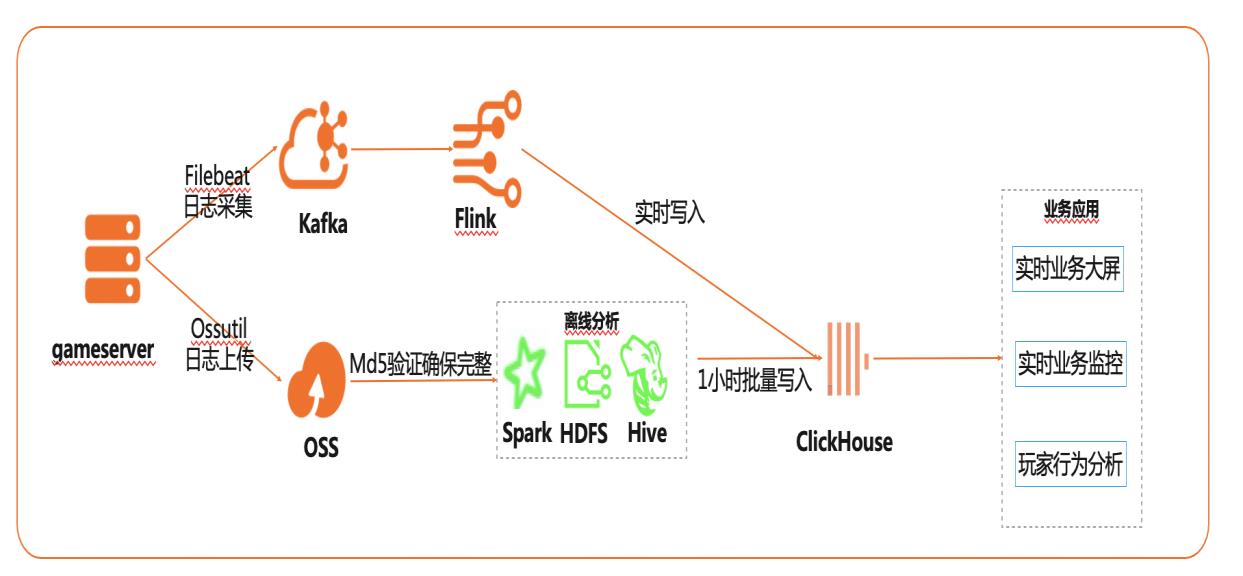

基于Flink+ClickHouse构建实时游戏数据分析

在互联网、游戏行业中,常常需要对用户行为日志进行分析,通过数据挖掘,来更好地支持业务运营,比如用户轨迹,热力图,登录行为分析,实时业务大屏等。当业务数据量达到千亿规模时,常常导致分析不实时,平均响应时间长达10分钟,影响业务的正常运营和发展。 本实践介绍如何快速收集海量用户行为数据,实现秒级响应的实时用户行为分析,并通过实时流计算Flink/Blink、云数据库ClickHouse等技术进行深入挖掘和分析,得到用户特征和画像,实现个性化系统推荐服务。 通过云数据库ClickHouse替换原有Presto数仓,对比开源Presto性能提升20倍。 利用云数据库ClickHouse极致分析性能,千亿级数据分析从10分钟缩短到30秒。 云数据库ClickHouse批量写入效率高,支持业务高峰每小时230亿的用户数据写入。 云数据库ClickHouse开箱即用,免运维,全球多Region部署,快速支持新游戏开服。 Flink+ClickHouse+QuickBI

Filebeat 可以监听指定的日 志文件或位置,从中收集日志事件并将其转发到 Elasticsearch或 Logstash进行索引,本实践采用 Filebeat收集 game-server的日志,并转发到 kafka。步骤1 在 ECS服务器上面,下载 Filebeat,为了兼容消息队列 kafka版本,推荐下载 filebeat-6.4.0-linux-x86_64:wget ...

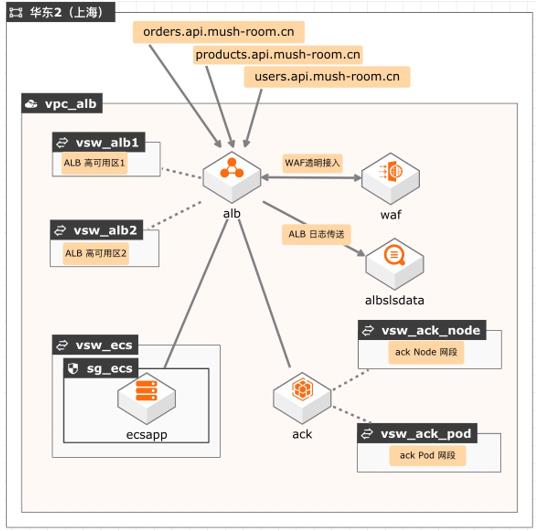

基于ALB的统一流量调度和监控

企业在走向容器化过渡阶段,内部同时存在ECS应用和容器应用的情况,在多域名业务场景下,为了对应用的入方向流量进行统一的调度和监控,可通过ALB快速完成内部应用统一流量的管控。 典型场景 多域名转发到混合应用类型场景。 方案优势 1、 高弹性,高并发 2、 减少SLB+EIP数量 3、 一键WAF透明接入 4、 配置简单易上手 5、 统一流量运营分析

云服务器 ECS免去了您采购 IT 硬件的前期准备,让您像使用水、电、天然气等公共资源一样便捷、高效地使用服 务器,实现计算资源的即开即用和弹性伸缩。阿里云ECS持续提供创新型服务器,解决多种业务需求,助力您的业务发展。详见:https://www.aliyun.com/product/ecs 云速搭 CADT:是一款为上云应用提供自助式云架构管理的...

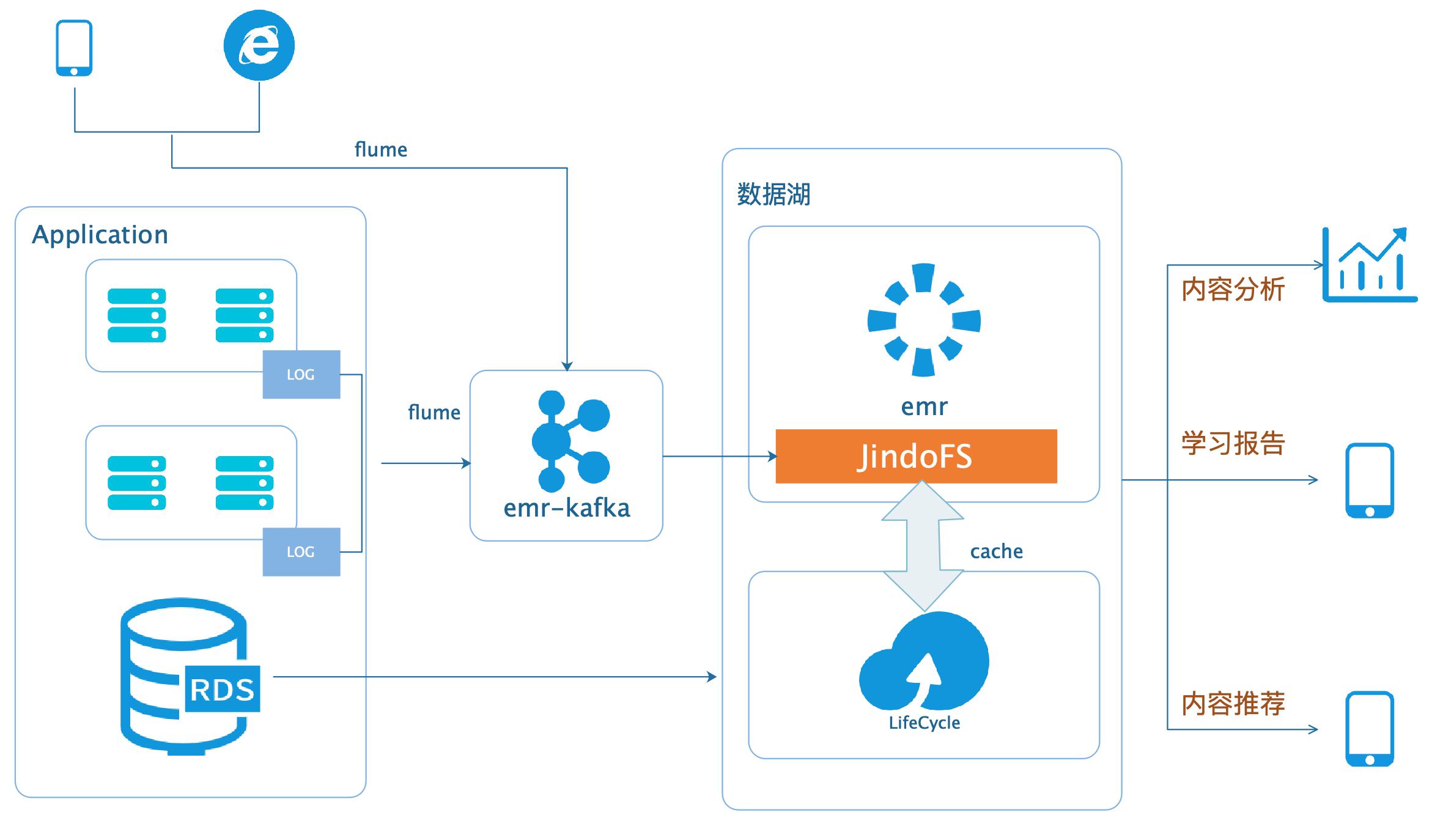

数据湖-在线学习场景数据分析

场景描述 本场景以在线教育中一个答题闯关类的应用为 例,使用WebServer来模拟演示这类日志数据 的分析处理。通过Nginx和Pythonflask搭建 WebServer,模拟应用中的关键页面,比如登 录、课程内容等,之后构造若干用户使用的模拟 日志数据,投递到数据湖进行分析后获取应用 PV、UV、课程内容访问排行、平均得分等等。 解决问题 基于数据湖(EMR+OSS)搭建大数据平台。 EMR和OSS使用和配置。 数据统一存储到OSS。 产品列表 E-MapReduce 对象存储OSS 云服务器ECS 访问控制RAM 专有网络VPC

本场景以在线教育中一个答题闯关类的应用为例,使用WebServer来模拟演示这类日 志数据的分析处理。通过Nginx和Pythonflask搭建WebServer,模拟应用中的关键 页面,比如登录、课程内容等,之后构造若干用户使用的模拟日志数据,投递到数据 湖进行分析后获取应用PV、UV、课程内容访问排行、平均得分等等。文档版本:20200331 ...

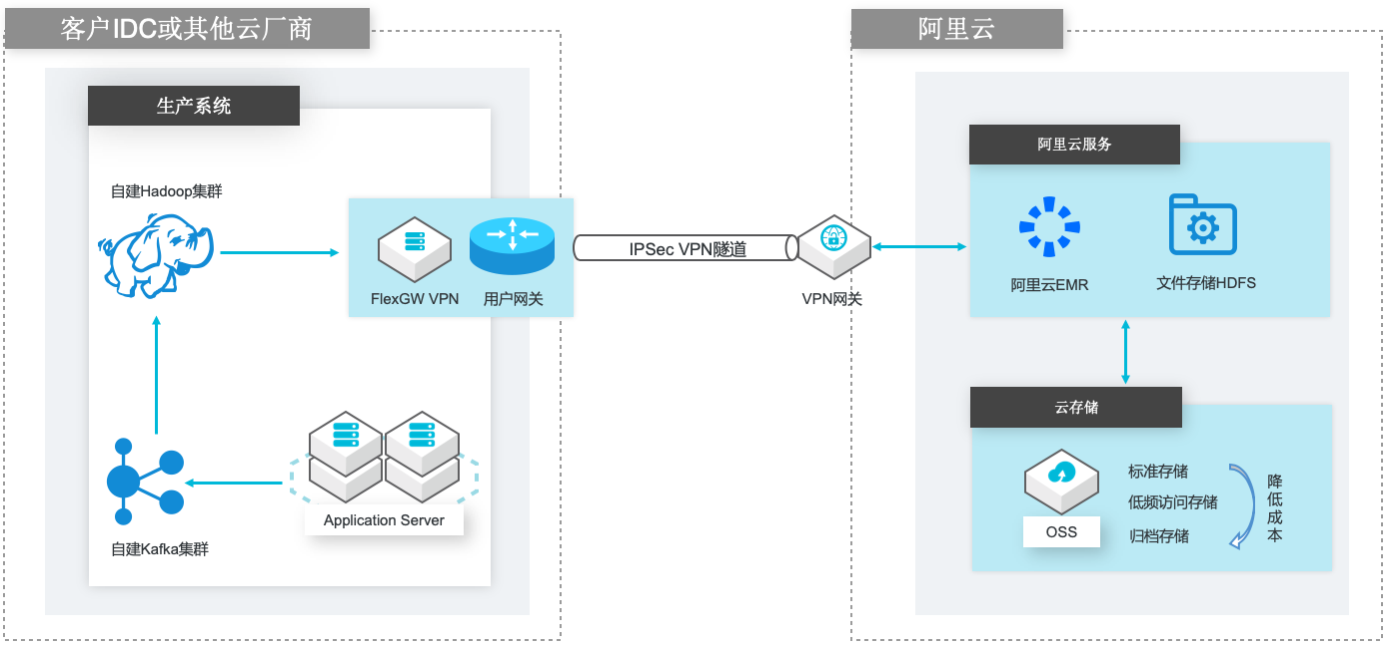

自建Hadoop迁移到阿里云EMR

场景描述 场景1:自建Hadoop集群数据(HDFS)迁移到 阿里云EMR集群的HDFS文件系统; 场景2:自建Hadoop集群数据(HDFS)迁移到 计算存储分离架构的阿里云EMR集群,以OSS 和JindoFS作为EMR集群的后端存储。 解决的问题 客户自建Hadoop迁移到阿里云EMR集群的 技术方案; 基于IPSecVPN隧道构建安全和低成本数据 传输链路 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

Flume Flume是一种分布式,可靠且可用的服务,用于有效地收集,聚合和移动大量日 志数据。它具有基于流数据流的简单灵活的体系结构。它具有可调整的可靠性机 制以及许多故障转移和恢复机制,具有强大的功能和容错能力。它使用一个简单 的可扩展数据模型,允许在线分析应用程序。文档版本:20200330 IV 自建Hadoop数据迁移到...

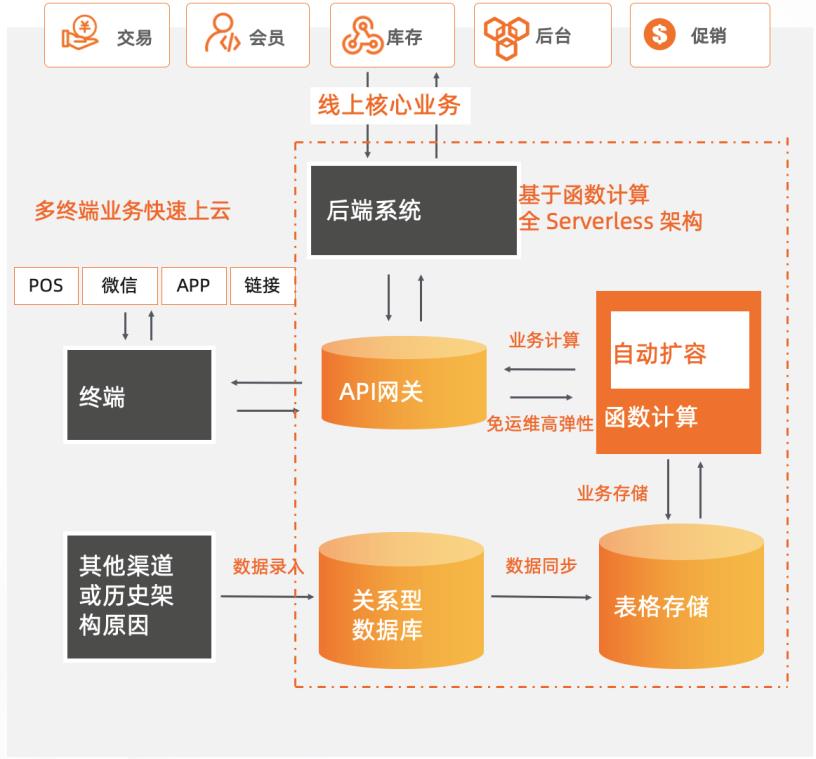

新零售商超基于Serverless服务化改造

某零售商超行业龙头企业,主要业务涵盖购物中心、大卖场、综合超市、标准超市、精品超市、便利店、无人值守智慧商店等零售业态,涉及全渠道零售、仓储物流、餐饮、消费服务、数据服务、金融业务、跨境贸易等领域。为了持续支持业务高速且稳定地发展,其在快速上云后,将核心业务改造为全Serverless架构的中台模式,采用函数计算 + API网关 + 表格存储OTS 作为计算网络存储核心,弹性支撑日常和大促峰谷所需资源,轻松支撑618/双11/双12大促。 核心价值 l 全 Serverless 架构:FC + API 网关 + OTS Serverless 解决方案。 l 弹性高可用:毫秒级弹性扩容、充足的资源池水位、跨可用区高可用。 l 敏捷开发免运维:函数式极简编程可专注于业务创新,无采购和部署成本、提供监控报警等完备的可观测能力。

是阿里巴巴经济体核心基础设施之一,提供稳定与极致的数据服 务。详见:https://www.aliyun.com/product/ots DTS:支持关系型数据库、NoSQL、大数据(OLAP)等数据源,集数据迁移、订阅 及实时同步功能于一体,能够解决公共云、混合云场景下,远距离、毫秒级异步数 据传输难题。其底层基础设施采用阿里双 11异地多活架构,为...

应用实时监控服务ARMS

作为云原生可观测平台,应用实时监控服务 ARMS 包含前端监控、应用监控、云拨测等模块。覆盖浏览器、小程序、APP、分布式应用、容器等不同可观测环境与场景。帮助企业实现全栈性能监控与端到端追踪诊断。提高监控效率,压降运维工作量。

丰富的预置集成组件,覆盖阿里云日志服务SLS、Prometheus、ARMS、开源主流监控系统。支持短信、电话、钉钉、邮件、飞信等多种通知方式,同时也支持对接 Aone/Jira/PageDuty 等多种协同系统.告警源&通知集成.支持多种告警策略,如通知策略、升级策略、静默策略、抑制策略等,支持通过定义事件匹配规则,对告警事件进行精准...

来自:

云产品

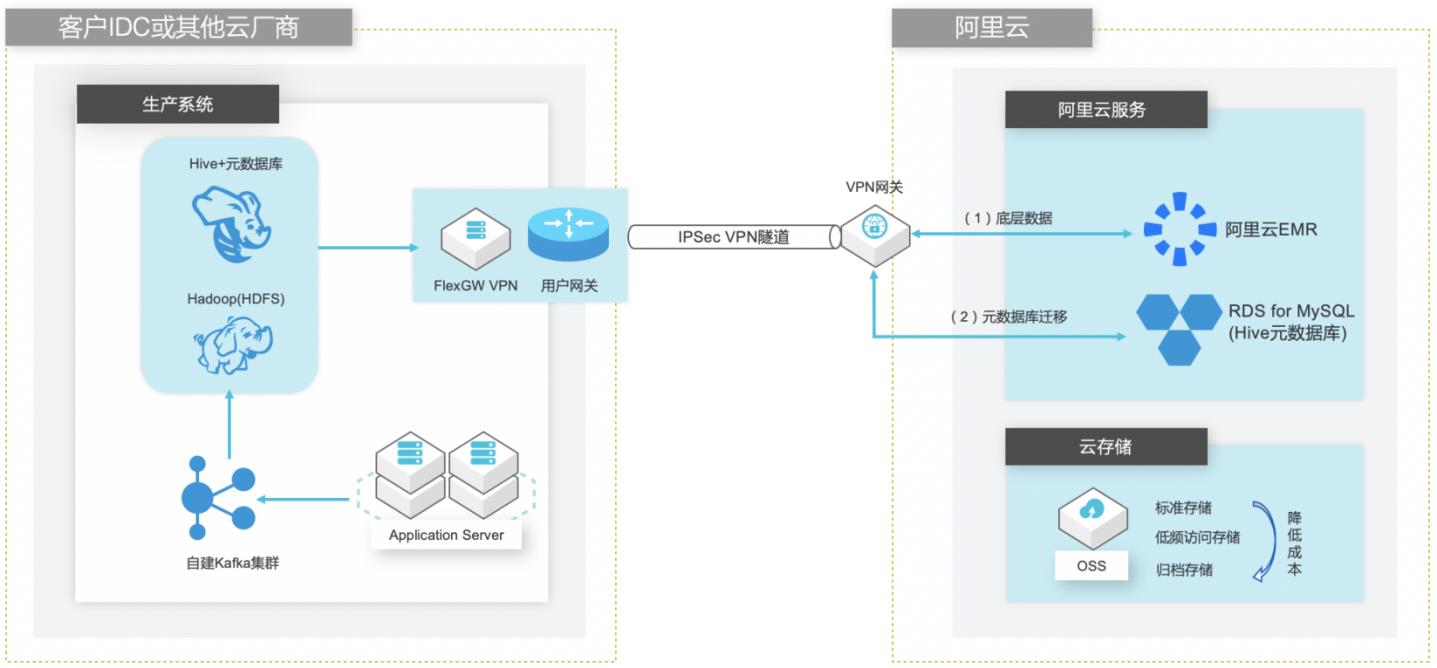

自建Hive数仓迁移到阿里云EMR

场景描述 客户在IDC或者公有云环境自建Hadoop集群构 建数据仓库和分析系统,购买阿里云EMR集群之 后,涉及到将数据仓库和Hive元数据的数据库迁 移上云。目前主流Hive数据仓库迁移场景为1.x 版本迁移到阿里云EMR(Hive2.x版本),涉及到 数据订正更新步骤。 解决的问题 Hive数据仓库的数据迁移方案 Hive元数据库的迁移方案 Hive跨版本迁移后的数据订正 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

步骤2 部署完成后,重启 Hive MetaStore和 HiveServer2 步骤3 由于在创建 EMR集群时我们指定了 RDS for MySQL实例的数据库作为 Hive的元数 据库,但是此时元数据库还未创建,因此在 EMR控制台可以看到 Hive MetaStore服 务异常停止。文档版本:20210721 25 自建Hive数据仓库跨版本迁移到阿里云 EMR 创建 EMR集群 通过查看 ...

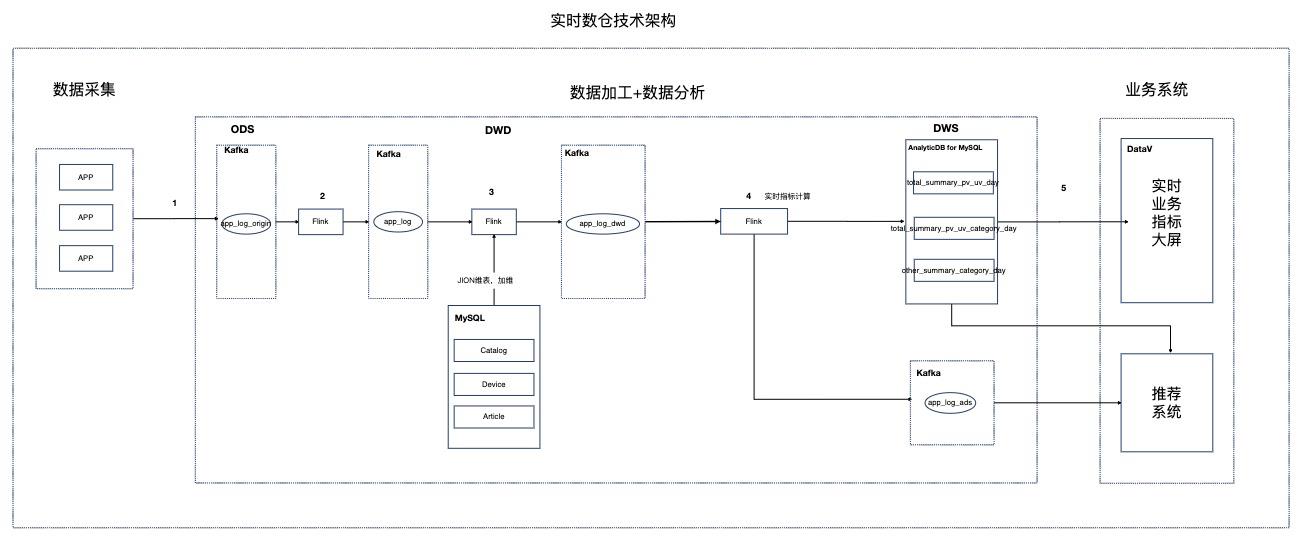

基于Flink的资讯场景实时数仓

场景描述 本实践针对资讯聚合类业务场景,Step by Step介绍 如何搭建实时数仓。 解决问题 1.如何搭建实时数仓。 2.通过实时计算Flink实现实时ETL和数据流。 3.通过实时计算Flink实现实时数据分析。 4.通过实时计算Flink实现事件触发。 产品列表 实时计算 专有网络VPC 云数据库RDSMySQL版 分析型数据库MySQL版 消息队列Kafka 对象存储OSS NAT网关 DataV数据可视化

IP2Region.java 通过 NAT 网 关 配 置 SNAT 访 问 公 网 服 务 http://whois.pconline.com.cn/ipJson.jsp?json=true&ip={ip}获取地理位置信息。本方式 仅演示外网访问和自定义函数 UDX,不适合生产环境使用。public class IP2Region extends TableFunction>{ private String urlPrefix=...

金融专属大数据workshop

实践目标 学习搭建一个实时数据仓库,掌握数据采集、存储、计算、输出、展示等整个业务流程。 整个实时数据仓库系统全部基于阿里云产品进行架构搭建,用户可以掌握并学会运用各个服务组件及各个组件之间如何联动。 理解阿里云原生实时离线一体数仓解决方案架构以及掌握交付落地的实践使用方法。 前置知识要求 熟练掌握SQL语法 对大数据体系系统知识有一定的了解

详见:https://www.aliyun.com/product/oss SLS:日志服务(SLS)是云原生观测分析平台,为Log/Metric/Trace等数据提供 大规模、低成本、实时平台化服务。一站式提供数据采集、加工、分析、告警可 视化与投递功能,全面提升研发、运维、运营和安全等场景数字化能力。详见:https://www.aliyun.com/product/sls CADT:...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

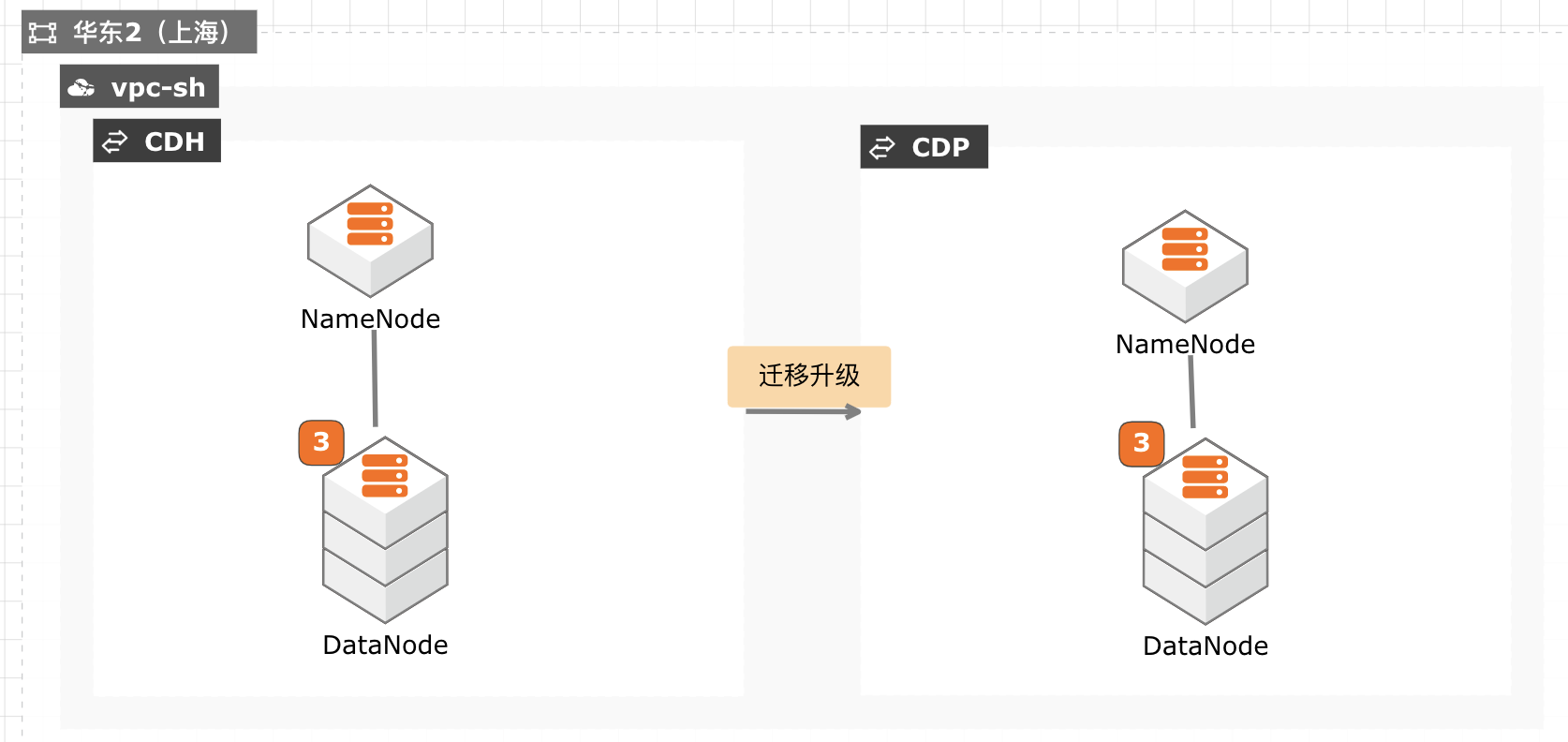

CDH迁移升级CDP最佳实践

当前 CDH 免费版停止下载,终止服务,针对需要企业版服务能力并且CDH 升级过程对业务影响较小的客户,通过安装新的 CDP 集群,将现有数据拷贝至新集群,然后将新集群切换为生产集群,升级过程没有数据丢失风险,停机时间较短,适合大部分互联网客户升级使用。

chmod+x/usr/java/jdk1.8.0_301/bin/java ssh slave1 chmod+x/usr/java/jdk1.8.0_301/bin/java ssh slave2 chmod+x/usr/java/jdk1.8.0_301/bin/java ssh slave3 chmod+x/usr/java/jdk1.8.0_301/bin/java 进入主机菜单配置 JDK所在目录。配置所有主机的 JAVA主目录为/usr/java/jdk1.8.0_301。文档版本:20211029 28 CDH迁移...

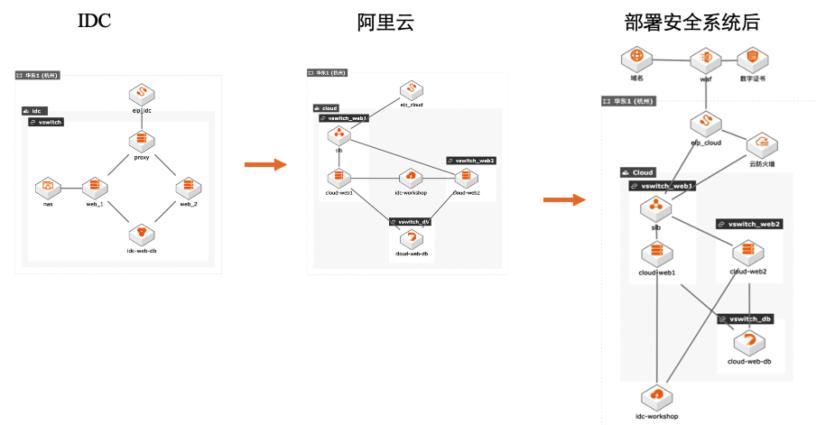

企业上云workshop

本文模拟了如下场景: 1. 线下 IDC 环境中部署了一个业务系统,业务是利用 wordpress 系统提供网站服务。 2. 本文详细介绍了如何将以上线下系统搬迁到云上, 包括如何在云上构建以上业务系统,如何迁移线下 系统到云上,如何割接。 3. 最后介绍了迁移上云后,如何部署安全系统。 解决问题 IDC 业务系统搬迁上云 云上构建业务系统 部署安全系统

本例中应用服 务器 web_1、web_2是对等的应用服务器,因此仅迁移一台即可,本例迁移 web_1。操作步骤 步骤1 登录云服务器 ECS控制台(https://ecs.console.aliyun.com/)步骤2 创建弹性公网 IP。文档版本:20210617 43 企业上云 workshop-IDC业务迁移上云 应用迁移 购买按量付费、按使用流量计费、带宽峰值不小于 100Mbps的...

来自:

最佳实践

相关产品:专有网络 VPC,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,负载均衡 SLB,弹性公网IP,文件存储NAS,云数据库PolarDB,Web应用防火墙,云防火墙,SSL证书,云速搭

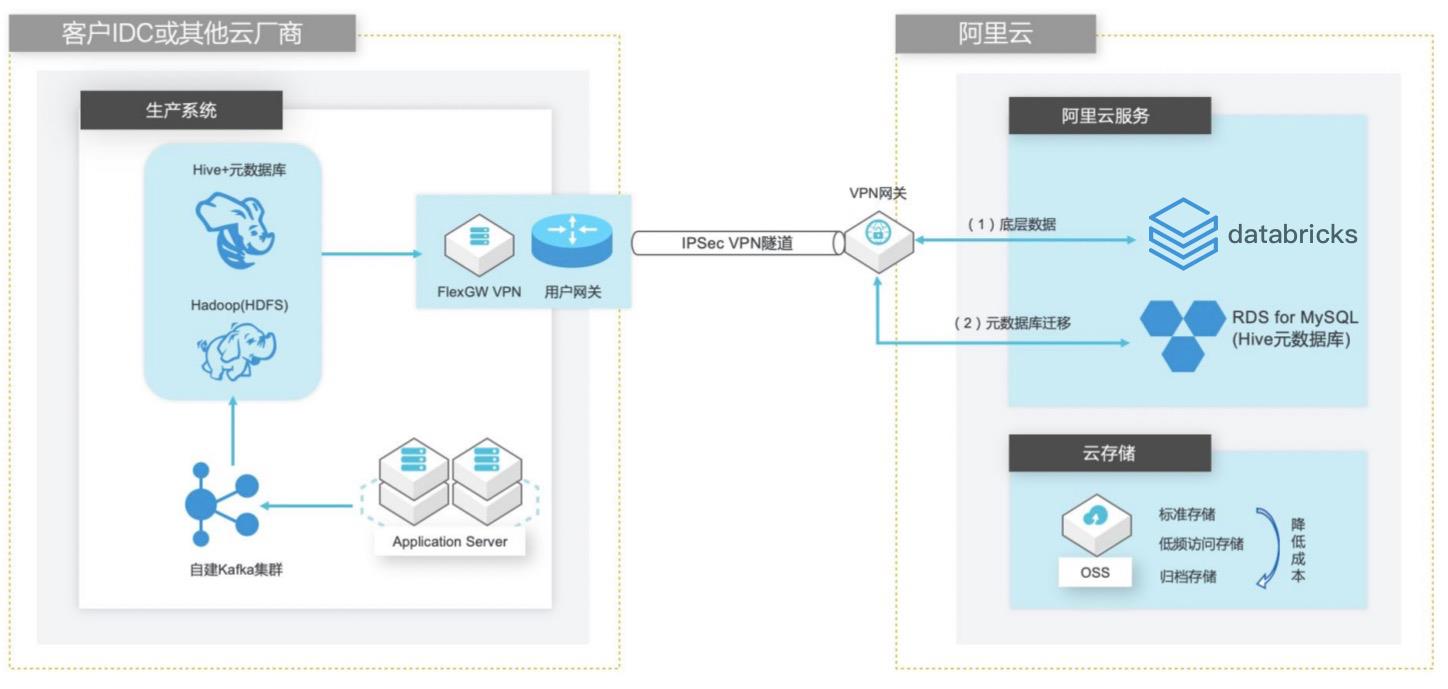

自建Hive数据仓库跨版本迁移到阿里云Databricks数据洞察

场景描述 客户在IDC或者公有云环境自建Hadoop集群构建数据仓库和分析系统,购买阿里云Databricks数据洞察集群之后,涉及到数仓数据和元数据的迁移以及Hive版本的订正更新。 方案优势 1. 全托管Spark集群免运维,节省人力成本。 2. Databricks数据洞察与阿里云其他产品(OSS、RDS、MaxCompute、EMR)进行深度整合,支持以这些产品为数据源的输入和输出。 3. 使用Databricks Runtime商业版引擎相比开源Spark性能有3-5倍的提升。 解决问题 1. Hive数仓数据迁移OSS方案。 2. Hive元数据库迁移阿里云RDS方案。 3. Hive跨版本迁移到Databricks数据洞察使用Delta表查询以提高查询效率。

yum install-y java java-1.8.0-openjdk-devel.x86_64 ssh slave1"yum install-y java java-1.8.0-openjdk-devel.x86_64"ssh slave2"yum install-y java java-1.8.0-openjdk-devel.x86_64"ssh slave3"yum install-y java java-1.8.0-openjdk-devel.x86_64"步骤5 下载并解压缩 Hadoop 2.10.1文件包。1.下载软件包,下面两...

Spark on ECI大数据分析

场景描述 方案优势 1.计算引擎弹性扩缩容,兼顾资源弹性与计 算资源成本优化。 2.计算与存储分离架构,结合阿里云原生云 存储产品,海量数据湖优势。 3.Kubernetes原生的调度性能优势,提升在 大规模分析作业时的分析性能优势分。 4.集群资源隔离和按需分配。 解决问题 1.计算资源弹性能力不足,计算资源成本管 控能力欠缺. 2.集群资源调度能力和隔离能力不足。 3.计算与存储无法分离,大数据量分析时出 现数据存储资源瓶颈。 4.Spark submit方式提交分析作业参数支持 有限等缺点。 产品列表 容器服务Kubernetes版(ACK) 弹性容器实例(ECI) 文件存储HDFS 对象存储OSS 专有网络VPC 容器镜像服务ACR

弹性容器实例 ECI:阿里云弹性容器实例(ECI)是免运维的 IaaS层容器组资源交付,提供安全的 Serverless容器运行服务,用户无需管理底层服务器,只需要提供打 包好的 Docker镜像即可运行容器并只为容器实际运行消耗的资源付费。ECI可以 与阿里云容器服务产品(ACK/ASK)无缝兼容,并且跟 Kubernetes的 Pod概念完 全兼容。文档...

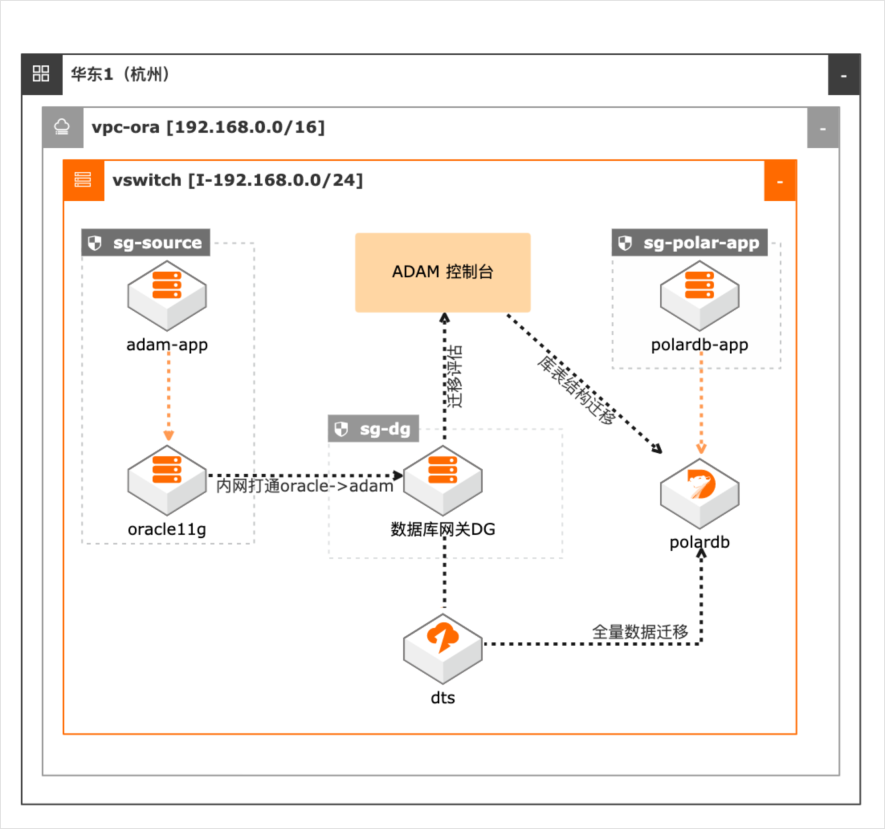

Oracle数据库与应用迁移PolarDB

场景描述 本最佳实践适用于Oracle数据库及应用迁 移到阿里云PolarDB数据库(Oracle兼容 版)。通过ADAM将Oracle数据库迁移到 PolarDB数据库,可以降低应用升级、运 维成本,同时提升系统弹性,实现数据库 及应用全栈上云。 解决问题 1.解决Oracle及其应用迁移上阿里云, 通过ADAM评估迁移工具,降低迁移 风险,提高迁移效率。 2.使用PolarDB(Oracle兼容版)数据 库,提升数据库并发读能力,降低运维 成本。 产品列表 数据库和应用迁移(ADAM) PolarDB(Oracle兼容版) 云服务器(ECS) 专有网络(VPC)

是阿里云提供的一种基础云计算服 务。无需提前采购硬件设备,根据业务需要,随时创建所需数量的云服务器 ECS 实例。在使用过程中,随着业务的扩展,可以随时扩容磁盘、增加带宽。也能随时 释放资源,节省费用。更多信息,请参考:https://www.aliyun.com/product/ecs PolarDB(Oracle兼容版):POLARDB是阿里巴巴自主研发的...

大数据workshop

大数据workshop

详见:https://www.aliyun.com/product/oss SLS:日志服务(SLS)是云原生观测分析平台,为 Log/Metric/Trace等数据提 供大规模、低成本、实时平台化服务。一站式提供数据采集、加工、分析、告警 可视化与投递功能,全面提升研发、运维、运营和安全等场景数字化能力。详见:https://www.aliyun.com/product/sls CADT:是一...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

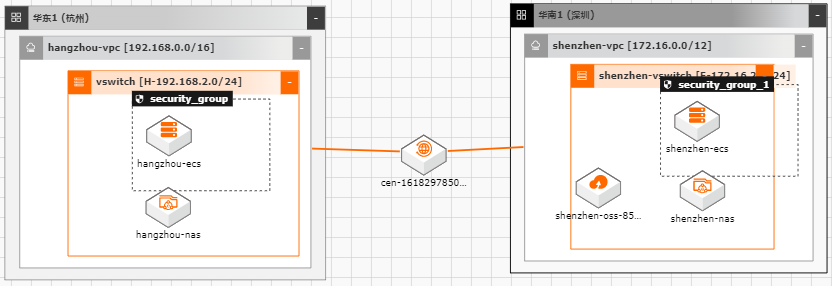

数据迁移上云

随着越来越多的企业选择将业务系统上云,各种类型的数据如何便捷、平滑的迁移上 云,成了用户上云较为关注的点;业务上云后,因为业务或者其他方面调整等因素, 也存在如跨区域,跨账号等数据迁移的场景。针对以上需求,阿里云上提供了较为丰 富的工具(如ossimport)、服务(在线迁移服务),旨在能够帮助客户便捷进行数据迁 移。 本文通过云架构设计工具CADT来快速创建云上基础资源,并以杭州区域来模拟线 下IDC(或友商),深圳区域模拟阿里云云上资源。通过云上的工具命令、服务来提 供常见数据迁移场景的最佳实践。

本案例以 FTP服务器为例,具体 FTP服 26 文档版本:20201013 数据迁移上云最佳实践 使用阿里云在线迁移服务进行数据迁移 务器搭建过程本文不再赘述。3.2.创建目的地址 步骤1 选择在线迁移服务>数据地址,并选择“OSS”的数据类型,数据所在区域选择“华南 1(深圳)”,然后点击创建数据地址 步骤2 在跳出的创建数据窗口中...

实时计算Flink版

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,具备实时应用的作业开发、数据调试、运行与监控、自动调优、智能诊断等全生命周期能力。内核引擎100%兼容Apache Flink,2倍性能提升,拥有FlinkCDC、动态CEP等企业级增值功能,内置丰富上下游连接器,助力企业构建高效、稳定和强大的实时数据应用。

查看全部日志.核心性能提升.数据实时入湖入仓.实时风控场景能力.上下游数据连接(Connector).问题分析与诊断.用户可以根据业务负载进行弹性扩缩容.可智能调优,无人值守自动监控并调整作业资源分配.可在指定时间段应用对应的资源计划,削峰填谷,节省成本.可进行细粒度资源,支持算子级别的精细化资源配置.大规模作业资源...

来自:

云产品

- 产品推荐

- 这些文档可能帮助您