自建Hadoop迁移MaxCompute

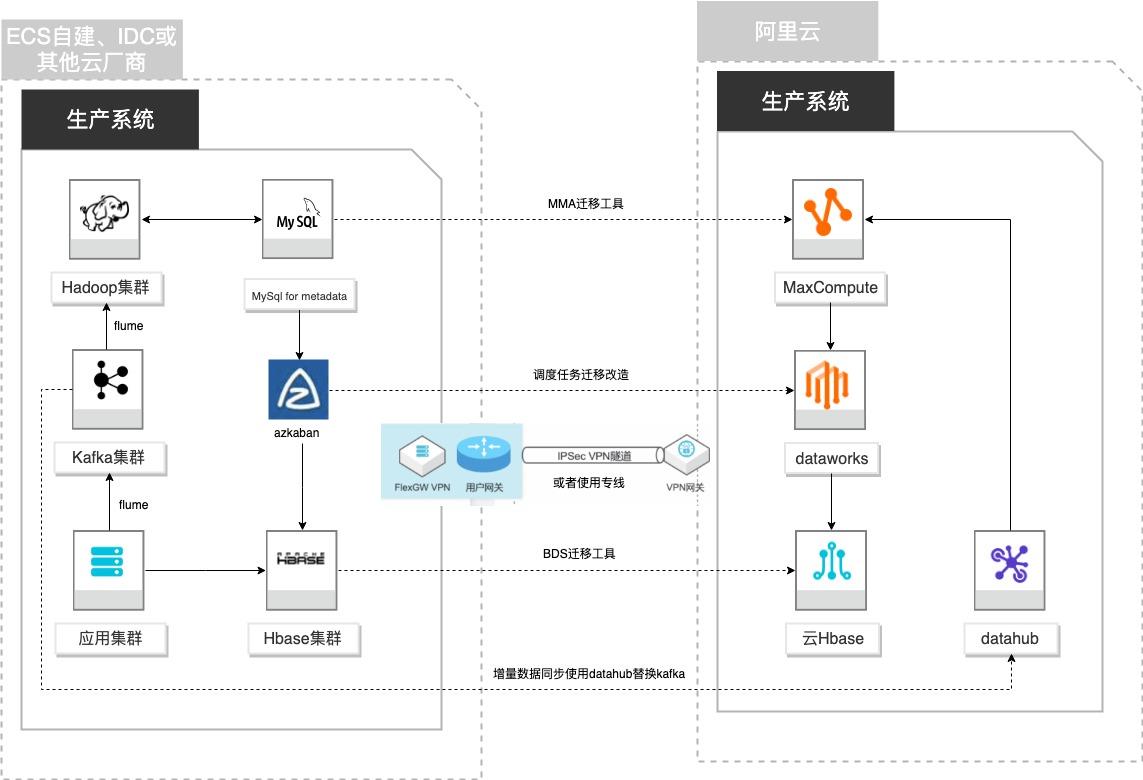

场景描述 客户基于ECS、IDC自建或在友商云平台自建了大数 据集群,为了降低企业大数据计算平台的成本,提高 大数据应用开发效率,更有效保障数据安全,把大数 据集群的数据、作业、调度任务以及业务数据库整体 迁移到MaxCompute和其他云产品。 解决的问题 自建Hadoop集群搬迁到MaxCompute 自建Hbase集群搬迁到云Hbase 自建Kafka或应用数据准实时同步到 MaxCompute 自建Azkaban任务迁移到Dataworks任务 产品列表 MaxCompute,Dataworks、云数据库Hbase版、Datahub、VPC,ECS。

用于连接云数据库 Hbase实例:这两个值通过云数据库 Hbase实例控制台获取:其中 hbase.rootdir格式为:hdfs:/xxxxx/hbase,其中的 xxxxx用上面截图的标注 2 替换。替换后效果为:文档版本:20210723 71 自建Hadoop迁移MaxCompute Azkaban定时任务迁移和改造 步骤13 将替换后的脚本完整内容粘贴进数据集成任务编辑栏 步骤14 ...

数据湖-在线学习场景数据分析

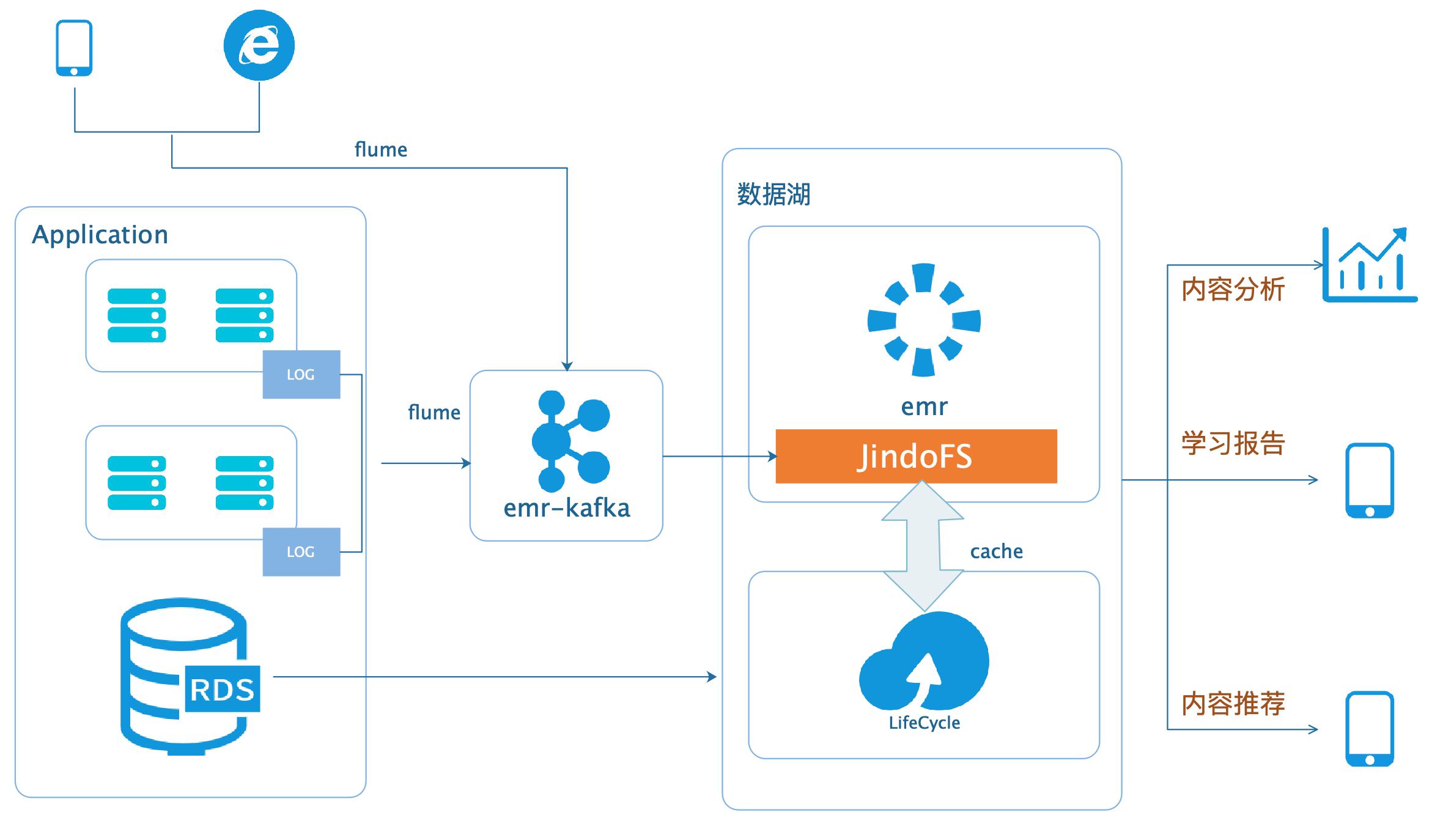

场景描述 本场景以在线教育中一个答题闯关类的应用为 例,使用WebServer来模拟演示这类日志数据 的分析处理。通过Nginx和Pythonflask搭建 WebServer,模拟应用中的关键页面,比如登 录、课程内容等,之后构造若干用户使用的模拟 日志数据,投递到数据湖进行分析后获取应用 PV、UV、课程内容访问排行、平均得分等等。 解决问题 基于数据湖(EMR+OSS)搭建大数据平台。 EMR和OSS使用和配置。 数据统一存储到OSS。 产品列表 E-MapReduce 对象存储OSS 云服务器ECS 访问控制RAM 专有网络VPC

文档版本:20200331 37数据湖-在线学习场景数据分析 应用场景 步骤1 首先在webserver上安装java#安装jdk sudoyum-yinstalljava-11-openjdk*#配置环境变量 cat>>/etc/profile:/root/ssh登录到EMRHadoop 集群的Master节点,执行命令:cd hadoopfs-mkdirjfs:/datalake/lib/hadoopfs-putnginx_url_parse-1.0.jarjfs:/datalake/...

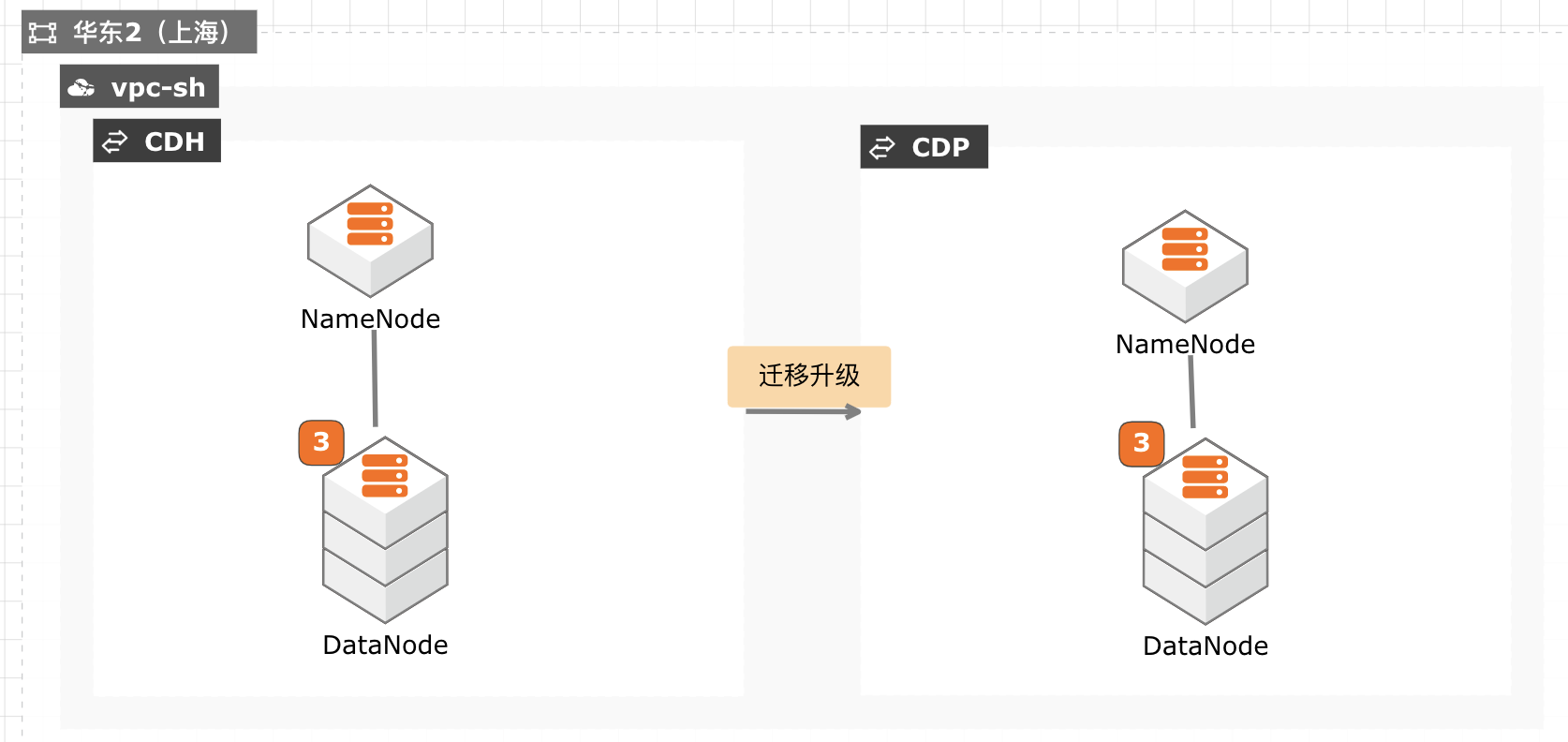

CDH迁移升级CDP最佳实践

当前 CDH 免费版停止下载,终止服务,针对需要企业版服务能力并且CDH 升级过程对业务影响较小的客户,通过安装新的 CDP 集群,将现有数据拷贝至新集群,然后将新集群切换为生产集群,升级过程没有数据丢失风险,停机时间较短,适合大部分互联网客户升级使用。

chmod+x/usr/java/jdk1.8.0_301/bin/java ssh slave1 chmod+x/usr/java/jdk1.8.0_301/bin/java ssh slave2 chmod+x/usr/java/jdk1.8.0_301/bin/java ssh slave3 chmod+x/usr/java/jdk1.8.0_301/bin/java 进入主机菜单配置 JDK所在目录。配置所有主机的 JAVA主目录为/usr/java/jdk1.8.0_301。文档版本:20211029 28 CDH迁移...

EMR集群安全认证和授权管理

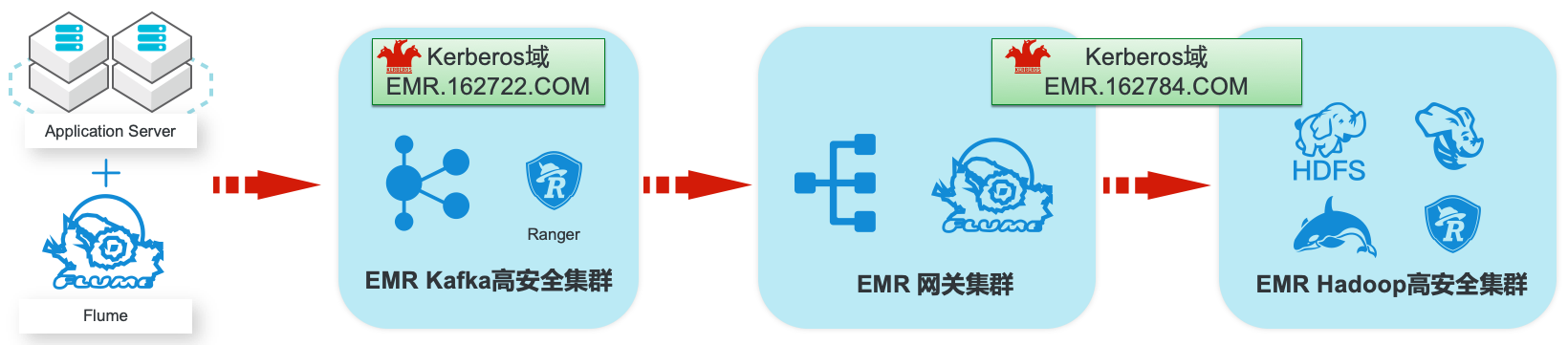

场景描述 阿里云EMR服务Kafka和Hadoop安全集群使 用Kerberos进行用户安全认证,通过Apache Ranger服务进行访问授权管理。本最佳实践中以 Apache Web服务器日志为例,演示基于Kafka 和Hadoop的生态组件构建日志大数据仓库,并 介绍在整个数据流程中,如何通过Kerberos和 Ranger进行认证和授权的相关配置。 解决问题 1.创建基于Kerberos的EMR Kafka和 Hadoop集群。 2.EMR服务的Kafka和Hadoop集群中 Kerberos相关配置和使用方法。 3.Ranger中添加Kafka、HDFS、Hive和 Hbase服务和访问策略。 4.Flume中和Kafka、HDFS相关的安全配 置。 产品列表:E-MapReduce、专有网络VPC、云服务器ECS、云数据库RDS版

产品列表:E-MapReduce、专有网络 VPC、云服务 最佳实践频道 阿里云最佳实践分享群 器 ECS、云数据库 RDS版 如二维码过期,请搜索群号:31852400 云服务器 ECS(产品名称)文档模板(手册名称)/文档版本信息 阿里云 EMR集群安全认证和授权管理 最佳实践 文档版本:20200330 文档版本:20150122(发布日期)II EMR集群安全...

大数据workshop

大数据workshop

详见:https://www.aliyun.com/product/bigdata/hologram 文档版本:20210628(发布日期)III 阿里云最佳实践大数据 WorkShop 产品介绍 云数据库 RDS MySQL版:云数据库 RDS MySQL 版是全球最受欢迎的开源数 据库之一,作为开源软件组合 LAMP(Linux+Apache+MySQL+Perl/PHP/Python)中的重要一环,广泛应用于各类应用场景。...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

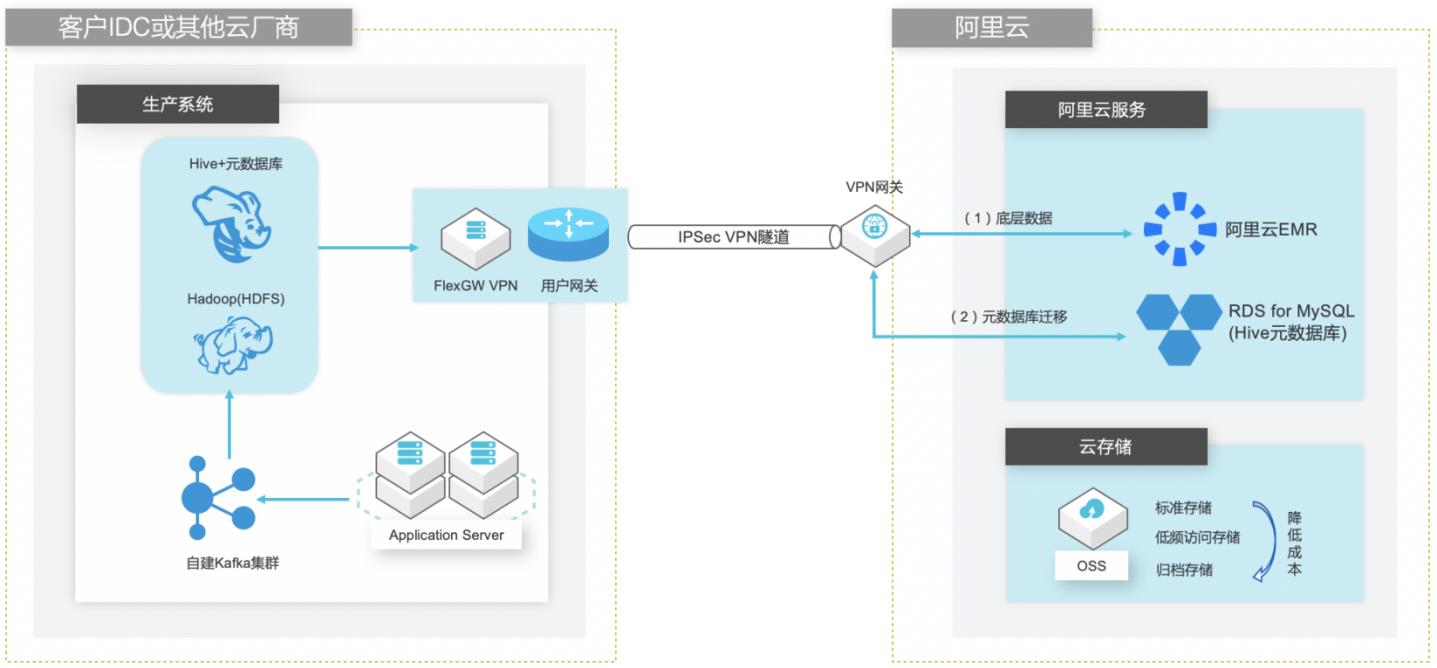

自建Hive数仓迁移到阿里云EMR

场景描述 客户在IDC或者公有云环境自建Hadoop集群构 建数据仓库和分析系统,购买阿里云EMR集群之 后,涉及到将数据仓库和Hive元数据的数据库迁 移上云。目前主流Hive数据仓库迁移场景为1.x 版本迁移到阿里云EMR(Hive2.x版本),涉及到 数据订正更新步骤。 解决的问题 Hive数据仓库的数据迁移方案 Hive元数据库的迁移方案 Hive跨版本迁移后的数据订正 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

可靠性 使用阿里云数据库 RDS保存 Hive的元数据信息,可以提升数据可靠性和服务可 用性,免除客户运维自建 MySQL数据库的工作。文档版本:20210721 2 自建Hive数据仓库跨版本迁移到阿里云 EMR 前置条件 前置条件 在进行本文操作之前,您需要完成以下准备工作:注册阿里云账号,并完成实名认证。您可以登录阿里云控制台,并...

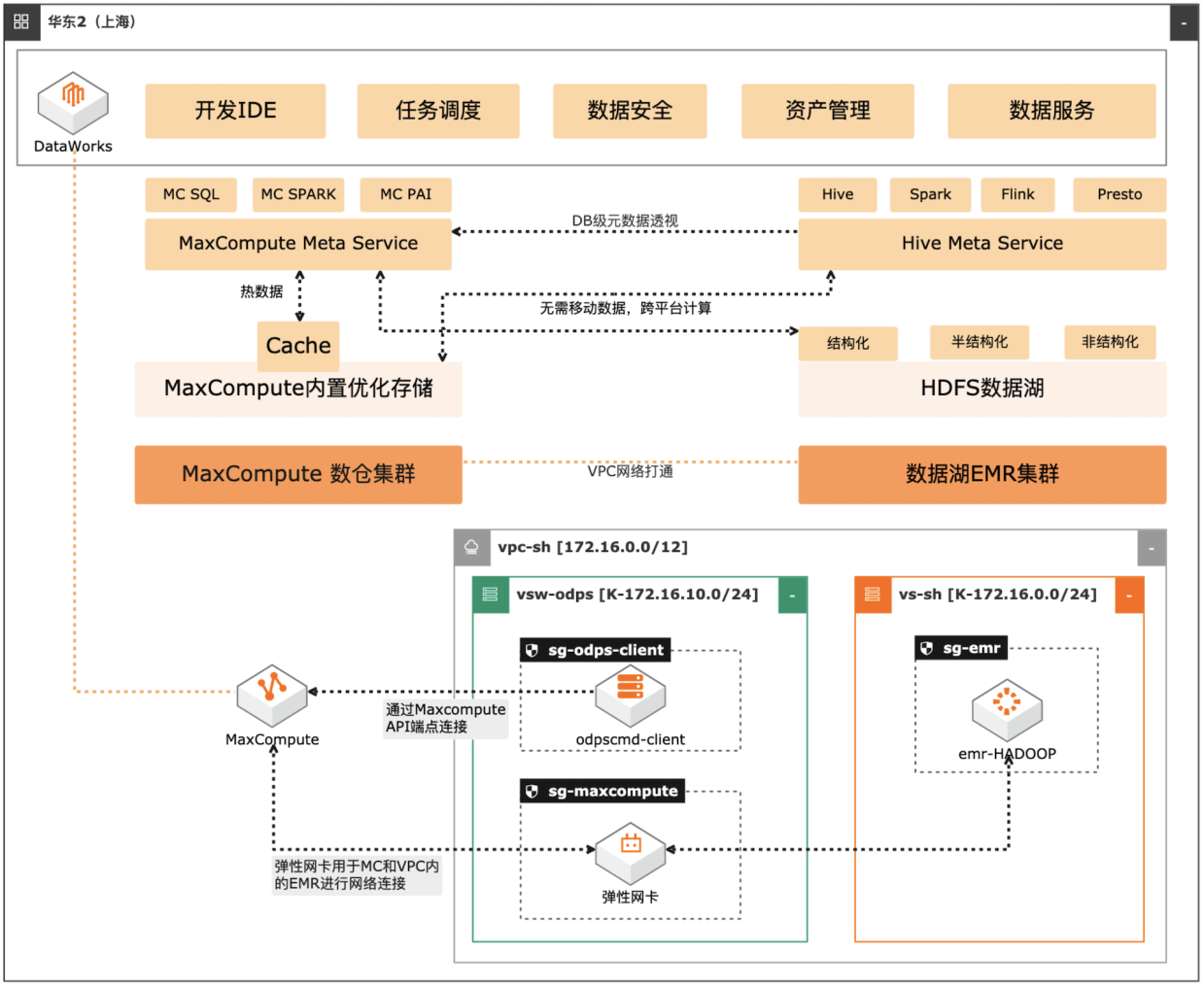

MaxCompute湖仓一体方案

场景描述 自建数据湖与云数仓的融合解决方案,将 MaxCompute与自建的Hive集群做数据打 通,通过存储共享,元数据镜像等方式,解 决传统模式下的存储冗余,计算资源弹性能 力弱的痛点。可大幅度增强系统的资源弹 性,解决业务高峰期计算资源不足的问题。 方案优势 1.业务无侵入性:现有业务无需改造。 2.性能优化:MaxCompute在SQL上做 了大量优化与能力沉淀,可提高SQL 运行性能,降低计算成本。 3.灵活管理:元数据实时同步,无需额外 管理数据同步任务。 4.资源弹性:利用MaxCompute计算池 弹性进行海量数据计算。 解决问题 1.增强业务高峰期的资源弹性。 2.优化自建数据湖的数据治理能力。 3.减少跨平台数据处理的存储冗余。 产品列表 专有网络VPC 云服务器ECS 访问控制RAM 运维编排OOS MaxCompute(原ODPS) 云企业网CEN

EMR:阿里云 E-MapReduce(EMR)是构建在阿里云云服务器 ECS 上的开源 Hadoop、Spark、HBase、Hive、Flink 生态大数据 PaaS 产品。提供用户在云上 使用开源技术建设数据仓库、离线批处理、在线流式处理、即时查询、机器学习等 场 景 下 的 大 数 据 解 决 方 案。更 多 信 息,请 参 见:...

金融专属大数据workshop

实践目标 学习搭建一个实时数据仓库,掌握数据采集、存储、计算、输出、展示等整个业务流程。 整个实时数据仓库系统全部基于阿里云产品进行架构搭建,用户可以掌握并学会运用各个服务组件及各个组件之间如何联动。 理解阿里云原生实时离线一体数仓解决方案架构以及掌握交付落地的实践使用方法。 前置知识要求 熟练掌握SQL语法 对大数据体系系统知识有一定的了解

详 见:https://www.aliyun.com/product/bigdata/hologram 云数据库RDSMySQL版:云数据库RDSMySQL版是全球最受欢迎的开源数据 文档版本:20210803(发布日期)III阿里云最佳实践大数据WorkShop 产品介绍 库之一,作为开源软件组合LAMP(Linux+Apache+MySQL+Perl/PHP/Python)中 的 重 要 一 环,广 泛 应 用 于 各 类 应...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

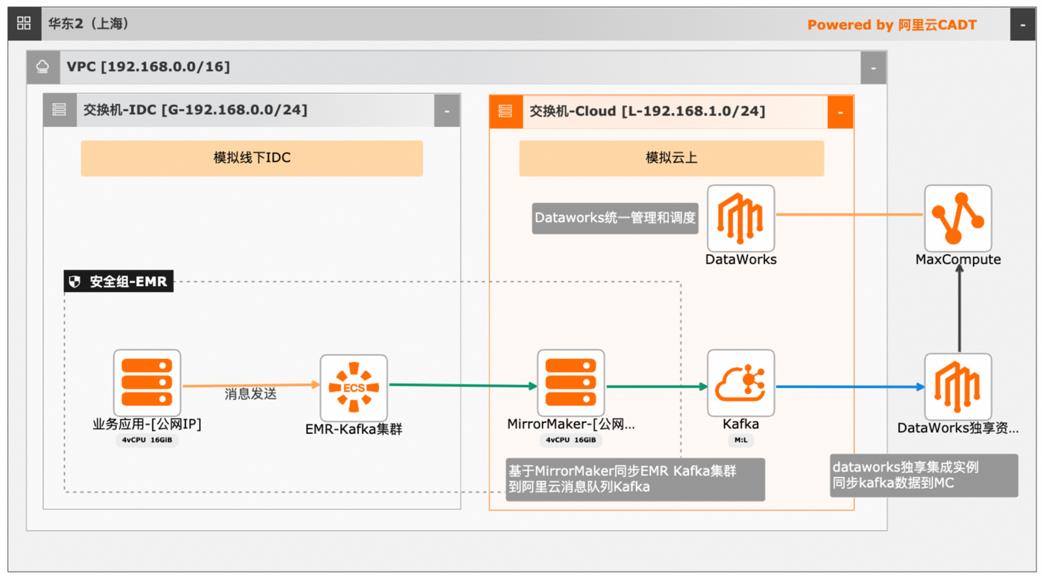

大数据近实时数据投递MaxCompute

本文介绍离线大数据场景使MaxCompute构建云 上近实时数仓,打通云下数据上云链路,解决数据复杂类型支持和动态分区问题,满足高级数据处理需求的最佳实践。 l混合云环境下,现有业务系统零改造,打通数据上云链路。 l使用UDF实现复杂数据类型转换和数据动态分区。 l使用DataWorks配置周期调度业务流程,数据自动入仓。 l借助MaxCompute优化计算引擎,实现降本增效。 产品列表 云服务器ECS 专有网络VPC 访问控制RAM 数据总线DataHub E-MapReduceEMR DataWorks 大数据计算服务MaxCompute

大数据近实时数据投递 MaxCompute 最佳实践 业务架构 最佳实践 解决问题 场景描述 混合云环境下,现有业务系统零改造,打通数据 本文介绍离线大数据场景使用 MaxCompute构建云 上云链路。上近实时数仓,打通云下数据上云链路,解决数据复 使用 UDF实现复杂数据类型转换和数据动态分 杂类型支持和动态分区问题,满足高级数据...

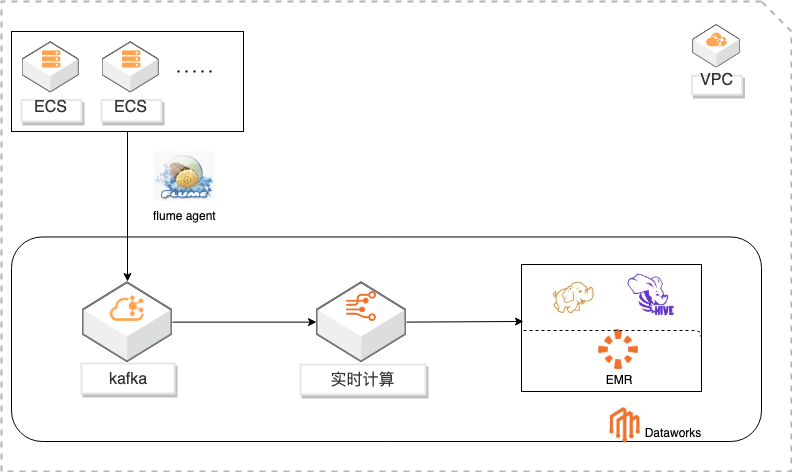

基于DataWorks的大数据一站式开发及数据治理

概述 基于Dataworks做大数据一站式开发,包含数据实时采集到kafka通过实时计算对数据进行ETL写入HDFS,使用Hive进行数据分析。通过Dataworks进行数据治理,数据地图查看数据信息和血缘关系,数据质量监控异常和报警。 适用场景 日志采集、处理及分析 日志使用Flink实时写入HDFS 日志数据实时ETL 日志HIVE分析 基于dataworks一站式开发 数据治理 方案优势 大数据一站式开发,完善的数据治理能力。 性能优越:高吞吐,高扩展性。 安全稳定:Exactly-Once,故障自动恢复,资源隔离。 简单易用:SQL语言,在线开发,全面支持UDX。 功能强大:支持SQL进行实时及离线数据清洗、数据分析、数据同步、异构数据源计算等Data Lake相关功能 ,以及各种流式及静态数据源关联查询。

详情请查看 www.aliyun.com/product/bigdata/product/sc EMR:阿里云 E-MapReduce(EMR)是构建在阿里云云服务器 ECS 上的开源 Hadoop、Spark、HBase、Hive、Flink 生态大数据 PaaS 产品。提供用户在云上 使用开源技术建设数据仓库、离线批处理、在线流式处理、即时查询、机器学习等 场景下的大数据解决方案。详情请查看 ...

自建Hadoop迁移到阿里云EMR

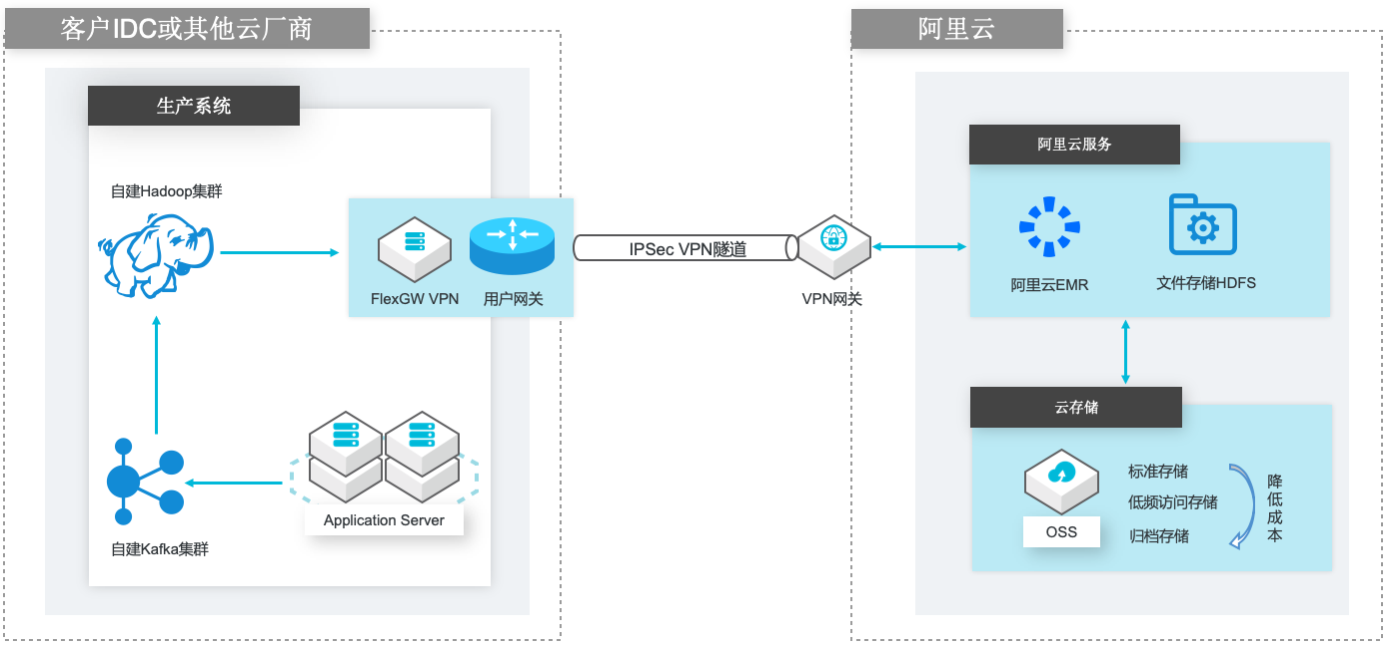

场景描述 场景1:自建Hadoop集群数据(HDFS)迁移到 阿里云EMR集群的HDFS文件系统; 场景2:自建Hadoop集群数据(HDFS)迁移到 计算存储分离架构的阿里云EMR集群,以OSS 和JindoFS作为EMR集群的后端存储。 解决的问题 客户自建Hadoop迁移到阿里云EMR集群的 技术方案; 基于IPSecVPN隧道构建安全和低成本数据 传输链路 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

VPN网关 VPN网关是一款基于 Internet的网络连接服务,通过加密通道的方式实现企业数 据中心、企业办公网络或 Internet终端与阿里云专有网络(VPC)安全可靠的连 接。VPN 网关提供 IPSec-VPN 连接和 SSL-VPN 连接。详情请查看 https://www.aliyun.com/product/vpn IPSec VPN 基于路由的 IPSec-VPN,不仅可以更方便的配置和...

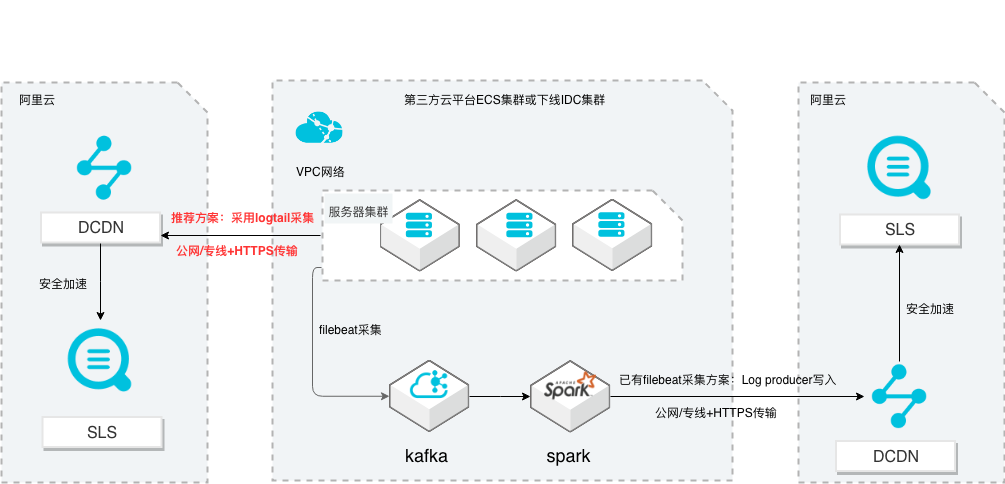

SLS多云日志采集、处理及分析

场景描述 从第三方云平台或线下IDC服务器上采集 日志写入到阿里云日志服务,通过日志服务 进行数据分析,帮助提升运维、运营效率, 建立DT 时代海量日志处理能力。 针对未使用其他日志采集服务的用户,推荐 在他云或线下服务器安装logtail采集并使用 Https安全传输;针对已使用其他日志采集 工具并且已有日志服务需要继续服务的情 况,可以通过Log producer SDK写入日志 服务。 解决问题 1.第三方云平台或线下IDC客户需要使用 阿里云日志服务生态的用户。 2.第三方云平台或线下IDC服务器已有完 整日志采集、处理及分析的用户。 产品列表 E-MapReduce 专有网络VPC 云服务器ECS 日志服务LOG DCDN

SLS多云日志采集、处理及分析 最佳实践 业务架构 场景描述 从第三方云平台或线下 IDC服务器上采集 日志写入到阿里云日志服务,通过日志服 务进行数据分析,帮助提升运维、运营效 率,建立 DT 时代海量日志处理能力。针对未使用其他日志采集服务的用户,推 荐在他云或线下服务器安装 logtail采集并使 用 Https安全传输;针对...

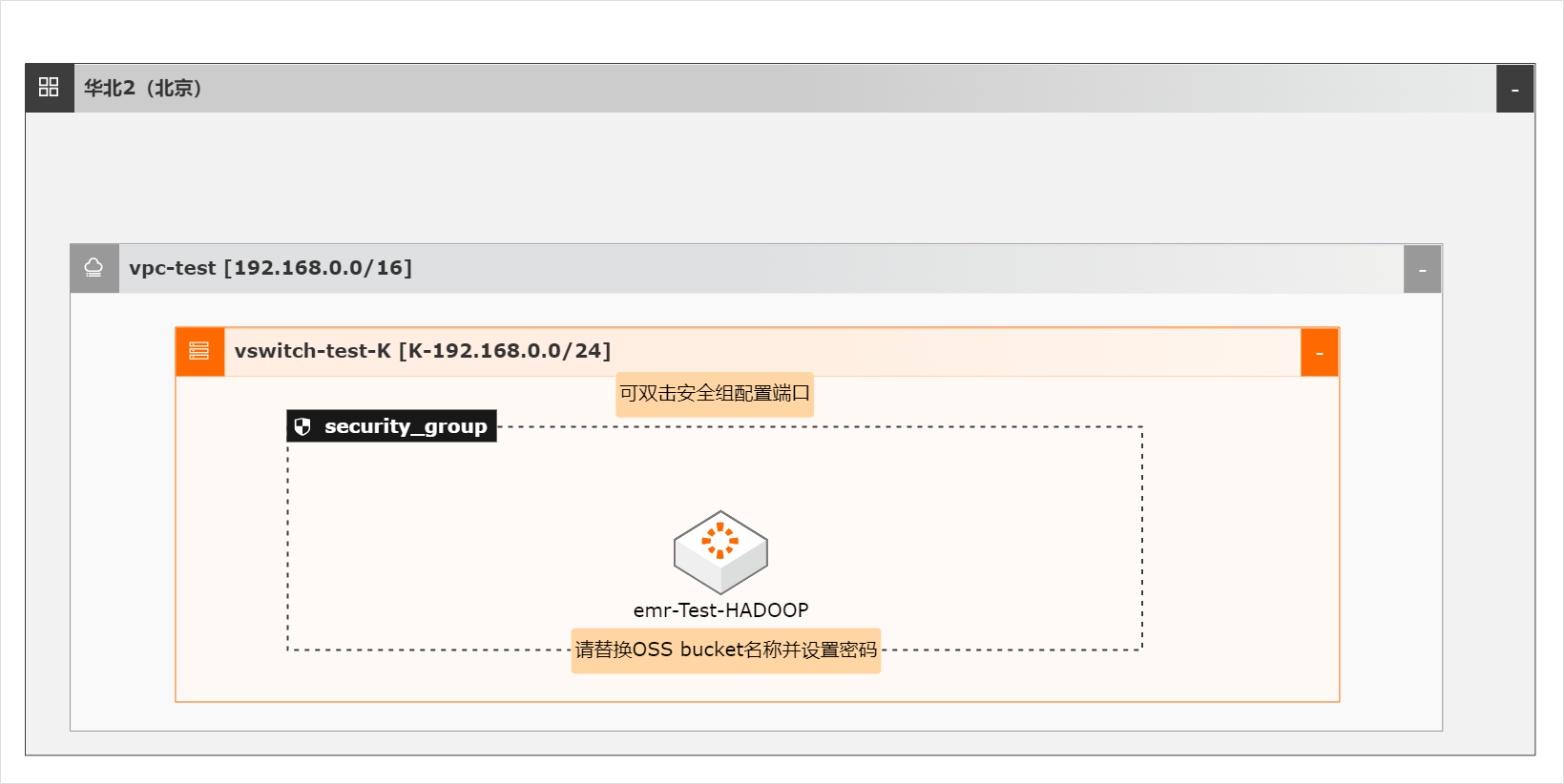

EMR HBase on OSS存算分离集群快速恢复

OSS-HDFS服务(JindoFS服务)是一款云原生数据湖存储产品。基于统一的元数据管理能力,在完全兼容HDFS文件系统接口的同时,提供充分的POSIX能力支持,能更好地满足大数据和AI等领域的数据湖计算场景。

(本截图为旧版 EMR控制台页面,新版的 Master节点的链接类似)文档版本:20220915 15 EMR HBase on OSS存算分离集群快速恢复 写入测试数据与集群恢复 步骤3 点击远程连接,通过 Workbench方式连接 master节点。文档版本:20220915 16 EMR HBase on OSS存算分离集群快速恢复 写入测试数据与集群恢复 3.2.复制创建数据脚本 ...

云数据库HBase

阿里云云数据库 HBase 版(ApsaraDB for HBase)是基于 Hadoop 且100%兼容HBase协议的高性能、可弹性伸缩、面向列的分布式数据库,轻松支持PB级大数据存储,满足千万级QPS高吞吐随机读写场景。

查看云数据库HBase版使用文档.查看云数据库HBase版试用案例.查看云数据库HBase版快速入门.加群交流HBase相关技术.支持海量全量数据快速批量导入以及实时增量数据快速写入,通过Spark轻松完成海量数据离线分析.冷热分离、异构存储、高压缩率。综合存储成本下降80%.HBase支持Spark Streaming流式处理,满足实时业务场景.高效...

来自:

云产品

物联网无线连接服务

阿里云物联网SIM服务向物联网设备提供蜂窝连接服务,包括公网、定向以及智能选网等功能,提供优质稳定网络以及一站式流量管理服务,是基于阿里巴巴集团电子商务生态系统,通过成熟、完整的解决方案和优秀的云技术平台,保证车联网业务快速部署,并提供领先的内容和互联网服务。

优质稳定的物联网一站式连接管理平台,套餐计费灵活多样,并提供定向安全上云、多网高可用上云等服务.合规用卡检测.物联网无线连接服务.查看更多商品.解决方案专区.户外广告行业正在进入数字化转型,电子广告屏正在替换海报广告。广告素材目前主要靠在线推送(非前期人工U盘更新的方式),设备是否能在线是广告素材能否推送...

来自:

云产品

跨链数据可信连接服务

跨链数据连接服务 ODATS 是利用蚂蚁区块链领先技术实现的跨链数据连接服务。通过制定标准化的区块链UDAG全栈跨链协议,保证跨链交易的安全性、可扩展性及可靠性,打破区块链数据孤岛,实现同构及异构链之间的可信互通,助力企业之间可信协作,促进产业生态可信融合。

便捷接入、高效协同.更多产品与服务.可信存证是目前大量落地推广的区块链场景,但是每条链也形成了数据的孤岛。通过应用层跨链,很难保证信息的真实性,同时应用层适配异构链的改造成本也很高。如何能够低成本地进行信息可信跨链传递,成为迫切需要解决的问题。合同存证链、版权存证链等数据存证场景中,如果发生任何纠纷,...

来自:

云产品

跨链数据连接服务解决方案

利用蚂蚁区块链领先技术实现的跨链数据连接服务 Open Data Access Trusted Service(ODATS)。通过制定标准化的区块链UDAG全栈跨链协议,保证跨链交易的安全性、可扩展性及可靠性,打破区块链数据孤岛,实现同构及异构链之间的可信互通,助力企业之间可信协作,促进产业生态可信融合。

便捷接入、高效协同.通过制定标准化的区块链UDAG全栈跨链协议,保证跨链交易的安全性、可扩展性及可靠性,打破区块链数据孤岛,实现同构及异构链之间的可信互通,助力企业之间可信协作,促进产业生态可信融合.可信数据连接服务包括同构/异构区块链层,跨链服务层,以及在业务层的区块链编程层.通过跨链服务在底层区块链中的...

来自:

解决方案

- 产品推荐

- 这些文档可能帮助您