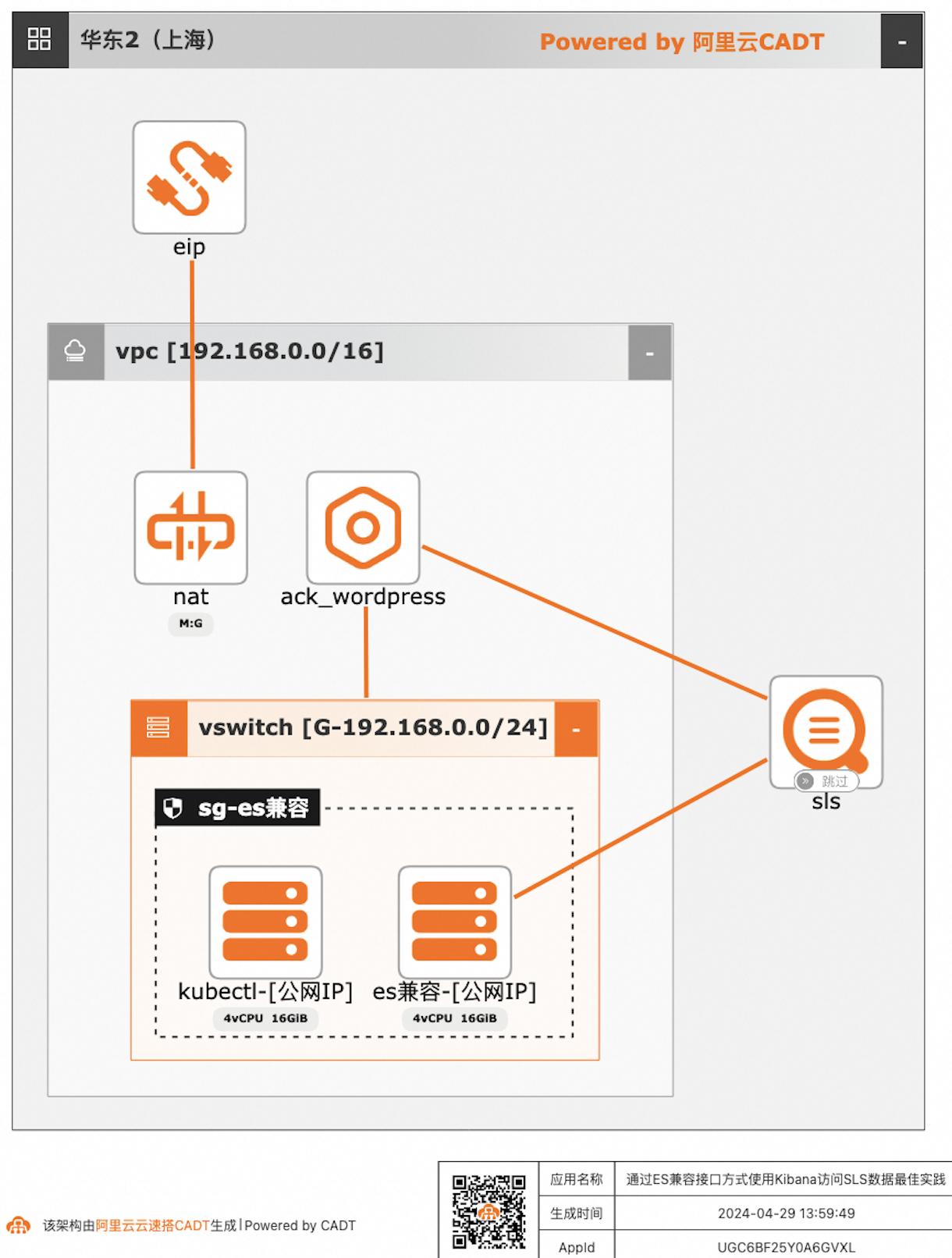

通过ES兼容接口方式使用Kibana访问SLS数据

自建ELK日志系统的客户迁移到阿里云日志服务SLS后,对SLS查询分析语法不太熟悉的客户,可以继续沿用原有的查询分析习惯,在不改变使用方式习惯的情况下,通过Elasticsearch兼容接口的方式使用Kibana访问SLS。

通过ES兼容接口方式使用Kibana访问SLS数据最佳实践 业务架构 场景描述 日志服务SLS提供Elasticsearch兼容接口,支 持客户将日志采集到日志服务后,仍可以继续沿 用Elasticsearch的查询方案,即通过使用 Kibana访问日志服务的Elasticsearch兼容接 口,实现查询SLS数据。应用场景 自建ELK日志系统的客户迁移到阿里云日志服 务...

金融专属大数据workshop

实践目标 学习搭建一个实时数据仓库,掌握数据采集、存储、计算、输出、展示等整个业务流程。 整个实时数据仓库系统全部基于阿里云产品进行架构搭建,用户可以掌握并学会运用各个服务组件及各个组件之间如何联动。 理解阿里云原生实时离线一体数仓解决方案架构以及掌握交付落地的实践使用方法。 前置知识要求 熟练掌握SQL语法 对大数据体系系统知识有一定的了解

阿里云技术框架 阿里云产品 简介 类比 ECS 弹性计算服务器 Linux服务器 RDS 关系型数据库 自有MySQL服务器 DataHub 数据总线 Kafka+各种服务接口 实时计算Flink版 实时计算 Spark、Flink Dataworks 一站式数据开发平台 目前没有 Hologres 交互式查询分析产品 PostgreSQL DataV 可视化数据展示工具 Tableau、Echarts、Kibana...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

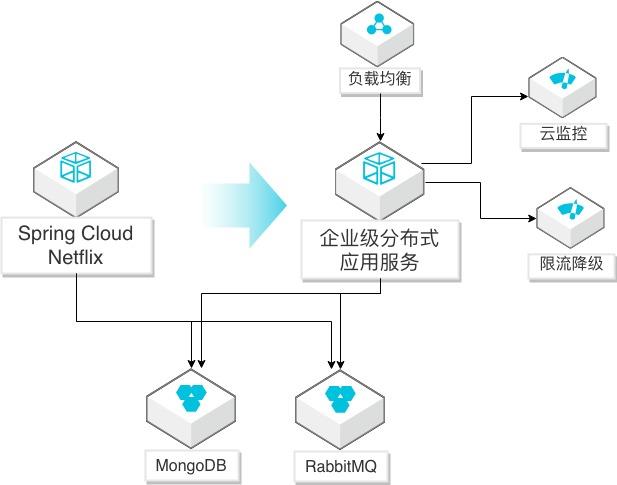

Spring Cloud Netflix应用迁移EDAS

场景描述 Spring Cloud Netflix微服务应用迁移到EDAS 服务(SpringCloud Alibaba云版本)的方法, 迁移后充分利用阿里云监控、调用链、限流降级 等能力,优化应用生命周期管理。 解决问题 1.帮助自建SpringCloudNetflix微服务应用 通过简单修改迁移到阿里云企业级分布式 应用服务(EDAS)平台。 2.迁移到EDAS后,简化应用的运维,提升监 控、调用链探测、限流降级等管理能力,提 高对应用的全生命周期管理。 产品列表 企业级分布式应用服务(EDAS) 负载均衡(SLB) 专有网络(VPC) 云服务器(ECS)

2.4节介绍部署微服务应用依赖的 RabbitMQ消息队列。2.5节介绍部署微服务应用依赖的 MongoDB数据库。2.6节介绍修改应用启动成功线下微服务应用。2.2.构建 PiggyMetrics本地开发环境 步骤1 下载项目源码。git clone https://github.com/sqshq/piggymetrics.git 步骤2 自行安装 JAVA环境和 MAVEN编译环境。1.请自行完成下载 ...

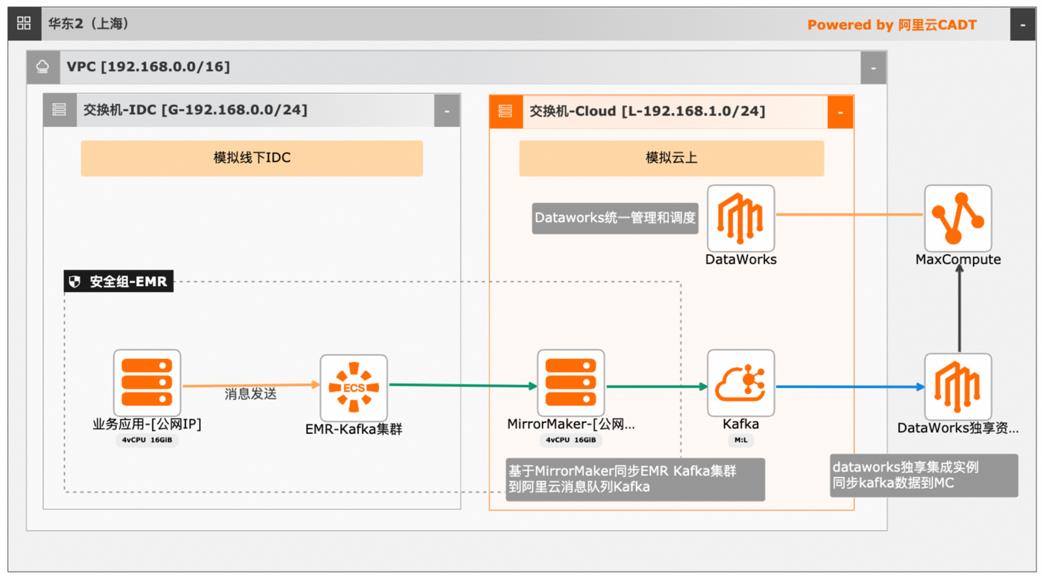

大数据近实时数据投递MaxCompute

本文介绍离线大数据场景使MaxCompute构建云 上近实时数仓,打通云下数据上云链路,解决数据复杂类型支持和动态分区问题,满足高级数据处理需求的最佳实践。 l混合云环境下,现有业务系统零改造,打通数据上云链路。 l使用UDF实现复杂数据类型转换和数据动态分区。 l使用DataWorks配置周期调度业务流程,数据自动入仓。 l借助MaxCompute优化计算引擎,实现降本增效。 产品列表 云服务器ECS 专有网络VPC 访问控制RAM 数据总线DataHub E-MapReduceEMR DataWorks 大数据计算服务MaxCompute

获取云消息队列 kafka的接入点.16 4.2.部署MirrorMaker服务.16 4.3.配置同步任务.18 5.投递数据至 MaxCompute.21 5.1.创建临时表.21 5.2.创建最终表.25 5.3.为Dataworks独享集成实例配置网络.28 5.4.配置Kafka数据源.29 5.5.MaxCompute中并验证数据.34 5.6.编写UDTF对临时表进行数据处理和动态分区.36 5.7.注册UDF函数.39 5...

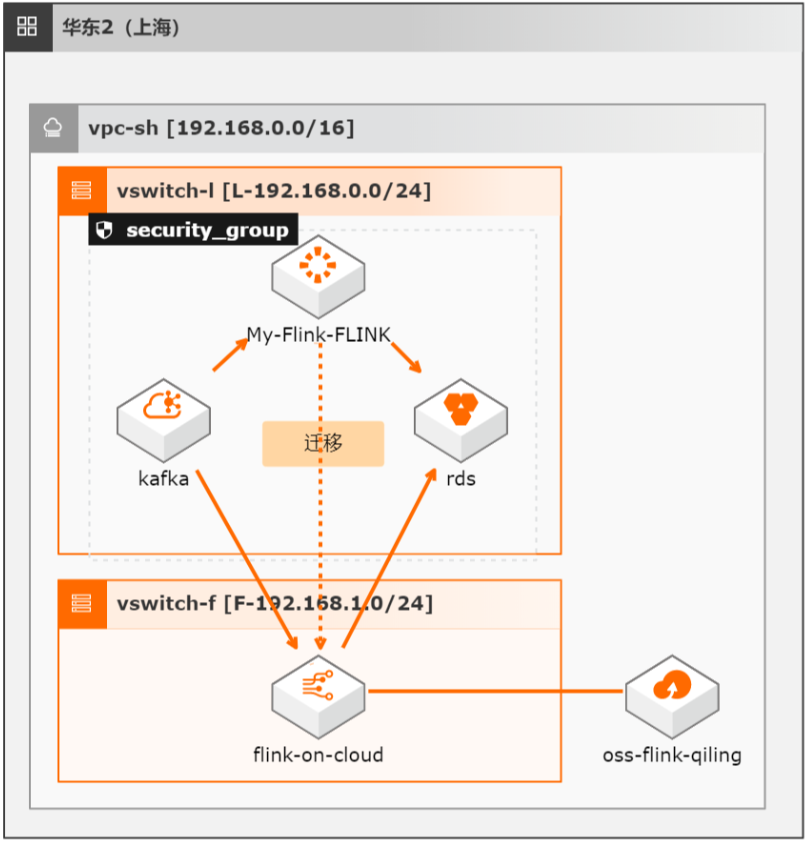

开源Flink迁移实时计算Flink全托管版最佳实践

本方案介绍如何将自建开源Flink集群的流式任务(包含Datastream、Table/SQL、PyFlink任务)迁移至阿里云实时计算全托管版。

参见:https://www.aliyun.com/product/rds/mysql 消息队列 Kafka 版:是阿里云基于 Apache Kafka 构建的高吞吐量、高可扩展性 的分布式消息队列服务,广泛用于日志收集、监控数据聚合、流式数据处理、在线 和离线分析等场景,是大数据生态中不可或缺的产品之一,阿里云提供全托管服 务,用户无需部署运维,更专业、更可靠、...

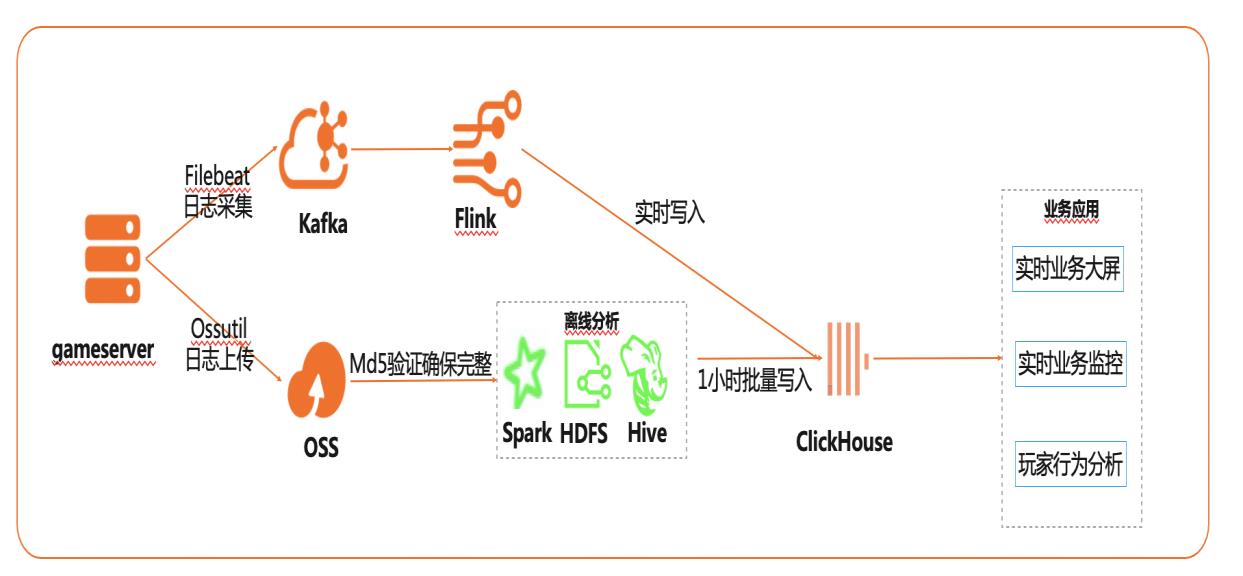

基于Flink+ClickHouse构建实时游戏数据分析

在互联网、游戏行业中,常常需要对用户行为日志进行分析,通过数据挖掘,来更好地支持业务运营,比如用户轨迹,热力图,登录行为分析,实时业务大屏等。当业务数据量达到千亿规模时,常常导致分析不实时,平均响应时间长达10分钟,影响业务的正常运营和发展。 本实践介绍如何快速收集海量用户行为数据,实现秒级响应的实时用户行为分析,并通过实时流计算Flink/Blink、云数据库ClickHouse等技术进行深入挖掘和分析,得到用户特征和画像,实现个性化系统推荐服务。 通过云数据库ClickHouse替换原有Presto数仓,对比开源Presto性能提升20倍。 利用云数据库ClickHouse极致分析性能,千亿级数据分析从10分钟缩短到30秒。 云数据库ClickHouse批量写入效率高,支持业务高峰每小时230亿的用户数据写入。 云数据库ClickHouse开箱即用,免运维,全球多Region部署,快速支持新游戏开服。 Flink+ClickHouse+QuickBI

产品列表 最佳实践频道 阿里云最佳实践分享群 专有网络 VPC 弹性公网 IP EIP 云服务器 ECS 消息队列 Kafka版 云数据库 ClickHouse 实时计算 Flink版 如二维码过期,Quick BI数据可视化分析平台 请搜索群号:31852400 云服务器 ECS(产品名称)文档模板(手册名称)/文档版本信息 阿里云 基于 Flink+ClickHouse 构建实时游戏...

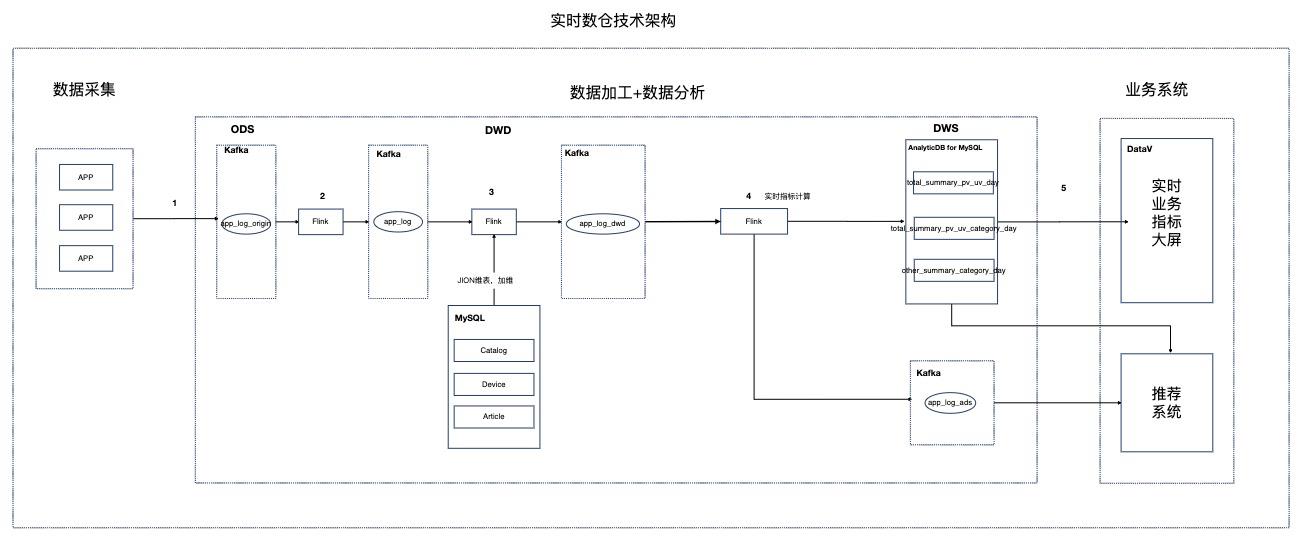

基于Flink的资讯场景实时数仓

场景描述 本实践针对资讯聚合类业务场景,Step by Step介绍 如何搭建实时数仓。 解决问题 1.如何搭建实时数仓。 2.通过实时计算Flink实现实时ETL和数据流。 3.通过实时计算Flink实现实时数据分析。 4.通过实时计算Flink实现事件触发。 产品列表 实时计算 专有网络VPC 云数据库RDSMySQL版 分析型数据库MySQL版 消息队列Kafka 对象存储OSS NAT网关 DataV数据可视化

更多信息,请参见:www.aliyun.com/product/vpc 消息队列 Kafka版:是阿里云基于 Apache Kafka 构建的高吞吐量、高可扩展性 的分布式消息队列服务,广泛用于日志收集、监控数据聚合、流式数据处理、在线 和离线分析等,是大数据生态中不可或缺的产品之一。阿里云提供全托管服务,用 户无需部署运维,更专业、更可靠、更安全...

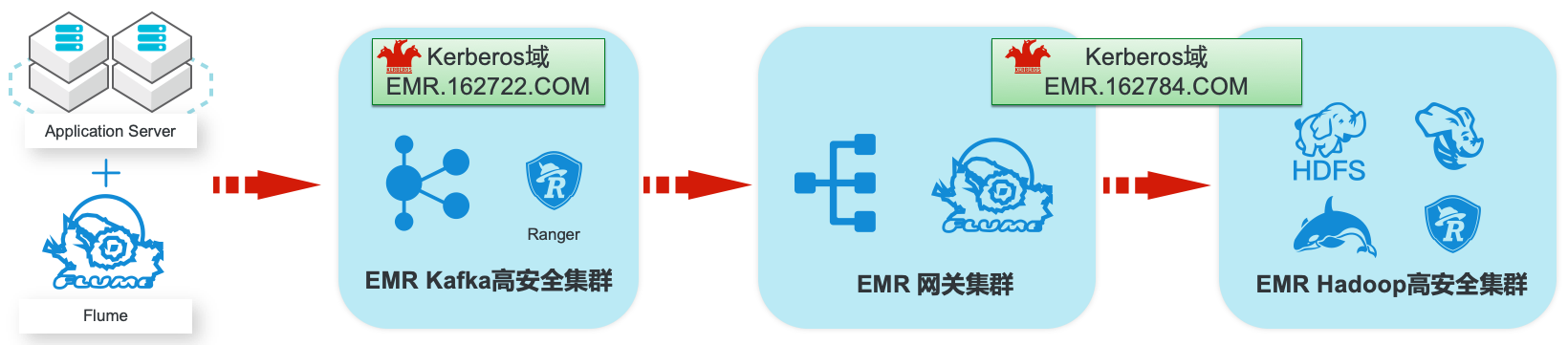

EMR集群安全认证和授权管理

场景描述 阿里云EMR服务Kafka和Hadoop安全集群使 用Kerberos进行用户安全认证,通过Apache Ranger服务进行访问授权管理。本最佳实践中以 Apache Web服务器日志为例,演示基于Kafka 和Hadoop的生态组件构建日志大数据仓库,并 介绍在整个数据流程中,如何通过Kerberos和 Ranger进行认证和授权的相关配置。 解决问题 1.创建基于Kerberos的EMR Kafka和 Hadoop集群。 2.EMR服务的Kafka和Hadoop集群中 Kerberos相关配置和使用方法。 3.Ranger中添加Kafka、HDFS、Hive和 Hbase服务和访问策略。 4.Flume中和Kafka、HDFS相关的安全配 置。 产品列表:E-MapReduce、专有网络VPC、云服务器ECS、云数据库RDS版

步骤2 查看 Flume后台日志,发现有报错信息:cd/mnt/disk1/log/flume/default-agent tail-f flume.log 说明该 Flume没有权限消费 Kafka队列的消息,需要通过 Kafka集群的 Ranger配置 消费消息队列的权限。文档版本:20200330 82 EMR集群安全认证和授权管理 EMR Hadoop安全集群和网关集群 步骤3 参考章节 2.6.3,编辑 Kafka...

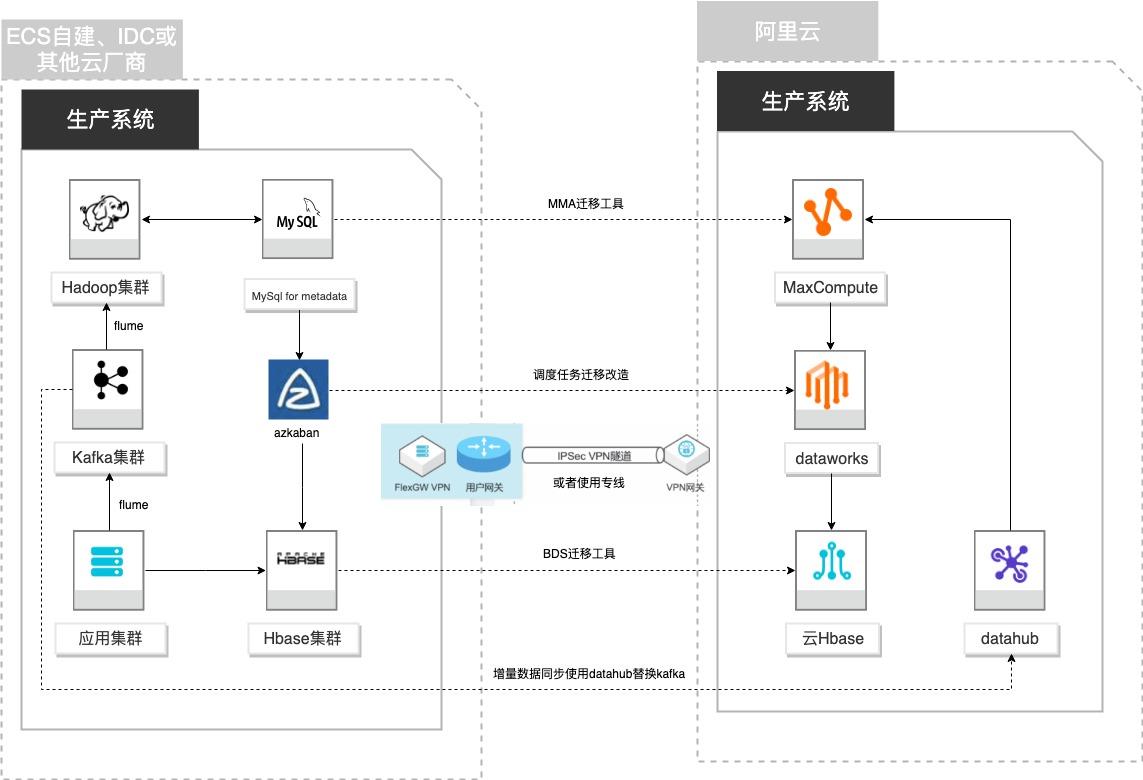

自建Hadoop迁移MaxCompute

场景描述 客户基于ECS、IDC自建或在友商云平台自建了大数 据集群,为了降低企业大数据计算平台的成本,提高 大数据应用开发效率,更有效保障数据安全,把大数 据集群的数据、作业、调度任务以及业务数据库整体 迁移到MaxCompute和其他云产品。 解决的问题 自建Hadoop集群搬迁到MaxCompute 自建Hbase集群搬迁到云Hbase 自建Kafka或应用数据准实时同步到 MaxCompute 自建Azkaban任务迁移到Dataworks任务 产品列表 MaxCompute,Dataworks、云数据库Hbase版、Datahub、VPC,ECS。

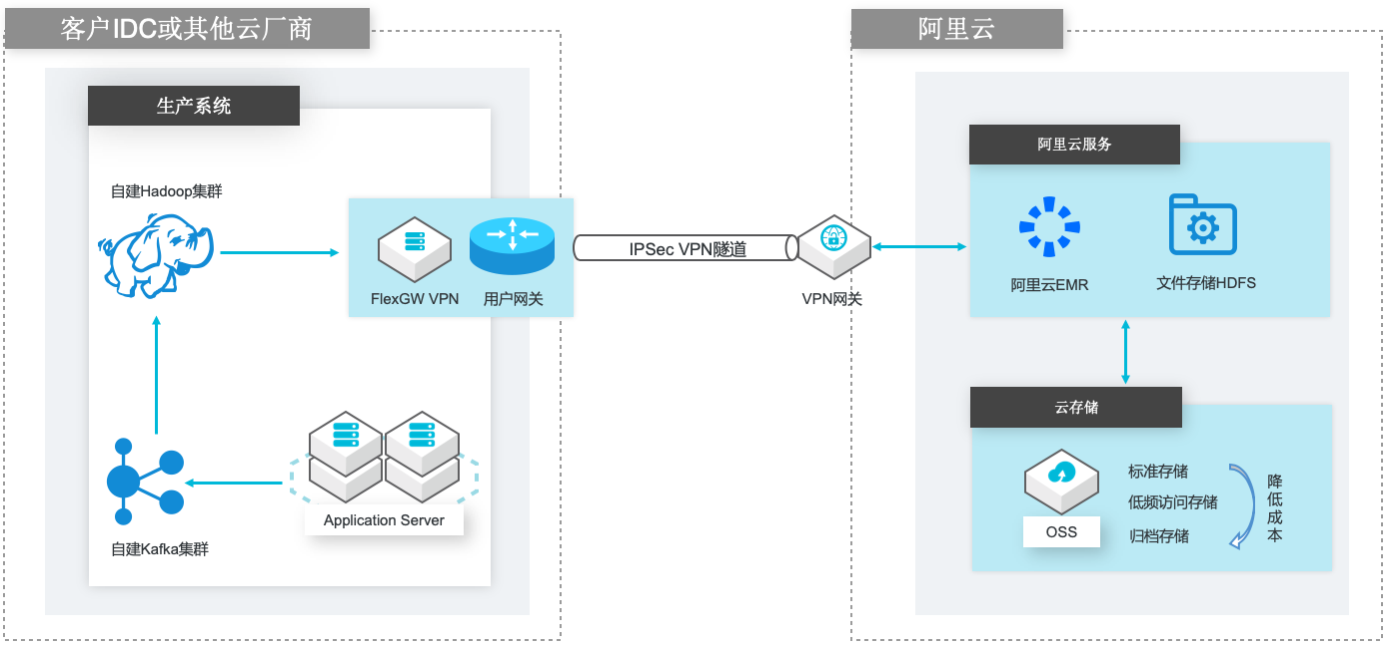

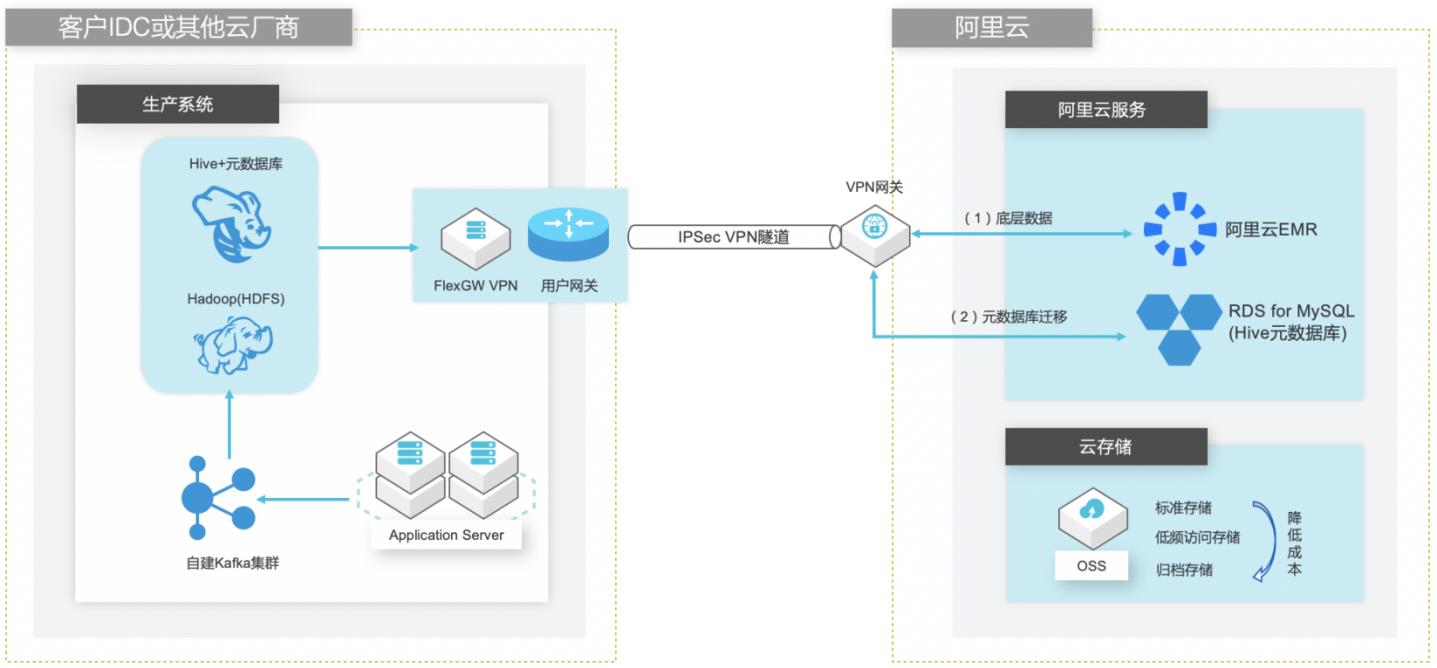

VPN网关 VPN网关是一款基于 Internet的网络连接服务,通过加密通道的方式实现企业数 据中心、企业办公网络或 Internet终端与阿里云专有网络(VPC)安全可靠的连 接。VPN 网关提供 IPSec-VPN 连接和 SSL-VPN 连接。详情请查看 https://www.aliyun.com/product/vpn IPSec VPN 基于路由的 IPSec-VPN,不仅可以更方便的配置和...

云消息队列 MQTT 版

云消息队列 MQTT 版是专为移动互联网(MI)、物联网(IoT)领域设计的消息产品,覆盖直播互动、金融支付、智能餐饮、即时聊天、移动 Apps、智能设备、车联网等多种应用场景;通过对 MQTT、WebSocket 等协议的全面支持,连接端云之间的双向通信,实现 C2C、C2B、B2C 等业务场景之间的消息通信,可支撑千万级设备与消息并发。

云消息队列 Kafka 版.兼容 AMQP 标准协议以及 RabbitMQ 开源生态与多语言客户端,开箱即用,免运维,更安全、更可靠.云消息队列 RabbitMQ 版.阿里巴巴官方指定消息产品,成熟、稳定、先进的技术体系打造金融级消息服务,感受双十一产品的完美体验.云消息队列 RocketMQ 版.采用 HTTP RESTful 标准,方便易用,快速接入,跨...

来自:

云产品

基于DataWorks的大数据一站式开发及数据治理

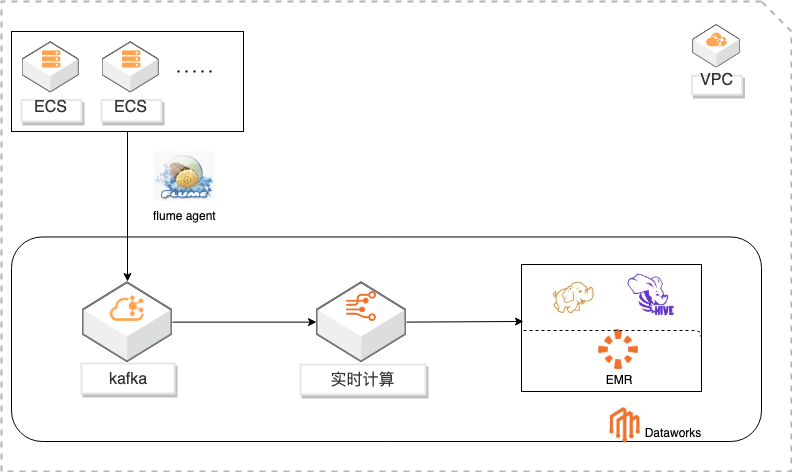

概述 基于Dataworks做大数据一站式开发,包含数据实时采集到kafka通过实时计算对数据进行ETL写入HDFS,使用Hive进行数据分析。通过Dataworks进行数据治理,数据地图查看数据信息和血缘关系,数据质量监控异常和报警。 适用场景 日志采集、处理及分析 日志使用Flink实时写入HDFS 日志数据实时ETL 日志HIVE分析 基于dataworks一站式开发 数据治理 方案优势 大数据一站式开发,完善的数据治理能力。 性能优越:高吞吐,高扩展性。 安全稳定:Exactly-Once,故障自动恢复,资源隔离。 简单易用:SQL语言,在线开发,全面支持UDX。 功能强大:支持SQL进行实时及离线数据清洗、数据分析、数据同步、异构数据源计算等Data Lake相关功能 ,以及各种流式及静态数据源关联查询。

4.配置任务:a1.sources=logfile a1.channels=memoryChannel a1.sinks=k1 a1.sources.logfile.type=exec a1.sources.logfile.command=tail-F/var/log/gen.log a1.sources.logfile.channels=memoryChannel a1.sinks.k1.type=org.apache.flume.sink.kafka.KafkaSink a1.sinks.k1.kafka.topic=me_log a1.sinks.k1.kafka....

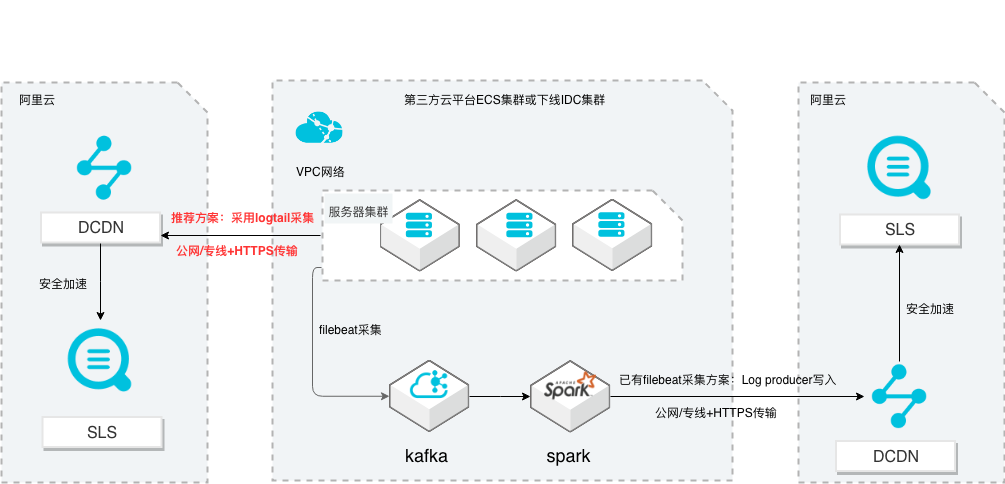

SLS多云日志采集、处理及分析

场景描述 从第三方云平台或线下IDC服务器上采集 日志写入到阿里云日志服务,通过日志服务 进行数据分析,帮助提升运维、运营效率, 建立DT 时代海量日志处理能力。 针对未使用其他日志采集服务的用户,推荐 在他云或线下服务器安装logtail采集并使用 Https安全传输;针对已使用其他日志采集 工具并且已有日志服务需要继续服务的情 况,可以通过Log producer SDK写入日志 服务。 解决问题 1.第三方云平台或线下IDC客户需要使用 阿里云日志服务生态的用户。 2.第三方云平台或线下IDC服务器已有完 整日志采集、处理及分析的用户。 产品列表 E-MapReduce 专有网络VPC 云服务器ECS 日志服务LOG DCDN

步骤6 开始读取 RDD 数据集,并通过 map 函数把读取的 JavaRDD>中的 Payload(即 kafka中的消息)提取转化为 JavaRDD,并通过 collect函数把 RDD数据转化为 List。步骤7 创建 producer,使用多线程对 List中的数据进行处理,写入日志服务(这里数据写入 文档版本:20211203 61 SLS多云日志采集、处理及分析 编写 Spark作业...

自建Hadoop迁移到阿里云EMR

场景描述 场景1:自建Hadoop集群数据(HDFS)迁移到 阿里云EMR集群的HDFS文件系统; 场景2:自建Hadoop集群数据(HDFS)迁移到 计算存储分离架构的阿里云EMR集群,以OSS 和JindoFS作为EMR集群的后端存储。 解决的问题 客户自建Hadoop迁移到阿里云EMR集群的 技术方案; 基于IPSecVPN隧道构建安全和低成本数据 传输链路 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

VPN网关 VPN网关是一款基于 Internet的网络连接服务,通过加密通道的方式实现企业数 据中心、企业办公网络或 Internet终端与阿里云专有网络(VPC)安全可靠的连 接。VPN 网关提供 IPSec-VPN 连接和 SSL-VPN 连接。详情请查看 https://www.aliyun.com/product/vpn IPSec VPN 基于路由的 IPSec-VPN,不仅可以更方便的配置和...

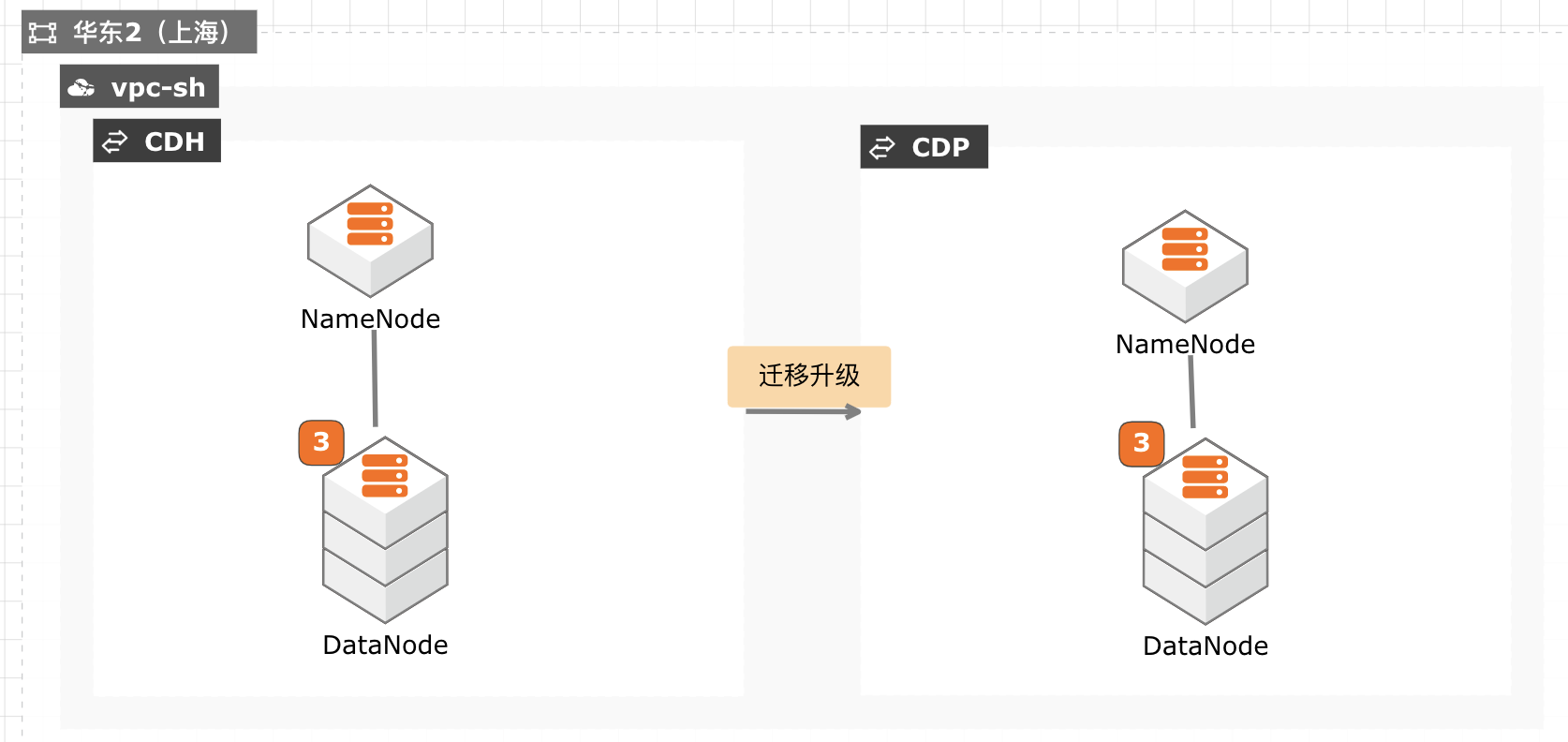

CDH迁移升级CDP最佳实践

当前 CDH 免费版停止下载,终止服务,针对需要企业版服务能力并且CDH 升级过程对业务影响较小的客户,通过安装新的 CDP 集群,将现有数据拷贝至新集群,然后将新集群切换为生产集群,升级过程没有数据丢失风险,停机时间较短,适合大部分互联网客户升级使用。

chmod+x/usr/java/jdk1.8.0_301/bin/java ssh slave1 chmod+x/usr/java/jdk1.8.0_301/bin/java ssh slave2 chmod+x/usr/java/jdk1.8.0_301/bin/java ssh slave3 chmod+x/usr/java/jdk1.8.0_301/bin/java 进入主机菜单配置 JDK所在目录。配置所有主机的 JAVA主目录为/usr/java/jdk1.8.0_301。文档版本:20211029 28 CDH迁移...

阿里云云原生可观测套件

阿里云云原生可观测套件围绕Prometheus服务、Grafana服务和链路追踪服务,通过标准的PromQL和SQL提供数据大盘展示、告警和数据探索能力。

《JAVA 应用排查全景图》.详细阐述云原生架构定义,完整展示云原生架构应用所需的演进路径与设计规则,帮助企业更好地理解与应用云原生架构,助力企业数字化转型升级.《云原生架构白皮书》.图片56*56(不可与icon共存).图片logo.icon名称(不可与图片logo共存).icon名称.不填写不展示.包含前端监控、应用监控、云拨测,覆盖...

来自:

云产品

大数据workshop

大数据workshop

需要创建高级版或专业版的 Quick BI以便支持 Hologres作为数据源(如果不支持 Hologres可以选择 PostgreSQL进行连接)。步骤2 新建数据源。文档版本:20210628(发布日期)70 阿里云最佳实践大数据 WorkShop 最佳实践项目实践 步骤3 选择 Hologres。文档版本:20210628(发布日期)71 阿里云最佳实践大数据 WorkShop 最佳...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

自建Hive数仓迁移到阿里云EMR

场景描述 客户在IDC或者公有云环境自建Hadoop集群构 建数据仓库和分析系统,购买阿里云EMR集群之 后,涉及到将数据仓库和Hive元数据的数据库迁 移上云。目前主流Hive数据仓库迁移场景为1.x 版本迁移到阿里云EMR(Hive2.x版本),涉及到 数据订正更新步骤。 解决的问题 Hive数据仓库的数据迁移方案 Hive元数据库的迁移方案 Hive跨版本迁移后的数据订正 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

基础环境搭建 本实践方案中,将按照技术架构图搭建相对完整的实践环境,包括 Apache日志发生 器、Kafka队列、Hadoop集群、Hive+MySQL元数据库。1.1.使用云速搭 CADT快速创建资源 步骤1 登录云速搭 CADT控制台。(https://bpstudio.console.aliyun.com/#/bpStudio/topo)按照以下架构图拖拽资源,并命名 文档版本:20210721 ...

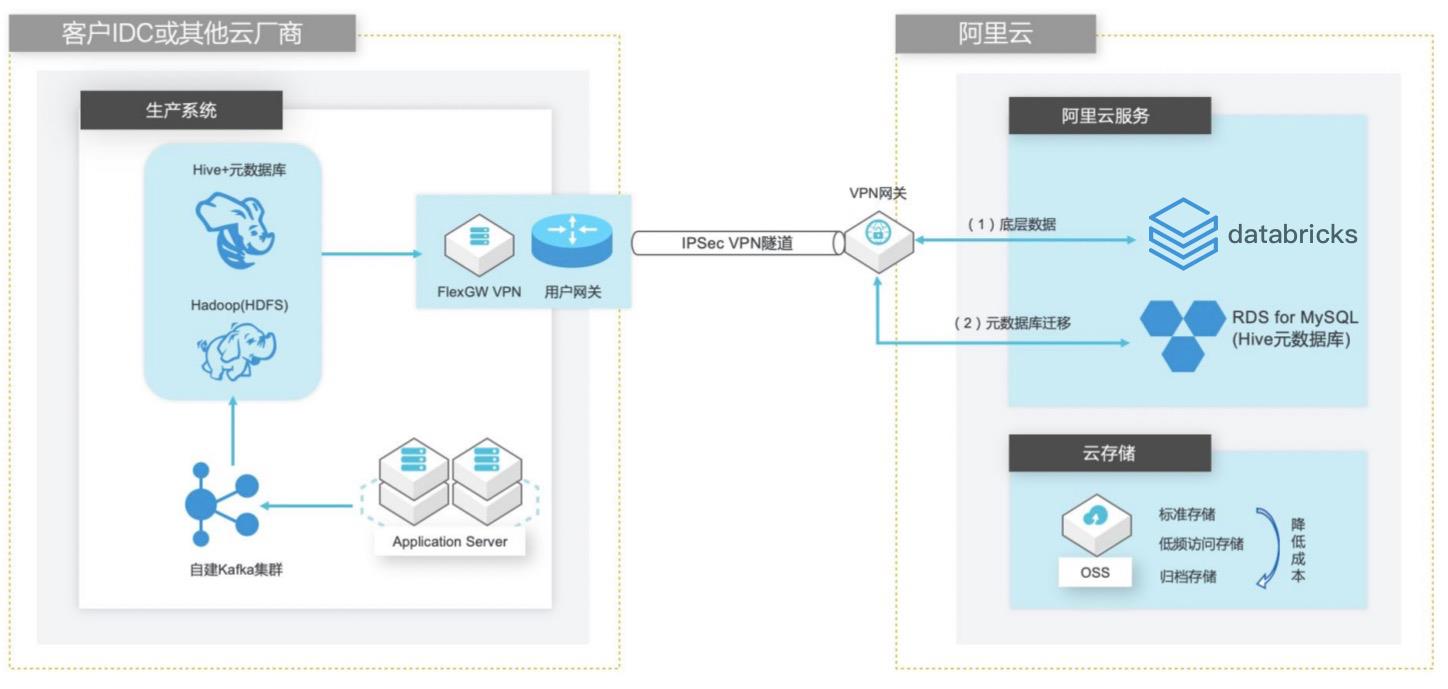

自建Hive数据仓库跨版本迁移到阿里云Databricks数据洞察

场景描述 客户在IDC或者公有云环境自建Hadoop集群构建数据仓库和分析系统,购买阿里云Databricks数据洞察集群之后,涉及到数仓数据和元数据的迁移以及Hive版本的订正更新。 方案优势 1. 全托管Spark集群免运维,节省人力成本。 2. Databricks数据洞察与阿里云其他产品(OSS、RDS、MaxCompute、EMR)进行深度整合,支持以这些产品为数据源的输入和输出。 3. 使用Databricks Runtime商业版引擎相比开源Spark性能有3-5倍的提升。 解决问题 1. Hive数仓数据迁移OSS方案。 2. Hive元数据库迁移阿里云RDS方案。 3. Hive跨版本迁移到Databricks数据洞察使用Delta表查询以提高查询效率。

Hive版本从 1.2.2变更为 2.3.5,因此这里我们需要依次执行下面几个 升级脚本:upgrade-1.2.0-to-2.0.0.mysql.sql upgrade-2.0.0-to-2.1.0.mysql.sql upgrade-2.1.0-to-2.2.0.mysql.sql upgrade-2.2.0-to-2.3.0.mysql.sql 步骤3 执行升级脚本更新 Hive元数据库的表结构,红色字体为 RDSforMySQL实例的内网连 接地址。...

- 产品推荐

- 这些文档可能帮助您