云消息队列 Kafka 版

云消息队列 Kafka 版是阿里云基于Apache Kafka构建的大数据消息中间件,广泛用于日志收集和分析、数据处理等场景。可提供全托管服务,用户无需部署运维,更专业、更可靠、更安全。

近年来KV存储(HBase)、搜索(ElasticSearch)、流式处理(Storm/Spark Streaming/Samza)、时序数据库(OpenTSDB)等专用系统应运而生,产生了同一份数据集需要被注入到多个专用系统内的需求。利用云消息队列 Kafka 版作为数据中转枢纽,同份数据可以被导入到不同专用系统中.发布/订阅模型,支持同份数据集能同时被消费多...

来自:

云产品

日志服务sls

日志服务(Log Service,简称Log)是针对实时数据一站式服务,在阿里集团经历大量大数据场景锤炼而成。无需开发就能快捷完成数据采集、消费、投递以及查询分析等功能,帮助提升运维、运营效率,建立DT时代海量日志处理能力。

日志服务 SLS 全面兼容开源 Elasticsearch.全栈可观测应用发布.云产品可观测平台 Alibaba CloudLens 发布.日志服务学习路径.日志服务案例中心.手把手进阶学习日志服务.SLS 开箱即用的日志应用.日志服务 SLS 助力企业 SecOps 云上安全审计.支持Log/Metric/Trace统一采集,支持服务器/应用/移动设备/网页/IoT等数据源接入,...

来自:

云产品

数据传输解决方案

数据传输解决方案支持关系型数据库、NoSQL、大数据(OLAP)等数据源间的数据传输。 它是一种集数据迁移、数据订阅及数据实时同步于一体的数据传输服务。数据传输致力于在公共云、混合云场景下,解决远距离、毫秒级异步数据传输难题。

完成从其他云厂商到阿里云的数据库实例多对一迁移.数据传输DTS.DTS实例的创建.创建数据传输DTS迁移、同步、订阅实例.创建数据迁移任务.选择不同的数据源和数据目标进行结构、全量和增量迁移.创建数据同步作业.支持MySQL、PolarDB-X、ADS、Redis、Elasticsearch等.创建数据订阅通道.创建MySQL、Oracle、PolarDB-X等数据订阅...

来自:

解决方案

数据管理与服务

数据管理与服务作为阿里云产品六大版块之一,面向不同业务场景,阿里云提供数据存储、分析、应用等全链路能力,满足企业客户全方位的数据处理需求,实现计算和存储分离、资源解耦、数据移动减化,用以满足行业快速发展的需求和趋势,利用数据重塑其业务。

检索分析服务 Elasticsearch 版.开源大数据平台 E-MapReduce.智能用户增长 Quick Audience.图计算服务 Graph Compute.数据湖构建 Data Lake Formation.数据可视化 DataV.数据可视化分析平台 Quick BI.数据总线 DataHub.数据集成 Data Integration.大数据专家服务.数据资源平台.智能数据建设与治理 Dataphin.Databricks 数据...

来自:

云产品

大数据workshop

大数据workshop

最佳实践方案设计 本章节通过对项目需求进行分析,理清项目架构里的各模块的需求点以及使用的阿 里云产品,基础环境可以使用阿里云的云架构设计工具 CADT进行搭建。2.1.实践目标以及前置知识要求 实践目标 1.学习搭建一个实时数据仓库,掌握数据采集、存储、计算、输出、展示等整个业 务流程。2.整个实时数据仓库系统全部...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

数据集成 Data Integration

阿里云数据集成 Data Integration是跨异构数据、低成本、弹性扩展的数据采集同步平台,为DataX的商业版,支持ETL,支持50+数据源跨网络离线(全量/增量)同步。

将指定的整个数据库全部或者部分表一次性的全部同步至Elasticsearch,并且支持后续的实时增量同步模式,将新增数据持续同步至Elasticsearch.一键实时同步至MaxCompute.可以将指定数据源中的数据,通过简单的配置,一次性的实时同步到MaxCompute中,支持整库内批量多表同步,同时也支持全增量一体化同步,先全量数据迁移,...

来自:

云产品

可观测可视化 Grafana 版

可观测可视化 Grafana 版作为云原生数据可视化平台,为运维SRE、研发工程师、产品经理、市场营销等不同角色提供开箱即用的一站式可视化平台,满足运维监控、经营分析、汇报展示等不同场景的查询、可视化、告警需求。

默认集成 ARMS、Prometheus、云监控、日志服务等云服务,提供 MySQL、Elasticsearch 各种云服务数据源配置、预置大盘与一键告警.海量插件任意选.近百种 Grafana 插件任意选择,借助数据源插件快速连接各类已有数据源,实时展现数据看板,无需数据迁移或抽取.自定义警报体系.一键创建警报并轻松整合各类报警,让告警策略制定...

来自:

云产品

云数据库ClickHouse

云数据库ClickHouse 是阿里云提供的分布式实时分析型列式数据库服务。具有高性能、开箱即用、企业特性支持。广泛应用于流量分析、广告营销分析、行为分析、人群划分、客户画像、敏捷BI、数据集市、网络监控、分布式服务和链路监控等业务场景。

解决自建开源 Elasticsearch 海量日志写入OOM 频发,随机聚合分析效率低问题。数据分效率提升 8 倍,人群圈选整体流程从 30 分钟缩短到 5 秒,资源投入更低,业务更稳定.某潮品社区电商.助力客户实现用户群体行为分析,支撑实时大屏等实时业务监控和实时运营。替换原有 Presto数仓,稳定支撑高峰期每小时200多亿数据写入。...

来自:

云产品

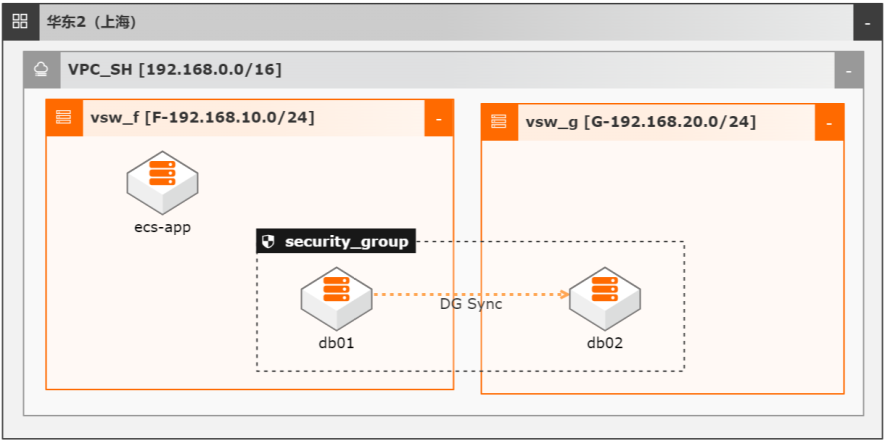

弹性裸金属自建ORACLE数据库双机

场景描述 1.客户业务系统选型ORACLE数据库且不愿做 业务改造:由于历史原因,客户业务系统只支持 ORACLE数据库,客户没有技术/时间去做技术栈 改造。 2.高性能:希望拥有比虚拟机更高的性能和稳定 性,以保障数据库高性能,支撑高并发的业务系 统。 3.高可用:追求数据库服务的高可用,在某一台数 据库服务器宕机时快速切换备机,实现对业务应 用的最小影响。 4.数据安全性:极端情况下能找回数据,数据备份 和恢复更方便。

ESSD云盘适用于部署 OLTP数据库、NoSQL数据库,运行 ElasticSearch分布式日志等场景。文档版本:20220207 III 弹性裸金属自建 ORACLE数据库双机 前言 快照:快照是某一时间点一块云盘和共享块存储(以下简称磁盘)的数据状态文 件。常用于数据备份、数据恢复和制作自定义镜像等。镜像:ECS镜像提供了创建 ECS实例所需的信息...

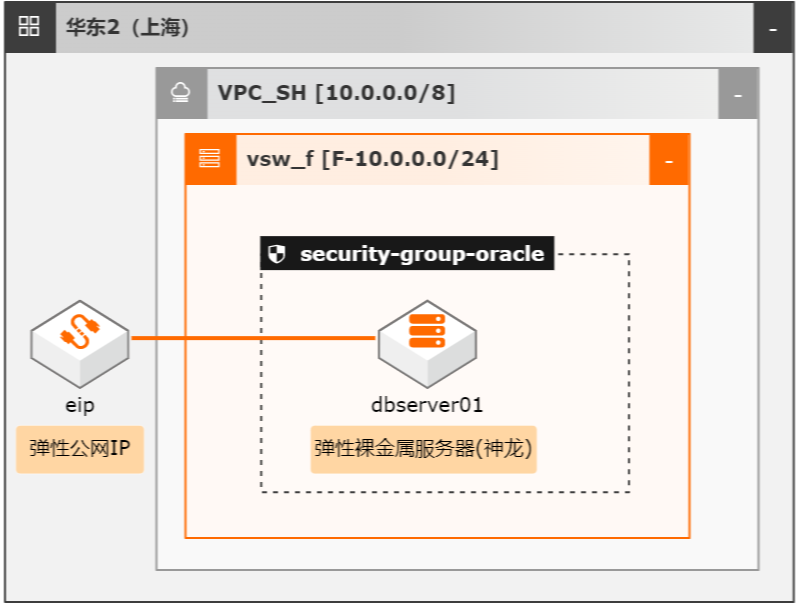

弹性裸金属自建ORACLE数据库单机版

场景描述 1.客户业务系统选型ORACLE数据库且不愿 做业务改造:由于历史原因,客户业务系统 只支持ORACLE数据库。适配开源数据库 业务改造量大,客户没有技术/时间去做改 造。 2.高性能:客户希望拥有比虚拟机更高的性能 和稳定性,以保障数据库高性能,支撑高并 发的业务系统; 3.高可用:在单机条件下,极端情况下数据库 发生宕机时,客户希望能快速拉起数据库服 务,减少停机时间; 4.数据安全性:极端情况下能找回数据。数据 备份和恢复更方便。

ESSD云盘适用于部署 OLTP数据库、NoSQL数据库,运行 ElasticSearch 分布式日志等场景。详见 https://help.aliyun.com/knowledge_detail/40551.html 快照:快照是某一时间点一块云盘和共享块存储(以下简称磁盘)的数据状态文 件。常用于数据备份、数据恢复和制作自定义镜像等。详见 ...

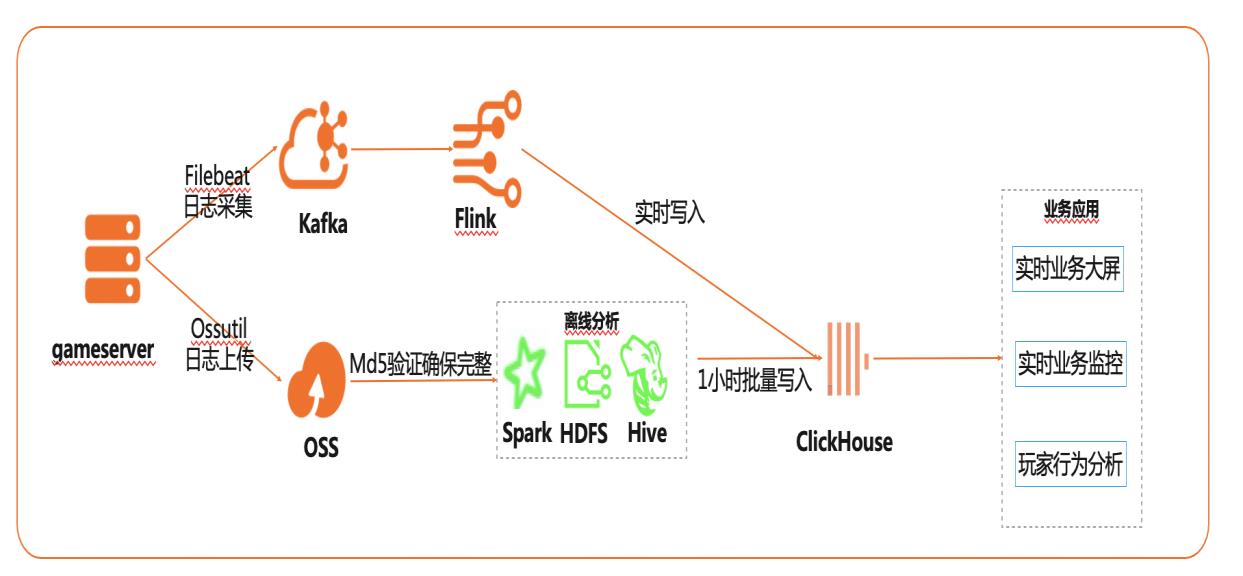

基于Flink+ClickHouse构建实时游戏数据分析

在互联网、游戏行业中,常常需要对用户行为日志进行分析,通过数据挖掘,来更好地支持业务运营,比如用户轨迹,热力图,登录行为分析,实时业务大屏等。当业务数据量达到千亿规模时,常常导致分析不实时,平均响应时间长达10分钟,影响业务的正常运营和发展。 本实践介绍如何快速收集海量用户行为数据,实现秒级响应的实时用户行为分析,并通过实时流计算Flink/Blink、云数据库ClickHouse等技术进行深入挖掘和分析,得到用户特征和画像,实现个性化系统推荐服务。 通过云数据库ClickHouse替换原有Presto数仓,对比开源Presto性能提升20倍。 利用云数据库ClickHouse极致分析性能,千亿级数据分析从10分钟缩短到30秒。 云数据库ClickHouse批量写入效率高,支持业务高峰每小时230亿的用户数据写入。 云数据库ClickHouse开箱即用,免运维,全球多Region部署,快速支持新游戏开服。 Flink+ClickHouse+QuickBI

Filebeat 可以监听指定的日 志文件或位置,从中收集日志事件并将其转发到 Elasticsearch或 Logstash进行索引,本实践采用 Filebeat收集 game-server的日志,并转发到 kafka。步骤1 在 ECS服务器上面,下载 Filebeat,为了兼容消息队列 kafka版本,推荐下载 filebeat-6.4.0-linux-x86_64:wget ...

云原生多模数据库Lindorm

云原生多模数据库Lindorm提供各规模、多模型的云原生数据库服务。可兼容HBase/Cassandra、OpenTSDB、Solr、SQL、HDFS等多种开源标准接口。支持海量数据的低成本存储处理和弹性按需付费,是互联网、IoT、车联网、广告、社交等场景首选数据库,也是为阿里核心业务提供支撑的数据库之一。

如何破解HBase+Elasticsearch组合使用遇到的难题.基于lindorm的互联网广告解决方案.面向海量KV、表格数据,具备全局二级索引、多维检索、动态列、TTL等能力,适用于元数据、订单、账单、画像、社交、feed流、日志等场景,兼容HBase、Phoenix(SQL)、Cassandra等开源标准接口.面向IoT、监控等场景存储和处理量测数据、设备...

来自:

云产品

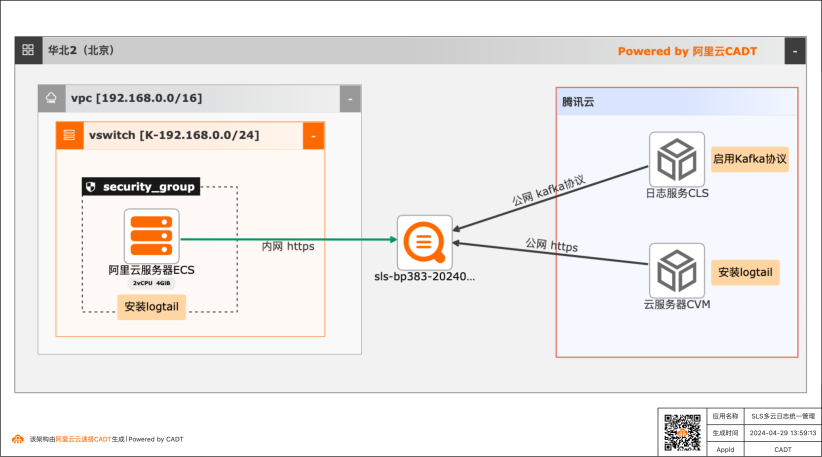

阿里云日志服务SLS多云统一日志方案之腾讯云日志采集最佳实践

使用日志服务SLS统一采集、存储、查询和分析阿里云、腾讯云等不同云厂商上的业务日志、系统日志和云产品日志,实现在一个平台上管理多云架构下的所有日志。

阿里云 SLS多云日志统一管理方案-腾讯云日志采集 最佳实践 业务架构 场景描述 使用日志服务 SLS统一采集、存储、查询和分析 阿里云、腾讯云等不同云厂商上的业务日志、系 统日志和云产品日志,实现在一个平台上管理多 云架构下的所有日志。产品列表 方案适用的场景和优势 阿里云 多云:使用多云架构的用户都需要有一个统一...

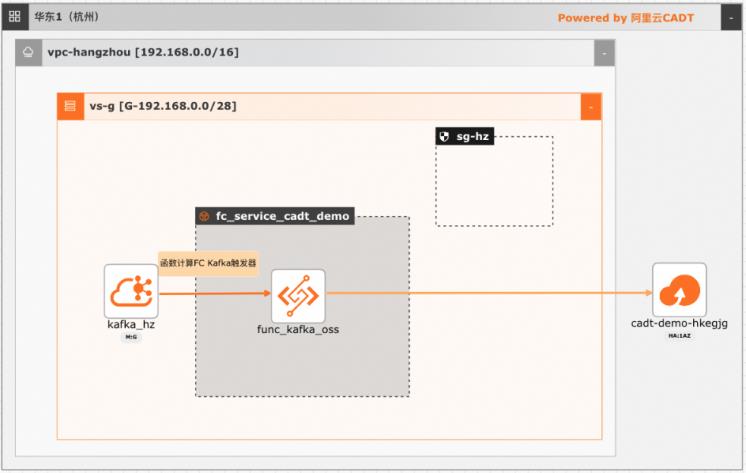

基于函数计算FC实现阿里云Kafka消息轻量级ETL处理

在大数据ETL场景,Kafka是数据的流转中心,Kafka中的数据一般是原始数据,可能存在多种数据混杂的情况,需要进一步做数据清洗后才能进行下一步的处理或者保存。利用函数计算FC,可以快速高效的搭建数据处理链路,用户只需要关注数据处理的逻辑,数据的触发,弹性伸缩,运维监控等阿里云函数计算都已经做了集成,函数计算FC也支持多种下游,OSS/数据库/消息队列/ES等都可以自定义的对接

专有网络 VPC 阿里云交换机 解决问题 阿里云安全组•快速搭建起数据处理全链路 阿里云函数计算(FC)•全链路自适应弹性,无需为流量峰谷做频繁 对象存储 OSS 的手工处理 阿里云云消息队列 Kafka 版•内置 CICD平台能力,灰度,回滚,监控开箱 云速搭 CADT 即用•按量付费,没有资源闲置费用 最佳实 践频道 ...

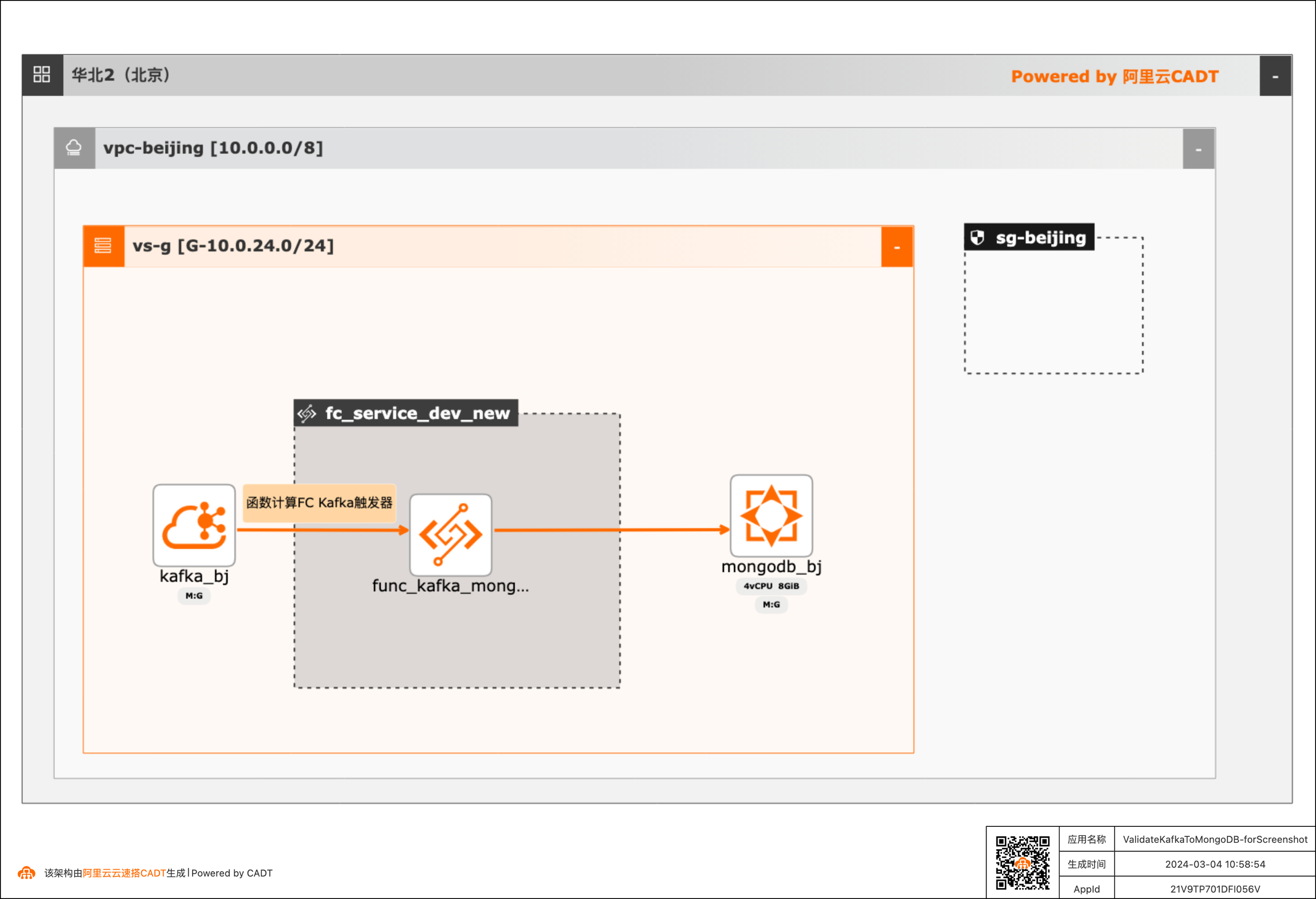

基于函数计算FC实现阿里云Kafka消息内容控制MongoDB DML操作

在大数据ETL场景,将Kafka中的消息流转到其他下游服务是很常见的场景,除了常规的消息流转外,很多场景还需要基于消息体内容做判断,然后决定下游服务做何种操作。 该方案实现了通过Kafka中消息Key的内容来判断应该对MongoDB做增、删、改的哪种DML操作。 当Kafka收到消息后,会自动触发函数计算中的函数,接收到消息,对消息内容做判断,然后再操作MongoDB。用户可以对提供的默认函数代码做修改,来满足更复杂的逻辑。 整体方案通过CADT可以一键拉起依赖的产品,并完成了大多数的配置,用户只需要到函数计算和MongoDB控制台做少量配置即可。

基于函数计算 FC 实现阿里云 Kafka 消息内容控制 MongoDB DML 操作 最佳实践 场景描述 业务架构 基于阿里云 Kafka 消息的 Key 或者消息体里的内 容做判断,然后对 MongoDB 做增,删,改的操 作。在传统 ETL 流程的基础上进一步增加了灵活 性和可扩展性。应用场景 在大数据 ETL 场景,将 Kafka 中的消息流转到其 他下游服务...

- 产品推荐

- 这些文档可能帮助您