- 相关产品:

- 基因云解决方案 保险数据中台解决方案 微服务持续交付解决方案

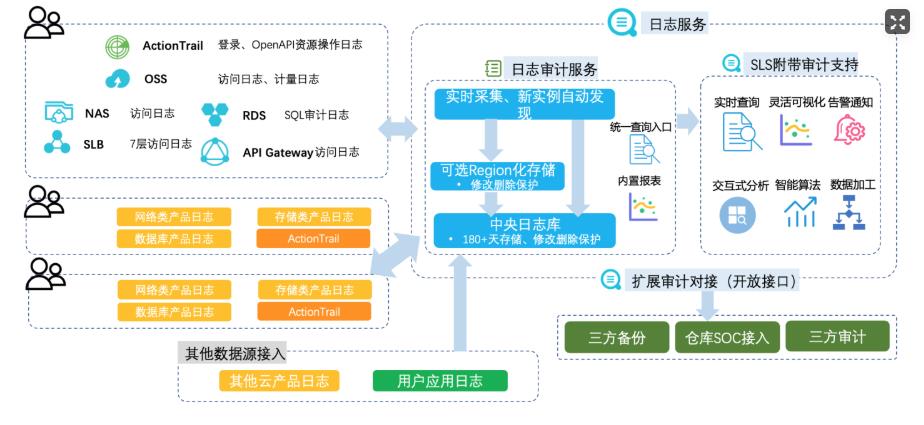

云上日志集中审计

场景描述 云上的各类云产品和客户部署的业务系统会产生各类 日志,企业合规及安全运营等都需要在一个地方能 集中的查看和分析日志;目前各云产品日志大部分 都进了sls,但都是产品独立的project,不方便集中 审计;客户的业务系统日志各种形态都有;多云和混 合云的场景,日志也需要能集中审计。 解决问题 1.所有日志集中到SLS一个中心project下。 2.满足等保合规和内部合规需求。 3.满足运维和安全运营需求。 产品列表 日志服务SLS 专有网络VPC 弹性公网IPEIP 负载均衡SLB 云服务器ECS 云数据库RDS 云防火墙CFW

ActionTrail审计中心 文档版本:20200630(发布日期)49 云上日志集中审计 日志审计示例 SLB审计中心 RDS审计中心 文档版本:20200630(发布日期)50 云上日志集中审计 日志审计示例 Web Log Apache日志 OSS审计中心 因为我们没有做 OSS相关的操作,所以 OSS审计中心,除了账号里的 OSS的历史 bucket之外,其他都是空的。...

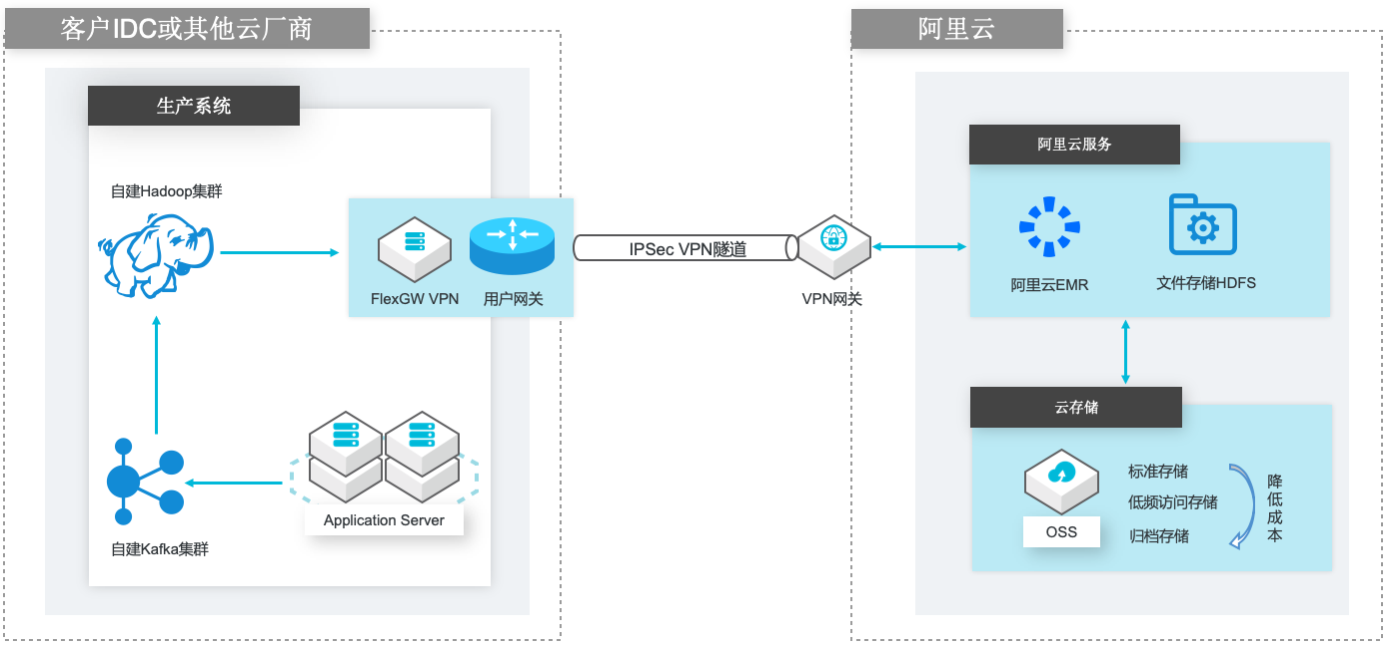

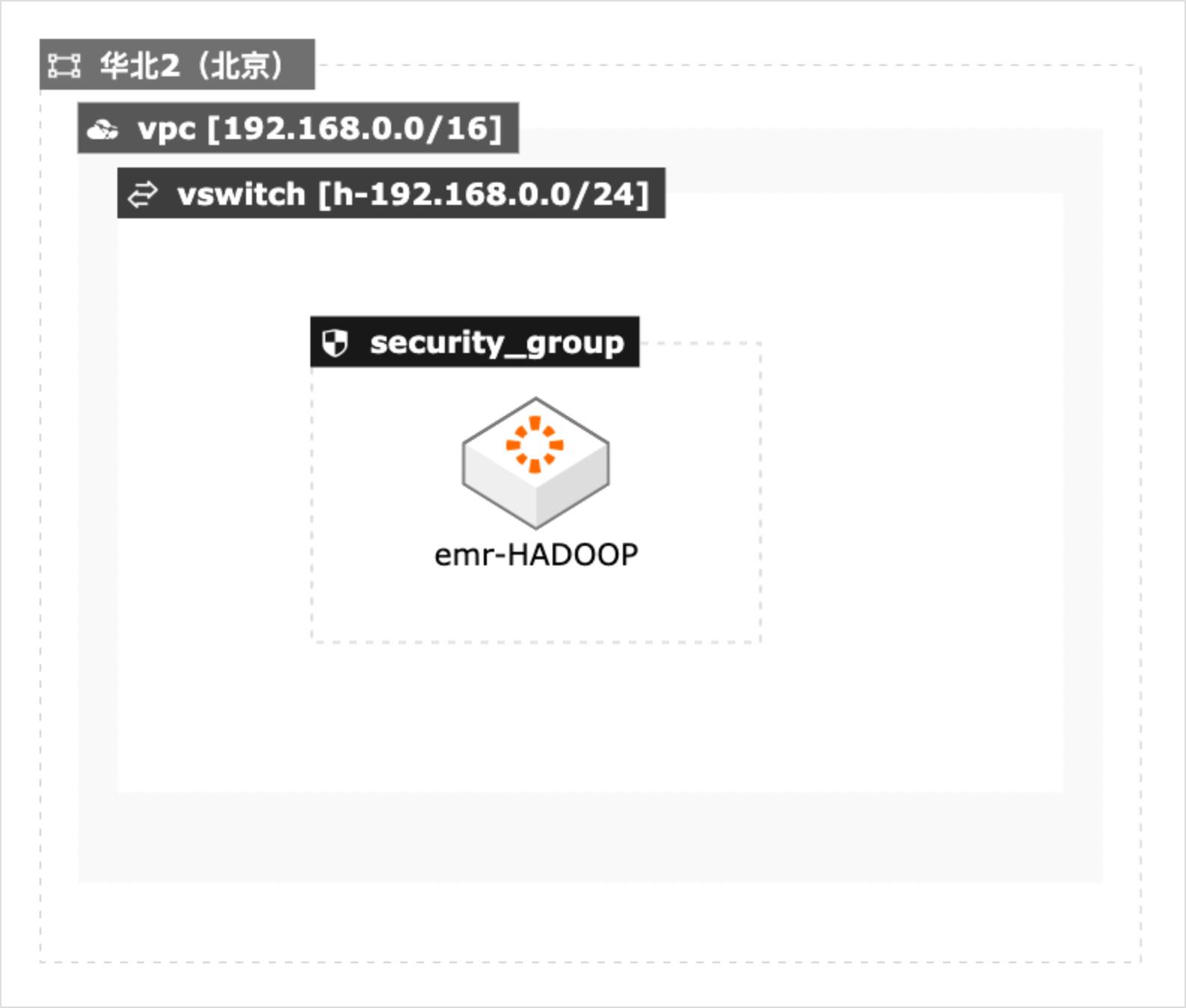

自建Hadoop迁移到阿里云EMR

场景描述 场景1:自建Hadoop集群数据(HDFS)迁移到 阿里云EMR集群的HDFS文件系统; 场景2:自建Hadoop集群数据(HDFS)迁移到 计算存储分离架构的阿里云EMR集群,以OSS 和JindoFS作为EMR集群的后端存储。 解决的问题 客户自建Hadoop迁移到阿里云EMR集群的 技术方案; 基于IPSecVPN隧道构建安全和低成本数据 传输链路 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

Flume Flume是一种分布式,可靠且可用的服务,用于有效地收集,聚合和移动大量日 志数据。它具有基于流数据流的简单灵活的体系结构。它具有可调整的可靠性机 制以及许多故障转移和恢复机制,具有强大的功能和容错能力。它使用一个简单 的可扩展数据模型,允许在线分析应用程序。文档版本:20200330 IV 自建Hadoop数据迁移到...

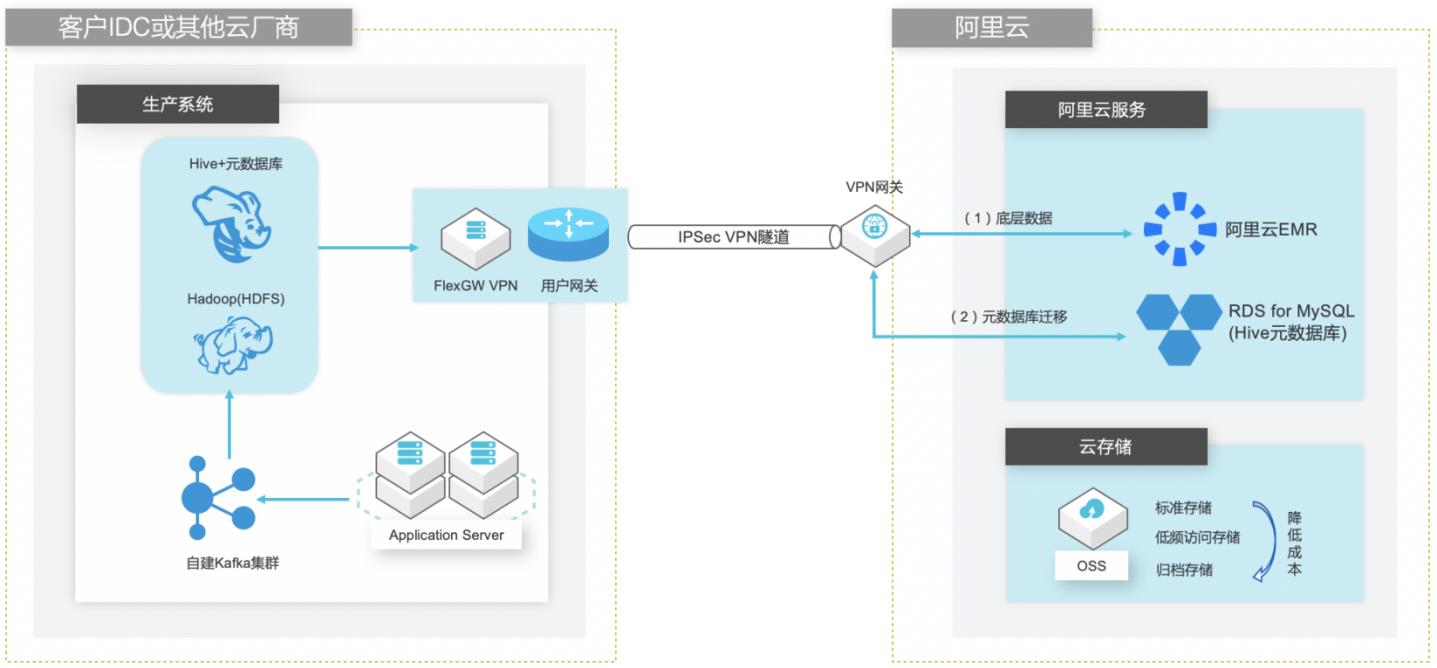

自建Hive数仓迁移到阿里云EMR

场景描述 客户在IDC或者公有云环境自建Hadoop集群构 建数据仓库和分析系统,购买阿里云EMR集群之 后,涉及到将数据仓库和Hive元数据的数据库迁 移上云。目前主流Hive数据仓库迁移场景为1.x 版本迁移到阿里云EMR(Hive2.x版本),涉及到 数据订正更新步骤。 解决的问题 Hive数据仓库的数据迁移方案 Hive元数据库的迁移方案 Hive跨版本迁移后的数据订正 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

基础环境搭建 本实践方案中,将按照技术架构图搭建相对完整的实践环境,包括 Apache日志发生 器、Kafka队列、Hadoop集群、Hive+MySQL元数据库。1.1.使用云速搭 CADT快速创建资源 步骤1 登录云速搭 CADT控制台。(https://bpstudio.console.aliyun.com/#/bpStudio/topo)按照以下架构图拖拽资源,并命名 文档版本:20210721 ...

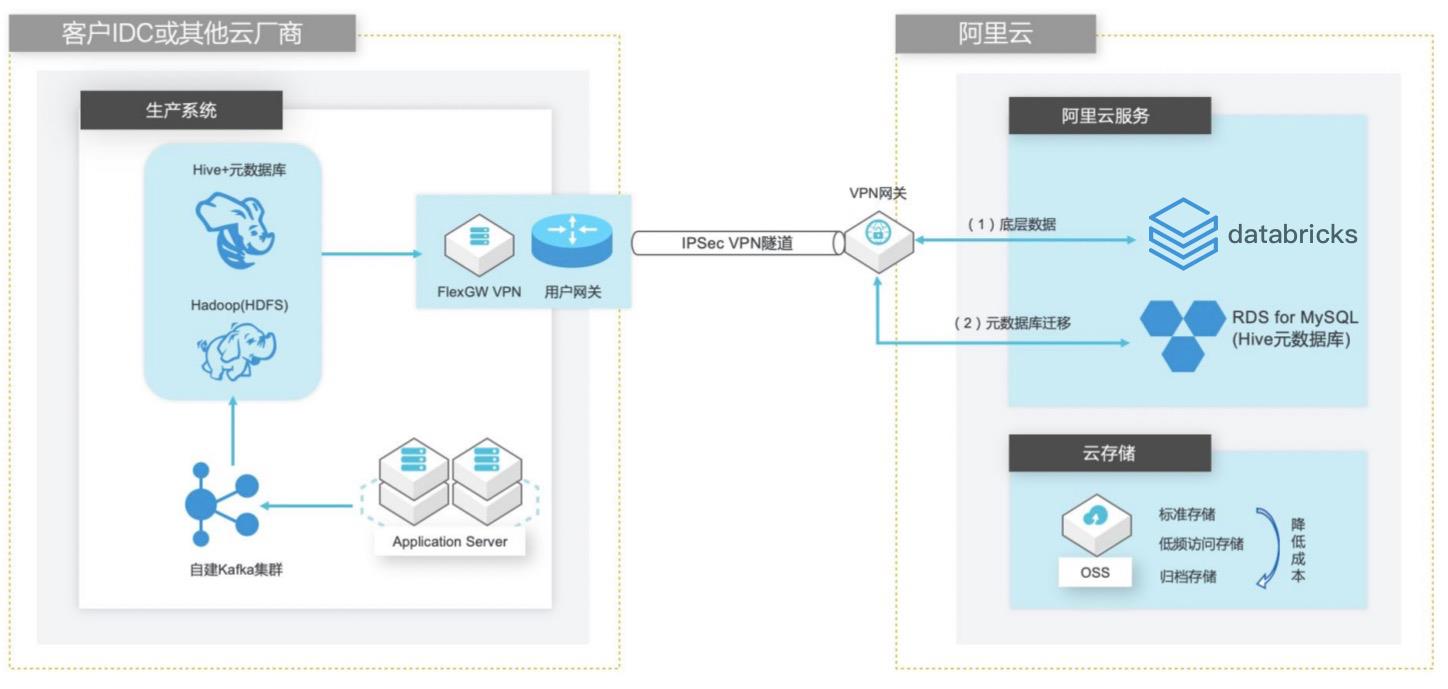

自建Hive数据仓库跨版本迁移到阿里云Databricks数据洞察

场景描述 客户在IDC或者公有云环境自建Hadoop集群构建数据仓库和分析系统,购买阿里云Databricks数据洞察集群之后,涉及到数仓数据和元数据的迁移以及Hive版本的订正更新。 方案优势 1. 全托管Spark集群免运维,节省人力成本。 2. Databricks数据洞察与阿里云其他产品(OSS、RDS、MaxCompute、EMR)进行深度整合,支持以这些产品为数据源的输入和输出。 3. 使用Databricks Runtime商业版引擎相比开源Spark性能有3-5倍的提升。 解决问题 1. Hive数仓数据迁移OSS方案。 2. Hive元数据库迁移阿里云RDS方案。 3. Hive跨版本迁移到Databricks数据洞察使用Delta表查询以提高查询效率。

步骤4 Apache日志生成器产生的日志如下所示,共有 9个字段:58.60.168.164-[07/Jan/2016:09:09:43+0800]"GET/HTTP/1.1" 200 11250 "-" "Mozilla/5.0(WindowsNT6.1;Win64;x64)AppleWebKit/537.36(KHTML,likeGecko)Chrome/47.0.2526.106Safari/537.36"在 Hive命令行界面输入如下 HQL命令,创建分区表,表名为 apache_logs:...

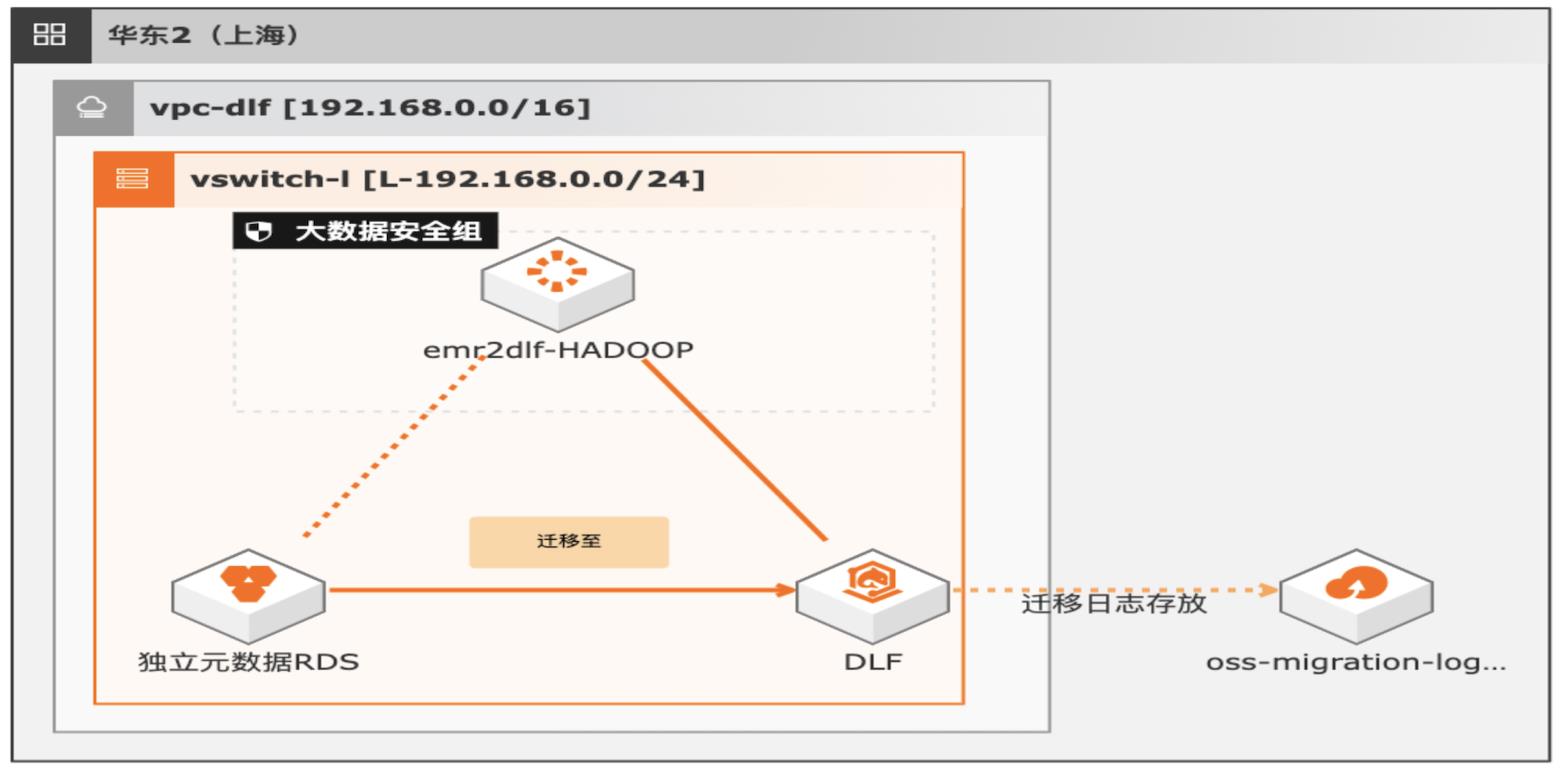

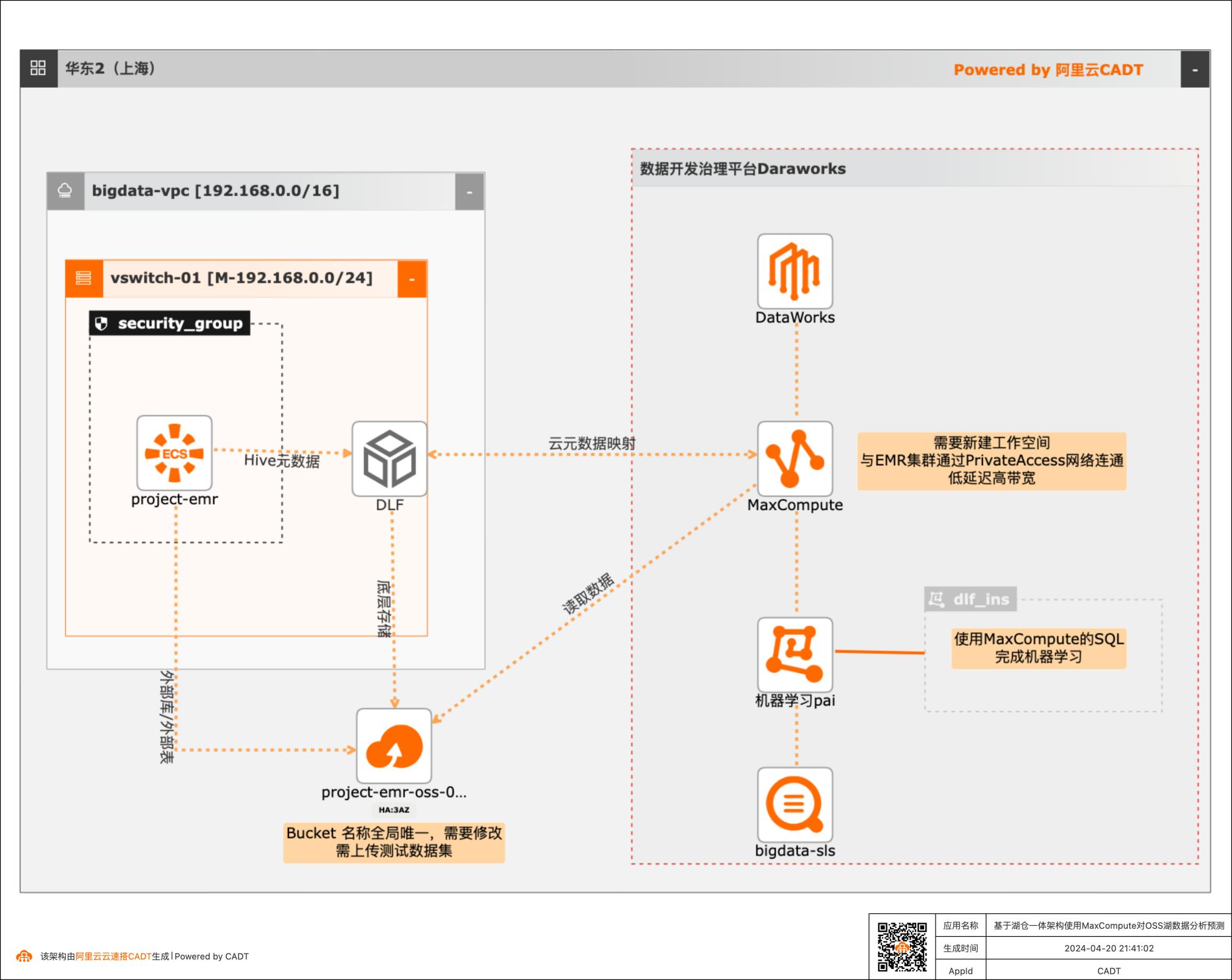

湖仓一体架构EMR元数据迁移DLF

通过EMR+DLF数据湖方案,可以为企业提供数据湖内的统一的元数据管理,统一的权限管理,支持多源数据入湖以及一站式数据探索的能力。本方案支持已有EMR集群元数据库使用RDS或内置MySQL数据库迁移DLF,通过统一的元数据管理,多种数据源入湖,搭建高效的数据湖解决方案。

https://testbp-106.oss-cn-shanghai.aliyuncs.com/236/Democode/democode.txt 1.2. 上传测试数据 说明:本方案以一个 apache日志文件作为原始数据,构建 HDFS存储和 Hive数据。下载地址:https://testbp-106.oss-cn-shanghai.aliyuncs.com/236/Democode/apache_logs.log步骤1 使用 scp命令拷贝测试数据到 EMR集群。scp ...

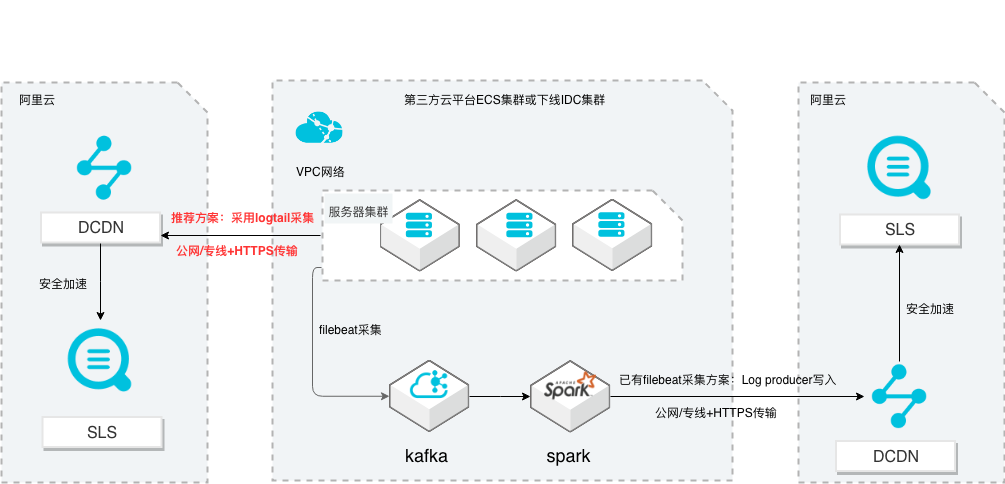

SLS多云日志采集、处理及分析

场景描述 从第三方云平台或线下IDC服务器上采集 日志写入到阿里云日志服务,通过日志服务 进行数据分析,帮助提升运维、运营效率, 建立DT 时代海量日志处理能力。 针对未使用其他日志采集服务的用户,推荐 在他云或线下服务器安装logtail采集并使用 Https安全传输;针对已使用其他日志采集 工具并且已有日志服务需要继续服务的情 况,可以通过Log producer SDK写入日志 服务。 解决问题 1.第三方云平台或线下IDC客户需要使用 阿里云日志服务生态的用户。 2.第三方云平台或线下IDC服务器已有完 整日志采集、处理及分析的用户。 产品列表 E-MapReduce 专有网络VPC 云服务器ECS 日志服务LOG DCDN

按照 2.5节的方式分别在日志机器组的两台 ECS实例开启日志发生器,等待数分钟 后停止 文档版本:20211203 76 SLS多云日志采集、处理及分析 日志服务器集群公网日志数据传递到日志服务 步骤15 查看日志库日志 回到日志服务控制台,选择创建的日志库 test20191009,可以看到日志机器组的日 志已经传递到日志服务:文档版本:...

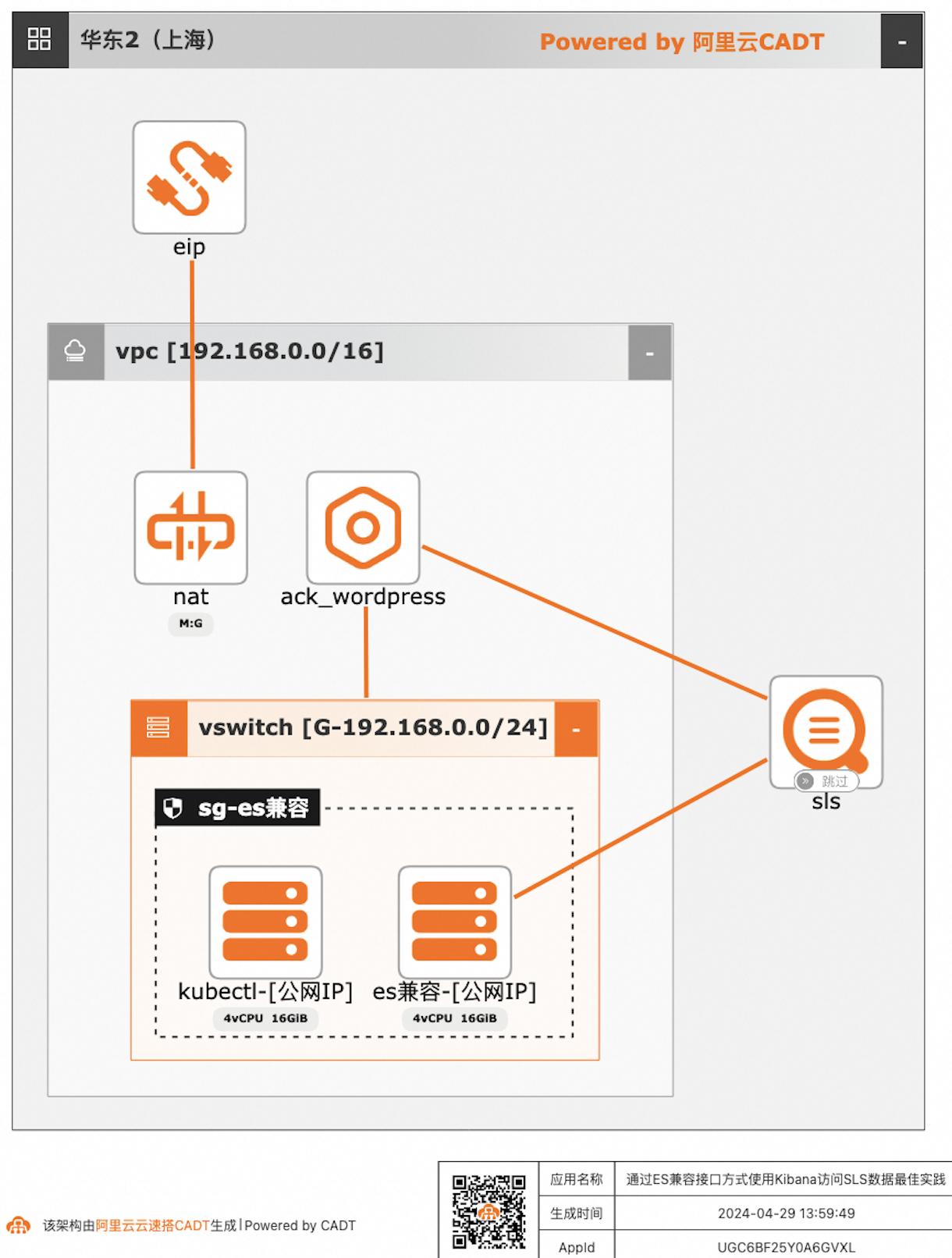

通过ES兼容接口方式使用Kibana访问SLS数据

自建ELK日志系统的客户迁移到阿里云日志服务SLS后,对SLS查询分析语法不太熟悉的客户,可以继续沿用原有的查询分析习惯,在不改变使用方式习惯的情况下,通过Elasticsearch兼容接口的方式使用Kibana访问SLS。

bin/bash ls/opt/bitnami/apache/logs 可以看到Wordpress应用的访问日志access_log和错误日志error_log 步骤3 查看日志文件大小 ls-lh/opt/bitnami/apache/logs/access_log 根据上述返回结果可以看到,access_log是一个指向/dev/stdout的符号链接(symboliclink),而不是一个常规的文件,这表明Wordpress访问日志重定向到...

云速搭部署SLS实现日志采集处理分析

通过云速搭部署ECS+SLS,在ECS上安装logtail收集Nginx应用日志写入SLS。通过日志生成器模拟Nginx日志生成,并通过SLS进行日志分析。

文档版本:20211203 30 云速搭部署 SLS实现日志采集处理分析 Logtail日志采集处理分析 注意:查询分析设置的修改操作只会对新写入的数据生效,如果您需要提前对查询分 析设置的某些字段分析统计生效,请使用指定字段查询的自定义方式在日志写入到日 志库之前进行开启统计查询。步骤4 再次启动日志发生器和停止日志发生器。...

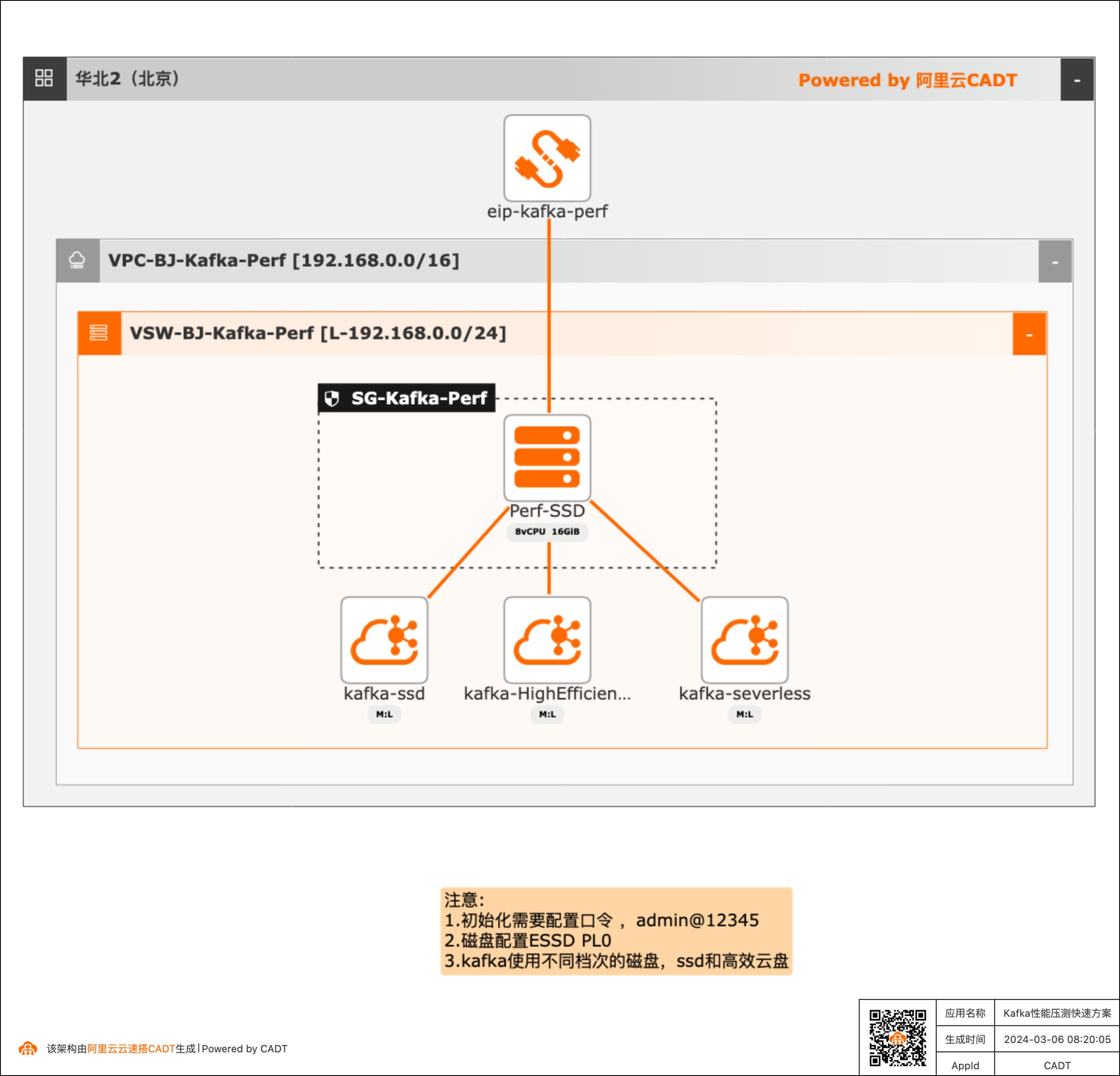

Kafka性能压测快速方案

产品性能基线测试场景需要对产品进行性能测试得到详细的压测数据,本方案可以快速构建测试的客户端(kafka官方的压测客户端)和不同的Kafka服务端( SSD云盘版、高效云盘、Serverless版三种实例),方便客户进行POC完成性能验证。

mkdir/root/kafka-perf 文档版本:20240229 4Kafka性能压测快速方案 部署基础环境#sleep10s sleep10#生成本地执行文件 cat>/root/kafka-perf/install_env.sh/root/kafka-perf/kafka-perf.sh/root/kafka-perf/kafka-perf.log2>&1&可用 tail-f/root/kafka-perf/kafka-perf.log查看系统启动部署kafka压测软件日志。echo"压测...

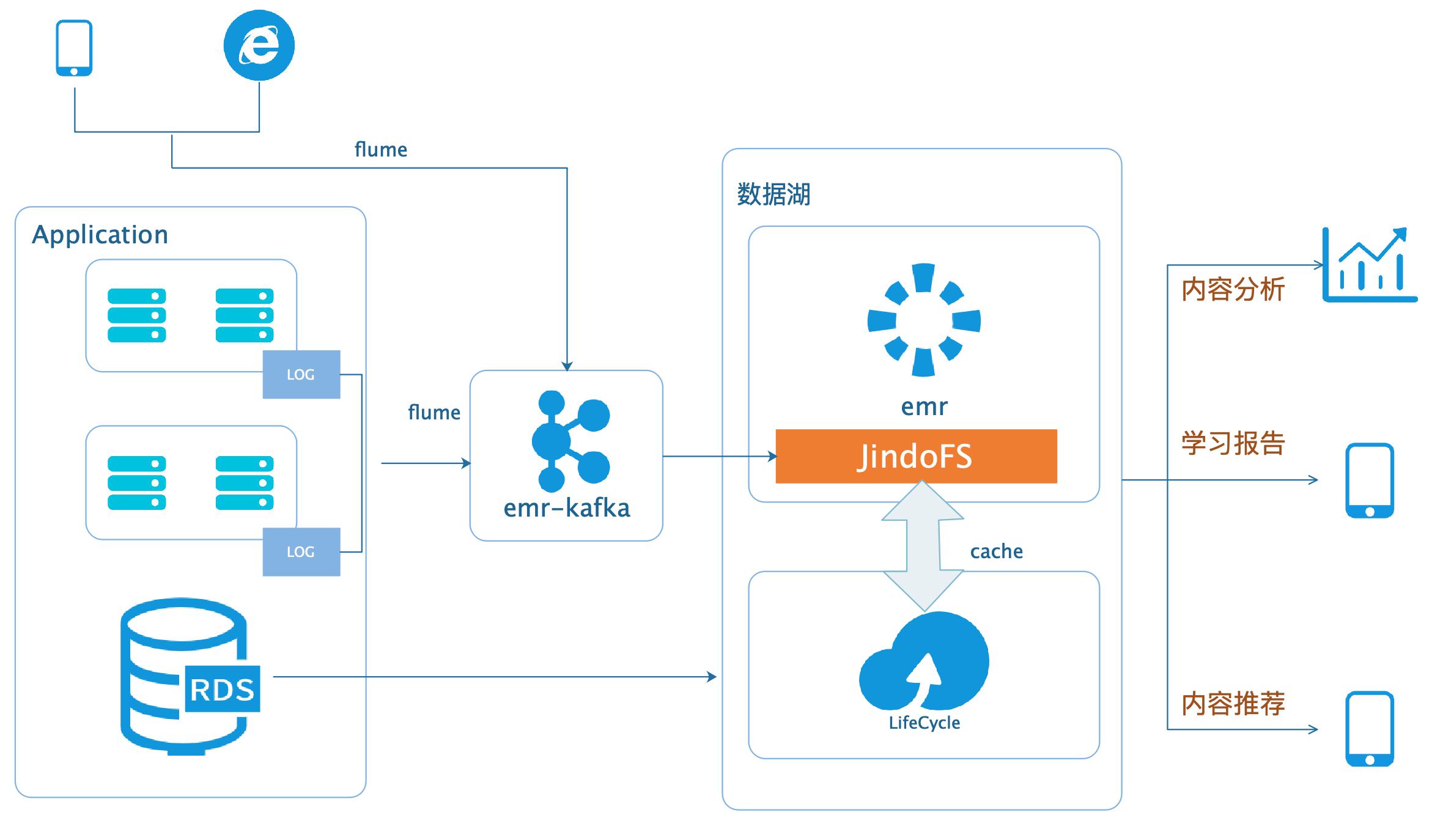

数据湖-在线学习场景数据分析

场景描述 本场景以在线教育中一个答题闯关类的应用为 例,使用WebServer来模拟演示这类日志数据 的分析处理。通过Nginx和Pythonflask搭建 WebServer,模拟应用中的关键页面,比如登 录、课程内容等,之后构造若干用户使用的模拟 日志数据,投递到数据湖进行分析后获取应用 PV、UV、课程内容访问排行、平均得分等等。 解决问题 基于数据湖(EMR+OSS)搭建大数据平台。 EMR和OSS使用和配置。 数据统一存储到OSS。 产品列表 E-MapReduce 对象存储OSS 云服务器ECS 访问控制RAM 专有网络VPC

本场景以在线教育中一个答题闯关类的应用为例,使用WebServer来模拟演示这类日 志数据的分析处理。通过Nginx和Pythonflask搭建WebServer,模拟应用中的关键 页面,比如登录、课程内容等,之后构造若干用户使用的模拟日志数据,投递到数据 湖进行分析后获取应用PV、UV、课程内容访问排行、平均得分等等。文档版本:20200331 ...

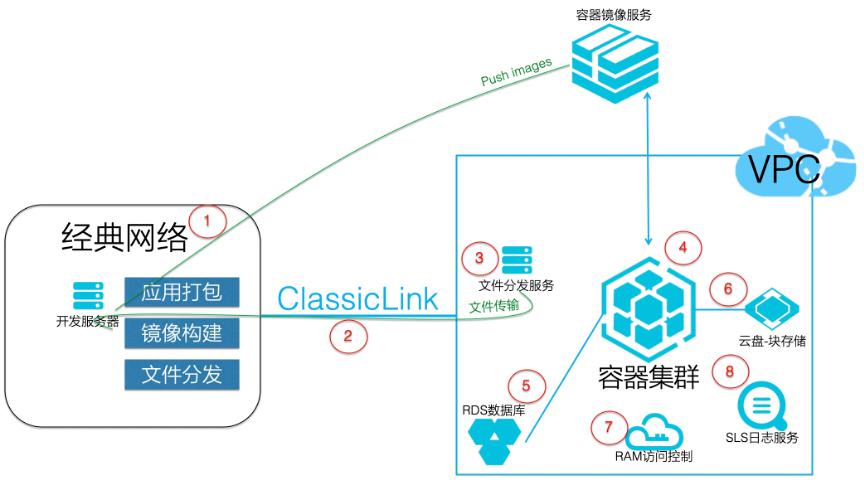

金融行业从经典网络向VPC容器化改造

本实践介绍经典网络向VPC容器化改造实践 以及配置步骤,可适用于金融等行业 方案优势 容器化完成经典网络完成向VPC网络改 造 应用发布灵活 运维效率提升 解决问题 1.经典网络管理困难 2.应用发布不灵活 3.运维效率低 产品列表 专有网络VPC 容器服务Kubernetes版 日志服务SLS 云数据库RDS版 NAT网关 容器镜像服务ACR 云盘

运维效率低 产品列表 专有网络VPC 容器服务Kubernetes版 日志服务SLS 云数据库RDS版 NAT网关 容器镜像服务ACR 云盘 产品版本:V1.0(软件版本)云服务器ECS(产品名称)文档模板(手册名称)/文档版本信息 文档版本:20190516(发布日期)阿里云 金融行业从经典网络向 VPC容器化改造 最佳实践 文档...

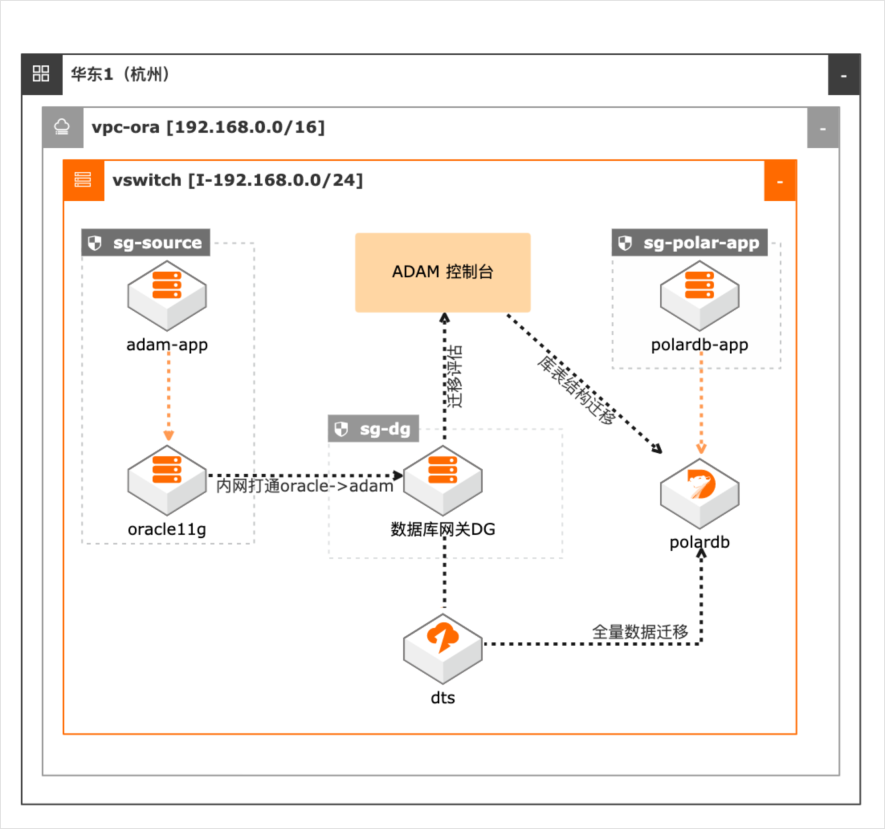

Oracle数据库与应用迁移PolarDB

场景描述 本最佳实践适用于Oracle数据库及应用迁 移到阿里云PolarDB数据库(Oracle兼容 版)。通过ADAM将Oracle数据库迁移到 PolarDB数据库,可以降低应用升级、运 维成本,同时提升系统弹性,实现数据库 及应用全栈上云。 解决问题 1.解决Oracle及其应用迁移上阿里云, 通过ADAM评估迁移工具,降低迁移 风险,提高迁移效率。 2.使用PolarDB(Oracle兼容版)数据 库,提升数据库并发读能力,降低运维 成本。 产品列表 数据库和应用迁移(ADAM) PolarDB(Oracle兼容版) 云服务器(ECS) 专有网络(VPC)

cd/root yum install-y java java-devel wget-no-check-certificate https://dlcdn.apache.org/maven/maven- 3/3.8.4/binaries/apache-maven-3.8.4-bin.tar.gz tar -xvfapache-maven-3.8.4-bin.tar.gz cat > /etc/profile export MAVEN_HOME=/root/apache-maven-3.8.4 export PATH=/root/apache-maven-3.8.4/bin:${PATH} EOF source/...

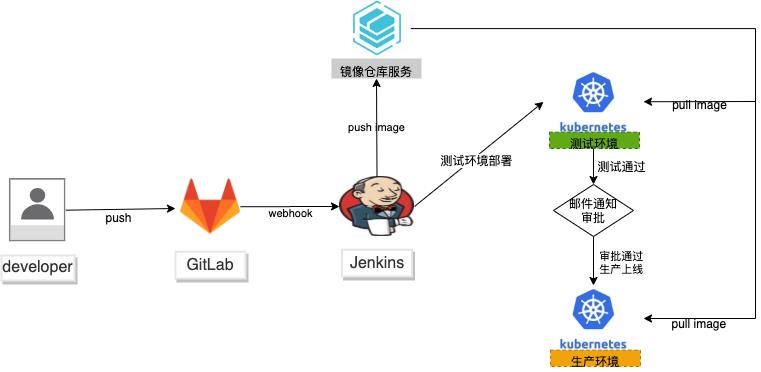

基于k8s多集群隔离环境下的devops实现

场景描述 DevOps是一组过程、方法与系统 的统称,并通过工具实现自动化部署, 确保部署任务的可重复性、减少部署出 错的可能性。随着微服务、中台架构的 兴起,devops重要性日益显著。 本方案使用两个独立的k8s集群: 用户已有的k8s模拟测试,ack集群模 拟生产环境,保证环境的高度隔离,互 不影响。通过gitlab+Jenkins的黄金组 合,实现容器应用的自动化构建和持续 部署,提高迭代效率。 解决问题 1.微服务应用的CI/CD。 2.测试和生产环境的高度隔离。 3.自动化的测试与部署。 4.现有CI对接ACK。 产品列表 专有网络VPC 容器服务ACK 容器镜像服务ACR 弹性公网IP 负载均衡SLB

随着 微服务、中台架构的兴起,devops重要性日 益显著。本方案使用两个独立的 k8s集群:用户已 有的 k8s模拟测试,ack集群模拟生产环境,保证环境的高度隔离,互不影响。通过 gitlab+Jenkins的黄金组合,实现容器应用的 自动化构建和持续部署,提高迭代效率。解决问题 产品列表 1.微服务应用的 CI/CD。专有网络 VPC 2.测试...

基于湖仓一体架构使用MaxCompute对OSS湖数据分析预测

本篇最佳实践先创建EMR集群作为数据湖对象,Hive元数据存储在DLF,外表数据存储在OSS。然后使用阿里云数据仓库MaxCompute以创建外部项目的方式与存储在DLF的元数据库映射打通,实现元数据统一。最后通过一个毒蘑菇的训练和预测demo,演示云数仓MaxCompute如何对于存储在EMR数据湖的数据进行加工处理以达到业务预期。

2.file_format,用于指定storeas所使用FileFormat,如orc、textfile等,设置后忽 略input_format,output_format 3.input_format,用于指定文件存储时所使用的InputFormat对应的类名,如 org.apache.hadoop.mapred.TextInputFormat 4.output_format,用于指定文件存储时所使用的OutputFormat对应的类名,如 org.apache....

大数据系统基准性能测试最佳实践

本方案适用于在阿里云上进行大数据基准性能测试的场景,包括 Teragen和Terasort测试,TestDFSIO测试。本文采用CADT工具结合阿里云的E-MapReduce服务快速构建测试集群,并提供了Teragen和Terasort测试,TestDFSIO测试的测试脚本,便于迅速开展测试。

EMR构建于云服务器 ECS上,基于开源的 Apache Hadoop和 Apache Spark,让您可以方便地使用 Hadoop和 Spark生态系统中的其他周边系统分析和 处理数据。EMR还可以与阿里云其他的云数据存储系统和数据库系统(例如,阿 里云 OSS和 RDS等)进行数据传输。EMR的 SmartData组件是 EMR Jindo引 擎的主要存储部分,为 EMR各个计算...

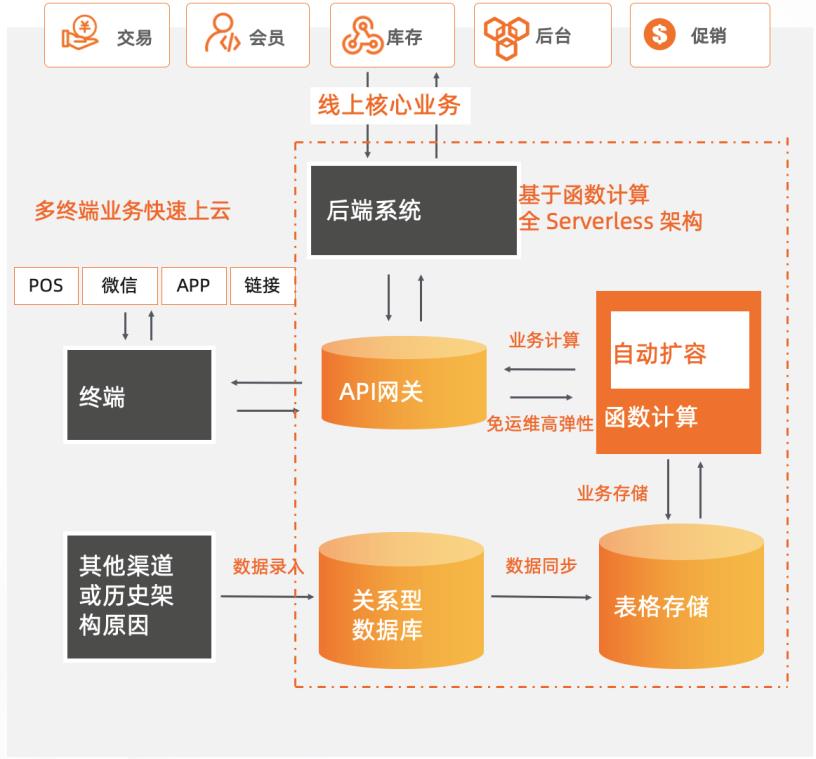

新零售商超基于Serverless服务化改造

某零售商超行业龙头企业,主要业务涵盖购物中心、大卖场、综合超市、标准超市、精品超市、便利店、无人值守智慧商店等零售业态,涉及全渠道零售、仓储物流、餐饮、消费服务、数据服务、金融业务、跨境贸易等领域。为了持续支持业务高速且稳定地发展,其在快速上云后,将核心业务改造为全Serverless架构的中台模式,采用函数计算 + API网关 + 表格存储OTS 作为计算网络存储核心,弹性支撑日常和大促峰谷所需资源,轻松支撑618/双11/双12大促。 核心价值 l 全 Serverless 架构:FC + API 网关 + OTS Serverless 解决方案。 l 弹性高可用:毫秒级弹性扩容、充足的资源池水位、跨可用区高可用。 l 敏捷开发免运维:函数式极简编程可专注于业务创新,无采购和部署成本、提供监控报警等完备的可观测能力。

安装 1.8或以上版本 JDK,请参考:https://www.oracle.com/java/technologies/javase-downloads.html 安装 2.5或以上版本 Maven,请参考:https://maven.apache.org/download.cgi安装 2.3或以上版本 Docker,请参考:https://www.docker.com/get-started 文档版本:20210519 2 新零售商超基于 Serverless服务化改造 前置条件...

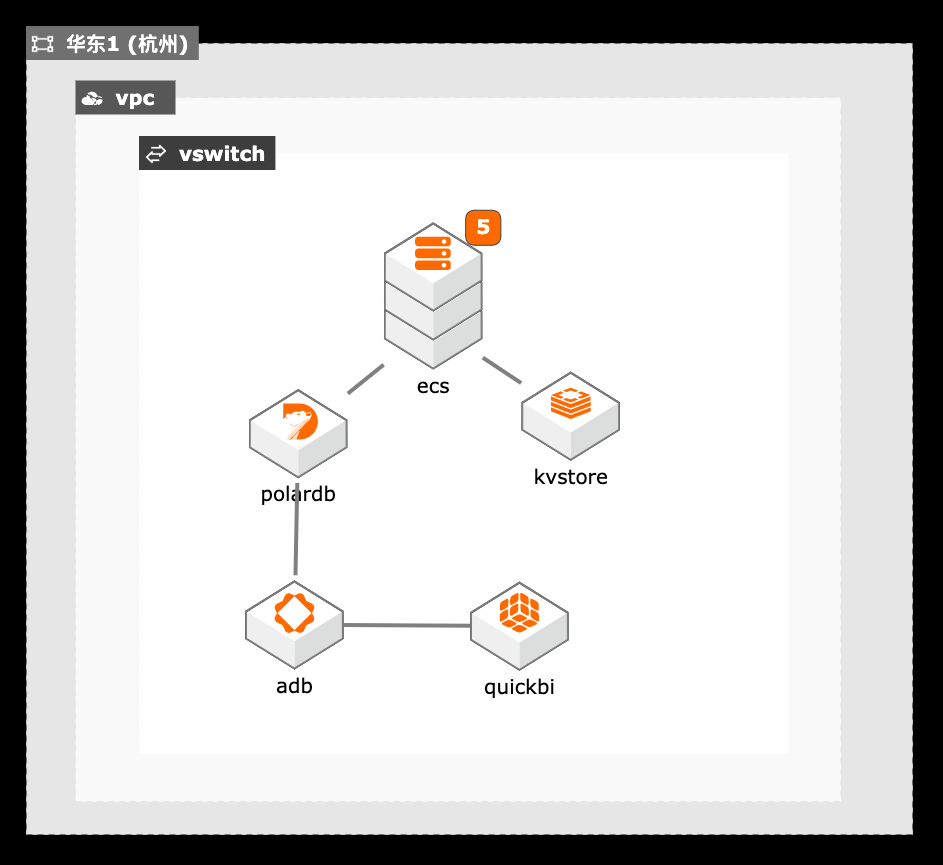

在线教育流量洪峰

1. 通过Tair缓存的性能增强型解决高并发读的性能问题,通过持久内存型解决大并发写性能及数据可靠性问题。 2. PolarDB作为主数据库保存业务的交易数据,通过弹性能力和并发SQL解决性能瓶颈。 3. ADB+QuickBI提供的数据仓库方案通过分时弹性能力和实时业务展现能力。

wget https://mirrors.bfsu.edu.cn/apache/maven/maven-3/3.6.3/binaries/apache-maven- 3.6.3-bin.tar.gz tar xzfapache-maven-3.6.3-bin.tar.gz cd /root/apache-maven-3.6.3/conf设定环境变量 M2_HOME和 PATH:vim.bash_profile 步骤5 编译 YCSB。source.bash_profile cd YCSB mvn-pl site.ycsb:redis-binding-am clean ...

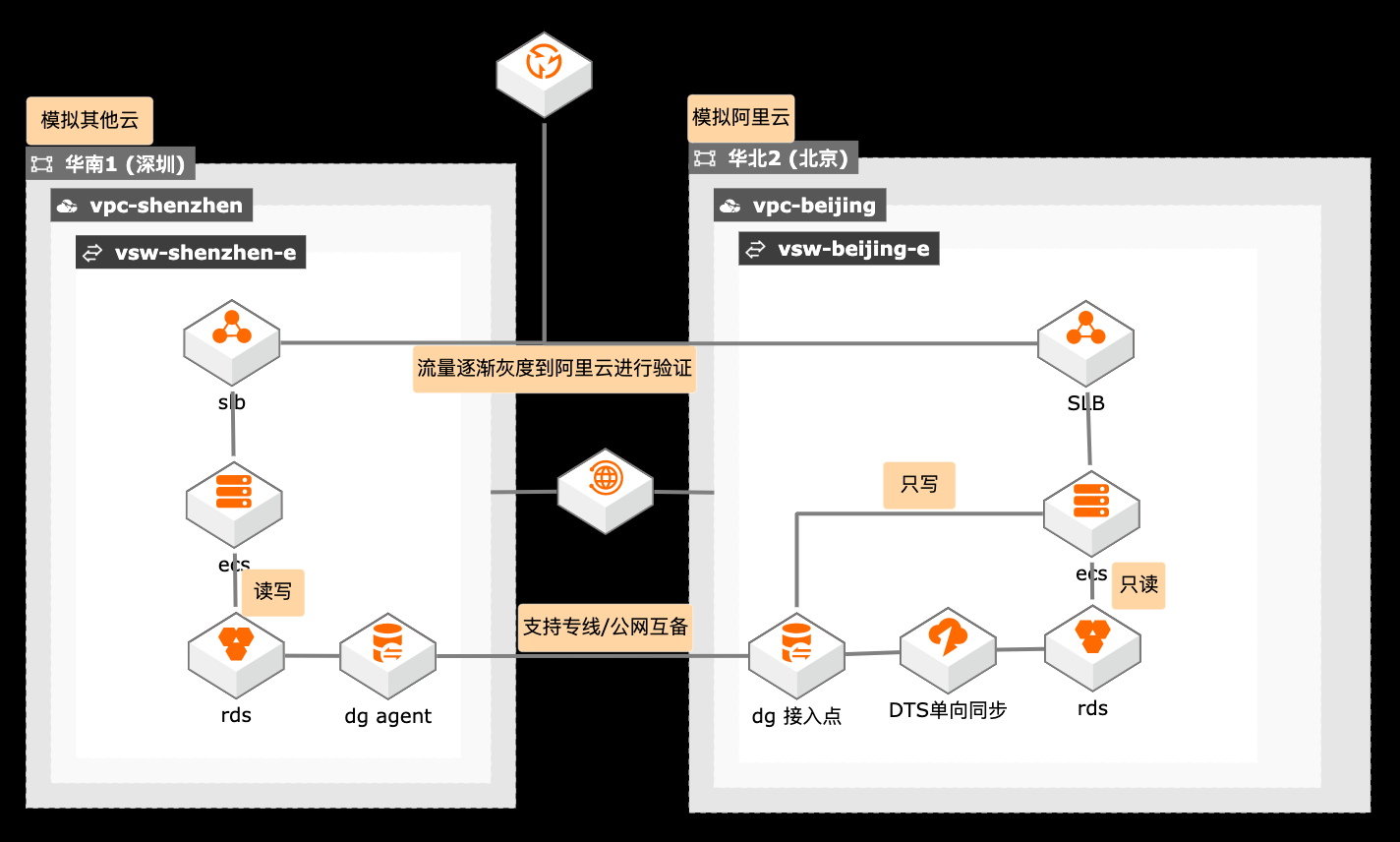

跨云迁移单写双读过渡架构

概述 在搬站场景下,涉及迁移跨度较长,在过渡阶段客户需要跨云访问,如何保障数据链路的高可用尤为关键,采用专线和公网双备的方案保障数据传输的高可用,也降低双专线的迁移成本。 适用场景 数据迁移链路的高可用 跨云迁移过渡期架构 读写分类架构设计 技术架构 本实践方案基于如下图所示的技术架构和主要流程编写操作步骤: 方案优势 在迁移时间持续较长的情况下,使用单写双读架构降低业务改造成本。 使用数据库网关做专线和公网互备。 流量逐渐灰度验证,保障迁移平滑过渡。 安全:原生的多租户系统,以项目进行隔离,所有计算任务在安全沙箱中运行。

详见:https://www.aliyun.com/product/dg 云数据库 RDS MySQL版:MySQL 是全球最受欢迎的开源数据库之一,作为开 源软件组合 LAMP(Linux+Apache+MySQL+Perl/PHP/Python)中的重要一 环,广泛应用于各类应用场景。文档版本:20201209 III 跨云迁移单写双读过渡架构 前言 详见:https://www.aliyun.com/product/mysql 数据...

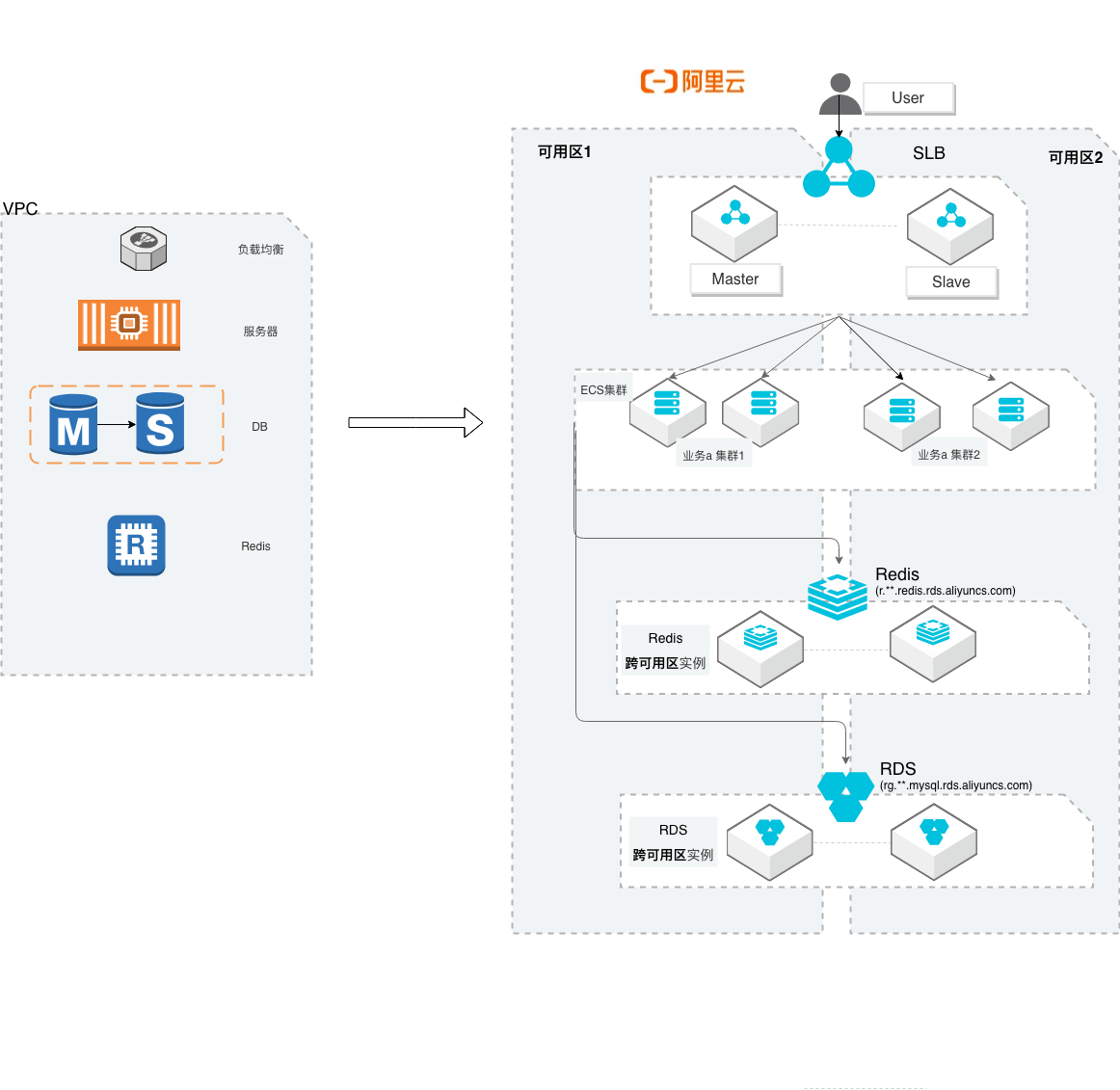

小型互联网迁移阿里云

场景描述 本方案主要适用于中小型互联网企业,从他云 迁移到阿里云的最佳实践。方案中会概述网络 规划、服务器、数据库、存储数据、Kafka和 镜像数据的迁移方案描述。同时在实践环节, 增加服务器和RDS的迁移操作演练和验证。 解决问题 提供服务器、数据库等关键环节的平滑迁移方 案 提供云上高可用架构参考 提供模拟简单的演练回归流程机制 产品列表 云服务器(ECS)、迁云工具(SMC)、数据库 (RDS)、数据库(Redis)、数据传输(DTS)、 负载均衡(SLB)、专有络(VPC)等

如果 binlog没有打开,那么需要修改源数 据库配置文件中的 log_bin,开启二进制日志 log_bin=mysql_bin。配置完成后重启源 数据库,参考 MySQL,重新进行预检查。访问数据库:mysql-h-P 3306-u admin-p 输入密码:show global variables like"log_bin;文档日期:20200114 30 小型互联网迁移上阿里云最佳实践 数据迁移准备 ...

- 产品推荐

- 这些文档可能帮助您