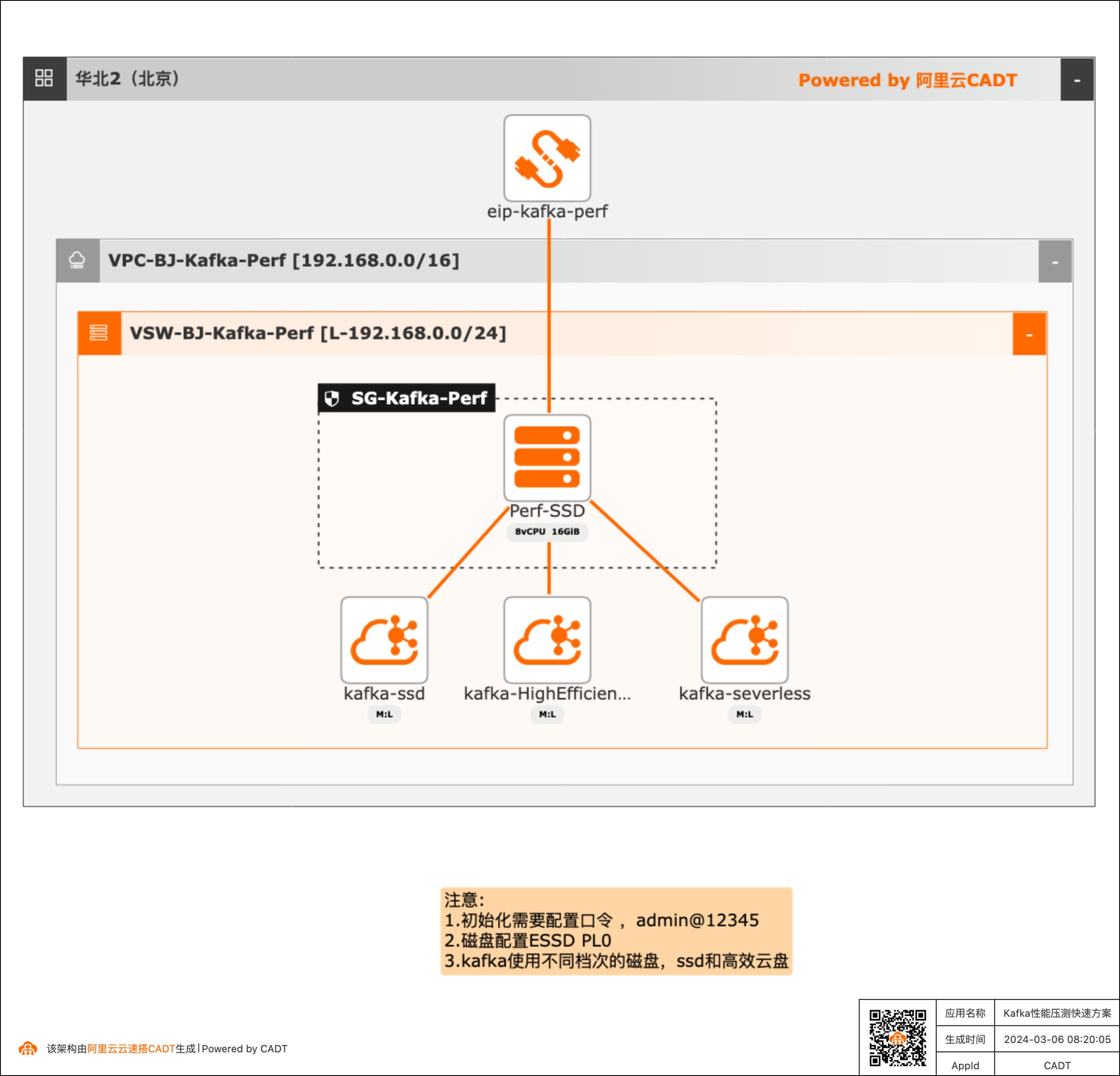

Kafka性能压测快速方案

产品性能基线测试场景需要对产品进行性能测试得到详细的压测数据,本方案可以快速构建测试的客户端(kafka官方的压测客户端)和不同的Kafka服务端( SSD云盘版、高效云盘、Serverless版三种实例),方便客户进行POC完成性能验证。

echo"压测kafka-ssd-生产-开始*"/root/kafka-perf/apache/kafka_2.11-2.0.0/bin/kafka-producer-perf-test.sh-topic test_kafka_perf1-num-records 10000000-record-size 687-producer-props bootstrap.servers=\$KAFKA_ENDPOINT_SSD batch.size=10000-throughput-1 echo"压测kafka-ssd-生产完成*"echo"*"echo"*"echo"*...

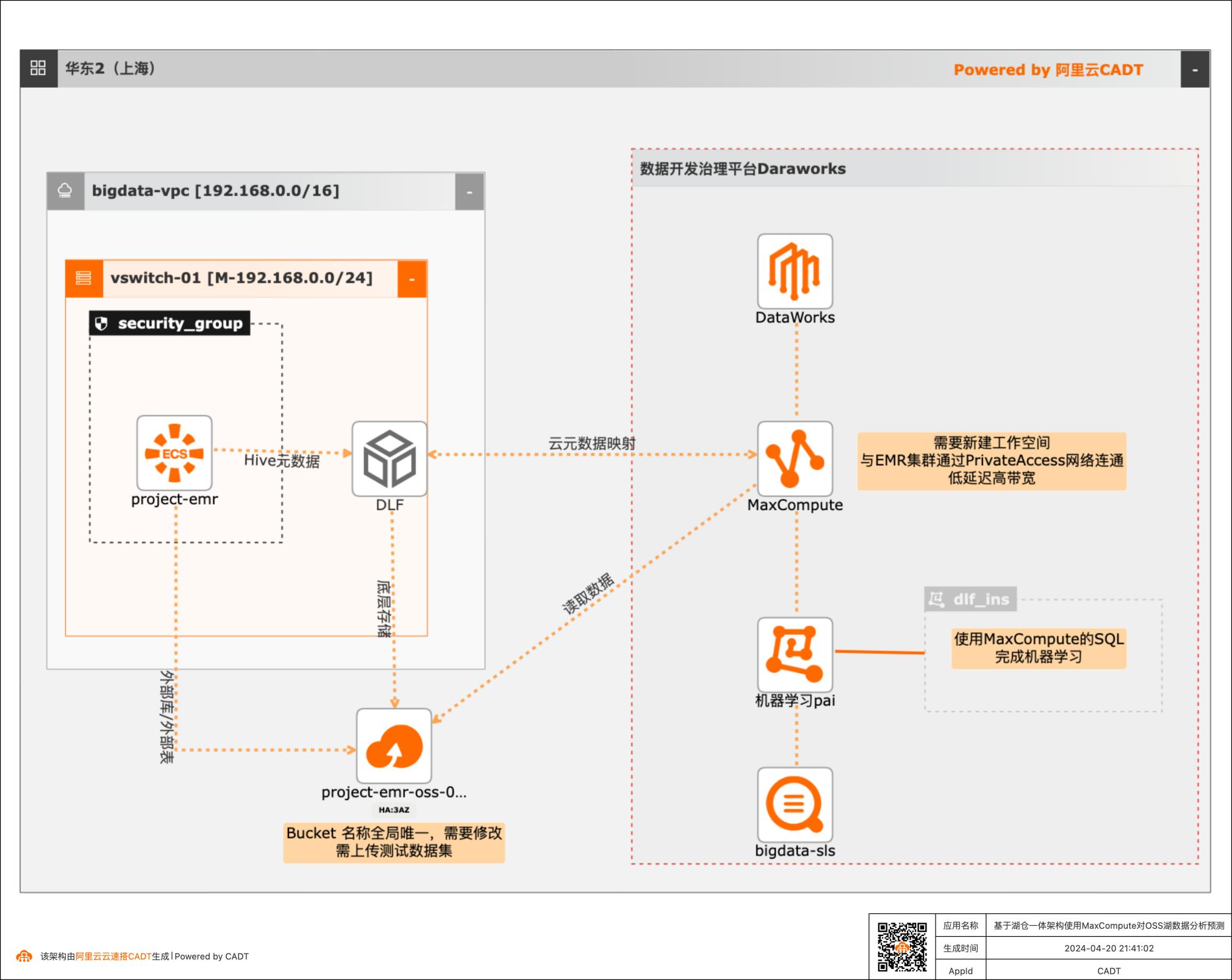

基于湖仓一体架构使用MaxCompute对OSS湖数据分析预测

本篇最佳实践先创建EMR集群作为数据湖对象,Hive元数据存储在DLF,外表数据存储在OSS。然后使用阿里云数据仓库MaxCompute以创建外部项目的方式与存储在DLF的元数据库映射打通,实现元数据统一。最后通过一个毒蘑菇的训练和预测demo,演示云数仓MaxCompute如何对于存储在EMR数据湖的数据进行加工处理以达到业务预期。

参数说明 1.endpoint:必须是DLF的跨域域名或者internal域名,具体的可提工单咨询(后 续会提供公网link参考)2.ramRoleArn:如果MaxCompute和DLF是同一账号下且已完成一键授权,则此 参数省略。本例就是省略此参数。若是跨账号授权或者自定义授权请参考附录A 3.ossEndpoint:指定与DLF同地域的OSS内网endpoint。请参考 ...

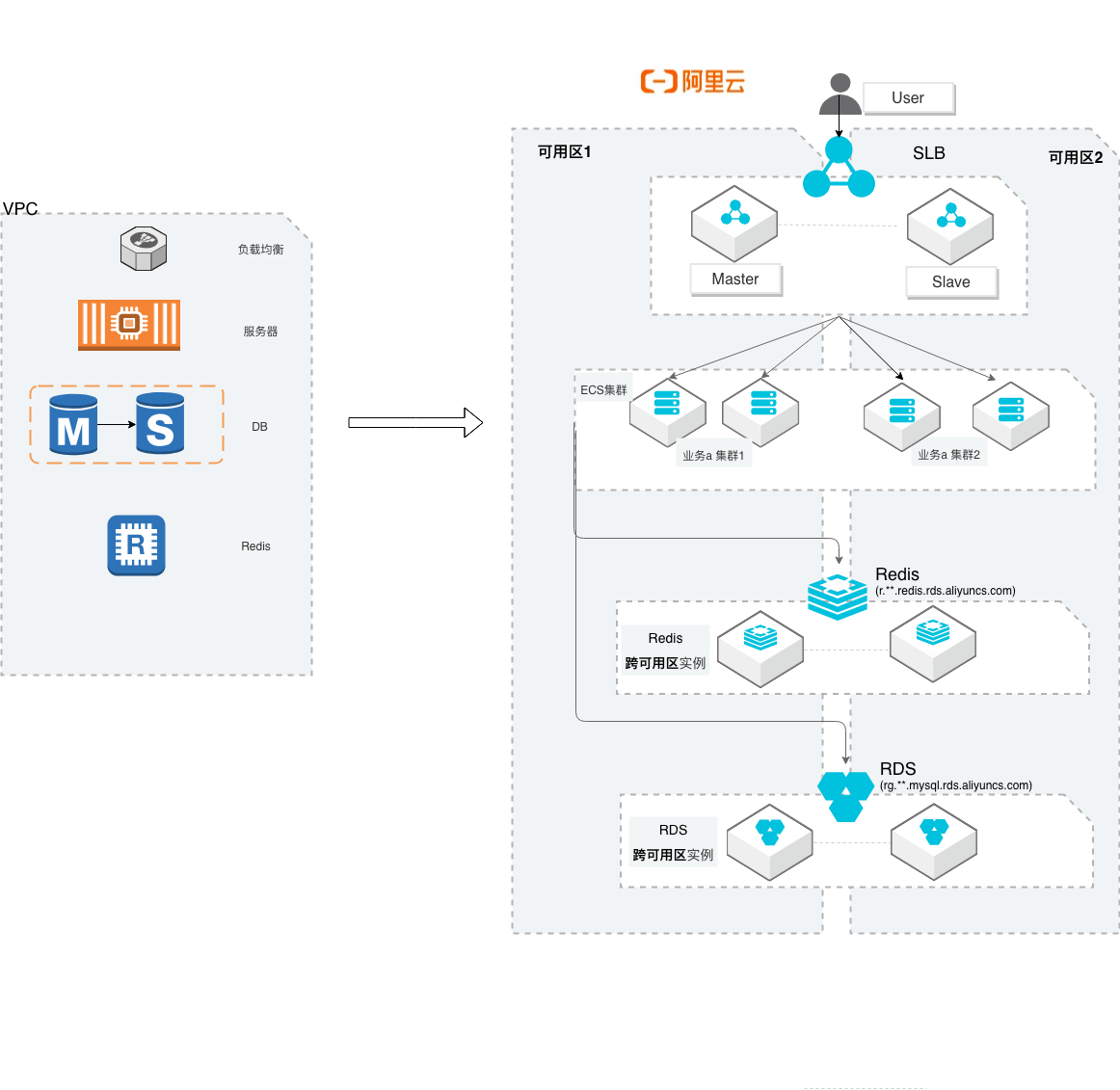

小型互联网迁移阿里云

场景描述 本方案主要适用于中小型互联网企业,从他云 迁移到阿里云的最佳实践。方案中会概述网络 规划、服务器、数据库、存储数据、Kafka和 镜像数据的迁移方案描述。同时在实践环节, 增加服务器和RDS的迁移操作演练和验证。 解决问题 提供服务器、数据库等关键环节的平滑迁移方 案 提供云上高可用架构参考 提供模拟简单的演练回归流程机制 产品列表 云服务器(ECS)、迁云工具(SMC)、数据库 (RDS)、数据库(Redis)、数据传输(DTS)、 负载均衡(SLB)、专有络(VPC)等

使用 SMC,可将您的单台或多台迁移源迁移至阿里云。迁移源(或源服务器)概 指您的待迁移 IDC服务器、虚拟机、其他云平台的云主机或其他类型的服务器。详见:https://smc.console.aliyun.com/home/sourceServers DTS:Data Transmission Service,支持关系型数据库、NoSQL、大数据(OLAP)等数据源间的数据传输。它是一种集...

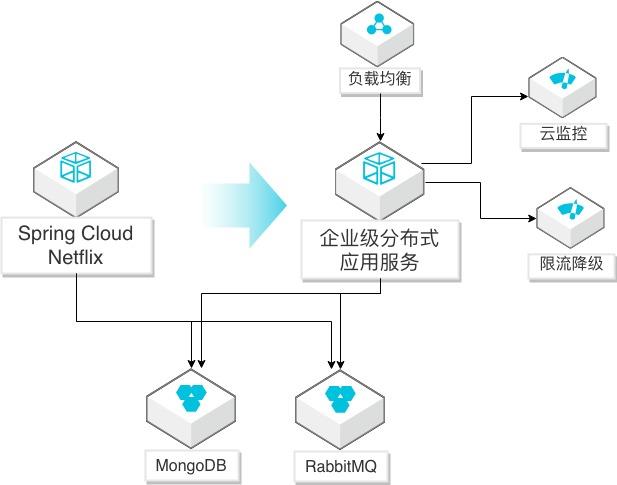

Spring Cloud Netflix应用迁移EDAS

场景描述 Spring Cloud Netflix微服务应用迁移到EDAS 服务(SpringCloud Alibaba云版本)的方法, 迁移后充分利用阿里云监控、调用链、限流降级 等能力,优化应用生命周期管理。 解决问题 1.帮助自建SpringCloudNetflix微服务应用 通过简单修改迁移到阿里云企业级分布式 应用服务(EDAS)平台。 2.迁移到EDAS后,简化应用的运维,提升监 控、调用链探测、限流降级等管理能力,提 高对应用的全生命周期管理。 产品列表 企业级分布式应用服务(EDAS) 负载均衡(SLB) 专有网络(VPC) 云服务器(ECS)

更多信息,请参 见:https://www.aliyun.com/product/slb EDAS:企业级分布式应用服务 EDAS(Enterprise Distributed Application Service)是一个应用托管和微服务管理的 PaaS平台,提供应用开发、部署、监控、运维等 全栈式解决方案,同时支持 Spring Cloud、Apache Dubbo(以下简称 Dubbo)等微服务运行环境。更多信息,...

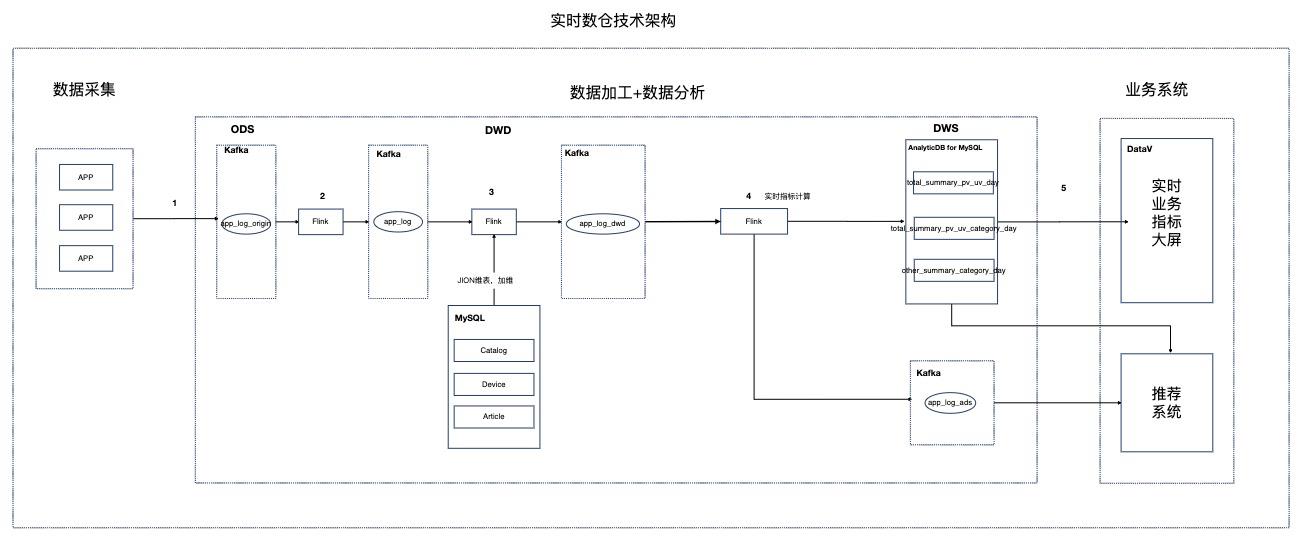

基于Flink的资讯场景实时数仓

场景描述 本实践针对资讯聚合类业务场景,Step by Step介绍 如何搭建实时数仓。 解决问题 1.如何搭建实时数仓。 2.通过实时计算Flink实现实时ETL和数据流。 3.通过实时计算Flink实现实时数据分析。 4.通过实时计算Flink实现事件触发。 产品列表 实时计算 专有网络VPC 云数据库RDSMySQL版 分析型数据库MySQL版 消息队列Kafka 对象存储OSS NAT网关 DataV数据可视化

更多信息,请参见:www.aliyun.com/product/vpc 消息队列 Kafka版:是阿里云基于 Apache Kafka 构建的高吞吐量、高可扩展性 的分布式消息队列服务,广泛用于日志收集、监控数据聚合、流式数据处理、在线 和离线分析等,是大数据生态中不可或缺的产品之一。阿里云提供全托管服务,用 户无需部署运维,更专业、更可靠、更安全...

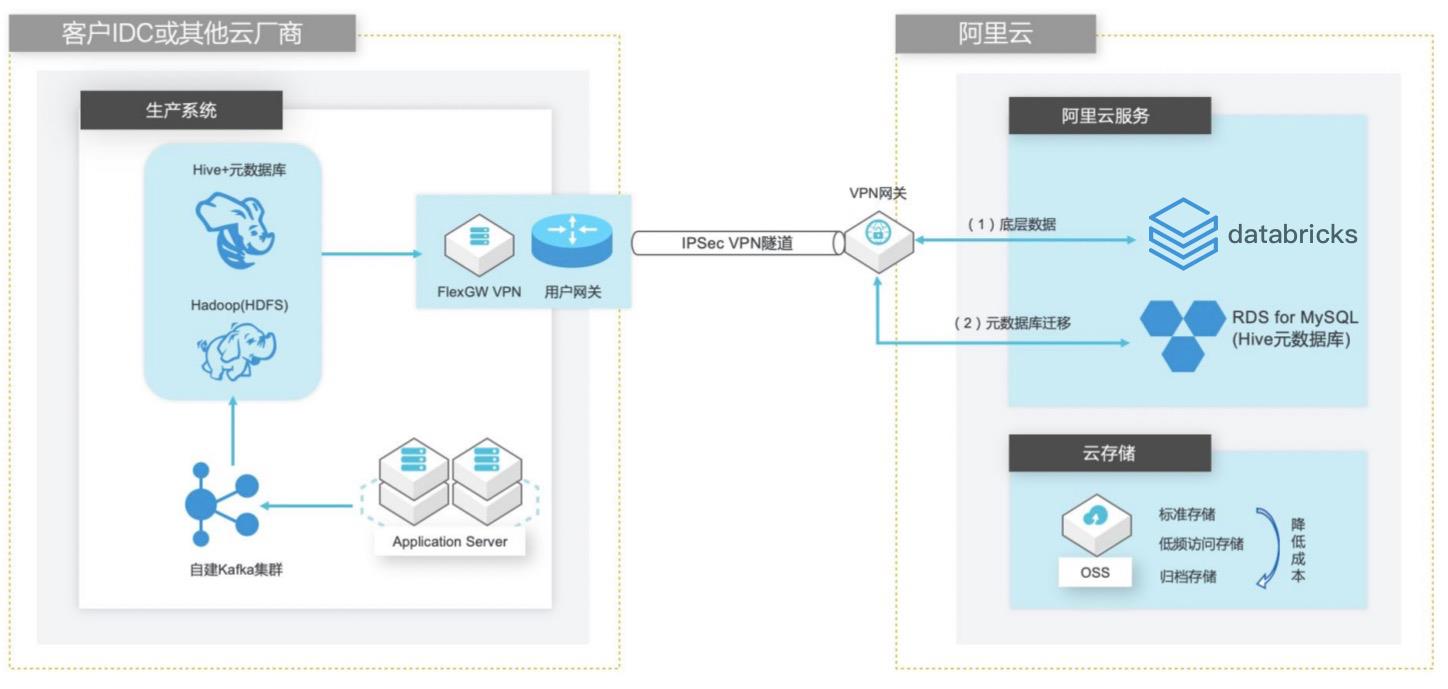

自建Hive数据仓库跨版本迁移到阿里云Databricks数据洞察

场景描述 客户在IDC或者公有云环境自建Hadoop集群构建数据仓库和分析系统,购买阿里云Databricks数据洞察集群之后,涉及到数仓数据和元数据的迁移以及Hive版本的订正更新。 方案优势 1. 全托管Spark集群免运维,节省人力成本。 2. Databricks数据洞察与阿里云其他产品(OSS、RDS、MaxCompute、EMR)进行深度整合,支持以这些产品为数据源的输入和输出。 3. 使用Databricks Runtime商业版引擎相比开源Spark性能有3-5倍的提升。 解决问题 1. Hive数仓数据迁移OSS方案。 2. Hive元数据库迁移阿里云RDS方案。 3. Hive跨版本迁移到Databricks数据洞察使用Delta表查询以提高查询效率。

cd~文档版本:20210425 13 自建 Hive数据仓库跨版本迁移到阿里云 Databricks数据洞察 基础环境搭建 wget https://mirrors.tuna.tsinghua.edu.cn/apache/hive/hive-1.2.2\ /apache-hive-1.2.2-bin.tar.gz tar -zxvfapache-hive-1.2.2-bin.tar.gz -C /usr/local/步骤2 配置环境变量。vim/etc/profile 1.在文件末尾添加如下内容,...

网络安全升级支持IPv6

场景描述 关键信息基础设施支持IPv6已经上升到国家战 略,公共云基础设施为云上客户系统支持IPv6 提供了完整的解决方案及产品。本最佳实践是在 现有WAF和高防IP作为网络安全架构基础上, 如何升级支持IPv6,同时满足云上和线下IDC 需求,满足合规要求。 解决问题 1.网络支持IPv6 2.支持V4和V6双栈 3.满足监管合规要求 产品列表 Web应用防火墙WAF DDoS高防IP DDoS防护包

文档版本:20210830 3 网络安全升级支持 IPv6 搭建 IPv4基础业务系统 步骤4 执行以下命令,进行安装部署 apache2 httpd服务,作为 webserver应用。yum install-y httpd cat/var/www/html/index.html Hostname:`hostname` EOF service httpd start 1.3. 配置 SLB 步骤1 登录 SLB控制台。...

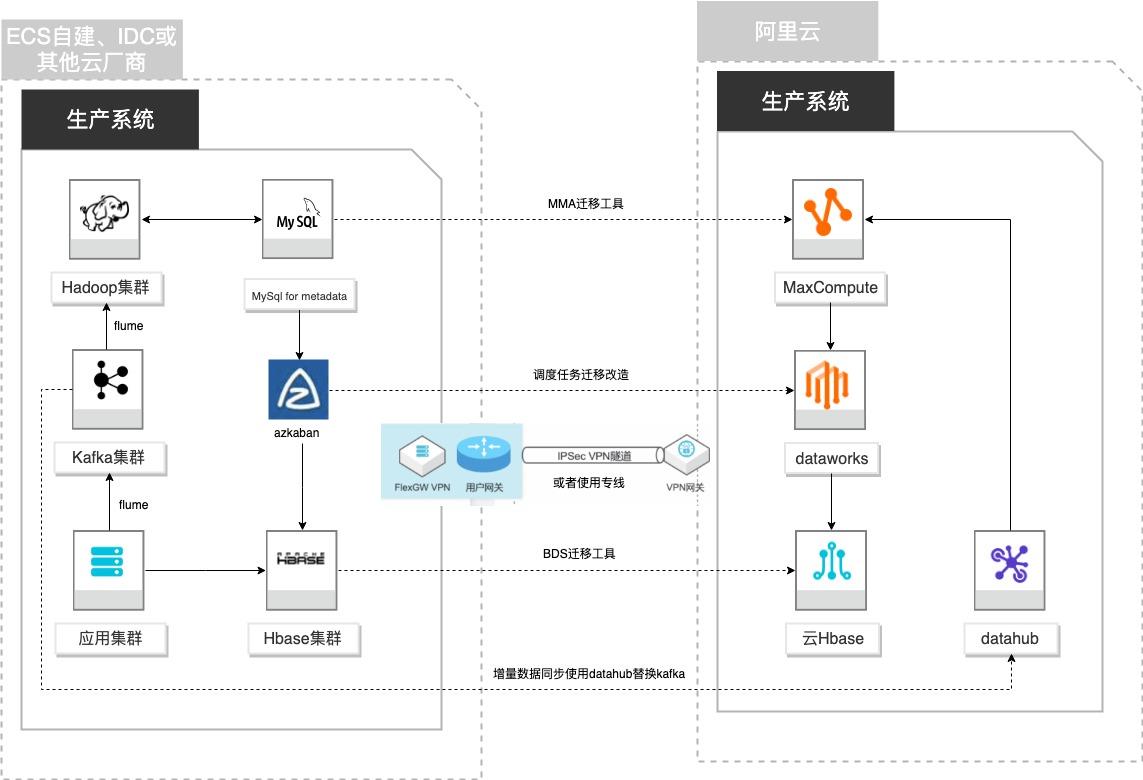

自建Hadoop迁移MaxCompute

场景描述 客户基于ECS、IDC自建或在友商云平台自建了大数 据集群,为了降低企业大数据计算平台的成本,提高 大数据应用开发效率,更有效保障数据安全,把大数 据集群的数据、作业、调度任务以及业务数据库整体 迁移到MaxCompute和其他云产品。 解决的问题 自建Hadoop集群搬迁到MaxCompute 自建Hbase集群搬迁到云Hbase 自建Kafka或应用数据准实时同步到 MaxCompute 自建Azkaban任务迁移到Dataworks任务 产品列表 MaxCompute,Dataworks、云数据库Hbase版、Datahub、VPC,ECS。

apache_logs maxcompute project:workspace20200221 maxcompute table:odps_apache_logs 通过下面命令生成 mapping文件:cd/root/odps-data-carrier vim hive_maxcompute_tables_mapping.ini 将下列内容粘贴到文件中,保存后退出:log_data_warehouse.apache_logs:workspace20200221.odps_apache_logs 如果你有多个表,请...

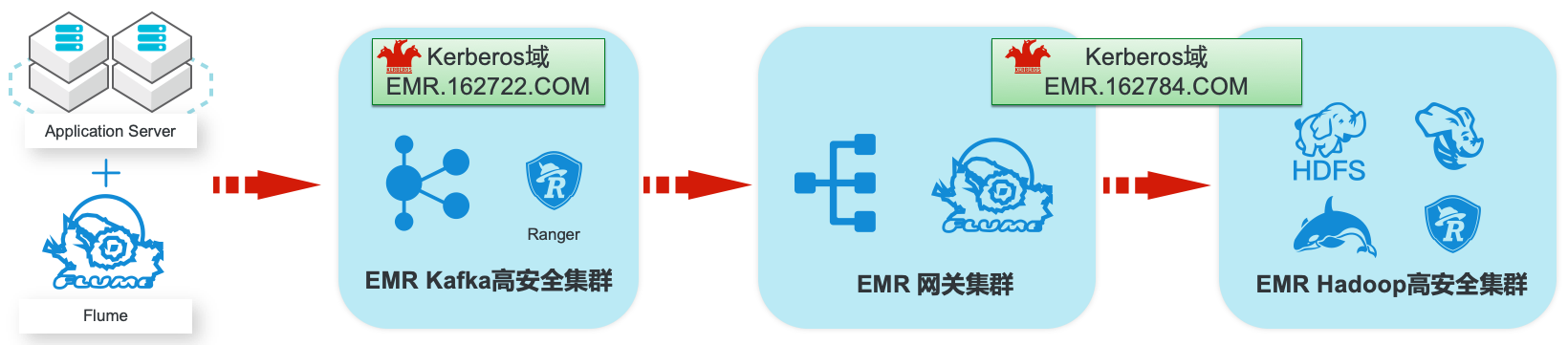

EMR集群安全认证和授权管理

场景描述 阿里云EMR服务Kafka和Hadoop安全集群使 用Kerberos进行用户安全认证,通过Apache Ranger服务进行访问授权管理。本最佳实践中以 Apache Web服务器日志为例,演示基于Kafka 和Hadoop的生态组件构建日志大数据仓库,并 介绍在整个数据流程中,如何通过Kerberos和 Ranger进行认证和授权的相关配置。 解决问题 1.创建基于Kerberos的EMR Kafka和 Hadoop集群。 2.EMR服务的Kafka和Hadoop集群中 Kerberos相关配置和使用方法。 3.Ranger中添加Kafka、HDFS、Hive和 Hbase服务和访问策略。 4.Flume中和Kafka、HDFS相关的安全配 置。 产品列表:E-MapReduce、专有网络VPC、云服务器ECS、云数据库RDS版

该关系的值是该特定主机或 域的 Kerberos 领 域 名 称。主 机 名 和 域 名 应 小 写。详见:https://web.mit.edu/kerberos/krb5-1.4/krb5-1.4.1/doc/krb5- admin/domain_realm.html [capaths]为了执行直接(非分层)跨领域身份验证,需要一个数据库来构造领域 之间的 身份 验 证路径,本节用于定 义该 数 据库。详见:...

大数据workshop

大数据workshop

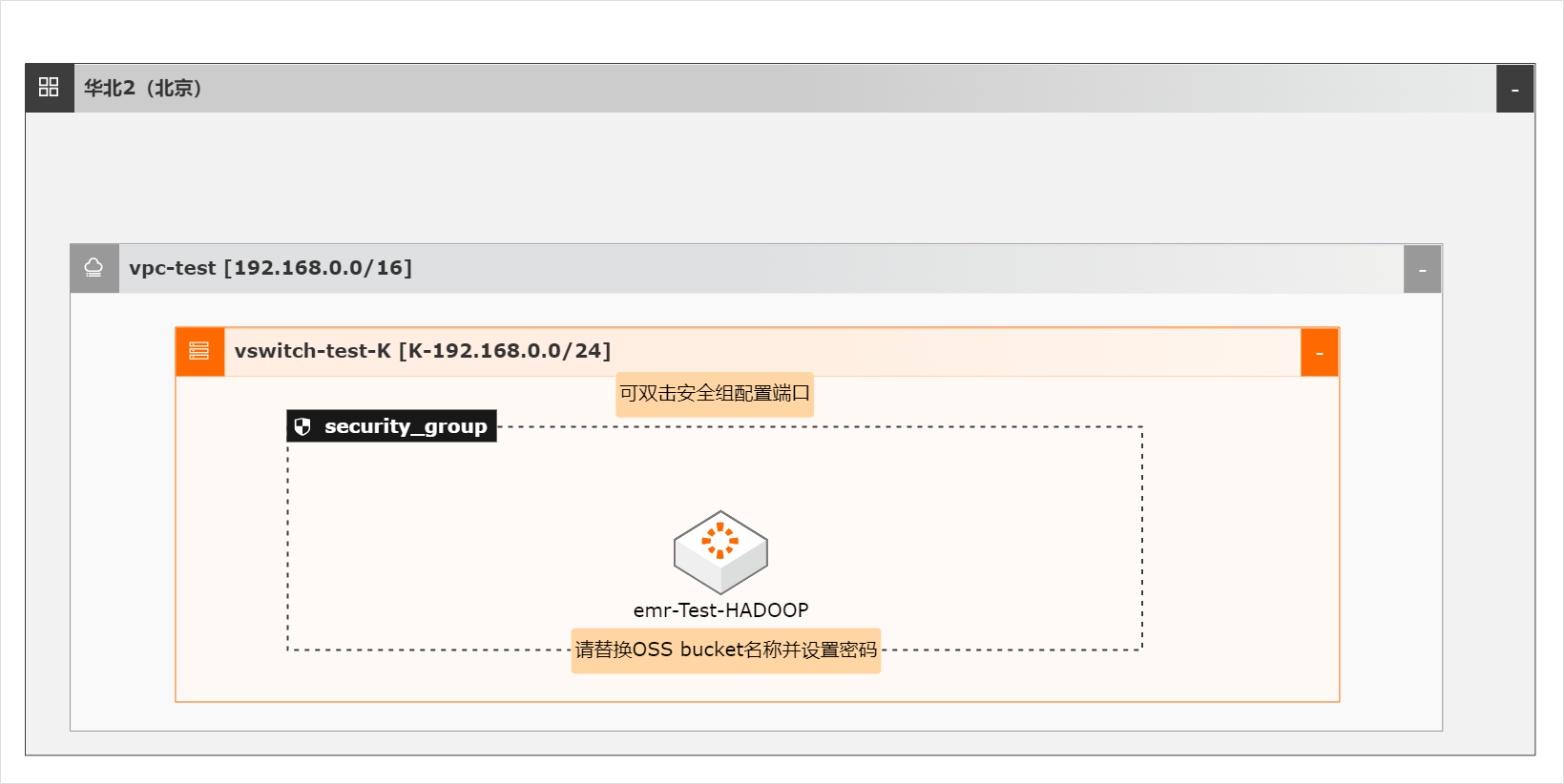

本实例架构图:文档版本:20210628(发布日期)9 阿里云最佳实践大数据 WorkShop 最佳实践项目实践(注:CADT暂不支持创建实时计算 Flink集群,下一章节将通过页面创建)需要注意:使用 CADT进行资源创建时,所有的实例名需要设置为自定义名称 步骤1 登录 CADT控制台。...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

EMR HBase on OSS存算分离集群快速恢复

OSS-HDFS服务(JindoFS服务)是一款云原生数据湖存储产品。基于统一的元数据管理能力,在完全兼容HDFS文件系统接口的同时,提供充分的POSIX能力支持,能更好地满足大数据和AI等领域的数据湖计算场景。

服务特性 OSS-HDFS服务支持的特性如下:HDFS兼容访问 OSS-HDFS 服务完全兼容 HDFS 接口,同时支持目录层级的操作,您只需集成 JindoSDK,即可为 Apache Hadoop的计算分析应用(例如 MapReduce、Hive、Spark、Flink等)提供了访问 HDFS服务的能力,像使用 Hadoop分布式文件系 统(HDFS)一样管理和访问数据。POSIX能力支持 ...

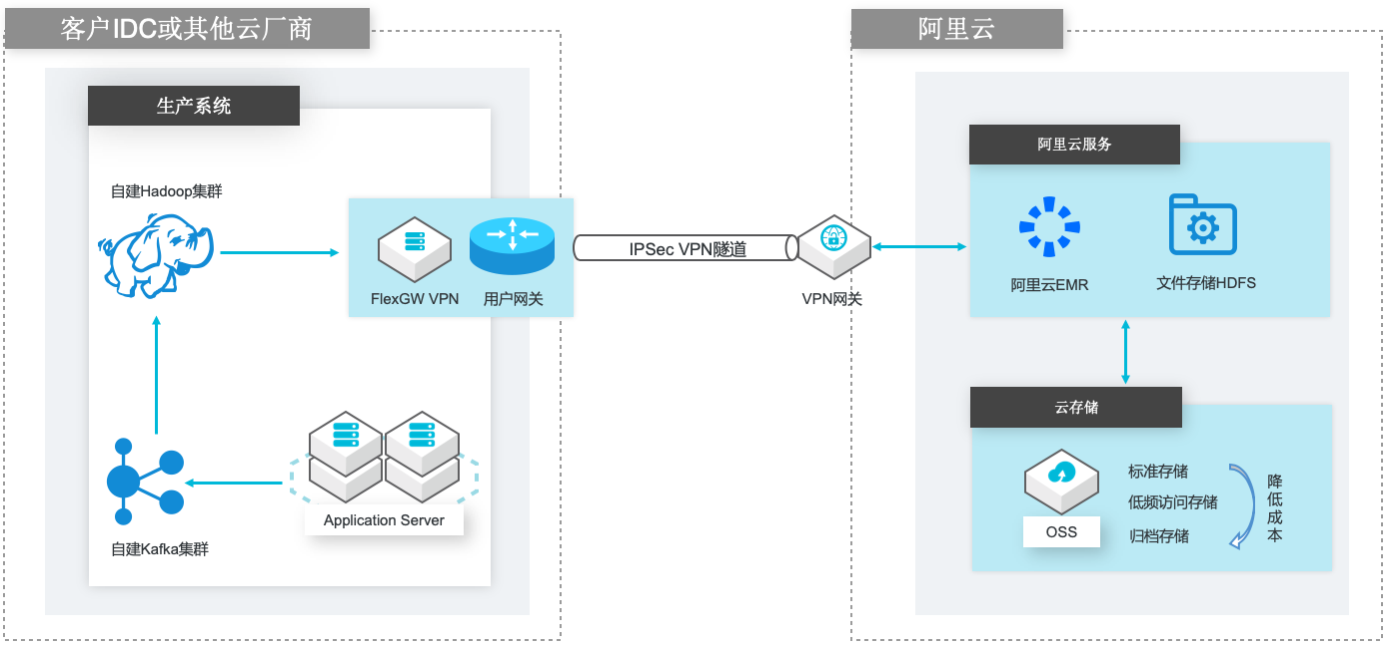

自建Hadoop迁移到阿里云EMR

场景描述 场景1:自建Hadoop集群数据(HDFS)迁移到 阿里云EMR集群的HDFS文件系统; 场景2:自建Hadoop集群数据(HDFS)迁移到 计算存储分离架构的阿里云EMR集群,以OSS 和JindoFS作为EMR集群的后端存储。 解决的问题 客户自建Hadoop迁移到阿里云EMR集群的 技术方案; 基于IPSecVPN隧道构建安全和低成本数据 传输链路 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

cd~wget https://mirrors.tuna.tsinghua.edu.cn/apache/flume/1.8.0/apache-flume-1.8.0-bin.tar.gz tar zxfapache-flume-1.8.0-bin.tar.gz文档版本:20210714 21 自建Hadoop数据迁移到阿里云 EMR 自建 Hadoop集群环境搭建 2.下载 flume-env.sh配置文件。cd~/apache-flume-1.8.0-bin/conf wget ...

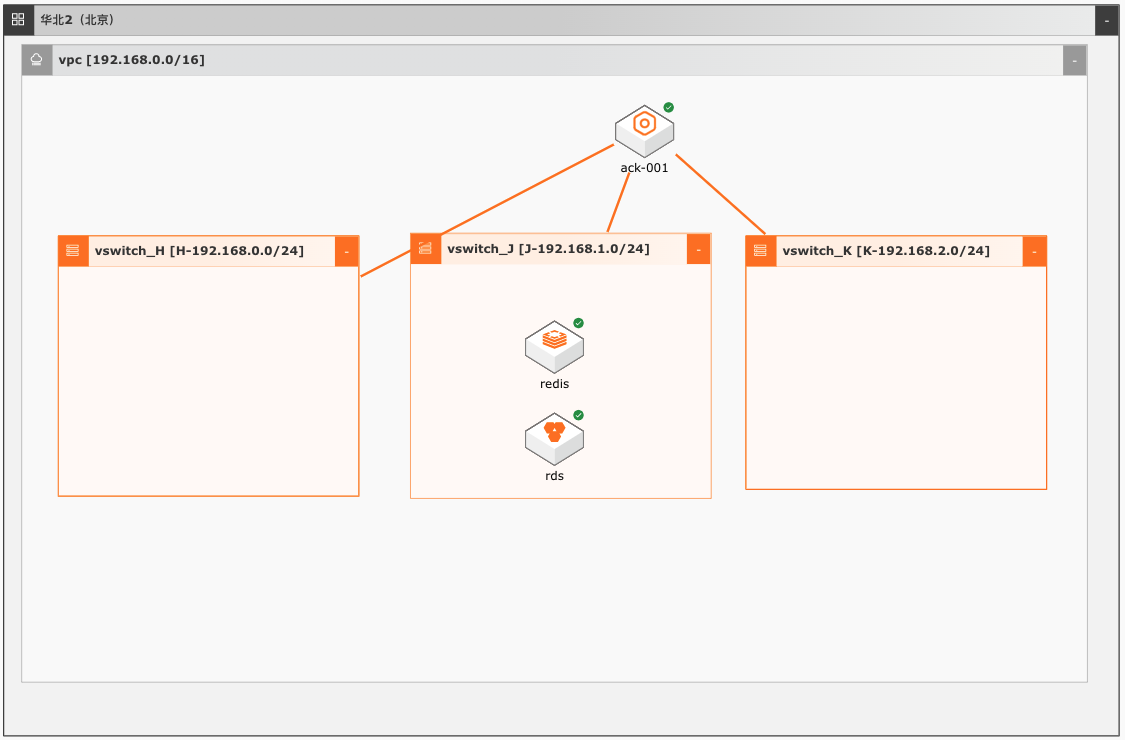

容器跨可用区高可用

场景描述 本实践适合使用容器服务ACK结合阿里云上的 其他产品构建跨可用区高可用应用的场景。在一 开始创建容器服务ACK的时候就把容器集群建 成多个可用区的架构,某可用区挂掉后,不影响 应用和集群的高可用。容器服务ACK通常配合 高可用SLB,RDS,Redis等产品,实现跨可用 区高可用。 解决问题 1.利用容器服务ACK搭建跨可用区高可用 的应用 2.容器服务ACK结合SLB,RDS,REDIS构 建高可用应用 产品列表 容器服务ACK RDSforMysql版 云数据库Redis版 文件存储NAS

在 一开始创建容器服务 ACK的时候就把容器集群 建成多个可用区的架构,某可用区挂掉后,不影 响应用和集群的高可用。容器服务 ACK通常配 合高可用 SLB,RDS,Redis等产品,实现跨可 用区高可用。解决问题 利用容器服务 ACK搭建跨可用区高可用 产品列表 的应用 容器服务 ACK 容器服务 ACK结合 SLB,RDS,REDIS构 RDS for ...

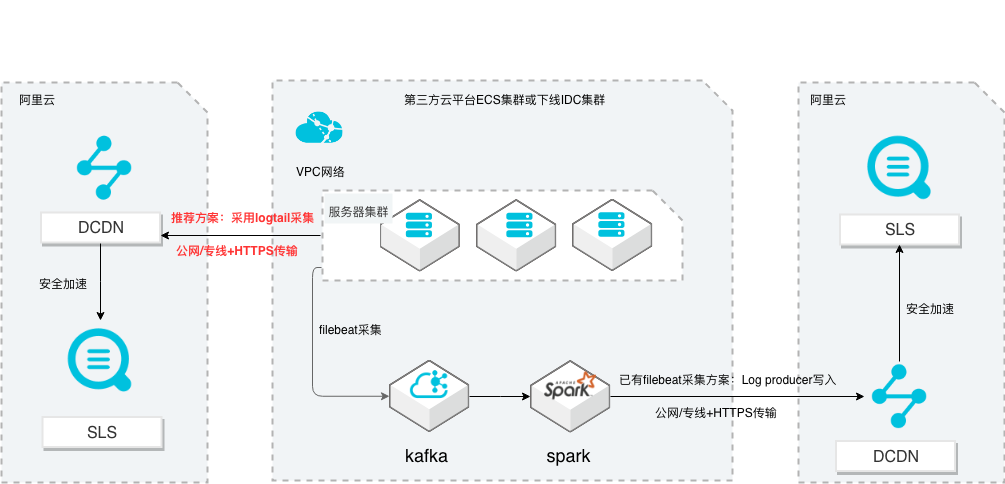

SLS多云日志采集、处理及分析

场景描述 从第三方云平台或线下IDC服务器上采集 日志写入到阿里云日志服务,通过日志服务 进行数据分析,帮助提升运维、运营效率, 建立DT 时代海量日志处理能力。 针对未使用其他日志采集服务的用户,推荐 在他云或线下服务器安装logtail采集并使用 Https安全传输;针对已使用其他日志采集 工具并且已有日志服务需要继续服务的情 况,可以通过Log producer SDK写入日志 服务。 解决问题 1.第三方云平台或线下IDC客户需要使用 阿里云日志服务生态的用户。 2.第三方云平台或线下IDC服务器已有完 整日志采集、处理及分析的用户。 产品列表 E-MapReduce 专有网络VPC 云服务器ECS 日志服务LOG DCDN

过程不再赘述 文档版本:20211203 67 SLS多云日志采集、处理及分析 日志服务器集群公网日志数据传递到日志服务 步骤4 创建日志服务 Project以及日志 Logstore 按照 3.1节的方式在华东 2(上海)区域创建名为 sls-test-121的日志服务 Project以 及名为 test20191009的日志 Logstore,并为 Logstore开启索引,过程不再赘述 ...

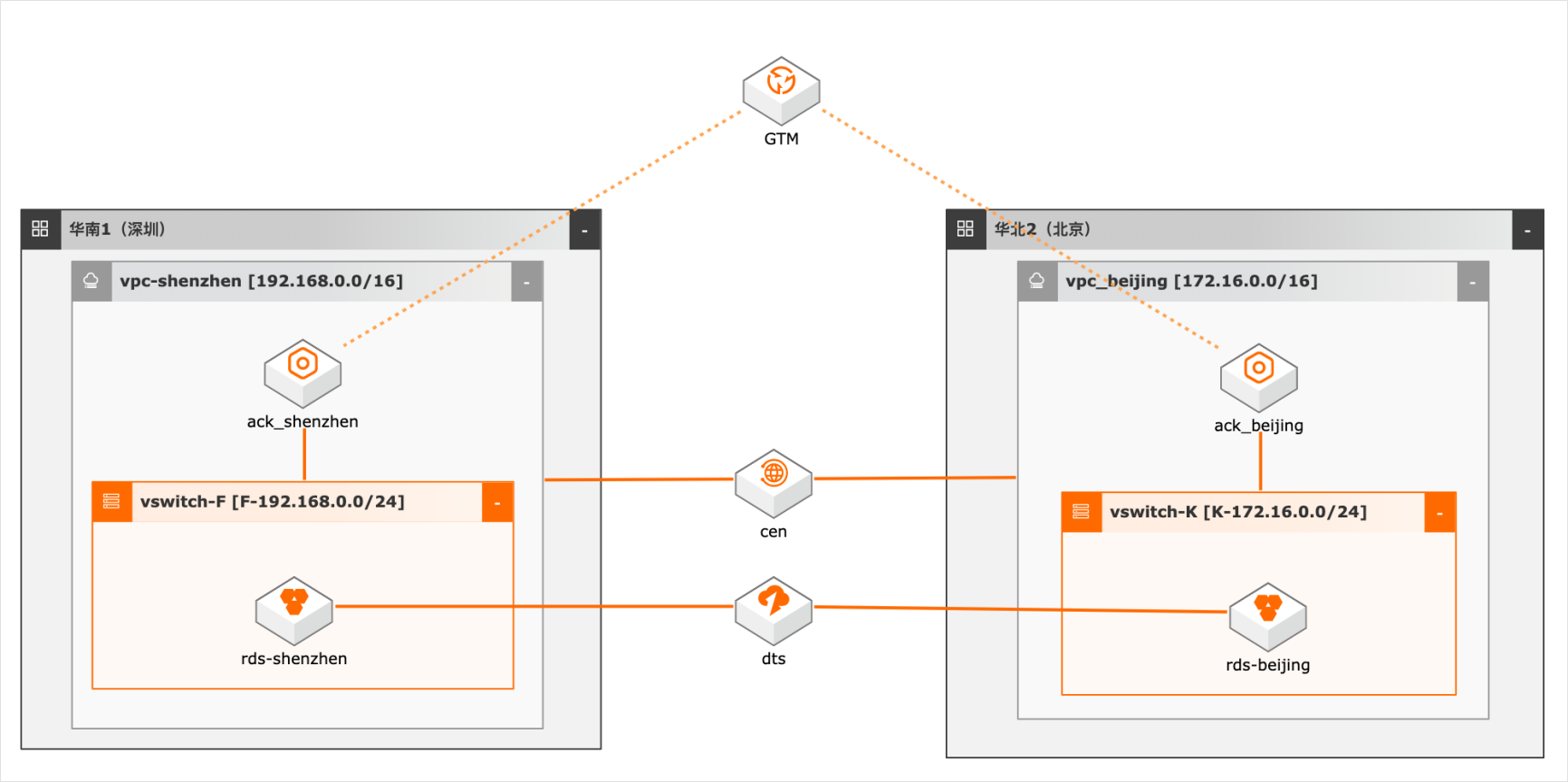

异地双活场景下的数据双向同步

概述 随着客户业务规模的扩大,对系统高可用性要求越来越高,越来越多用户采用异地双活/多活架构,多活架构往往涉及业务侧做单元化改造,本方案仅模拟用户已做单元化改造后的数据双向同步,数据库采用双主架构,本地写本地读,同时又保证双库的数据一致性,为业务增加可用性和灵活性。 适用场景 数据库双向同步 数据库全局ID不冲突 双活架构的数据库建设问题 技术架构 本实践方案基于如下图所示的技术架构和主要流程编写操作步骤: 方案优势 DTS双向同步,采用独立模块避免数据同步占用系统资源。 奇偶ID涉及,避免数据冲突。 DTS多种处理冲突的方式供业务选择。 安全:原生的多租户系统,以项目进行隔离,所有计算任务在安全沙箱中运行。

异地双活场景下的数据双向同步 最佳实践 业务架构 场景描述 解决的问题 随着客户业务规模的扩大,对系统高可用性要求越 数据库双向同步 来越高,越来越多用户采用异地双活/多活架构,多 数据库全局 ID不冲突 活架构往往涉及业务侧做单元化改造,本方案仅模 双活架构的数据库建设问题 拟用户已做单元化改造后的数据双向同步...

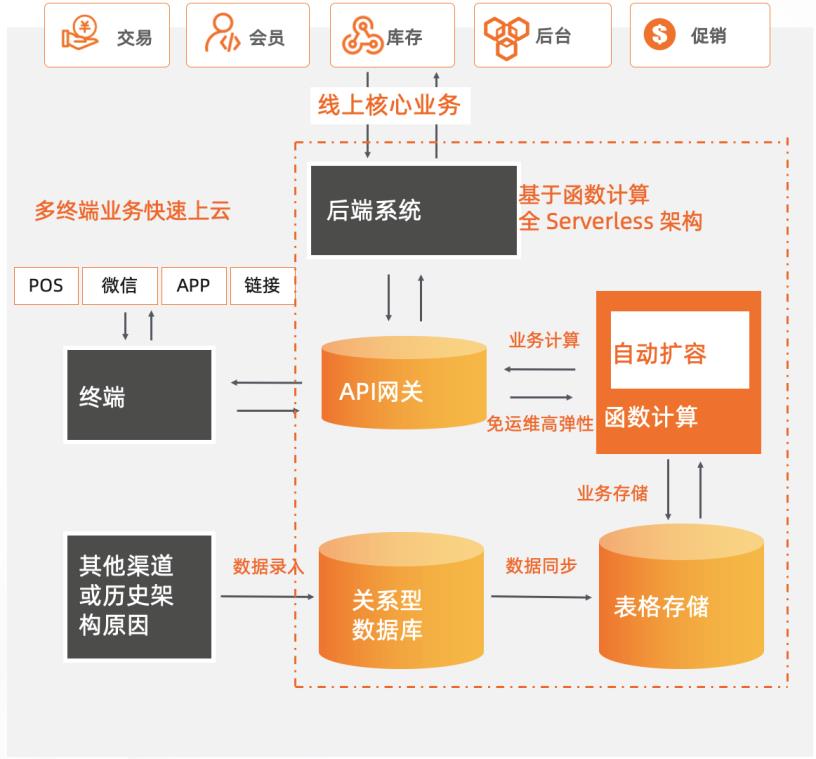

新零售商超基于Serverless服务化改造

某零售商超行业龙头企业,主要业务涵盖购物中心、大卖场、综合超市、标准超市、精品超市、便利店、无人值守智慧商店等零售业态,涉及全渠道零售、仓储物流、餐饮、消费服务、数据服务、金融业务、跨境贸易等领域。为了持续支持业务高速且稳定地发展,其在快速上云后,将核心业务改造为全Serverless架构的中台模式,采用函数计算 + API网关 + 表格存储OTS 作为计算网络存储核心,弹性支撑日常和大促峰谷所需资源,轻松支撑618/双11/双12大促。 核心价值 l 全 Serverless 架构:FC + API 网关 + OTS Serverless 解决方案。 l 弹性高可用:毫秒级弹性扩容、充足的资源池水位、跨可用区高可用。 l 敏捷开发免运维:函数式极简编程可专注于业务创新,无采购和部署成本、提供监控报警等完备的可观测能力。

文档版本:20210519 34 新零售商超基于 Serverless服务化改造 架构环境搭建 步骤7 上线后,可访问 API网关提供的二级域名,该二级域名仅供测试使用,客户端直接调 用时会有每天 1000次访问限制。建议为分组绑定独立域名,使用独立域名访问不会 受到此限制,详见配置过程:...

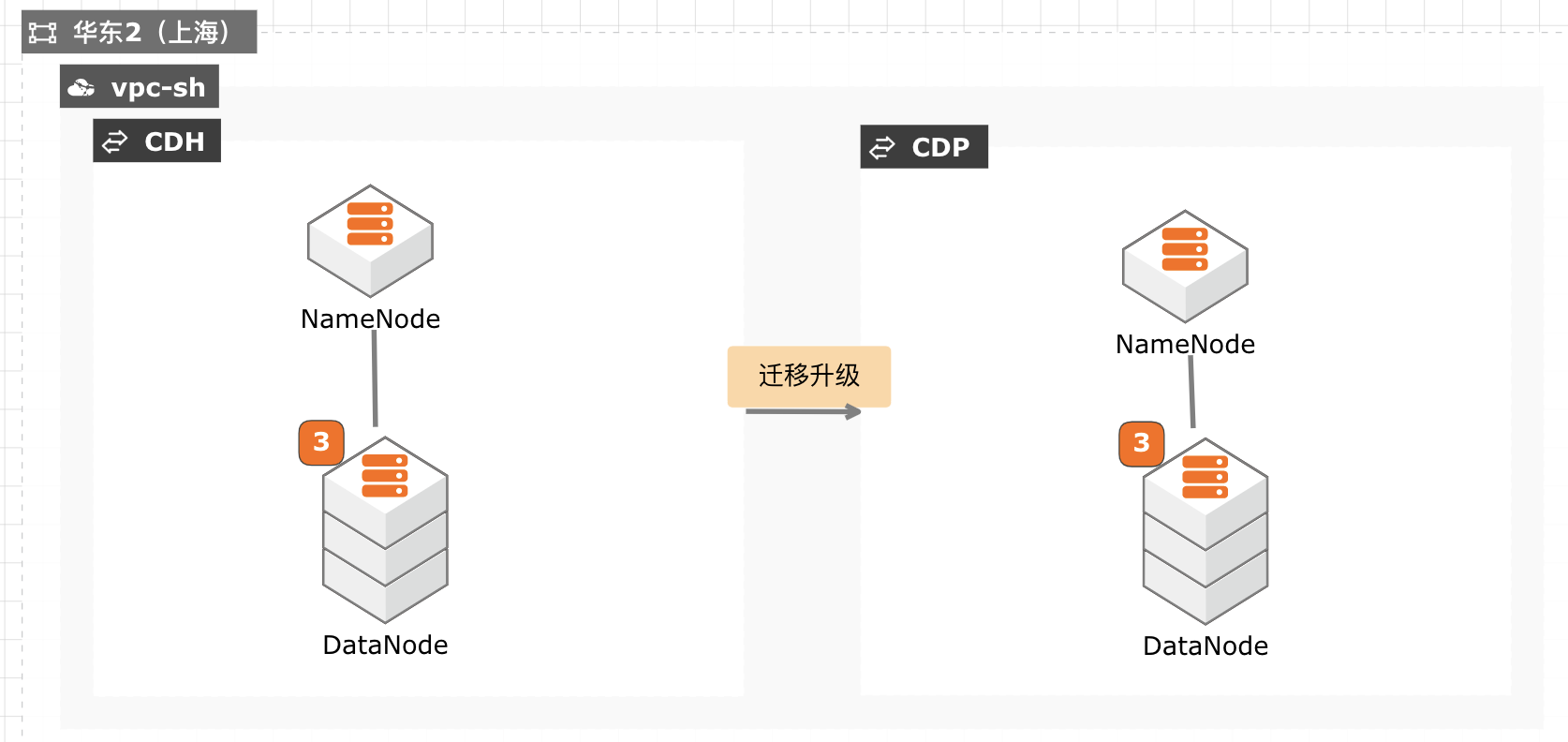

CDH迁移升级CDP最佳实践

当前 CDH 免费版停止下载,终止服务,针对需要企业版服务能力并且CDH 升级过程对业务影响较小的客户,通过安装新的 CDP 集群,将现有数据拷贝至新集群,然后将新集群切换为生产集群,升级过程没有数据丢失风险,停机时间较短,适合大部分互联网客户升级使用。

yum-y install gcc gcc-c++ wget http://archive.apache.org/dist/maven/maven-3/3.6.0/binaries/apache-maven-3.6.0- bin.tar.gz tar zxfapache-maven-3.6.0-bin.tar.gz mvapache-maven-3.6.0 /usr/local/maven3使用以下命令配置 maven环境变量。export M2_HOME=usr/local/maven3 export PATH=$PATH:$M2_HOME/bin source/etc/...

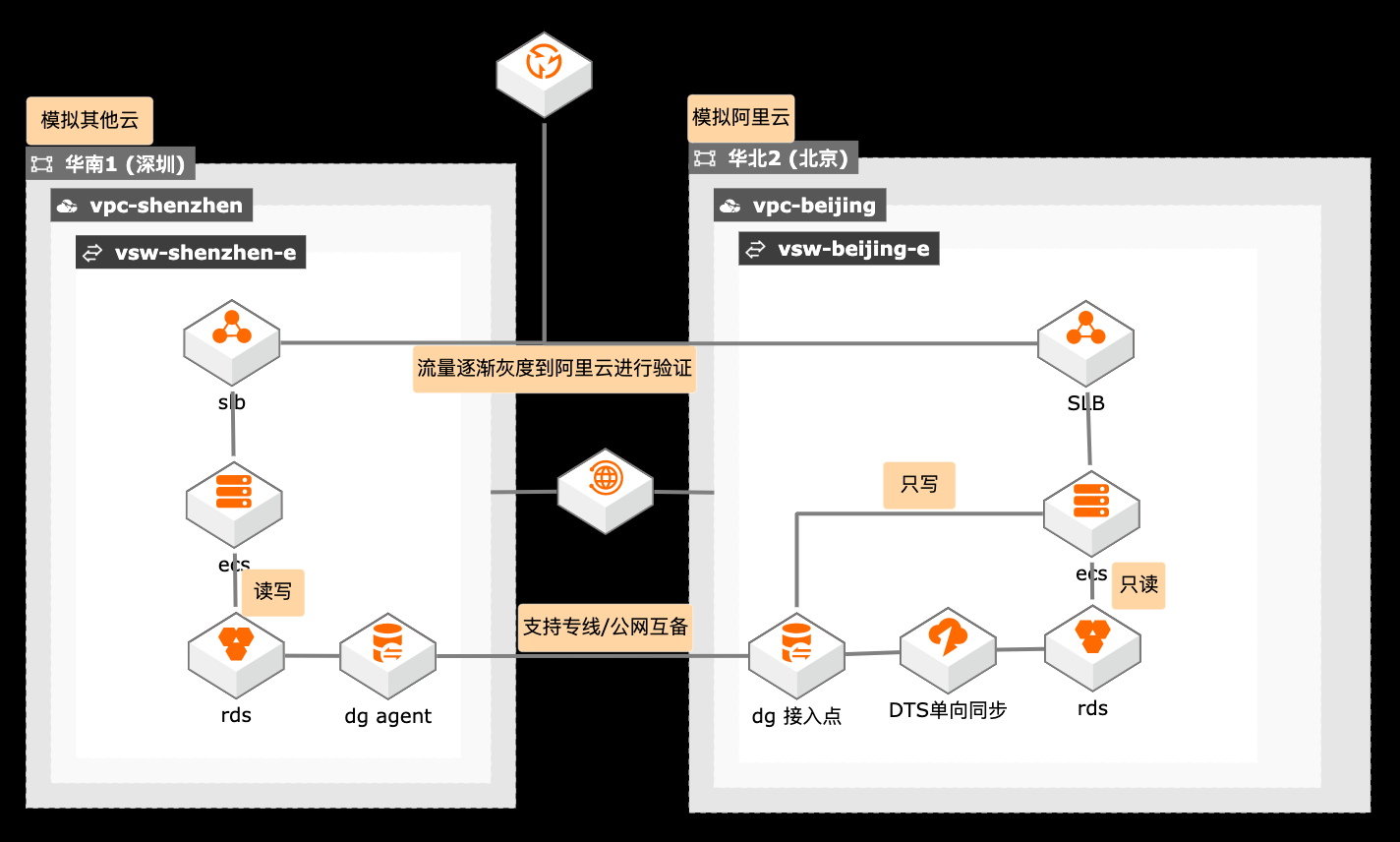

跨云迁移单写双读过渡架构

概述 在搬站场景下,涉及迁移跨度较长,在过渡阶段客户需要跨云访问,如何保障数据链路的高可用尤为关键,采用专线和公网双备的方案保障数据传输的高可用,也降低双专线的迁移成本。 适用场景 数据迁移链路的高可用 跨云迁移过渡期架构 读写分类架构设计 技术架构 本实践方案基于如下图所示的技术架构和主要流程编写操作步骤: 方案优势 在迁移时间持续较长的情况下,使用单写双读架构降低业务改造成本。 使用数据库网关做专线和公网互备。 流量逐渐灰度验证,保障迁移平滑过渡。 安全:原生的多租户系统,以项目进行隔离,所有计算任务在安全沙箱中运行。

多台云服务器进行流量分发的负载均衡 服务,可以通过流量分发扩展应用系统对外的服务能力,通过消除单点故障提升 应用系统的可用性。详见:https://www.aliyun.com/product/slb PTS: Performance Testing Service是面向所有技术背景人员的云化测试工具。有别于传统工具的繁复,PTS以互联网化的交互,提供性能测试、API调试...

金融专属大数据workshop

实践目标 学习搭建一个实时数据仓库,掌握数据采集、存储、计算、输出、展示等整个业务流程。 整个实时数据仓库系统全部基于阿里云产品进行架构搭建,用户可以掌握并学会运用各个服务组件及各个组件之间如何联动。 理解阿里云原生实时离线一体数仓解决方案架构以及掌握交付落地的实践使用方法。 前置知识要求 熟练掌握SQL语法 对大数据体系系统知识有一定的了解

本实例架构图:文档版本:20210803(发布日期)11阿里云最佳实践金融大数据WorkShop 最佳实践项目实践(注:CADT暂不支持创建实时计算Flink集群,下一章节将通过页面创建)需要注意:使用CADT进行资源创建时,所有的实例名需要设置为自定义名称 步骤1 登录CADT控制台。...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

- 产品推荐

- 这些文档可能帮助您