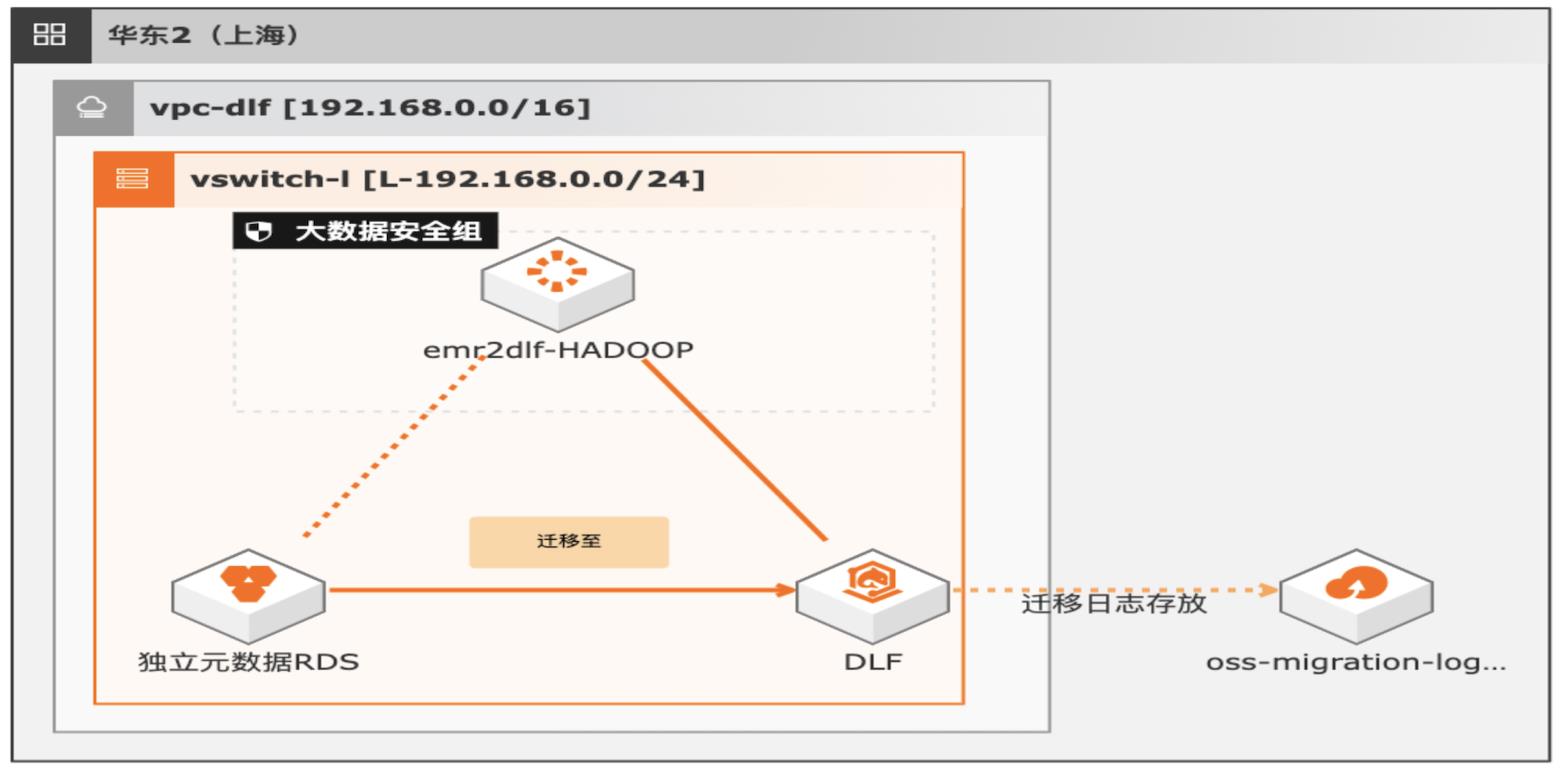

湖仓一体架构EMR元数据迁移DLF

通过EMR+DLF数据湖方案,可以为企业提供数据湖内的统一的元数据管理,统一的权限管理,支持多源数据入湖以及一站式数据探索的能力。本方案支持已有EMR集群元数据库使用RDS或内置MySQL数据库迁移DLF,通过统一的元数据管理,多种数据源入湖,搭建高效的数据湖解决方案。

批量调用 DLF SDK的批次大小,最大不能超过 500,太大可能会超时,太小效率慢,一般 100左右可以。ᅳ debug:必选配置。Spark是否会向 console输出 debug信息。ᅳ deleteBeforeCreate:必选配置。如果在 DLF创建对象的时候,如果对象已经 存在,是否要删除后再重新创建。false的情况不会删除,冲突时会 update;true的情况...

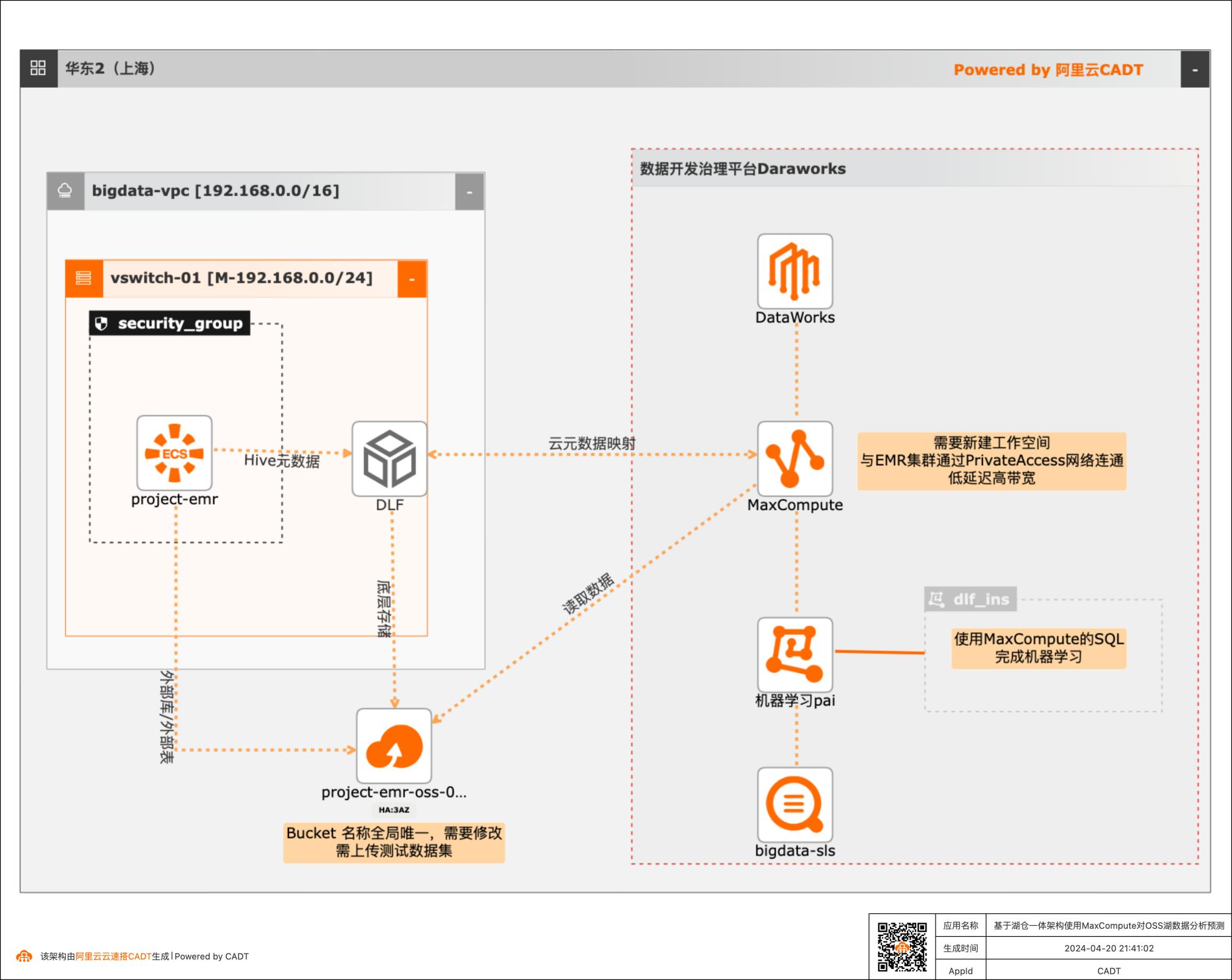

基于湖仓一体架构使用MaxCompute对OSS湖数据分析预测

本篇最佳实践先创建EMR集群作为数据湖对象,Hive元数据存储在DLF,外表数据存储在OSS。然后使用阿里云数据仓库MaxCompute以创建外部项目的方式与存储在DLF的元数据库映射打通,实现元数据统一。最后通过一个毒蘑菇的训练和预测demo,演示云数仓MaxCompute如何对于存储在EMR数据湖的数据进行加工处理以达到业务预期。

可用区M 支持导入已保 有资源 IPv4网段 192.168.0.0/24 安全组:系统默认配置,自动创建 基于模版新建 名称:project-emr 可选服务:如果更换地域 付费类型:按量付费 OSS-HDFS、Hadoop-Common、或者可用区,业务场景:新版数据湖 Hive、Spark3、Tez、YARM 注意规格 元数据:DLF统一元数据 EMR 集群存储根路径:勾选:挂载...

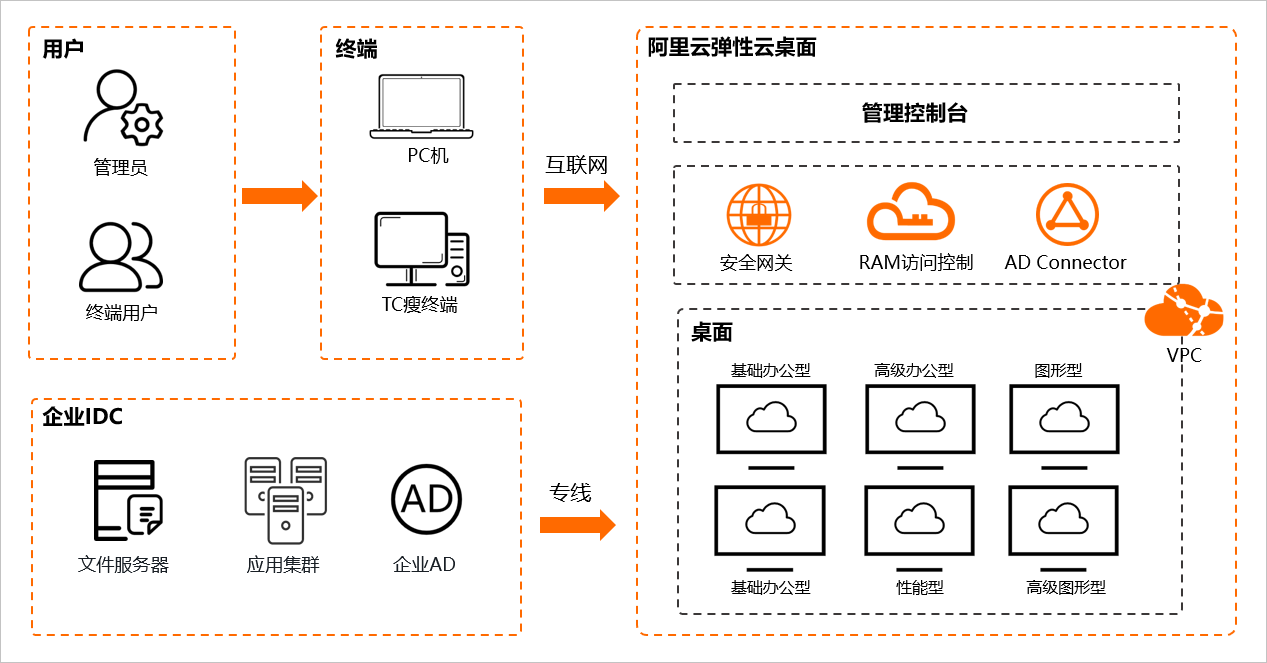

远程办公-AD管控下的弹性云桌面

在弹性云桌面中部署企业基础办公环境时,IT人员通常会面临以下问题,本文希望通过场景实践的方式,示范如何结合使用不同阿里云产品,来解决这些问题:用户如何管理?企业已有AD用户如何上云?云上共享文件服务权限怎么管?数据安全问题有保障吗?该如何设置?云桌面能使用本地机房或IDC中的服务吗? 本文使用的应用场景: 场景1:客户A在云上新建Windows ActiveDirectory(以下简称AD);弹性云桌面,和NAS文件存储服务部署在AD所在的VPC内。场景2:客户B在阿里云上已有AD和NAS。弹性云桌面创建在与AD不同的VPC中。AD与云桌面的VPC通过CEN连接。场景3:客户C在云下IDC有自建AD和文件服务。弹性云桌面创建在阿里云上。云下机房与阿里云弹性云桌面所在VPC通过IPsec VPN连接。 方案优势: 易部署:弹性云桌面支持快速便捷的桌面环境创建、部署、统一管控与运维。 CEN和VPN网关服务开通即用,配置实时生效,快速完成部署。 低成本:弹性云桌面无需前期传统硬件投资,帮您快速构建安全、高性能、低成本的桌面办公体系。可广泛应用于具有高数据安全管控、高性能计算等要求的金融、设计、视频、教育等领域。VPN网关基于Internet建立加密通道,比建立专线更便宜,快速实现混合云。 安全性:VPN网关使用IKE(秘钥交换协议)和IPSec对传输数据或进行加密,保证数据安全可靠。云桌面自带的安全策略保证数据不落地。 集中管控:通过Windows AD对云桌面用户和共享文件服务进行统一权限管控。可实现AD用户自动同步上云,和文件级别的权限管控。

可广泛应用于具有高数据安全管控、高性能计算等要求的金融、设 计、视频、教育等领域。VPN网关基于 Internet建立加密通道,比建立专线更便宜,快速实现混合云。安全性 文档版本:20201210 2 远程办公-AD管控下的弹性云桌面最佳实践 最佳实践概述 VPN网关使用 IKE(秘钥交换协议)和 IPSec对传输数据或进行加密,保证数据 ...

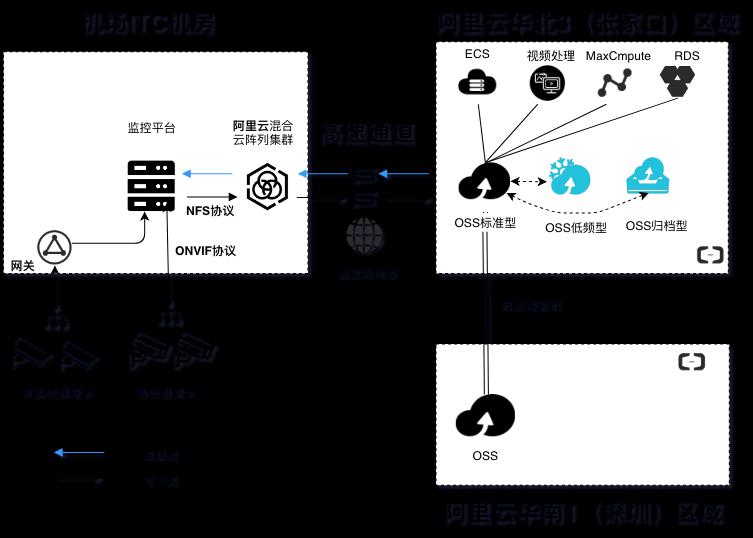

机场视频监控

场景描述 该最佳实践适用于国内机场的视频监控行业,将线下视频文件通过混合云阵列缓存后,通过专线上传到阿里云OSS上。 也适用于其他混合云场景中,利用阵列缓存文件,并通过网络传输到阿里云OSS上的场景。 解决问题 1.通过混合云阵列+专线将线下文件传到阿 里云OSS上 2.通过阿里云OSS跨区域复制功能实现异 地文件备份 3.通过OSS的自动生命周期管理功能实现 文件生命周期管理 产品列表 OSS对象存储 混合云阵列 高速通道(专线)

文件过期策略:选择过期天数,设置对象文件保留天数,以该文件最后修 改时间的天数为起始计算,超过设定天数时即执行规则进行删除或转换为 其他存储类型(低频访问类型或归档类型)。如设置时间为 30 天,最后 修改日期为 2016-1-1 的对象会在2016年 1 月 31 号被后端程序扫描 删除或转换为其他存储类型。 不勾选转换...

基于DataWorks的大数据一站式开发及数据治理

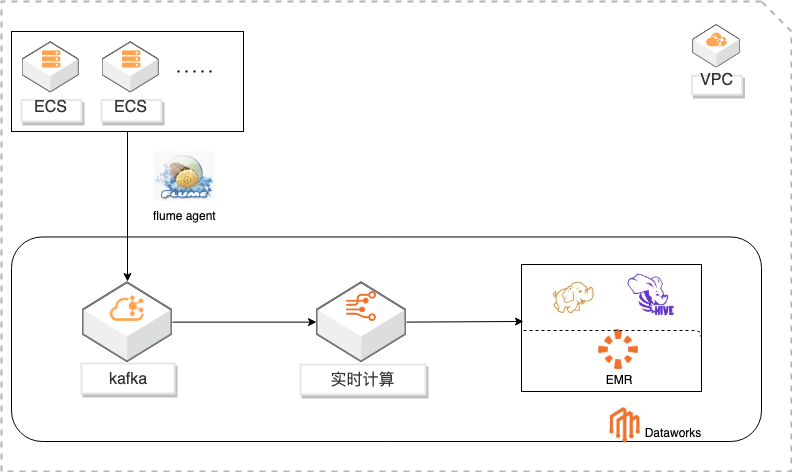

概述 基于Dataworks做大数据一站式开发,包含数据实时采集到kafka通过实时计算对数据进行ETL写入HDFS,使用Hive进行数据分析。通过Dataworks进行数据治理,数据地图查看数据信息和血缘关系,数据质量监控异常和报警。 适用场景 日志采集、处理及分析 日志使用Flink实时写入HDFS 日志数据实时ETL 日志HIVE分析 基于dataworks一站式开发 数据治理 方案优势 大数据一站式开发,完善的数据治理能力。 性能优越:高吞吐,高扩展性。 安全稳定:Exactly-Once,故障自动恢复,资源隔离。 简单易用:SQL语言,在线开发,全面支持UDX。 功能强大:支持SQL进行实时及离线数据清洗、数据分析、数据同步、异构数据源计算等Data Lake相关功能 ,以及各种流式及静态数据源关联查询。

自定义 HDFS Sink.47 文档版本:20201020 IV 基于 Dataworks的大数据一站式开发及数据治理 最佳实践概述 最佳实践概述 概述 本实践基于 Dataworks做大数据一站式开发,包含数据实时采集到 kafka通过实时计 算对数据进行 ETL写入 HDFS,使用 Hive进行数据分析。通过 Dataworks进行数据 治理,数据地图查看数据信息和血缘关系...

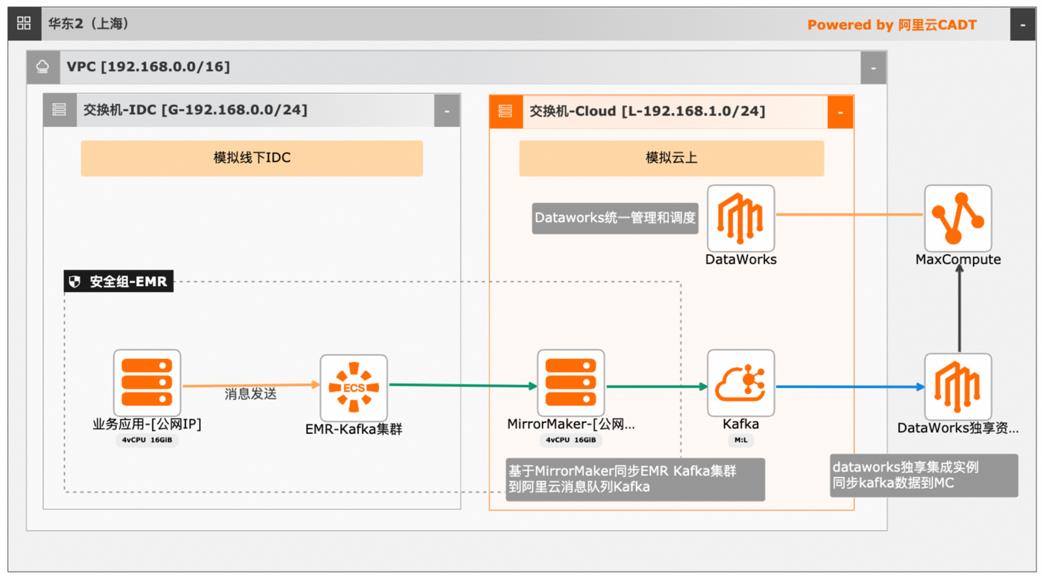

大数据近实时数据投递MaxCompute

本文介绍离线大数据场景使MaxCompute构建云 上近实时数仓,打通云下数据上云链路,解决数据复杂类型支持和动态分区问题,满足高级数据处理需求的最佳实践。 l混合云环境下,现有业务系统零改造,打通数据上云链路。 l使用UDF实现复杂数据类型转换和数据动态分区。 l使用DataWorks配置周期调度业务流程,数据自动入仓。 l借助MaxCompute优化计算引擎,实现降本增效。 产品列表 云服务器ECS 专有网络VPC 访问控制RAM 数据总线DataHub E-MapReduceEMR DataWorks 大数据计算服务MaxCompute

MaxCompute支持 SQL、MapReduce、UDF(Java/Python)、Graph、基于 DAG的处理、交互式、内存计算、机器学习等计 算类型及 MPI迭代类算法。大幅简化了企业大数据平台的应用架构,具有强数据安 全、低成本、免运维、极致弹性扩展等特点。MaxCompute已与数据集成、DataWorks、QuickBI、机器学习 PAI、ADB、推荐引擎、移动数据...

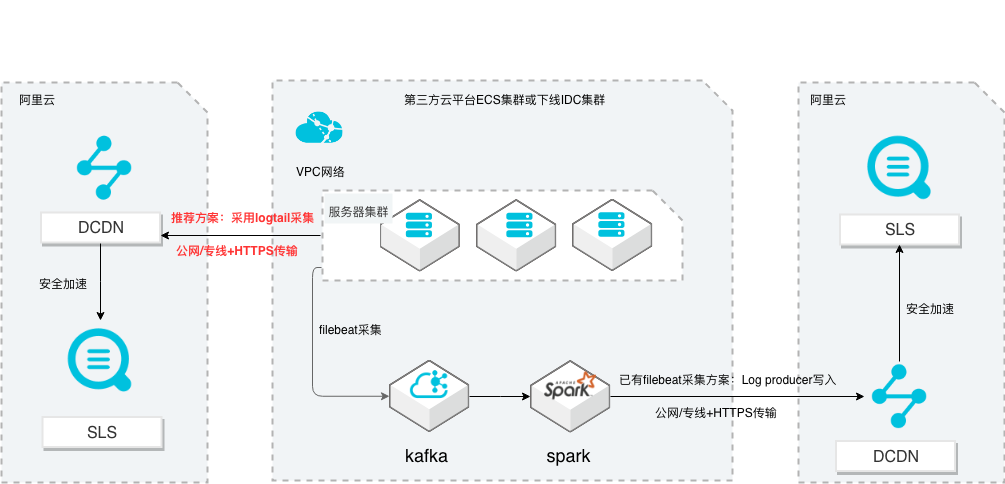

SLS多云日志采集、处理及分析

场景描述 从第三方云平台或线下IDC服务器上采集 日志写入到阿里云日志服务,通过日志服务 进行数据分析,帮助提升运维、运营效率, 建立DT 时代海量日志处理能力。 针对未使用其他日志采集服务的用户,推荐 在他云或线下服务器安装logtail采集并使用 Https安全传输;针对已使用其他日志采集 工具并且已有日志服务需要继续服务的情 况,可以通过Log producer SDK写入日志 服务。 解决问题 1.第三方云平台或线下IDC客户需要使用 阿里云日志服务生态的用户。 2.第三方云平台或线下IDC服务器已有完 整日志采集、处理及分析的用户。 产品列表 E-MapReduce 专有网络VPC 云服务器ECS 日志服务LOG DCDN

提供用户在云上 使用开源技术建设数据仓库、离线批处理、在线流式处理、即时查询、机器学习 等场景下的大数据解决方案。更多信息,请参见专有 E-MapReduce简介(https://www.aliyun.com/product/emapreduce)。全站加速 DCDN:旨在提升动静态资源混合站点的访问体验,支持静态资源边缘 缓存,动态内容最优路由回源传输,...

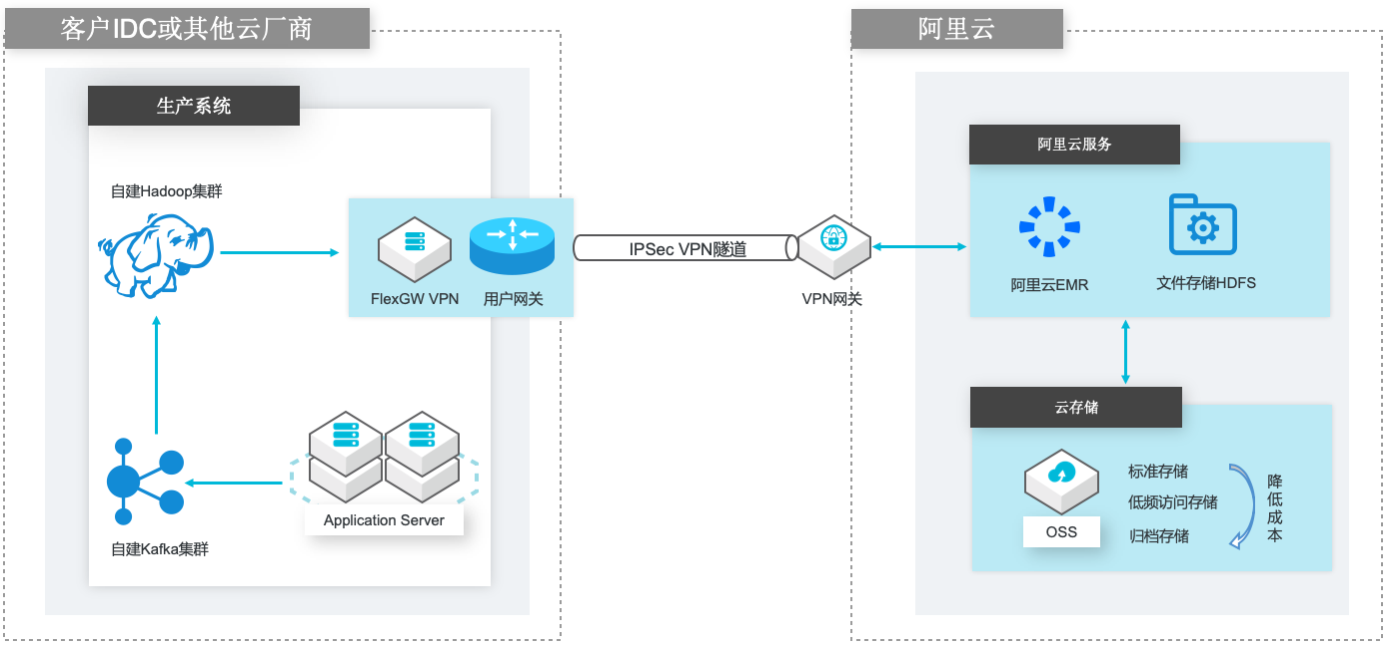

自建Hadoop迁移到阿里云EMR

场景描述 场景1:自建Hadoop集群数据(HDFS)迁移到 阿里云EMR集群的HDFS文件系统; 场景2:自建Hadoop集群数据(HDFS)迁移到 计算存储分离架构的阿里云EMR集群,以OSS 和JindoFS作为EMR集群的后端存储。 解决的问题 客户自建Hadoop迁移到阿里云EMR集群的 技术方案; 基于IPSecVPN隧道构建安全和低成本数据 传输链路 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

场景2:自建 Hadoop集群数据(HDFS)迁移到计 基于 IPSec VPN隧道构建安全和低成本数据 算存储分离架构的阿里云 EMR集群,以 OSS 和 传输链路 JindoFS作为 EMR集群的后端存储。产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。文档模板(手册名称)/Error!Use the Home tab to apply 云服务器 ECS(产品名称)标题 to the ...

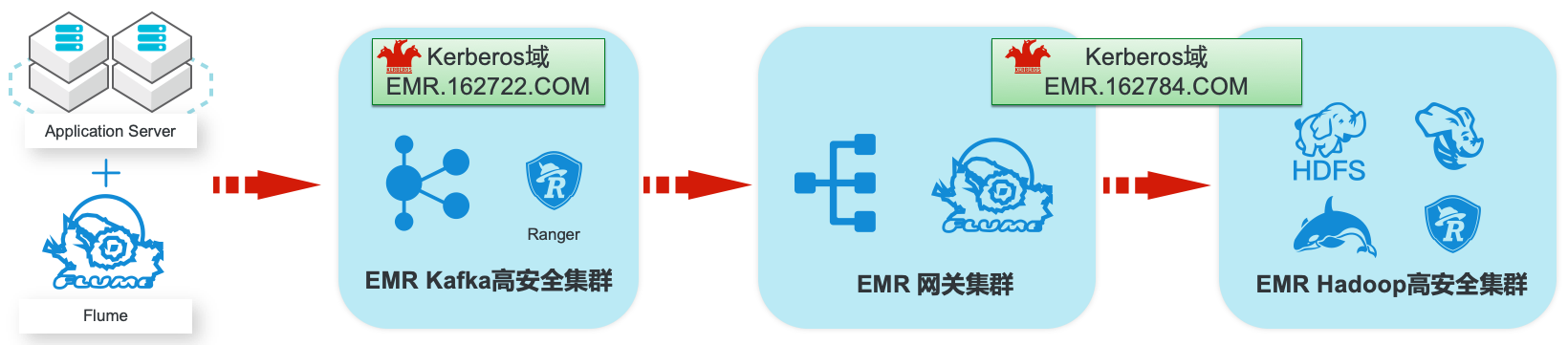

EMR集群安全认证和授权管理

场景描述 阿里云EMR服务Kafka和Hadoop安全集群使 用Kerberos进行用户安全认证,通过Apache Ranger服务进行访问授权管理。本最佳实践中以 Apache Web服务器日志为例,演示基于Kafka 和Hadoop的生态组件构建日志大数据仓库,并 介绍在整个数据流程中,如何通过Kerberos和 Ranger进行认证和授权的相关配置。 解决问题 1.创建基于Kerberos的EMR Kafka和 Hadoop集群。 2.EMR服务的Kafka和Hadoop集群中 Kerberos相关配置和使用方法。 3.Ranger中添加Kafka、HDFS、Hive和 Hbase服务和访问策略。 4.Flume中和Kafka、HDFS相关的安全配 置。 产品列表:E-MapReduce、专有网络VPC、云服务器ECS、云数据库RDS版

提供 用户在云上使用开源技术建设数据仓库、离线批处理、在线流式处理、即时查询、机 器 学 习 等 场 景 下 的 大 数 据 解 决 方 案。详 情 请 查 看 www.aliyun.com/product/emapreduce Kerberos:Kerberos是一种网络身份验证协议,它旨在通过使用密钥加密为客户 端/服务器应用程序提供强身份验证。它提供了网络上的身份...

批量计算BCS

阿里云批量计算(BatchCompute)是一种适用于大规模并行批处理作业的分布式云服务。支持海量作业并发规模,系统自动完成资源管理,作业调度和数据加载,并按实际使用量计费。可广泛应用于电影动画渲染、生物数据分析、多媒体转码、金融保险分析、科学计算等领域。

支持10万核级别以上并发,加速计算过程.一键提交作业,自动完成资源...批量计算(BatchCompute)是一种适用于大规模并行批处理作业的分布式云服务。可支持海量作业并发规模,系统自动完成资源管理,作业调度和数据加载,并按实际使用量计费。广泛应用于电影动画渲染、生物数据分析、多媒体转码、金融保险分析、科学计算等领域.

来自:

云产品

- 产品推荐

- 这些文档可能帮助您