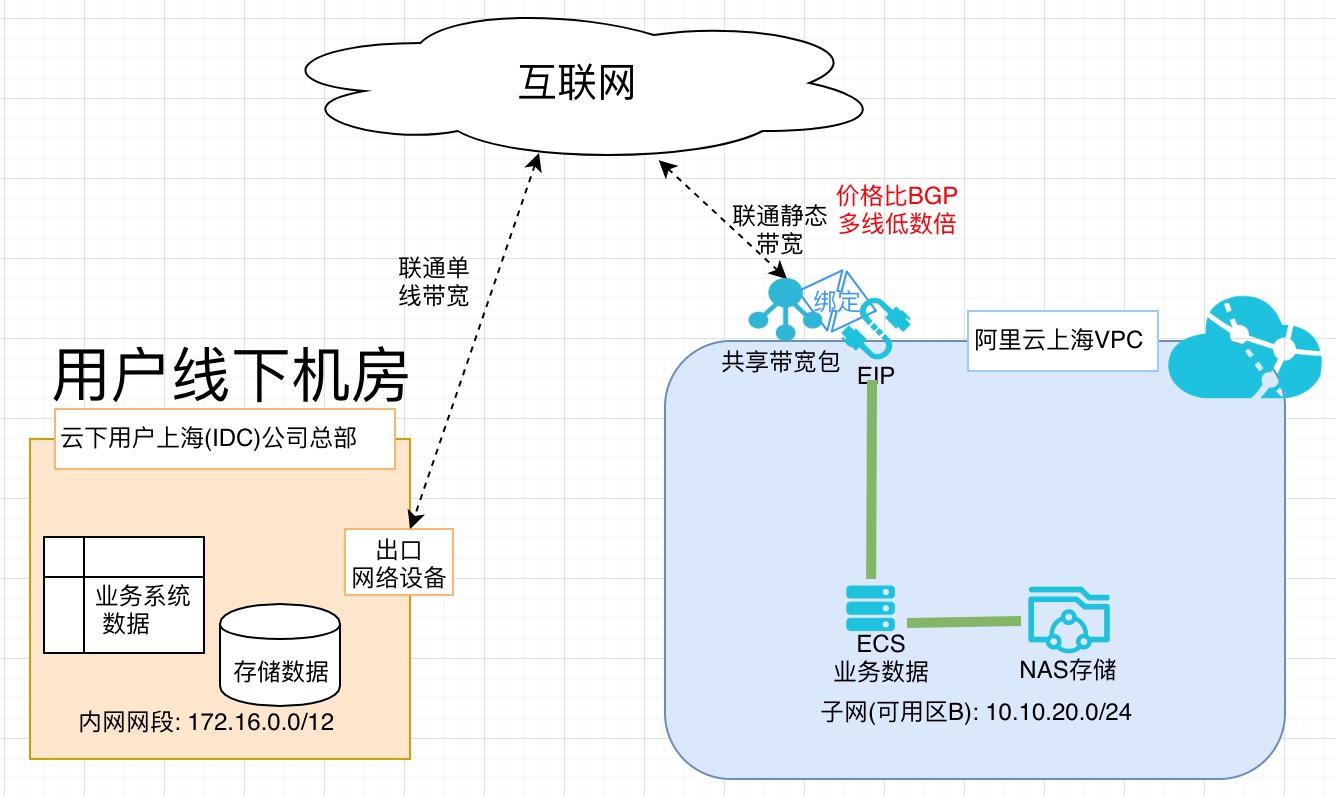

利用低成本链路完成业务数据迁移上云

场景描述 随着云计算被越来越多的客户所接受,除业务系 统上云外,很多客户已经把业务数据搬迁上云。 业务数据量一般都比较大,迁移上云需要大量的 网络带宽,BGP费用比较高。阿里云对用户开 放所需地域购买静态单线共享带宽包的权限(移 动/联通/电信均可),可用为迁移数据有效降低 成本。 解决问题 1.业务数据上云网络成本高 产品列表 专有网络VPC 云服务器ECS 网络存储NAS 共享带宽包

传输文件在云下A主机所挂载存储数据上,为方便演示,在A主机根目录/qiany目录 下,准备迁移的文件如下(后面介绍生成方式)。1.100m.file#100m的文件3个。2.1000m.file#1000m的文件2个。共2300m(方案验证为了时间成本不演示全部200TB的传输)。登录云下服务器,准备迁移数据 步骤1 SSH登录服务器。sshroot@47.xxx.xxx.114 ...

数据迁移上云

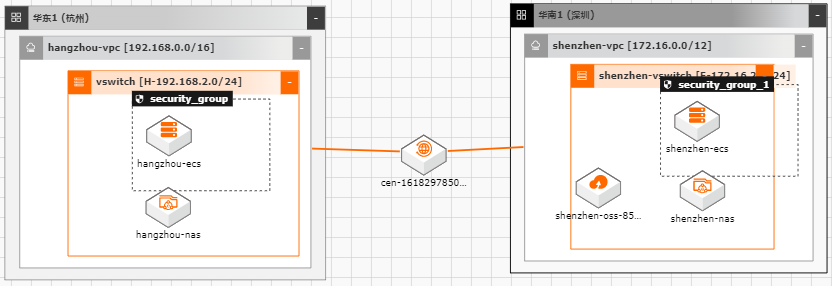

随着越来越多的企业选择将业务系统上云,各种类型的数据如何便捷、平滑的迁移上 云,成了用户上云较为关注的点;业务上云后,因为业务或者其他方面调整等因素, 也存在如跨区域,跨账号等数据迁移的场景。针对以上需求,阿里云上提供了较为丰 富的工具(如ossimport)、服务(在线迁移服务),旨在能够帮助客户便捷进行数据迁 移。 本文通过云架构设计工具CADT来快速创建云上基础资源,并以杭州区域来模拟线 下IDC(或友商),深圳区域模拟阿里云云上资源。通过云上的工具命令、服务来提 供常见数据迁移场景的最佳实践。

本案例以 FTP服务器为例,具体 FTP服 26 文档版本:20201013 数据迁移上云最佳实践 使用阿里云在线迁移服务进行数据迁移 务器搭建过程本文不再赘述。3.2.创建目的地址 步骤1 选择在线迁移服务>数据地址,并选择“OSS”的数据类型,数据所在区域选择“华南 1(深圳)”,然后点击创建数据地址 步骤2 在跳出的创建数据窗口中...

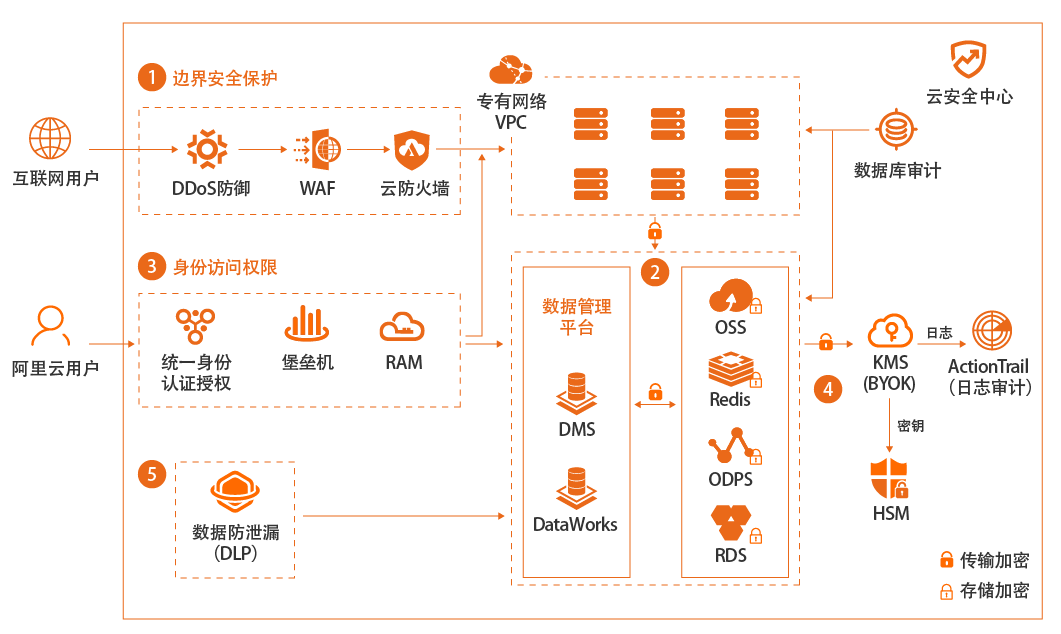

企业上云数据安全

场景描述 企业是否选择上公共云,或者哪些系统或数据上 公共云,对数据安全的关心是重要因素之一。本 最佳实践重点在于介绍狭义的数据加密存储安 全范畴,即首先使用SDDP产品进行敏感数据发 现和分级分类,然后对高级别敏感数据进行按 需、不同类型的全链路加密存储。 解决问题 1.帮助客户发现敏感数据 2.对敏感数据进行分类、分级 3.对不同级别的数据如何选择加密方式 4.具体如何进行加密 产品列表 敏感数据识别SDDP 密钥管理服务KMS 云数据库RDS 对象存储OSS

python encrypt_locally_with_kms_to_oss.py 文档版本:20210809 37 企业上云数据安全 RDS数据安全 4.RDS数据安全 RDS的数据加密,一般可分为两种:一种是对整个数据库或表的加密,加密动作在服 务端进行,客户端无感知,一般称为透明加密,即 TDE。另一种是对表中的某个字段 加密,加密的动作在客户端,客户端在执行数据...

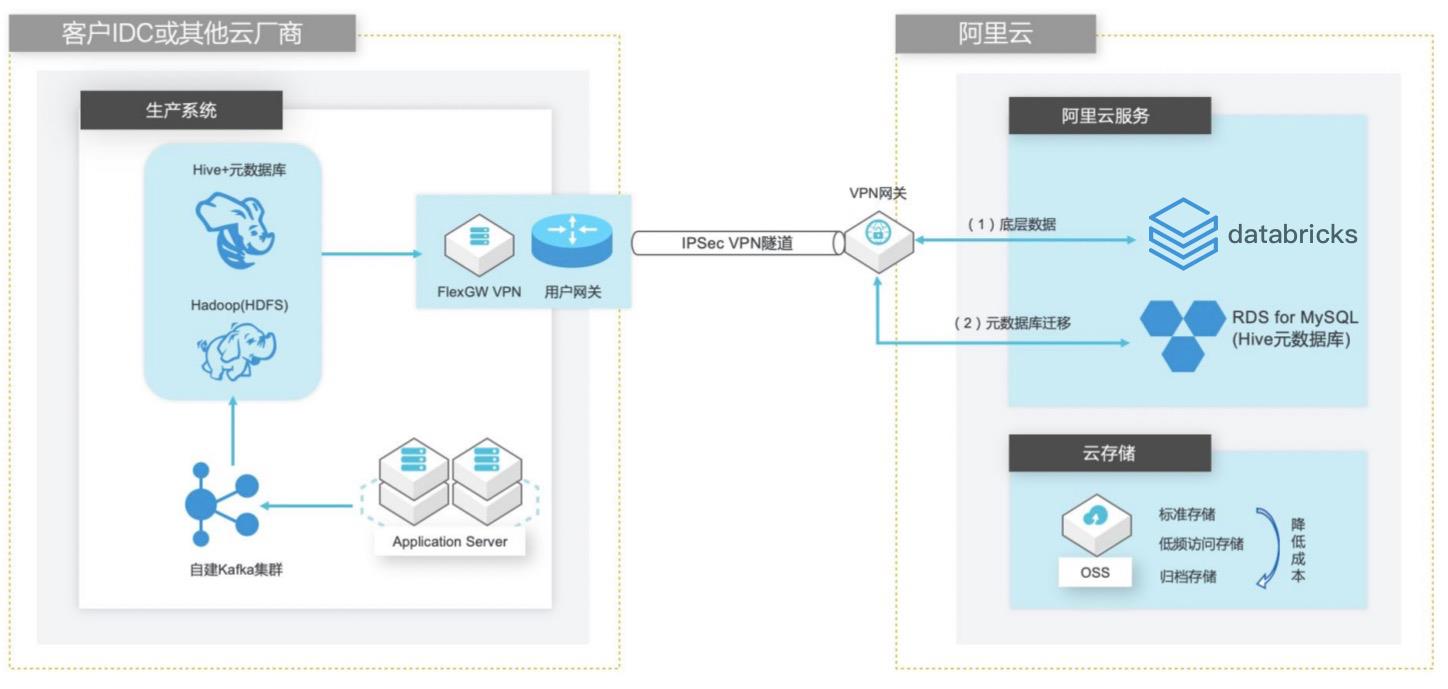

自建Hive数据仓库跨版本迁移到阿里云Databricks数据洞察

场景描述 客户在IDC或者公有云环境自建Hadoop集群构建数据仓库和分析系统,购买阿里云Databricks数据洞察集群之后,涉及到数仓数据和元数据的迁移以及Hive版本的订正更新。 方案优势 1. 全托管Spark集群免运维,节省人力成本。 2. Databricks数据洞察与阿里云其他产品(OSS、RDS、MaxCompute、EMR)进行深度整合,支持以这些产品为数据源的输入和输出。 3. 使用Databricks Runtime商业版引擎相比开源Spark性能有3-5倍的提升。 解决问题 1. Hive数仓数据迁移OSS方案。 2. Hive元数据库迁移阿里云RDS方案。 3. Hive跨版本迁移到Databricks数据洞察使用Delta表查询以提高查询效率。

自建 Hive数据仓库跨版本迁移到阿里云 Databricks数据洞察 业务架构 场景描述 客户在 IDC或者公有云环境自建 Hadoop集群 构建数据仓库和分析系统,购买阿里云 Databricks数据洞察集群之后,涉及到数仓数 据和元数据的迁移以及 Hive版本的订正更新。方案优势 1.全托管 Spark集群免运维,节省人力成 本。2.Databricks数据洞察...

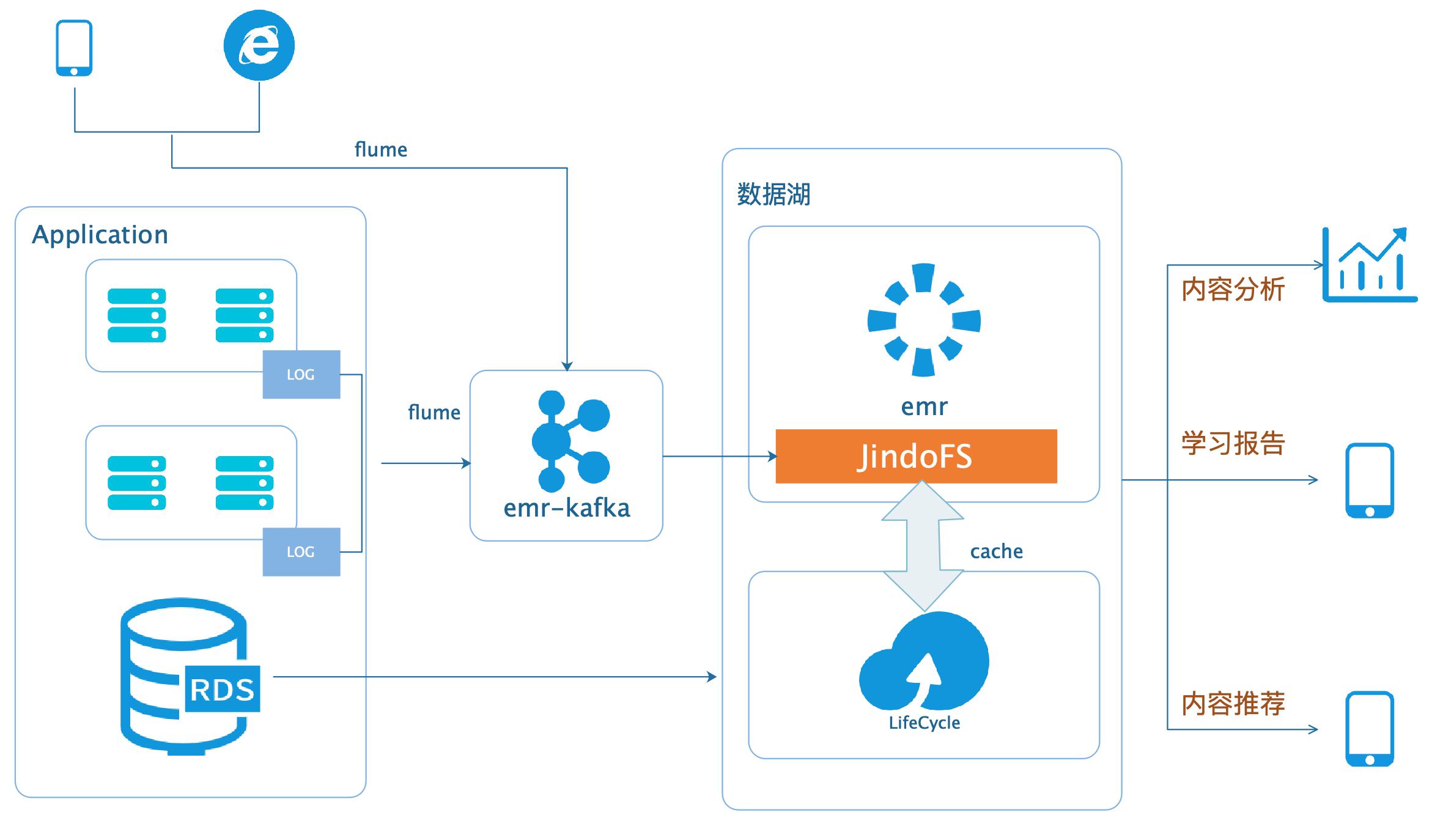

数据湖-在线学习场景数据分析

场景描述 本场景以在线教育中一个答题闯关类的应用为 例,使用WebServer来模拟演示这类日志数据 的分析处理。通过Nginx和Pythonflask搭建 WebServer,模拟应用中的关键页面,比如登 录、课程内容等,之后构造若干用户使用的模拟 日志数据,投递到数据湖进行分析后获取应用 PV、UV、课程内容访问排行、平均得分等等。 解决问题 基于数据湖(EMR+OSS)搭建大数据平台。 EMR和OSS使用和配置。 数据统一存储到OSS。 产品列表 E-MapReduce 对象存储OSS 云服务器ECS 访问控制RAM 专有网络VPC

传统的Hadoop 方案中原始数据和ETL之后的数据都存储于HDFS,随着业务数据量增大,特别是在 线教育学习平台,文本、图片、音频、视频等文件对于数据存储的需求非常大,对大 数据集群规模的压力越来越大,对存储的压力越来越大,集群扩展时DataNode节点 需要退役更换,移动数据的成本很大,造成集群扩展的时间太长。...

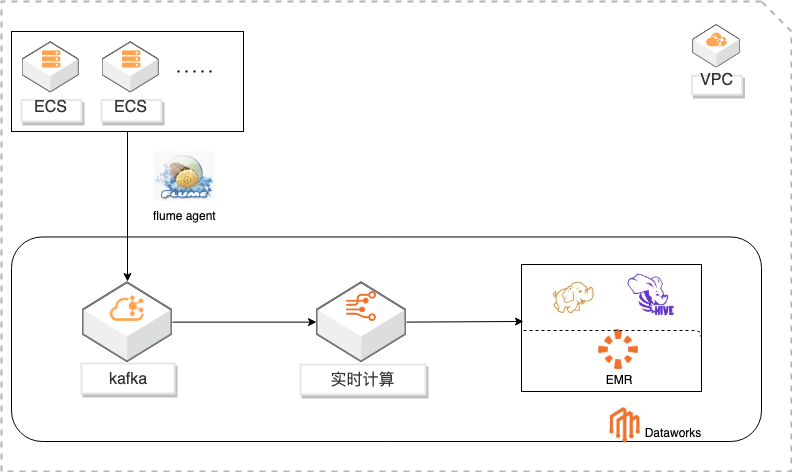

基于DataWorks的大数据一站式开发及数据治理

概述 基于Dataworks做大数据一站式开发,包含数据实时采集到kafka通过实时计算对数据进行ETL写入HDFS,使用Hive进行数据分析。通过Dataworks进行数据治理,数据地图查看数据信息和血缘关系,数据质量监控异常和报警。 适用场景 日志采集、处理及分析 日志使用Flink实时写入HDFS 日志数据实时ETL 日志HIVE分析 基于dataworks一站式开发 数据治理 方案优势 大数据一站式开发,完善的数据治理能力。 性能优越:高吞吐,高扩展性。 安全稳定:Exactly-Once,故障自动恢复,资源隔离。 简单易用:SQL语言,在线开发,全面支持UDX。 功能强大:支持SQL进行实时及离线数据清洗、数据分析、数据同步、异构数据源计算等Data Lake相关功能 ,以及各种流式及静态数据源关联查询。

基于 DataWorks的大数据一站式开发及数据治理 最佳实践 业务架构 场景描述 解决问题 本实践基于 Dataworks做大数据一站式开发,包含 日志采集、处理及分析 数据实时采集到 kafka 通过实时计算对数据进行 日志使用 Flink实时写入 HDFS ETL写入 HDFS,使用 Hive进行数据分析。通过 日志数据实时 ETL Dataworks进行数据治理,...

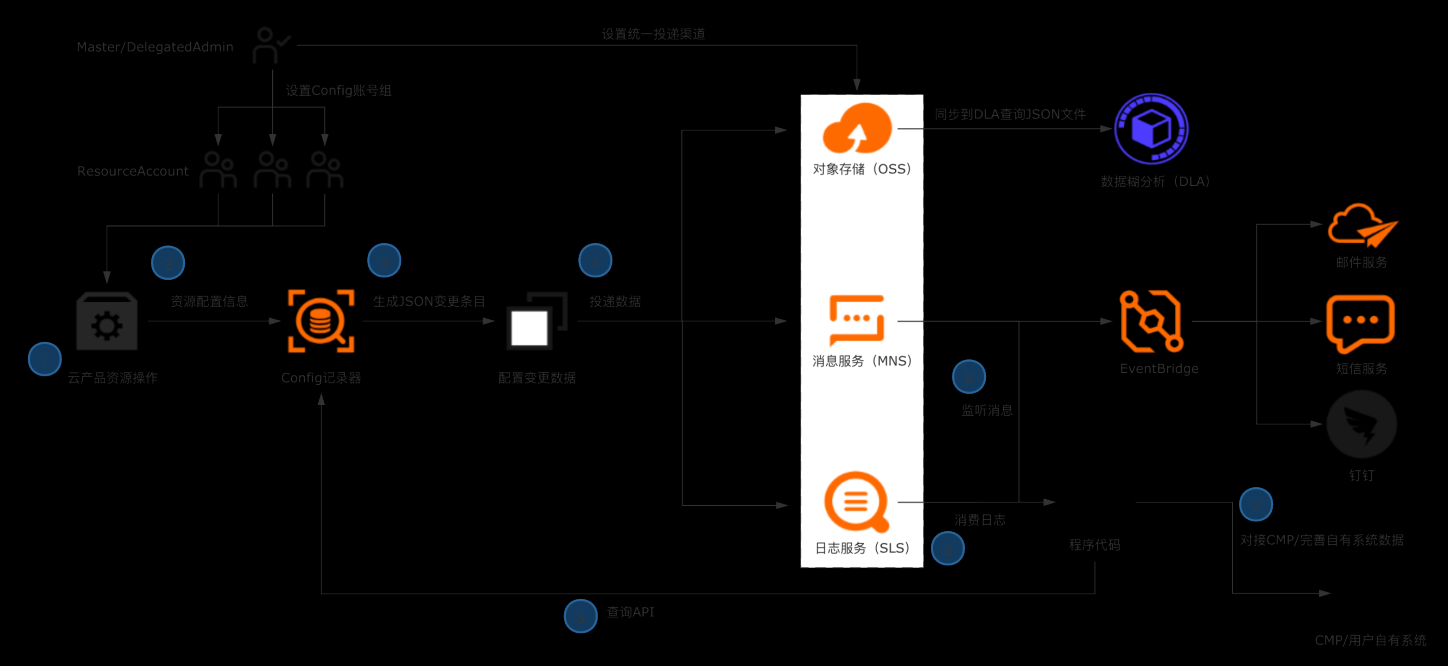

企业构建统一CMDB数据源

典型场景 l 企业/ISV构建多云CMDB平台,对接数十款产品的API,拉取、清洗、格式化、存储配置数据是复杂且高成本的工作。 l 企业日常的资源管理,需依赖资源配置历史、资源关系数据进行故障溯源和影响评估。 解决方案 l 企业管理账号设置Config配置数据投递,将所有账号的资源配置快照和历史归集到统一地址留存。 l 使用OSS做长期归档,使用SLS做实时分析和监听。获取全量资源数据并及时感知云上资源的变更。 l 将数据集成到自有CMDB平台 客户价值 l 基于配置审计简单便捷的持续收集云上资源配置数据,在自建CMDB过程中节省大量人力和时间成本。 l 跨账号统一收集数据,实现中心化的资源配置管理。 l 实现资源配置数据的持续收集和监听,及时感知云上资源的增删改,洞察异常变更。

获取ECS网络信息 本章节,我们以ECS资源的网络配置数据为例,使用 python脚本模拟将资源配置数 据导入企业自有系统。用到了配置审计的 API,在使用前需要导入阿里云 SDK 核心库:aliyun-python-sdk-core:在多账号情况下,列出主账号下指定账号 组的所有资源数据:在多账号情况下,查询指定资源的详细数据 注意:上述两个...

EMR本地盘实例大规模数据集测试

场景描述 阿里云为了满足大数据场景下的存储需求,在云 上推出了本地盘D1机型,这个系列提供了本地 盘而非云盘作为存储,提高了磁盘的吞吐能力, 发挥Hadoop的就近计算优势。阿里云EMR 产品针对本地盘机型,推出了一整套的自动化运 维方案,帮助用户方便可靠地使用本地盘机型, 不需要关注整个运维过程同时数据的高可靠和 服务的高可用。 解决问题 1.云盘多份冗余数据导致成本高 2.磁盘吞吐量不高 3.节点的高可靠分布问题 4.本地盘与节点的故障监控问题 5.数据迁移时自动决策问题 6.自动故障节点迁移与数据平衡问题 产品列表 EMR(E-MapReduce) 本地盘 VPC

Master节点 通常可以生成 1TB的数据进行基准性能测试,首先进入 hive-testbench目录下执行如 下脚本并加载测试数据 参数说明:数据集规模参数单位为 GB,1000表示生成的数据量为 1TB/tpcdata/tpcds 为表数据生成的目录,目录不存在就自动生成,如果不指定目录,数 据目录就默认生成到/tmp/tpcds目录下 cd hive-testbench#如果...

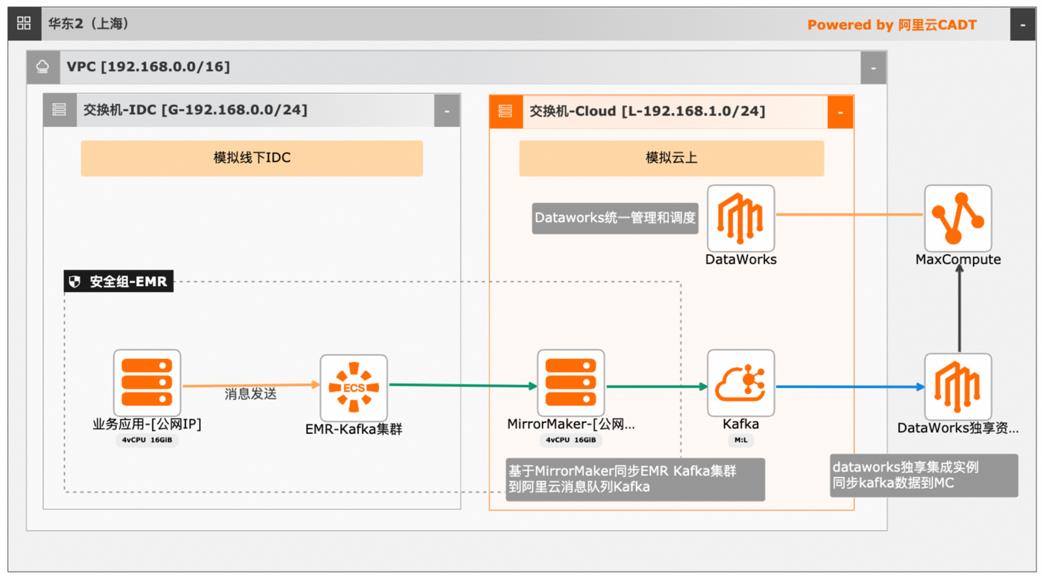

大数据近实时数据投递MaxCompute

本文介绍离线大数据场景使MaxCompute构建云 上近实时数仓,打通云下数据上云链路,解决数据复杂类型支持和动态分区问题,满足高级数据处理需求的最佳实践。 l混合云环境下,现有业务系统零改造,打通数据上云链路。 l使用UDF实现复杂数据类型转换和数据动态分区。 l使用DataWorks配置周期调度业务流程,数据自动入仓。 l借助MaxCompute优化计算引擎,实现降本增效。 产品列表 云服务器ECS 专有网络VPC 访问控制RAM 数据总线DataHub E-MapReduceEMR DataWorks 大数据计算服务MaxCompute

上近实时数仓,打通云下数据上云链路,解决数据复 使用 UDF实现复杂数据类型转换和数据动态分 杂类型支持和动态分区问题,满足高级数据处理需求 区。的最佳实践。使用 DataWorks配置周期调度业务流程,数据自 产品列表 动入仓。借助 MaxCompute优化计算引擎,实现降本增 云服务器 ECS 效。云消息队列 Kafka 最佳实践频道 ...

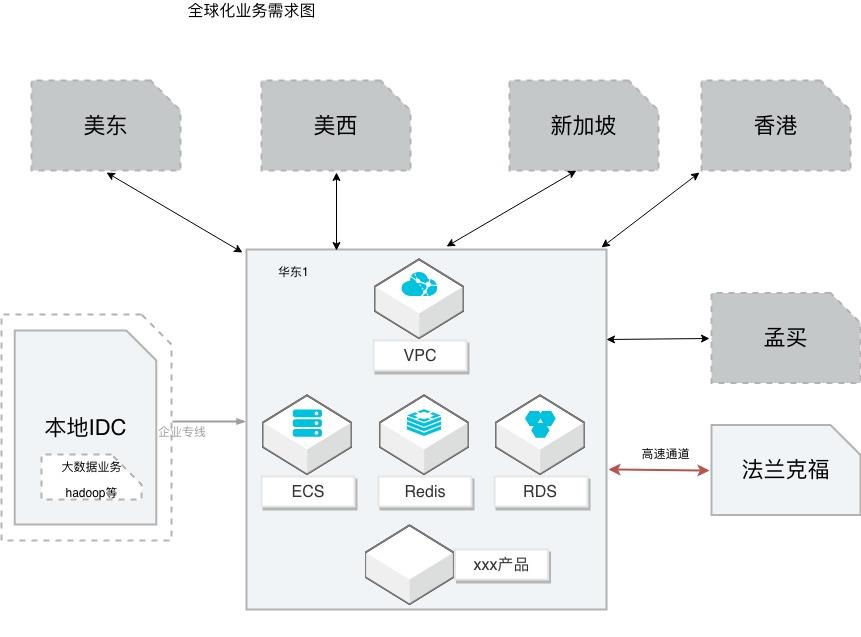

互联网业务全球化互通组网

场景描述 本方案适用从事全球化业务的客户,希望借助全球 互通的网络,实现多地域的互通。 同时在全球互联的网络下,搭建应用多地部署。如果 业务中涉及到高速通道,提供高速通道迁移云企业网 的操作演练;涉及到跨账号多VPC下的数据迁移和 同步,本方案提供详细的操作步骤,帮助客户快速完 成演练。 解决问题 借助云企业网解决网络互通 高速通道到云企业网的平滑迁移 RDS的数据互通,特别是跨账号多VPC的数据同步 应用的快速部署 产品列表 云企业网(CEN)、云服务器(ECS)、数据库(RDS)、 数据库(Redis)、数据传输(DTS)、负载均衡(SLB) 块存储、专有网络(VPC)

制作人 阿瑟、明誉 审阅人 云护、江柳 文档变更记录 版本编号 日期 作者 审核人 说明 V1.0 2019-05-07 阿瑟、明誉 云护 创建 V1.1 2019-07-25 阿瑟-更新模版 V1.2 2019-11-04 阿瑟 江柳 增加跨账号多VPC的数 据同步 V1.3 2019-11-13 筱晖-文档优化 V1.4 2019-12-17 阿瑟 增加概览页 文档版本:20191217 I 互联网业务全球化...

阿里云最佳实践离线大数据workshop

本最佳实践,首先搭建一个简化的电商 demo 系统,然后为此 demo 系统构建一套离 线大数据分析系统。 实践目标 1. 学习搭建一个离线大数据分析系统,学习从数据采集到数据存储和业务分析的业 务流程。 2. 整个离线大数据分析系统全部基于阿里云产品进行搭建,学习掌运用各个服务组 件及各个组件之间如何联动。 背景知识要求 熟练掌握 SQL 语法 对大数据体系系统知识有一定的了解

MaxCompute向用户提供了完善的数据导入方 案以及多种经典的分布式计算模型,能够更快速的解决用户海量数据计算问题,有 效 降 低 企 业 成 本,并 保 障 数 据 安 全。详 见:https://help.aliyun.com/product/27797.html Dataworks:DataWorks基于MaxCompute/EMR/MC-Hologres等大数据计算引 文档版本:20210802(发布...

来自:

最佳实践

相关产品:云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,日志服务(SLS),大数据计算服务 MaxCompute,DataV数据可视化,数据总线,Quick BI,云速搭

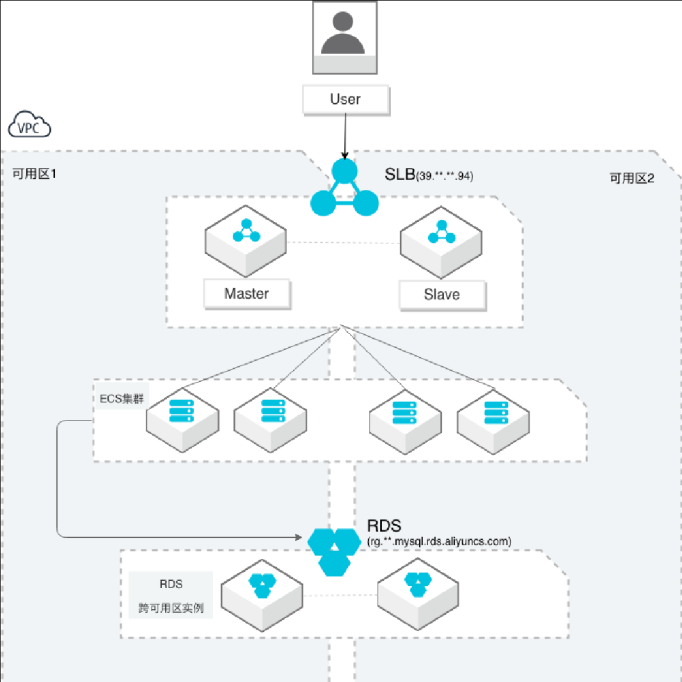

同地域跨可用区容灾

场景描述 面向阿里云公共云客户, 1.业务在同一个地域(Region) 2.应用已经无状态 3.在不大幅增加成本的情况下,希望获得支持业务的跨可用区(Zone)容灾能力 3.希望对整体的应用做容灾备份(简称容灾),而非单独的数据库或存储等 解决问题 提供云上高可用架构方案并提供可参考的跨可用区架构提供简单的容灾演练 产品列表 云服务器(ECS)、数据库(RDS)、专有络(VPC)、负载均衡(SLB)、消息队列(MQ)等

希望对整体的应用做容灾备份(简称容灾),而非单独的数据库或存储等 解决问题 提供云上高可用架构方案 并提供可参考的跨可用区架构 提供简单的容灾演练 遇到问题或使用建议和意见 请扫钉钉二维码,联系 owner 产品列表 云服务器(ECS)、数据库(RDS)、专有络(VPC)、负载均衡(SLB)、消息队列(MQ)等 云服务器 ECS...

金融专属大数据workshop

实践目标 学习搭建一个实时数据仓库,掌握数据采集、存储、计算、输出、展示等整个业务流程。 整个实时数据仓库系统全部基于阿里云产品进行架构搭建,用户可以掌握并学会运用各个服务组件及各个组件之间如何联动。 理解阿里云原生实时离线一体数仓解决方案架构以及掌握交付落地的实践使用方法。 前置知识要求 熟练掌握SQL语法 对大数据体系系统知识有一定的了解

在HoloWeb控制台,选择SQL编辑器,然后点击新增SQL窗口,选择对应的数 据库,编辑填写相应的DDL建表语句(默认数据表的属性是列存模式,列存模式更 适合OLAP数据分析,数据表的行存模式更适合高QPS点查询场景)。1.首先创建ads_province_info表。文档版本:20210803(发布日期)39阿里云最佳实践金融大数据WorkShop 最佳...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

大数据workshop

大数据workshop

在 HoloWeb控制台,选择 SQL编辑器,然后点击新增 SQL窗口,选择对应的数 据库,编辑填写相应的 DDL建表语句(默认数据表的属性是列存模式,列存模式更 适合 OLAP数据分析,数据表的行存模式更适合高 QPS点查询场景)。1.首先创建 ads_province_info表。文档版本:20210628(发布日期)42 阿里云最佳实践大数据 WorkShop ...

来自:

最佳实践

相关产品:块存储,云服务器ECS,云数据库RDS MySQL 版,对象存储 OSS,弹性公网IP,数据传输,DataWorks,大数据计算服务 MaxCompute,DataV数据可视化,实时计算,数据总线,Quick BI,Hologres

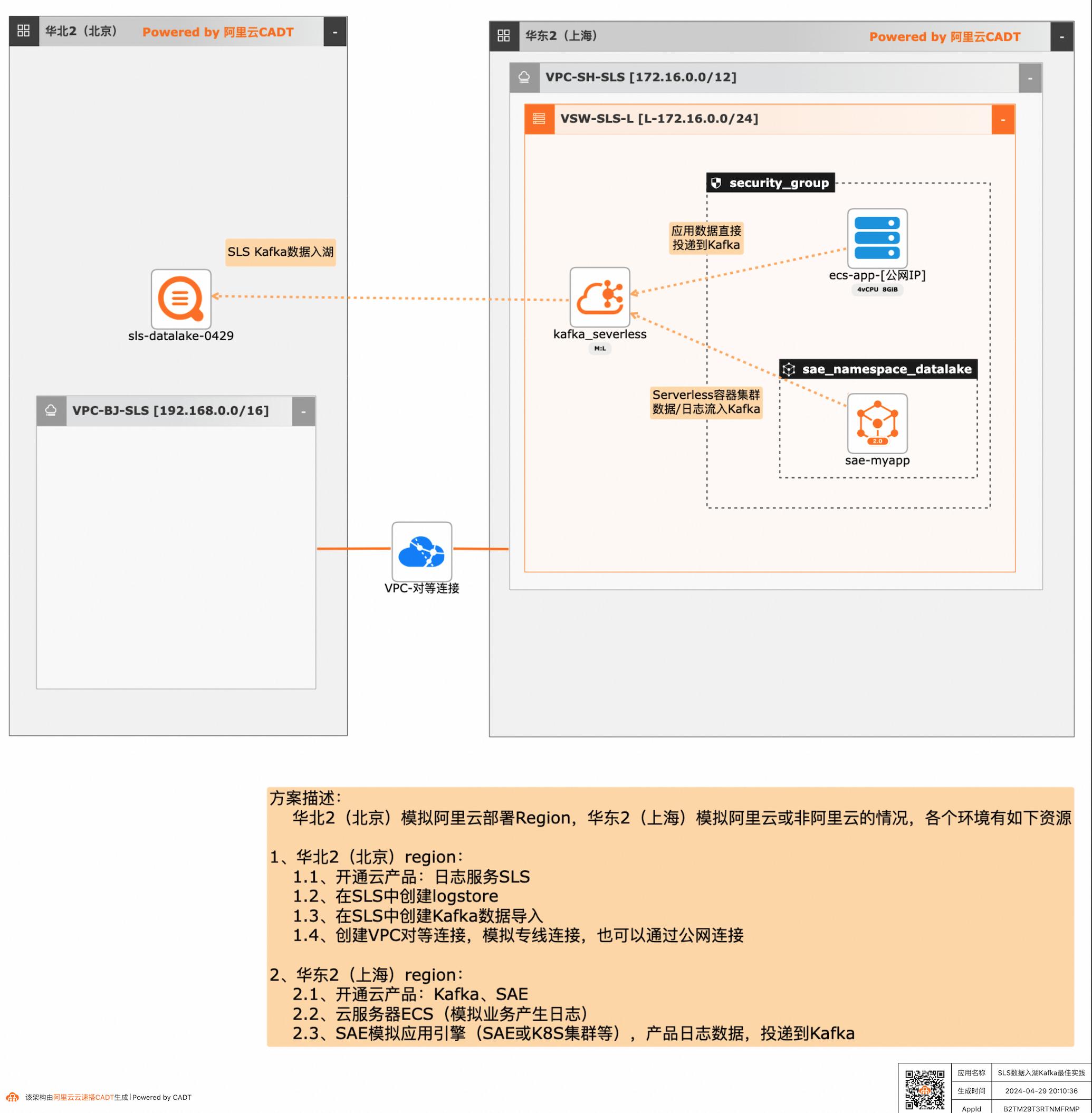

SLS数据入湖Kafka最佳实践

应用和数据分散在多云或混合云,在面对多云/混合云这样大的趋势下,数据无法进行统一的聚合、分析处理和导出等,本方案给出了在多云/混合云场景下,构建通过标准的Kafka协议和托管服务,SLS可以连接Kafka数据入湖导入,然后进行统一的海量数据的集中存储、智能转储、聚合分析查询等。

SLS 数据入湖 Kafka 最佳实践 业务架构 场景描述 应用和数据分散在多云或混合云,在面对多云/混合云这样大的趋势下,数据无法进行统一的 聚合、分析处理和导出等,本方案给出了在多 云/混合云场景下,构建通过标准的Kafka协议 和托管服务,SLS可以连接Kafka数据入湖导 入,然后进行统一的海量数据的集中存储、智 能转储、...

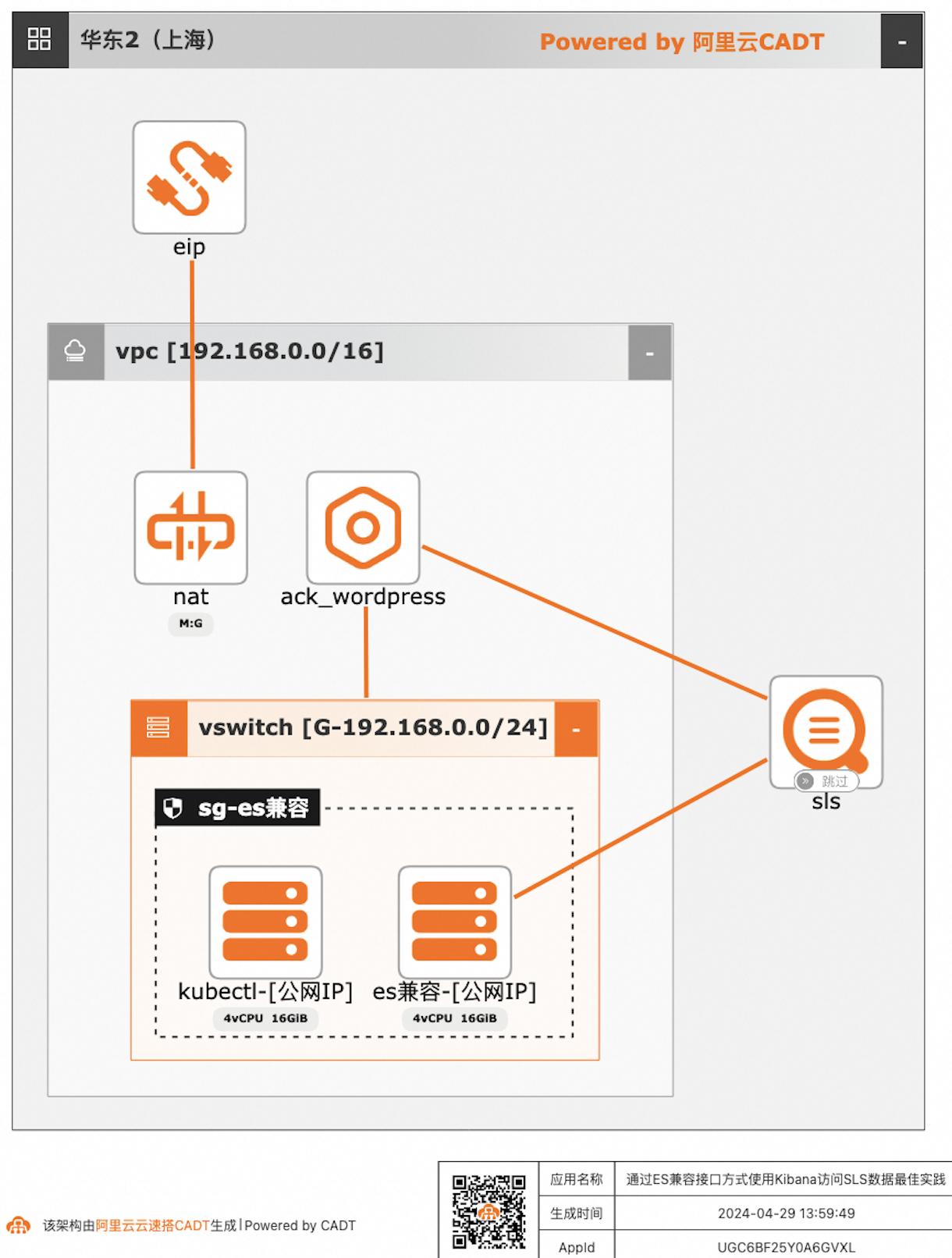

通过ES兼容接口方式使用Kibana访问SLS数据

自建ELK日志系统的客户迁移到阿里云日志服务SLS后,对SLS查询分析语法不太熟悉的客户,可以继续沿用原有的查询分析习惯,在不改变使用方式习惯的情况下,通过Elasticsearch兼容接口的方式使用Kibana访问SLS。

应用场景 自建ELK日志系统的客户迁移到阿里云日志服 务SLS后,对SLS查询分析语法不太熟悉的客 户,可以继续沿用原有的查询分析习惯,在不改 变使用方式习惯的情况下,通过Elasticsearch 兼容接口的方式使用Kibana访问SLS。解决问题 如何使用ACK部署Wordpress应用,并使 用SLS采集容器日志到SLS 最大程度保障Elastic...

1分钟部署幻兽帕鲁游戏服务器

近期幻兽帕鲁、雾锁王国等游戏备受追捧,其对计算资源与带宽有较高的要求。为确保游戏过程的流畅度与优质体验,玩家需要配备性能好、稳定可靠的游戏服务器。

产品解决方案文档与社区权益中心定价云市场合作伙伴支持与服务了解阿里云备案控制台方案导读方案介绍方案优势应用场景方案部署1分钟部署幻兽帕鲁游戏服务器近期幻兽帕鲁、雾锁王国等游戏备受追捧,其对计算资源与带宽有较高的要求。为确保游戏过程的流畅度与优质体验,玩家需要配备性能好、稳定可靠的游戏服务器。本方案为...

来自:

解决方案

基于函数计算实现直播流录制-存储-通知

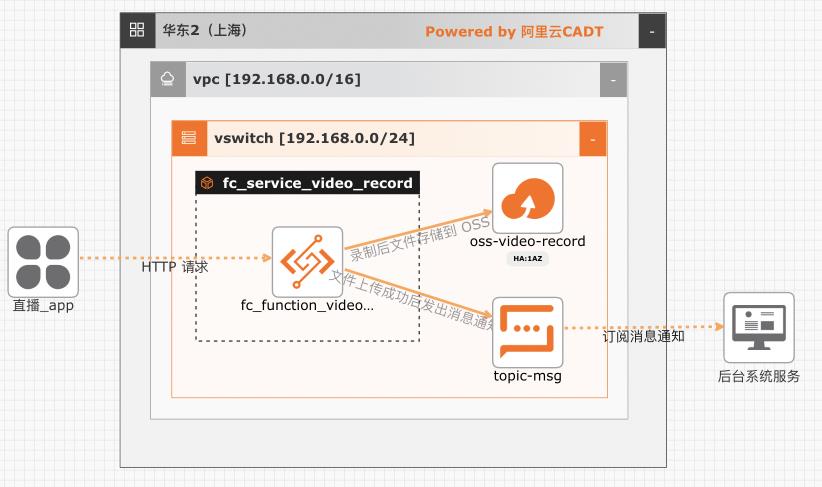

在互娱、教育、电商等行业都会有直播相关的业务,大部分场合都需要对直播相关的业务做安全审核,或者对直播的课程进行录制和转码。该方案实现了一种完全按需拉起、按量弹性、按实际使用付费的录制方案。基于本方案还可以扩展实现直播流截帧、自动化安全审核等能力

基于函数计算实现直播流录制-存储-通知最佳实践 业务架构 场景描述 基于阿里云函数计算实现对直播流的实时录制,录制结束后会把录制的结果写入 OSS 存储桶,并把录制的结果写到消息队列,下游服务可以通 过订阅的方式来消费消息 应用场景 在互娱、教育、电商等行业都会有直播相关的业 务,大部分场合都需要对直播相关的业务...

- 产品推荐

- 这些文档可能帮助您