从海量到价值,泛时序数据一站式分析与洞察

泛时序数据广泛存在于车联网、工业物联网、金融交易、股票分析等业务场景。随着业务增长带来的数据量激增,如何高效地获取和分析这些数据成为业务洞察和决策的关键挑战,Lindorm作为阿里云自研的云原生多模数据库,具备低成本存储、弹性高可用的能力,提供一站式的分析与洞察。

在线部署 适用客户 有车联网、金融、日志等海量数据处理场景 寻求“宽表+搜索+分析”大数据组合方案的一站式替代 方案优势 为什么选择 Lindorm 使用Lindorm对泛时序数据进行一站式的处理分析,不仅在开发效率和成本效益上超越传统自建方式,更在性能优化和运维便捷性上提供卓越表现。预处理效率高 支持接收实时数据,进行流...

来自:

技术解决方案

日志服务 SLS 产品概述

阿里云日志服务SLS为 Log/Metric/Trace 等可观测数据提供一站式提供数据采集、加工、分析、告警可视化与投递、存储功能,兼容开源ELK,满足运维监控与分析,业务分析,安全审计等场景需求。

查看更多极致性能近实时日志写入与流式存储,提供高性能日志查询与时序查询分析引擎,支持超大规模、超复杂查询,每秒查询千亿行日志/分析数十亿行日志,百万时间线秒级计算。查看更多高性价比无需从零搭复杂的开源框架,免去人工运维成本;100%Serverless化服务,无需规划资源用量;提供多种按量计费模式,灵活应对业务...

来自:

云产品

多源集成,极致性能,搭建轻量OLAP分析平台

本方案基于阿里云Hologres和DataWorks数据集成,通过简单的产品操作即可完成数据库RDS实时同步数据到Hologres,并通过Hologres强大的查询分析性能,完成一站式高性能的OLAP数据分析。

在线部署 适用客户 有提高复杂分析性能的需求 有统一分析平台技术栈需求 有提升分析稳定性降低成本需求 方案优势 复杂的OLAP场景带来一系列技术挑战 在这个以数据驱动决策为核心的时代,OLAP分析成为了企业大数据技术栈中越来越核心的方向。但是技术栈选择多、查询性能慢、数据不一致、多处维护、数据需求响应慢等难题极大...

来自:

技术解决方案

向量检索服务 Milvus 版

阿里云向量检索服务Milvus版是一款云原生开源向量检索引擎,为用户提供多模态检索服务和高效稳定的向量数据检索能力,与云计算等产品集成对接,为AI应用场景的数据工程提供便利。

在开源版版本的基础上增强了稳定性、可用性与可扩展性,能提供超大规模向量数据的相似性检索服务。查看详情阅读产品文档,了解更多产品优势产品优势拥抱开源持续拥抱开源Milvus和AI生态坚持100%兼容开源生态,在AI、搜索推荐等领域内,坚持与开源社区一起共建产品能力。向客户提供兼容程度高,迁移成本低,灵活可控的全托管...

来自:

云产品

数据迁移上云

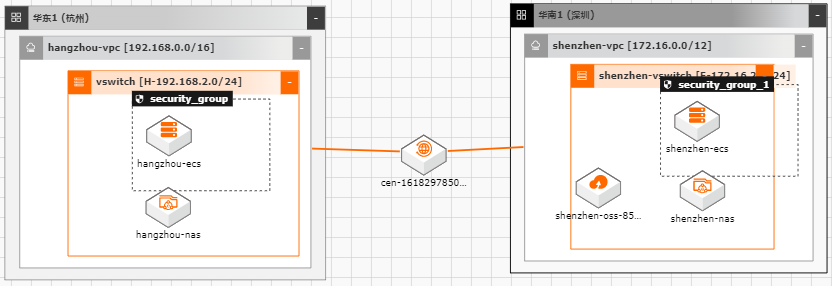

随着越来越多的企业选择将业务系统上云,各种类型的数据如何便捷、平滑的迁移上 云,成了用户上云较为关注的点;业务上云后,因为业务或者其他方面调整等因素, 也存在如跨区域,跨账号等数据迁移的场景。针对以上需求,阿里云上提供了较为丰 富的工具(如ossimport)、服务(在线迁移服务),旨在能够帮助客户便捷进行数据迁 移。 本文通过云架构设计工具CADT来快速创建云上基础资源,并以杭州区域来模拟线 下IDC(或友商),深圳区域模拟阿里云云上资源。通过云上的工具命令、服务来提 供常见数据迁移场景的最佳实践。

您可以将 ossimport部署在任意多台可以访问您待迁移数据,且可以访问 OSS的机器上。说明:当您待迁移的数据过大时,为了节约时间,您可以将 ossimport部署到与您 OSS 相同地域的 ECS实例上,并通过专线将源数据存放的服务器挂载到阿里云 VPC网络 中。多台 ECS实例将数据通过内网迁移至 OSS,会极大的提升数据迁移效率。2.2....

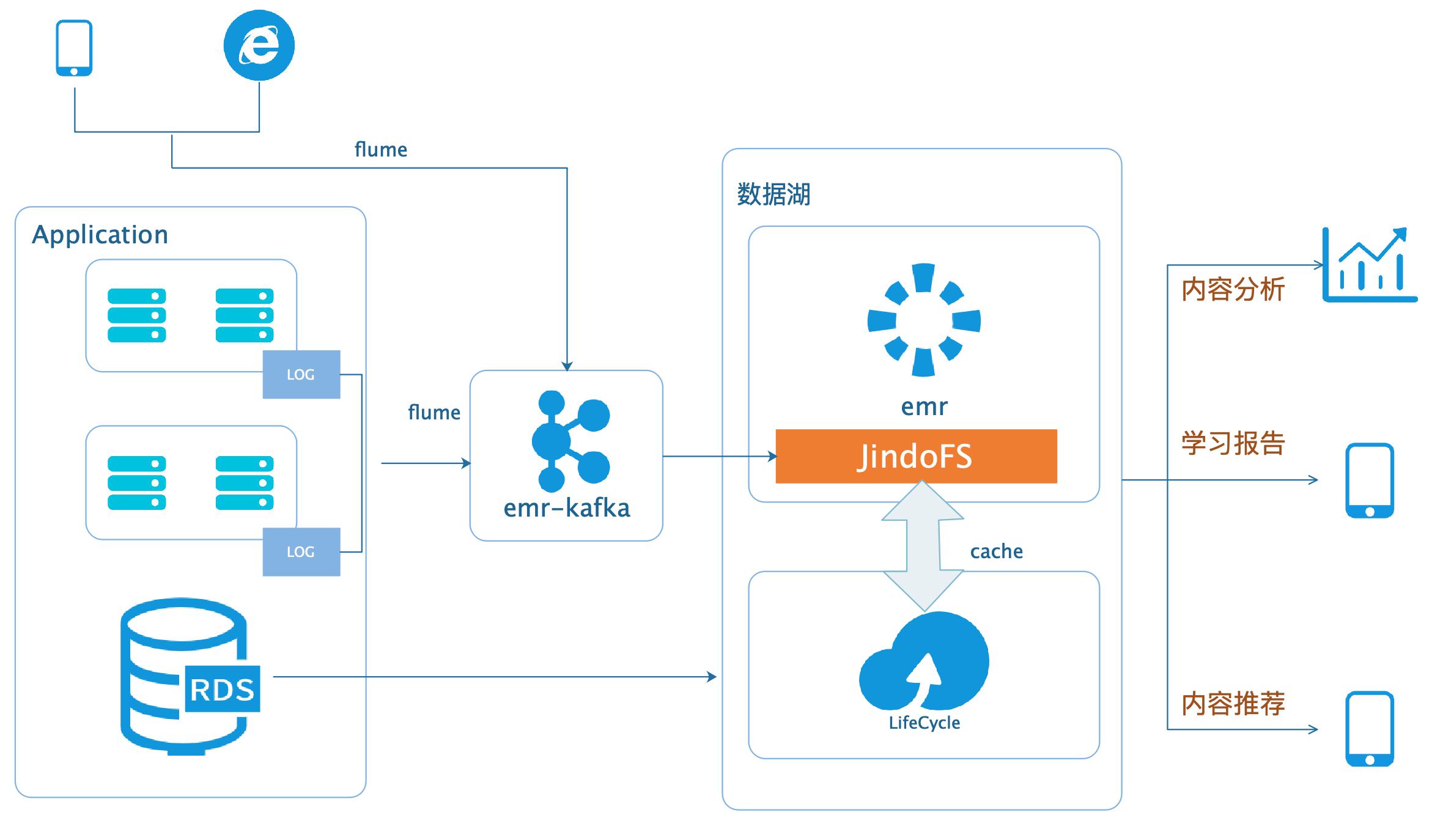

数据湖-在线学习场景数据分析

场景描述 本场景以在线教育中一个答题闯关类的应用为 例,使用WebServer来模拟演示这类日志数据 的分析处理。通过Nginx和Pythonflask搭建 WebServer,模拟应用中的关键页面,比如登 录、课程内容等,之后构造若干用户使用的模拟 日志数据,投递到数据湖进行分析后获取应用 PV、UV、课程内容访问排行、平均得分等等。 解决问题 基于数据湖(EMR+OSS)搭建大数据平台。 EMR和OSS使用和配置。 数据统一存储到OSS。 产品列表 E-MapReduce 对象存储OSS 云服务器ECS 访问控制RAM 专有网络VPC

传统的Hadoop 方案中原始数据和ETL之后的数据都存储于HDFS,随着业务数据量增大,特别是在 线教育学习平台,文本、图片、音频、视频等文件对于数据存储的需求非常大,对大 数据集群规模的压力越来越大,对存储的压力越来越大,集群扩展时DataNode节点 需要退役更换,移动数据的成本很大,造成集群扩展的时间太长。...

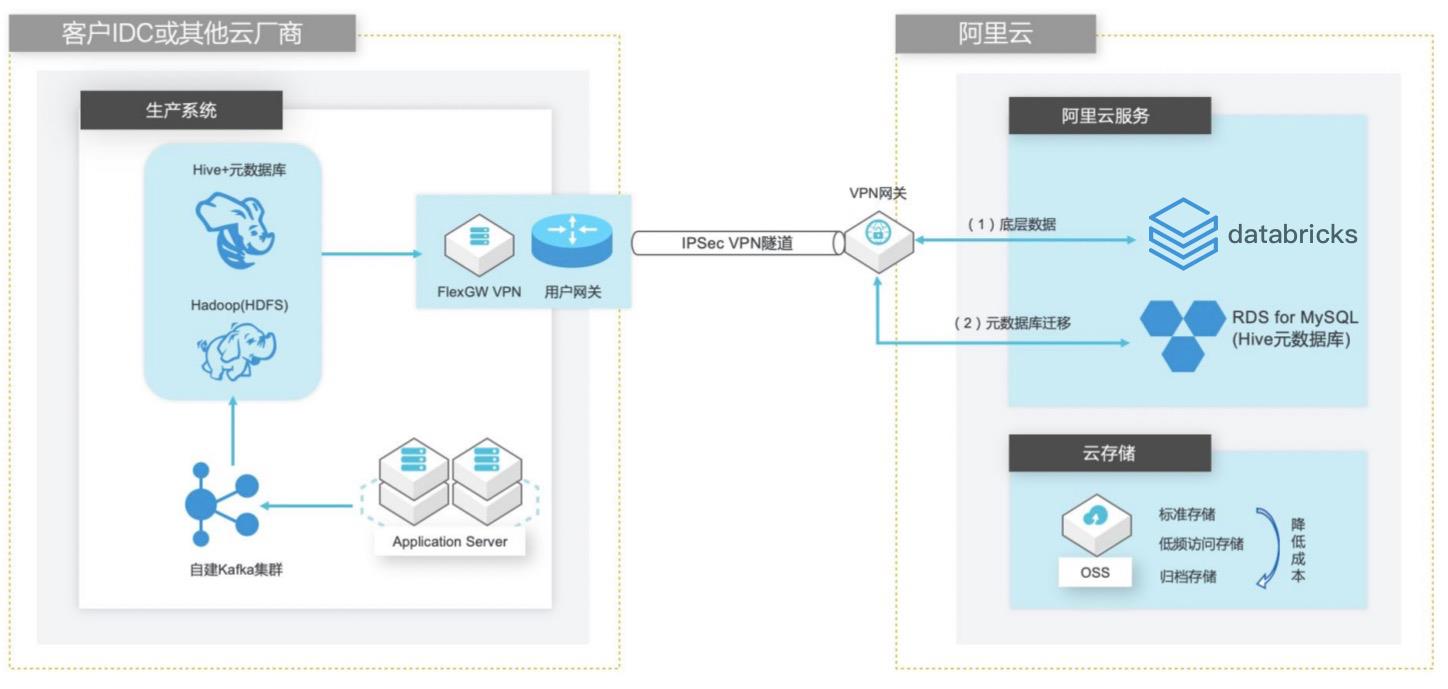

自建Hive数据仓库跨版本迁移到阿里云Databricks数据洞察

场景描述 客户在IDC或者公有云环境自建Hadoop集群构建数据仓库和分析系统,购买阿里云Databricks数据洞察集群之后,涉及到数仓数据和元数据的迁移以及Hive版本的订正更新。 方案优势 1. 全托管Spark集群免运维,节省人力成本。 2. Databricks数据洞察与阿里云其他产品(OSS、RDS、MaxCompute、EMR)进行深度整合,支持以这些产品为数据源的输入和输出。 3. 使用Databricks Runtime商业版引擎相比开源Spark性能有3-5倍的提升。 解决问题 1. Hive数仓数据迁移OSS方案。 2. Hive元数据库迁移阿里云RDS方案。 3. Hive跨版本迁移到Databricks数据洞察使用Delta表查询以提高查询效率。

自建 Hive数据仓库跨版本迁移到阿里云 Databricks数据洞察 业务架构 场景描述 客户在 IDC或者公有云环境自建 Hadoop集群 构建数据仓库和分析系统,购买阿里云 Databricks数据洞察集群之后,涉及到数仓数 据和元数据的迁移以及 Hive版本的订正更新。方案优势 1.全托管 Spark集群免运维,节省人力成 本。2.Databricks数据洞察...

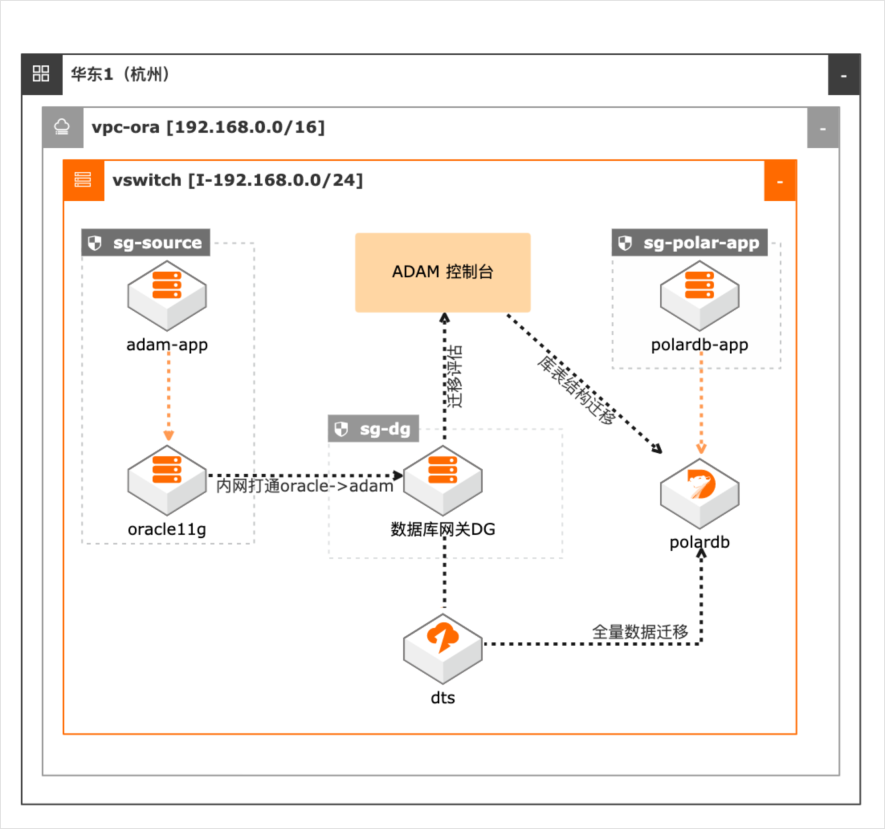

Oracle数据库与应用迁移PolarDB

场景描述 本最佳实践适用于Oracle数据库及应用迁 移到阿里云PolarDB数据库(Oracle兼容 版)。通过ADAM将Oracle数据库迁移到 PolarDB数据库,可以降低应用升级、运 维成本,同时提升系统弹性,实现数据库 及应用全栈上云。 解决问题 1.解决Oracle及其应用迁移上阿里云, 通过ADAM评估迁移工具,降低迁移 风险,提高迁移效率。 2.使用PolarDB(Oracle兼容版)数据 库,提升数据库并发读能力,降低运维 成本。 产品列表 数据库和应用迁移(ADAM) PolarDB(Oracle兼容版) 云服务器(ECS) 专有网络(VPC)

本文仅 涉及全量数据迁移,对于需要增量迁移、数据回流等需求的用户,可以联系阿里云 数据库专家服务。4.1.配置目标 PolarDB实例 步骤1 登录 PolarDB控制台 https://polardb.console.aliyun.com/cn-hangzhou/clusters,点 击目标 PolarDB实例。步骤2 增加集群白名单 文档版本:20220210 35 Oracle数据库与应用迁移 PolarDB ...

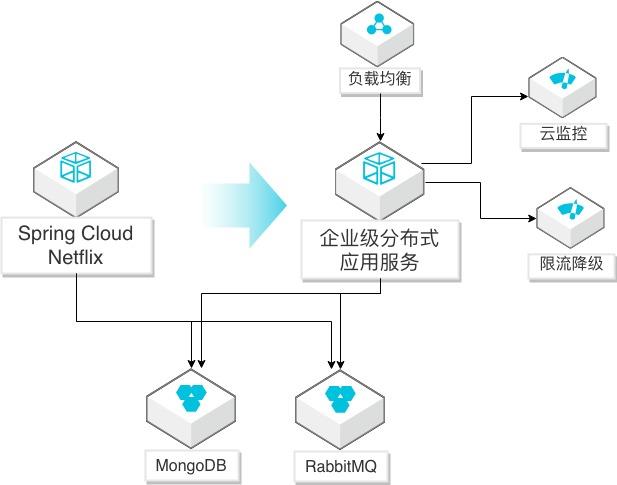

Spring Cloud Netflix应用迁移EDAS

场景描述 Spring Cloud Netflix微服务应用迁移到EDAS 服务(SpringCloud Alibaba云版本)的方法, 迁移后充分利用阿里云监控、调用链、限流降级 等能力,优化应用生命周期管理。 解决问题 1.帮助自建SpringCloudNetflix微服务应用 通过简单修改迁移到阿里云企业级分布式 应用服务(EDAS)平台。 2.迁移到EDAS后,简化应用的运维,提升监 控、调用链探测、限流降级等管理能力,提 高对应用的全生命周期管理。 产品列表 企业级分布式应用服务(EDAS) 负载均衡(SLB) 专有网络(VPC) 云服务器(ECS)

演示从 Spring Cloud应用迁移迁移到阿里云 EDAS仅需要对配置文件进行修改,对依赖包和对接服务修改后可以直接部署在 EDAS平台。通过应用部署到 EDAS平台,利用 EDAS提供的配置管理、服务注册、限流降级 能力,实现更稳定和高效的应用服务能力。通过应用部署到 EDAS平台,利用 EDAS提供的调用链分析、ARMS应用监控能 力,...

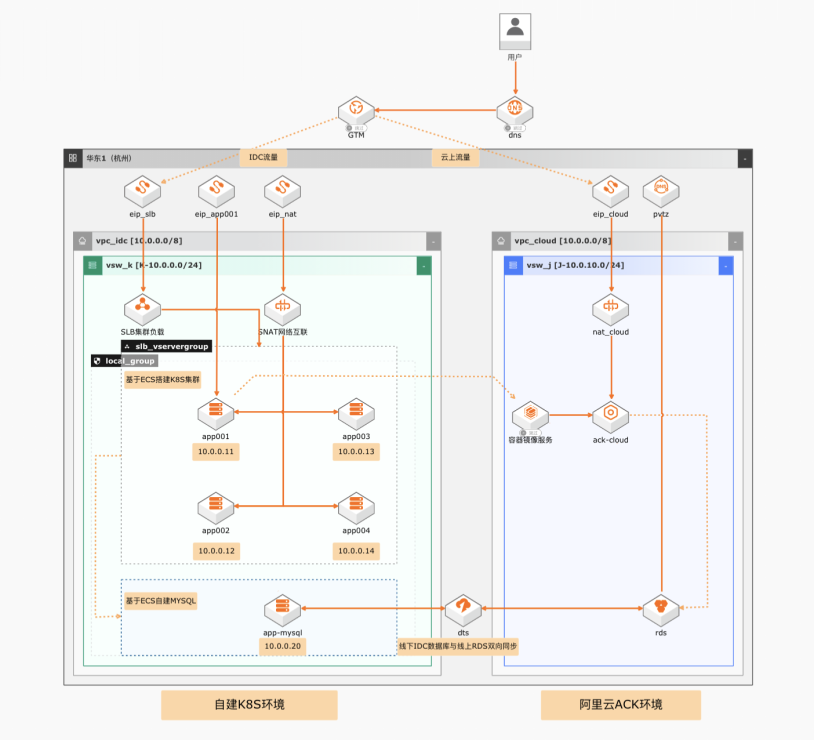

自建K8S集群迁移ACK弹性裸金属集群

场景描述 在微服务化改造之后,企业在享受K8S带来应 用管理的便利的同时,存在硬件性能不足,本 地扩展性差,容器容灾难,K8S管理复杂等问 题。 解决问题 1.增强K8S扩展性:如何通过弹性裸金属服务 器的强劲硬件性能,实现云端资源急速扩 展,从容应对应用访问压力大的问题。 2.如何简化云端K8S运维:通过阿里云容器服 务(ACK)实现敏捷开发和部署落地,加速 企业业务迭代。 3.如何综合考虑迁移和容灾:如何整合云上和 云下容器资源实现遇到故障时可以通过健 康检查实现自动容灾。 4.如何不改应用上云:如何实现应用上云数据 库连接零修改。 5.数据库上云及回退:如何实现上云回退; 产品列表 ACK/ECS/SLB/NAT网关/弹性裸金属服务器/DTS/RDS MySQL

详 见:https://www.aliyun.com/product/rds/mysql DTS:Data Transmission Service,简称 DTS,是一种集数据迁移、数据订阅及 数据实时同步于一体的数据传输服务。解决远距离、毫秒级异步数据传输难题。详 见:https://www.aliyun.com/product/dts 全局流量管理:全局流量管理(Global Traffic Manager),简称 GTM,可以...

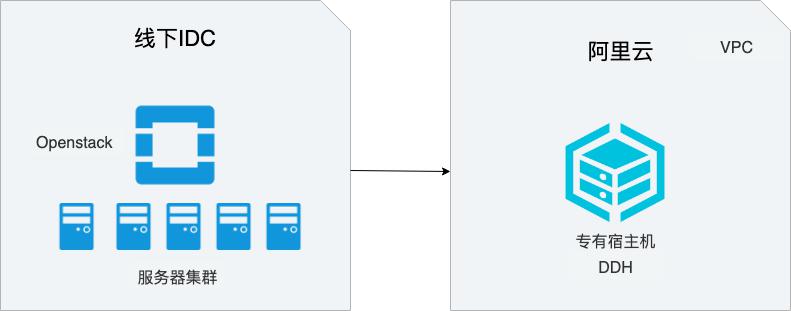

Openstack迁移DDH

场景描述 在线下IDC中,很多用户使用OpenStack构建云环境,本 文介绍如何将线下IDC中基于OpenStack构建的云服务器 迁移到阿里云专有宿主机(DDH)上,从而实现业务平滑 上云的同时,显著降低成本。 解决问题 1.如何将OpenStack中的云服务器迁移 DDH上。 2.如何使用DDH构建云上环境。 产品列表 专有宿主机DDH 对象存储OSS 服务器迁移中心SMC 专有网络VPC

如何将OpenStack中的云服务器迁移 迁移到阿里云专有宿主机(DDH)上,从而实现业务平滑 DDH上。上云的同时,显著降低成本。2.如何使用DDH构建云上环境。产品列表 专有宿主机DDH 对象存储OSS 服务器迁移中心SMC 专有网络VPC 云服务器ECS(产品名称)文档模板(手册名称)/文档版本信息 阿里云 企业上云实践 ...

Databricks数据洞察

阿里云Databricks数据洞察是基于Apache Spark的全托管数据分析平台, 内核采用更高效、稳定的商业版Databricks Runtime和Delta Lake。可满足数据分析师、数据工程师和数据科学家在大数据场景下对数据湖分析、实时数仓、离线数仓、BI数据分析、AI机器学习等需求

Databricks 数据洞察.Databricks数据洞察是基于Apache Spark的全托管数据分析平台,内核采用更高效稳定的商业版Databricks Runtime和Delta Lake,满足用户对数据湖分析、实时数仓、离线数仓、BI数据分析、AI机器学习等场景需求。因产品服务策略调整,本产品将于2023年10月23日停止全面支持,并将于2024年4月23日停止服务....

来自:

云产品

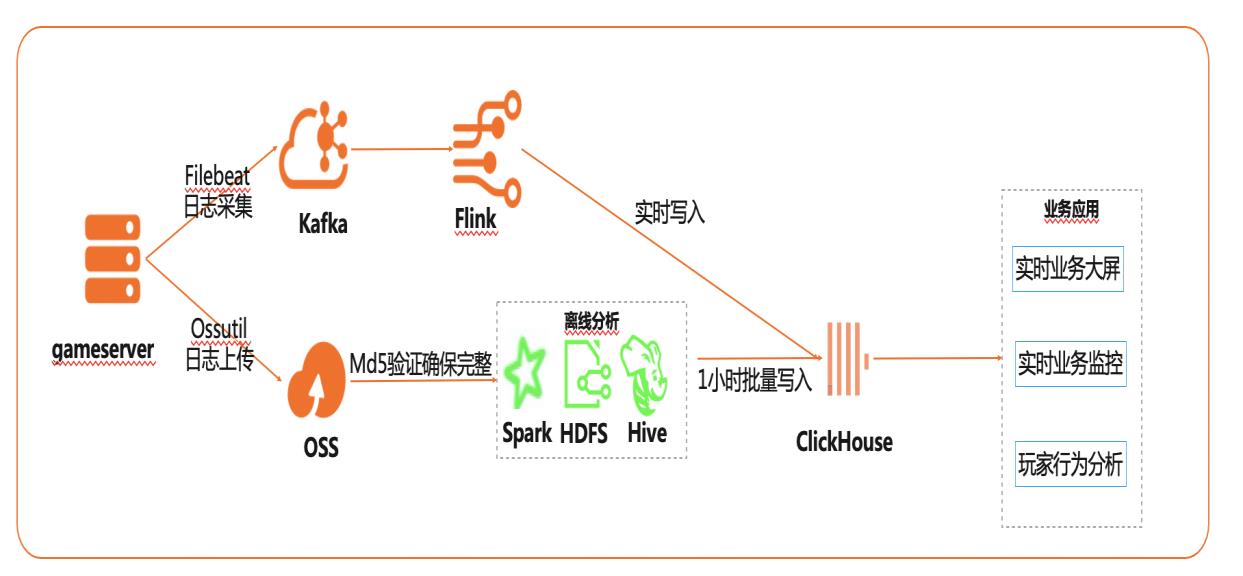

基于Flink+ClickHouse构建实时游戏数据分析

在互联网、游戏行业中,常常需要对用户行为日志进行分析,通过数据挖掘,来更好地支持业务运营,比如用户轨迹,热力图,登录行为分析,实时业务大屏等。当业务数据量达到千亿规模时,常常导致分析不实时,平均响应时间长达10分钟,影响业务的正常运营和发展。 本实践介绍如何快速收集海量用户行为数据,实现秒级响应的实时用户行为分析,并通过实时流计算Flink/Blink、云数据库ClickHouse等技术进行深入挖掘和分析,得到用户特征和画像,实现个性化系统推荐服务。 通过云数据库ClickHouse替换原有Presto数仓,对比开源Presto性能提升20倍。 利用云数据库ClickHouse极致分析性能,千亿级数据分析从10分钟缩短到30秒。 云数据库ClickHouse批量写入效率高,支持业务高峰每小时230亿的用户数据写入。 云数据库ClickHouse开箱即用,免运维,全球多Region部署,快速支持新游戏开服。 Flink+ClickHouse+QuickBI

本实践介绍如何快速收集海量用户行为数 据,实现秒级响应的实时用户行为分析,并 通过实时流计算、云数据库 ClickHouse等 技术进行深入挖掘和分析,得到用户特征和 画像,实现个性化系统推荐服务。产品列表 最佳实践频道 阿里云最佳实践分享群 专有网络 VPC 弹性公网 IP EIP 云服务器 ECS 消息队列 Kafka版 云数据库 ...

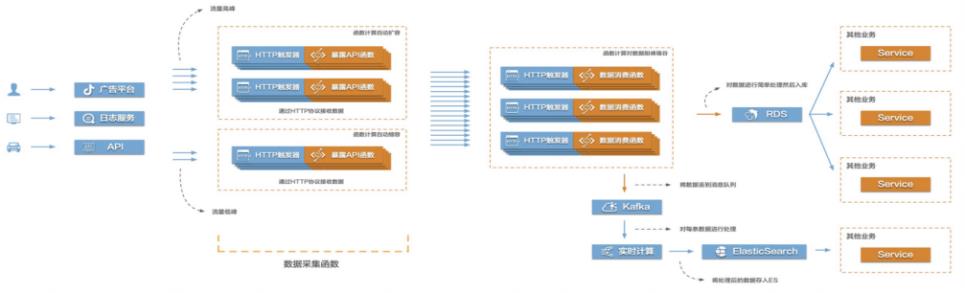

Function Compute构建高弹性大数据采集系统

当前互联网很多场景都存在需要将大量的数据信息采集起来然后传输到后端的各类系统服务中,对数据进行处理、分析,形成业务闭环。比如游戏行业中的游戏发行、游戏运营,产互行业中的数字营销,物联网、车联网行业中的硬件、车辆信息上报等等。这些场景普遍存在数据采集量大、数据传输需要稳定且吞吐量大的特点,给整个数据采集传输系统带来很大的挑战。在这个场景中,有三个关键的环节,数据采集、数据传输、数据处理。该最佳实践主要涉

步骤1 进入函数计算控制台,找到我们创建的服务下的 fun01这个函数,需要在函数详情页在 线编辑 Python代码,代码修改如下:#-*-coding:utf-8-*-import logging import json import urllib.parse#引入函数计算库 import fc2 client=None HELLO_WORLD=b'Hello world!' def my_initializer(context):logger=logging.getLogger...

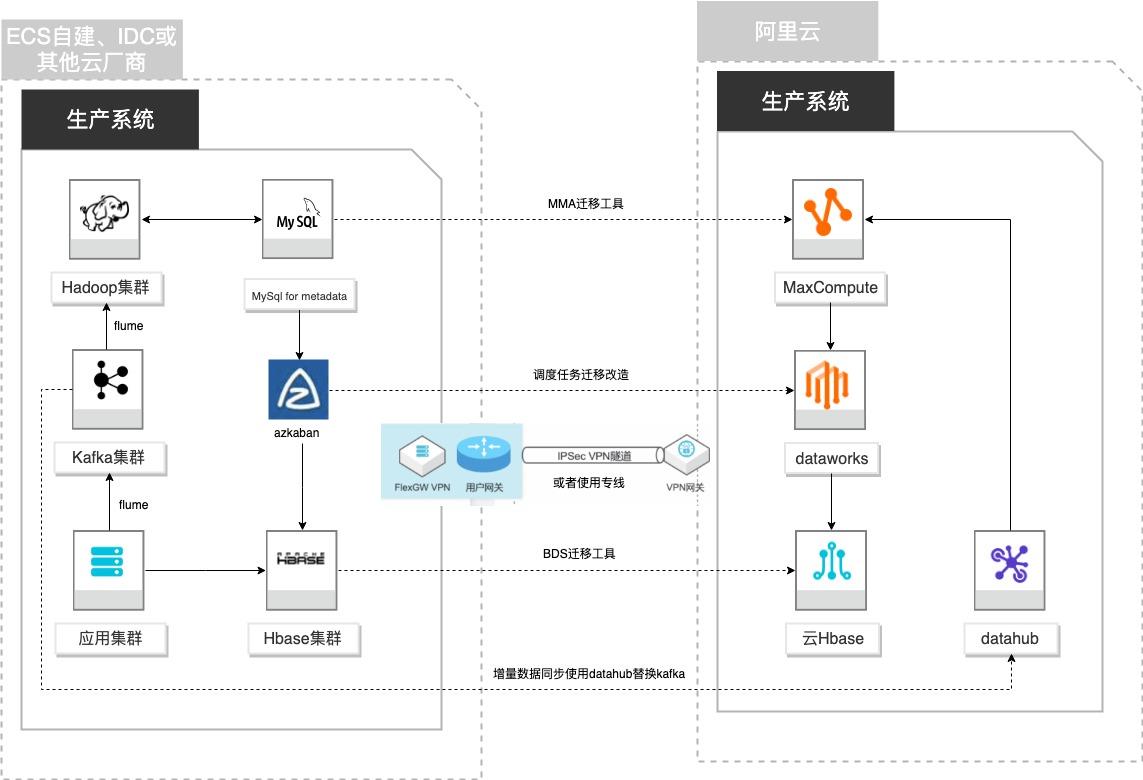

自建Hadoop迁移MaxCompute

场景描述 客户基于ECS、IDC自建或在友商云平台自建了大数 据集群,为了降低企业大数据计算平台的成本,提高 大数据应用开发效率,更有效保障数据安全,把大数 据集群的数据、作业、调度任务以及业务数据库整体 迁移到MaxCompute和其他云产品。 解决的问题 自建Hadoop集群搬迁到MaxCompute 自建Hbase集群搬迁到云Hbase 自建Kafka或应用数据准实时同步到 MaxCompute 自建Azkaban任务迁移到Dataworks任务 产品列表 MaxCompute,Dataworks、云数据库Hbase版、Datahub、VPC,ECS。

步骤3 新建数据集成离线同步任务 文档版本:20210723 51 自建Hadoop迁移MaxCompute Azkaban定时任务迁移和改造 步骤4 双击离线同步任务节点,进行编辑 步骤5 选择数据源并设置分区信息:说明:分区信息将决定,抽取源表中的哪些分区的数据,并插入到目标表的哪个分区,是整个数 据同步任务的关键。在本例中,源表 datahub_...

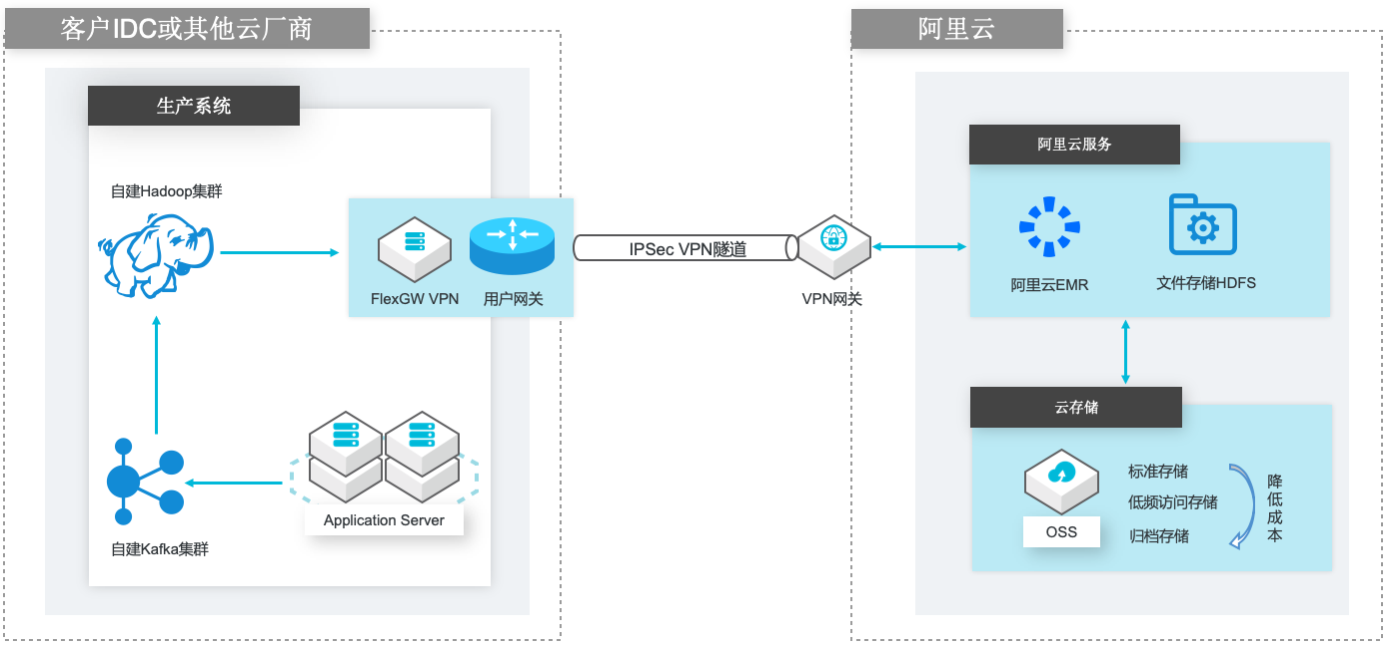

自建Hadoop迁移到阿里云EMR

场景描述 场景1:自建Hadoop集群数据(HDFS)迁移到 阿里云EMR集群的HDFS文件系统; 场景2:自建Hadoop集群数据(HDFS)迁移到 计算存储分离架构的阿里云EMR集群,以OSS 和JindoFS作为EMR集群的后端存储。 解决的问题 客户自建Hadoop迁移到阿里云EMR集群的 技术方案; 基于IPSecVPN隧道构建安全和低成本数据 传输链路 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

文档版本:20210714 46 自建Hadoop数据迁移到阿里云 EMR 启动数据迁移任务 此时在 EMR集群的 master节点查看文件大小,进一步和自建 Hadoop集群上文件大 小进行比对:EMR集群上的文件大小:hadoop fs-du/usr/dfs/data/flume/kafka 自建 Hadoop集群文件大小,替换下面红色字体为实际的 IP地址:hadoop fs-du hdfs:/192.168....

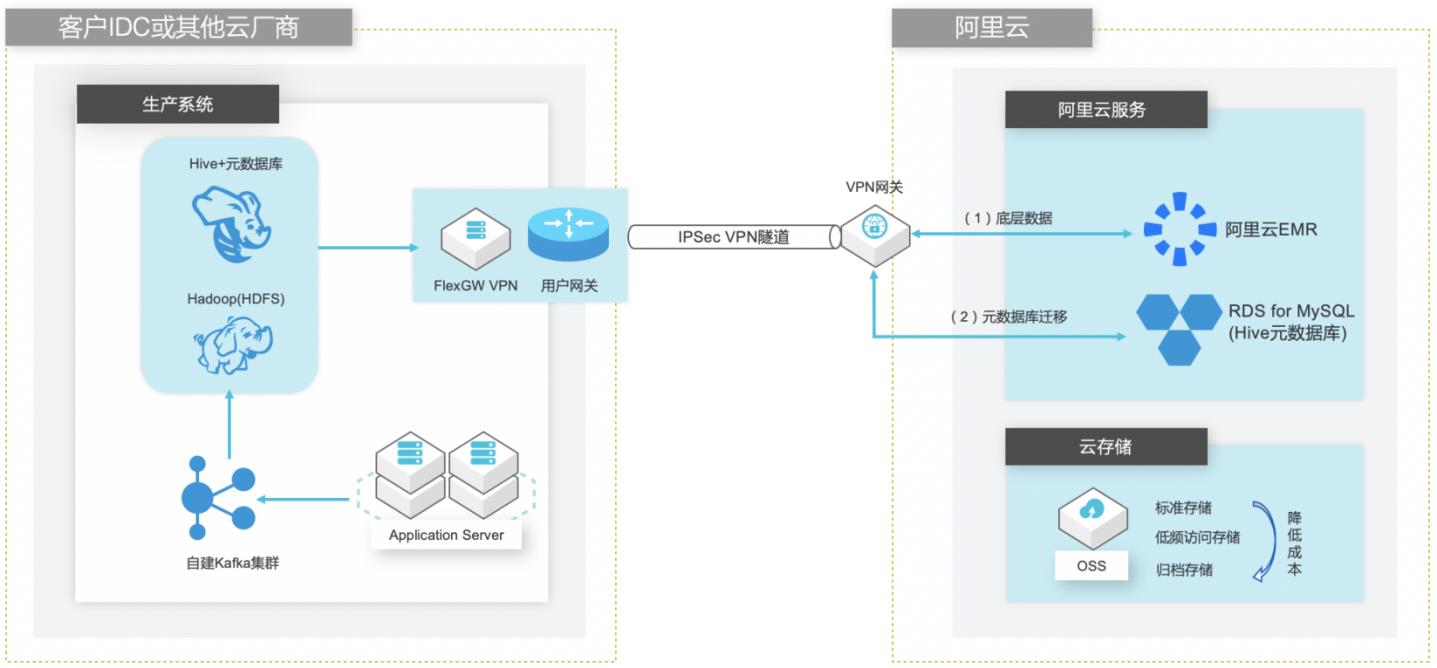

自建Hive数仓迁移到阿里云EMR

场景描述 客户在IDC或者公有云环境自建Hadoop集群构 建数据仓库和分析系统,购买阿里云EMR集群之 后,涉及到将数据仓库和Hive元数据的数据库迁 移上云。目前主流Hive数据仓库迁移场景为1.x 版本迁移到阿里云EMR(Hive2.x版本),涉及到 数据订正更新步骤。 解决的问题 Hive数据仓库的数据迁移方案 Hive元数据库的迁移方案 Hive跨版本迁移后的数据订正 产品列表 E-MapReduce,VPC,ECS,OSS,VPN网关。

客户在决策上云之后,会将自建 Hadoop集群的数据迁 移到阿里云 EMR集群。在迁移过程中,Hive迁移主要分为三部分:底层数据迁移 保存在 HDFS的数据可通过 Hadoop原生的 DistCp工具进行迁移,详细迁移方案 请参考:《自建 Hadoop数据迁移到阿里云 EMR》最佳实践...

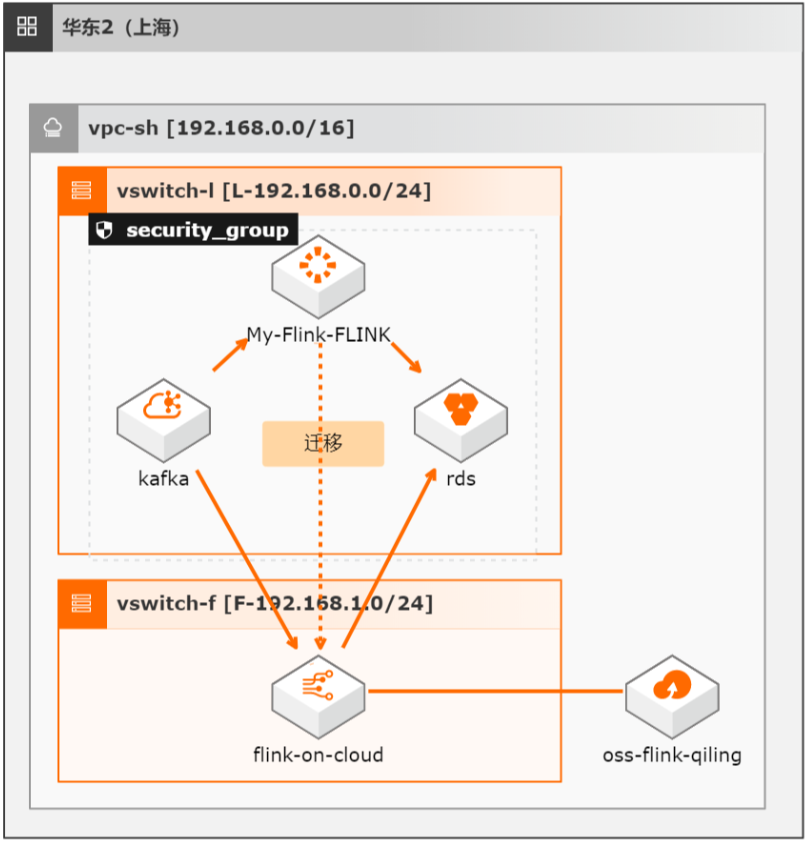

开源Flink迁移实时计算Flink全托管版最佳实践

本方案介绍如何将自建开源Flink集群的流式任务(包含Datastream、Table/SQL、PyFlink任务)迁移至阿里云实时计算全托管版。

比如聚合任务按小时、天维度计算的聚合值,清洗任务加工的按天分区表等,在数据对比时就可以根据对应的时间周期来进对比,比如小时周期的任务实际已完整处理多个小时数据 后,就可以对比处理过的小时数 据,而天维度的聚合值,一般就需要等待新任务处理完完整的一天数 据后才能对比。2、数据规模 中小数据规模:建议进行全量...

- 产品推荐

- 这些文档可能帮助您