每当有深度学习框架开源时,我们也和广大的吃瓜群众一样,期冀着是不是能有一波新的浪潮,把端侧AI托上一个新的高度。但同时,出于同行们对MNN的认可,我们几乎每一次都会在对比的榜单上出镜,有时甚至是唯一竞对。高处不胜寒哪。

在正文之前,要先赞扬一下腾讯的开源精神。2017年,NCNN吹响了国内引擎开源的号角,为诸多后来者树立了榜样。而今,TNN又一次在移动性能上又迈出了一步。作为开源社区的一员,来,我们欢迎…emmm…这一位到底是该称为老戏骨还是小鲜肉…加入社区性能毒打群和谐友爱的大社区。

关于测评的一些观点

端侧AI在这两三年里,可谓高速发展,新应用、新算法、新硬件推陈出新,也不断有新推理引擎涌现。但对引擎的评价方式定格在了三年前,比较的总是ARMv7/ARM64下MobileNet、SqueezeNet、ResNet不同版本的性能比较。

这对我们而言,愈发像是一场性能的"圣杯战争" —— 性能重要吗?当然重要。能不参与吗?又无人身免。但这几个模型的性能真的是推理引擎们的终极目标吗?当然不是!如果我们的目标是真正去降低社区AI应用的门槛,就不能只停留在这些指标上。

测评报告的原初目的,应该是便于用户针对自身的业务,做出选择,而不是秀肌肉。

一个好的推理引擎应至少具有三个基本特性:

- 通用性,模型支持是一切应用的前提;

- 高性能,但快慢若脱离业务价值,也会缺失实际意义

- 易用性,能少搬几块砖,岂不美哉?

因此,行业评价推理引擎的方式亟需升级 —— 性能上,除了基准的数据,也应包含对新后端、新特性的支持情况;算子上,用户可能更关心除了CNN以外,能不能支持RNN、GAN、Transformer;易用性上,是不是有提供可视化工具、测评工具、量化工具,编程界面是不是足够友好。

为此,我们一直在努力。

高性能

虽然说不能只看性能,但点名了,还是要回应一下的。

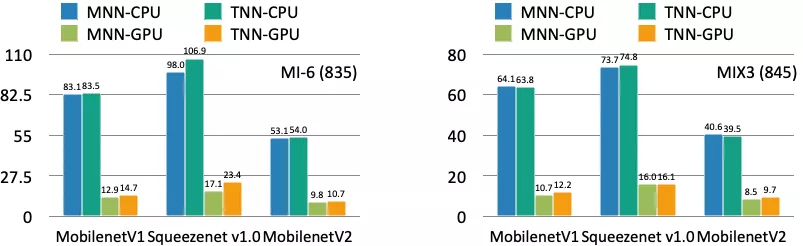

做完数据验证,虽然数据和TNN的测评稍有出入,但毕竟也为我们的工程师刷新了一个小目标。于是,我们把之前搁置的优化拎上了日程。一周不到的时间,835/845上跑小网络,CPU上,略胜一筹;GPU上,则是5 ~ 15%的领先。

但这再也不是当年从2000ms降低到700ms那样的飞跃了。

而如果我们放眼大一些的模型,比如Inception V3,那么情况会是:

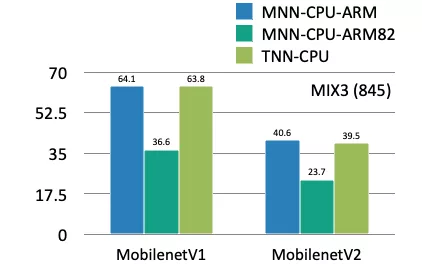

又或是打开ARM v8.2的情况下,不论是fp16还是quant,性能都可以有一段跃迁:

你看,可以为业务带来质变优化的点依然存在。而这些,正是我们暂时按下ARM优化的原因。

通用性

除了性能,用户最为关心的指标就是通用性。性能再好,业务模型跑不起来都白搭。而MNN背靠阿里巴巴的众多智能场景,久经各方业务的磨炼,在支持算子的数量、算子实现的质量上,都可谓久经考验。但如果不是MNN的死忠粉,可能都很难意识到,我们在通用性方面下的苦功。

模型转换上,我们没有将Caffe、TensorFlow、TensorFlow Lite的转换转嫁给三方的工具,尽量避免模型格式间转换导致的失败。从开源到现在,在支持的转换算子总量上,MNN翻了一番还多。

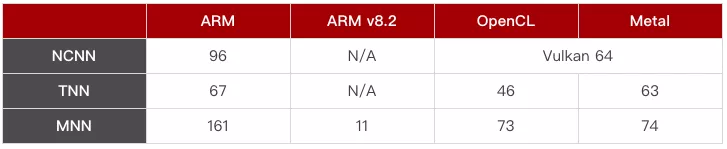

算子实现上,我们在计算后端的支持上,应该也是业界最广的。除了前文所述的ARM v8.2,我们在GPU算子的支持上,也不遑多让。

注:计算算子数量时,对Binary、Unary、Reduce算子,统一到友商口径,采用拆分成多种的方式计算。

易用性

易用性方面,在过去的一年,我们也着墨颇多。

可视化上,我们在跨平台可视化工具 Netron 上增加了对MNN模型的支持。

模型压缩上,我们的工具同时支持了KL和ADMM两种量化方式,即可以采用Post-training Quantization 降低量化门槛,也可以采用Quantization Aware Training 来提升量化的精度。

模型测评上,我们提供的校验工具和Profiler工具,可以帮助开发者快速定位模型中的问题所在。

前端语言上,我们还打通了MNN和Python的桥接,方便算法工程师们,在自己熟悉的平台、熟悉的语言上,完成开发、校验。

除了工程之外,文档示例上,我们也没落下。我们搭建了 中英文的文档集 ,也和社区一起搭建了我们的 示例集 。

想点大事

如果跳出引擎的小圈子,放眼整个AI生态圈,端侧AI近几年发展到底怎么样呢?

我们以云侧AI为标尺,可以把端侧AI拆解为上下两层:

- 基础设施

如前所述,不只是性能,推理引擎在通用性、易用性等方面还有待完善。而推理引擎也只是解决了模型在端侧运行的问题,从端侧AI部署的完整迭代来说,模型转换、模型压缩、开发调试、效果评估、算法和工程怎么高效协同等等,需要优化、提效的流程,还有很多。

- 上层应用

从应用角度来说,目前端侧AI应用的广度和深度都是不够的 —— 一方面,杀手级的应用不多,甚至基本就没有;另一方面,AI应用的门槛还比较高,很多长尾需求难以落地。可以说,端侧AI的业务价值还没有充分被挖掘出来。因此,相比于烈火烹油的云侧AI,或是三端一体的Flutter,我们都还需要和社区站在一起,做更进一步的探索。

我们真切得认为端侧AI还处于发展的初期,更需要从业者一起努力推动行业发展,而不是把弹药浪费在无尽的对比内耗上面。我们期望和大家在真正有益于繁荣AI生态的方向上,探索出一片新的空间。

端智能团队

淘宝基础平台部-端智能团队欢迎移动端计算优化工程师和推理引擎架构师的加入。对新技术感兴趣,善于创新突破,渴望用新技术给用户带来创新体验的同学请联系我们。

简历投递至吕行:chengfei.lcf@alibaba-inc.com

关注「淘系技术」微信公众号,一个有温度有内容的技术社区~