一 修复版《士兵突击》,帧享 60 帧的《重生》,你看了吗?

回想 10 年前看士兵突击的时候,29 寸电视机绝对是“大电视”。但是今天 40 寸、60 寸已经非常普遍,甚至很多家庭直接使用投影仪看剧。尺寸越来越大,我们对清晰度的要求就越高。

如何让视频更清晰?今年年初优酷联合内容制作侧、终端消费侧的产业链合作伙伴共同推出了一套超高清解决方案——帧享,从内容创作、超高清重制、终端渲染等各个环节严格把关, 精益求精,真正呈现出 “每一帧,都享受”的高水准视听效果。

《重生》是优酷重磅打造的悬疑题材热剧,很多的镜头和情节处理都非常适合叠加我们的高帧率和声场技术,所以,我们通过视频超分辨率、视频插帧、SDR 转 HDR,立体声增强等技术手段,让画面细节更细腻、让动态场景更顺滑,让声场更立体,真正做到身临其境的超爽视听体验,最重要的实现普惠,让千元安卓机也同样流畅看高清。

大家都知道,优酷创立的时间很早,视频库中有很多老视频资源,而老视频资源中存在的最普遍问题就是噪声和模糊。我们通过高清修复技术,实现批量去噪、去模糊、去划痕、去闪烁、去抖动、高帧率等能力,修补之外重新调色,用工业化方式解决老片修复问题。2006 年单机工作室修复一部两小时左右的电影需要数十天甚至上百天的时间,现在通过异构计算平台,修复一部经典电影到 4K 仅要 1 小时。比如 80 后的集体记忆:还珠格格、士兵突击、家有儿女等都在修复后换新颜。

二 用优酷追剧为什么不卡?

视频高清了,如何不卡顿?视频清晰度的选择那么多,如何选择刚刚好的模式?从地跌的“移动”网络到家的 Wi-Fi 稳定网络,如何能不麻烦的做转换?

“智能档”要解决的关键问题就是“高清不卡”,并且自动匹配合适的清晰度,这背后是自适应码率技术的支持。码率自适应技术,并不是新技术,在学术界早已有非常多的论文。但这样一个成熟“学术”技术,在真正大规模落地过程中,遇到了很多问题和挑战:

- 第一, 国内用户对这一功能很陌生,甚至觉得比较“傻”;

- 第二, 用户评判“体验好”的标准比较主观,流畅和高清的平衡点难把握;

- 第三, 公开的算法框架的实际效果不理想。原因是特征纬度单薄,对实际细节考虑少。

在技术策略之外,我们主要想分享,如何将成熟的学术算法落地到工程业务场景:

- 第一,抓住算法框架的核心点,不要太在乎结构性,要看算法解决的核心问题的切入点,和你要解决的是不是一个问题,是不是能借鉴;

- 第二,与大数据有关的算法,一定要关注好数据集的质和量,结合自身业务,积累高质量的大量数据;

- 第三,算法效果的度量标准,结合业务场景来看,尤其是那些非标准化、不好量化的场景,避免生硬的套用已有标准,毕竟你才是对问题最了解的人;

- 第四,像 AB 测试、大数据 Pipeline 等工程系统能力,确实对产品技术的迭代效率提升是非常大的。

三 前方高能!基于人脸识别的跟随弹幕来了

要高清不卡,还要参与互动。在追剧时,第一好看是剧情,第二好看是弹幕,而且有些剧里弹幕甚至比剧情还要精彩,比如上过热搜的出自《东宫》的那一句“谈恋爱吗?灭你全族的那种”。正是由于这些神一般的网友频频曝出精句,让某些剧集精彩程度翻了几倍。

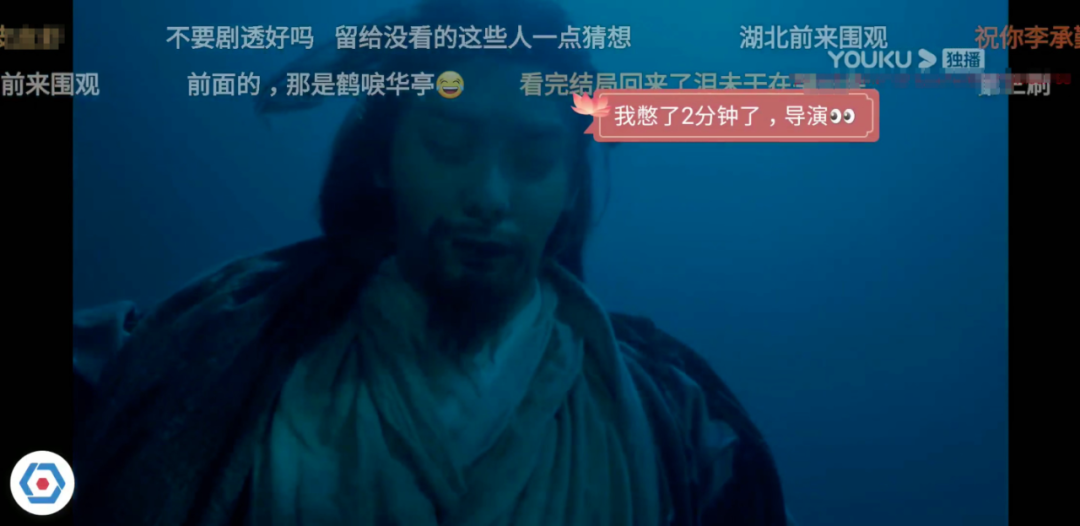

喜欢用优酷看视频发弹幕的同学应该已经发现,很多剧都上线了基于 AI 人脸识别的跟随弹幕,以往的普通弹幕或高级弹幕都是在播放器顶端自右向左以跑马灯式的效果展示,而这种跟随弹幕是以气泡样式挂在人物头像旁边,随着人物移动而移动。这种跟随弹幕可玩性更高,有才网友可发挥余地更大。

结合人物动作的玩法

结合人物所处场景的玩法

自编自导人物对话

从几个视频 demo 中可以看出,相比普通弹幕,这种跟随弹幕是以一种类似剧中人物的内心 OS 的方式展示出来的,与视频无割离感,更有趣更新颖更精彩,有更多玩法。

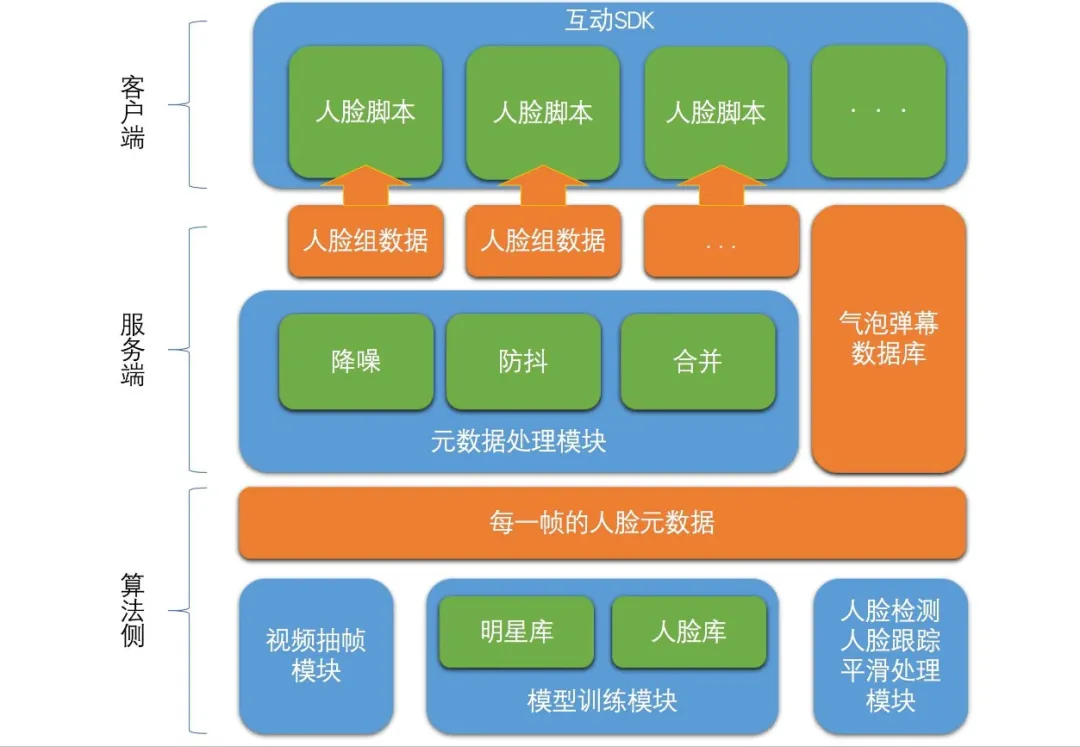

人脸跟随弹幕的架构分成算法侧、服务端、客户端三层:

首先,算法侧按每秒 25 帧的频率进行视频抽帧,对每一帧进行人脸识别,配合人脸跟踪和平滑处理,生成每一帧的人脸元数据;

其次,服务端将多个帧的人脸元数据通过降噪、防抖、合并后组合成一组组的人脸组数据,将该数据与跟随弹幕数据一起下发给客户端;

最后,客户端在互动 SDK 中将每组人脸数据生成一个脚本,脚本中完成弹幕跟随该人脸轨迹的移动而移动。

剧中的人脸数据如果只应用在跟随弹幕中就大材小用了,下一步我们准备把带有人脸数据和人体数据的脚本做为基本脚本,后面除了跟随弹幕脚本,还会有弹幕穿人脚本等等。后续客户端这部分架构可能会调整,方便大家通过外部注入等方式,构建自己想要的脚本。

四 让你自然美的实时直播美颜技术

看高清、发弹幕还是不过瘾?那就来直播。在经历了在家上课,在家办公之后,非常多的一线教师、职员、程序员都开启了直播之路。打开摄影头,心里有点发慌?实时直播美颜技术,让你1秒变美,而且是自然的美。

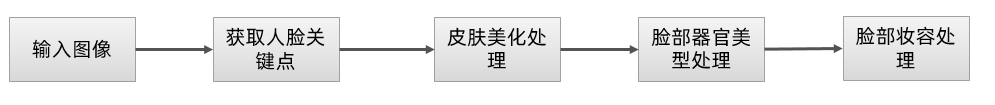

为达成人脸美颜效果,在技术上我们主要通过以下四个关键步骤来实现:

其中,脸部美型处理主要包括脸型调整和脸部器官调整,核心步骤是基于人脸关键点通过图像形变的形式来实现脸部各器官的形状调整。图像形变算法主要是局部扭曲算法和三角剖分,局部扭曲算法一般包括局部缩放、局部平移、局部旋转等,如大眼功能即可通过局部缩放来实现。三角剖分的方法则是通过对三角网顶点进行平移,再将平移后的顶点更新到对应的纹理坐标,通过 openGL 或者 D3D 进行绘制渲染,从而实现整个关联三角网的变形。具体的脸部美型效果如下图所示:

在性能方面,在 iphone 6 Plus 等中低端机型上,可实现 720p 24fps 实时人脸美颜;

在效果方面,通过对皮肤的处理,可使人脸皮肤达到白皙细腻的效果,同时主播可按照自己的喜好对脸部的任意器官进行调整。

目前人脸美颜功能已在来疯直播(移动端和 PC 端)、优来播移动端及淘宝直播 PC 端落地,来疯移动端主播日均开播人数实现一倍增长。具体的人脸美颜效果如下图所示:

五 优酷酷看体验:你猜老胡是卧底吗?

细心的观众已经发现,优酷视频中出现了很多有人情味的“黑科技“,比如百科 tips、角色伴侣、剧情竞猜等,让用户“边看剧边互动”,这就是优酷的酷看模式。酷看模式在移动端采用了多路流的同屏展示、智能平滑切换、精准同步和动态化渲染等技术。其中动态化渲染、子母屏和多路流同步播放是酷看模式在端侧的核心能力,能够做到多路流、多机位视频帧级同步播放。

六 不知道看什么?多模态搜索来帮忙

与中午吃什么一样伤脑筋,用户打开视频平台,常常面临一个难题是 “不知道看什么、不知道如何搜索”,针对这个痛点,文娱人工智能平台提出了基于多轮对话式搜索系统。

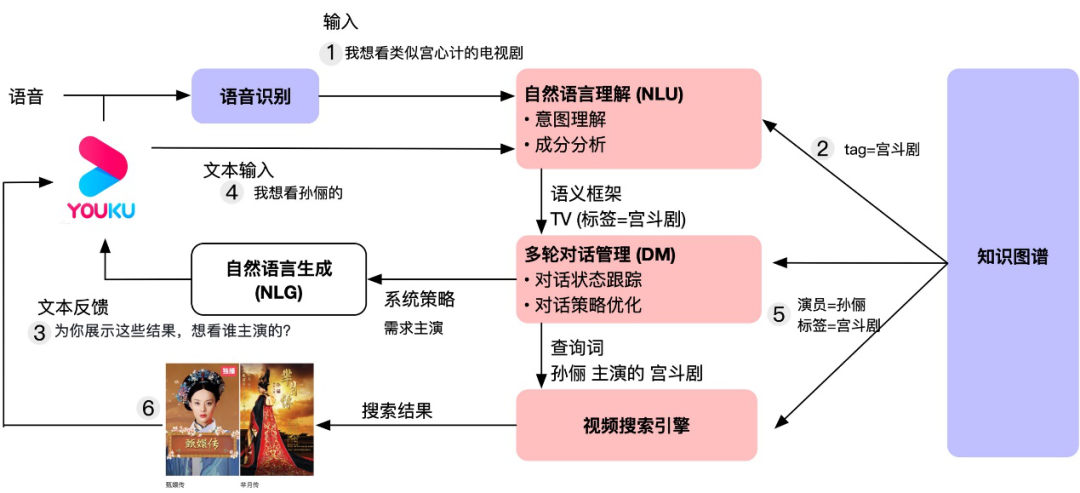

交互式搜索系统采用模块化的设计思路,按照分层逻辑结构,分为应用技术层、核心技术层和基础数据层。应用技术层主要包括是自然语言理解(NLU)和对话技术,其中 NLU 包括意图理解(Intent Understanding)技术和成分分析((Slot Filling)技术;对话技术包括对话管理(DM)以及对话生成(NLG)。核心技术层包括知识图谱(Knowledge Graph)的构建和推理应用。基础数据层是基于视觉技术的智能媒资库。

用户在视频这个垂直领域,意图和属性槽相对比较明确,整体以有限状态机的方法为基础,基础动作迁移状态以人工设计动作为主;模型的方法作为泛化能力,解决不确定场景的理解。

系统对话流程如下:

用户说“我想看类似宫心计的电视剧”,系统通过语音识别(ASR)和自然语言理解(NLU)技术理解分析用户想看‘宫斗剧’,通过检索反馈给用户‘宫斗剧’相关电视剧,并通过自然语言生成(NLG)技术主动和用户作进一步的交互,得到用户想看‘孙俪’主演的需求后,系统基于多轮对话管理(DM)技术将前后两轮的用户综合理解,向搜索引擎发起再次检索实现多轮交互。

七 视频物体分割:在视频中随意“抠图”

视频物体分割(Video Object Segmentation,简称 VOS ),顾名思义就是从视频所有图像中把感兴趣的物体区域完整的分割出来。为了方便大家的理解,先给出一个我们自己的视频物体分割的结果。

阿里文娱摩酷实验室从 2019 年 3 月底开始从事半监督和交互式视频物体分割算法的研究。

2019 年 5 月,我们完成一版基础的半监督视频物体分割算法和交互式视频物体分割解决方案,并以此参加了 DAVIS Challenge on Video Object Segmentation 2019,在交互式视频物体分割赛道获得第四名。

我们提出的 VOS with robust tracking 策略,可以较大幅度的提高基础算法的鲁棒性。在 Davis 2017 验证集上,我们交互式视频物体分割算法 J&F @ 60s 准确率从 3 月底的 0.353 提高到 5 月初的 0.761。现在,我们的半监督视频物体分割算法也达到了 J&F = 0.763。可以说,在这个集合上我们的结果已经接近业界一流水准。一些分割结果示例如下:

八 数据反映的是真实的观看体验吗?

看基于人类视觉感知的视频体验评价体系怎么回答:

随着 4K 电视、HDR 技术、multi-view、free-viewpoint video、360 视频、虚拟现实 VR、增强现实 AR 以及混合现实 MR 的发展,Qualinet 定义的 QoE 的概念可以无差别的直接应用于这些多媒体载体上,所以在业界被广泛采用并认定其为标准定义。

为什么要做质量评价?因为用户的观看体验永远是第一位。而在整个视频从获取,处理,压缩,传输到最后解码,增强,播放的 pipeline 中,每一个阶段视频质量的评估可以指导和优化相对应的算法实现,进而实现每一个阶段算法效果的提升,最终导致用户观看体验的提升。这是我们的终极目标。

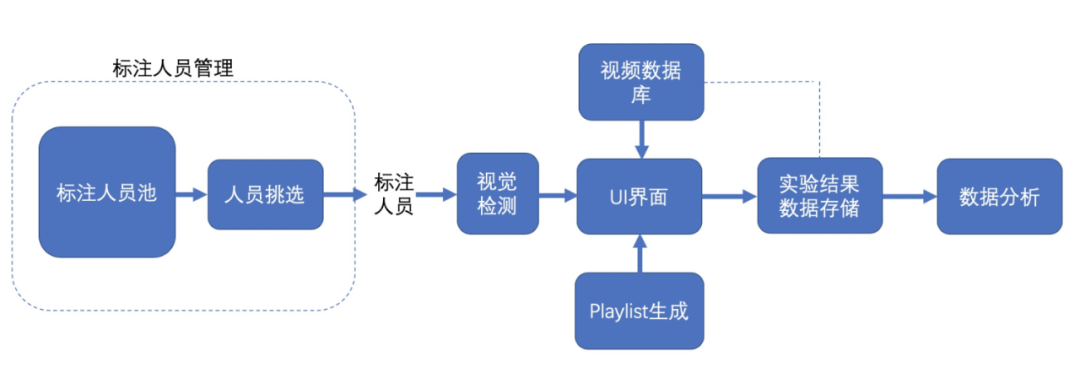

阿里文娱摩酷实验室依据 ITU 国际标准,搭建了自己的主观测试平台。

摩酷实验室主观测试流程

5G 的到来势必颠覆用户的观看习惯和体验。目前已经出现的新型多媒体技术,比如 Light-field Imaging, AR, VR, 360 VR, MR, High Dynamic Range (HDR), Free-viewpoint video, 以及 Autostereoscopic 3D 将会是未来 5G 时代的主流。以提高用户多维度的感知体验为目的下一代视频内容生成,视频压缩,视频增强,depth estimation, view synthesis 等技术势必需要质量评价方法来做监控。同时,这其中有可能产生的会引发观众视觉疲劳等危害身体健康的视频更需要质量评价方法去做前期评估预警。

九 竖屏看热剧如何实现?

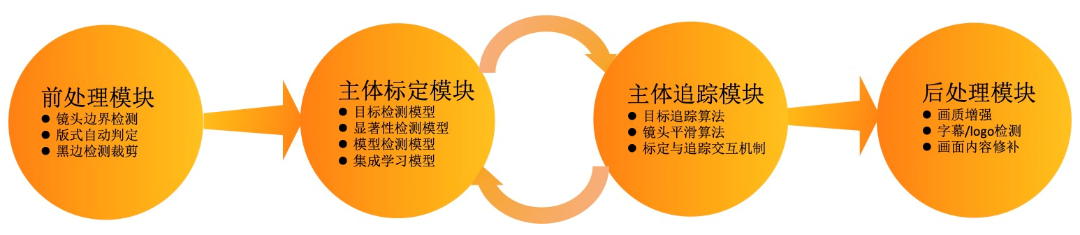

近两年,随着竖版视频的流行和播放转化效率,用户对竖版视频的消费需求越来越旺盛。针对这一需求,优酷将基于机器视觉的视频裁剪技术应用于视频二次生产和智能封面图生成业务中,智能裁剪技术主要应用于以多人或者单人为主体的场景,我们将目标检测,跟踪,识别等技术进行创新和结合,开发了完整的视频智能裁剪技术链路,面对实际业务中的主体标定,视频帧间抖动,视频黑边填充等问题针对性的研发了算法解决方案,可以根据不同的业务场景将各算法可插拔的配置进主裁剪 pipeline 中,视频智能裁剪技术的研发给内容行业的素材自动化制作,剪辑作品的视觉效果和制作成本降低等方面都带来了大幅度的提升。

在视频智能裁剪技术链路中,我们研发了前处理模块(包含镜头切分, 画面尺寸判定,黑边检测裁剪等),主体标定模块,主体追踪模块和后处理模块(包含画质增强,字幕/logo 检测,画面内容修补等)。

目前视频智能裁剪技术生产的视频和封面图广泛应用于优酷的各个场景,我们对视频智能裁剪算法栈进行了整体性能优化,达到处理时间仅 1:2 视频时长,目前该技术累计对优酷综艺:演技派、这就是街舞、这就是灌篮;优酷剧集:陆战之王、天雷一部之春花秋月、微微一笑很倾城等百部 OGC 进行裁剪服务,裁剪后的竖版视频用于抖音,微博等外渠宣发和站内投放,同时主体标定算法服务于搜索双列封面图转竖项目,镜头平滑算法服务于弹幕人脸项目。

十 推荐如何又好又准?

如何为用户推荐真正想看的视频,这离不开对视频内容的理解,在个性化视频推荐中,为了对视频的内容进行表征,一种常用的方法是给视频打上多个标签,每个标签代表了一个视频中的主要元素。优酷过去的标签算法主要依赖于文本分析,当视频的文本元信息(标题、描述、评论等)对主题的描述不明确时,我们常常无法分析视频内容。为了解决这一问题,我们采用文本、封面图、音频、视频多种模态信息对视频进行多标签分类,大大提高了建模的准确率。从而提升推荐成功率。

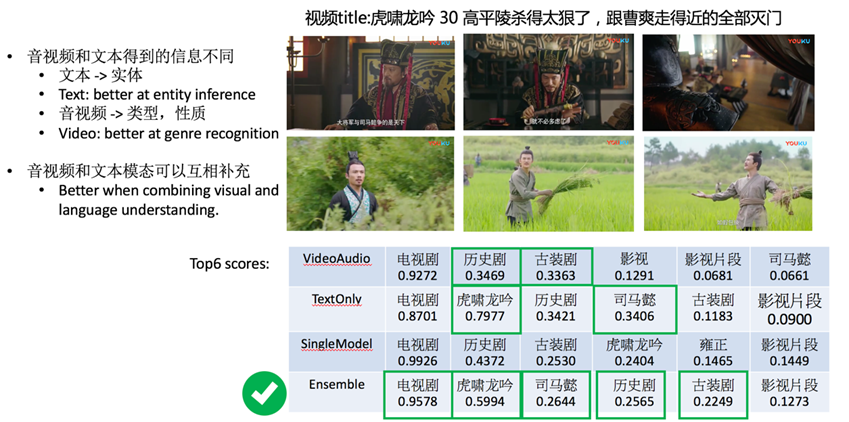

多模态视频多标签分类结果示例

当然,音视频模态面临的一个严重问题是对于知识的提取能力有限,文本模态对于实体有更好的提取与推断能力。在下面的例子中,音视频模态会以更高的权重推断「古装剧」和「历史剧」,而文本模态则会推断「虎啸龙吟」与「司马懿」,最终的融合模型则可以融合两者的优势获得更完整的推断结果。