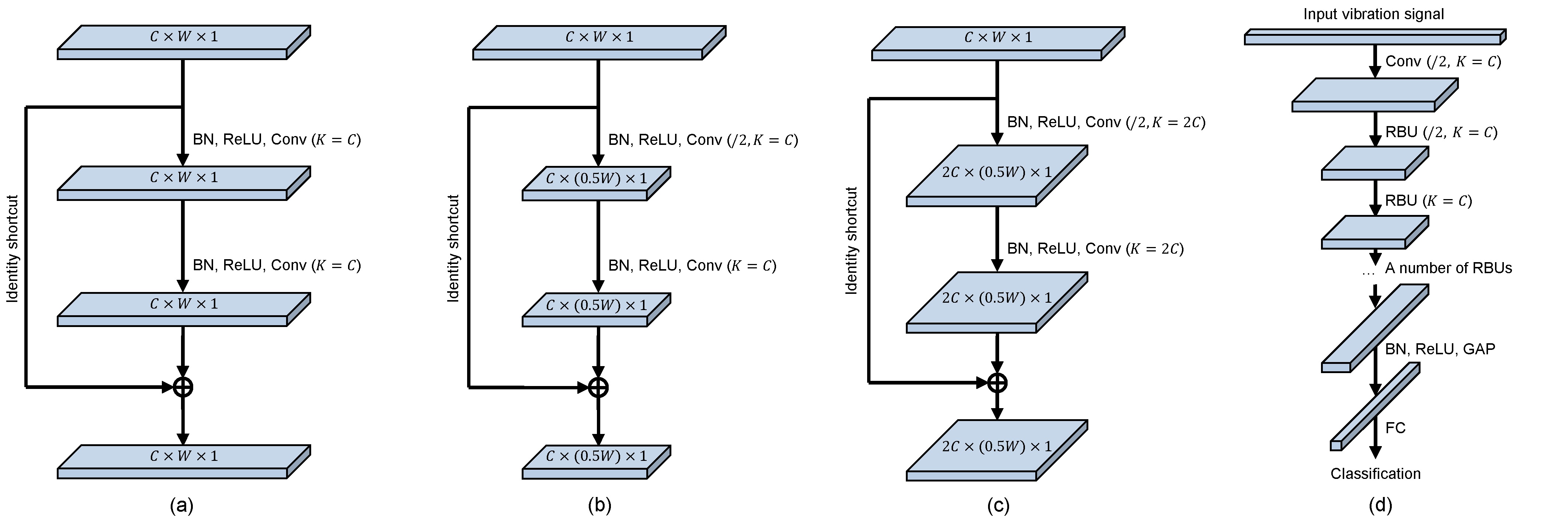

(1)深度残差网络的回顾

在下图中,(a)-(c)分别是三种残差模块,(d)是深度残差网络的整体示意图。BN指的是批标准化(Batch Normalization),ReLU指的是整流线性单元激活函数(Rectifier Linear Unit),Conv指的是卷积层(Convolutional layer),Identity shortcut指的是跨层的恒等映射,RBU指的是残差模块(Residual Building Unit),GAP是全局均值池化(Global Average Pooling),FC是全连接层(Fully Connected Layer)。

C表示特征图的通道数,W表示特征图的宽度,1表示特征图的高度始终为1(这是因为这篇文章以一维的振动信号作为输入)。

在Conv后的括号中,K表示卷积层中卷积核的个数。当K=C时,输出特征图的通道数为C。当K=2C时,输出特征图的通道数为2C。/2表示的是卷积核每次移动的步长为2,从而使得输出特征图的宽度减半。

我们可以看到,在图(a)中,输入特征图的尺寸为C×W×1,输出特征图的尺寸也是C×W×1,也就是说,特征图的尺寸保持不变。在图(b)中,输出特征图的尺寸减小为C×(0.5W)×1,换言之,宽度减小为原先的一半。在图(c)中,输出特征图的尺寸变为2C×(0.5W)×1,即不仅宽度减小为原先的一半,而且通道数增加了一倍。

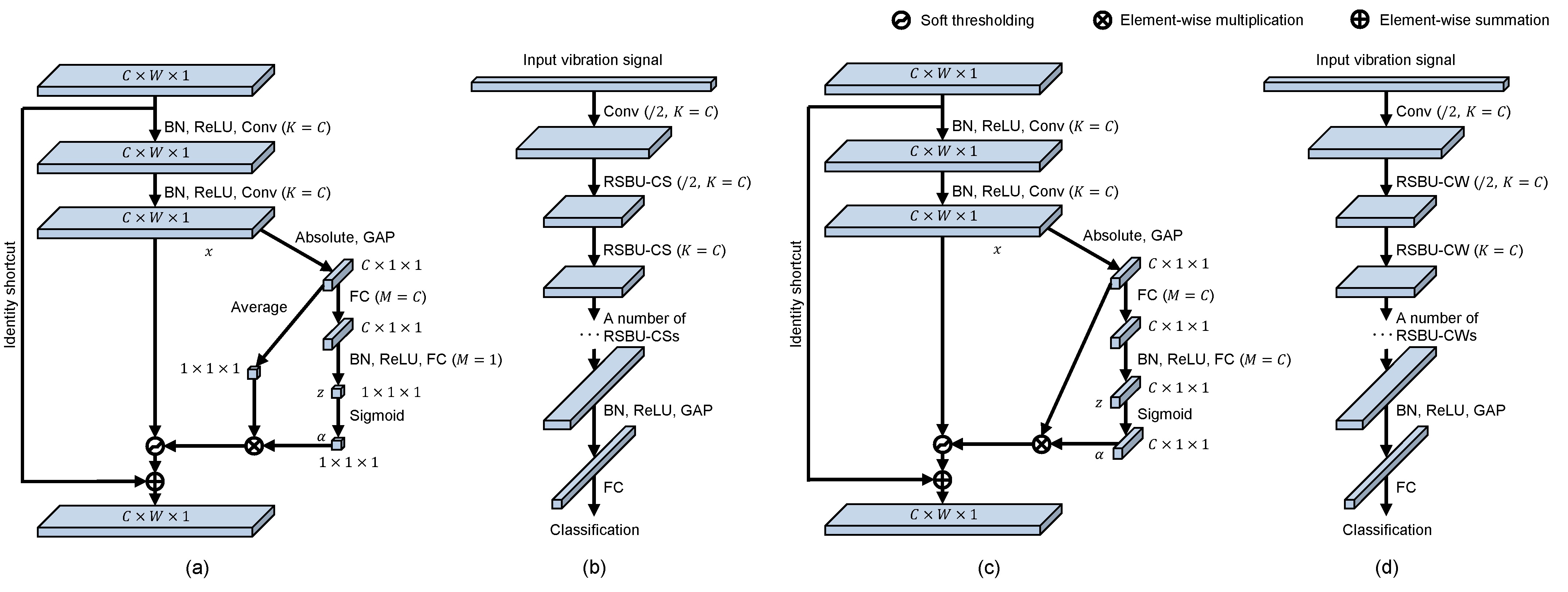

(2)深度残差收缩网络的网络结构

在该论文中,提出了两种深度残差收缩网络(Deep Residual Shrinkage Networks,简称DRSN)。第一种是“通道之间共享阈值的深度残差收缩网络(Deep Residual Shrinkage Networks with Channel-shared Thresholds,简称DRSN-CS)”,第二种是“逐通道不同阈值的深度残差收缩网络(Deep Residual Shrinkage Networks with Channel-wise Thresholds,简称DRSN-CW)”。

在下图中,(a)表示一种改进后的残差模块,名为“残差收缩模块-通道之间共享阈值(Residual Shrinkage Building Unit with Channel-shared thresholds,简称RSBU-CS)”;(b)表示的是DRSN-CS的整体结构示意图;(c)表示另一种改进后的残差模块,名为“残差收缩模块-逐通道不同阈值(Residual Shrinkage Building Unit with Channel-wise thresholds,简称RSBU-CW)”;(d)表示的是DRSN-CW的整体结构示意图。

其中,M表示的是全连接层神经元的个数。M=C表示神经元的个数与之前特征图的通道数相等,M=1表示神经元的个数为1。Absolute表示对特征图中的每个元素取绝对值,Average表示求特征图内所有元素的平均值。

可以看出,深度残差收缩网络的整体结构,和传统的深度残差网络,没有区别。其区别在于残差模块的不同。在改进后的残差模块中,不仅有一个软阈值化函数作为非线性层,而且嵌入了一个子网络,用于自动地设置软阈值化所需要的阈值。

转载网址:

深度残差收缩网络:(一)背景知识 https://www.cnblogs.com/yc-9527/p/11598844.html

深度残差收缩网络:(二)整体思路 https://www.cnblogs.com/yc-9527/p/11601322.html

深度残差收缩网络:(三)网络结构 https://www.cnblogs.com/yc-9527/p/11603320.html

深度残差收缩网络:(四)注意力机制下的阈值设置 https://www.cnblogs.com/yc-9527/p/11604082.html

深度残差收缩网络:(五)实验验证 https://www.cnblogs.com/yc-9527/p/11610073.html

论文网址:

M. Zhao, S. Zhong, X. Fu, B. Tang, and M. Pecht, “Deep Residual Shrinkage Networks for Fault Diagnosis,” IEEE Transactions on Industrial Informatics, 2019, DOI: 10.1109/TII.2019.2943898