本文节选自《不一样的 双11 技术:阿里巴巴经济体云原生实践》一书

作者:

黄挺,花名鲁直,蚂蚁金服微服务以及云原生方向负责人,主导蚂蚁金服的云原生落地。

雷志远,花名碧远,蚂蚁金服 RPC 框架负责人

更多云原生技术资讯可关注阿里巴巴云原生技术圈。

引言

Service Mesh 是蚂蚁金服下一代架构的核心,本主题主要分享在蚂蚁金服当前的体量下,我们如何做到在奔跑的火车上换轮子,将现有的 SOA 体系快速演进至 Service Mesh 架构。聚焦 RPC 层面的设计和改造方案,分享蚂蚁金服 双11 核心应用如何将现有的微服务体系平滑过渡到 Service Mesh 架构下并降低大促成本。

蚂蚁金服每年 双11 大促会面临非常大的流量挑战,在已有 LDC 微服务架构下已支撑起弹性扩容能力。本次分享主要分为 4 部分:

- Service Mesh 简介;

- 为什么要 Service Mesh;

- 我们的方案是什么;

- 分时调度案例;

Service Mesh 简介

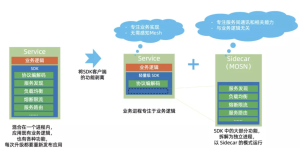

在讲具体的蚂蚁金服落地之前,想先和大家对齐一下 Service Mesh 的概念,和蚂蚁金服对应的产品。

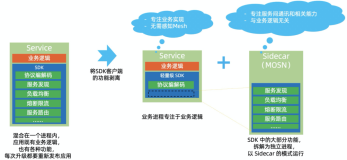

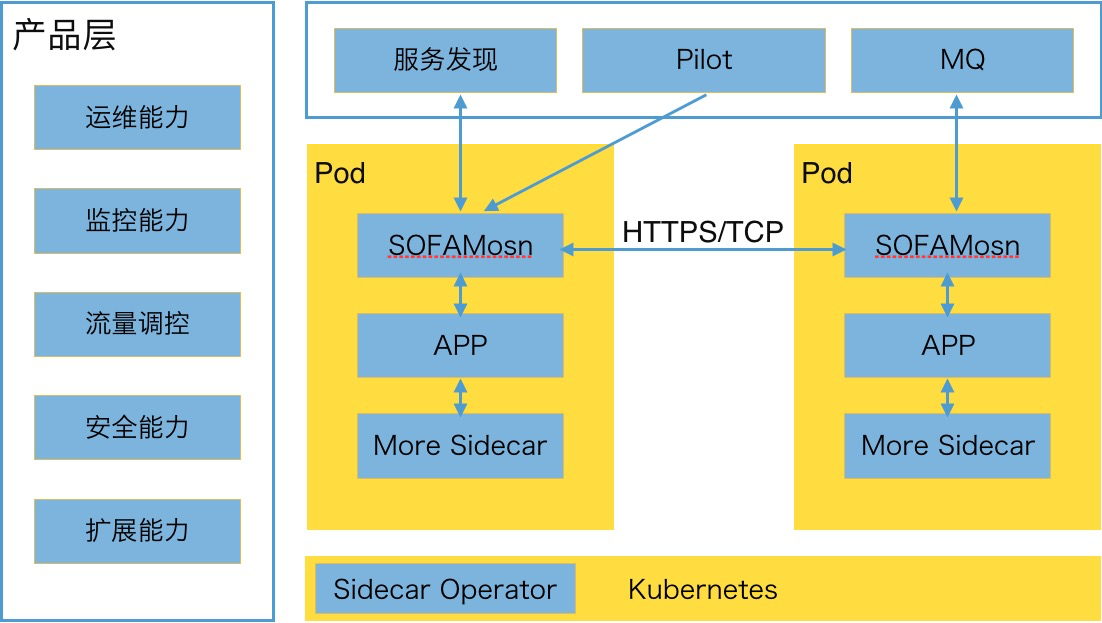

这张图大家可能不陌生,这是业界普遍认可的 Service Mesh 架构,那么对应到蚂蚁金服,蚂蚁金服的 Service Mesh 也分为控制面和数据面,分别叫做 SOFAMesh 和 SOFAMosn,其中 SOFAMesh 后面会以更加开放的姿态参与到 Istio 里面去。

今天我们讲的实践主要集中在 SOFAMosn 上,以下我的分享中提到的主要就是集中在数据面上的落地,这里面大家可以看到,我们有支持 HTTP/SOFARPC/Dubbo/WebService。

为什么我们要 Service Mesh

有了一个初步的了解之后,可能大家都会有这样一个疑问,你们为什么要 Service Mesh,我先给出结论:

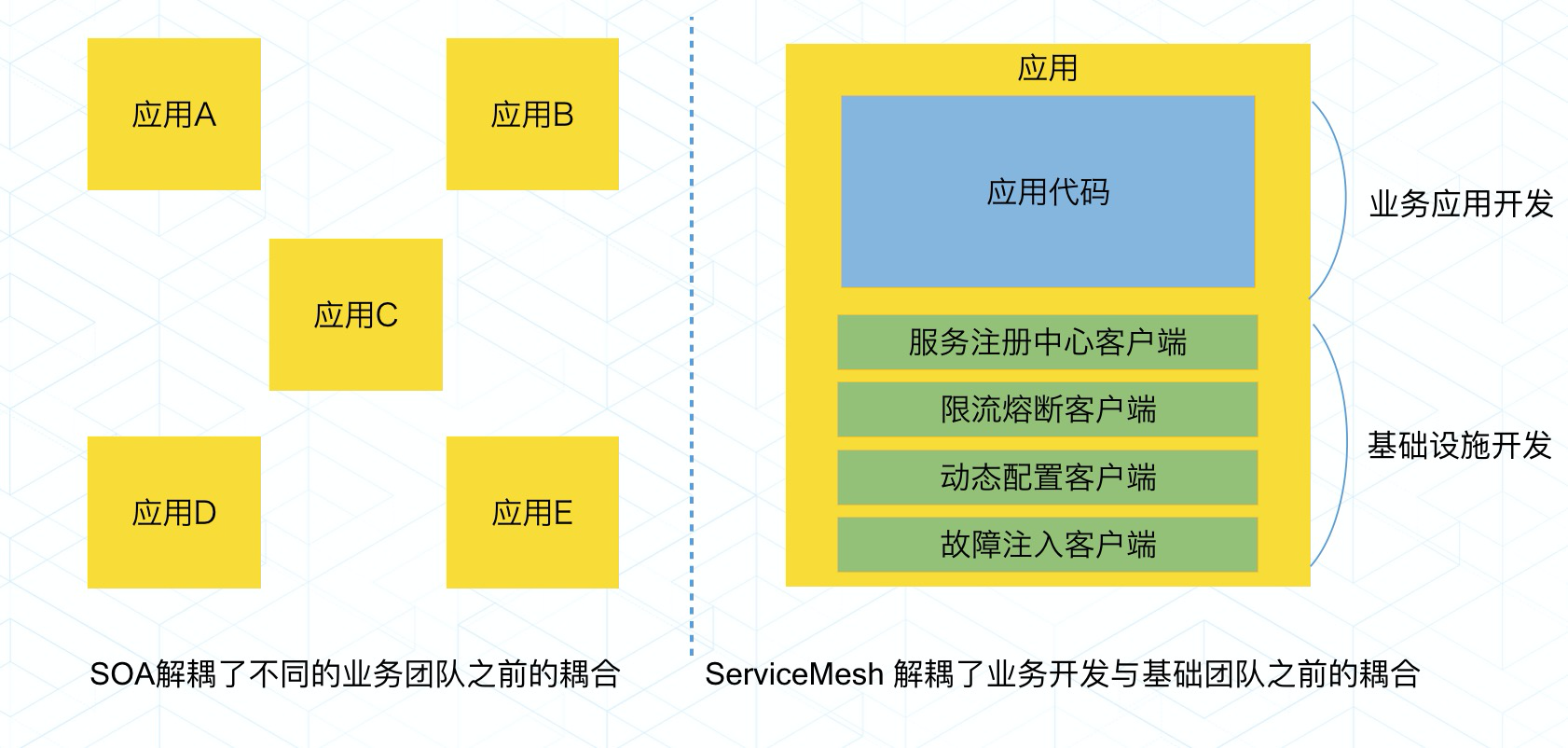

因为我们要解决在 SOA 下面,没有解决但亟待解决的:基础架构和业务研发的耦合,以及未来无限的对业务透明的稳定性与高可用相关诉求。

那么接下来,我们一起先看看在没有 Service Mesh 之前的状况。

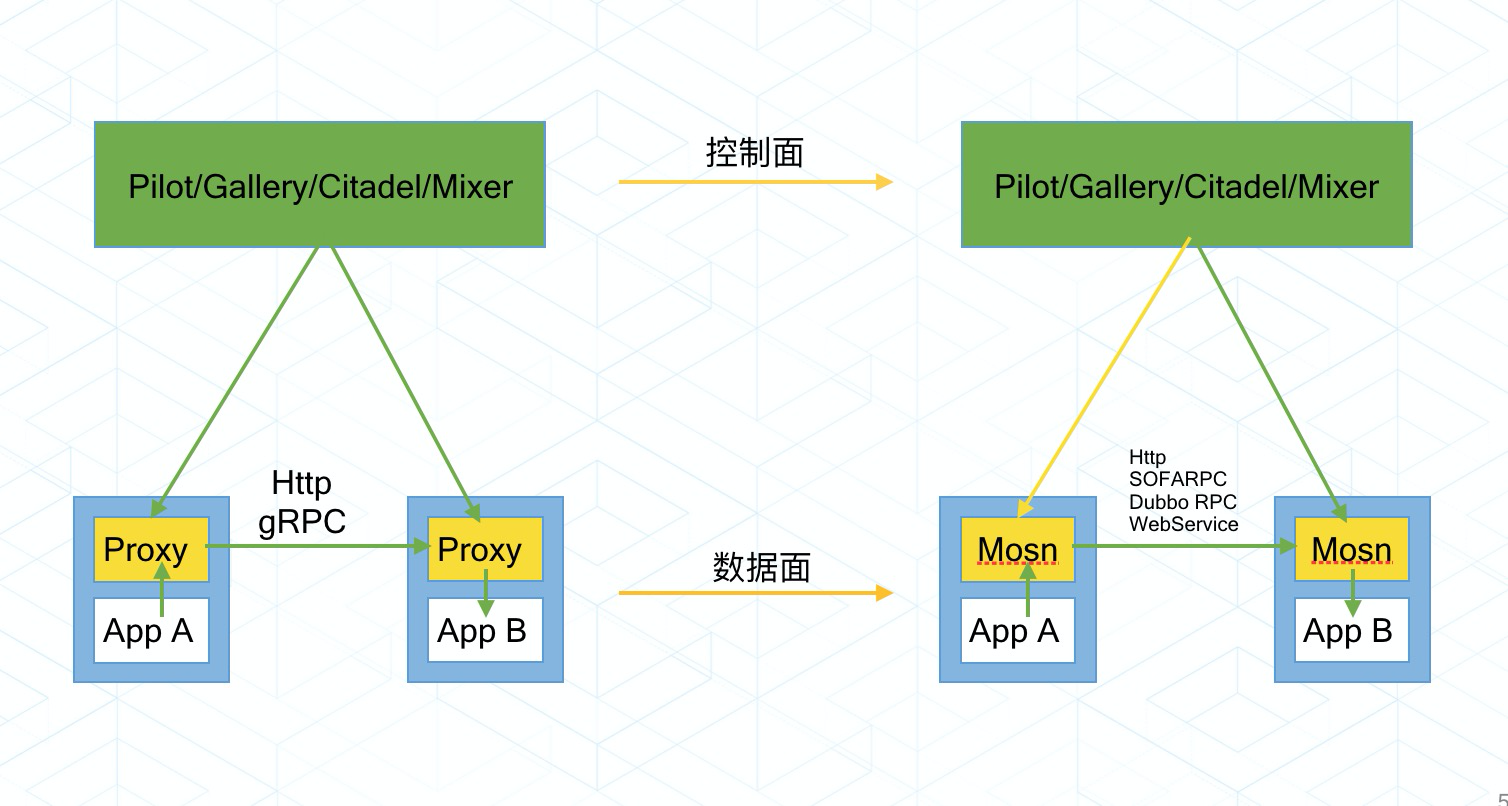

在没有 Service Mesh 之前,整个 SOFAStack 技术演进的过程中,框架和业务的结合相当紧密,对于一些 RPC 层面的需求,比如流量调度,流量镜像,灰度引流等,是需要在 RPC 层面进行升级开发支持,同时,需要业务方来升级对应的中间件版本,这给我们带来了一些困扰和挑战。如图所示:

- 线上客户端框架版本不统一;

- 业务和框架耦合,升级成本高,很多需求由于在客户端无法推动,需要在服务端做相应的功能,方案不够优雅;

- 机器逐年增加,如果不增加机器,如何度过 双11;

- 在基础框架准备完成后,对于新功能,不再升级给用户的 API 层是否可行;

- 流量调拨,灰度引流,蓝绿发布,AB Test 等新的诉求;

这些困扰着我们,我们知道在 SOA 的架构下,负责每个服务的团队都可以独立地去负责一个或者多个服务,这些服务的升级维护也不需要其他的团队的接入,SOA 其实做到了团队之间可以按照接口的契约来接耦。但是长期以来,基础设施团队需要推动很多事情,都需要业务团队进行紧密的配合,帮忙升级 JAR 包,基础设施团队和业务团队在工作上的耦合非常严重,上面提到的各种问题,包括线上客户端版本的不一致,升级成本高等等,都是这个问题带来的后果。

而 Service Mesh 提供了一种可能性,能够将基础设施下沉,让基础设施团队和业务团队能够解耦,让基础设施和业务都可以更加快步地往前跑。

我们的方案

说了这么多,那我们怎么解决呢?

方案一:全部迁移到 Envoy?不现实,自有协议+历史负担。

方案二:透明劫持?性能问题,且表达能力有限,运维和可监控性,风险不太可控。

方案三:自研数据面,最终我们给出的答案是 SOFAMosn。

总体

我们的 SOFAMosn 支持了 Pilot ,自有服务发现 SOFARegistry,和自有的消息组件,还有一些 DB 的组件。在产品层,提供给开发者,不同的能力,包括运维,监控,安全等能力,这个是目前我们的一个线上的状态。

SOFARegistry 是蚂蚁金服开源的具有承载海量服务注册和订阅能力的、高可用的服务注册中心,在支付宝/蚂蚁金服的业务发展驱动下,近十年间已经演进至第五代。

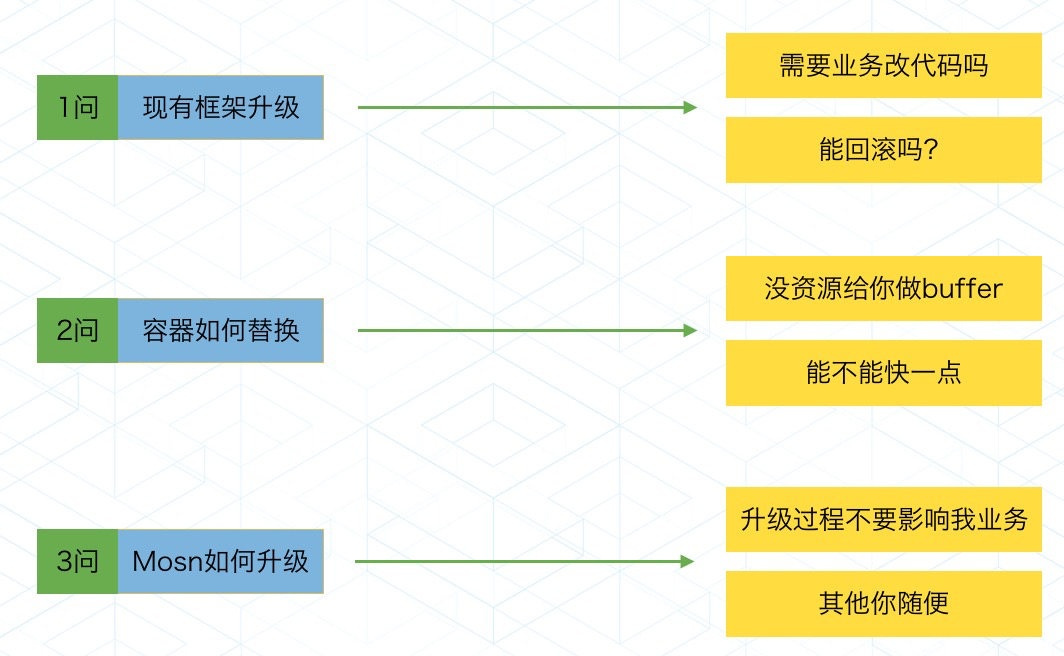

看上去很美好,要走到这个状态,我们要回答三个问题。

这三个问题后面,分别对应着业务的几大诉求,大家做过基础框架的应该比较有感触。

框架升级方案

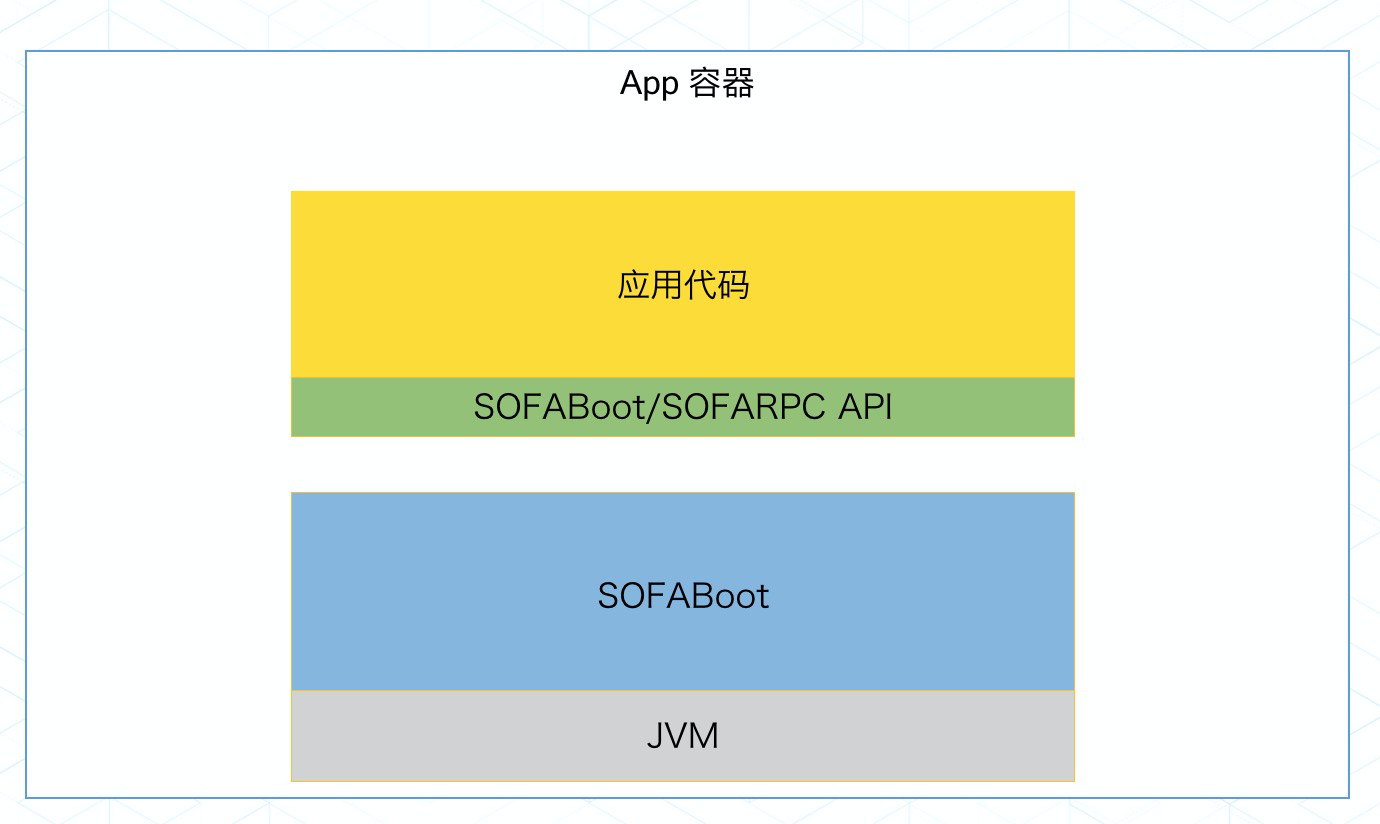

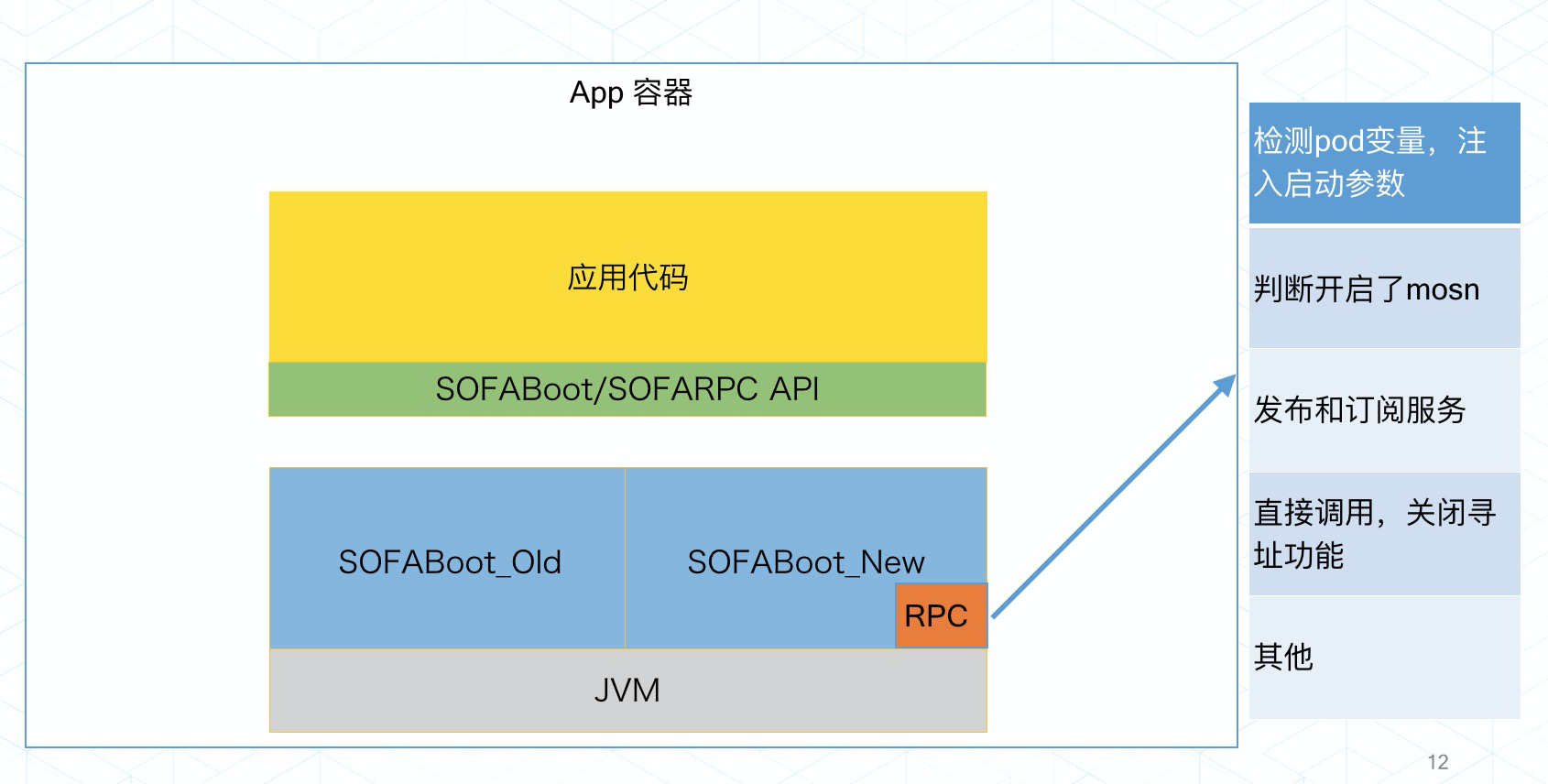

准备开始升级之后,我们要分析目前我们的线上情况,而我们现在线上的情况,应用代码和框架有一定程度的解耦,用户面向的是一个 API,最终代码会被打包,在 SOFABoot 中运行起来。

SOFABoot 是蚂蚁金服开源的基于 SpringBoot 的研发框架,它在 SpringBoot 的基础上,提供了诸如 Readiness Check,类隔离,日志空间隔离等能力。在增强了 SpringBoot 的同时,SOFABoot 提供了让用户可以在 SpringBoot 中非常方便地使用 SOFA 中间件的能力。

那么,我们就可以在风险评估可控的情况下,直接升级底层的 SOFABoot,在这里,我们的 RPC 会检测一些信息,来确定当前 Pod 是否需要开启 SOFAMosn 的能力。然后我们完成如下的步骤。

这里,我们通过检测 PaaS 传递的容器标识,知道自己是否开启了 SOFAMosn,则将发布和订阅给 SOFAMosn,然后调用不再寻址,直接完成调用。

可以看到,我们通过批量的运维操作,直接修改了线上的 SOFABoot 版本,以此,来直接使得现有的应用具备了 SOFAMosn 的能力,有些同学可能会问,那你一直这么做不行吗?不行,因为这个操作时要配合流量关闭等操作来运行的,也不具备平滑升级的能力。而且直接和业务代码强相关。不适合长期操作。

这里我们来详细回答一下,为什么不采用社区的流量劫持方案?

主要的原因是一方面 iptables 在规则配置较多时,性能下滑严重。另一个更为重要的方面是它的管控性和可观测性不好,出了问题比较难排查。而 Service Mesh 从初期就把蚂蚁金服现在线上的系统全量切换 Mesh 作为目标,并不是只是跑跑 demo,所以我们对性能和运维的要求是非常高的,毕竟,技术架构升级,如果是以业务有损或者资源利用率大幅度上升,这是无论如何都不能接受的。

容器替换方案

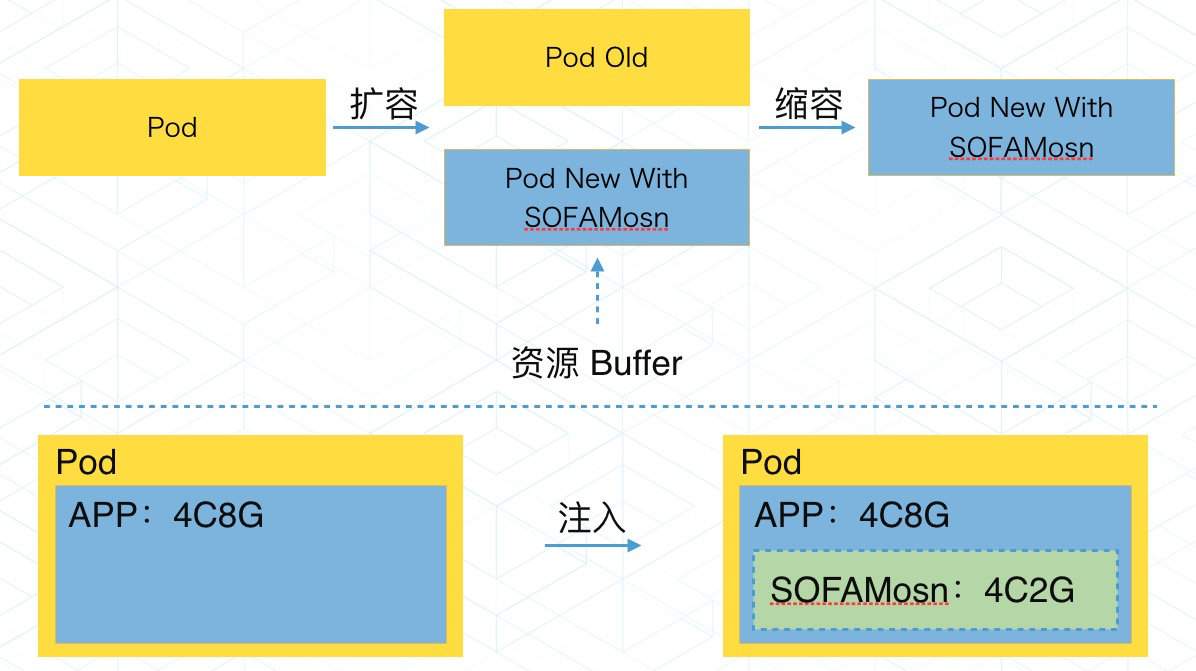

解决了刚刚提到的第一个难题,也只是解决了可以做,而并不能做得好,更没有做得快,面对线上数十万,带着流量的业务容器, 我们如何立刻开始实现这些容器的快速稳定接入?

这么大的量,按照传统的替换接入显然是很耗接入成本的事情,于是我们选择了原地接入,我们可以来看下两者的区别

在之前,我们做一些升级操作之类的,都是需要有一定的资源 Buffer,然后批量的进行操作,替换 Buffer 的不断移动,来完成升级的操作。这就要求 PaaS 层留有非常多的 Buffer,但是在 双11 的情况下,我们要求不增加机器,并且为了一个接入 SOFAMosn 的操作,反而需要更多的钱来买资源,这岂不是背离了我们的初衷。有人可能会问,不是还是增加了内存和 CPU 吗,这是提高了 CPU 利用率。以前业务的 CPU 利用率很低。并且这个是一个类似超卖的方案。看上去分配了。实际上基本没增加。

可以看到, 通过 Paas 层,我们的 Operator 操作,直接在现有容器中注入,并原地重启,在容器级别完成升级。升级完成后,这个 Pod 就具备了 SOFAMosn 的能力。

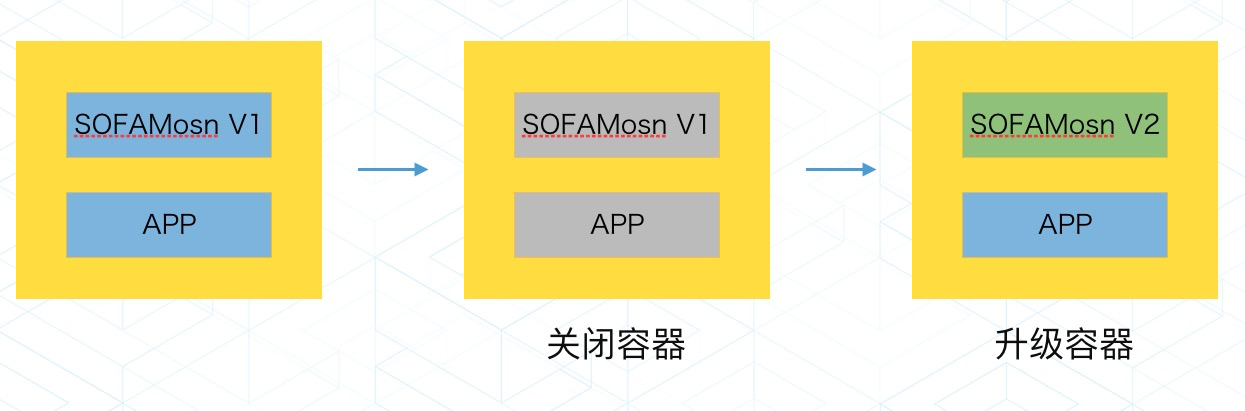

SOFAMosn 升级方案

在快速接入的问题完成后,我们要面临第二个问题,由于是大规模的容器,所以 SOFAMosn 在开发过程中,势必会存在一些问题,出现问题,如何升级,要知道,线上几十万容器要升级一个组件的难度是很大的,因此,在版本初期,我们就考虑到 SOFAMosn 升级的方案。

能想到的最简单的方法,就是销毁容器,然后用新的来重建,但是在容器数量很多的时候,这种运维成本是不可接受的。如果销毁容器重建的速度不够快,就可能会影响业务的容量,造成业务故障。因此,我们在 SOFAMosn 层面,和 PaaS 一起,开发了无损流量升级的方案。

在这个方案中。SOFAMosn 会感知自己的状态,新的 SOFAMosn 启动会通过共享卷的 Domain Socket 来检测是否已有老的 SOFAMosn 在运行,如果有,则通知原有 SOFAMosn 进行平滑升级操作。

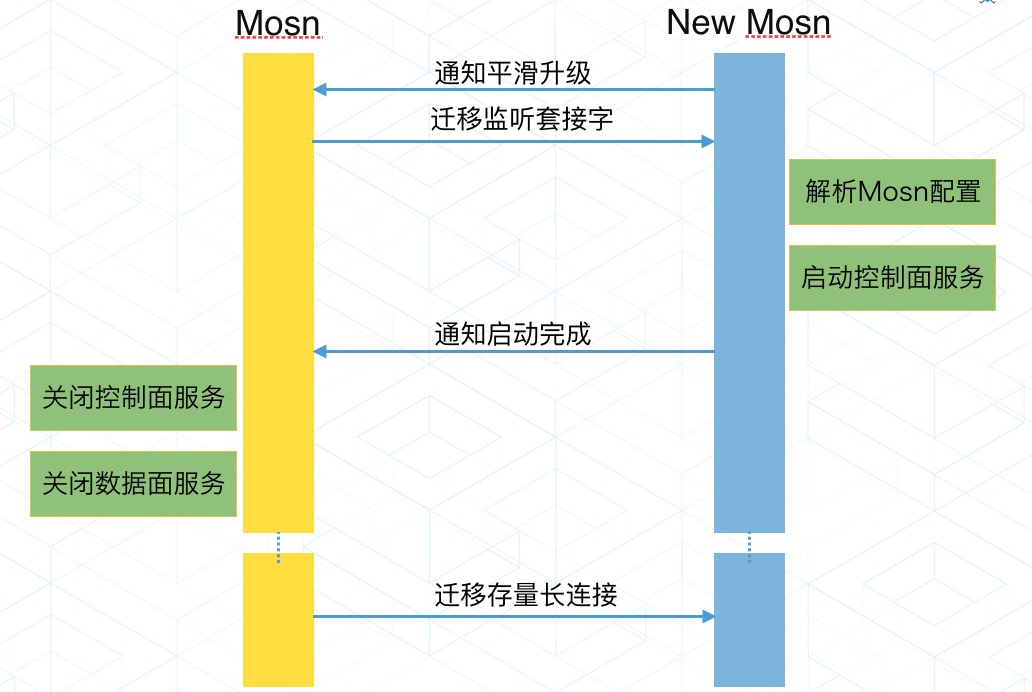

具体来说,SOFAMosn 启动的时候查看同 Pod 是否有运行的 SOFAMosn (通过共享卷的domain socket),如果存在,需要进入如下流程:

1.New Mosn 通知 Old Mosn,进入平滑升级流程

2.Old Mosn 把服务的 Listen Fd 传递给 New Mosn,New Mosn 接收 Fd 之后启动, 此时 Old 和 New Mosn 都正常提供服务。

3.然后 New Mosn 通知 Old Mosn,关闭 Listen Fd,然后开始迁移存量的长链接。

4.Old Mosn 迁移完成, 销毁容器。

这样,我们就能做到,线上做任意的 SOFAMosn 版本升级,而不影响老的业务,这个过程中的技术细节,不做过多介绍,之后,SOFAStack 会有更详细的分享文章。

分时调度案例

技术的变革通常一定不是技术本身的诉求,一定是业务的诉求,是场景的诉求。没有人会为了升级而升级,为了革新而革新,通常,技术受业务驱动,也反过来驱动业务。

在阿里经济体下,在不断的淘宝直播,实时红包,蚂蚁森林,各种活动的不断扩张中,给技术带了复杂了场景考验。

这个时候,业务同学往往想的是什么?我的量快撑不住了,我的代码已经最优化了,我要扩容加机器,而更多的机器付出更多的成本,面对这样的情况,我们觉得应用 Service Mesh,是一个很好的解法。通过和 JVM, 系统部的配合,利用进阶的分时调度实现灵活的资源调度,不加机器。这个可以在资源调度下有更好的效果。

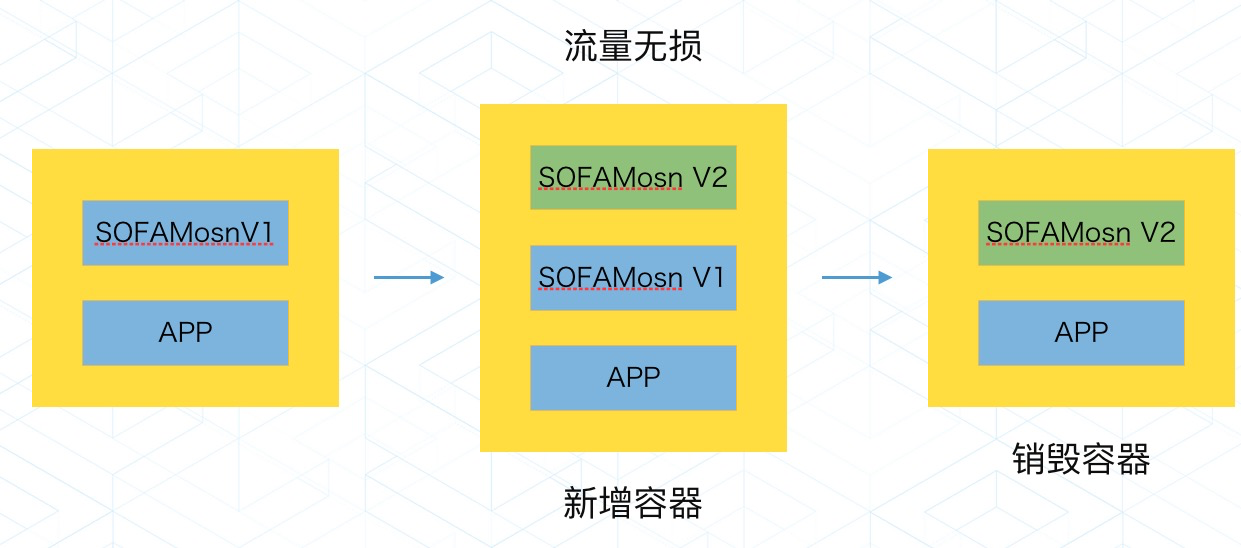

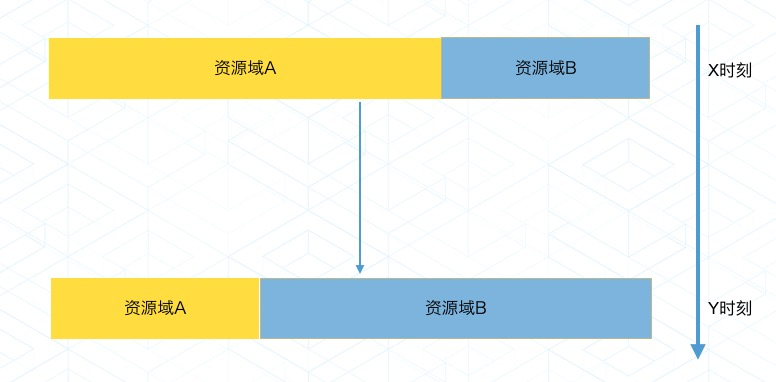

首先,我们假设有两个大的资源池的资源需求情况,可以看到在 X 点的时候,资源域 A 需要更多的资源,Y 点的时候,资源域 B 需要更多的资源,总量不得增加。那当然,我们就希望能借调机器。就像下面这样。

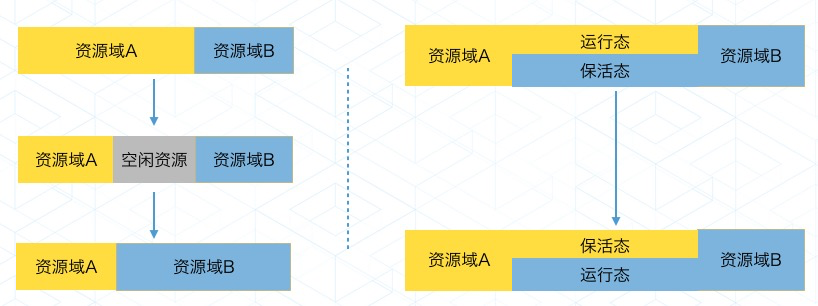

请大家看左图。

在这个方案中, 我们需要先释放资源,然后销毁进程,然后开始重建资源,然后启动资源域 B 的资源。这个过程对于大量的机器,是很重的,而且变更就是风险,关键时候,做这种变更,很有可能带来衍生影响。

而在 SOFAMosn 中,我们有了新的解法。如右图所示,有一部分资源,一直通过超卖,运行着两种应用,但是 X 点的时候,对于资源域 A,我们通过 SOFAMosn 来将流量全部转走,这样,应用的 CPU 和内存就被限制到非常低的情况,大概保留 1% 的能力。这样,机器依然可以预热,进程也不停。

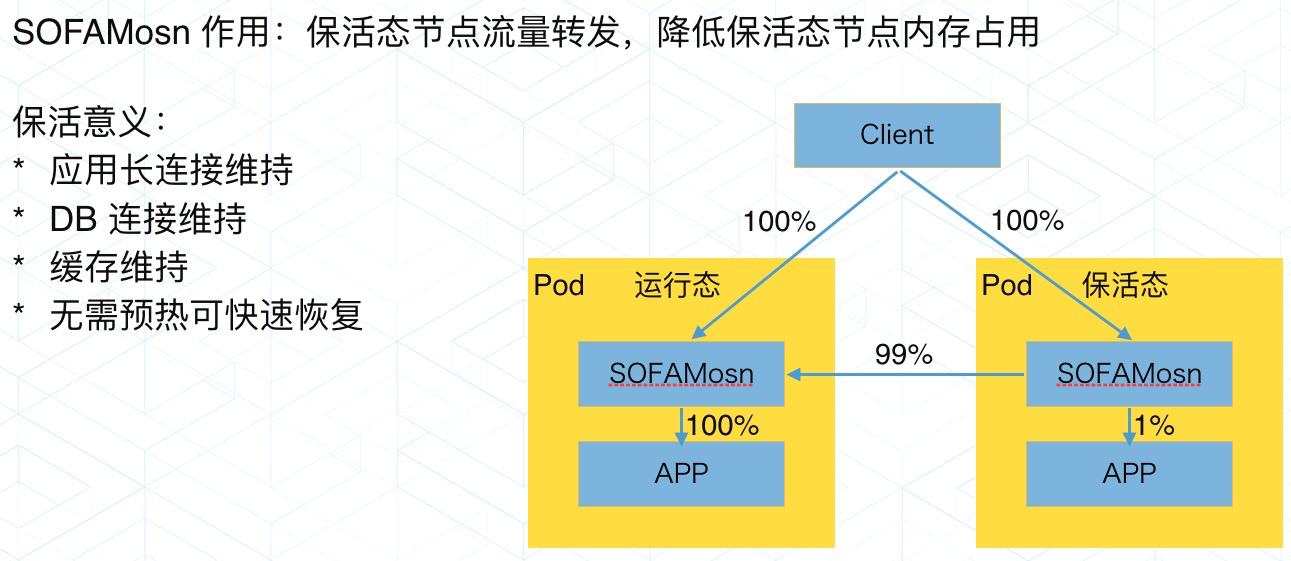

在这里。我们可以看这张图。

当需要比较大的资源调度的时候,我们推送一把开关,则资源限制打开,包活状态取消。资源域 B 瞬间可以满血复活。而资源域 A 此时进入上一个状态,CPU 和内存被限制。在这里,SOFAMosn 以一个极低的资源占用。完成流量保活的能力。使得资源的快速借调成为可能。

我们对 Service Mesh 的思考与未来

Service Mesh 在蚂蚁金服经过 2 年的沉淀,最终经过 双11 的检验,在 双11 ,我们覆盖了 200+ 的 双11 交易核心链路,Mosn 注入的容器数量达到了数十万,双11 当天处理的 QPS 达到了几千万,平均处理 RT<0.2 ms,SOFAMosn 本身在大促中间完成了数十次的在线升级,基本上达到了我们的预期,初步完成了基础设施和业务的第一步的分离,见证了 Mesh 化之后基础设施的迭代速度。

不论何种架构,软件工程没有银弹。架构设计与方案落地总是一种平衡与取舍,目前还有一些 Gap 需要我们继续努力,但是我们相信,云原生是远方也是未来,经过我们两年的探索和实践,我们也积累了丰富的经验。

我们相信,Service Mesh 可能会是云原生下最接近“银弹”的那一颗,未来 Service Mesh 会成为云原生下微服务的标准解决方案,接下来蚂蚁金服将和阿里集团一起深度参与到 Istio 社区中去,与社区一起把 Istio 打造成 Service Mesh 的事实标准。

本书亮点

- 双11 超大规模 K8s 集群实践中,遇到的问题及解决方法详述

- 云原生化最佳组合:Kubernetes+容器+神龙,实现核心系统 100% 上云的技术细节

- 双 11 Service Mesh 超大规模落地解决方案

“阿里巴巴云原生技术圈关注微服务、Serverless、容器、Service Mesh 等技术领域、聚焦云原生流行技术趋势、云原生大规模的落地实践,做最懂云原生开发者的技术圈。”