智造观点

现今,“AI让会让你丢失工作"、"AI可以无孔不入的监控你"等等危险的言论,让很多人都很恐惧AI的发展。最近,谷歌首席决策科学家CassieKozyrkov却提出了:“人类可以弥补人工智能的缺点”,并进一步表示,相较于”机器学习“,”机器教学“才是AI发展到现在更需要关注的点。

AI刚刚兴起的时候,大多数人们对这个词汇还是感到很陌生,但随着各类AI机器人不断出现,人工智能声名大噪,成为了各个国家未来的发展战略。科学家、工程师看到了一个崭新领域的兴起,商人们看到了技术带来源源不断的财富,而普通人则不得不面对“机器人窃取大量工作”的局面。由此“人工智能是人类最大的生存威胁”、“我们应该抵制人工智能”等言论甚嚣尘上!人类与人工智能究竟能否共赢共存成为了一个既敏感又现实的问题。

近日,谷歌首席决策科学家CassieKozyrkov提出了:“人类可以弥补人工智能的缺点”。过去五年,CassieKozyrkov在Google担任过很多技术职务,但如今她要正式面对“首席决策科学家”这个有点奇怪的职位了。

简单来讲,决策科学就是数据和行为科学的交叉点,涉及统计学、机器学习、心理学、经济学等学科。Kozyrkov的主要职责就是帮助Google推动更积极的AI议程,至少也要让人们相信AI并不像头条新闻所说的那么糟糕。

面对人工智能,人类到底在焦虑些什么?

“机器人正在窃取我们的工作,”“人工智能是人类最大的生存威胁”,类似的宣言已经存在了很长一段时间,但在过去几年中,这种担忧变得更加明显。

对话式AI助手广泛存在于现实生活中,汽车、卡车几乎能够自动驾驶,机器可以轻而易举的在电脑游戏中击败人类,甚至艺术创意的工作也受到了人工智能的冲击。我们不断被告知,无聊和重复的工作可能会成为过去。

身处自动化世界,人们对未来感到焦虑和困惑是可以理解的。但是,根据Kozyrkov的说法,人工智能仅仅是自人类诞生以来一直努力奋斗的延伸。

在伦敦AI峰会上Kozyrkov发表讲话说:“人类的故事是自动化的故事。人类发展的历程就是关于如何将事情做得更好,从旧石器时代开始,原始人拿起一块石头敲击另一块岩石,就是因为可以更快完成工具,然后利用工具进行更好的创造。从古至今,人类都是工具制造的种族,我们反对一味的埋头苦干”。

人工智能是危险的,因为它能比人类做得更好。这种的潜在威胁对Kozyrkov来说是站不住脚的,她认为所有的工具都比人类徒手来做强得多。理发师用剪刀剪头发,就是因为用手抓不那么理想。古腾堡的印刷机生产文本的规模可以达到了人类无法复制的规模。

使用工具比人类徒手做效果更好—这就是工具的意义。如果没有工具你可以做得更好,为什么要使用这个工具?如果你担心计算机在认知上比你更好,那么笔和纸在记忆时也比人类更长久;水桶在拿水的时候比人类得储存量更大,计算器的六位数计算远胜于大部分人类计算。我们有理由相信,未来人工智能在某些方面也会变得更好。

当然,许多人对人工智能和自动化的潜在恐惧并不是说它会比人类做得更好。而是害怕政府、企业和任何恶意实体可以肆无忌惮地追踪和微观管理人类的一举一动——几乎不费吹灰之力就可以实现秘密的宏伟愿景,从而给人类蒙上反乌托邦的阴影。

其他问题涉及像算法偏见,缺乏足够的监督以及世界末日情景等因素有关:如果某件事急剧地——无意地——出错了怎么办?

人工智能该如何真正减少人类的偏见?

研究人员已经证明了面部识别系统的内在偏见,像亚马逊的Rekognition。最近,民主党总统候选人参议员伊丽莎白·沃伦呼吁联邦机构解决有关算法偏差的问题,例如美联储的放贷歧视问题 。

其实,人工智能在现实生活也能起到减少人类现有偏见的作用。

最近,旧金山警方声称,指控人们犯罪时,它将使用人工智能来减少偏见,例如,通过自动编辑警方报告中的某些信息。在招聘领域,由风险投资公司支持的Fetcher正在着手通过利用人工智能来帮助公司寻找人才,该公司声称人工智能也有助于将人类偏见降至最低,Fetcher通过搜索在线渠道自动寻找潜在候选人,并使用关键字来确定个人可能拥有的、未在个人资料中列出的技能。该公司将自己定位为简单消除招聘偏见的平台,因为如果你训练一个系统遵循一套严格的标准,而这些标准只关注技能和经验,那么性别、种族或年龄等因素就不会被考虑在内。

在很多人工智能领域,AI如何扩散系统歧视的担忧是首要议程。微软敦促美国政府监管面部识别系统,研究人员致力于在不影响预测结果准确性的情况下减少人工智能中的偏见。

人工智能展示的偏差来源于何处?

人工智能正处于相对初期阶段,研究人员仍在研究如何解决算法偏差等问题。但Kozyrkov表示,人工智能展示的偏见和现存人类偏见是一样的,人类用来训练机器的数据集就像用来教育人类的教科书一样。数据集和教科书都有人类作者—它们都是根据人类的指示收集的,其中一个比另一个更容易搜索。一个可能是纸质版,另一个是电子版,实际上它们没什么区别。如果你给学生一本有极度偏见作家写的教科书,难道你的学生不会接受一些同样的偏见吗?

当然,在现实世界中,备受好评的同行评审期刊或教科书应该有足够的监督来对抗任何公然的偏见。如果作家、原始数据、鼓励学生阅读的教科书的老师都有相同的偏见呢?人们要花费很长的时间才能发现一些陷阱,但到那时阻止任何不良影响都为时已晚。因此,Kozyrkov认为“视角的多样性”对于确保最小的偏见是必不可少的。

研究人员越是关注自己的数据,思考用这些例子来表达自己的结论,就越有可能抓住那些潜在的坏案例。在人工智能中,数据的多样性是必须的,而且需要从不同的角度来看待和思考使用这些例子会对世界产生怎样的影响。

检验人工智能与检验学生学习的方法非常相似

人工智能算法和机器学习模型部署之前,关键要像学生考试一样测试它们,确保能够执行设定任务的。

如果在考试中,一个学生被问及学过的确切问题,可能表现得非常好,但这极大概率要归功于好的记忆,而不是对手头的科目有完全的了解。为了测试更广泛的理解,要为学生提供更多的问题,以便他们能更好的应用所学知识。

机器学习在同一个前提下运行——有一个被称为“过度拟合”的建模错误,即一个特定的函数与训练数据过于接近,就会导致误报。“计算机有很好的记忆力,“Kozyrkov指出,“所以你实际测试它们的方式是你给他们真正的新东西,他们无法记住,这与你的问题有关。如果它有效,那么它就有效。“

Kozyrkov在安全有效的人工智能四个原则和学生教学的四个基本原则之间进行了相似的比较并表示:

明确的教学目标—你想要教给你学生的东西。

相关和多样化的观点。

精心设计的测试。

安全网

安全网特别重要,因为很容易出现忽视“如果出现问题怎么办?”的情况。即使是最精心设计,人工智能系统也可能出现问题。事实上,系统越好在某些方面就越危险,就像学生一样。

Kozyrkov表示,即使你的学生真的很好,但他们仍然会犯错误。

甚至在某些方面,“C”学生比“A +”学生更不危险,因为“C”学生犯错误的频率较高,所以你已经有了安全网。 但是“A +”犯错频率较少,如果你以前从未见过他们犯错误,你可能会认为他们从未犯过错误,那么极有可能导致一个灾难性的失败。

所谓的“安全网”可以采取多种形式,通常涉及建立一个单独的系统而不是“过度信任你的“A +”学生。

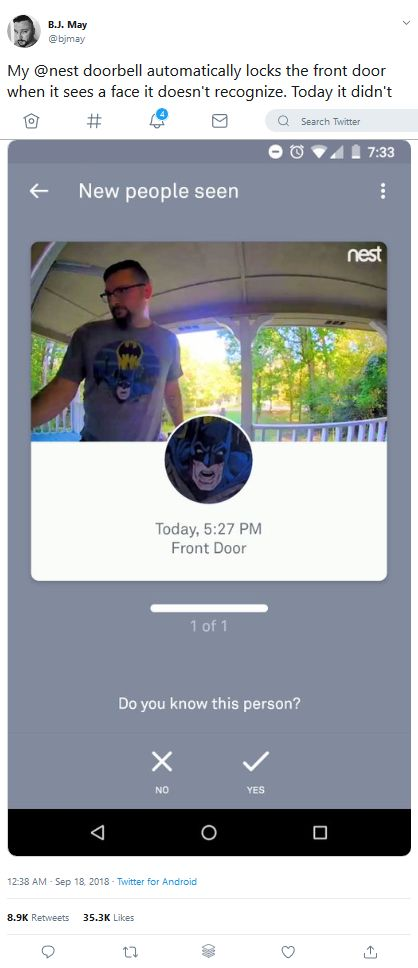

一个有趣的例子,房主配置他的智能相机和锁定系统以激活它是否发现不熟悉的面孔。但是,它错误地将房主识别为他的T恤上蝙蝠侠图像并拒绝他进入。在这种情况下,“安全网”是锁上的PIN,房主也可以在他的移动应用程序中使用一个功能来覆盖AI。

这些都引出了一个对许多人来说显而易又值得重复的观点:人工智能是其创造者的反映。因此,我们需要专注于实施系统和检查,以确保那些制造机器的人(“教师”)是负责的。

目前,人们越来越认同“机器教学”的重要性,微软等公司最近表示,人工智能的下一个前沿领域将需要利用人类专业人员的专业知识来培训机器学习系统——而不是专家对人工智能的知识或编码能力如何。。

“现在是我们关注机器教学的时候了,而不仅仅是机器学习,”Kozyrkov指出。“不要让科幻小说的华丽辞藻分散你对人类责任的注意力,要从一开始就关注人类本身。领导者设定的目标、工程师创作、分析师和决策者核查数据集、统计学家进行测试以及可靠性工程师构建的安全网——所有这些都包含了许多人为因素。”

来源:微信公众号 人工智能观察