上一节展示了如何使用矩阵分解来学习嵌入。但矩阵分解存在一些局限性,包括:

- 使用侧面特征困难(即查询ID /项目ID以外的任何特征)。因此,只能使用训练集中存在的用户或项目来查询模型。

- 建议的相关性。每个人都倾向于推荐受欢迎的项目,特别是在使用点积作为相似性度量时。最好是能够捕获特定的用户兴趣。

深度神经网络(DNN)模型可以解决矩阵分解的这些局限性。DNN可以轻松地合并查询特征和项目特征(由于网络输入层的灵活性),这有助于捕获用户的特定兴趣并提高建议的相关性。

Softmax DNN推荐

一种可能的DNN模型是softmax,它将问题看作多类预测问题,其中:

- 输入是用户查询。

- 输出是一个概率向量,其大小等于语料库中的项目数,表示与每个项目交互的概率; 例如,点击或观看YouTube视频的可能性。

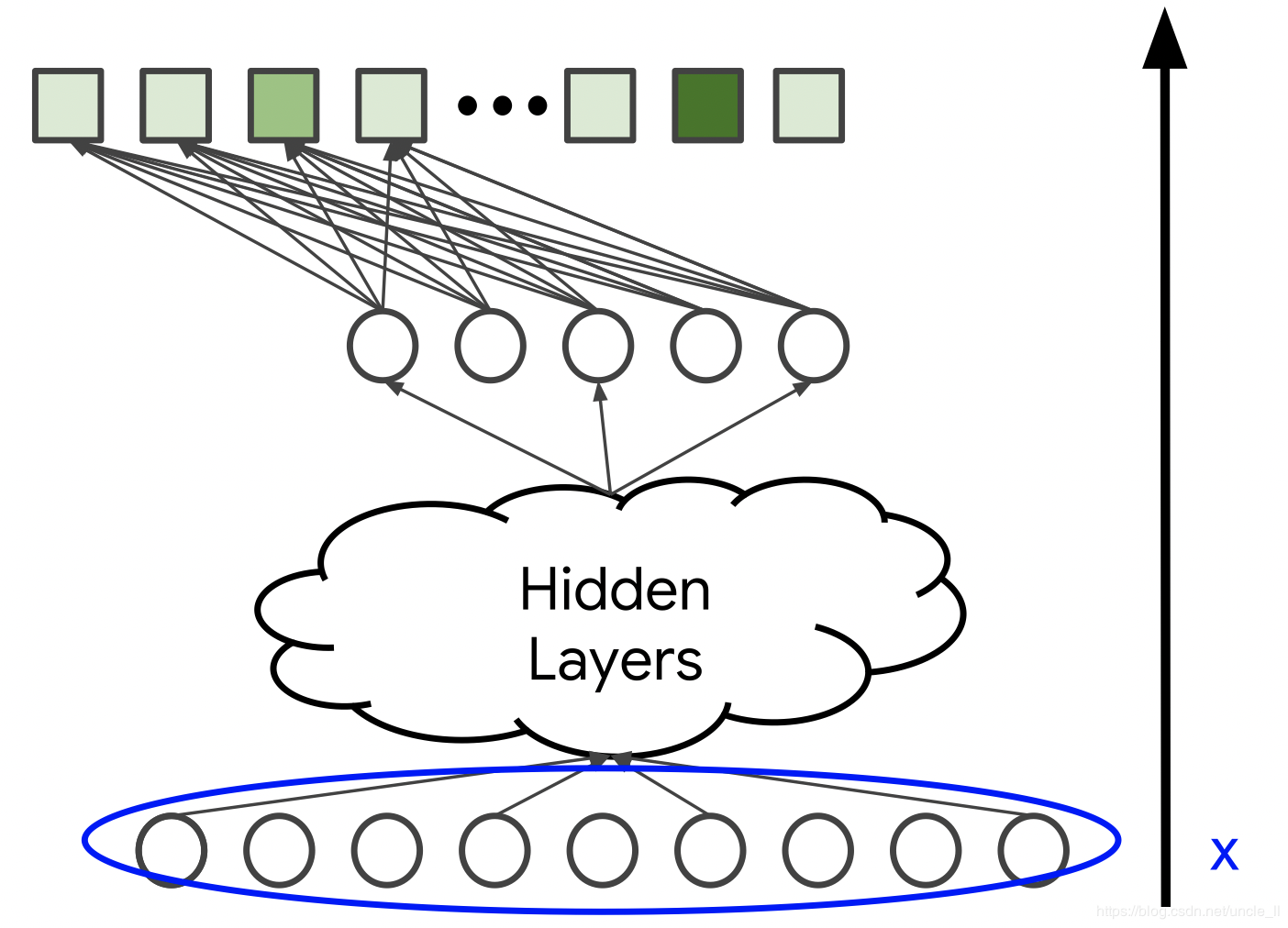

输入

DNN的输入可包括:

- 密集特征(例如,观看自上次观看以来的时间和时间)

- 稀疏特征(例如,观看历史记录和国家/地区)

与矩阵分解方法不同,还可以添加年龄或国家区域等侧面特征。这里用x表示输入向量。

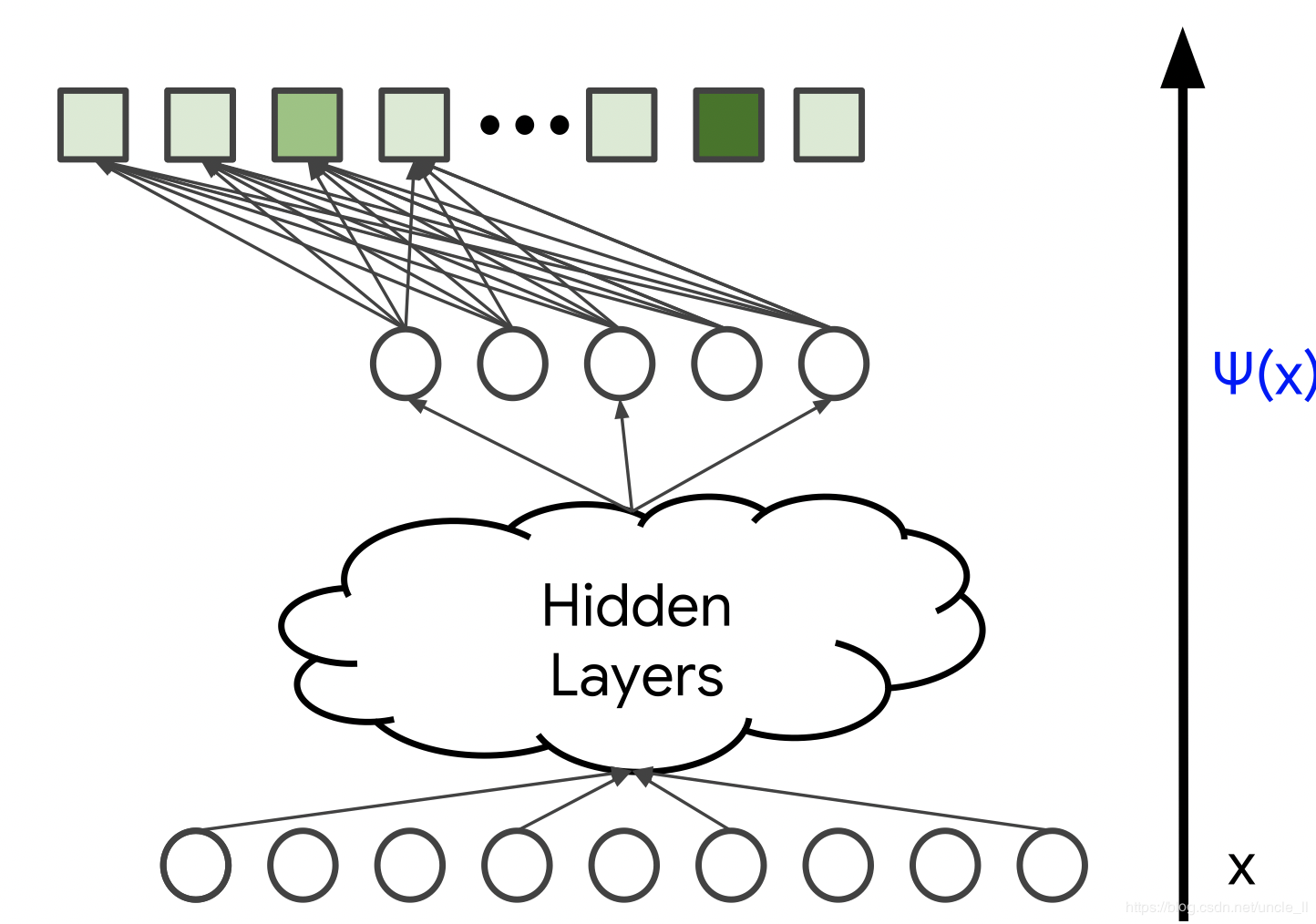

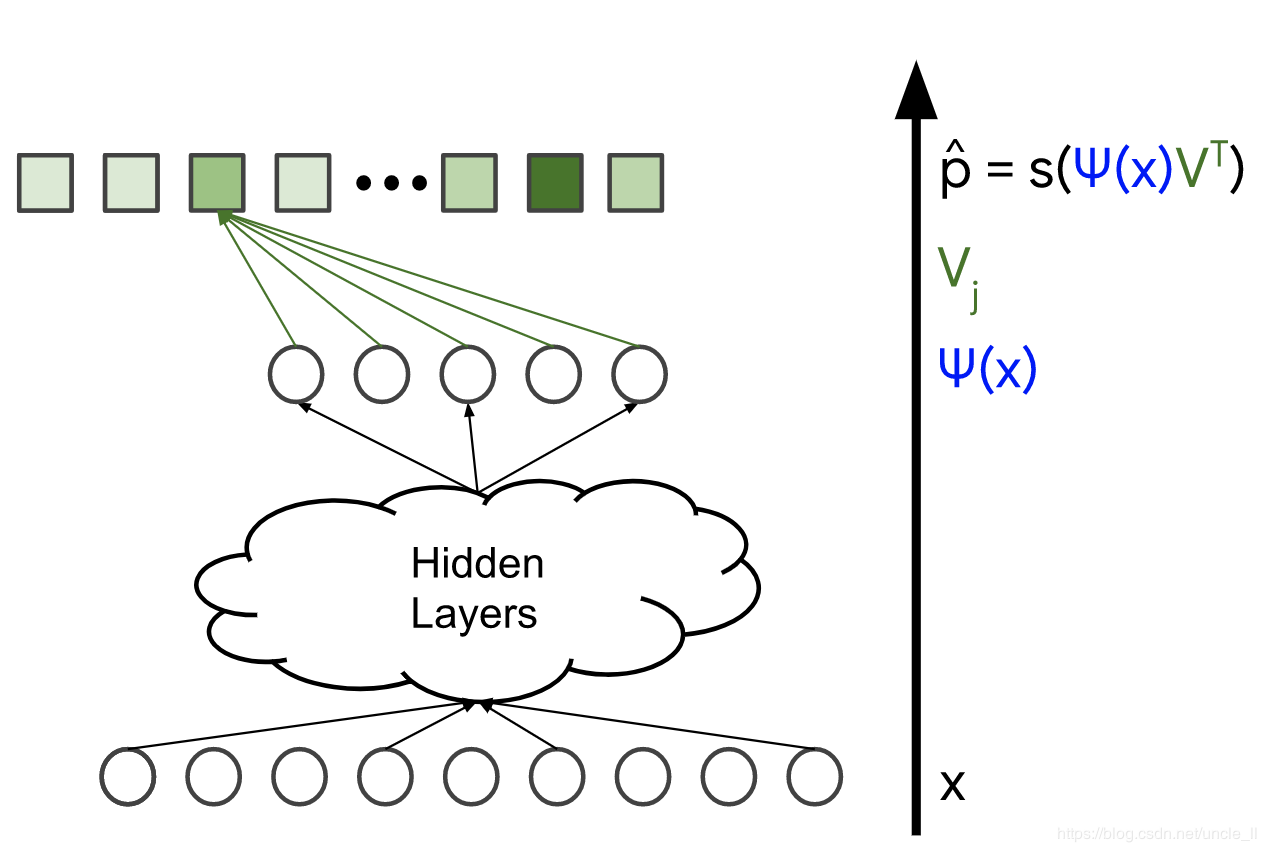

模型架构

模型架构决定了模型的复杂性和表现力。通过添加隐藏层和非线性激活函数(例如,ReLU),模型可以捕获数据中更复杂的关系。然而,增加参数的数量通常也使得模型更难以训练并且计算起来更复杂。最后一个隐藏层的输出用 $\psi (x) \in \mathbb R^d$ 表示。

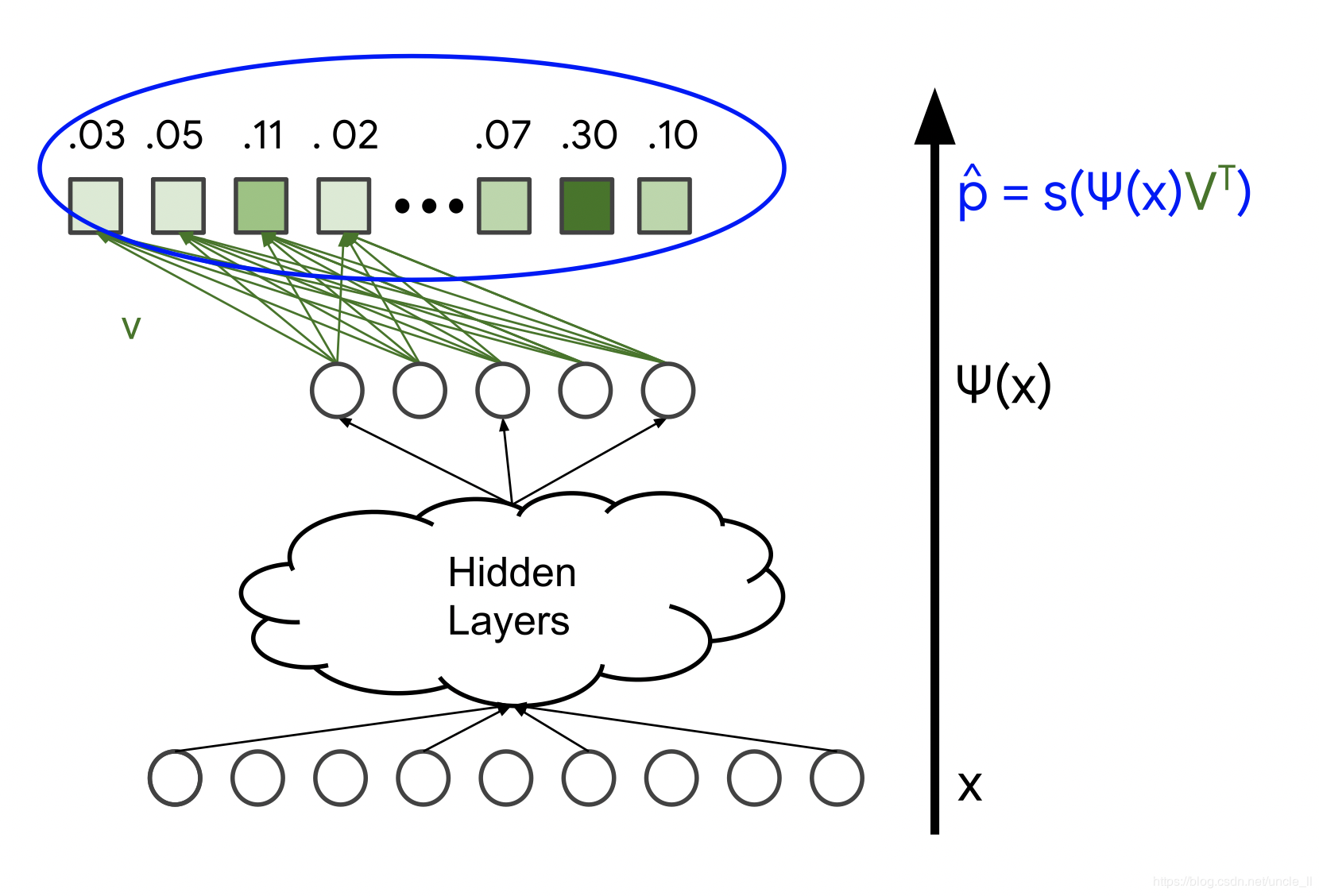

Softmax输出:预测的概率分布

模型映射最后一层的输出, ψ(X),通过softmax层到概率分布 $\hat p = h(\psi(x) V^T)$,其中:

- $h : \mathbb R^n \to \mathbb R^n$ 是softmax函数,由下式给出 $h(y)_i=\frac{e^{y_i}}{\sum_j e^{y_j}}$

- $V \in \mathbb R^{n \times d}$是softmax层的权重矩阵。

softmax层映射得分矢量$y \in \mathbb R^n$有时称为 (logits)为概率分布。

图3.预测的概率分布,$\hat p = h(\psi(x) V^T)$

你知道吗?

softmax这个名字是一个单词的游戏。“硬”(hard)表示将最大值的概率1分配给得分最高的项目 ÿ。相比之下,softmax为所有的项目分配非零概率,但是具有更高分数的项目其概率也越高。当 α→∞,分数缩放时,softmax $h(\alpha y)$ 收敛到"硬"最大值。

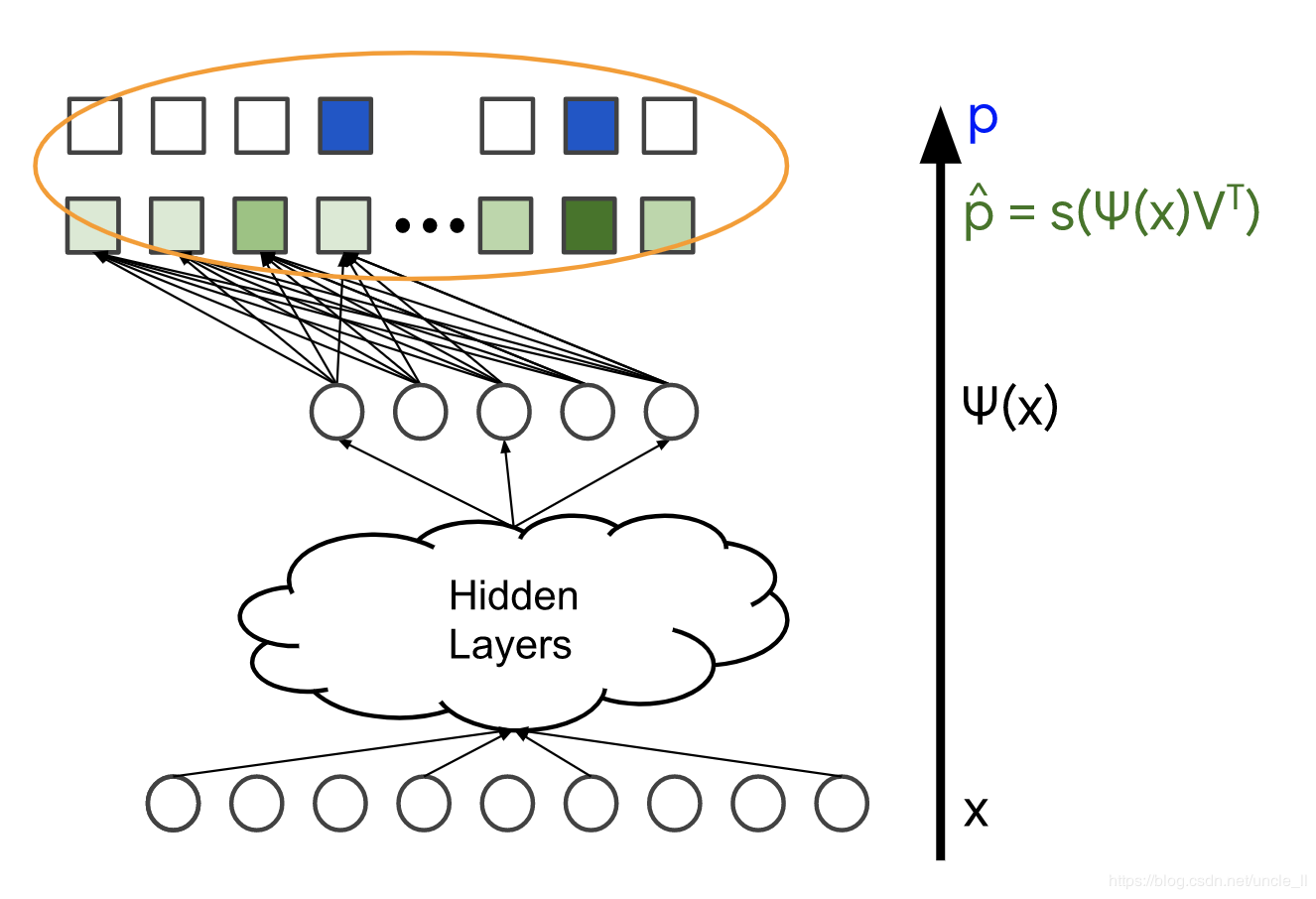

损失函数

最后,定义一个损失函数:

- $\hat p$,softmax层的输出(概率分布);

- $p$,真值,真实标签,可以表示为归一化的多热分布(概率矢量);

例如,可以使用交叉熵损失,因为正在比较两个概率分布。

Softmax嵌入

项目$j$的概率是$\hat p_j = \frac{\exp(\langle \psi(x), V_j\rangle)}{Z}$得到,其中 $Z$ 是一个不依赖$j$的归一化常数。

换一种说法,$\log(\hat p_j) = \langle \psi(x), V_j\rangle - log(Z)$,所以项目$j$的对数概率 是(最多为加性常数)两个d维度向量的点积 ,可以将其解释为查询和项目的嵌入:

- $\psi(x) \in \mathbb R^D$是最后一个隐藏层的输出,称之为查询$x$嵌入;

- $V_j \in \mathbb R^d$是将最后一个隐藏层连接到输出j的权重向量,称之为项目$j$嵌入;

注意: 由于log函数是一个递增函数,项目$j$概率最高的 $\hat p_j$ 会获得最高点积的项目$\langle \psi(x) , V_j\rangle$。因此,点积可以被解释为该嵌入空间中的相似性度量。

图5.项目的嵌入 $V_j \in \mathbb R^d$

DNN和矩阵分解

在softmax模型和矩阵分解模型中,系统都是对每一个项目 $j$学习嵌入向量 $V_j$。在矩阵分解中,将其称之为项目嵌入矩阵 $V \in \mathbb R^{n \times d}$;在DNN中,是通过softmax层的权重矩阵表示。

但是,查询嵌入的表示是不同的。在DNN中,不再是对每一个查询$i$学习一个嵌入$U_i$,而是系统从查询特征中学习映射查询特征X为查询嵌入$\psi(x) \in \mathbb R^d$。因此,可以将DNN模型视为矩阵分解的泛化。

使用物品特征

可以将相同的想法应用到学习项目嵌入上面吗?即,不是为每一个项目学习到一个嵌入,而是模型是否可以学习将项目特征映射到项目嵌入的非线性函数?答案是可以的。实现这一点需要使用双塔神经网络,该网络由两个神经网络组成:

- 一个神经网络映射查询特征$x_{query}$到查询嵌入$\psi(x_{\text{query}}) \in \mathbb R^d$

- 一个神经网络映射项目特征$x_{item}$到项目嵌入$\phi(x_{\text{item}}) \in \mathbb R^d$

模型的输出可以定义为点积 $\langle \psi(x_{\text{query}}), \phi(x_{\text{item}}) \rangle$。注意,这里不再是softmax模型。新模型预测每对$(x_{\text{query}}, x_{\text{item}})$值, 而不是每个查询$x_{query}$的概率向量。