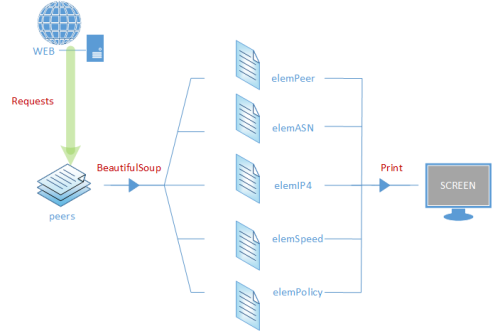

在前几周的grep/sed/awk实战中提到,“和CoreSite - Any2 California接入商建立网络BGP邻居关系。从peeringdb上找到了所有接入商的信息,但是转移信息到本地不是很方便,需要进行多次文本调整,耗时较长。作为萌新,立马就想到近期学习的grep/sed/awk工具。于是就尝试处理数据。”因为当时是刚学习了linux正则的这三个工具,就立马利用了起来,权当练手。在文末也曾提到所有的操作其实都可以通过python完成。

恰巧近几天,又学习了python抓取页面提取信息的一些知识。因此,就同样的内容,再次以python的方式去处理。

▎元素样本:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

<

div

class

=

"row item"

>

<

div

class

=

"col-xs-5 col-sm-5 col-md-5"

>

<

div

class

=

"peer"

data-sort-value

=

"zenlayer inc"

data-filter-value

=

"Zenlayer Inc"

>

<

a

href

=

"/net/1234"

>Zenlayer Inc</

a

>

</

div

>

<

div

class

=

"asn"

data-sort-value

=

"21859"

data-filter-value

=

"21859"

>21859</

div

>

</

div

>

<

div

class

=

"col-xs-4 col-sm-4 col-md-4"

>

<

div

class

=

"ip4"

data-filter-value

=

"206.72.210.119"

>206.72.210.119</

div

>

<

div

class

=

"ip6"

data-filter-value

=

"None"

>None</

div

>

</

div

>

<

div

class

=

"col-xs-3 col-sm-3 col-md-3"

>

<

div

class

=

"speed"

data-sort-value

=

"20000"

data-filter-value

=

"20G"

>20G</

div

>

<

div

class

=

"policy"

data-filter-value

=

"Open"

>Open</

div

>

</

div

>

</

div

>

|

▎处理思路:

▎简易版脚本:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

#/usr/bin/env python

import

requests,bs4

headers

=

{

'User-Agent'

:

'Mozilla/5.0 (X11; Ubuntu; Linux x86_64; rv:24.0) Gecko/20100101 Firefox/24.0'

}

url

=

'https://www.peeringdb.com/ix/142'

peering

=

requests.get(url,headers

=

headers)

peering.raise_for_status()

peers

=

bs4.BeautifulSoup(peering.text[:],

'html.parser'

)

elemPeer

=

peers.select(

'.peer a'

)

elemASN

=

peers.select(

'.asn'

)

elemIP4

=

peers.select(

'.ip4'

)

elemSpeed

=

peers.select(

'.speed'

)

elemPolicy

=

peers.select(

'.policy'

)

if

__name__

=

=

'__main__'

:

for

i

in

range

(

len

(elemPeer)):

print

(elemPeer[i].getText()

+

'*'

+

elemASN[i].getText()

+

'*'

+

elemIP4[i].getText()

+

'*'

+

elemSpeed[i].getText()

+

'*'

+

elemPolicy[i].getText())

|

作为简易版,这里没有做任何的异常处理,也没有对各个元素的list进行长度比较。这部分在后期可以考虑加上。代码相关的解释参见学习笔记,主要运用了requests和BeautifulSoup两个模块。需要解释的是,elemPeer这个变量在处理的时候,因为“class="peer"”内还有一行“<a href="/net/1234">Zenlayer Inc</a>”,因此还需要加上“a”元素精确定位抓取。

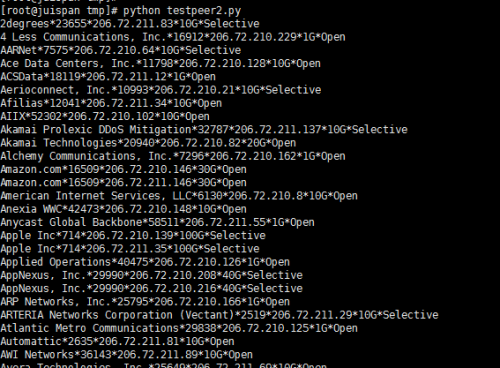

▎运行效果:

由于测试系统为CentOS 7,不支持Excel,因此这里不使用openpyxl模块导入EXCEL文件里这个功能。暂时改为手动处理。

阅读者如有兴趣,可优化代码,并深入处理,如:登录网站、爬虫每个接入商的页面,提取其他信息等。

对比此文和前次利用grep/sed/awk处理的两种方式,可以发现python版的处理方式更为简洁,人工处理的部分更少。由此,可以看到python在处理大数据信息上的优势。

本文转自Grodd51CTO博客,原文链接:http://blog.51cto.com/juispan/1952178,如需转载请自行联系原作者