一、Cloudera Manager/CDH5

1、关于cloudera manager和CDH是什么,这里不做详细介绍了。有官网和百科介绍。

附上官网地址:cloudera manager

2、官网的安装指南

官方文档提供了三种安装方式:在线自动安装/手动安装包安装/手动使用cloudera manager管理安装

此处使用第三种方式安装hadoop集群。

二、环境规划

1、系统:CentOS 6.4_x86

master:4G内存,硬盘尽量大容量

slave1:2G内存,硬盘尽量大容量

slave2:2G内存,硬盘尽量大容量

2、Cloudera Manager 5.3.3

3、CDH 5.3.3

安装包下载:

-

Cloudera Manager 5.3.3:http://archive-primary.cloudera.com/cm5/cm/5/

-

CDH 5.5.5:http://archive-primary.cloudera.com/cdh5/parcels/5.3.3/

下载软件包:

三、系统环境准备工作

-

此次执行权限均为root用户

-

所有的机器都必须ssh互信模式

-

修改主机名使用hosts文件或者DNS服务器

-

关闭iptables和selinux

-

卸载系统自带的openjdk,安装oracle的jdk

-

master节点安装mysql

-

所有节点的时间必须同步(ntp服务器或其他方法)

-

修改所有节点的内核参数

i. echo 0 > /proc/sys/vm/swappiness

ii.echo never > /sys/kernel/mm/redhat_transparent_hugepage/defrag

四、正式开始安装

1、cloudera manager默认的目录是在/opt下,解压到/opt目录下。

|

1

2

3

4

5

6

|

# tar xf cloudera-manager-el6-cm5.3.3_x86_64.tar.gz -C /opt/

# ls /opt/

cloudera cm

-

5.3

.

3

#

# 安装mysql-connector-java

# yum -y install mysql-connector-java

|

2、初始化数据库

|

1

2

|

# /opt/cm-5.3.3/share/cmf/schema/scm_prepare_database.sh mysql cm -hlocalhost -uroot -p123456 --scm-host localhost scm scm scm

# mysql -uroot -p123456 -e "show databases;" 查看下cm数据库是否创建成功

|

3、复制数据到其他节点

|

1

2

3

4

5

6

7

8

|

# 修改配置文件server_host为master节点的主机名

# grep server_host /opt/cm-5.3.3/etc/cloudera-scm-agent/config.ini

server_host

=

master

# scp -rp /opt/cm-5.3.3 slave1:/opt/

# scp -rp /opt/cm-5.3.3 slave2:/opt/

#

# 每个节点创建系统用户

# useradd --system --home=/opt/cm-5.3.3/run/cloudera-scm-server --no-create-home --shell=/bin/false --comment "cloudera scm user" cloudera-scm

|

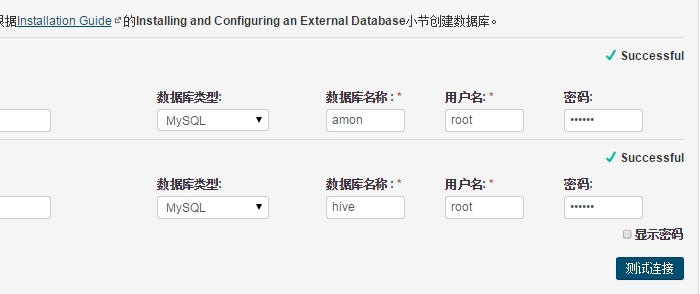

4、数据库的配置

|

1

2

3

4

5

6

|

# hive

# create database hive DEFAULT CHARSET utf8 COLLATE utf8_general_ci;

# active monitor

# create database amon DEFAULT CHARSET utf8 COLLATE utf8_general_ci;

# 授权master主机

# grant all on *.* to 'root'@'master' identified by 'PASSWD';

|

5、准备parcels安装包到/opt/cloudera/parcel-repo/

|

1

2

3

4

5

6

7

8

9

10

11

|

# ls /opt/cloudera/parcel-repo/

CDH

-

5.3

.

3

-

1.cdh5

.

3.3

.p0.

5

-

el6.parcel CDH

-

5.3

.

3

-

1.cdh5

.

3.3

.p0.

5

-

el6.parcel.sha manifest.json

# 注意:CDH-5.3.3-1.cdh5.3.3.p0.5-el6.parcel.sha下载后的文件重命名的

#

# 启动master节点的server和agent脚本

# /opt/cm-5.3.3/etc/init.d/cloudera-scm-agent start

# /opt/cm-5.3.3/etc/init.d/cloudera-scm-server start

# server端口启动较慢

#

# 启动其他所有节点的agent脚本

# /opt/cm-5.3.3/etc/init.d/cloudera-scm-agent start

|

五、CDH 5安装配置

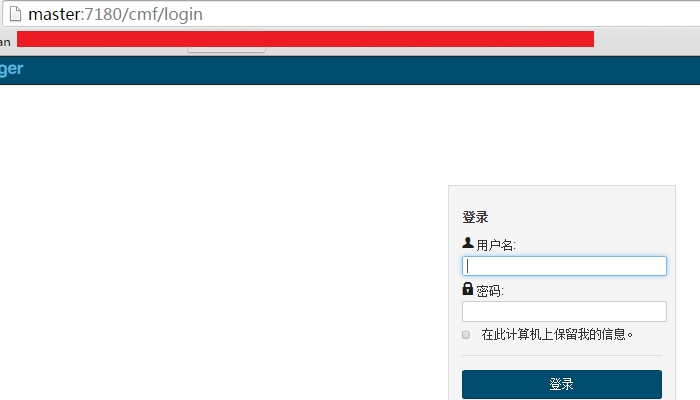

1、访问http://master-ip:7180端口开始安装

登陆名:admin 密码:admin

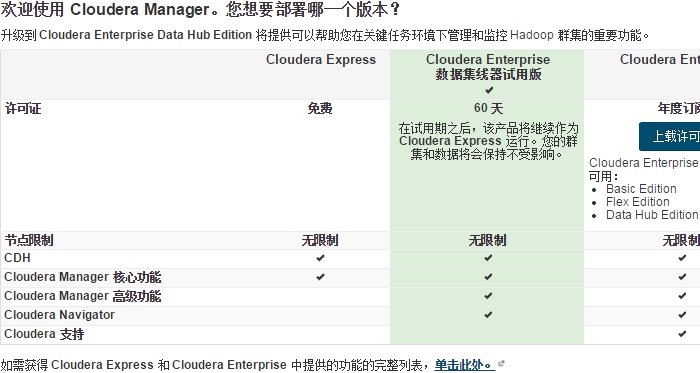

2、选择一个版本进行安装,此处选择第一个免费版。然后下一步-->下一步

3、选中所有主机:

4、如果配置正确,会出现如下界面

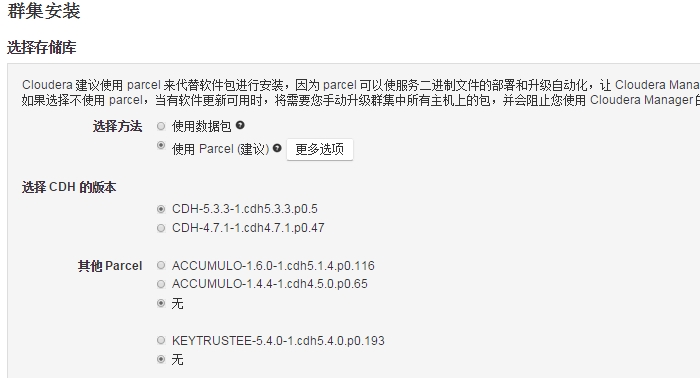

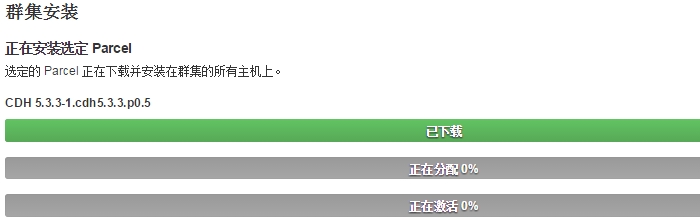

5、然后继续下一步,由于我们已经下载了离线包,所以下载是很快就能完成的

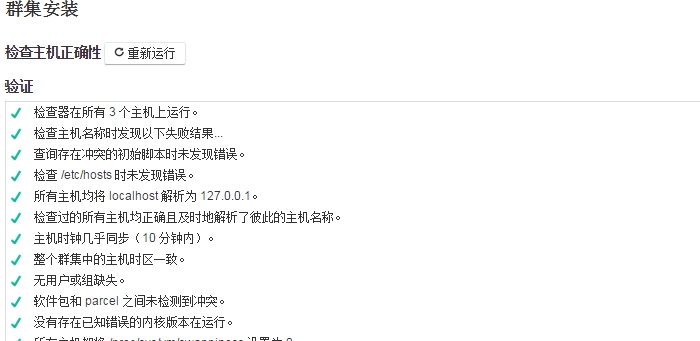

6、主机检测,检测主机是否符合安装要求,符合要求后会全部通过,否则请按照要求设置

7、然后选择需要安装的软件包,可以全选或自定义,也可以选择集成了某一个组件功能的软件包来安装

8、角色分配,此处默认,可以按需调整

9、数据库测试:

10、审核更改参数,可以使用默认,也可以按需更改

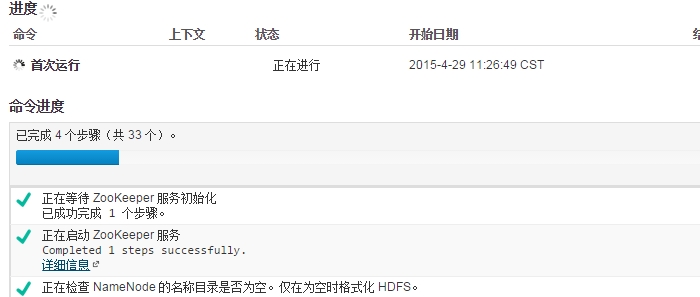

11、启动正常的安装配置了,等待安装完成后再次访问主页即可。

12、完成后的登陆界面

由于主机性能较低,数据延迟很大,查询经常无法显示。而且由于此处的磁盘空间不足,所以有很多警告信息。到此安装已全部完成。

六、其他问题说明

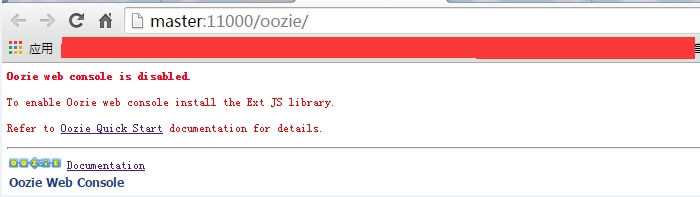

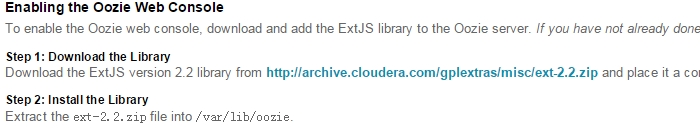

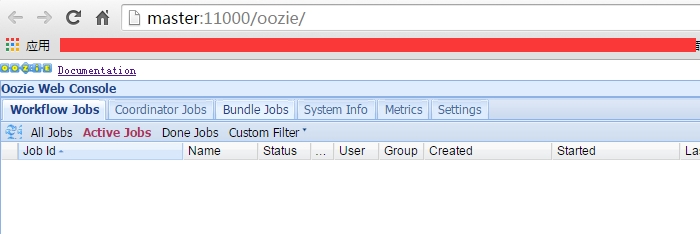

oozie的web界面的开启:

cloudera的文档中有说明配置oozie:

安装这个操作即可:

|

1

2

3

|

# mv ext-2.2.zip /var/lib/oozie/

# cd /var/lib/oozie

# unzip ext-2.2.zip

|

刷新界面:

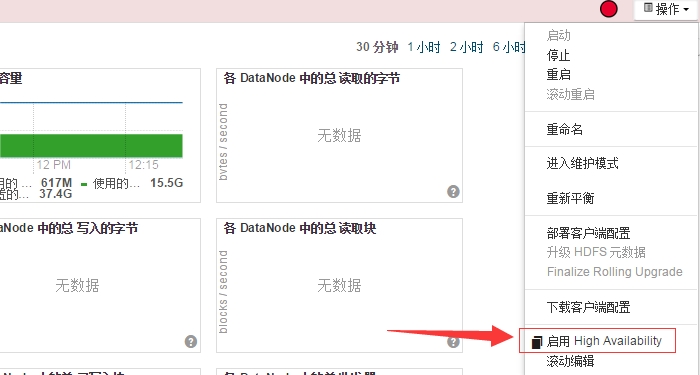

hadoop2.x版本更新了一些新功能,支持HDFS的高可用等。cloudera manager管理界面可以直接操作等这一系列的功能,还是很方便的。

在集群里的HDFS界面的右上角有操作选项栏:

点击后根据提示就能正常的配置了。管理界面添加移除集群中的主机也是非常方便的,具体的操作就不一一演示了。

七、Hadoop测试程序

|

1

2

3

4

5

6

|

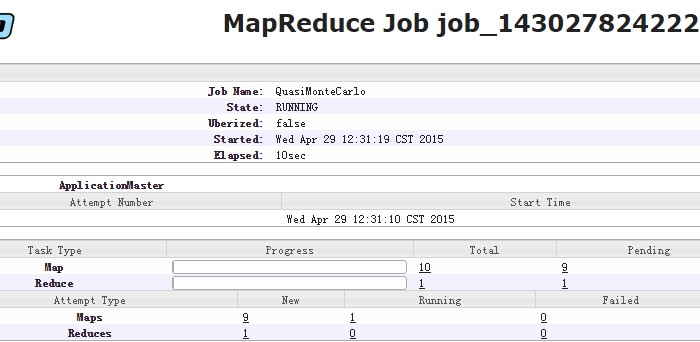

# 计算pi值

# sudo -u hdfs hadoop jar /opt/cloudera/parcels/CDH/lib/hadoop-mapreduce/hadoop-mapreduce-examples.jar pi 10 100

...

Job Finished

in

126.439

seconds

Estimated value of Pi

is

3.14800000000000000000

# 可以看到执行结果

|

可以在YARN的web界面看到详细job的信息

还有很多测试程序可以运行测试。这里就不一一演示了。

另外,这种安装方式虽然快捷方便,但是不利于对整体的理解,建议还是使用下载安装包的方式安装,配置文件等都是需要手动编写的,对于理解比较深刻。

本文转自Mr_陈 51CTO博客,原文链接:http://blog.51cto.com/chenpipi/1640255,如需转载请自行联系原作者