1.网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。

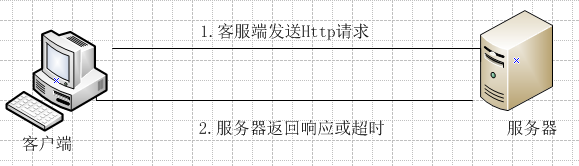

2.那么程序获取网页的原理到底是怎么回事呢?看下面的图:客服端首先向服务器端发出Http请求,之后服务器端返回相应的结果或者请求超时客户端自己报错。

服务器端发出的Http请求,实际上说是对服务器的文件的请求。下面的表格是一些常见的HTTP请求对应的文件。(因为第一列给出的都是主机的网址信息,主机一般都通过配置文件将该请求转换为网站主页地址index.php或index.jsp或者index.html等)

服务器端发出的Http请求,实际上说是对服务器的文件的请求。下面的表格是一些常见的HTTP请求对应的文件。(因为第一列给出的都是主机的网址信息,主机一般都通过配置文件将该请求转换为网站主页地址index.php或index.jsp或者index.html等)

| HTTP请求 | HTTP对应的文件 |

| http://www.baidu.com | http://www.baidu.com/index.php |

| http://www.sina.com.cn | http://www.sina.com.cn/index.html |

| http://www.cnblogs.com | http://www.cnblogs.com/index.html |

| http://ac.jobdu.com | http://ac.jobdu.com/index.php |

3.java实现网页源码获取的步骤:

(1)新建URL对象,表示要访问的网址。如:url=new URL("http://www.sina.com.cn");

(2)建立HTTP连接,返回连接对象urlConnection对象。如:urlConnection = (HttpURLConnection)url.openConnection();

(3)获取相应HTTP 状态码。如responsecode=urlConnection.getResponseCode();

(4)如果HTTP 状态码为200,表示成功。从urlConnection对象获取输入流对象来获取请求的网页源代码。

4.java获取网页源码代码:

import java.io.BufferedReader; import java.io.InputStreamReader; import java.net.HttpURLConnection; import java.net.URL; public class WebPageSource { public static void main(String args[]){ URL url; int responsecode; HttpURLConnection urlConnection; BufferedReader reader; String line; try{ //生成一个URL对象,要获取源代码的网页地址为:http://www.sina.com.cn url=new URL("http://www.sina.com.cn"); //打开URL urlConnection = (HttpURLConnection)url.openConnection(); //获取服务器响应代码 responsecode=urlConnection.getResponseCode(); if(responsecode==200){ //得到输入流,即获得了网页的内容 reader=new BufferedReader(new InputStreamReader(urlConnection.getInputStream(),"GBK")); while((line=reader.readLine())!=null){ System.out.println(line); } } else{ System.out.println("获取不到网页的源码,服务器响应代码为:"+responsecode); } } catch(Exception e){ System.out.println("获取不到网页的源码,出现异常:"+e); } } }