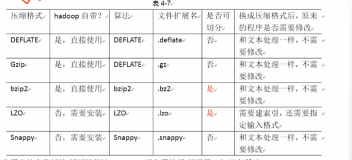

在EMR的项目中,按理阿里云目前提供的解决方案,大多数的同学可能都是使用的logtail做的日志收集,然后通过logshipper投递到oss中存储。这么配置以后,存储在oss里面的文件都是snappy格式了,但是怎么使用估计大部分同学是一脸懵逼的。

有两个小的配置,可以方便的和使用gzip一样使用snappy文件。

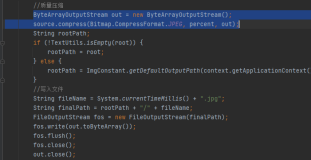

1 hadoop fs -text的命令直接查看。如果是直接使用的话,你看到的都是二进制,直接把shell搞死。需要用下面的格式查看

hadoop fs -Dio.compression.codec.snappy.native=true -text oss://xxx/xx.snappy

2使用MR脚本的时候,需要配置下,这个可能大部分同学都会,因为之前使用gzip的时候,也需要添加类似的配置项才能跑起来

hadoop ....... -jobconf io.compression.codec.snappy.native=true