实验背景介绍

了解更多2017云栖大会·北京峰会 TechInsight & Workshop.

本手册为云栖大会Workshop之《云计算·大数据:海量日志数据分析与应用》场的前提准备条件所需。主要为保障各位学员在workshop当天能够顺畅进行动手实操,那么本场需要各位学员再参加之前确保自己云账号已免费开通表格存储TableStore、大数据计算服务MaxCompute、DataWorks和Quick BI。

实验涉及大数据产品

- 表格存储 TableStore

- 大数据计算服务 MaxCompute

- 数据工场 DataWorks

- 智能分析套件Quick BI

其中表格存储TableStore、大数据计算服务MaxCompute的服务Region都选择华北2.

实验环境准备

必备条件:首先需要确保自己有阿里云云账号并已实名认证。详细点击:

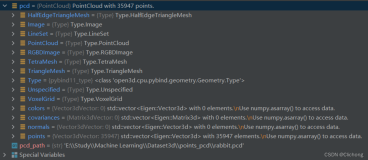

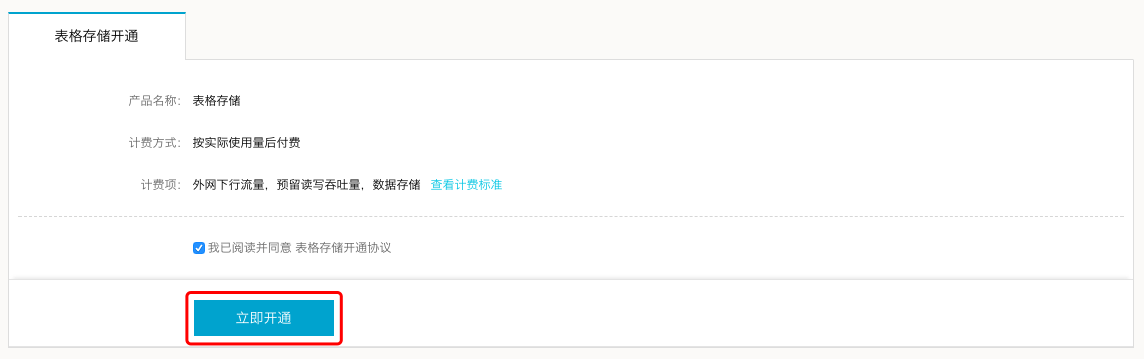

开通表格存储TableStore

若已经开通和购买了TableStore,可以忽略此步骤,直接进入开通MaxCompute步骤。

- step1:进入阿里云官网并点击右上角登录阿里云账号。

- step2:点击进入表格存储TableStore详情页,点击立即开通。

- step3:进入开通页面,点击立即开通。

- step4:随之点击进入管理控制台。

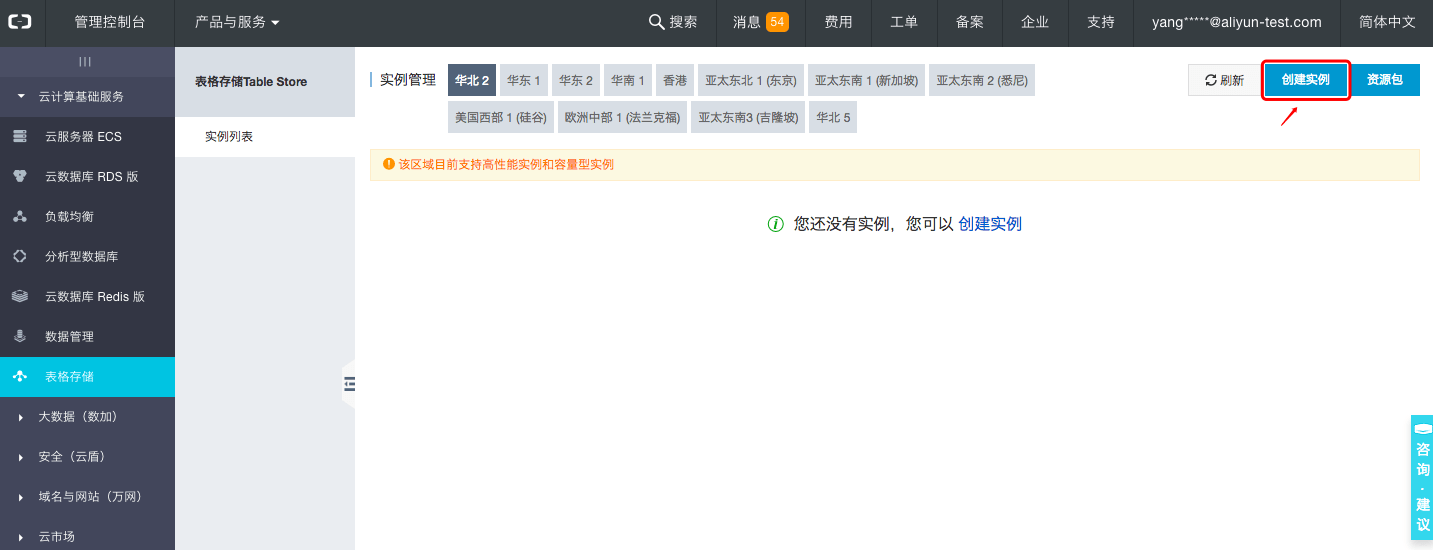

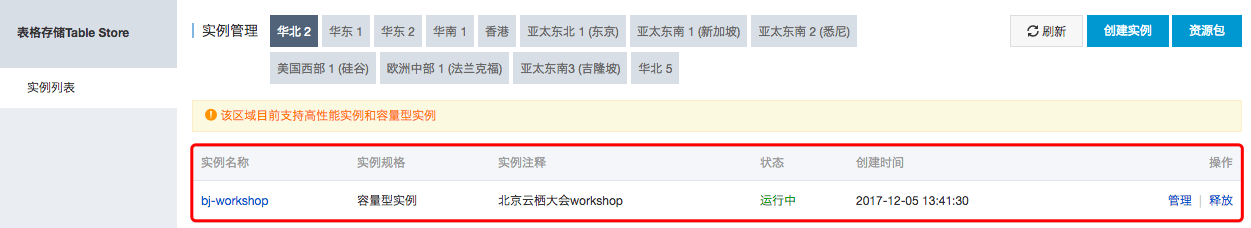

- step5:创建实例,选择华北2,点击创建实例,选择容量型实例。

注意:实例名称在TableStore中,同一个Region下是全局唯一,建议大家选用自己可辨识且符合规则的名称即可。在MaxCompute数据处理中也会用到此实例名称。

至此,北京云栖大会workshop所需的表格存储TableStore服务已经开通好。

关于如何选择实例,详见实例。

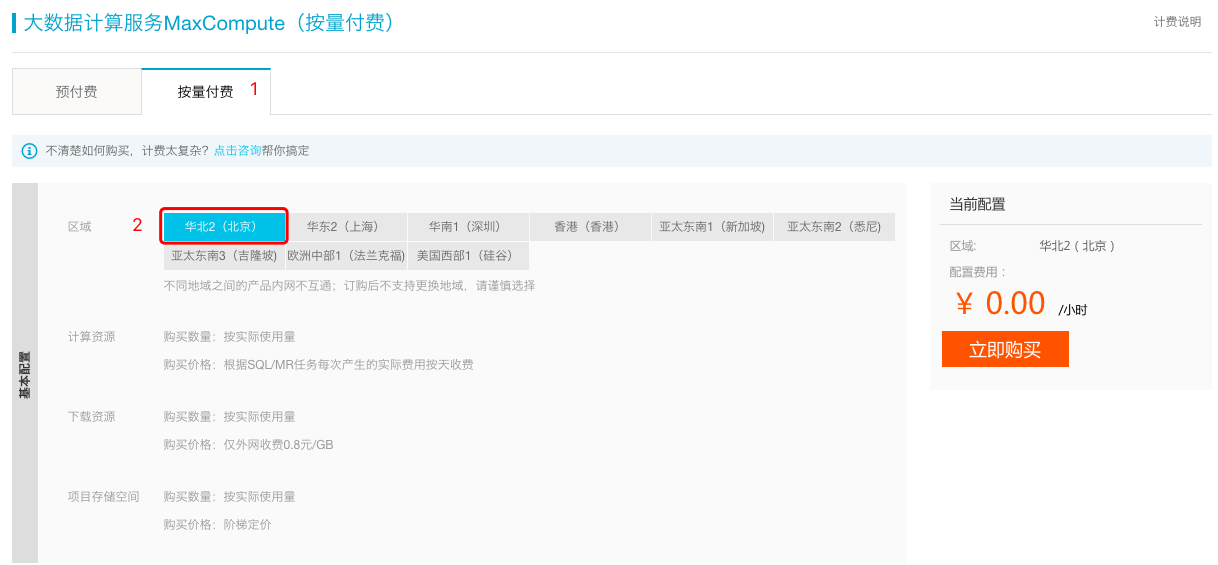

开通大数据计算服务MaxCompute

若已经开通和购买了MaxCompute,请忽略次步骤直接进入创建DataWorks项目空间。

- step1:点击进入大数据计算服务产品MaxCompute详情页,点击立即购买。

- step2:选择按量付费并点击立即购买。

注意:选择华北2(北京)Region进行按量付费服务的开通。

创建DataWorks项目空间

确保阿里云账号处于登录状态。

- step1:点击进入大数据(数加)管理控制台>大数据开发套件tab页面下。

- step2:点击右上角创建项目,跳出创建项目对话框。

- step3:勾选付费方式为I/O后付费,填写项目名称及相关信息,点击确定,直至返回创建成功状态。

项目名需要字母或下划线开头,只能包含字母下划线和数字。

【注意】项目名称全局唯一,建议大家采用自己容易区分的名称来作为本次workshop的项目空间名称。

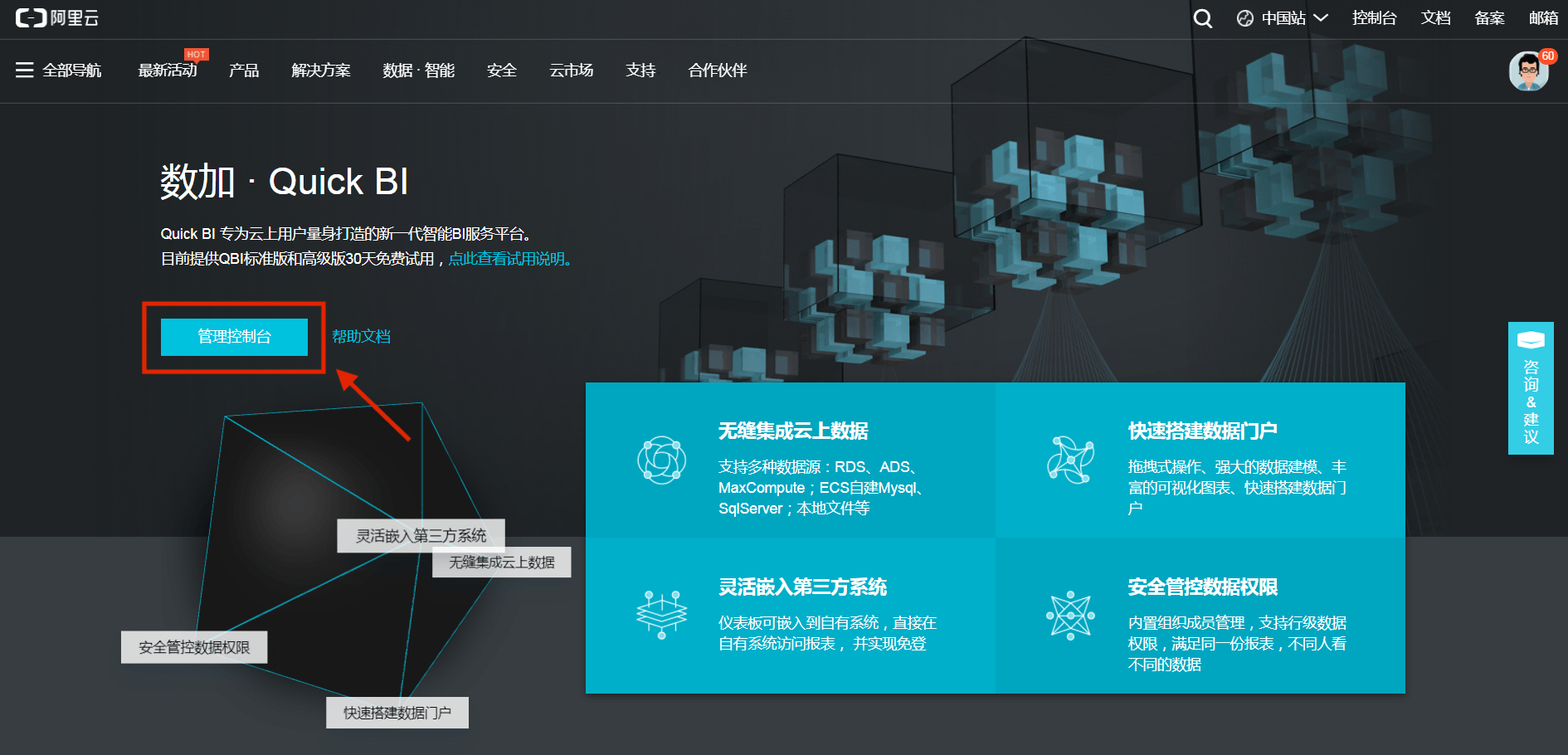

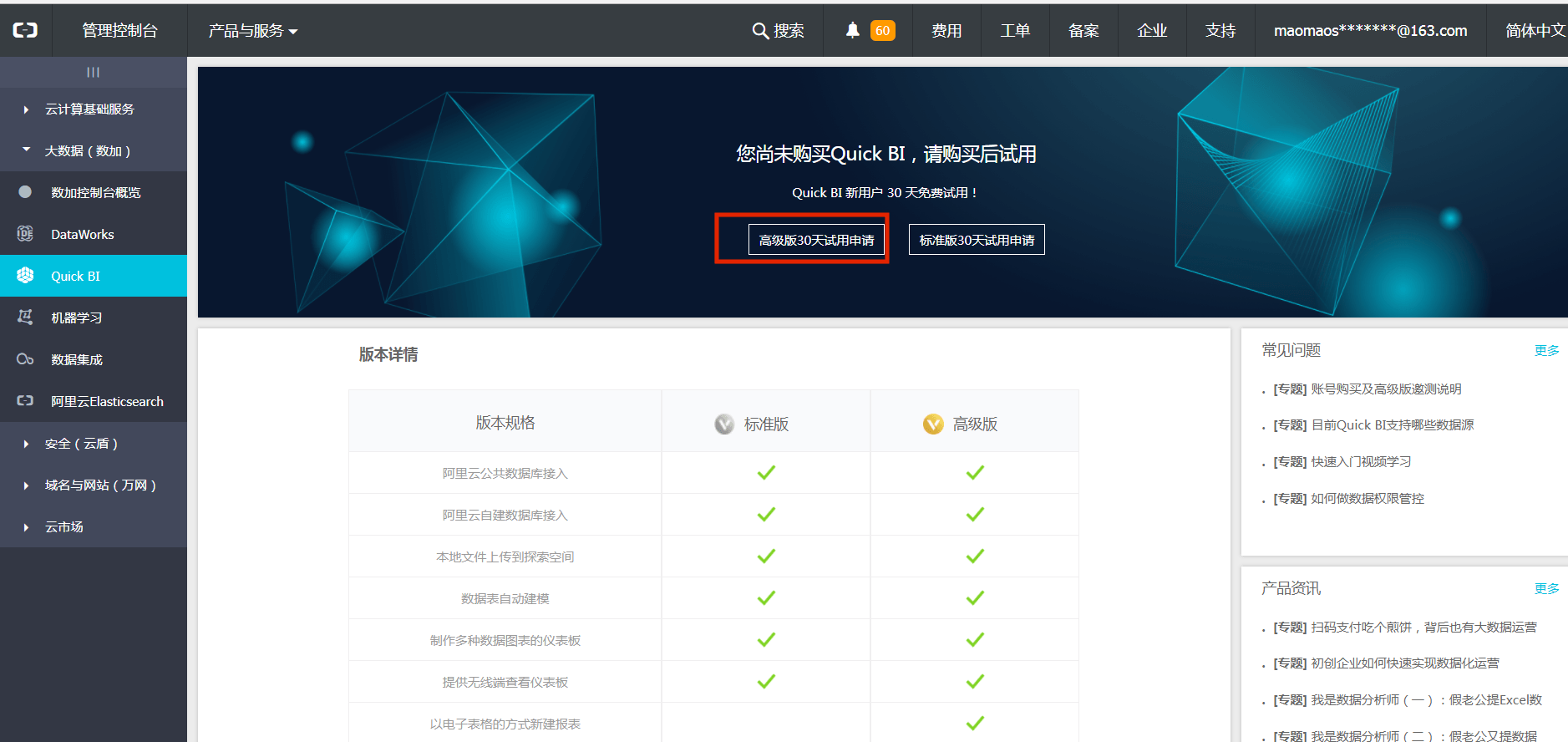

0元购开通Quick BI

确保阿里云账号处于登录状态。

- step1: 点击进入产品-大数据分析及展现-Quick BI详情页,点击管理控制台。

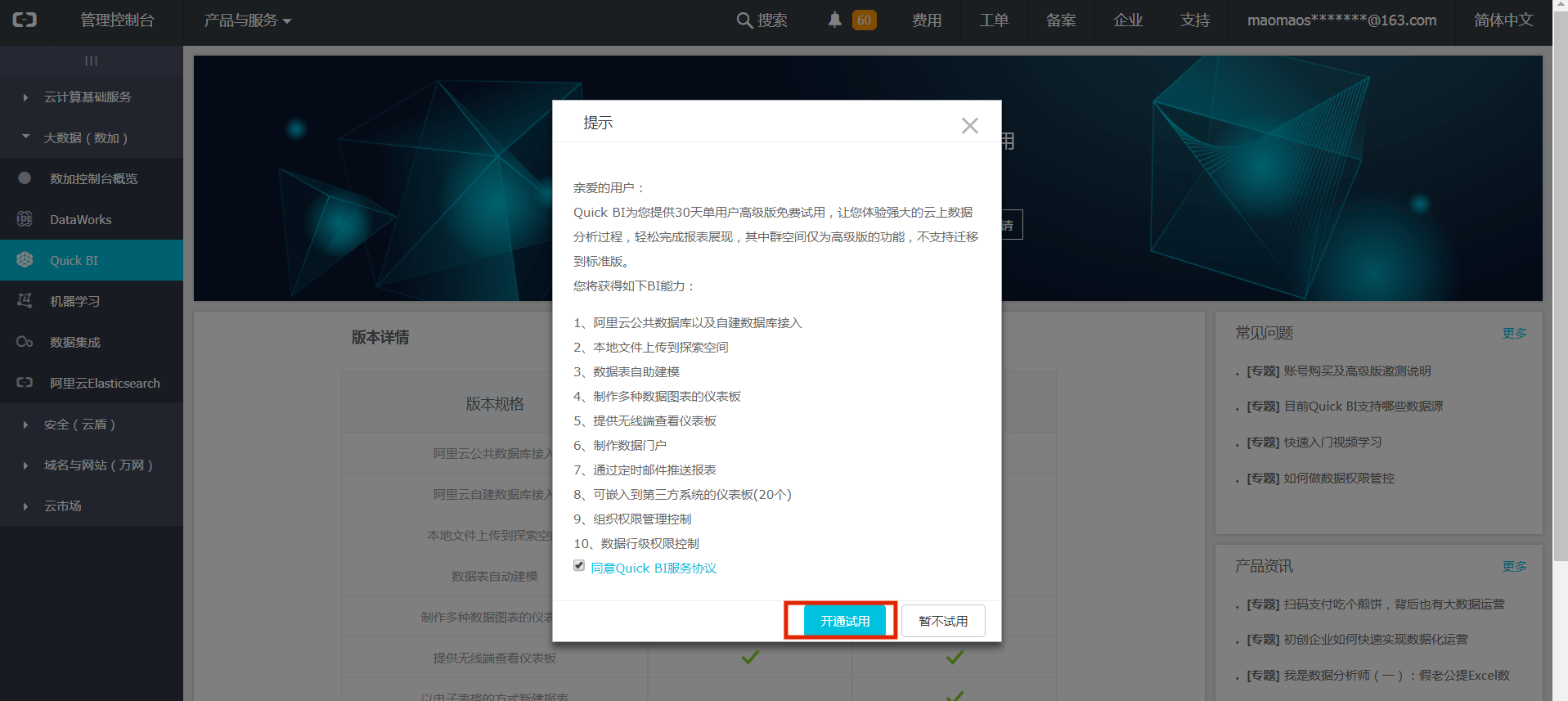

- step2:进入控制台页面,点击高级版30天试用申请。

- step3:弹出高级版协议,先勾选同意Quick BI服务协议,再点击开通试用。

- step5:成功开通Quick BI如下图所示,点击进入Quick BI高级版 开始分析。

通过以上的步骤就可以完成北京workshop《云数据·大计算:快速搭建互联网在线运营分析平台》场的实验环境配置。