AMD宣布计划推出一系列人工智能产品,包括3款图形加速卡,4款OEM机箱和一系列开源软件。在这个新兴市场中,Nvidia已经发展了一段时间,英特尔和几个初创公司也都在开发替代产品。

AMD将在面向机器学习的GPU领域“引发以前从来没有过的竞争”,Tirias Research高级分析师Kevin Krewell这样表示。

“关键是没有那么多卡,但是有很多软件,”Krewell表示。“Nvidia提供Cuda软件来帮助人们立即开始进行编码。AMD支持OpenCL,但是现在他们有更有吸引力的解决方案。”

AMD公布了3款在Radeon Instinct新品牌下的图形卡,支持16位打包浮点运算操作,其中2款卡预计将在明年年初出货,采用现有的GPU,针对推断类的任务。

150W MI6采用Polaris GPU和16Bytes内存,通过224 Gbit/s链路提供最高5.7 TFlops的FP16峰值性能。175W MI8加速卡在2.5-D堆栈上采用Fiji Nano GPU,有4GB High-Bandwidth Memory运行在512 Gbit/s链路上,性能最高可达到8.2 TFlops。高端300W MI25卡针对培训任务,采用AMD的下一代Vega GPU,将在7月前出货。

这些卡将运行在4月新推出的MIOpen开源GPU加速库,支持像卷积、池化、激活功能、归一化和张量格式。

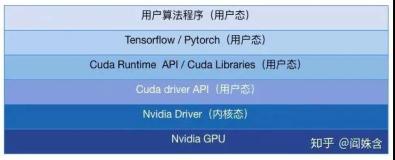

新的加速库是基于AMD现有的Randeon Open Compute软件,其中包括域专有的编辑器,针对线性代数和张量以及语言运行时间。该软件支持7种机器学习框架,包括Caffe、Torch 7以及Tensorflow,还有4种编程语言——Python、OIpenCL、高性能版C以及针对Nvidia的编译层。

AMD MIOpen堆栈的定位是作为Nvidia Cuda的一个更开放的替代选择(来源:AMD)

AMD称,新的GPU卡将打败来自Nvidia的、针对AI的竞争产品(来源:AMD)

超微宣布推出了支持AMD这三款新卡的机架式系统。Inventec也宣布两款系统支持一个机架节点最多有4个或者16个带有PCIe插槽、FPGA或者固态盘的M125 Vega卡。Inventec还展示了一款将会包含120个Vega卡、GPU计算性能最高达到3 Petaflops的机架系统。

在机器学习方面,AMD正在迎头赶上。4月,Nvidia开始出货针对高端GPU四路集群的设计,采用Nvidia独有的NV-Link技术,支持更高吞吐量、更低延迟的PCIe。并且Nvidia针对GPU计算的Cuda多年来已经被广泛采用。

上个月,英特尔详细阐述了采用至强和至强Phi处理器的计划,以及收购通过收购Nervana和Movidius以覆盖广泛的推断和培训类任务。此外像Cornami、Graphcore以及Wave Computing的初创公司已经公布了新芯片计划,据他们称,它在培训类任务方面的表现将击败GPU。

在过去两年中,机器学习已经成为Amazon、百度和Facebook等数据中心巨头的一种战略性工作负载。5月,Google宣布设计出了他们自己的AI推理加速器。

AMD计划公布一项基于采用更开放的组件的独特计划。除了新的开源加速库之外,AMD还将开放GPU指令集,针对那些希望做低等级优化的工程师们。

此外,AMD还计划支持像CCIX、GenZ连接到FPGA加速器以及存储存储这样的开放互连。与此同时,AMD也支持PCIe和单根虚拟化标准。

今年年底,AMD计划推出名为Naples的新服务器处理器,采用Zen x86核心。AMD表示,将把最低延迟的链路带入x86主机,能够在单一服务器节点中打包4-16个GPU。AMD目前已经支持GPU之间的直接内存访问(DMA),以及机架间的远程DMA。

AMD表示,与使用通用矩阵乘法(GEMM)的卷积相比,MIOpen代码将加速AI任务近3倍之多。此外AMD还分别展示了在Nvidia TitanX-Maxwell以及Pascal的DeepBench DEMM之上MI8和MI25卡显著提升的性能。

AMD正在快速向前发展。它展示了两周时间内Vega采用Cuda和Caffe处理MIOpen软件中的培训任务。Vega芯片仍然供不应求,因为开发者正在致力于将传统图形软件和游戏放到Vega芯片上。

AMD Radeon部门首席架构师Raja Koduri表示,AMD的MxGPU虚拟化将提供给机器学习和游戏。

“我们的竞争对手是把游戏和人工智能分成两个部分,而我们希望把两者结合到一起,”他说。

此前,AMD公布了与数据中心巨头阿里巴巴以及Google在GPU方面的合作。

多伦多大学的研究人员称赞了MIOpen软件,他使用该软件做4位数据和汇编语言支持天文学应用程序。“我们发现人们还在谈论1位和2位数学,这说明我们在机器学习方面还处于很早起的阶段,”Xilinx副总裁Liam Madden这样表示。

原文发布时间为:2016年12月13日

本文作者:孙博

本文来自云栖社区合作伙伴至顶网,了解相关信息可以关注至顶网。