本节书摘来自华章计算机《Python爬虫开发与项目实战》一书中的第1章,第1.3节,作者:范传辉著,更多章节内容可以访问云栖社区“华章计算机”公众号查看

1.3 IO编程

IO在计算机中指的是Input/Output,也就是输入输出。凡是用到数据交换的地方,都会涉及IO编程,例如磁盘、网络的数据传输。在IO编程中,Stream(流)是一种重要的概念,分为输入流(Input Stream)和输出流(Output Stream)。我们可以把流理解为一个水管,数据相当于水管中的水,但是只能单向流动,所以数据传输过程中需要架设两个水管,一个负责输入,一个负责输出,这样读写就可以实现同步。本节主要讲解磁盘IO操作,网络IO操作放到之后的1.5节进行讨论。

1.3.1 文件读写

1.?打开文件

读写文件是最常见的IO操作。Python内置了读写文件的函数,方便了文件的IO操作。

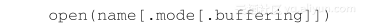

文件读写之前需要打开文件,确定文件的读写模式。open函数用来打开文件,语法如下:

open函数使用一个文件名作为唯一的强制参数,然后返回一个文件对象。模式(mode)和缓冲区(buffering)参数都是可选的,默认模式是读模式,默认缓冲区是无。

假设有个名为qiye.txt的文本文件,其存储路径是c:text(或者是在Linux下的~/text),那么可以像下面这样打开文件。在交互式环境的提示符“>>>”下,输入如下内容:

>>> f = open(r'c:\text\qiye.txt')

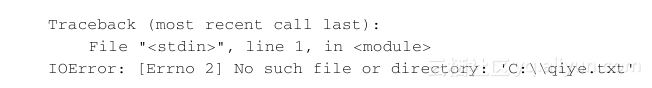

如果文件不存在,将会看到一个类似下面的异常回溯:

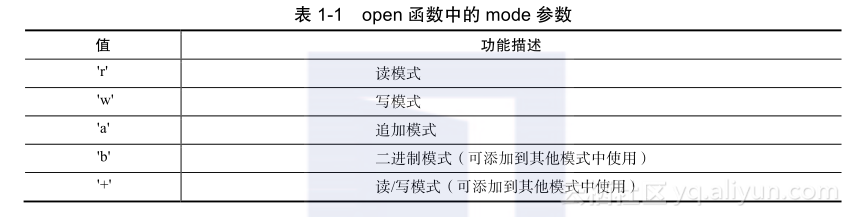

2.?文件模式

下面主要说一下open函数中的mode参数(如表1-1所示),通过改变mode参数可以实现对文件的不同操作。

这里主要是提醒一下'b'参数的使用,一般处理文本文件时,是用不到'b'参数的,但处理一些其他类型的文件(二进制文件),比如mp3音乐或者图像,那么应该在模式参数中增加'b',这在爬虫中处理媒体文件很常用。参数'rb'可以用来读取一个二进制文件。

3.?文件缓冲区

open函数中第三个可选参数buffering控制着文件的缓冲。如果参数是0,I/O操作就是无缓冲的,直接将数据写到硬盘上;如果参数是1,I/O操作就是有缓冲的,数据先写到内存里,只有使用flush函数或者close函数才会将数据更新到硬盘;如果参数为大于1的数字则代表缓冲区的大小(单位是字节),-1(或者是任何负数)代表使用默认缓冲区的大小。

4.?文件读取

文件读取主要是分为按字节读取和按行进行读取,经常用到的方法有read()、readlines()、close()。

在“>>>”输入f = open(r'c:textqiye.txt')后,如果成功打开文本文件,接下来调用read()方法则可以一次性将文件内容全部读到内存中,最后返回的是str类型的对象:

>>> f.read()

"qiye"

最后一步调用close(),可以关闭对文件的引用。文件使用完毕后必须关闭,因为文件对象会占用操作系统资源,影响系统的IO操作。

>>> f.close()

由于文件操作可能会出现IO异常,一旦出现IO异常,后面的close()方法就不会调用。所以为了保证程序的健壮性,我们需要使用try ... finally来实现。

try:

f = open(r'c:\text\qiye.txt','r')

print f.read()

finally:

if f:

f.close()

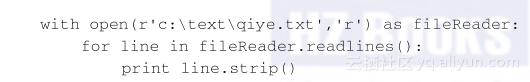

上面的代码略长,Python提供了一种简单的写法,使用with语句来替代try ... finally代码块和close()方法,如下所示:

with open(r'c:\text\qiye.txt','r') as fileReader:

print fileReader.read()

调用read()一次将文件内容读到内存,但是如果文件过大,将会出现内存不足的问题。一般对于大文件,可以反复调用read(size)方法,一次最多读取size个字节。如果文件是文本文件,Python提供了更加合理的做法,调用readline()可以每次读取一行内容,调用readlines()一次读取所有内容并按行返回列表。大家可以根据自己的具体需求采取不同的读取方式,例如小文件可以直接采取read()方法读到内存,大文件更加安全的方式是连续调用read(size),而对于配置文件等文本文件,使用readline()方法更加合理。

将上面的代码进行修改,采用readline()的方式实现如下所示:

5.?文件写入

写文件和读文件是一样的,唯一的区别是在调用open方法时,传入标识符'w'或者'wb'表示写入文本文件或者写入二进制文件,示例如下:

f = open(r'c:\text\qiye.txt','w')

f.write('qiye')

f.close()

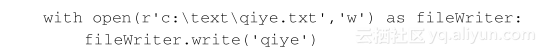

我们可以反复调用write()方法写入文件,最后必须使用close()方法来关闭文件。使用write()方法的时候,操作系统不是立即将数据写入文件中的,而是先写入内存中缓存起来,等到空闲时候再写入文件中,最后使用close()方法就将数据完整地写入文件中了。当然也可以使用f.flush()方法,不断将数据立即写入文件中,最后使用close()方法来关闭文件。和读文件同样道理,文件操作中可能会出现IO异常,所以还是推荐使用with语句:

1.3.2 操作文件和目录

在Python中对文件和目录的操作经常用到os模块和shutil模块。接下来主要介绍一些操作文件和目录的常用方法:

- 获得当前Python脚本工作的目录路径:os.getcwd()。

- 返回指定目录下的所有文件和目录名:os.listdir()。例如返回C盘下的文件:os.listdir("C:\")

- 删除一个文件:os.remove(filepath)。

- 删除多个空目录:os.removedirs(r"d:python")。

- 检验给出的路径是否是一个文件:os.path.isfile(filepath)。

- 检验给出的路径是否是一个目录:os.path.isdir(filepath)。

- 判断是否是绝对路径:os.path.isabs()。

- 检验路径是否真的存在:os.path.exists()。例如检测D盘下是否有Python文件夹:os.path.exists(r"d:python")

- 分离一个路径的目录名和文件名:os.path.split()。例如:

os.path.split(r"/home/qiye/qiye.txt"),返回结果是一个元组:('/home/qiye', 'qiye.txt')。 - 分离扩展名:os.path.splitext()。例如os.path.splitext(r"/home/qiye/qiye.txt"),返回结果是一个元组:('/home/qiye/qiye', '.txt')。

- 获取路径名:os.path.dirname(filetpah)。

- 获取文件名:os.path.basename(filepath)。

- 读取和设置环境变量:os.getenv()与os.putenv()。

- 给出当前平台使用的行终止符:os.linesep。Windows使用'rn',Linux使用'n'而Mac使用'r'。

- 指示你正在使用的平台:os.name。对于Windows,它是'nt',而对于Linux/Unix用户,它是'posix'。

- 重命名文件或者目录:os.rename(old,new)。

- 创建多级目录:os.makedirs(r"c:pythontest")。

- 创建单个目录:os.mkdir("test")。

- 获取文件属性:os.stat(file)。

- 修改文件权限与时间戳:os.chmod(file)。

- 获取文件大小:os.path.getsize(filename)。

- 复制文件夹:shutil.copytree("olddir","newdir")。olddir和newdir都只能是目录,且newdir必须不存在。

- 复制文件:shutil.copyfile("oldfile","newfile"),oldfile和newfile都只能是文件;shutil. copy("oldfile","newfile"),oldfile只能是文件,newfile可以是文件,也可以是目标目录。

- 移动文件(目录):shutil.move("oldpos","newpos")。

- 删除目录:os.rmdir("dir"),只能删除空目录;shutil.rmtree("dir"),空目录、有内容的目录都可以删。

1.3.3 序列化操作

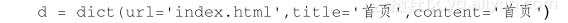

对象的序列化在很多高级编程语言中都有相应的实现,Python也不例外。程序运行时,所有的变量都是在内存中的,例如在程序中声明一个dict对象,里面存储着爬取的页面的链接、页面的标题、页面的摘要等信息:

在程序运行的过程中爬取的页面的链接会不断变化,比如把url改成了second.html,但是程序一结束或意外中断,程序中的内存变量都会被操作系统进行回收。如果没有把修改过的url存储起来,下次运行程序的时候,url被初始化为index.html,又是从首页开始,这是我们不愿意看到的。所以把内存中的变量变成可存储或可传输的过程,就是序列化。

将内存中的变量序列化之后,可以把序列化后的内容写入磁盘,或者通过网络传输到别的机器上,实现程序状态的保存和共享。反过来,把变量内容从序列化的对象重新读取到内存,称为反序列化。

在Python中提供了两个模块:cPickle和pickle来实现序列化,前者是由C语言编写的,效率比后者高很多,但是两个模块的功能是一样的。一般编写程序的时候,采取的方案是先导入cPickle模块,如果此模块不存在,再导入pickle模块。示例如下:

try:

import cPickle as pickle

except ImportError:

import pickle

pickle实现序列化主要使用的是dumps方法或dump方法。dumps方法可以将任意对象序列化成一个str,然后可以将这个str写入文件进行保存。在Python Shell中示例如下:

>>> import cPickle as pickle

>>> d = dict(url='index.html',title='首页',content='首页')

>>> pickle.dumps(d)

"(dp1\nS'content'\np2\nS'\\xca\\xd7\\xd2\\xb3'\np3\nsS'url'\np4\nS'index.html'\n

p5\nsS'title'\np6\ng3\ns."

如果使用dump方法,可以将序列化后的对象直接写入文件中:

>>> f=open(r'D:\dump.txt','wb')

>>> pickle.dump(d,f)

>>> f.close()

pickle实现反序列化使用的是loads方法或load方法。把序列化后的文件从磁盘上读取为一个str,然后使用loads方法将这个str反序列化为对象,或者直接使用load方法将文件直接反序列化为对象,如下所示:

>>> f=open(r'D:\dump.txt','rb')

>>> d=pickle.load(f)

>>> f.close()

>>> d

{'content': '\xca\xd7\xd2\xb3', 'url': 'index.html', 'title': '\xca\xd7\xd2\xb3'}

通过反序列化,存储为文件的dict对象,又重新恢复出来,但是这个变量和原变量没有什么关系,只是内容一样。以上就是序列化操作的整个过程。

假如我们想在不同的编程语言之间传递对象,把对象序列化为标准格式是关键,例如XML,但是现在更加流行的是序列化为JSON格式,既可以被所有的编程语言读取解析,也可以方便地存储到磁盘或者通过网络传输。对于JSON的操作,将在第5章进行讲解。