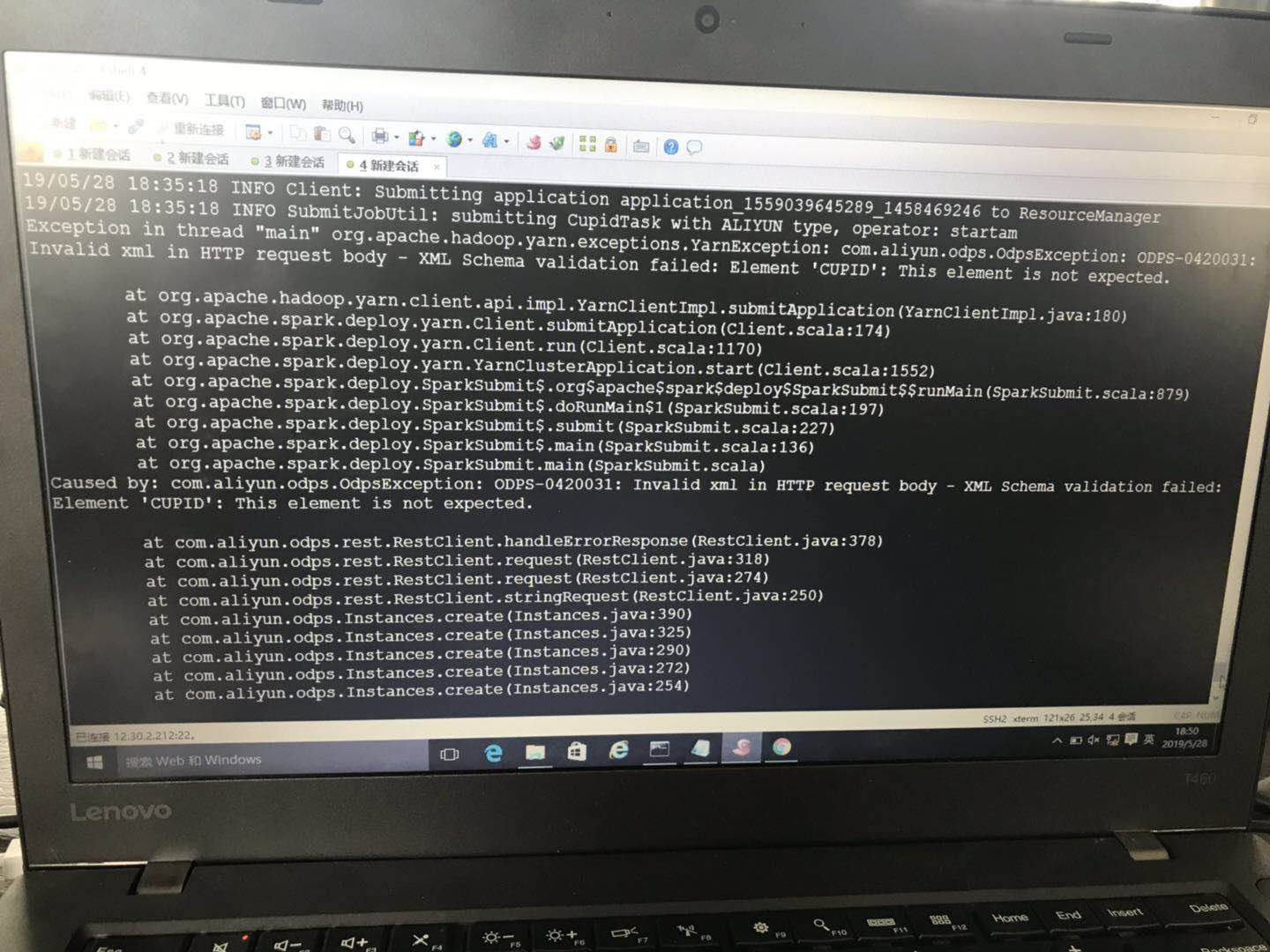

在maxcompute下提交原生pyspark任务 报错odps-0420031 具体情况如下

刚刚开始接触阿里云大数据开发平台,通过官方文档看到,是完全支持原生spark的任务的提交,于是按照文档的环境配置,搭建了spark-2.3.0版本的客户端环境,但是在提交任务的过程中,已local[N]的模式提交,运行spark下的example的demo没有问题,运行自己的测试代码也没有任何问题,但是一旦以yarn-cluster模式提交,就会出现一个错误,目前没有解决的相关头绪,报错截图如下,往各位前辈,能指点一下,任务是以pyspark的方式提交,任务脚本为python开发

提交命令如下: spark-submit --master yarn-cluster --jars odps-spark-datasource_2.11.3.3.3_public.jar example/pi.py

报错内容大致为 发送请求时,对某个xml文件解析出现问题,但是我没有找到任何关于xml文件的信息

展开

收起

问答标签:

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

相关问答