7月25日,阿里云宣布正式推出消息队列Kafka,全面融合开源生态。在兼容Apache生态的基础上,阿里云消息队列Kafka彻底解决了开源产品稳定性不足的痛点,可用性达99.9%,数据可靠性99.999999%,并且支持消息无缝迁移到云上。

据介绍,阿里云消息队列Kafka在海量消息堆积的情况下,始终保持Kafka集群的消息收、发的高吞吐能力;同时,消息会持久化落盘到消息队列,在磁盘容量足够的情况下,未到期数据保障存储,数据可靠性达到99.999999%,服务可用性达99.9%。

此外,阿里云消息队列Kafka还支持数万级topic高并发读写,始终保持Kafka集群的高吞吐能力,适用于构建日志分析平台、网站活动追踪、流计算处理、数据中转枢纽等多类场景。

阿里云消息队列Kafka高级产品经理娜米表示,“用户使用消息队列Kafka,无需担心和开源生态的兼容性问题,进一步提升了 Kafka 对大数据生态的价值,提高了开发者在大数据生态下的开发效率。”

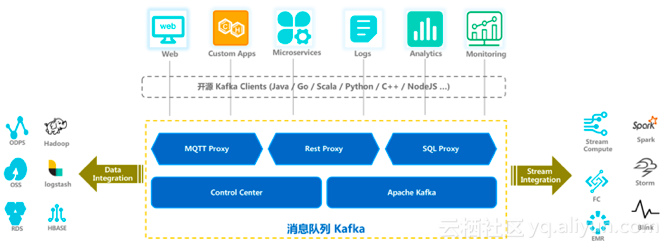

据了解,阿里云消息队列Kafka全面兼容Apache生态,用户可将 Kafka 中的消息导入到 ODPS、HBase、HBASE 等离线数据仓库;此外,从自建 Kafka到上云,阿里云支持开源产品的无缝迁移,提供无门槛接入方式,如:

- 阿里云消息队列Kafka 100%兼容开源社区Apache Kafka(0.10.0.0及以上版本),直接使用Kafka开源客户端便可与阿里云上消息队列Kafka进行通讯;

- 对于原本使用开源Apache Kafka的用户无需任何改造,即可迁移上云,享受到阿里云提供的消息队列Kafka服务;

- 同时消息队列Kafka支持开源社区、阿里云平台产品的打通,与Kafka全生态能快速对接。

近几年随着大数据产业的发展,Kafka也吸引了众多的用户和开发者。据统计,目前已有三分之一的财富500强企业正在使用Kafka,包括阿里、Linkedin、美团、Twitter、Spotify、高盛、Netflix、新浪、携程、Uber等,用于构建系统和应用之间的实时流数据通道,并提供基于实时流数据的应用程序服务,是大数据生态不可或缺产品之一。阿里云消息队列Kafka的推出将为更多长期使用Apache Kafka的开发者带来便利。