人脑是自然界最复杂精密的系统,而脑和计算机在某些机制和原理上具有高度的相似性。眼下,人工智能芯片热潮正盛,但AI芯片场景仍以小规模为主,用于手机端、自动驾驶和消费电子产品。百尺竿头更上一层楼,聚焦神经芯片和“众神(经)计算”,2018年3月11日,北京脑科学和类脑计算论坛在中科院计算所召开,探讨用于脑科学和脑疾病的新一代研究工具。

在实体生物以及高性能计算机的纯模拟之间,我们能否找到一种既有生物,也有计算系统成分的高效模拟系统?

大会主席:中科院计算所计算机体系结构国家重点实验室孙毓忠研究员

中国科学院院士李国杰、郭爱克,中科院计算所副所长陈熙霖,中国神经科学会常务理事、中国脑科学计划申报书写作组和实施方案编制组统稿人范明等出席会并发表演讲。

计算机似乎是唯一能实现人工智能的手段,但不理智的决策如何计算?

李国杰院士

李国杰院士指出,现在做的脑科学研究和类脑计算,都属于计算神经科学,而计算神经科学与人工智能,两者应当相向而行,渐进融合。李院士提出,短期内把脑的科学和奥妙解开不太可能。正如此前北京大学的黄铁军教授所说,想要弄清人脑、根据脑的肌理来做计算机,可能性极低,不如先把计算机做出来,而后再了解脑,就像先制造出飞机,然后再了解空气动力学。但是,类脑计算比造飞机难,凭空想象也不容易,所以,应该两边同时展开研究,最后在中间融合,两个领域都能对彼此形成启发。

中科院计算所副所长陈熙霖

中科院计算所副所长陈熙霖指出,到目前为止,计算机似乎是唯一能实现人工智能的手段,从这个意义上讲,计算是非常重要的。但经济学家研究发现,我们做决策时并不是完全理智的,而如果不是完全理智的,那么是不是就不能完全依靠计算来模拟人脑?

陈所长这样描述他从计算的角度看未来我们从脑科学里能得到的启示:“用计算模拟的办法推动脑科学进展,好比在爬一座山,我们希望有一条路能上去,如果什么都没有,就是在盲人摸象地往上爬。如果我们从脑科学那里得到一些启示,就好比我看到山上有人告诉我,他爬到顶上去过,换句话说,把黑盒变成一个灰盒,再逐步的变成一个白盒。”

陈所长还抛出了一个问题:如果一条线的一端是脑,另一端是数学,那么深度学习位于哪里?是离脑更近,还是离数学更近?

回答这个问题,或许还是要从认识人脑讲起。

认知人脑:敢为天下先,设计硅基大脑,整合多种天才特征

郭爱克院士

人类大脑在整体上是怎样工作的?郭爱克院士介绍,大数据出现之前,我们主要是依靠抽样数据记录,数据是片面的,依靠经验、结论、假设和价值观来认知人类的大脑,这一过程闪耀着一颗颗璀璨的科学明星:

薛定谔,关注生命的本质,提出了“非周期晶体”、“负熵”、“密码传递”、“量子跃迁”等概念,用来解释和理解生命现象;皮亚杰,回到智力的本质,把“适应”(adaptation)看做智力的本质,人的智力发展过程被视为适应水平不断提高的过程;拉蒙·卡哈尔,发现神经元结构,“神经系统是由独立的神经细胞组成”;谢灵顿,提出了突触的概念,认为神经元的末梢分支与另一个神经元胞体获树突仅仅是接触,在原生质上并不连续——突触是脑的基本操作单元,它对于脑的重要性,如同原子对于物质,DNA对于生命那样重要。

再到巴甫洛夫、赫布(突触修饰和神经细胞群)、克里克(在还原论上认识生命本质),以及中国的两座高山:冯德培,上海生理所前所长,观察到强直后增强效应(PTP),这是亚细胞水平神经可塑性的一个先驱性电生理发现,以及张香桐,创建了中科院上海脑研究所,是历史上第一个阐述了树突上突触连接重要性的人。

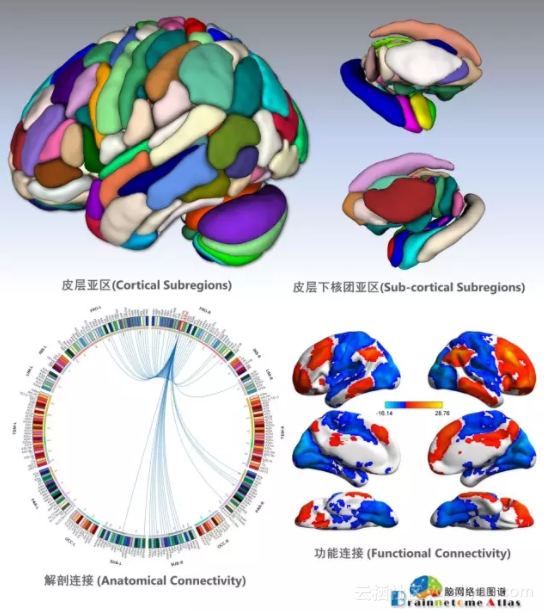

但是,这些毕竟是观察和抽样,只有绘制出人类大脑的联结图,我们才能真正了解大脑如何工作。在这方面,中科院自动化所完成了一项十分重大的工作:2016年,中科院自动化所蒋田仔团队与国际合作,6年时间成功绘制出全新的人类脑图谱:脑网络组图谱。

该图谱包括246个精细脑区亚区,以及脑区亚区间的多模态连接模式,突破了100多年来传统脑图谱绘制思想,引入了脑结构和功能连接信息对脑区进行精细划分和脑图谱绘制的全新思想和方法,比传统的Brodmann图谱精细4-5倍,具有客观精准的边界定位,第一次建立了宏观尺度上的活体全脑连接图谱。

接下来,郭院士介绍了进化基本的计算原则具有的普遍性。例如,递归网络与气味的稀疏编码:大脑就是一个编码器,通过神经元和神经网络的特殊语言,将输入进来的物理信息翻译为一种视觉,嗅觉,听觉,触觉上的直观感觉,神经编码在原则上可以有多种形式,在信息流(比如视神经)的瓶颈形成区域,或者和记忆相关的重要区域,稀疏编码是非常可取的。

再例如最近邻搜索任务:哈希算法和果蝇嗅觉编码,后者更加优越。研究人员将果蝇的嗅觉回路看作是一个哈希函数,输入是一种气味,输出是一个对应标签(哈希)。果蝇将相似的气味与类似的标签联系起来,这样从某一种气味中学到的条件反射,可以应用到以后遇到的相似的气味上。研究人员推测,果蝇的嗅觉回路产生的标签是局部敏感的——局部敏感哈希是解决计算机科学中众多相似搜索问题的基础,而且果蝇的算法效率更高。这也表明局部敏感哈希可能是大脑中使用的一个一般计算原则。

郭院士指出,他认为脑可能是以模块的方式来工作的。这些模块可能在果蝇的蘑菇体发现,也可能在斑马鱼的视顶盖,还可能在鼠的下丘脑,或者灵长类的伏隔核。我们或许可以参照化学的元素周期表,总结出大脑的功能模块,构建大脑功能模块的“元素周期表”,成为脑的密码表。

在此基础上,敢为天下先:设计硅基大脑,整合多种天才特征。脑里有很多的天才特征,有数学的,有音乐的,有绘画的,有记忆的。这些特征很多不是出生以后学习过来的,而是在神经网络中可以编码的。有没有可能计算机科学家和脑科学家携手,设计整合各种天才特征?或者从这些特征中设计一个更强大的系统,可以完成多种功能,类似一个“硅基大脑”。

脑科学和类脑智能是一个具有无限可能的领域,人类完全可以期待从脑科学那里获得最为令人吃惊的启迪,拉开人类历史上的智能革命,从脑-智力-环境-社会的复杂统一体中逼近脑和人类本质。

深度学习的问题:从神经环路看类脑计算

清华计算神经科学教授、博士生导师宋森博士

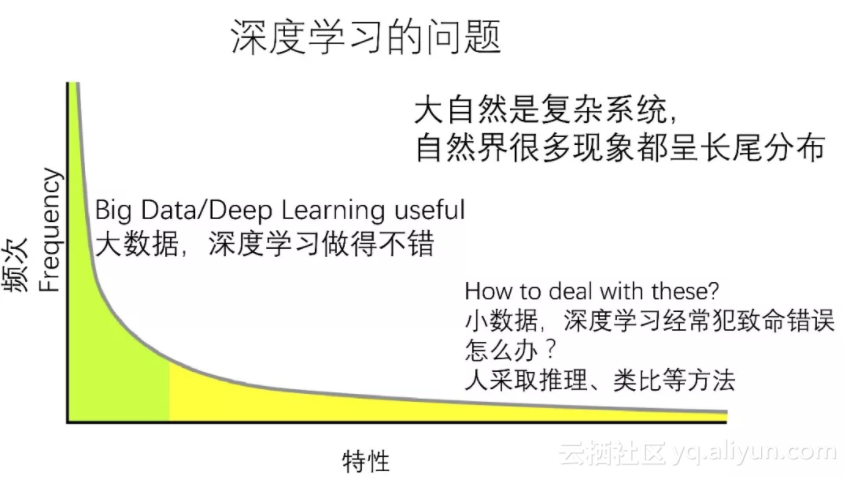

清华大学脑与智能实验室及类脑计算中心的宋森博士,分享了他关于深度学习局限性的思考。常见的深度学习一般是基于大数据的,其实就是一个函数。这种大数据深度学习现在来说做得不错,但可能从2017年开始,瓶颈已经比较明显了。那么,深度学习的问题在哪里?

宋森博士认为,这是由大自然的特性决定的。大自然是个复杂系统,复杂系统呈现出来一个比较常见的现象,就是呈长尾分布。深度学习可能搞定了很多事情,但遇到个例和不那么常见的情况,就容易出问题。

人会采取推理、类比等方法,对那些不常见的事情给出一些比较粗略的判断。计算机要做到像大脑那样学习,就需要考虑如何将这两种推理模式——基于大数据的精确推理和基于小数据的模糊推理给有机结合起来。

和现有的人工神经网络不同,混合计算是大脑的一种基本形式,这可能和大脑的多任务型和鲁棒性有关。宋森博士从编码、局部环路结构、学习和全局环路结构四方面做了探讨。从编码的层次看,大脑的一个基本特征就是用高度并行的原理,用空间来换时间。举个例子,你要表示“8”这个数字,在计算机里面必须有一个二进制编码,因此也涉及到解码。而生物的外周神经元,可能就是让一个神经元发放8个脉冲,采取经典频率编码。

而大脑里面一种关键的编码是稀疏编码。这样表述的一个好处就是,很容易和概率标准自然地连接起来。稀疏编码是大脑的一个比较重要的系统。但如果仔细看,就会发现稀疏编码并不能解释一切,有很多神经元会参与多个集成,稀疏性在每一个大脑皮层也是不同的。

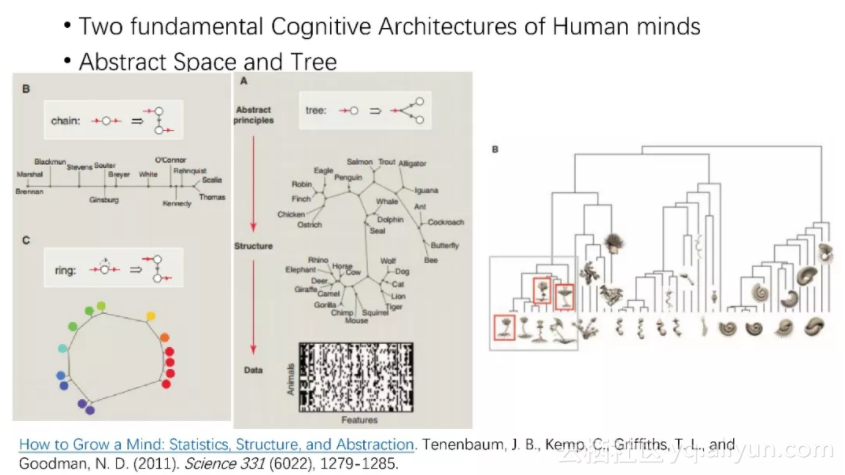

宋森博士推测,不同的大脑皮层功能不同,第2、3层可能是稀疏编码,统一分布在抽象空间中,主要用于识别;而第5、6层则可能是树状结构,主要用于关联。他认为大脑采取稀疏和压缩双重编码,同时也采取空间和时间复合编码。

从局部神经环路的层面,研究已经发现,大脑中互相连接比较强的神经元,它们的功能特性也差不多;而从深度学习角度理解,初级神经皮层上面有些现象也可以与CNN对应起来。

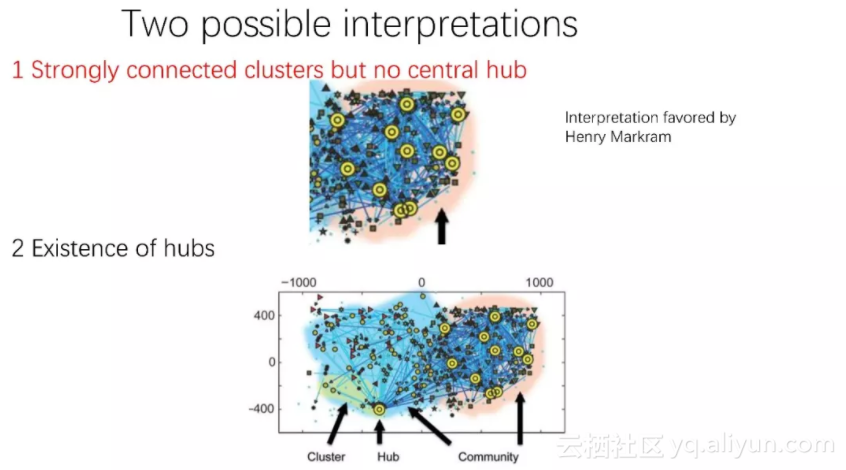

宋博士指出,脑环路和深度学习有一些可能存在相似性,但有些有不同的地方。在局部环路结构上,大脑的连接是层级化的,存在局部群(community)、中心神经元(hub)和富人俱乐部(rich club)现象。

在提到学习时,宋森博士认为,大脑中有两类不同的学习任务,一类是模式分离,也即渐变学习,有点像大数据问题,比如试错类型的学习。另一类则是模式联想(快速关系学习),典型的例子是恐惧调节,也就是将小鼠放在盒子中进行电击,下次再将它放在类似的盒子中,就知道自己可能会遭遇不好的事情。而在学习这两类不同的任务时,大脑是把不同的东西分开来的。

在全局神经环路层面,大脑采取多时钟同步通讯的办法来实现灵活高效的控制和调配,通过调配实现动态链接网络结构。

从大脑到计算的路有多长?

中科院自动化所余山研究员

中科院自动化所的余山博士论述了神经科学和人工智能如何能够相互促进。

或许你也认为,真正人工智能专家需要了解的问题,可能神经科学专家回答不了,而且神经科学的发现可能太过细致,一眼看不到直接的实际用处。

如何解决这个问题?余山博士认为,我们可以从大脑的工作原理中总结一些基本的规律,这很可能是大脑和计算的通用原则。我们在神经科学中观察到一些重要的现象规律,把它用起来,看它对机器学习算法有没有帮助,好比一个前馈的过程,再配合一个反馈的过程(反向传播),看能否很明确地用数学的语言表达其功能,如果可行,就建立起一个环路,我们就可能有效发现类脑计算的一些途径。

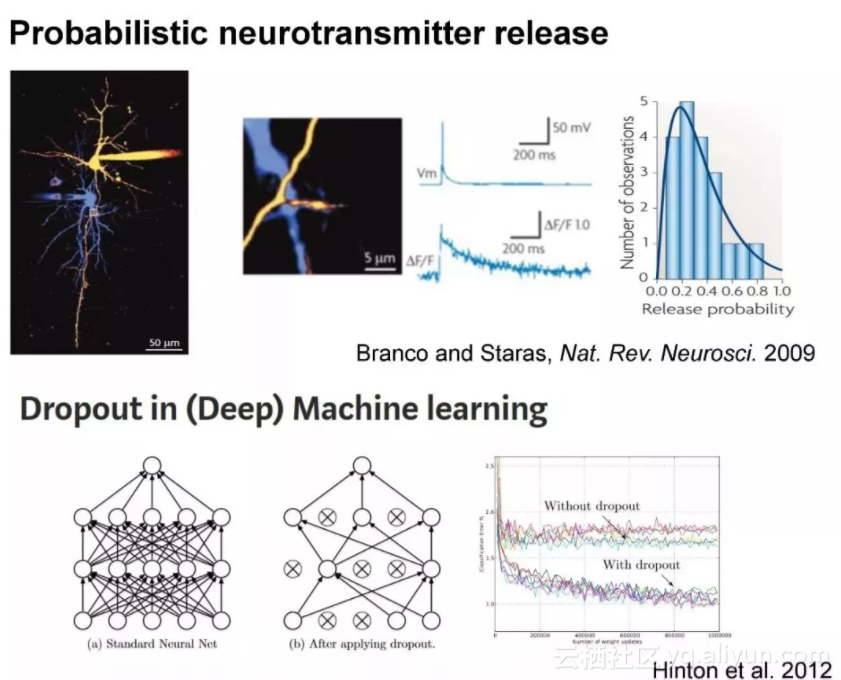

余山博士举了几个例子。首先是突触传播和Dropout。在神经生物学中发现,突触响应不是确定性的,存在很大的失误率,有信号传递过来,突触不一定能传递,甚至不一定能转化为化学信号,突触在20%~30%的情况下才传递成功,一般将其理解为生物噪音,但这样实在太没效率了。另一方面,在有些地方突触却可以实现100%成功传递,说明这不是不可能做到。

神经科学家很早就观察到了这一现象,但对其功能意义并不完全理解。2012年,Hinton提出Dropout算法,以及后续提出的Drop connect算法,随机让网络中的一些节点(突触)不工作,使得网络有效避免了过拟合,从而实现了更好的泛化性能。实际上这正好对应了突触传递的随机性。这就是机器学习专家从数学的角度理解,让生物学家得到启发的一个例证。

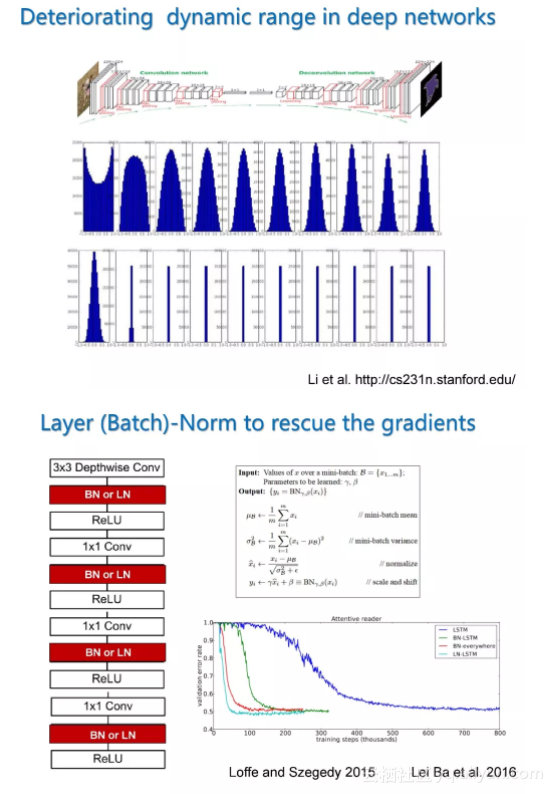

第二个例子是临界态和类脑之间的关系。神经科学家发现,当生物处于临界态时有利于信息的传递,处于超临界(大多数神经元都处于饱和)、亚临界(激活不够)时都不利于信息处理。用脑片做实验也发现,临界状态使得网络的动态范围实现最优化。

这个现象,机器学习专家从ML的角度来理解,能得到哪些启示呢?在一个深度网络中,浅层神经元的动态范围容易保持在较大的水平,但随着层数越来越深,很快网络的动态范围就变得非常小,要么大多数神经元都不活跃,那么大多数神经元都趋于饱和。这个带来的一个重要问题,就是BP算法中梯度的回传就受到影响,也即“梯度消散”。

在生物中,大脑通过临界态来解决这个问题。而在机器学习领域,人们采取的做法是在每两个层之间另加一层(Batch Norm层或是Layer Norm 层),从而让后面层级保持一个较好的动态范围,相当于让每层都保持在临界态,这些方法在深度学习中都有广泛的应用。

余山博士总结说,由此可见,大脑和机器学习很多时候面临的问题是很相似的,即便我们现在对大脑的了解还不完整,但是我们仍然可以去尝试,去发现大脑通用的功能优势,然后去理解这样做在信息处理上的意义是什么,如果我们能够理解这些问题,借鉴大脑的一些解决方法,就能帮助我们设计更好的机器学习算法。

Q&A:人类的大脑里存在量子效应吗?

在这次脑科学和类脑计算论坛上,北京大学信息科学技术学院教授吴思,中科院神经科学研究所高级研究员、神经科学国家重点实验室副主任王佐任,中科院宁波材料所诸葛飞博士,四川大学类脑计算研究中心主任唐锦华博士,以及中科院沈阳自动化所研究员斯白露博士也分别发表了报告,从神经计算、忆阻型神经形态芯片、空间记忆神经动力学等多个角度,对计算神经科学与人工智能的融合、借鉴与发展进行深入探讨。

左起:斯白露、诸葛飞、王佐仁、唐锦华、中国传媒大学脑科学与智能媒体研究院院长曹立宏、吴思、余山和陈熙霖

记者:从大脑图谱的研究里,有没有发现人的大脑存在量子效应,还是说人的大脑就遵循经典的物理和化学?

余山:我试着回答一下,从目前的大脑图谱研究看,我没有看到人脑跟量子有关系。这个话题有很多人在说,我认为目前神经科学没有很强的证据表明,量子力学在大脑的神经信息处理当中发挥了任何重要的作用。这样说有几方面的证据,一个是在大脑这样一个37摄氏度的环境当中,很难保持要保持量子纠缠态,现在所有的量子计算都取决于量子纠缠,以及能够保持足够长时间,这样看大脑是不满足相关条件的。

王佐仁:对,我完全同意余山老师的观点,量子纠缠当然是物质的基础,但它跟神经计算可能没有直接联系。这样的纠缠可能听起来很fancy,当初是一个叫彭罗斯的物理学家提出来的,神经科学家对这个理论是普遍是否认的。

原文发布时间为:2018-03-15

本文作者:闻菲

本文来自云栖社区合作伙伴新智元,了解相关信息可以关注“AI_era”微信公众号