##搭建集群的时候要学会看日志,日志很重要的,日志真的很重要

一、准备工作

1.1、服务器配置

| 主机名 |

IP地址 |

||

| Pxc01 |

192.168.1.17 |

||

| Pxc02 |

192.168.1.18 |

||

| Pxc03 |

192.168.1.19 |

源码软件包下载:http://down.51cto.com/data/2330430

1.2、环境配置

注:不能用oracle的mysql进行编译安装,因为mysql GPL 不识别 pxc的相关参数。

安装pxc环境需要用到以下安装包:

-

percona xtaDB cluster ----percona mysql 数据库

-

percona xtracebackup ----备份恢复工具

备注:

Percona-XtraDB-Cluster-5.6.28-rel76.1-25.14.1.Linux.x86_64.ssl100.tar.gz–已经编译的安装包,解压完成后只需要执行scripts中的mysql_install_db初始化数据库即可。

percona-xtradb-cluster-5.6_5.6.28-25.14.orig.tar.gz–原始安装包,需要使用cmake编译安装

1.3、名词解释

名词:

WS:write set 写数据集

IST: Incremental State Transfer 增量同步

SST:State Snapshot Transfer 全量同步

UUID:节点状态改变及顺序的唯一标识。

GTID:Global Transaction ID ,由UUID和偏移量组成。wsrep api 中定义的集群内全局事务id。

1.4、PXC原理

pxc是基于验证的数据强一致性数据复制的mysql集群,特性分析:

优点:

1.高可用性,节点不可用不影响集群正常运行。

2.强一致性,可以将读扩展到多个节点上。

3. 节点的增加数据同步自动化(IST,SST)。

4. 可实现多点读写,但写压力仍要同步到所有节点。

缺点:

1.由于ddl需全局验证通过,则集群性能由集群中最差性能节点决定。

2.为保证一致性,galera 总是优先保证数据一致性,在多点并发写时,锁冲突问题严重

3.新节点加入或延后较大的节点重新加入需全量拷贝数据(sst),作为donor的节点在同步过程中无法提供读写

4.数据冗余度为节点数

1.5、PXC工作原理

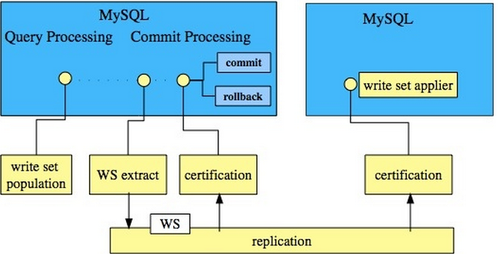

节点接收sql 请求后,对于ddl 操作,在commit之前,由wsrep API 调用galera 库进行集群内广播,所有其他节点验证成功后事务在集群所有节点进行提交,反之roll back。pxc 保证整个集群所有数据的强一致性,满足CAP理论中满足:Consistency 和 Availability。

-

WSREP API:

1):在DBMS和wsrep provider 之间提供接口。

2):GTID:Global Transaction ID. 由UUID 和 sequence number组成,用于标示集群中发生状态改变的唯一标示以及队列中的偏移量。

-

Galera wsrep provider:

1):完成事务在集群内的广播:本地事务发送给其他节点验证,接收其他节点事件本地验证并返回结果

2):应用从其他节点接收并全局验证通过的事件到本地。

3):集群内通信,节点存活的检测,pc的选举等

4):脑裂,为避免节点失效导致pc选举失败整个集群不可用,建议节点数至少为3

5):多点写入时的锁冲突检测机制

6):等待队列中事务的并发提交

galera的group communication 层实现统一全局数据同步策略和集群内所有事务的排序,便于生成GTID。

对于每一个节点有2方面工作:

(1)、完成数据同步。

(2)、完成与其他节点的通信。

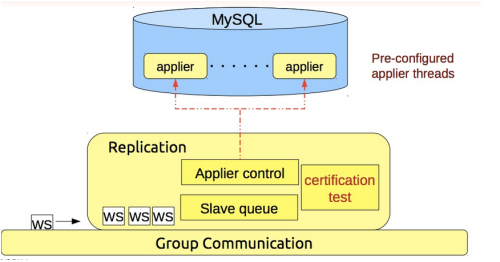

galera 的replication 层完成数据同步,由slavequeue 和applier组成,在事务的同步过程中,事务在队列中以及应用线程中时于节点本地产生锁冲突处理方式。replication 模块的效率直接影响整个集群的写入性能。

同步过程中,本地事务和等待队列中的锁冲突:

innodb内部使用悲观锁,保证事务的成功进行和提交。pxc中使用乐观锁,以避免在每个节点获取锁以及网路开销,在写入节点上,事务在提交之前与单点的innodb一样,到达提交点时,向集群其他节点广播(galera库完成 并发)事物并等待各节点验证结果,如果所有节点都返回成功,则提交,反之,回滚。

pxc 中先提交的事物成功,其他事务(本地或其他节点同步)将回滚或报死锁错误。

相关状态值:

wsrep_local_cert_failures 同步过程中节点认证失败计数,冲突来自本地提交的事务和同步队列中事务存在锁冲突,则本地验证失败(保证全局数据一致性)

wsrep_local_bf_aborts 强制放弃,本地事务和同步队列中正在执行的事务存在锁冲突时,将强制保证先提交的事务成功,后者回滚活报错

验证模块:

验证过程中,节点在接收到其他节点writeset后,在本地做冲突验证并返回验证结果。

1.6、PXC状态说明

1.OPEN:节点启动成功,尝试连接到集群,如果失败则根据配置退出或创建新的集群

2.PRIMARY:节点处于集群PC中,尝试从集群中选取donor进行数据同步

3.JOINER:节点处于等待接收/接收数据文件状态,数据传输完成后在本地加载数据

4.JOINED:节点完成数据同步工作,尝试保持和集群进度一致

5.SYNCED:节点正常提供服务:数据的读写,集群数据的同步,新加入节点的sst请求

6.DONOR:节点处于为新节点准备或传输集群全量数据状态,对客户端不可用。

状态机变化因素:

1.新节点加入集群

2.节点故障恢复

3.节点同步实效

监控状态说明:

(1)集群完整性检查:

wsrep_cluster_state_uuid:在集群所有节点的值应该是相同的,有不同值的节点,说明其没有连接入集群.

wsrep_cluster_conf_id:正常情况下所有节点上该值是一样的.如果值不同,说明该节点被临时”分区”了.当节点之间网络连接恢复的时候应该会恢复一样的值.

wsrep_cluster_size:如果这个值跟预期的节点数一致,则所有的集群节点已经连接.

wsrep_cluster_status:集群组成的状态.如果不为”Primary”,说明出现”分区”或是”split-brain”状况.

(2)节点状态检查:

wsrep_ready: 该值为ON,则说明可以接受SQL负载.如果为Off,则需要检查wsrep_connected.

wsrep_connected:如果该值为Off,且wsrep_ready的值也为Off,则说明该节点没有连接到集群.(可能是wsrep_cluster_address或wsrep_cluster_name等配置错造成的.具体错误需要查看错误日志)

wsrep_local_state_comment:如果wsrep_connected为On,但wsrep_ready为OFF,则可以从该项查看原因.

状态变化阶段:

1.OPEN: 节点启动成功,尝试连接到集群,如果失败则根据配置退出或创建新的集群

2.PRIMARY: 节点处于集群PC中,尝试从集群中选取donor进行数据同步

3.JOINER: 节点处于等待接收/接收数据文件状态,数据传输完成后在本地加载数据

4.JOINED: 节点完成数据同步工作,尝试保持和集群进度一致

5.SYNCED:节点正常提供服务:数据的读写,集群数据的同步,新加入节点的sst请求

6.DONOR(贡献数据者):节点处于为新节点准备或传输集群全量数据状态,对客户端不可用。

当其中一个节点停机重启后,通过IST来同步增量数据,来完成保证与另外两个节点的数据一致,IST的实现是由wsrep_provider_options="gcache.size=1G"参数决定,一般设置为1G大小,参数大小是由什么决定的,根据停机时间,若停机一小时,需要确认1小时内产生多大的binlog来算出参数大小。假设我们三个节点都关闭了,会发生什么呢,全部传SST,因为gcache数据没了。

全部关闭需要采用滚动关闭方式:

1、关闭node1,修复完后,启动加回来;

2、关闭node2,修复完后,启动加回来;

3、直到最后一个节点

4、原则要保持Group里最少一个成员活着

数据库关闭之后,最会保存一个last Txid,所以启动时,先要启动最后一个关闭的节点,启动顺序和关闭顺序刚好相反。

wsrep_recover=on参数在启动时加入,用于从log中分析gtid。

怎样避免关闭和启动时数据丢失?

| 1、所有的节点中最少有一个在线,进行滚动重启; |

| 2、利用主从的概念,把一个从节点转化成PXC里的节点。 |

(3)复制健康检查:

wsrep_flow_control_paused:表示复制停止了多长时间.即表明集群因为Slave延迟而慢的程度.值为0~1,越靠近0越好,值为1表示复制完全停止.可优化wsrep_slave_threads的值来改善.

如果主节点写入过大,怎么处理? Wsrep_slave_threads参数配置成cpu的个数相等或是1.5倍。

wsrep_cert_deps_distance:有多少事务可以并行应用处理.wsrep_slave_threads设置的值不应该高出该值太多.

wsrep_flow_control_sent:表示该节点已经停止复制了多少次.

wsrep_local_recv_queue_avg:表示slave事务队列的平均长度.slave瓶颈的预兆.

最慢的节点的wsrep_flow_control_sent和wsrep_local_recv_queue_avg这两个值最高.这两个值较低的话,相对更好.

(4)检测慢网络问题:

wsrep_local_send_queue_avg:网络瓶颈的预兆.如果这个值比较高的话,可能存在网络瓶

冲突或死锁的数目:

wsrep_last_committed:最后提交的事务数目

wsrep_local_cert_failures和wsrep_local_bf_aborts:回滚,检测到的冲突数目

三. pxc注意的问题

1、脑裂

任何命令执行出现unkown command ,表示出现脑裂,集群两节点间4567端口连不通,无法提供对外服务。

SET GLOBAL wsrep_provider_options="pc.ignore_sb=true";

2、并发写

三个节点的自增起始值为1、2、3,步长都为3,解决了insert问题,但update同时对一行操作就会有问题,出现:Error: 1213 SQLSTATE: 40001,所以更新和写入在一个节点上操作。

3、DDL

引起全局锁,采用:pt-online-schema-change

4、MyISAM引擎不能被复制,只支持innodb

5、pxc结构里面必须有主键

如果没有主建,有可能会造成集中每个节点的Data page里的数据不一样

6、不支持表级锁

不支持lock /unlock tables

| 7、pxc里只能把slow log ,query log 放到File里 |

| 8、不支持XA事务 |

| 9、性能由集群中性能最差的节点决定 |

1.7、PXC优缺点

优点:

(1).同步复制 Synchronous replication

(2).Active-active multi-master 拓扑逻辑

(3).可对集群中任一节点进行数据读写

(4).自动成员控制,故障节点自动从集群中移除

(5).自动节点加入

(6).真正并行的复制,基于行级

(7).直接客户端连接,原生的 MySQL 接口

(8).每个节点都包含完整的数据副本

(9).多台数据库中数据同步由 wsrep 接口实现

缺点:

(1).目前的复制仅仅支持InnoDB存储引擎,任何写入其他引擎的表,包括mysql.*表将不会复制,但是DDL语句会被复制的,因此创建用户将会被复制,但是insert into mysql.user…将不会被复制的

(2).DELETE操作不支持没有主键的表,没有主键的表在不同的节点顺序将不同,如果执行SELECT…LIMIT… 将出现不同的结果集

(3).在多主环境下LOCK/UNLOCK TABLES不支持,以及锁函数GET_LOCK(), RELEASE_LOCK()…

(4).查询日志不能保存在表中。如果开启查询日志,只能保存到文件中

(5).允许最大的事务大小由wsrep_max_ws_rows和wsrep_max_ws_size定义。任何大型操作将被拒绝。如大型的LOAD DATA操作

(6).由于集群是乐观的并发控制,事务commit可能在该阶段中止。如果有两个事务向在集群中不同的节点向同一行写入并提交,失败的节点将中止。对于集群级别的中止,集群返回死锁错误代码(Error: 1213 SQLSTATE: 40001 (ER_LOCK_DEADLOCK))

(7).XA事务不支持,由于在提交上可能回滚

(8).整个集群的写入吞吐量是由最弱的节点限制,如果有一个节点变得缓慢,那么整个集群将是缓慢的。为了稳定的高性能要求,所有的节点应使用统一的硬件

(9).集群节点建议最少3个

(10).如果DDL语句有问题将破坏集群。

二、二进制包安装percona mysql

二进制安装过程略:

编辑my.cnf文件

[root@PXC01 Percona-XtraDB-Cluster-5.6.28-76.1]#vi /etc/my.cnf

basedir = /usr/local/mysql

datadir = /data/mysql

port = 3306

server_id = 3

socket = /tmp/mysql.sock

pid-file = /tmp/mysql.pid

# replication settings #

sync_binlog=0

binlog_format=row

# log settings #

log-error = /data/log/3306.err

log-bin=/data/binlog/mysql-bin

# connection #

interactive_timeout = 1800

wait_timeout = 1800

lock_wait_timeout = 1800

skip_name_resolve = 1

max_connections = 2000

max_connect_errors = 1000000

default-storage-engine=INNODB

skip-name-resolve

skip-host-cache

explicit_defaults_for_timestamp

sql_mode=STRICT_TRANS_TABLES,NO_ENGINE_SUBSTITUTION,NO_ZERO_DATE,NO_ZERO_IN_DATE,ERROR_FOR_DIVISION_BY_ZERO,NO_AUTO_CREATE_USER

expire_logs_days = 7

collation_server=utf8_general_ci

init_connect='SET NAMES utf8'

transaction_isolation = READ-COMMITTED

max_allowed_packet = 16M

max_heap_table_size = 64M

# session memory settings #

sort_buffer_size = 33M

join_buffer_size = 134M

query_cache_size = 0

query_cache_limit = 0

read_buffer_size= 8M

# table cache performance settings

table_open_cache = 4096

table_definition_cache = 4096

table_open_cache_instances = 64

# innodb settings #

innodb_undo_directory = /data/undolog/

innodb_undo_logs = 128

innodb_undo_tablespaces = 3

innodb_buffer_pool_instances = 8

innodb_online_alter_log_max_size=1G

innodb_data_file_path = ibdata1:1G:autoextend

innodb_buffer_pool_size = 20G

innodb_file_per_table = 1

innodb_flush_method = O_DIRECT

innodb_flush_log_at_trx_commit = 2

innodb_log_buffer_size = 64M

innodb_log_file_size = 256M

innodb_log_files_in_group = 3

innodb_io_capacity = 600

innodb_max_dirty_pages_pct = 80

innodb_autoinc_lock_mode=2

#innodb_locks_unsafe_for_binlog=1

#innodb_doublewrite=0

innodb_open_files = 4096

innodb_page_size = 16k

innodb_purge_threads=4

innodb_large_prefix = 1

innodb_thread_concurrency = 64

innodb_print_all_deadlocks = 1

innodb_strict_mode = 1

innodb_sort_buffer_size = 60M

innodb_online_alter_log_max_size=1G

2.1、初始化数据库

标注:

作为primary节点的数据库需要初始化数据库,作为从节点就不需要初始化数据库,只需要直接启动数据库,从节点会自动从primary节点拷贝数据到存放数据文件的位置。

2.1.2、源码安装xtrabackup

2.1.2.1、安装依赖包

[root@PXC01 opt]#yum -y install perl-DBI perl-DBD-MySQLperl-Time-HiRes perl-IO-Socket-SSL libev libgcrypt-devel libcurl-devel crypt* libgcrypt*imake libxml2-devel expat-devel git bzip2* python-sphinx* cryptopp* ncurses* perl-TermReadKey*tcp_wrappers* libev-devel

2.1.2.2、编译xtrabackup

注意:sphinx,lzlib,libev动态库需要手动下载,编译安装,下载地址如下:

http://software.schmorp.de/pkg/libev.html

http://download.savannah.gnu.org/releases/lzip/lzlib/

http://www.dest-unreach.org/socat/

2.1.2.2.1、安装socat

[root@pxc02opt]# tar -zxvf socat-2.0.0-b9.tar.gz -C /usr/local

[root@pxc02 opt]# cd /usr/local/socat-2.0.0-b9

[root@pxc02 socat-2.0.0-b9]# ./configure

[root@pxc02 socat-2.0.0-b9]# make

[root@pxc02 socat-2.0.0-b9]# make install

[root@pxc02 socat-2.0.0-b9]# ln -s /usr/local/bin/socat /usr/bin/

2.1.2.2.2、安装libev

[root@PXC01 opt]# tar -zxvf libev-4.22.tar.gz -C /usr/local

[root@PXC01 libev-4.22]# chmod 755 ./*

[root@PXC01 libev-4.22]# ./configure

[root@PXC01 libev-4.22]# make install

2.1.2.2.3、安装lzlib

[root@PXC01 opt]# tar -zxvf lzlib-1.7.tar.gz -C /usr/local

[root@PXC01 opt]# cd /usr/local/lzlib-1.7/

[root@PXC01 lzlib-1.8-rc3]#./configure

[root@PXC01 lzlib-1.8-rc3]# make

[root@PXC01 lzlib-1.8-rc3]# make install

2.1.2.2.4、安装sphinx

[root@PXC01 opt]# tar -zxvf sphinx-2.2.8-release.tar.gz -C /usr/local

[root@PXC01 local]# cd /usr/localsphinx-2.2.8-release/

[root@PXC01sphinx-2.2.8-release]# ./configure--prefix=/usr/local/sphinx/ --with-mysql --enable-id64

注意:

如果mysql没有安装到/usr/local/下,使用一下命令:

./configure--prefix=/usr/local/sphinx/ --with-mysql=/mysoft --with-mysql-includes=/mysoft/include--enable-id64

[root@PXC01sphinx-2.2.8-release]#make

[root@PXC01sphinx-2.2.8-release]#make install

2.1.2.2.5、安装xtrabackup

[root@PXC01 opt]# tar -zxvfpercona-xtrabackup_2.3.4.orig.tar.gz

[root@PXC01 opt]#cd percona-xtrabackup-2.3.4

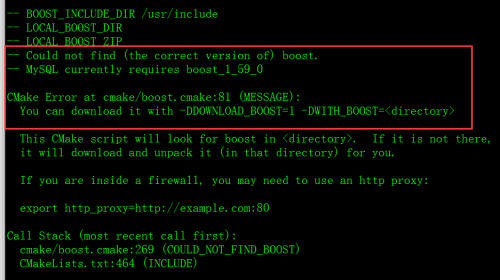

[root@PXC01percona-xtrabackup-2.3.4]# cmake -DBUILD_CONFIG=xtrabackup_release-DWITH_MAN_PAGES=OFF

[root@PXC01percona-xtrabackup-2.3.4]#make

[root@PXC01percona-xtrabackup-2.3.4]#make install

默认安装到/usr/local/xtrabackup

注意:如果编译安装出错、需要重新安装需要清除旧的对象和缓存信息

重新安装需要xtrabackup

rm -rf /usr/bin/innobackupex

rm -rf /usr/bin/xtrabackup

在编译时可以添加如下两个参数:

-DDOWNLOAD_BOOST=1 -DWITH_BOOST=/usr/local

2.1.2.5.1、建立软连接

[root@PXC01xtrabackup]#ln -s/usr/local/xtrabackup/bin/innobackupex /usr/bin/innobackupex

[root@PXC01xtrabackup]#ln -s/usr/local/xtrabackup/bin/xbcrypt /usr/bin/xbcrypt

[root@PXC01xtrabackup]#ln -s/usr/local/xtrabackup/bin/xbstream /usr/bin/xbstream

[root@PXC01xtrabackup]#ln -s /usr/local/xtrabackup/bin/xtrabackup/usr/bin/xtrabackup

[root@PXC01xtrabackup]#ln -s/usr/local/xtrabackup/bin/xbcloud_osenv /usr/bin/xbcloud_osenv

[root@PXC01 xtrabackup]#ln -s /usr/local/xtrabackup/bin/xbcloud/usr/bin/xbcloud

ln -s/usr/local/xtrabackup/bin/innobackupex /usr/bin/innobackupex

ln -s /usr/local/xtrabackup/bin/xbcrypt /usr/bin/xbcrypt

ln -s /usr/local/xtrabackup/bin/xbstream /usr/bin/xbstream

ln -s /usr/local/xtrabackup/bin/xbcloud_osenv/usr/bin/xbcloud_osenv

ln -s /usr/local/xtrabackup/bin/xbcloud/usr/bin/xbcloud

ln –s /usr/local/xtrabackup/bin/xtrabackup/usr/bin/xtrabackup

2.1.2.5.2、验证xtrabackup

[root@PXC01 xtrabackup]# xtrabackup-version

xtrabackup version 2.3.4 based on MySQLserver 5.6.24 Linux (x86_64) (revision id: e80c779)

2.1.3、安装galera

2.1.3.1、编译galera

[root@pxc01 opt]#tar –zxvf /opt/ galera-3-25.3.16.tar.gz–C /usr/local

[root@pxc01 opt]# cd/usr/local/galera-3-25.3.16/

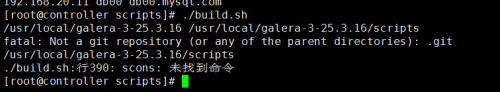

[root@pxc01 galera-3-25.3.16]#cd scripts

[root@pxc01 galera-3-25.3.16]#./build.sh

[root@PXC01 galera-3-25.3.16]# cplibgalera_smm.so/usr/lib64

[root@PXC01 galera-3-25.3.16]# chmod +x libgalera_smm.so

执行上面脚本./build.sh时报错解决如:

yum install boost* openssl* check* -y

yum -y install gcc

yum -y install scons

然后可以不执行脚本执行scons进行编译即可:

[root@pxc01 opt]# cd/usr/local/galera-3-25.3.16/

#scons

可以以正常模式启动主节点mysql(/usr/local/mysql/bin/mysqld_safe--wsrep_cluster_address=gcomm://>/dev/null &)

2.2、从节点安装

其余2个节点按照主节点步骤安装,

从节点安装完mysql以后不需要初始化数据,可以直接启动mysql,mysql启动以后会自动加入到集群节点,并从主节点拷贝数据文件到存放数据文件的位置。

chown -R mysql.mysql /usr/local/mysql/

从节点启动:

/usr/local/mysql/bin/mysqld_safe--wsrep_cluster_address=gcomm://192.168.20.11:4567>/dev/null&

/usr/local/mysql/bin/mysqld_safe--wsrep_cluster_address=gcomm://192.168.20.22:4567 >/dev/null &

四、配置PXC集群

4.1、添加PXC参数

4.1.1、添加集群复制账号

[mysql@VM-172-31-102-133 ~]#mysql

mysql>GRANT PROCESS, RELOAD, LOCKTABLES, REPLICATION CLIENT ON *.* TO 'sstuser'@'localhost' identified by'sstuser';

mysql>FLUSH PRIVILEGES;

4.1.2、编辑my.cnf文件

编辑my.cnf文件,添加以下参数:

server-id = 1

# Path to Galera library

wsrep_provider=/usr/lib64/libgalera_smm.so ---注意编译galera软件时的存放目录

# Cluster connection URL contains the IPsof node#1, node#2 and node#3

wsrep_cluster_address=gcomm://172.31.102.133,172.31.102.139,172.31.102.167 --节点IP地址,不添加端口会使用默认端口

# In order for Galera to work correctlybinlog format should be ROW

binlog_format=ROW

# MyISAM storage engine has onlyexperimental support

default_storage_engine=InnoDB

# This changes how InnoDB autoincrementlocks are managed and is a requirement for Galera

innodb_autoinc_lock_mode=2

# Node #1 address

wsrep_node_address=172.31.102.133 ---主机IP

# SST method

wsrep_sst_method=xtrabackup-v2

# Cluster name

wsrep_cluster_name=my_centos_cluster

# Authentication for SST method

wsrep_sst_auth="sstuser:s3cret"

[root@pxc01 ]#cat /etc/my.cnf

[mysqld]

basedir = /usr/local/mysql

datadir = /data/mysql

port = 3306

server-id = 238

#socket = /data/mysql/mysql.sock

pid-file = /tmp/mysql.pid

# replication settings #

sync_binlog = 0

binlog_format = row

# log settings #

log-error = /data/log/3306.err

log-bin=/data/binlog/mysql-bin

# connection #

interactive_timeout = 1800

wait_timeout = 1800

lock_wait_timeout = 1800

skip_name_resolve = 1

max_connections = 2000

max_connect_errors = 1000000

default-storage-engine = innodb

skip-name-resolve

skip-host-cache

explicit_defaults_for_timestamp

sql_mode =STRICT_TRANS_TABLES,NO_ENGINE_SUBSTITUTION,NO_ZERO_DATE,NO_ZERO_IN_DATE,ERROR_FOR_DIVISION_BY_ZERO,NO_AUTO_CREATE_USER

expire_logs_days = 7

collation_server=utf8_general_ci

init_connect='SET NAMES utf8'

transaction_isolation = READ-COMMITTED

max_allowed_packet = 16M

max_heap_table_size = 64M

# session memory settings #

sort_buffer_size = 33M

join_buffer_size = 134M

query_cache_size = 0

query_cache_limit = 0

read_buffer_size= 8M

# table cache performance settings

table_open_cache = 4096

table_definition_cache = 4096

table_open_cache_instances = 64

# innodb settings #

innodb_undo_directory = /data/undolog/

innodb_undo_logs = 128

innodb_undo_tablespaces = 3

innodb_buffer_pool_instances = 8

innodb_online_alter_log_max_size = 1G

innodb_data_file_path = ibdata1:1G:autoextend

innodb_buffer_pool_size = 12G

innodb_file_per_table = 1

innodb_flush_method = O_DIRECT

innodb_flush_log_at_trx_commit = 2

innodb_log_buffer_size = 64M

innodb_log_file_size = 256M

innodb_log_files_in_group = 3

innodb_io_capacity = 600

innodb_max_dirty_pages_pct = 75

innodb_autoinc_lock_mode = 2

innodb_locks_unsafe_for_binlog = 1

innodb_doublewrite = 0

innodb_open_files = 4096

innodb_page_size = 16k

innodb_purge_threads = 4

innodb_large_prefix = 1

innodb_thread_concurrency = 64

innodb_print_all_deadlocks = 1

innodb_strict_mode = 1

innodb_sort_buffer_size = 60M

innodb_online_alter_log_max_size = 1G

# wsrep settings #

wsrep_provider=/usr/lib64/libgalera_smm.so

wsrep_cluster_address=gcomm://192.168.10.238,192.168.10.239,192.168.10.240

wsrep_sst_auth=sstuser:sstuser

wsrep_provider_options="gcache.size=2G"

wsrep_cluster_name=Percona_cluster

wsrep_sst_method=xtrabackup-v2

wsrep_node_address=192.168.10.238

wsrep_node_name=pxc01

wsrep_slave_threads=8

4.1.3、启动mysql

以PXC(初始化)模式启动mysql,只有主节点可以这么启动,从节点必须按照正常启动方式启动mysql

[mysql@VM-172-31-102-133 ~]#/etc/init.d/mysqldbootstrap-pxc

Bootstrapping PXC (Percona XtraDBCluster)Starting MySQL (Percona XtraDB Cluster). SUCCESS!

4.1.3、配置第二个节点

server-id = 2

配置my.cnf文件,添加以下参数:

# Path to Galera library

wsrep_provider=/usr/lib64/libgalera_smm.so

# Cluster connection URL contains the IPsof node#1, node#2 and node#3

wsrep_cluster_address=gcomm://172.31.102.133,172.31.102.139,172.31.102.167

# In order for Galera to work correctlybinlog format should be ROW

binlog_format=ROW

# MyISAM storage engine has onlyexperimental support

default_storage_engine=InnoDB

# This changes how InnoDB autoincrementlocks are managed and is a requirement for Galera

innodb_autoinc_lock_mode=2

# Node #1 address

wsrep_node_address=172.31.102.139

# SST method

wsrep_sst_method=xtrabackup-v2

# Cluster name

wsrep_cluster_name=my_centos_cluster

# Authentication for SST method

wsrep_sst_auth="sstuser:s3cret"

4.1.4、配置第三个节点

server-id = 3

配置my.cnf文件,添加以下参数:

# Path to Galera library

wsrep_provider=/usr/lib64/libgalera_smm.so

# Cluster connection URL contains the IPsof node#1, node#2 and node#3

wsrep_cluster_address=gcomm://172.31.102.133,172.31.102.139,172.31.102.167

# In order for Galera to work correctlybinlog format should be ROW

binlog_format=ROW

# MyISAM storage engine has onlyexperimental support

default_storage_engine=InnoDB

# This changes how InnoDB autoincrementlocks are managed and is a requirement for Galera

innodb_autoinc_lock_mode=2

# Node #1 address

wsrep_node_address=172.31.102.167

# SST method

wsrep_sst_method=xtrabackup-v2

# Cluster name

wsrep_cluster_name=my_centos_cluster

# Authentication for SST method

wsrep_sst_auth="sstuser:s3cret"

4.1.4、启动从节点mysql

以次下列命令启动

Service mysql start

查看日志: